视频 谷歌 DeepMind 的书呆子们开发了一个深度学习课程,可以教机器人如何踢糟糕的足球——这真是太棒了。

与之相反 优美的杂技 在波士顿动力公司的 Atlas 机器人中,一对 Robotis OP3 机器人在 DeepMind 的指导下笨手笨脚地在一个 5 米乘 4 米的足球场或足球场上跌跌撞撞,就像精疲力竭的幼儿一样。 在下面的视频中自己判断。

他们这样做的目的很明显,尽管屡次跌倒,他们还是设法纠正自己并偶尔进球。 在这些人形机器的孩子般的跌跌撞撞中,很容易看出类似于我们重视和鼓励彼此的决心的东西,即使这只是错位的拟人化。 很难不支持他们,尽管如果他们扩大规模和武器化,他们会激发其他情绪。

参与该项目的 28 名研究人员描述了他们的工作 一篇论文 [PDF] 标题为“通过深度强化学习为双足机器人学习敏捷足球技能”。

“我们使用深度 [强化学习] 来训练具有 20 个驱动关节的人形机器人来玩简化的一对一 (1v1) 足球比赛,”作者解释道。 “我们首先单独训练个人技能,然后在自我对弈环境中端到端地组合这些技能。

“由此产生的政策展示了强大而动态的运动技能,例如快速跌倒恢复、行走、转身、踢腿等; 并以平稳、稳定和高效的方式在它们之间转换——远远超出了机器人的直觉预期。”

DeepMind 项目在范围上不如为 RoboCup 先进技术竞赛准备机器的努力那么雄心勃勃,该竞赛已经进行了多年。 然而,RoboCup 的最新迭代是 看起来肯定没那么有趣 由于参与者的克制行为。 RoboCup 机器人具有的刚性 大河之舞 双臂固定在身体两侧的表演者,DeepMind 玩家 像疯子一样挥舞着他们的手臂 – 诚然,在试图避免打手球时并不理想,但更好地征求同情。

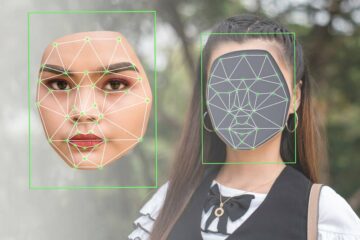

深度强化学习是一种训练神经网络的方法,其中代理(基于软件或硬件的实体)通过反复试验学习如何做事(模拟或在现实世界中)。 并且它已经成为教机器人如何在各种环境中四处移动的常用技术,从 卡西的跑步敏锐度,一种你希望永远不会看到追逐你的机械鸵鸟躯干。

DeepMind 团队的目标是训练一个代理人踢足球,这需要多种技能,包括走路、踢球、站立、得分和防守,所有这些都需要协调才能进球并赢得比赛。

为了训练代理人——在这种情况下是控制机器人的软件——仅仅奖励系统进球是不够的,这不会产生所有必要的技能。 取而代之的是,研究人员分别研究了这些技能组合,专注于制定他们所谓的教师政策。 这些政策规定了一些事情,比如起身和对未经训练的对手进球 - 一个立即倒地的人,这种行为与真正的足球跳水没有什么不同。

研究人员必须小心地在智能体倒地时停止进球训练,以防止出现不良但明显的功能性行为:“如果没有这种终止,智能体会找到局部最小值并学会在地面上滚向球以将其击倒进入球门,而不是边走边踢,”他们在论文中解释道。

起床政策和进球政策最终结合在一起。 通过深度强化学习和实现特定目标的奖励过程,该软件开发了可以通过的足球技能。

事实证明,将经过训练的软件代理转移到机器人身上并不难。 这组作者说,这是一个零样本过程,这意味着他们不需要进行额外的培训。

“我们通过简单的系统识别减少了模拟与真实的差距,通过域随机化和训练期间的扰动提高了我们政策的稳健性,并包括塑造奖励条款以获得不太可能损坏机器人的行为,”他们解释道。

也就是说,他们确保模拟器参数映射到硬件执行器设置、地板摩擦和关节方向等随机特性、机器人部件的质量、控制回路延迟和随机扰动,所有这些都是为了确保软件能够处理各种作用在机器人身体上的力。 在一项调整中,他们添加了奖励成分,鼓励机器人减少对膝关节的压力,否则膝关节容易受损。

培训起跑和足球老师分别花费了 14 小时和 158 小时(6.5 天),然后是 68 小时的提炼和自我发挥。 棺材说,结果比刻意尝试编程这些技能要好。

“强化学习策略比专门的手动设计技能表现得更好:它走路快了 156%,起床时间减少了 63%,”该论文说。

“当在球附近初始化时,它踢球的速度降低了 5%; 两者都达到了大约 2 m/s 的球速。 然而,通过对球的额外助跑方法,学习策略的平均踢球速度为 2.6 m/s(比脚本技能快 24%),并且跨片段的最大踢球速度为 3.4 m/s。”

DeepMind 的研究人员证明,深度强化学习可以有效且低成本地应用于人形机器人的教学。 无论是好是坏,这都是迈向双足机器人走在我们中间的未来的又一步。 ®

- SEO 支持的内容和 PR 分发。 今天得到放大。

- 柏拉图爱流。 Web3 数据智能。 知识放大。 访问这里。

- 与 Adryenn Ashley 一起铸造未来。 访问这里。

- 使用 PREIPO® 买卖 PRE-IPO 公司的股票。 访问这里。

- Sumber: https://go.theregister.com/feed/www.theregister.com/2023/05/09/ai_robot_soccer/

- :具有

- :是

- :不是

- :在哪里

- $UP

- 14

- 20

- 24

- 28

- 7

- a

- 关于

- 根据

- 实现

- 实现

- 横过

- 实际

- 头脑

- 添加

- 额外

- 调整

- 驳

- 经纪人

- 中介代理

- 敏捷

- 瞄准

- 所有类型

- 有雄心

- 其中

- 我们之间

- an

- 和

- 另一个

- 明显的

- 应用的

- 的途径

- 武器

- 围绕

- AS

- At

- 作者

- 避免

- 惨

- 球

- BE

- 成为

- 很

- 如下。

- 更好

- 之间

- 超越

- 身体

- 波士顿

- 都

- 机器人

- 大黄蜂

- 但是

- by

- 呼叫

- CAN

- 小心

- 案件

- 特点

- CO

- 结合

- 相当常见

- 竞争

- 元件

- 由

- 对比

- 控制

- 控制

- 协调

- 可以

- 课程设置

- 一年中的

- 深

- 深入学习

- DeepMind

- 卫冕

- 证明

- 描述

- 尽管

- 决心

- 发达

- 发展

- 难

- do

- 域

- 两

- ,我们将参加

- 动态

- 动力学

- 易

- 只

- 高效

- 工作的影响。

- 情绪

- 鼓励

- 鼓励

- 端至端

- 更多

- 确保

- 实体

- 环境中

- 错误

- 甚至

- 终于

- 展品

- 预期

- 说明

- 秋季

- 下降

- 快

- 部分

- 找到最适合您的地方

- (名字)

- 固定

- 地板

- 聚焦

- 其次

- 足球

- 针对

- 部队

- 摩擦

- 止

- 开玩笑

- 实用

- 未来

- 游戏

- 差距

- 得到

- 越来越

- 目标

- 理想中

- 去

- 谷歌

- 陆运

- 民政事务总署

- 暂停

- 处理

- 硬件

- 有

- 抱有希望

- HOURS

- 创新中心

- How To

- 但是

- HTTPS

- 人形

- 理想

- 鉴定

- if

- 立即

- 改善

- in

- 包括

- 包含

- 个人

- 启发

- 代替

- 成

- 参与

- 隔离

- IT

- 迭代

- 联合

- JPG

- 法官

- 只是

- 标签

- 潜伏

- 最新

- 学习用品

- 知道

- 学习

- 减

- 喜欢

- 容易

- 本地

- 看

- 廉价

- 机

- 制成

- 管理

- 方式

- 质量

- 最多

- 意味着

- 意

- 最低限度

- 放错地方

- 更多

- 移动

- 运动

- 近

- 必要

- 需求

- 网络

- 神经网络

- 决不要

- 目标

- 获得

- of

- 折扣

- on

- 一

- or

- 其他名称

- 除此以外

- 我们的

- 成果

- 对

- 纸类

- 参数

- 与会者

- 部分

- 百分

- 表演者

- 沥青

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 播放

- 球员

- 政策

- 政策

- Prepare

- 防止

- 过程

- 生产

- 曲目

- 项目

- 证明

- 目的

- 放

- 随机

- 随机化

- 快

- 宁

- 真实

- 真实的世界

- 恢复

- 减少

- 重复

- 需要

- 研究人员

- 分别

- 导致

- 积分

- 奖励

- 右

- 机器人

- 机器人

- 健壮

- 稳健性

- 滚

- 根

- s

- 说

- 对工资盗窃

- 说

- 范围

- 得分了

- 得分

- 看到

- 看到

- 套数

- 设置

- 设置

- 成型

- 双方

- 简易

- 简

- 模拟器

- 技能

- 技能

- So

- 足球

- 软件

- 招揽

- 东西

- 专门

- 指定

- 速度

- 稳定

- 步

- Stop 停止

- 应力

- 绊脚

- 这样

- 系统

- 教师

- 教诲

- 团队

- 条款

- 比

- 这

- 其

- 他们

- 他们自己

- 然后

- 博曼

- 他们

- 事

- Free Introduction

- 那些

- 虽然?

- 通过

- 次

- 标题

- 至

- 也有

- 了

- 对于

- 向

- 培训

- 熟练

- 产品培训

- 火车

- 转换

- 试用

- 谈到

- 下

- 不像

- 上

- us

- 用过的

- 折扣值

- 各种

- 各个

- 通过

- 视频

- 走

- 步行

- 是

- 方法..

- we

- 井

- 为

- 什么是

- 什么是

- ,尤其是

- 这

- WHO

- 赢

- 也完全不需要

- 精彩

- 工作

- 世界

- 更坏

- 年

- 完全

- 你自己

- YouTube的

- 和风网