Twitter 的图形学习研究主管迈克尔·布朗斯坦 (Michael Bronstein) 表示,GPU 是机器学习工作负载的强大工具,尽管它们不一定是每项 AI 工作的正确工具。

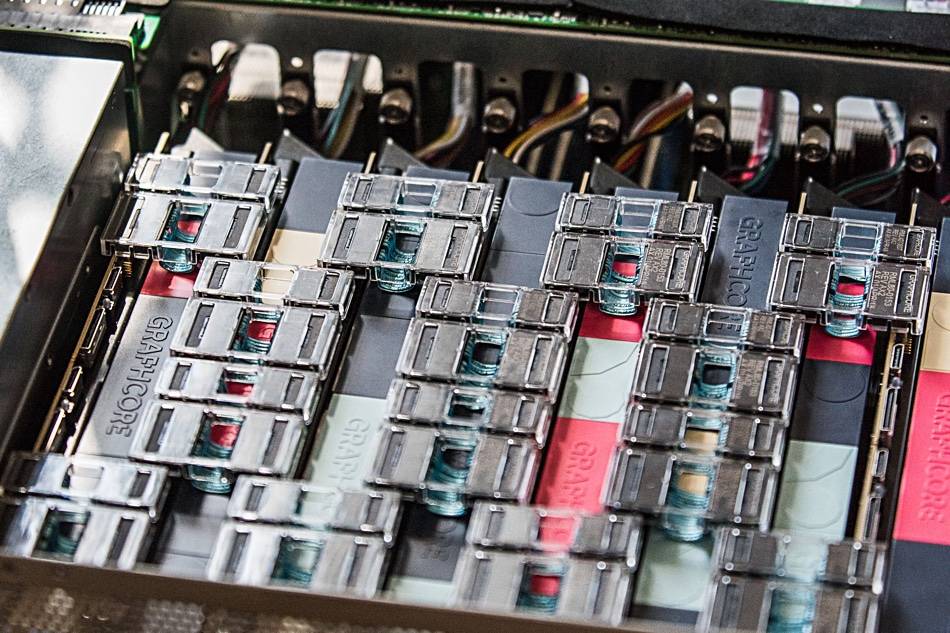

他的团队最近展示了 Graphcore 的 AI 硬件在时间图网络 (TGN) 模型中提供了“将单个 IPU 处理器与 Nvidia A100 GPU 进行比较时的数量级加速”。

“用于实现 Graph ML 模型的硬件选择是一个至关重要但经常被忽视的问题,”阅读 联合文章 由 Bronstein 与 Twitter 的 ML 研究员 Emanuele Rossi 和 Graphcore 的研究员 Daniel Justus 共同撰写。

图神经网络提供了一种在复杂系统中寻找顺序的方法,通常用于社交网络和推荐系统。 然而,三人解释说,这些环境的动态特性使这些模型的训练特别具有挑战性。

该小组调查了 Graphcore 的 IPU 在处理多个 TGN 模型方面的可行性。 初步测试是在一个小型 TGN 模型上进行的,基于 朱迪 将用户链接到他们对页面所做的编辑的维基百科数据集。 该图由 8,227 个用户和 1,000 篇文章组成,共有 9,227 个节点。 JODIE 是一个开源预测系统,旨在理解时间交互网络。

三人组的实验表明,与较小的批量相比,大批量会导致验证和推理准确性下降。

三人写道:“节点内存和图连接都只有在处理完一个完整的批次后才会更新。” “因此,一批中较晚的事件可能依赖于过时的信息,因为他们不知道较早的事件。”

然而,通过使用 10 的批量大小,该小组能够实现最佳的验证和推理精度,但他们注意到 IPU 上的性能仍然优于 GPU,即使在使用大批量大小时也是如此。

“当使用 10 的批处理端时,TGN 在 IPU 上的训练速度可以快 11 倍,即使使用 200 的大批量,在 IPU 上的训练速度仍然快 XNUMX 倍,”帖子中写道。 “在所有操作中,IPU 可以更有效地处理小批量。”

该团队认为,Graphcore 的大型处理器内 SRAM 缓存提供的快速内存访问和高吞吐量为 IPU 提供了优势。

这种性能领先还扩展到超过 IPU 处理器内内存的图形模型——每个 IPU 具有 1GB SRAM 缓存——需要使用连接到芯片的较慢的 DRAM 内存。

Bronstein 的团队发现,在对由 261 万 Twitter 用户组成的 15.5 亿关注的图形模型进行测试时,将 DRAM 用于节点内存将吞吐量降低了两倍。

然而,当基于一个 10 倍于 Twitter 图大小的合成数据集诱导几个子图时,该团队发现吞吐量与图大小无关。 换句话说,性能下降是使用较慢内存的结果,而不是模型大小的结果。

“在 IPU 上使用这种技术,TGN 可以应用于几乎任意的图形大小,仅受可用主机内存量的限制,同时在训练和推理期间保持非常高的吞吐量,”文章写道。

该团队得出结论,Graphcore 的 IPU 架构在计算和内存访问异构的工作负载中显示出明显优于 GPU 的优势。

然而,更广泛的收获是 ML 研究人员应该仔细考虑他们对硬件的选择,而不应该默认使用 GPU。

“抽象出底层硬件的云计算服务的可用性导致了这方面的某些懒惰,”三人写道。 “我们希望我们的研究能够引起对这一重要主题的更多关注,并为未来更高效的 Graph ML 应用算法和硬件架构铺平道路。” ®