今天,我们很高兴地宣布,由 Meta 开发的 Code Llama 基础模型可供客户通过 亚马逊SageMaker JumpStart 一键部署以运行推理。 Code Llama 是一种最先进的大型语言模型 (LLM),能够根据代码和自然语言提示生成代码和有关代码的自然语言。您可以使用 SageMaker JumpStart 尝试此模型,SageMaker JumpStart 是一个机器学习 (ML) 中心,提供对算法、模型和 ML 解决方案的访问,以便您可以快速开始使用 ML。在这篇文章中,我们将介绍如何通过 SageMaker JumpStart 发现和部署 Code Llama 模型。

代码骆驼

Code Llama 是由 元 它构建在 Llama 2 之上。这种最先进的模型旨在通过帮助开发人员创建高质量、记录良好的代码来提高开发人员的编程任务的工作效率。这些模型在 Python、C++、Java、PHP、C#、TypeScript 和 Bash 中表现出色,并且有可能节省开发人员的时间并使软件工作流程更加高效。

它具有三种变体,旨在涵盖各种应用:基础模型 (Code Llama)、Python 专用模型 (Code Llama Python) 和用于理解自然语言指令的指令跟踪模型 (Code Llama Instruct)。所有 Code Llama 变体都有四种尺寸:7B、13B、34B 和 70B 参数。 7B 和 13B 基本和指令变体支持基于周围内容的填充,使其成为代码助理应用程序的理想选择。这些模型以 Llama 2 为基础进行设计,然后在 500 亿个 token 的代码数据上进行训练,Python 专用版本则在增量 100 亿个 token 上进行训练。 Code Llama 模型提供了具有多达 100,000 个上下文标记的稳定生成。所有模型均在 16,000 个标记的序列上进行训练,并在最多 100,000 个标记的输入上显示出改进。

该模型是在相同的条件下提供的 社区许可证为 Llama 2。

SageMaker 中的基础模型

SageMaker JumpStart 提供对流行模型中心的一系列模型的访问,包括 Hugging Face、PyTorch Hub 和 TensorFlow Hub,您可以在 SageMaker 的 ML 开发工作流程中使用这些模型。 机器学习的最新进展催生了一类新的模型,称为 基础模型,它们通常经过数十亿个参数的训练,并且适用于广泛的用例,例如文本摘要、数字艺术生成和语言翻译。由于这些模型的训练成本很高,因此客户希望使用现有的预先训练的基础模型并根据需要对其进行微调,而不是自己训练这些模型。 SageMaker 提供了精选的模型列表,您可以在 SageMaker 控制台上进行选择。

您可以在 SageMaker JumpStart 中找到来自不同模型提供商的基础模型,使您能够快速开始使用基础模型。您可以根据不同的任务或模型提供者找到基础模型,并轻松查看模型特征和使用条款。您还可以使用测试 UI 小部件来尝试这些模型。当您想要大规模使用基础模型时,您可以使用模型提供商提供的预构建笔记本,而无需离开 SageMaker。由于模型在 AWS 上托管和部署,因此您可以放心,无论是用于评估还是大规模使用模型,您的数据都不会与第三方共享。

在 SageMaker JumpStart 中探索 Code Llama 模型

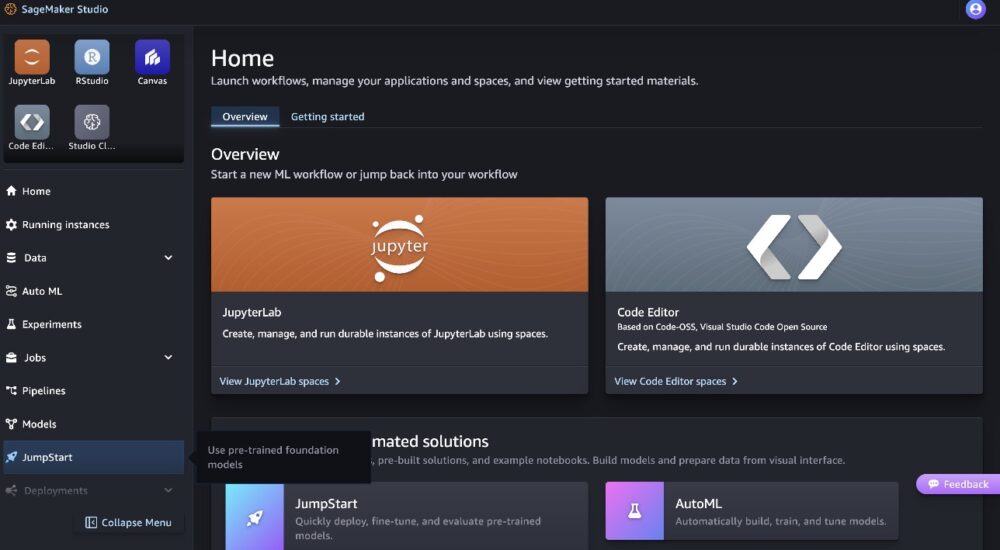

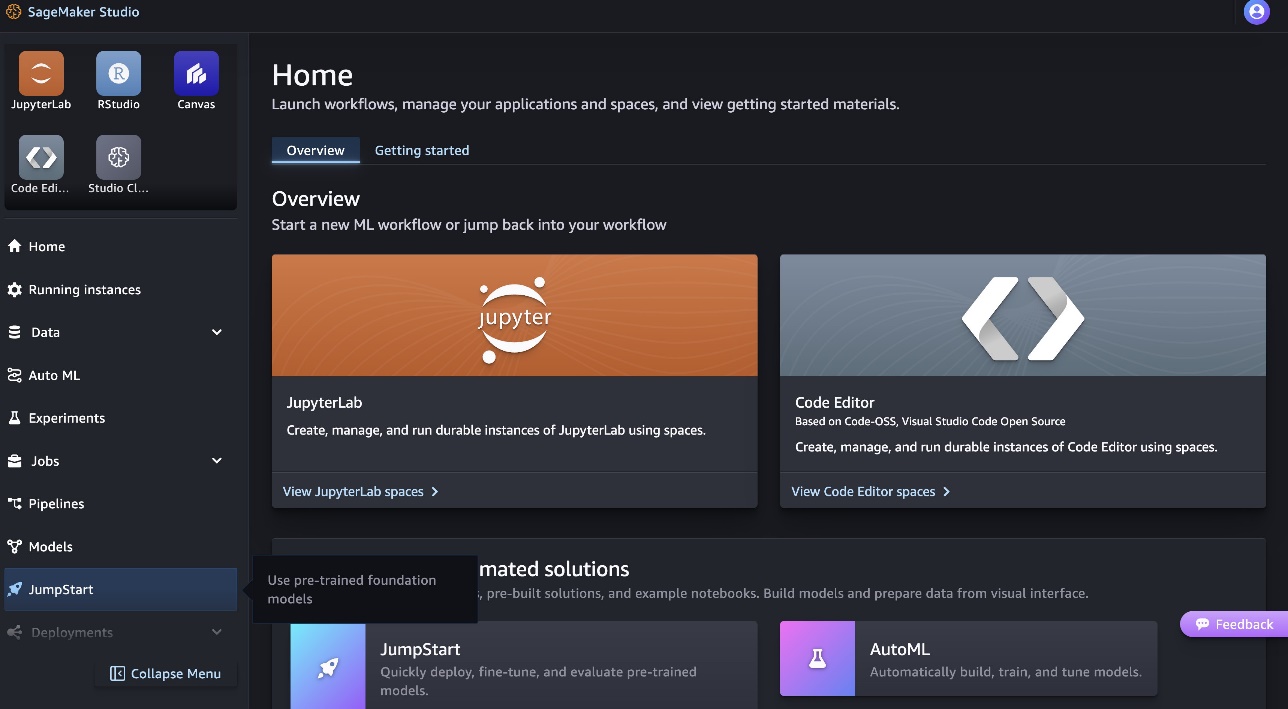

要部署 Code Llama 70B 模型,请完成以下步骤: 亚马逊SageMaker Studio:

- 在 SageMaker Studio 主页上,选择 快速启动 在导航窗格中。

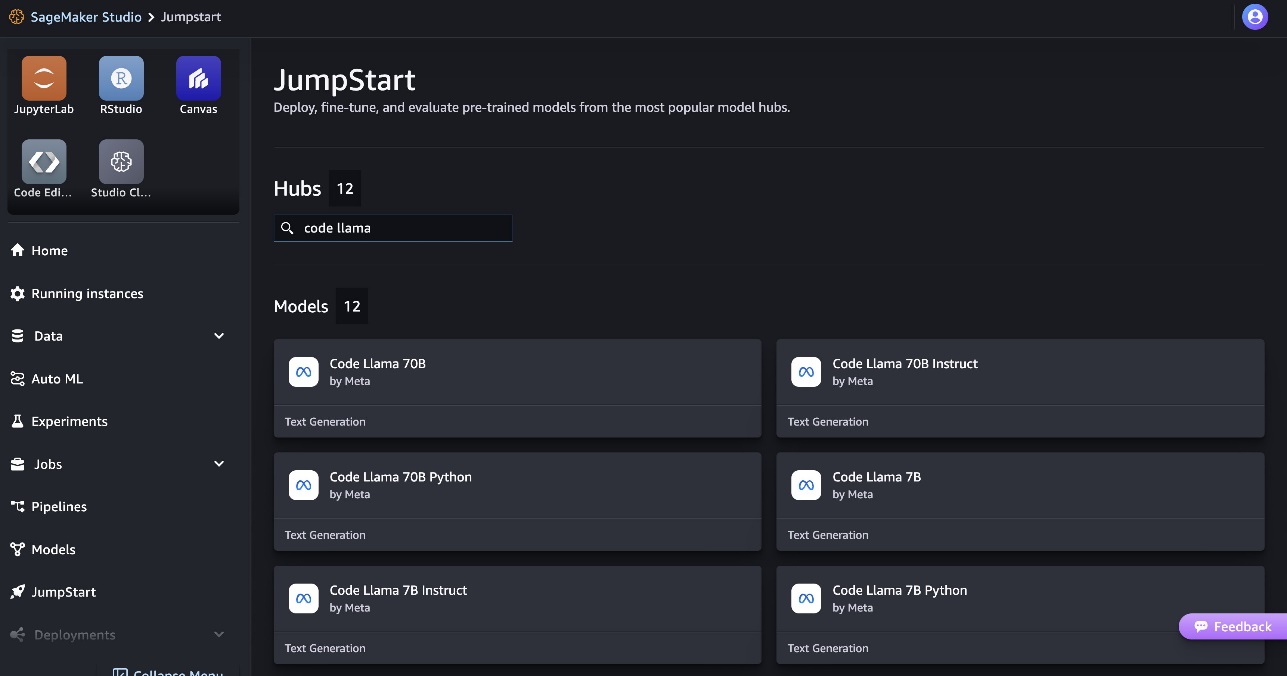

- 搜索 Code Llama 型号并从显示的型号列表中选择 Code Llama 70B 型号。

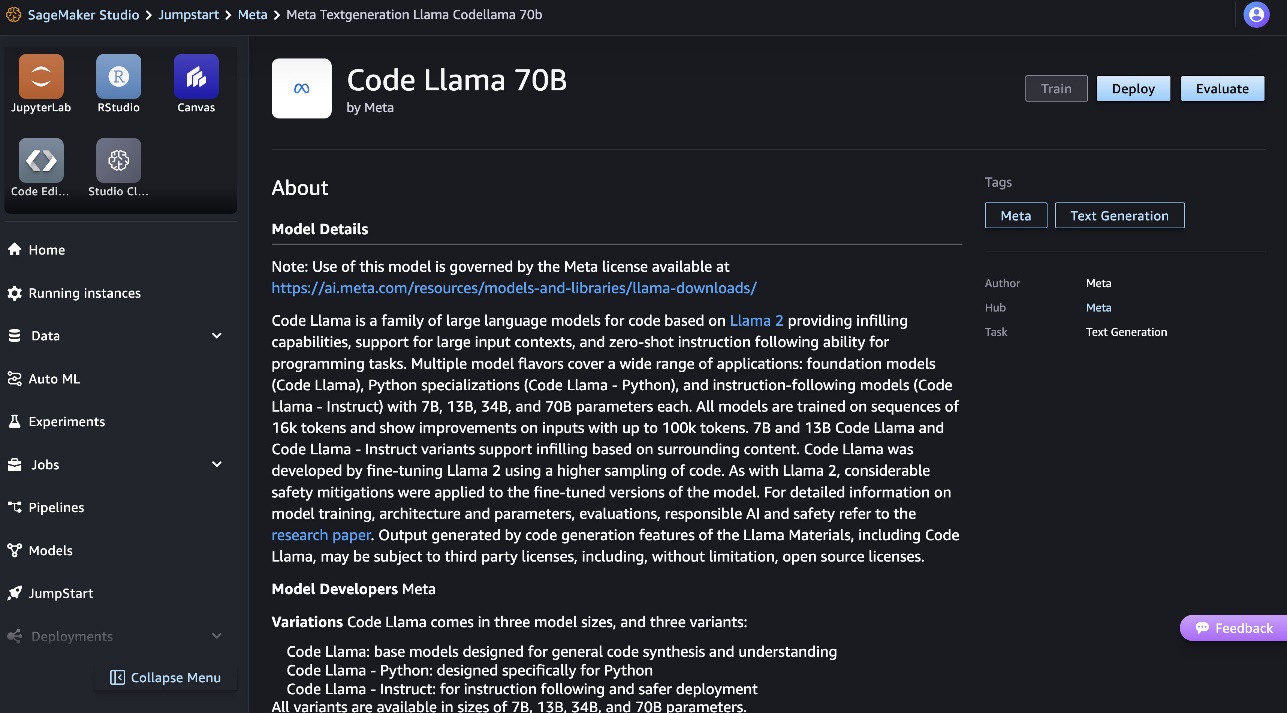

您可以在 Code Llama 70B 型号卡上找到有关该型号的更多信息。

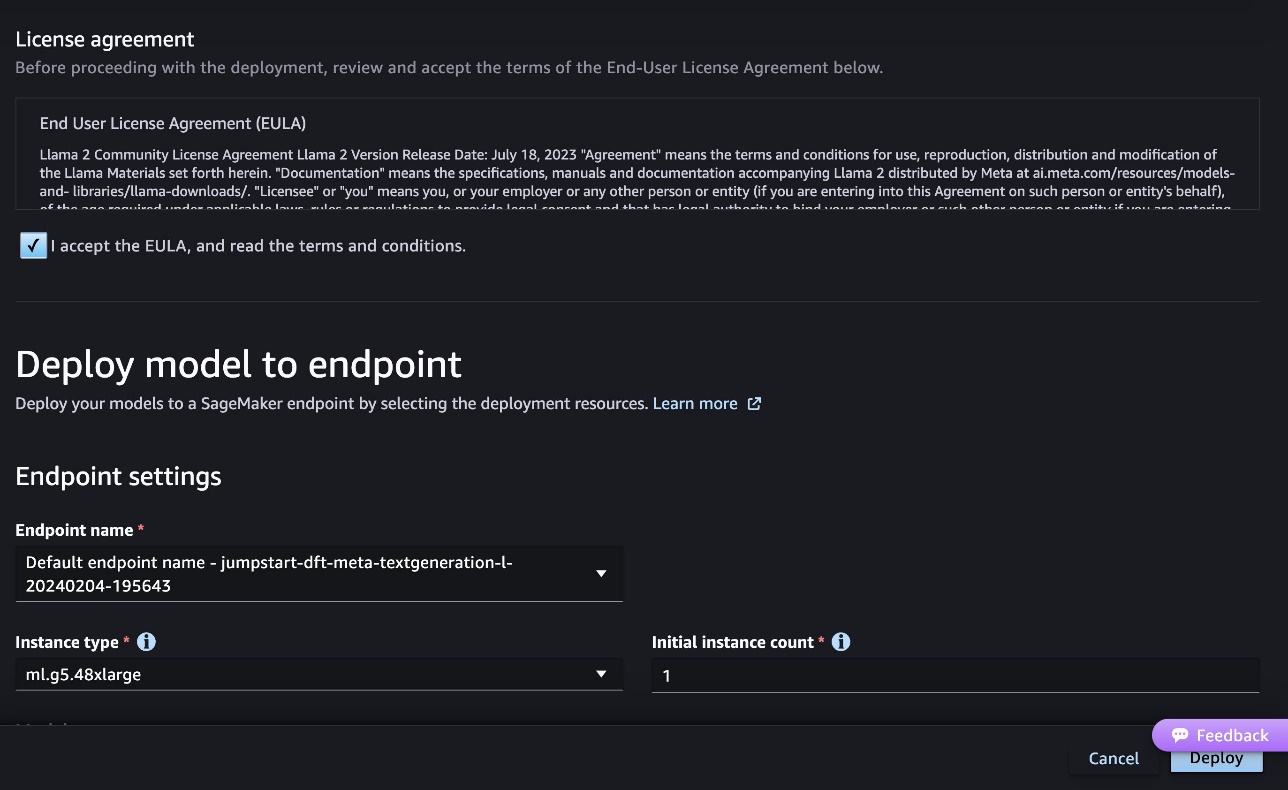

以下屏幕截图显示了端点设置。您可以更改选项或使用默认选项。

- 接受最终用户许可协议 (EULA) 并选择 部署.

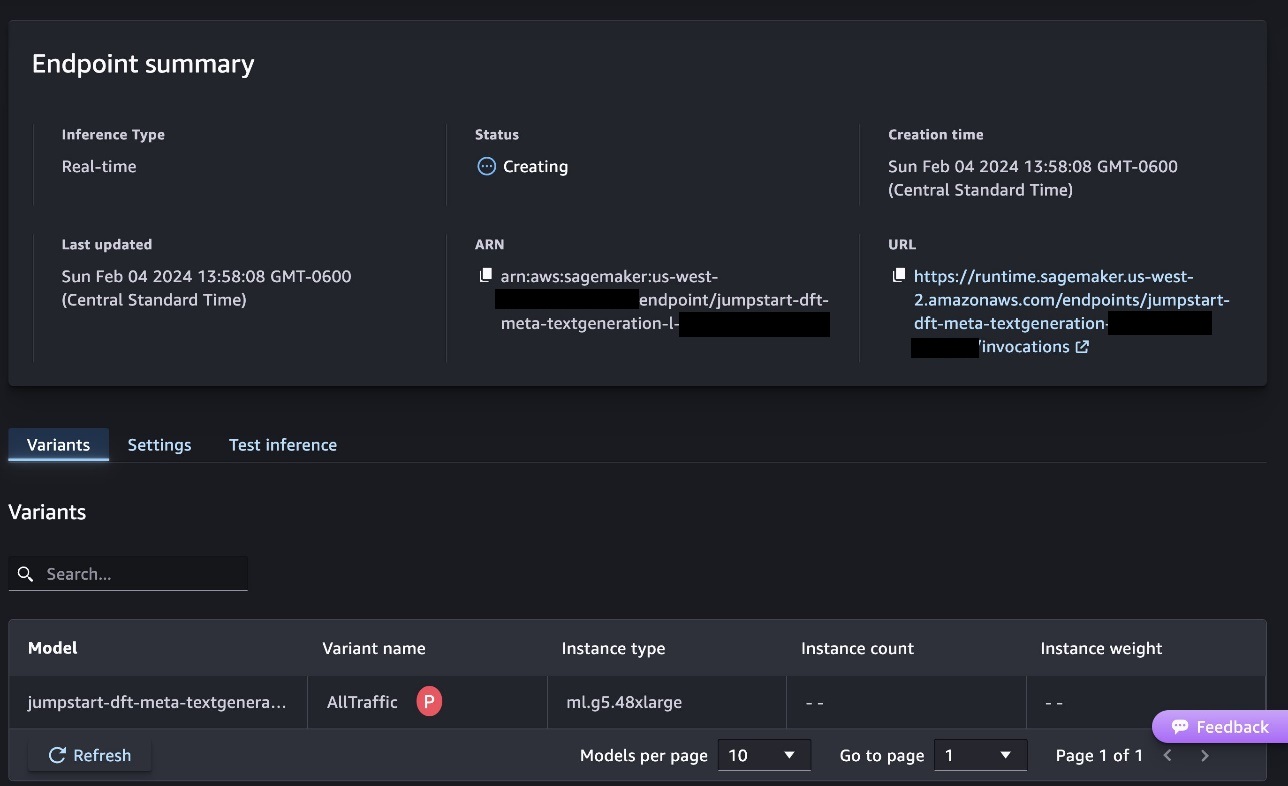

这将启动端点部署过程,如以下屏幕截图所示。

使用 SageMaker Python SDK 部署模型

或者,您可以通过选择示例笔记本进行部署 打开笔记本 在 Classic Studio 的模型详细信息页面中。该示例笔记本提供了有关如何部署模型进行推理和清理资源的端到端指导。

要使用笔记本进行部署,我们首先选择适当的模型,由 model_id。 您可以使用以下代码在 SageMaker 上部署任何选定的模型:

这会使用默认配置(包括默认实例类型和默认 VPC 配置)在 SageMaker 上部署模型。 您可以通过在中指定非默认值来更改这些配置 快速启动模型。请注意,默认情况下, accept_eula 被设置为 False. 你需要设置 accept_eula=True 成功部署端点。通过这样做,您接受前面提到的用户许可协议和可接受的使用政策。你也可以 下载 许可协议。

调用 SageMaker 端点

部署端点后,您可以使用Boto3或SageMaker Python SDK进行推理。在以下代码中,我们使用 SageMaker Python SDK 调用模型进行推理并打印响应:

该功能 print_response 接受由有效负载和模型响应组成的有效负载并打印输出。 Code Llama 在执行推理时支持许多参数:

- 最长长度 – 模型生成文本直到输出长度(包括输入上下文长度)达到

max_length. 如果指定,它必须是正整数。 - 最大新令牌数 – 模型生成文本直到输出长度(不包括输入上下文长度)达到

max_new_tokens. 如果指定,它必须是正整数。 - 梁数 – 这指定了贪婪搜索中使用的波束数量。如果指定,它必须是大于或等于的整数

num_return_sequences. - no_repeat_ngram_size – 该模型确保一系列单词

no_repeat_ngram_size在输出序列中不重复。 如果指定,它必须是大于 1 的正整数。 - 温度 – 这控制输出的随机性。更高

temperature产生具有低概率单词的输出序列,并且较低temperature产生具有高概率单词的输出序列。如果temperature为0时,会导致贪婪解码。如果指定,它必须是正浮点数。 - 提前停止 - 如果

True,当所有束假设到达句子标记的末尾时,文本生成完成。如果指定,则它必须是布尔值。 - 做样本 - 如果

True,模型根据可能性对下一个单词进行采样。如果指定,则它必须是布尔值。 - 前k个 – 在文本生成的每个步骤中,模型仅从

top_k最有可能的话。 如果指定,它必须是正整数。 - 顶部_p – 在文本生成的每一步中,模型都会以累积概率从尽可能小的单词集中进行采样

top_p。 如果指定,它必须是 0 到 1 之间的浮点数。 - 返回全文 - 如果

True,输入文本将成为输出生成文本的一部分。如果指定,则它必须是布尔值。它的默认值是False. - 停止 – 如果指定,它必须是字符串列表。如果生成任何一个指定字符串,文本生成就会停止。

您可以在调用端点时指定这些参数的任何子集。接下来,我们将展示如何使用这些参数调用端点的示例。

代码完成

以下示例演示如何执行代码完成,其中预期端点响应是提示的自然延续。

我们首先运行以下代码:

我们得到以下输出:

对于下一个示例,我们运行以下代码:

我们得到以下输出:

代码生成

以下示例展示了使用 Code Llama 生成 Python 代码。

我们首先运行以下代码:

我们得到以下输出:

对于下一个示例,我们运行以下代码:

我们得到以下输出:

这些是使用 Code Llama 70B 执行与代码相关的任务的一些示例。您可以使用该模型生成更复杂的代码。我们鼓励您使用自己的代码相关用例和示例进行尝试!

清理

测试端点后,请确保删除 SageMaker 推理端点和模型,以避免产生费用。使用以下代码:

结论

在这篇文章中,我们介绍了 SageMaker JumpStart 上的 Code Llama 70B。 Code Llama 70B 是一种最先进的模型,用于根据自然语言提示和代码生成代码。您可以在 SageMaker JumpStart 中通过几个简单的步骤部署模型,然后使用它来执行代码相关的任务,例如代码生成和代码填充。下一步,尝试将模型与您自己的代码相关用例和数据一起使用。

关于作者

凯尔乌尔里希博士 是 Amazon SageMaker JumpStart 团队的应用科学家。 他的研究兴趣包括可扩展的机器学习算法、计算机视觉、时间序列、贝叶斯非参数和高斯过程。 他拥有杜克大学博士学位,并在 NeurIPS、Cell 和 Neuron 上发表过论文。

凯尔乌尔里希博士 是 Amazon SageMaker JumpStart 团队的应用科学家。 他的研究兴趣包括可扩展的机器学习算法、计算机视觉、时间序列、贝叶斯非参数和高斯过程。 他拥有杜克大学博士学位,并在 NeurIPS、Cell 和 Neuron 上发表过论文。

法鲁克·萨比尔博士 是 AWS 的高级人工智能和机器学习专家解决方案架构师。 他拥有德克萨斯大学奥斯汀分校的电气工程博士和硕士学位,以及佐治亚理工学院的计算机科学硕士学位。 他拥有超过 15 年的工作经验,也喜欢教授和指导大学生。 在 AWS,他帮助客户制定和解决他们在数据科学、机器学习、计算机视觉、人工智能、数值优化和相关领域的业务问题。 他和他的家人居住在得克萨斯州达拉斯,喜欢旅行和长途旅行。

法鲁克·萨比尔博士 是 AWS 的高级人工智能和机器学习专家解决方案架构师。 他拥有德克萨斯大学奥斯汀分校的电气工程博士和硕士学位,以及佐治亚理工学院的计算机科学硕士学位。 他拥有超过 15 年的工作经验,也喜欢教授和指导大学生。 在 AWS,他帮助客户制定和解决他们在数据科学、机器学习、计算机视觉、人工智能、数值优化和相关领域的业务问题。 他和他的家人居住在得克萨斯州达拉斯,喜欢旅行和长途旅行。

六月赢了 是 SageMaker JumpStart 的产品经理。 他专注于使基础模型易于发现和使用,以帮助客户构建生成式人工智能应用程序。 他在亚马逊的经验还包括移动购物应用程序和最后一英里送货。

六月赢了 是 SageMaker JumpStart 的产品经理。 他专注于使基础模型易于发现和使用,以帮助客户构建生成式人工智能应用程序。 他在亚马逊的经验还包括移动购物应用程序和最后一英里送货。

- :具有

- :是

- :不是

- :在哪里

- $UP

- 000

- 1

- 10

- 100

- 11

- 12

- 13

- 14

- 15 年

- 15%

- 16

- 22

- 25

- 500

- 7

- 80

- 9

- a

- 关于

- 接受

- 可接受

- 验收

- ACCESS

- 进步

- 协议

- AI

- 算法

- 所有类型

- 还

- Amazon

- 亚马逊SageMaker

- 亚马逊SageMaker JumpStart

- 亚马逊网络服务

- an

- 和

- 宣布

- 任何

- 应用领域

- 应用领域

- 应用的

- 适当

- 保健

- 参数

- 艺术

- 人造的

- 人工智能

- 人工智能和机器学习

- AS

- 助理

- 保证

- At

- 奥斯汀

- 可使用

- 避免

- AWS

- 基地

- 基于

- 打坏

- 贝叶斯

- BE

- 光束

- 因为

- 之间

- 亿

- 十亿代币

- 十亿美元

- 都

- 泡沫

- 建立

- 建

- 商业

- by

- C + +中

- 呼叫

- CAN

- 能力

- 卡

- 携带

- 例

- 产品类别

- 细胞

- 更改

- 特点

- 收费

- 选择

- 程

- 经典

- 清洁

- 点击

- 码

- 学院

- 如何

- 购买的订单均

- 完成

- 完成

- 复杂

- 一台

- 计算机科学

- 计算机视觉

- 组成

- 安慰

- 内容

- 上下文

- 延续

- 控制

- 外壳

- 创建信息图

- 策划

- 合作伙伴

- 达拉斯

- data

- 数据科学

- 解码

- 默认

- 交货

- 演示

- 部署

- 部署

- 部署

- 部署

- 设计

- 细节

- 发达

- 开发

- 研发支持

- 不同

- 数字

- 数码艺术

- 通过各种方式找到

- do

- 做

- 域名

- 公爵

- 杜克大学

- 每

- 此前

- 容易

- 高效

- 使

- 鼓励

- 结束

- 端至端

- 端点

- 设计

- 工程师

- 确保

- 等于

- 错误

- 评估

- 甚至

- 例子

- 例子

- Excel

- 除

- 兴奋

- 排除

- 现有

- 预期

- 昂贵

- 体验

- 指数

- 面部彩妆

- 家庭

- 少数

- 找到最适合您的地方

- (名字)

- 浮动

- 重点

- 以下

- 针对

- 基金会

- 基础

- 四

- 止

- 功能

- 生成

- 产生

- 产生

- 发电

- 代

- 代

- 生成的

- 生成式人工智能

- 得到

- 特定

- Go

- 更大的

- 贪婪

- 指导

- 有

- he

- 帮助

- 帮助

- 帮助

- 高品质

- 更高

- 他的

- 持有

- 主页

- 主持人

- 托管

- 创新中心

- How To

- HTTPS

- 中心

- 集线器

- i

- 理想

- if

- 进口

- 改善

- 改善

- in

- 包括

- 包括

- 包含

- 增量

- 信息

- 输入

- 输入

- 例

- 研究所

- 说明

- 房源搜索

- 利益

- 介绍

- IT

- 爪哇岛

- JPG

- 已知

- 凯尔

- 语言

- 大

- (姓氏)

- 学习

- 离开

- 长度

- 执照

- 可能性

- 容易

- 喜欢

- 清单

- 骆驼

- LLM

- 长

- 爱

- 降低

- 机

- 机器学习

- 制成

- 使

- 制作

- 经理

- 许多

- 提到

- 导师

- 元

- 英里

- ML

- 联络号码

- 模型

- 模型

- 更多

- 更高效

- 最先进的

- MS

- 必须

- 自然

- 旅游导航

- 需求

- 打印车票

- 决不要

- 全新

- 下页

- 注意

- 笔记本

- 现在

- 数

- of

- on

- 一

- 那些

- 仅由

- 优化

- 附加选项

- or

- 我们的

- 输出

- 产量

- 超过

- 己

- 页

- 面包

- 文件

- 参数

- 部分

- 各方

- 为

- 演出

- 执行

- 博士学位

- PHP

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 政策

- 热门

- 积极

- 可能

- 帖子

- 潜力

- 预报器

- 打印

- 打印

- 问题

- 过程

- 过程

- 产品

- 产品经理

- 生产率

- 代码编程

- 提示

- 提供

- 供应商

- 提供

- 出版

- 蟒蛇

- pytorch

- 很快

- 随机性

- 范围

- 宁

- 达到

- 上游

- 最近

- 有关

- 发布

- 重复

- 研究

- 资源

- 响应

- REST的

- 成果

- 回报

- 反转

- 检讨

- 上升

- 路

- 运行

- 运行

- sagemaker

- SageMaker 推理

- 同

- 保存

- 可扩展性

- 鳞片

- 科学

- 科学家

- SDK

- 搜索

- 选

- 选择

- 前辈

- 句子

- 序列

- 系列

- 特色服务

- 集

- 设置

- 共用的,

- 购物

- 显示

- 如图

- 作品

- 简易

- 尺寸

- So

- 软件

- 解决方案

- 解决

- 一些

- 专家

- 专门

- 指定

- 指定

- 稳定

- 开始

- 开始

- 国家的最先进的

- 步

- 步骤

- 车站

- 串

- 学生

- 工作室

- 顺利

- 这样

- SUPPORT

- 支持

- 肯定

- 周围

- 需要

- 任务

- 团队

- 专业技术

- tensorflow

- 条款

- test

- 测试

- 德州

- 文本

- 比

- 这

- 其

- 他们

- 他们自己

- 然后

- 博曼

- 第三

- 第三者

- Free Introduction

- 三

- 通过

- 次

- 时间序列

- 至

- 象征

- 令牌

- 最佳

- 培训

- 熟练

- 翻译

- 旅行

- 横过

- true

- 尝试

- 类型

- 打字稿

- 一般

- ui

- 下

- 理解

- 大学

- 直到

- 可用

- 用法

- 使用

- 用过的

- 用户

- 运用

- 折扣值

- 价值观

- 各种

- 版本

- 通过

- 愿景

- 走

- 想

- we

- 卷筒纸

- Web服务

- 井

- 为

- ,尤其是

- 是否

- 这

- 而

- 宽

- 小部件

- 将

- 中

- 也完全不需要

- Word

- 话

- 工作

- 工作流程

- 工作流程

- 写

- 年

- 完全

- 您一站式解决方案

- 和风网