এনভিডিয়া বুধবার GPU-তে নির্মিত কম্পিউটিং ক্লাস্টারগুলির দক্ষতা বাড়ানোর জন্য AI-কেন্দ্রিক Kubernetes অর্কেস্ট্রেশন প্রদানকারী Run:ai-এর অধিগ্রহণের ঘোষণা দিয়েছে।

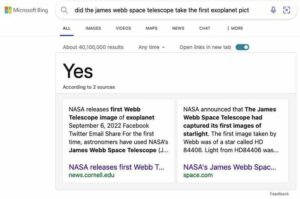

বিস্তারিত চুক্তি প্রকাশ করা হয়নি, কিন্তু জানা চুক্তির মূল্য প্রায় $700 মিলিয়ন হতে পারে। তেল আবিব ভিত্তিক স্টার্টআপ রয়েছে স্পষ্টতই এটি 118 সালে প্রতিষ্ঠিত হওয়ার পর থেকে চারটি ফান্ডিং রাউন্ড জুড়ে $2018 মিলিয়ন সংগ্রহ করেছে।

Run:ai-এর প্ল্যাটফর্ম বিভিন্ন জনপ্রিয় Kubernetes ভেরিয়েন্টের সাথে কাজ করার জন্য একটি কেন্দ্রীয় ব্যবহারকারী ইন্টারফেস এবং নিয়ন্ত্রণ সমতল প্রদান করে। এটি এটিকে কিছুটা RedHat এর OpenShift বা SUSE এর Rancher এর মত করে তোলে এবং এতে নামস্থান, ব্যবহারকারীর প্রোফাইল এবং সম্পদ বরাদ্দের মতো জিনিসগুলি পরিচালনা করার জন্য একই সরঞ্জামগুলির অনেকগুলি বৈশিষ্ট্য রয়েছে৷

মূল পার্থক্য হল Run:ai's ডিজাইন করা হয়েছে থার্ড-পার্টি AI টুলস এবং ফ্রেমওয়ার্কের সাথে একীভূত করার জন্য এবং GPU অ্যাক্সিলারেটেড কন্টেইনার পরিবেশের সাথে মোকাবিলা করার জন্য। এর সফ্টওয়্যার পোর্টফোলিওতে কাজের লোড শিডিউলিং এবং অ্যাক্সিলারেটর পার্টিশনিংয়ের মতো উপাদান রয়েছে, যার পরবর্তীটি একাধিক ওয়ার্কলোডকে একক GPU জুড়ে ছড়িয়ে দেওয়ার অনুমতি দেয়।

এনভিডিয়ার মতে, Run:ai-এর প্ল্যাটফর্ম ইতিমধ্যেই এর সুপারপড কনফিগারেশন, বেস কমান্ড ক্লাস্টার ম্যানেজমেন্ট সিস্টেম, এনজিসি কন্টেইনার লাইব্রেরি এবং একটি এআই এন্টারপ্রাইজ স্যুট সহ তার ডিজিএক্স কম্পিউট প্ল্যাটফর্মগুলিকে সমর্থন করে।

এআই কুবারনেটস বেয়ার মেটাল ডিপ্লোয়মেন্টের উপর অনেক সুবিধার দাবি করে, কারণ একাধিক, সম্ভাব্য ভৌগলিকভাবে বিতরণ করা সংস্থানগুলি জুড়ে স্কেলিং পরিচালনা করার জন্য পরিবেশ কনফিগার করা যেতে পারে।

আপাতত, বিদ্যমান Run:ai গ্রাহকদের Nvidia প্ল্যাটফর্মে বড় পরিবর্তন আনার বিষয়ে চিন্তা করতে হবে না। ক মুক্তি, এনভিডিয়া বলেছে যে এটি অবিলম্বে ভবিষ্যতের জন্য একই ব্যবসায়িক মডেলের অধীনে Run:ai-এর পণ্যগুলি অফার করা চালিয়ে যাবে — এর অর্থ যাই হোক না কেন।

ইতিমধ্যে, যারা এনভিডিয়ার ডিজিএক্স ক্লাউডে সাবস্ক্রাইব করেছে তারা তাদের এআই ওয়ার্কলোডের জন্য Run:ai-এর বৈশিষ্ট্য সেটে অ্যাক্সেস পাবে, যার মধ্যে বড় ভাষা মডেল (LLM) স্থাপনা রয়েছে।

জিপিইউ জায়ান্টের ঠিক এক মাস পরে ঘোষণাটি আসে অপাবৃত এনভিডিয়া ইনফারেন্স মাইক্রোসার্ভিসেস (NIM) নামে এআই মডেল তৈরির জন্য একটি নতুন কন্টেইনার প্ল্যাটফর্ম।

NIMS হল মূলত প্রি-কনফিগার করা এবং অপ্টিমাইজ করা কন্টেইনার ইমেজ যাতে মডেল থাকে, সেটা ওপেন সোর্স বা মালিকানাধীন সংস্করণই হোক না কেন, এটি চালানোর জন্য প্রয়োজনীয় সমস্ত নির্ভরতা সহ।

বেশিরভাগ কন্টেইনারের মতো, CUDA-এক্সিলারেটেড কুবারনেটস নোড সহ বিভিন্ন ধরনের রানটাইম জুড়ে NIMগুলি স্থাপন করা যেতে পারে।

এলএলএম এবং অন্যান্য এআই মডেলগুলিকে মাইক্রোসার্ভিসে পরিণত করার পিছনে ধারণাটি হল যে সেগুলিকে একসাথে নেটওয়ার্ক করা যেতে পারে এবং আরও জটিল এবং বৈশিষ্ট্যযুক্ত AI মডেলগুলি তৈরি করতে ব্যবহার করা যেতে পারে যা অন্যথায় নিজেকে কোনও ডেডিকেটেড মডেলকে প্রশিক্ষণ না দিয়েই সম্ভব হবে, বা অন্ততপক্ষে এইভাবে এনভিডিয়া লোকেদের ব্যবহার করে কল্পনা করে। তাদের

Run:ai-এর অধিগ্রহণের সাথে, Nvidia-এর এখন GPU অবকাঠামো জুড়ে এই NIM-এর স্থাপনা পরিচালনার জন্য একটি Kubernetes অর্কেস্ট্রেশন স্তর রয়েছে। ®

- এসইও চালিত বিষয়বস্তু এবং পিআর বিতরণ। আজই পরিবর্ধিত পান।

- PlatoData.Network উল্লম্ব জেনারেটিভ Ai. নিজেকে ক্ষমতায়িত করুন। এখানে প্রবেশ করুন.

- প্লেটোএআইস্ট্রিম। Web3 ইন্টেলিজেন্স। জ্ঞান প্রসারিত. এখানে প্রবেশ করুন.

- প্লেটোইএসজি। কার্বন, ক্লিনটেক, শক্তি, পরিবেশ সৌর, বর্জ্য ব্যবস্থাপনা. এখানে প্রবেশ করুন.

- প্লেটো হেলথ। বায়োটেক এবং ক্লিনিক্যাল ট্রায়াল ইন্টেলিজেন্স। এখানে প্রবেশ করুন.

- উত্স: https://go.theregister.com/feed/www.theregister.com/2024/04/24/runai_acquisition_nvidia/

- : আছে

- : হয়

- 2018

- a

- সম্পর্কে

- দ্রুততর

- বেগবর্ধক ব্যক্তি

- প্রবেশ

- অর্জন

- দিয়ে

- সুবিধাদি

- পর

- AI

- এআই মডেল

- লক্ষ্য

- সব

- বরাদ্দ

- অনুমতি

- ইতিমধ্যে

- an

- এবং

- ঘোষিত

- ঘোষণা

- রয়েছি

- AS

- At

- ভিত্তি

- BE

- পিছনে

- বিট

- তাকিয়া

- নির্মাণ করা

- ভবন

- নির্মিত

- ব্যবসায়

- ব্যবসা মডেল

- কিন্তু

- নামক

- CAN

- মধ্য

- পরিবর্তন

- দাবি

- মেঘ

- গুচ্ছ

- CO

- আসে

- হুকুম

- জটিল

- গনা

- কম্পিউটিং

- কনফিগার

- আধার

- কন্টেনারগুলি

- অবিরত

- নিয়ন্ত্রণ

- পারা

- CrunchBase

- গ্রাহকদের

- লেনদেন

- নিবেদিত

- নির্ভরতা

- মোতায়েন

- বিস্তৃতি

- স্থাপনার

- পরিকল্পিত

- বিস্তারিত

- পার্থক্য

- বণ্টিত

- দক্ষতা

- প্রচেষ্টা

- উপাদান

- উদ্যোগ

- পরিবেশ

- পরিবেশের

- কল্পনা

- মূলত

- বিদ্যমান

- বৈশিষ্ট্য

- বৈশিষ্ট্য

- জন্য

- উদিত

- চার

- অবকাঠামো

- তহবিল

- তহবিল রাউন্ড

- ভবিষ্যৎ

- ভৌগোলিক দিক থেকে

- পাওয়া

- দৈত্য

- জিপিইউ

- হাতল

- সাহায্য

- কিভাবে

- HTTPS দ্বারা

- ধারণা

- চিত্র

- আশু

- মনোরম

- in

- অন্তর্ভুক্ত

- সুদ্ধ

- পরিকাঠামো

- সম্পূর্ণ

- ইন্টারফেস

- মধ্যে

- IT

- এর

- JPG

- মাত্র

- চাবি

- ভাষা

- বড়

- স্তর

- অন্তত

- লাইব্রেরি

- মত

- LLM

- মুখ্য

- তৈরি করে

- পরিচালনা করা

- ব্যবস্থাপনা

- পরিচালক

- অনেক

- মে..

- গড়

- ধাতু

- microservices

- মিলিয়ন

- মডেল

- মডেল

- মাস

- অধিক

- সেতু

- বহু

- প্রয়োজনীয়

- নতুন

- এনজিসি

- নোড

- এখন

- সংখ্যা

- এনভিডিয়া

- of

- অর্পণ

- on

- খোলা

- ওপেন সোর্স

- অপ্টিমাইজ

- or

- অর্কেস্ট্রারচনা

- অন্যান্য

- অন্যভাবে

- শেষ

- সমতল

- মাচা

- প্ল্যাটফর্ম

- Plato

- প্লেটো ডেটা ইন্টেলিজেন্স

- প্লেটোডাটা

- জনপ্রিয়

- দফতর

- সম্ভব

- সম্ভাব্য

- পণ্য

- প্রোফাইল

- মালিকানা

- প্রদানকারী

- উপলব্ধ

- উত্থাপিত

- চেহারা

- সংস্থান

- Resources

- ধনী

- মোটামুটিভাবে

- চক্রের

- চালান

- দৌড়

- s

- বলেছেন

- একই

- আরোহী

- পূর্বপরিকল্পনা

- সেট

- থেকে

- একক

- সফটওয়্যার

- উৎস

- বিস্তার

- প্রারম্ভকালে

- অনুসরণ

- সমর্থন

- পদ্ধতি

- টেল

- চেয়ে

- যে

- সার্জারির

- তাদের

- তাহাদিগকে

- এইগুলো

- তারা

- কিছু

- তৃতীয় পক্ষের

- এই

- সেগুলো

- থেকে

- একসঙ্গে

- সরঞ্জাম

- প্রশিক্ষণ

- বাঁক

- অধীনে

- ব্যবহৃত

- ব্যবহারকারী

- ব্যবহারকারী ইন্টারফেস

- ব্যবহার

- দামী

- বৈচিত্র্য

- সংস্করণ

- ছিল

- বুধবার

- weren

- যাই হোক

- কিনা

- যে

- ইচ্ছা

- সঙ্গে

- ছাড়া

- কাজ

- চিন্তা

- would

- আপনার

- নিজেকে

- zephyrnet