Generativ AI modeller har potentialet til at revolutionere virksomhedens drift, men virksomheder skal nøje overveje, hvordan de kan udnytte deres magt, mens de overvinder udfordringer som at beskytte data og sikre kvaliteten af AI-genereret indhold.

RAG-rammen (Retrieval-Augmented Generation) udvider prompter med eksterne data fra flere kilder, såsom dokumentlagre, databaser eller API'er, for at gøre fundamentmodeller effektive til domænespecifikke opgaver. Dette indlæg præsenterer RAG-modellens muligheder og fremhæver det transformative potentiale i MongoDB Atlas med dens Vector Search-funktion.

MongoDB Atlas er en integreret suite af datatjenester, der accelererer og forenkler udviklingen af datadrevne applikationer. Dens vektordatalager integreres problemfrit med operationel datalagring, hvilket eliminerer behovet for en separat database. Denne integration muliggør kraftfulde semantiske søgefunktioner igennem Vektorsøgning, en hurtig måde at bygge semantisk søgning og AI-drevne applikationer på.

Amazon SageMaker gør det muligt for virksomheder at bygge, træne og implementere maskinlæringsmodeller (ML). Amazon SageMaker JumpStart leverer præ-trænede modeller og data til at hjælpe dig i gang med ML. Du kan få adgang til, tilpasse og implementere forudtrænede modeller og data via SageMaker JumpStart-landingssiden i Amazon SageMaker Studio med blot et par klik.

Amazon Lex er en samtalegrænseflade, der hjælper virksomheder med at skabe chatbots og stemmebots, der engagerer sig i naturlige, naturtro interaktioner. Ved at integrere Amazon Lex med generativ AI kan virksomheder skabe et holistisk økosystem, hvor brugerinput problemfrit går over i sammenhængende og kontekstuelt relevante svar.

Løsningsoversigt

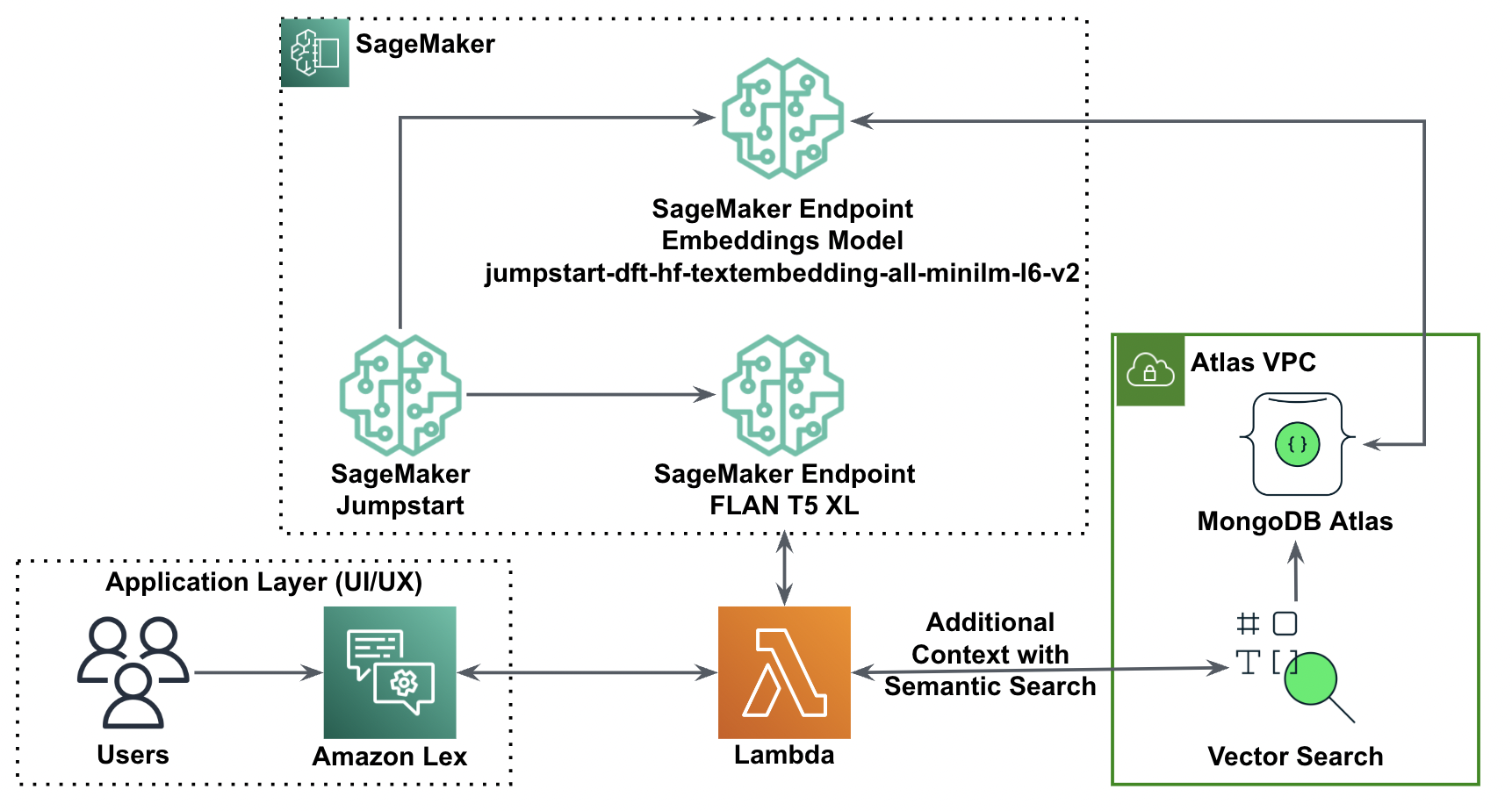

Følgende diagram illustrerer løsningsarkitekturen.

I de følgende afsnit gennemgår vi trinene for at implementere denne løsning og dens komponenter.

Opsæt en MongoDB-klynge

For at oprette en gratis MongoDB Atlas-klynge skal du følge instruktionerne i Opret en klynge. Opsæt databasen adgang og netværk adgang.

Implementer SageMaker-indlejringsmodellen

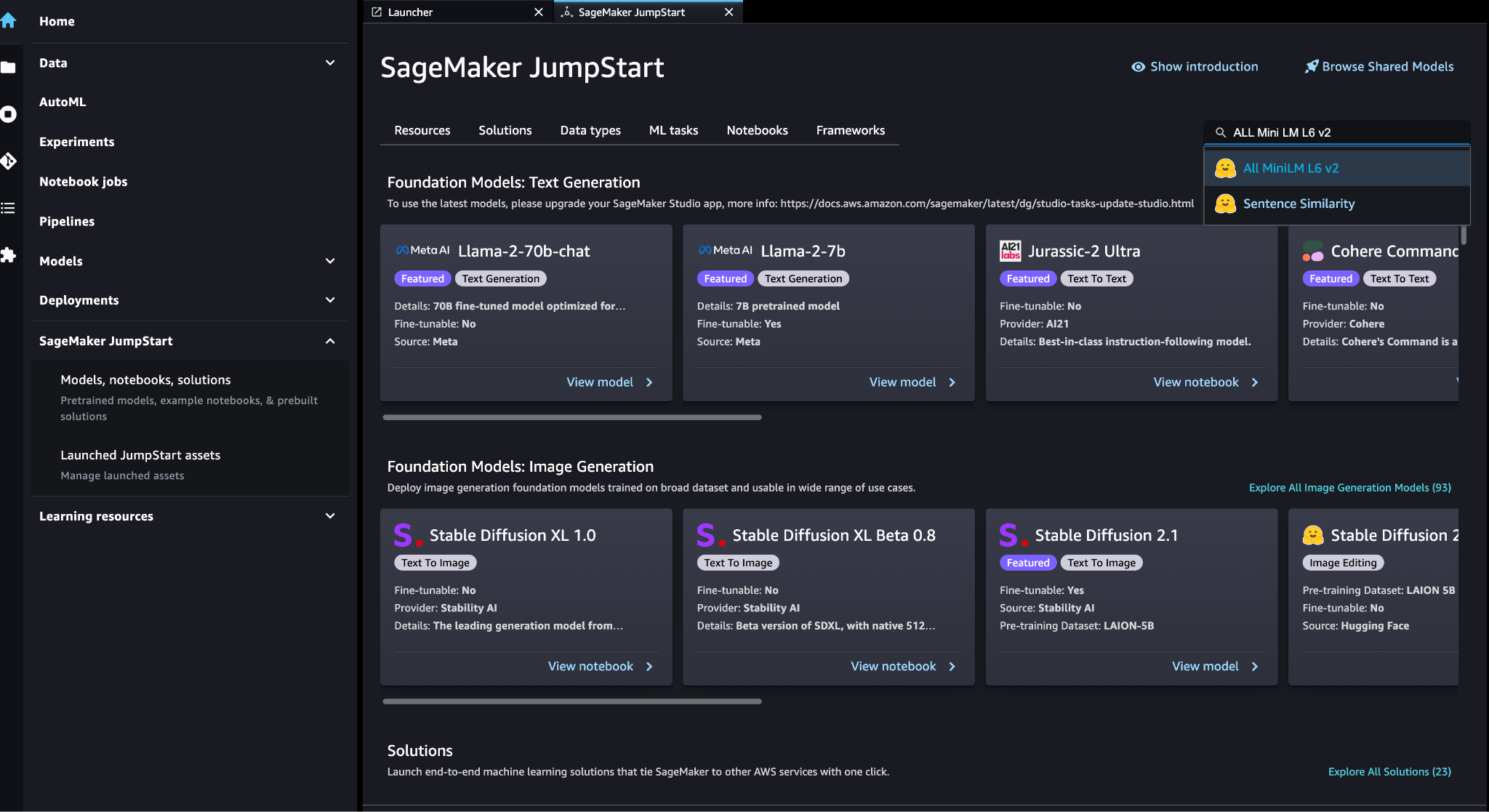

Du kan vælge indlejringsmodellen (ALL MiniLM L6 v2) på SageMaker JumpStart-modeller, notebooks, løsninger .

Vælg Implementer at implementere modellen.

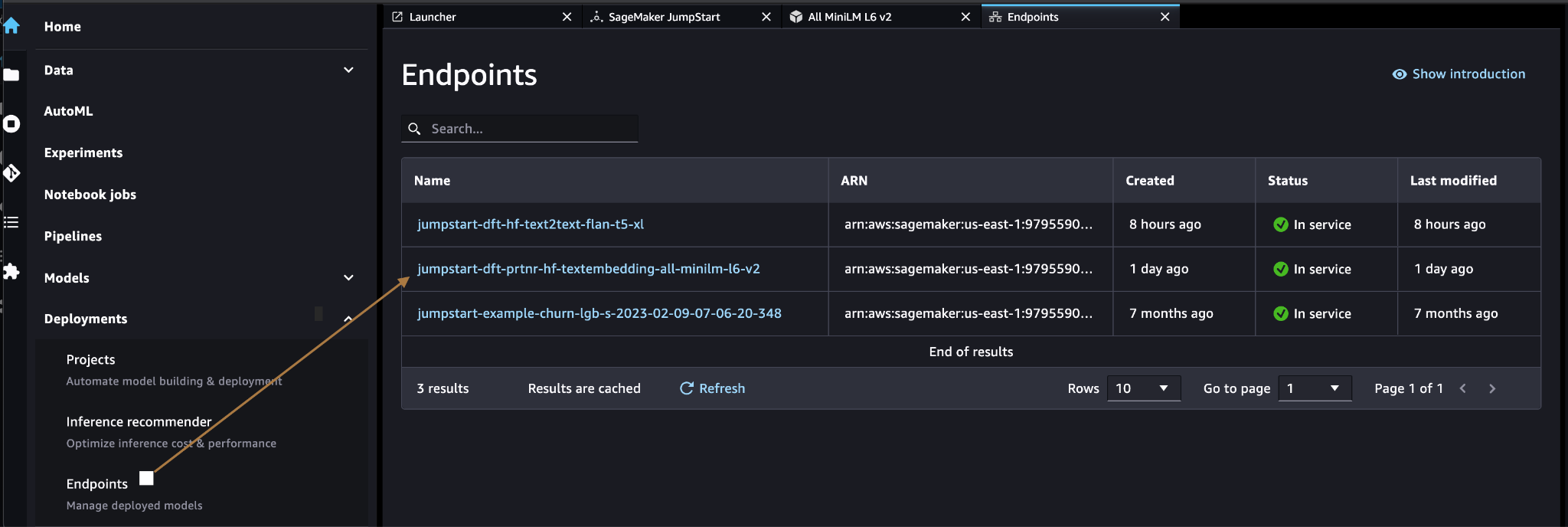

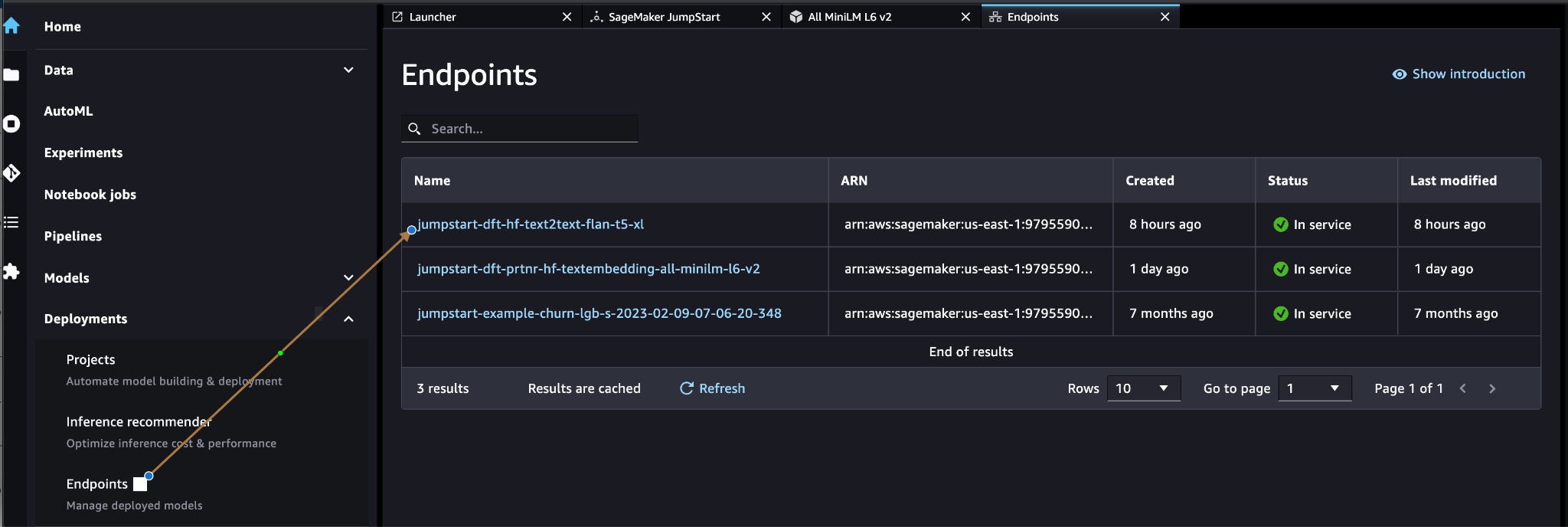

Bekræft, at modellen er implementeret korrekt, og bekræft, at slutpunktet er oprettet.

Vektor indlejring

Vektor indlejring er en proces med at konvertere en tekst eller et billede til en vektorrepræsentation. Med følgende kode kan vi generere vektorindlejringer med SageMaker JumpStart og opdatere samlingen med den oprettede vektor for hvert dokument:

payload = {"text_inputs": [document[field_name_to_be_vectorized]]}

query_response = query_endpoint_with_json_payload(json.dumps(payload).encode('utf-8'))

embeddings = parse_response_multiple_texts(query_response) # update the document

update = {'$set': {vector_field_name : embeddings[0]}}

collection.update_one(query, update)Koden ovenfor viser, hvordan man opdaterer et enkelt objekt i en samling. For at opdatere alle objekter skal du følge anvisninger.

MongoDB vektordatalager

MongoDB Atlas vektorsøgning er en ny funktion, der giver dig mulighed for at gemme og søge vektordata i MongoDB. Vektordata er en type data, der repræsenterer et punkt i et højdimensionelt rum. Denne type data bruges ofte i ML- og kunstig intelligens-applikationer. MongoDB Atlas Vector Search bruger en teknik kaldet k-nærmeste naboer (k-NN) for at søge efter lignende vektorer. k-NN virker ved at finde de k mest lignende vektorer til en given vektor. De mest lignende vektorer er dem, der er tættest på den givne vektor med hensyn til den euklidiske afstand.

Lagring af vektordata ved siden af driftsdata kan forbedre ydeevnen ved at reducere behovet for at flytte data mellem forskellige lagersystemer. Dette er især fordelagtigt for applikationer, der kræver realtidsadgang til vektordata.

Opret et vektorsøgningsindeks

Det næste skridt er at oprette en MongoDB vektorsøgningsindeks på vektorfeltet, du oprettede i det forrige trin. MongoDB bruger knnVector type for at indeksere vektorindlejringer. Vektorfeltet skal repræsenteres som en matrix af tal (kun BSON int32, int64 eller dobbelt datatyper).

Der henvises til Gennemgå knnVector Type Begrænsninger for mere information om begrænsningerne af knnVector type.

Følgende kode er et eksempel på en indeksdefinition:

{ "mappings": { "dynamic": true, "fields": { "egVector": { "dimensions": 384, "similarity": "euclidean", "type": "knnVector" } } }

}

Bemærk, at dimensionen skal matche din indlejringsmodeldimension.

Forespørg på vektordatalageret

Du kan forespørge vektordatalageret ved hjælp af Vector Search aggregeringspipeline. Den bruger vektorsøgningsindekset og udfører en semantisk søgning på vektordatalageret.

Følgende kode er et eksempel på en søgedefinition:

{ $search: { "index": "<index name>", // optional, defaults to "default" "knnBeta": { "vector": [<array-of-numbers>], "path": "<field-to-search>", "filter": {<filter-specification>}, "k": <number>, "score": {<options>} } }

}

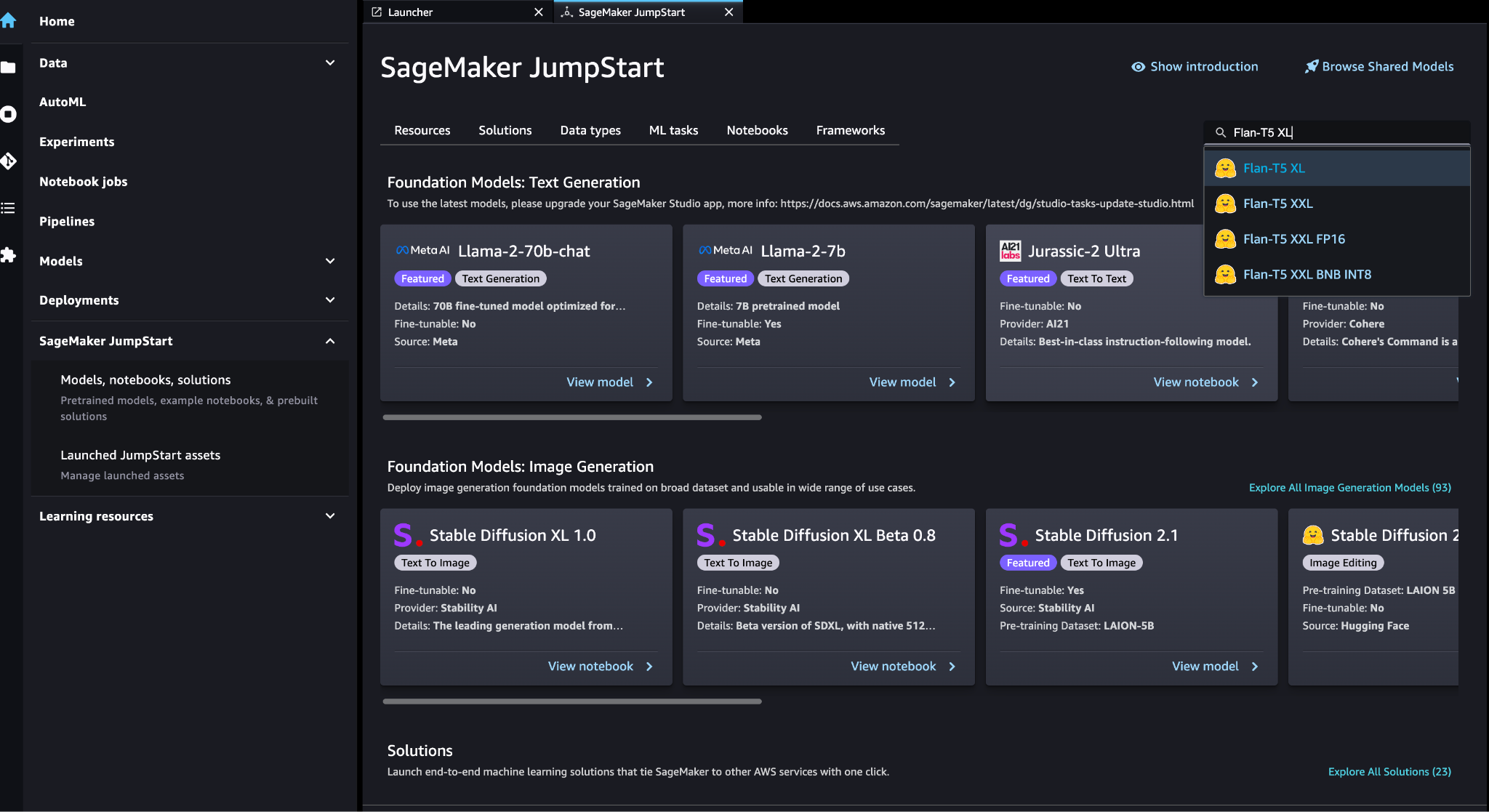

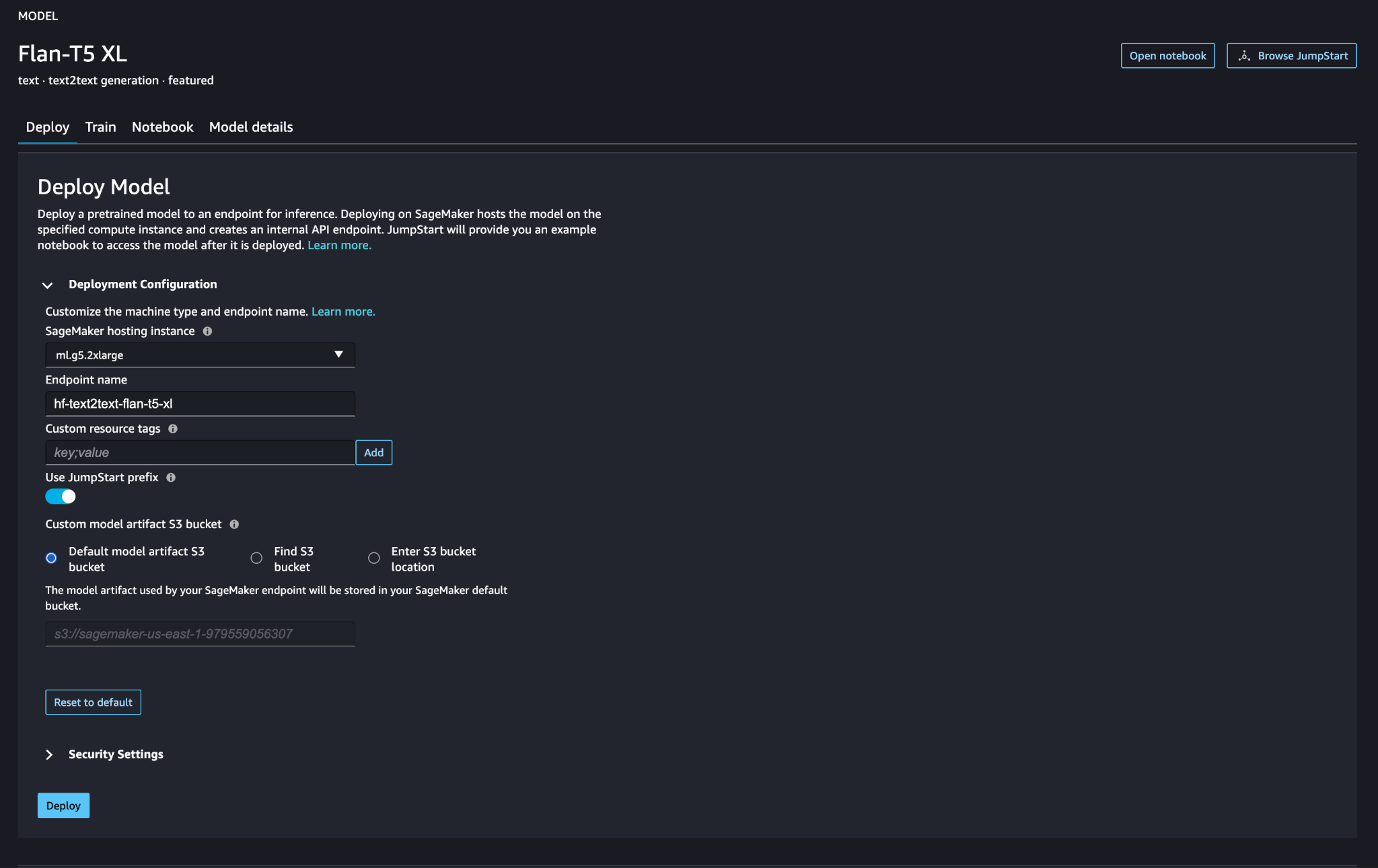

Implementer SageMaker store sprogmodel

SageMaker JumpStart foundation modeller er præ-trænede store sprogmodeller (LLM'er), der bruges til at løse en række forskellige naturlige sprogbehandlingsopgaver (NLP), såsom tekstresumé, besvarelse af spørgsmål og naturlig sproglig inferens. De fås i en række forskellige størrelser og konfigurationer. I denne løsning bruger vi Knusende ansigt FLAN-T5-XL model.

Søg efter FLAN-T5-XL-modellen i SageMaker JumpStart.

Vælg Implementer for at opsætte FLAN-T5-XL-modellen.

Bekræft, at modellen er implementeret korrekt, og at slutpunktet er aktivt.

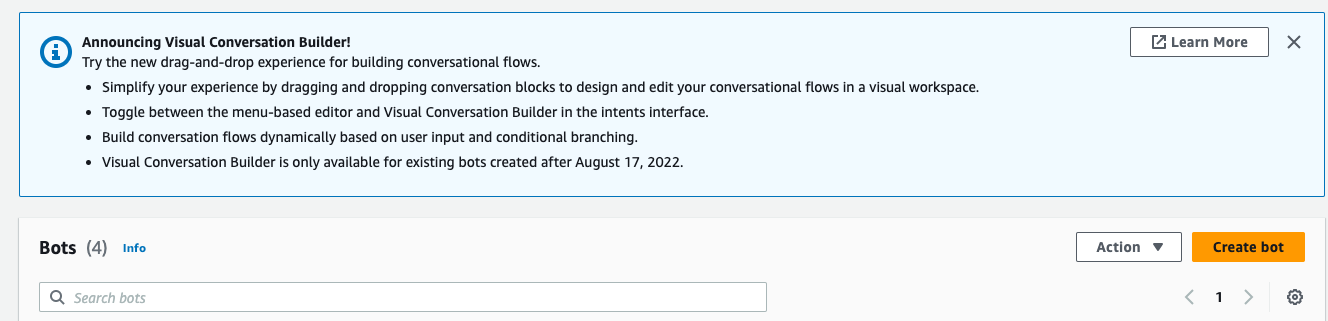

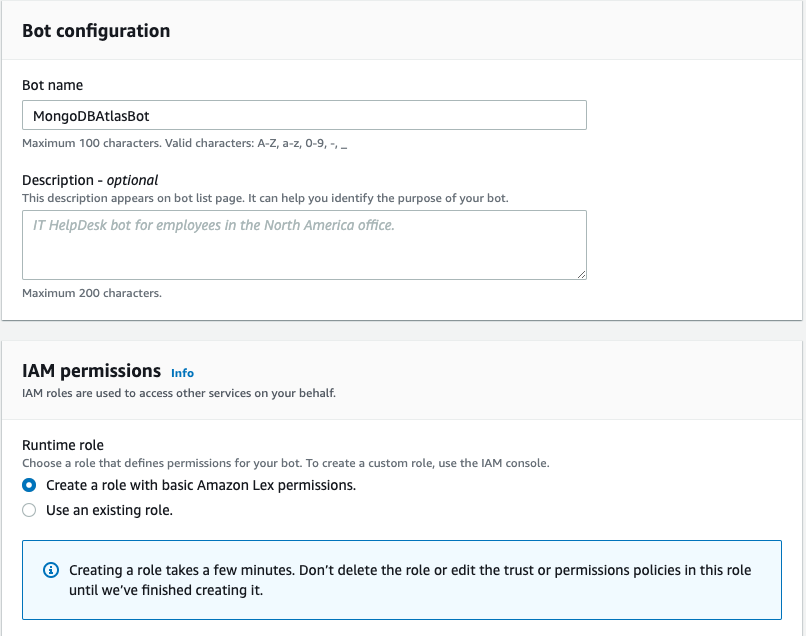

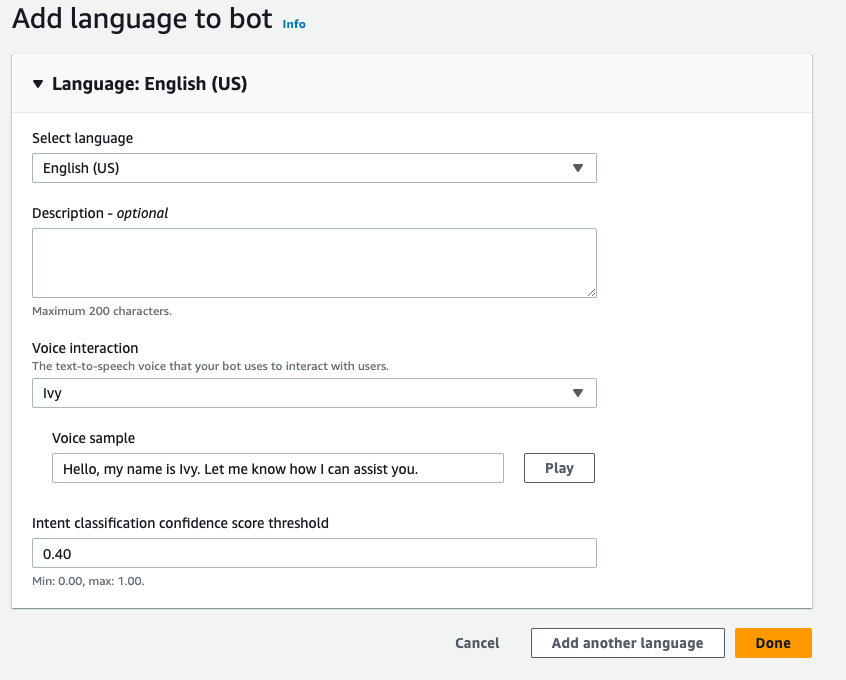

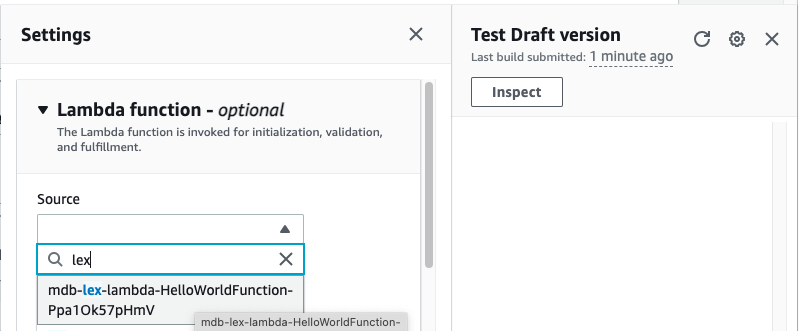

Opret en Amazon Lex-bot

For at oprette en Amazon Lex-bot skal du udføre følgende trin:

- På Amazon Lex-konsollen skal du vælge Opret bot.

- Til Bot navn, indtast et navn.

- Til Runtime rolle, Vælg Opret en rolle med grundlæggende Amazon Lex-tilladelser.

- Angiv dine sprogindstillinger, og vælg derefter Udført.

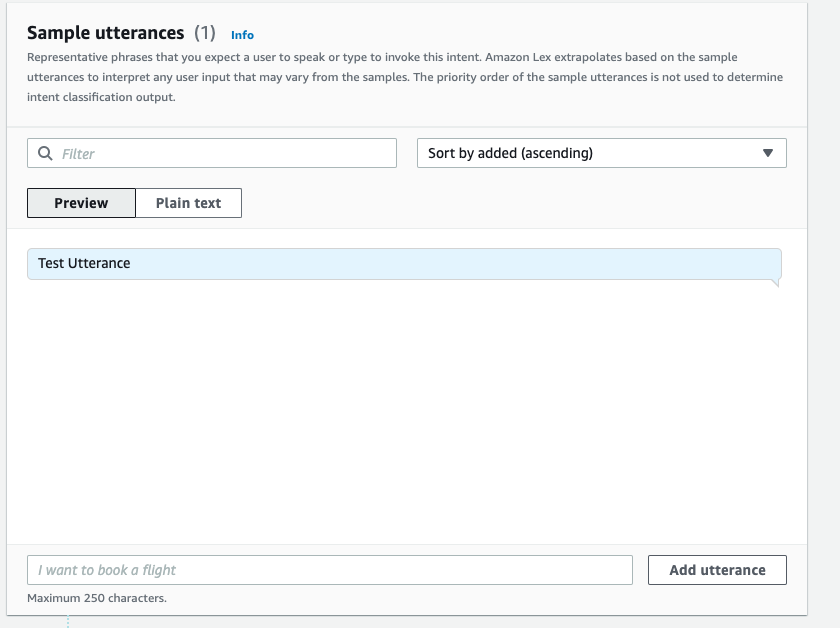

- Tilføj et eksempel på en ytring i

NewIntentUI og vælg Gem hensigten.

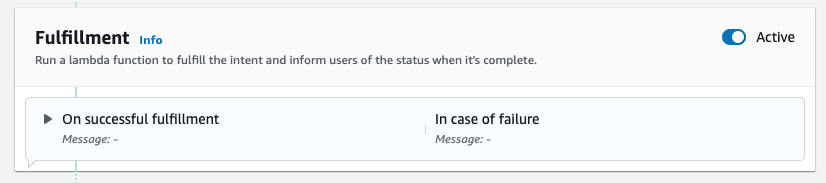

- Naviger til

FallbackIntentsom blev oprettet til dig som standard og skifte Aktiv i Opfyldelse sektion.

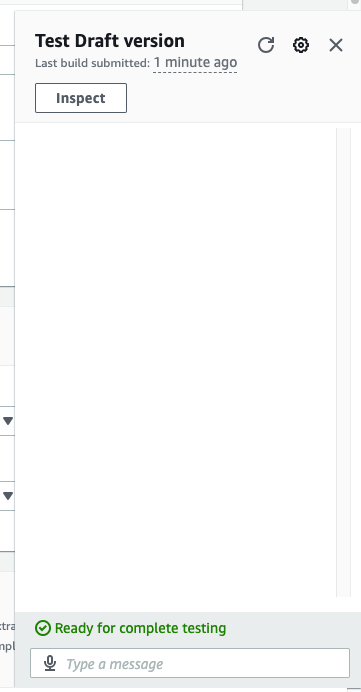

- Vælg Byg og når opbygningen er vellykket, skal du vælge Test.

- Inden du tester, skal du vælge tandhjulsikonet.

- Angiv AWS Lambda funktion, der vil interagere med MongoDB Atlas og LLM for at give svar. Følg for at oprette lambda-funktionen disse trin.

- Du kan nu interagere med LLM.

Ryd op

For at rydde op i dine ressourcer skal du udføre følgende trin:

- Slet Amazon Lex-bot.

- Slet Lambda-funktionen.

- Slet LLM SageMaker-slutpunktet.

- Slet indlejringsmodellen SageMaker-slutpunktet.

- Slet MongoDB Atlas-klyngen.

Konklusion

I indlægget viste vi, hvordan man laver en simpel bot, der bruger MongoDB Atlas semantisk søgning og integrerer med en model fra SageMaker JumpStart. Denne bot giver dig mulighed for hurtigt at prototype brugerinteraktion med forskellige LLM'er i SageMaker Jumpstart, mens du parrer dem med konteksten, der stammer fra MongoDB Atlas.

Som altid modtager AWS gerne feedback. Giv venligst din feedback og spørgsmål i kommentarfeltet.

Om forfatterne

Igor Alekseev er Senior Partner Solution Architect hos AWS i data- og analysedomæne. I sin rolle arbejder Igor med strategiske partnere, der hjælper dem med at bygge komplekse, AWS-optimerede arkitekturer. Før han kom til AWS, implementerede han som Data/Solution Architect mange projekter i Big Data-domænet, herunder flere datasøer i Hadoop-økosystemet. Som dataingeniør var han involveret i at anvende AI/ML til svindeldetektion og kontorautomatisering.

Babu Srinivasan er Senior Partner Solutions Architect hos MongoDB. I sin nuværende rolle arbejder han sammen med AWS for at bygge de tekniske integrationer og referencearkitekturer til AWS- og MongoDB-løsningerne. Han har mere end to årtiers erfaring med database- og cloud-teknologier. Han brænder for at levere tekniske løsninger til kunder, der arbejder med flere globale systemintegratorer (GSI'er) på tværs af flere geografiske områder.

Babu Srinivasan er Senior Partner Solutions Architect hos MongoDB. I sin nuværende rolle arbejder han sammen med AWS for at bygge de tekniske integrationer og referencearkitekturer til AWS- og MongoDB-løsningerne. Han har mere end to årtiers erfaring med database- og cloud-teknologier. Han brænder for at levere tekniske løsninger til kunder, der arbejder med flere globale systemintegratorer (GSI'er) på tværs af flere geografiske områder.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/retrieval-augmented-generation-with-langchain-amazon-sagemaker-jumpstart-and-mongodb-atlas-semantic-search/

- :har

- :er

- :hvor

- $OP

- 100

- 200

- 321

- 361

- 7

- 9

- a

- Om

- over

- fremskynde

- adgang

- tværs

- aktiv

- Efter

- aggregering

- AI

- AI-drevne

- AI / ML

- Alle

- tillader

- altid

- Amazon

- Amazon Lex

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- an

- analytics

- ,

- API'er

- applikationer

- Anvendelse

- arkitektur

- ER

- Array

- kunstig

- kunstig intelligens

- AS

- At

- tilføjelserne

- Automation

- til rådighed

- AWS

- AWS Lambda

- grundlæggende

- BE

- gavnlig

- mellem

- Big

- Big data

- Bot

- bots

- bygge

- virksomheder

- men

- by

- kaldet

- CAN

- kapaciteter

- omhyggeligt

- udfordringer

- chatbots

- Vælg

- ren

- Cloud

- Cluster

- kode

- SAMMENHÆNGENDE

- samling

- kommentarer

- fuldføre

- komplekse

- komponenter

- Overvej

- Konsol

- indhold

- sammenhæng

- konversation

- konvertering af

- skabe

- oprettet

- Nuværende

- Kunder

- tilpasse

- data

- data opbevaring

- datastyret

- Database

- databaser

- årtier

- Standard

- defaults

- definition

- indsætte

- indsat

- Detektion

- Udvikling

- forskellige

- Dimension

- størrelse

- afstand

- dokumentet

- domæne

- fordoble

- dynamisk

- økosystem

- Effektiv

- eliminere

- indlejring

- muliggør

- Endpoint

- engagere

- ingeniør

- sikring

- Indtast

- Enterprise

- virksomheder

- især

- Hver

- erfaring

- ekstern

- FAST

- Feature

- tilbagemeldinger

- få

- felt

- Fields

- filtrere

- finde

- følger

- efter

- Til

- Foundation

- Framework

- bedrageri

- bedrageri afsløring

- Gratis

- fra

- funktion

- Gear

- generere

- generation

- generative

- Generativ AI

- geografier

- få

- given

- Global

- seletøj

- Have

- he

- hjælpe

- hjælpe

- hjælper

- højdepunkter

- hans

- holistisk

- Hvordan

- How To

- HTML

- http

- HTTPS

- ICON

- illustrerer

- billede

- gennemføre

- implementeret

- Forbedre

- in

- Herunder

- indeks

- oplysninger

- indgang

- anvisninger

- integreret

- Integrerer

- Integration

- integration

- integrationer

- Intelligens

- interagere

- interaktion

- interaktioner

- grænseflade

- ind

- involverede

- IT

- ITS

- sammenføjning

- json

- lige

- søer

- landing

- Sprog

- stor

- læring

- Forlade

- livagtige

- begrænsninger

- LLM

- maskine

- machine learning

- lave

- mange

- Match

- ML

- model

- modeller

- MongoDB

- mere

- mest

- bevæge sig

- flere

- skal

- navn

- Natural

- Natural Language Processing

- Behov

- netværk

- Ny

- næste

- NLP

- nu

- numre

- objekt

- objekter

- of

- Office

- tit

- on

- dem

- kun

- operationelle

- Produktion

- or

- Oprindelig

- overvinde

- oversigt

- side

- parring

- partner

- partnere

- lidenskabelige

- sti

- ydeevne

- udfører

- plato

- Platon Data Intelligence

- PlatoData

- Vær venlig

- Punkt

- Indlæg

- potentiale

- magt

- vigtigste

- gaver

- tidligere

- Forud

- behandle

- forarbejdning

- projekter

- prototype

- give

- giver

- leverer

- kvalitet

- spørgsmål

- Spørgsmål

- hurtigt

- realtid

- reducere

- henvisningen

- relevant

- repræsentation

- repræsenteret

- repræsenterer

- kræver

- Ressourcer

- reaktioner

- revolutionere

- roller

- varetagelse

- sagemaker

- score

- problemfrit

- Søg

- Sektion

- sektioner

- senior

- adskille

- Tjenester

- sæt

- indstillinger

- flere

- bør

- viste

- Shows

- lignende

- Simpelt

- forenkle

- enkelt

- størrelser

- løsninger

- Løsninger

- SOLVE

- Kilder

- Space

- påbegyndt

- Trin

- Steps

- opbevaring

- butik

- Strategisk

- strategiske partnere

- vellykket

- Succesfuld

- sådan

- suite

- systemet

- Systemer

- opgaver

- Teknisk

- teknik

- Teknologier

- vilkår

- prøve

- Test

- tekst

- end

- at

- deres

- Them

- derefter

- de

- denne

- Gennem

- tier

- til

- Tog

- transformative

- overgange

- sand

- to

- typen

- typer

- ui

- Opdatering

- brug

- anvendte

- Bruger

- bruger

- ved brug af

- række

- verificere

- Voice

- gå

- var

- Vej..

- we

- web

- webservices

- Hilser velkommen

- mens

- vilje

- med

- arbejder

- virker

- Du

- Din

- zephyrnet