Lige siden ChatGPT eksploderede på teknologiscenen i november sidste år, har det hjulpet folk med at skrive alle slags materiale, generere kode og finde information. Det og andre store sprogmodeller (LLM'er) har lettet opgaver fra at udføre kundeserviceopkald til at tage fastfood-bestillinger. I betragtning af hvor nyttige LLM'er har været for mennesker i den korte tid, de har eksisteret, hvordan kan en ChatGPT for robotter påvirke deres evne til at lære og gøre nye ting? Forskere ved Google DeepMind besluttede at finde ud af det og publicerede deres resultater i en blogindlæg og papir udgivet i sidste uge.

De kalder deres system RT-2. Det er en forkortelse for robottransformator 2, og det er efterfølgeren til robottransformer 1, som selskabet udgav i slutningen af sidste år. RT-1 var baseret på et lille sprog- og visionsprogram og specifikt trænet til at udføre mange opgaver. Softwaren blev brugt i Alphabet X's Hverdagslige robotter, hvilket gør dem i stand til at udføre over 700 forskellige opgaver med en succesrate på 97 procent. Men når de blev bedt om at udføre nye opgaver, de ikke var uddannet til, var robotter, der brugte RT-1, kun succesfulde 32 procent af tiden.

RT-2 fordobler næsten denne hastighed og udfører med succes nye opgaver 62 procent af tiden, den bliver bedt om. Forskerne kalder RT-2 for en vision-language-action (VLA) model. Den bruger tekst og billeder, den ser online til at lære nye færdigheder. Det er ikke så enkelt, som det lyder; det kræver, at softwaren først "forstår" et koncept, derefter anvender denne forståelse på en kommando eller et sæt instruktioner og derefter udfører handlinger, der opfylder disse instruktioner.

Et eksempel, som avisens forfattere giver, er bortskaffelse af affald. I tidligere modeller skulle robottens software først trænes til at identificere affald. For eksempel, hvis der er en skrællet banan på et bord med skrællen ved siden af, vil botten blive vist, at skrællen er skrald, mens bananen ikke er det. Det ville så blive lært, hvordan man samler skrællen op, flytter den til en skraldespand og deponerer den der.

RT-2 fungerer dog lidt anderledes. Da modellen har trænet på masser af information og data fra internettet, har den en generel forståelse af, hvad affald er, og selvom den ikke er trænet til at smide affald væk, kan den sammensætte trinene til at fuldføre denne opgave.

De LLM'er, forskerne brugte til at træne RT-2, er PaLI-X (en visions- og sprogmodel med 55 milliarder parametre), og PALM-E (det Google kalder en indlejret multimodal sprogmodel, udviklet specifikt til robotter, med 12 milliarder parametre). "Parameter" refererer til en egenskab, som en maskinlæringsmodel definerer baseret på dens træningsdata. I tilfælde af LLM'er modellerer de forholdet mellem ord i en sætning og afvejer, hvor sandsynligt det er, at et givet ord vil blive indledt eller efterfulgt af et andet ord.

Gennem at finde relationer og mønstre mellem ord i et kæmpe datasæt, lærer modellerne af deres egne slutninger. De kan efterhånden finde ud af, hvordan forskellige begreber relaterer til hinanden og skelne kontekst. I RT-2's tilfælde omsætter den den viden til generaliserede instruktioner til robothandlinger.

Disse handlinger er repræsenteret for robotten som tokens, som normalt bruges til at repræsentere naturlig sprogtekst i form af ordfragmenter. I dette tilfælde er tokens dele af en handling, og softwaren binder flere tokens sammen for at udføre en handling. Denne struktur gør det også muligt for softwaren at udføre kæde-af-tanke-ræsonnement, hvilket betyder, at den kan svare på spørgsmål eller prompter, der kræver en vis grad af ræsonnement.

Eksempler holdet giver omfatter at vælge en genstand, der skal bruges som hammer, når der ikke er nogen hammer tilgængelig (robotten vælger en sten) og at vælge den bedste drik til en træt person (robotten vælger en energidrik).

"RT-2 viser forbedrede generaliseringsevner og semantisk og visuel forståelse ud over de robotdata, den blev udsat for," skrev forskerne i en Google blogindlæg. "Dette inkluderer fortolkning af nye kommandoer og reaktion på brugerkommandoer ved at udføre rudimentære ræsonnementer, såsom ræsonnement om objektkategorier eller beskrivelser på højt niveau."

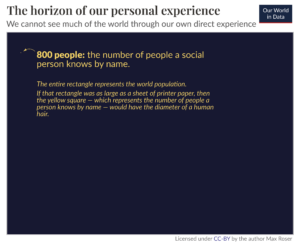

Drømmen om robotter til generelle formål der kan hjælpe mennesker med hvad end der måtte opstå – hvad enten det er i et hjem, i en kommerciel eller en industriel setting – vil ikke være opnåelige, før robotter kan lære på farten. Det, der virker som det mest grundlæggende instinkt for os, er for robotter en kompleks kombination af at forstå kontekst, at kunne ræsonnere igennem den og tage handlinger for at løse problemer, der ikke var forventet at dukke op. Det er umuligt at programmere dem til at reagere passende på en række uplanlagte scenarier, så de skal være i stand til at generalisere og lære af erfaring, ligesom mennesker gør.

RT-2 er et skridt i denne retning. Forskerne anerkender dog, at selvom RT-2 kan generalisere semantiske og visuelle begreber, er den endnu ikke i stand til at lære nye handlinger på egen hånd. Den anvender snarere de handlinger, den allerede kender til nye scenarier. Måske vil RT-3 eller 4 være i stand til at tage disse færdigheder til det næste niveau. I mellemtiden, som holdet afslutter i deres blogindlæg, "Selvom der stadig er en enorm mængde arbejde, der skal gøres for at aktivere nyttige robotter i menneskecentrerede miljøer, viser RT-2 os en spændende fremtid for robotteknologi lige inden for rækkevidde."

Billede Credit: Google DeepMind

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Automotive/elbiler, Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- BlockOffsets. Modernisering af miljømæssig offset-ejerskab. Adgang her.

- Kilde: https://singularityhub.com/2023/08/02/deepminds-chatgpt-like-brain-for-robots-lets-them-learn-from-the-internet/

- :har

- :er

- :ikke

- $OP

- 12

- 32

- 700

- a

- evne

- I stand

- Om

- anerkende

- Handling

- aktioner

- Alle

- Alfabet

- allerede

- også

- beløb

- an

- ,

- En anden

- Forventet

- Indløs

- passende

- ER

- omkring

- AS

- At

- forfattere

- til rådighed

- væk

- Banan

- baseret

- grundlæggende

- BE

- været

- være

- BEDSTE

- mellem

- Beyond

- Billion

- Bot

- Brain

- men

- by

- ringe

- Opkald

- CAN

- kapaciteter

- bære

- tilfælde

- kategorier

- ChatGPT

- vælge

- kode

- kombination

- Kom

- kommerciel

- selskab

- fuldføre

- komplekse

- Konceptet

- begreber

- sammenhæng

- kredit

- kunde

- Kundeservice

- data

- besluttede

- DeepMind

- definerer

- Degree

- depositum

- udviklet

- forskellige

- retning

- do

- færdig

- Doubles

- drøm

- Drikke

- hver

- muliggøre

- muliggør

- muliggør

- ende

- energi

- miljøer

- til sidst

- eksempel

- spændende

- erfaring

- udsat

- lettes

- FAST

- Figur

- Finde

- finde

- fund

- Fornavn

- efterfulgt

- mad

- Til

- formular

- fra

- fremtiden

- Generelt

- generere

- kæmpe

- Giv

- given

- giver

- Go

- forståelse

- hammer

- Have

- hjælpe

- hjælpsom

- hjælpe

- højt niveau

- Home

- Hvordan

- How To

- HTML

- HTTPS

- Mennesker

- identificere

- if

- billeder

- KIMOs Succeshistorier

- umuligt

- forbedret

- in

- omfatter

- omfatter

- industrielle

- oplysninger

- anvisninger

- Internet

- ind

- IT

- ITS

- jpg

- lige

- viden

- Sprog

- stor

- Efternavn

- Sidste år

- LÆR

- læring

- Lets

- Niveau

- ligesom

- Sandsynlig

- lidt

- belastninger

- maskine

- machine learning

- mange

- materiale

- max-bredde

- Kan..

- betyder

- mellemtiden

- måske

- model

- modeller

- mest

- bevæge sig

- flere

- Natural

- Behov

- Ny

- næste

- ingen

- november

- objekt

- of

- on

- online

- kun

- på

- or

- ordrer

- Andet

- ud

- i løbet af

- egen

- Papir

- parametre

- dele

- mønstre

- Mennesker

- procent

- Udfør

- udfører

- måske

- person,

- pick

- stykke

- plato

- Platon Data Intelligence

- PlatoData

- pop

- tidligere

- problemer

- Program

- Programmering

- offentliggjort

- Spørgsmål

- Sats

- hellere

- Reagerer

- grund

- refererer

- Relationer

- frigivet

- repræsentere

- repræsenteret

- kræver

- Kræver

- forskere

- Svar

- reagere

- robot

- robotteknik

- robotter

- klippe

- s

- scenarier

- scene

- synes

- Sees

- dømme

- tjeneste

- sæt

- indstilling

- Kort

- vist

- Shows

- Simpelt

- siden

- færdigheder

- lille

- So

- Software

- SOLVE

- nogle

- specifikt

- Trin

- Steps

- Stadig

- struktur

- succes

- vellykket

- Succesfuld

- sådan

- systemet

- bord

- Tag

- tager

- Opgaver

- opgaver

- undervist

- hold

- tech

- at

- deres

- Them

- derefter

- Der.

- Disse

- de

- ting

- denne

- dem

- selvom?

- Gennem

- tid

- træt

- til

- sammen

- Tokens

- Tog

- uddannet

- Kurser

- transformer

- enorm

- forståelse

- indtil

- us

- brug

- anvendte

- Bruger

- bruger

- ved brug af

- sædvanligvis

- række

- vision

- var

- uge

- veje

- var

- Hvad

- uanset

- hvornår

- som

- mens

- vilje

- med

- inden for

- ord

- ord

- Arbejde

- virker

- ville

- skriver

- skrev

- X'er

- år

- endnu

- zephyrnet