Sam var seks måneder gammel, da han første gang spændte et letvægtskamera fast på sin pande.

I det næste halvandet år, kameraet fangede uddrag af hans liv. Han kravlede rundt om familiens kæledyr, så sine forældre lave mad og græd på verandaen med bedstemor. Hele tiden optog kameraet alt, hvad han hørte.

Det, der lyder som en sød hjemmevideo til småbørn, er faktisk et vovet koncept: Kan AI lære sprog som et barn? Resultaterne kunne også afsløre, hvordan børn hurtigt tilegner sig sprog og begreber i en tidlig alder.

En ny undersøgelse in Videnskab beskriver, hvordan forskere brugte Sams optagelser til at træne en AI til at forstå sprog. Med kun en lillebitte del af et barns livserfaring over et år, var AI i stand til at forstå grundlæggende koncepter - for eksempel en bold, en sommerfugl eller en spand.

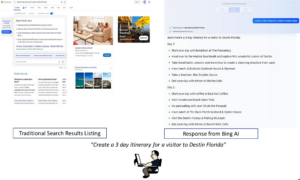

AI, kaldet Child's View for Contrastive Learning (CVCL), efterligner groft sagt, hvordan vi lærer som småbørn ved at matche syn med lyd. Det er en meget anderledes tilgang end den, der tages af store sprogmodeller som dem bag ChatGPT eller Bard. Disse modellers uhyggelige evne til at lave essays, poesi eller endda podcast-manuskripter har begejstret verden. Men de er nødt til at fordøje billioner af ord fra en lang række nyhedsartikler, manuskripter og bøger for at udvikle disse færdigheder.

Børn derimod lærer med langt mindre input og generaliserer hurtigt deres læring, efterhånden som de vokser. Forskere har længe spekuleret på, om kunstig intelligens kan fange disse evner alene med hverdagsoplevelser.

"Vi viser for første gang, at et neuralt netværk trænet på dette udviklingsmæssigt realistiske input fra et enkelt barn kan lære at knytte ord til deres visuelle modstykker," undersøgelsesforfatter Dr. Wai Keen Vong ved NYU's Center for Data Science sagde i en pressemeddelelse om forskningen.

Børns leg

Børn opsuger nemt ord og deres betydninger fra hverdagens erfaringer.

Ved blot seks måneder gamle begynder de at forbinde ord med det, de ser - for eksempel er en rund hoppende ting en "bold". I en alder af to år kender de omkring 300 ord og deres begreber.

Forskere har længe diskuteret, hvordan dette sker. En teori siger, at børn lærer at matche det, de ser, med det, de hører. En anden antyder, at sprogindlæring kræver en bredere oplevelse af verden, såsom social interaktion og evnen til at ræsonnere.

Det er svært at pirre disse ideer fra hinanden med traditionelle kognitive tests hos småbørn. Men vi kan måske få et svar ved at træne en AI gennem øjne og ører på et barn.

M3GAN?

Den nye undersøgelse benyttede en rig videoressource kaldet SAYCam, som omfatter data indsamlet fra tre børn mellem 6 og 32 måneder gamle ved hjælp af GoPro-lignende kameraer fastspændt til deres pande.

To gange om ugen optog kameraerne omkring en times optagelser og lyd, mens de ammede, kravlede og spillede. Al hørbar dialog blev transskriberet til "ytringer" - ord eller sætninger, der blev sagt, før taleren eller samtalen ændrede sig. Resultatet er et væld af multimediedata fra babyer og småbørns perspektiv.

Til det nye system designede holdet to neurale netværk med en "dommer" til at koordinere dem. Man oversatte førstepersons-visuals til whos og whats af en scene – er det en mor, der laver mad? Den anden tydede ord og betydninger fra lydoptagelserne.

De to systemer blev derefter korreleret i tid, så AI lærte at forbinde korrekte billeder med ord. For eksempel lærte AI at matche et billede af en baby med ordene "Se, der er en baby" eller et billede af en yogabold til "Wow, det er en stor bold." Med træning lærte den gradvist at adskille begrebet yogabold fra en baby.

"Dette giver modellen et fingerpeg om, hvilke ord der skal forbindes med hvilke objekter," sagde Vong.

Holdet trænede derefter AI på videoer fra omkring halvandet år af Sams liv. Tilsammen udgjorde det over 600,000 videoframes, parret med 37,500 transskriberede ytringer. Selvom tallene lyder store, er de omtrent kun én procent af Sams daglige vågne liv og jordnødder sammenlignet med mængden af data, der bruges til at træne store sprogmodeller.

Baby AI på vej

For at teste systemet tilpassede holdet en fælles kognitiv test, der bruges til at måle børns sproglige evner. De viste AI'en fire nye billeder - en kat, en tremmeseng, en bold og en græsplæne - og spurgte, hvilken der var bolden.

Alt i alt valgte AI det korrekte billede omkring 62 procent af tiden. Ydeevnen matchede næsten en state-of-the-art algoritme trænet på 400 millioner billed- og tekstpar fra nettet - størrelsesordener flere data end det, der blev brugt til at træne AI'en i undersøgelsen. De fandt ud af, at det var afgørende at forbinde videobilleder med lyd. Da holdet blandede videoframes og deres tilhørende ytringer, brød modellen fuldstændig sammen.

AI'en kunne også "tænke" ud af boksen og generalisere til nye situationer.

I en anden test blev den trænet i Sams perspektiv af en billedbog, da hans forælder sagde: "Det er en and og en sommerfugl." Senere holdt han en legetøjssommerfugl op, da han blev spurgt: "Kan du lave sommerfuglen?" Da den blev udfordret med flerfarvede sommerfuglebilleder - dem, AI aldrig havde set før - opdagede den tre ud af fire eksempler på "sommerfugle" med en nøjagtighed på over 80 procent.

Ikke alle ordbegreber scorede det samme. For eksempel var "skeen" en kamp. Men det er værd at påpege, at som en hård reCAPTCHA, træningsbillederne var svære at tyde selv for et menneske.

Vokseværk

AI bygger på de seneste fremskridt inden for multimodal maskinlæring, som kombinerer tekst, billeder, lyd eller video for at træne en maskinhjerne.

Med input fra blot et enkelt barns oplevelse var algoritmen i stand til at fange, hvordan ord relaterer til hinanden og koble ord til billeder og begreber. Det tyder på, at for småbørn at høre ord og matche dem til det, de ser, hjælper det med at opbygge deres ordforråd.

Det betyder ikke, at andre hjerneprocesser, såsom sociale signaler og ræsonnement, ikke spiller ind. Tilføjelse af disse komponenter til algoritmen kunne potentielt forbedre den, skrev forfatterne.

Holdet planlægger at fortsætte eksperimentet. I øjeblikket lærer "baby" AI'en kun fra stillbilleder og har et ordforråd, der hovedsageligt består af substantiver. At integrere videosegmenter i træningen kan hjælpe AI med at lære verber, fordi video inkluderer bevægelse.

Tilføjelse af intonation til taledata kan også hjælpe. Børn lærer tidligt, at en mors "hmm" kan have vidt forskellige betydninger afhængigt af tonen.

Men overordnet set er kombinationen af kunstig intelligens og livserfaringer en stærk ny metode til at studere både maskin- og menneskehjerner. Det kan hjælpe os med at udvikle nye AI-modeller, der lærer som børn, og potentielt omforme vores forståelse af, hvordan vores hjerne lærer sprog og begreber.

Billedkredit: Wai Keen Vong

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://singularityhub.com/2024/02/01/an-ai-just-learned-language-through-the-eyes-and-ears-of-a-toddler/

- :har

- :er

- :ikke

- $OP

- 000

- 300

- 32

- 400

- 500

- 600

- 80

- a

- evner

- evne

- I stand

- Om

- over

- nøjagtighed

- erhverve

- faktisk

- tilføje

- fremskridt

- alder

- AI

- AI modeller

- algoritme

- Alle

- alene

- også

- Skønt

- beløb

- an

- ,

- En anden

- besvare

- fra hinanden

- tilgang

- omkring

- artikler

- AS

- Associate

- forbundet

- At

- lyd

- forfatter

- forfattere

- Baby

- bold

- grundlæggende

- BE

- fordi

- før

- begynde

- mellem

- Big

- bog

- Bøger

- både

- Boks

- Brain

- bredere

- Broke

- bygge

- bygger

- men

- by

- kaldet

- værelse

- kameraer

- CAN

- fange

- fanget

- KAT

- center

- udfordret

- Ændringer

- ChatGPT

- barn

- Børn

- kognitive

- kombinerer

- kombinerer

- Kom

- Fælles

- sammenlignet

- fuldstændig

- komponenter

- Indeholder

- Konceptet

- begreber

- Tilslut

- fortsæt

- kontrast

- Samtale

- koordinere

- korrigere

- kunne

- modparter

- håndværk

- kredit

- afgørende

- dagligt

- data

- datalogi

- dechifrere

- Afhængigt

- beskriver

- konstrueret

- opdaget

- udvikle

- Dialog

- forskellige

- Fordøje

- do

- Dont

- ned

- dr

- hver

- Tidligt

- nemt

- Endog

- Hver

- hverdagen

- at alt

- eksempel

- eksempler

- erfaring

- Oplevelser

- eksperiment

- Øjne

- langt

- Fornavn

- første gang

- Til

- pande

- fundet

- fire

- fra

- forsiden

- få

- gradvist

- forståelse

- Grow

- havde

- Halvdelen

- sker

- Hård Ost

- Have

- he

- hørt

- høre

- Held

- hjælpe

- hjælper

- hans

- Home

- time

- Hvordan

- http

- HTTPS

- menneskelig

- ideer

- if

- billede

- billeder

- Forbedre

- in

- omfatter

- indgang

- instans

- Integration

- interaktion

- ind

- IT

- lige

- bare en

- Keen

- børn

- Kend

- Sprog

- stor

- senere

- LÆR

- lærte

- læring

- lærer

- mindre

- Livet

- letvægt

- ligesom

- LINK

- Linking

- Lang

- maskine

- Match

- matchede

- matchende

- Kan..

- betydninger

- måle

- metode

- million

- model

- modeller

- mor

- måned

- mere

- for det meste

- bevægelse

- multimedie

- næsten

- Behov

- netværk

- net

- neurale

- neurale netværk

- neurale netværk

- aldrig

- Ny

- nyheder

- næste

- NIH

- substantiver

- nu

- numre

- objekter

- of

- Gammel

- on

- ONE

- dem

- kun

- på

- or

- Andet

- vores

- ud

- uden for

- i løbet af

- samlet

- parret

- par

- forældre

- procent

- ydeevne

- perspektiv

- Kjæledyr

- plukket

- billede

- planer

- plato

- Platon Data Intelligence

- PlatoData

- Leg

- spillet

- podcast

- Poetry

- del

- potentielt

- vigtigste

- trykke

- Processer

- giver

- hurtigt

- realistisk

- grund

- nylige

- registreres

- Kræver

- forskning

- forskere

- omforme

- ressource

- resultere

- Resultater

- afsløre

- Rich

- groft

- rundt

- Said

- samme

- siger

- siger

- Videnskab

- forskere

- scripts

- se

- set

- segmenter

- adskille

- bør

- Vis

- viste

- Syn

- enkelt

- situationer

- SIX

- Seks måneder

- færdigheder

- So

- Social

- Lyd

- lyde

- Højttaler

- tale

- talt

- state-of-the-art

- Stadig

- Kamp

- Studere

- sådan

- foreslår

- systemet

- Systemer

- taget

- Tappet

- hold

- prøve

- tests

- tekst

- end

- at

- verdenen

- deres

- Them

- derefter

- teori

- Disse

- de

- ting

- denne

- tre

- begejstret

- Gennem

- tid

- til

- sammen

- TONE

- hård

- traditionelle

- Tog

- uddannet

- Kurser

- billioner

- to

- forstå

- forståelse

- us

- anvendte

- ved brug af

- række

- langt

- meget

- video

- Videoer

- Specifikation

- visuel

- visuals

- var

- Overvågede

- we

- Rigdom

- uge

- var

- Hvad

- Whats

- hvornår

- som

- mens

- bred

- med

- ord

- ord

- world

- værd

- skrev

- år

- år

- Yoga

- Du

- zephyrnet