For at opmuntre teknikere og ingeniører til at prøve sin AI-accelerationshardware, har Intel sammensat en masse softwarereferencesæt, som det hævder vil reducere den tid og de ressourcer, der kræves for at implementere maskinlæringssystemer på sit silicium.

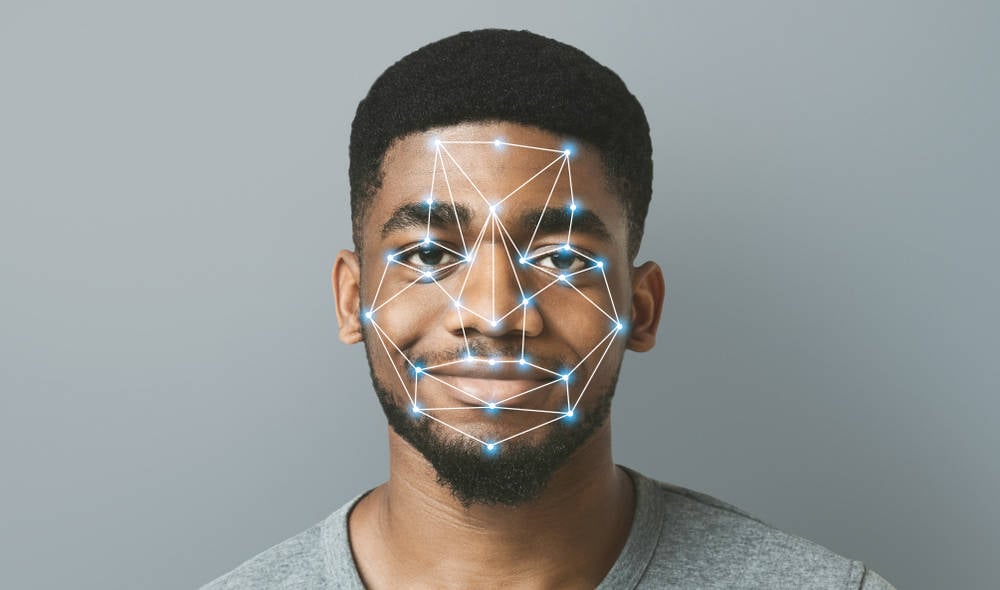

Som du kunne forvente, er 34 open source referencesæt adressere en række almindelige AI/ML-arbejdsbelastninger – lige fra store sprogmodeller, der bruges til at drive chatbots og anden generativ AI, til mere hverdagsagtige opgaver som objektdetektering, stemmegenerering og forudsigelse af økonomisk risiko.

Intel siger, at hvert sæt, udviklet i samarbejde med Accenture, indeholder al den nødvendige modelkode, træningsdata, biblioteker, openAPI-komponenter og instruktioner, der er nødvendige for at implementere dem på Intel-hardware. Vi får at vide, at referencesættene vil blive opdateret med jævne mellemrum baseret på feedback fra fællesskabet.

For at være klar, ser disse kits ud til at være rent software: du leverer (Intel inde) hardwaren og bruger derefter de givne kits til at bygge applikationer på dem.

Intel har en hel del acceleratorer og GPU'er, der er i stand til at køre denne slags AI-apps - inklusive dets Habana Gaudi2-træningsprocessorer, Ponte Vecchio GPU'er og de avancerede Matrix-udvidelser, der er indbygget i Intels Sapphire Rapids Xeon Scalable-processorer.

På trods af al hypen omkring generativ AI, har Intels acceleratorer dog ikke nydt den offentlige opmærksomhed og udbredte adoption, som Nvidias GPU'er har. Men på grund af de store klynger af GPU-noder, der kræves for at træne de største og mest imponerende modeller – de store cloud-udbydere implementerer titusindvis af GPU'er og acceleratorer netop af denne grund – kan Intel ende med at score sejre, simpelthen fordi kunderne ikke kan få fingrene i Nvidias kort i passende mængder eller rimelige priser.

Som rapporteret af vores søskendeside Den næste platform, Nvidias H100 PCIe-kort – ikke engang den mest kraftfulde version af GPU’en – er blevet fik øje på sælges for så meget som $40,000 pr. pop på eBay.

Så hvis Intel kan sænke barrieren for at implementere AI-arbejdsbelastninger på sine acceleratorer, er det en grund til, at x86-titanen skal have lettere ved at overbevise kunder om at købe dens dele - især de dyrere.

Selvfølgelig er Intel ikke alene i denne strategi. Nvidia har allerede fundet stor succes med at udvikle og kommercialisere software fremskyndet af sine GPU'er. Sidste år understregede CFO Colette Kress vigtigheden af en sådan abonnementssoftware for at få accelerationsmesterens indtægter op på en høj $ 1 billioner.

AMD er også blevet mere aggressiv med at skubbe sine egne GPU'er og acceleratorer til AI. I juni det detaljeret dens Instinct MI300 APU'er og GPU'er, som er designet til at konkurrere direkte med Nvidia i både HPC og AI/ML arenaerne. Udover det nye silicium, også chipmakeren annoncerede et strategisk partnerskab med Hugging Face, som udvikler værktøjer til at bygge ML-apps, for at optimere populære AI-modeller til AMD's Instinct GPU'er, Alveo FPGA'er og Epyc og Ryzen CPU'er. ®

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Automotive/elbiler, Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- BlockOffsets. Modernisering af miljømæssig offset-ejerskab. Adgang her.

- Kilde: https://go.theregister.com/feed/www.theregister.com/2023/07/25/intel_ai_sdk/

- :har

- :ikke

- $OP

- 000

- a

- Om

- accelereret

- acceleratorer

- Accenture

- adresse

- Vedtagelse

- fremskreden

- aggressive

- AI

- AI / ML

- Alle

- alene

- langs med

- allerede

- også

- AMD

- an

- ,

- vises

- applikationer

- apps

- ER

- AS

- opmærksomhed

- barriere

- baseret

- BE

- fordi

- været

- både

- bygge

- Bygning

- Bunch

- men

- købe

- by

- CAN

- stand

- Kort

- CFO

- chatbots

- fordringer

- klar

- Cloud

- CO

- kode

- samarbejde

- Fælles

- samfund

- konkurrere

- komponenter

- indeholder

- Kursus

- Kunder

- data

- indsætte

- implementering

- konstrueret

- Detektion

- udviklet

- udvikling

- udvikler

- kørsel

- grund

- hver

- lettere

- eBay

- tilskynde

- ende

- Ingeniører

- Endog

- forvente

- dyrt

- udvidelser

- Ansigtet

- tilbagemeldinger

- få

- finansielle

- Til

- fundet

- fra

- generation

- generative

- Generativ AI

- få

- given

- GPU

- GPU'er

- stor

- hænder

- Hardware

- Have

- hoved

- hjælpe

- Fremhævet

- HPC

- HTML

- HTTPS

- Hype

- if

- gennemføre

- betydning

- imponerende

- in

- Herunder

- indvendig

- anvisninger

- Intel

- ind

- isn

- IT

- ITS

- jpg

- juni

- Sprog

- stor

- største

- Efternavn

- Sidste år

- læring

- biblioteker

- ligesom

- ophøjede

- lavere

- maskine

- machine learning

- større

- Matrix

- Kan..

- ML

- model

- modeller

- mere

- mest

- meget

- nødvendig

- Ny

- næste

- noder

- Nvidia

- objekt

- Objektdetektion

- of

- on

- dem

- åbent

- open source

- Optimer

- or

- Andet

- vores

- ud

- egen

- især

- Partnerskab

- dele

- plato

- Platon Data Intelligence

- PlatoData

- pop

- Populær

- magt

- vigtigste

- forudsigelse

- Priser

- processorer

- give

- udbydere

- offentlige

- rent

- skubber

- Pushing

- sætte

- spænder

- RE

- grund

- rimelige

- reducere

- rapporteret

- påkrævet

- Ressourcer

- indtægter

- Risiko

- kører

- s

- siger

- skalerbar

- scoring

- sælger

- Salg

- bør

- Silicon

- ganske enkelt

- websted

- Software

- Kilde

- står

- Strategisk

- Strategisk partnerskab

- Strategi

- abonnement

- succes

- sådan

- Omkringliggende

- Systemer

- opgaver

- tiere

- at

- deres

- Them

- derefter

- Disse

- denne

- selvom?

- tusinder

- tid

- titan

- til

- sammen

- værktøjer

- Tog

- Kurser

- prøv

- opdateret

- brug

- anvendte

- række

- udgave

- meget

- Voice

- mængder

- we

- som

- udbredt

- vilje

- Vinder

- med

- år

- Du

- zephyrnet