I dag er vi glade for at kunne meddele, at Mixtral-8x7B stor sprogmodel (LLM), udviklet af Mistral AI, er tilgængelig for kunder gennem Amazon SageMaker JumpStart at implementere med et klik for at køre inferens. Mixtral-8x7B LLM er en fortrænet sparsom blanding af ekspertmodeller, baseret på en 7-milliard parameter-rygrad med otte eksperter pr. feed-forward-lag. Du kan prøve denne model med SageMaker JumpStart, en maskinlæringshub (ML), der giver adgang til algoritmer og modeller, så du hurtigt kan komme i gang med ML. I dette indlæg gennemgår vi, hvordan du opdager og implementerer Mixtral-8x7B-modellen.

Hvad er Mixtral-8x7B

Mixtral-8x7B er en grundmodel udviklet af Mistral AI, der understøtter engelsk, fransk, tysk, italiensk og spansk tekst med kodegenereringsevner. Det understøtter en række forskellige brugssager såsom tekstresumé, klassificering, tekstfuldførelse og kodefuldførelse. Den opfører sig godt i chattilstand. For at demonstrere modellens enkle tilpasningsmuligheder har Mistral AI også udgivet en Mixtral-8x7B-instruktionsmodel til chatbrugssager, finjusteret ved hjælp af en række offentligt tilgængelige samtaledatasæt. Mixtral-modeller har en stor kontekstlængde på op til 32,000 tokens.

Mixtral-8x7B giver betydelige ydeevneforbedringer i forhold til tidligere avancerede modeller. Dens sparsomme blanding af ekspertarkitektur gør det muligt for den at opnå bedre præstationsresultater på 9 ud af 12 benchmarks for naturlig sprogbehandling (NLP) testet af Mistral AI. Mixtral matcher eller overgår ydeevnen af modeller op til 10 gange størrelsen. Ved kun at bruge en brøkdel af parametre pr. token opnår den hurtigere inferenshastigheder og lavere beregningsomkostninger sammenlignet med tætte modeller af tilsvarende størrelser - for eksempel med 46.7 milliarder parametre i alt, men kun 12.9 milliarder brugt pr. Denne kombination af høj ydeevne, flersproget support og beregningseffektivitet gør Mixtral-8x7B til et tiltalende valg til NLP-applikationer.

Modellen er gjort tilgængelig under den tilladelige Apache 2.0-licens, til brug uden begrænsninger.

Hvad er SageMaker JumpStart

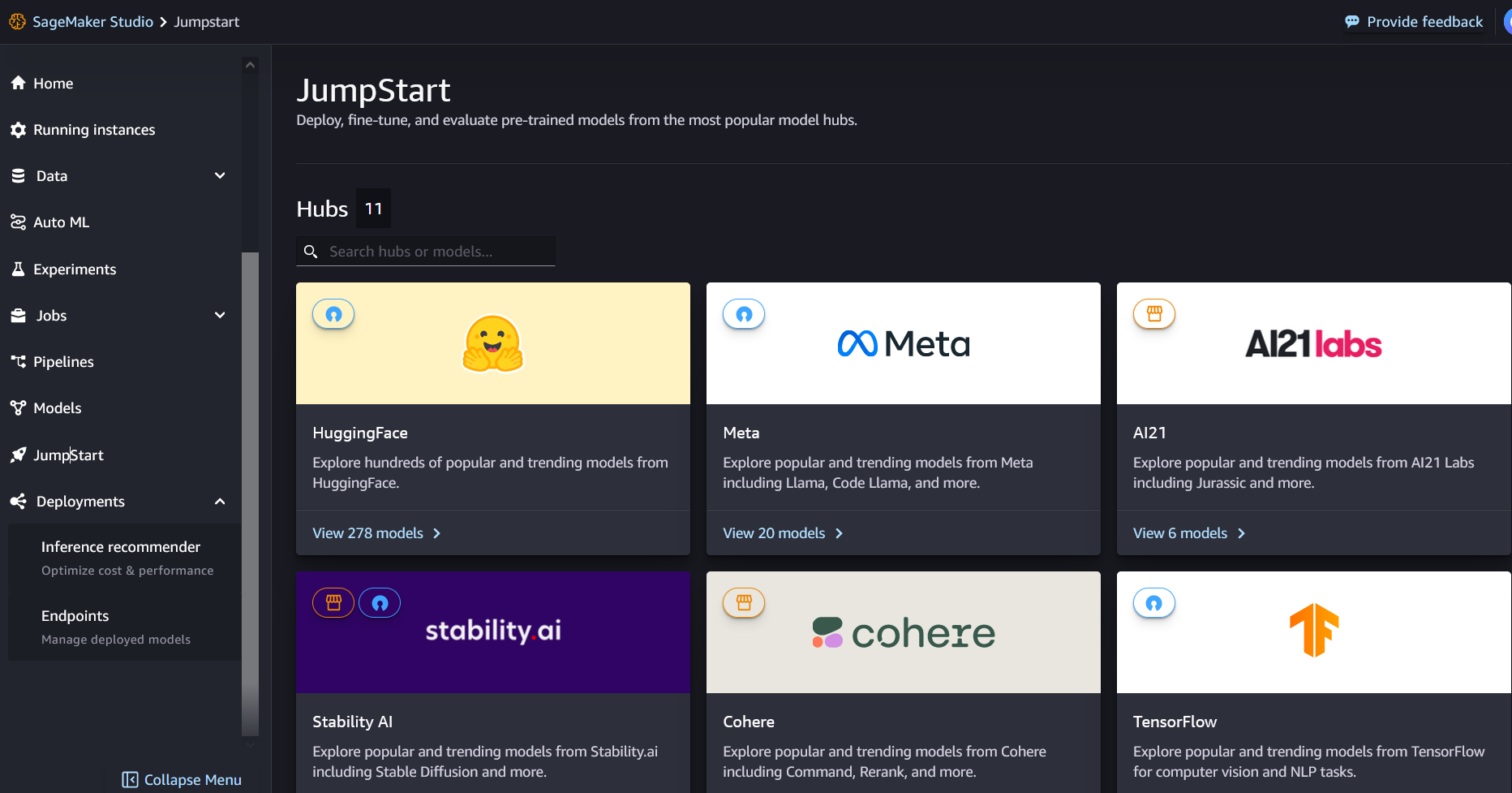

Med SageMaker JumpStart kan ML-praktiserende læger vælge fra en voksende liste over bedst ydende foundation-modeller. ML praktikere kan implementere fundamentmodeller til dedikerede Amazon SageMaker forekomster i et netværksisoleret miljø, og tilpasse modeller ved hjælp af SageMaker til modeltræning og implementering.

Du kan nu opdage og implementere Mixtral-8x7B med et par klik ind Amazon SageMaker Studio eller programmatisk gennem SageMaker Python SDK, så du kan udlede modelydelse og MLOps-kontroller med SageMaker-funktioner som f.eks. Amazon SageMaker Pipelines, Amazon SageMaker Debuggereller containerlogfiler. Modellen er implementeret i et AWS-sikkert miljø og under din VPC-kontrol, hvilket hjælper med at sikre datasikkerhed.

Opdag modeller

Du kan få adgang til Mixtral-8x7B-fundamentmodeller gennem SageMaker JumpStart i SageMaker Studio UI og SageMaker Python SDK. I dette afsnit gennemgår vi, hvordan du opdager modellerne i SageMaker Studio.

SageMaker Studio er et integreret udviklingsmiljø (IDE), der giver en enkelt webbaseret visuel grænseflade, hvor du kan få adgang til specialbyggede værktøjer til at udføre alle ML-udviklingstrin, fra forberedelse af data til opbygning, træning og implementering af dine ML-modeller. For flere detaljer om, hvordan du kommer i gang og opsætter SageMaker Studio, se Amazon SageMaker Studio.

I SageMaker Studio kan du få adgang til SageMaker JumpStart ved at vælge Forspring i navigationsruden.

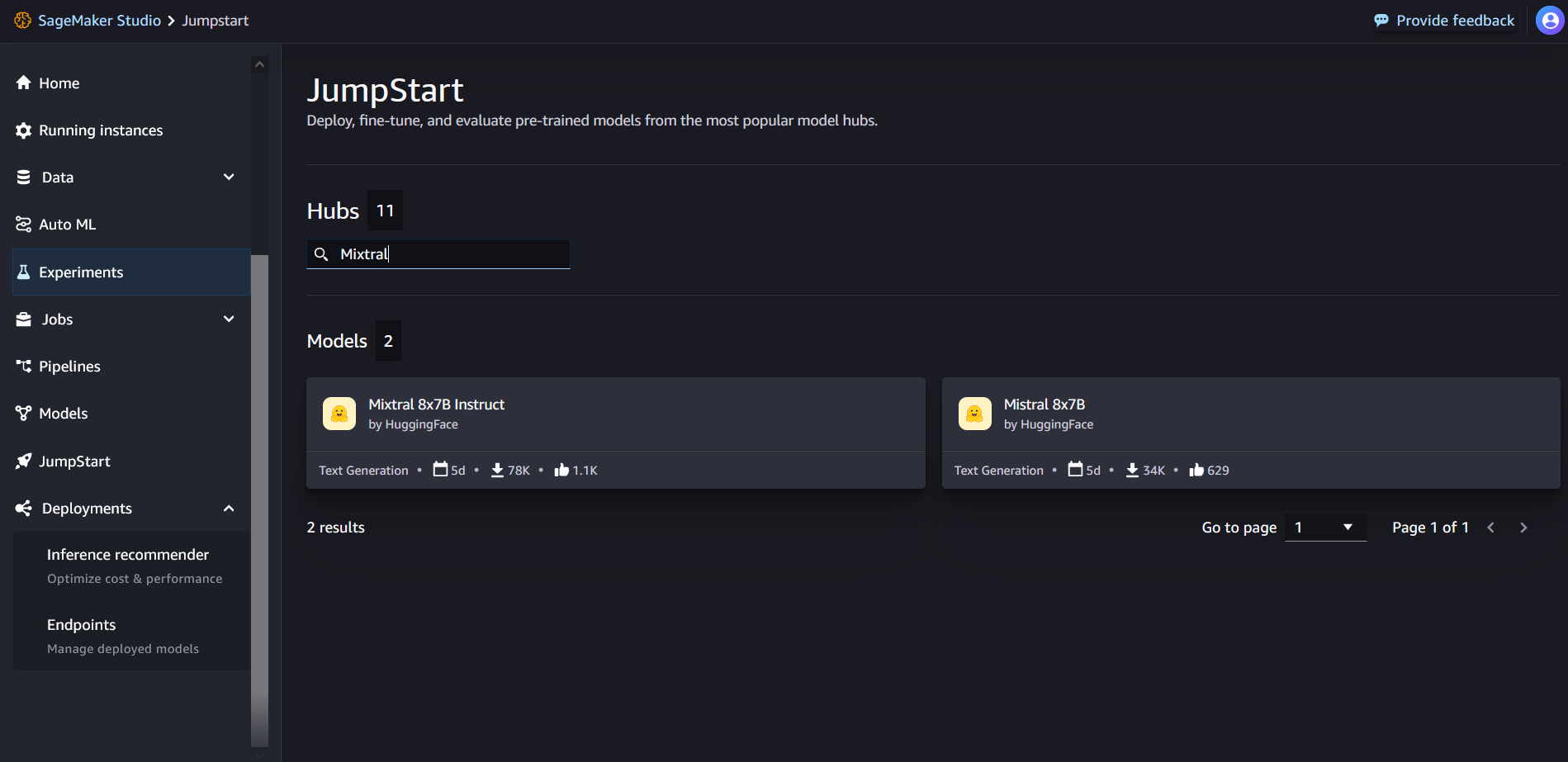

Fra SageMaker JumpStart-landingssiden kan du søge efter "Mixtral" i søgefeltet. Du vil se søgeresultater, der viser Mixtral 8x7B og Mixtral 8x7B Instruct.

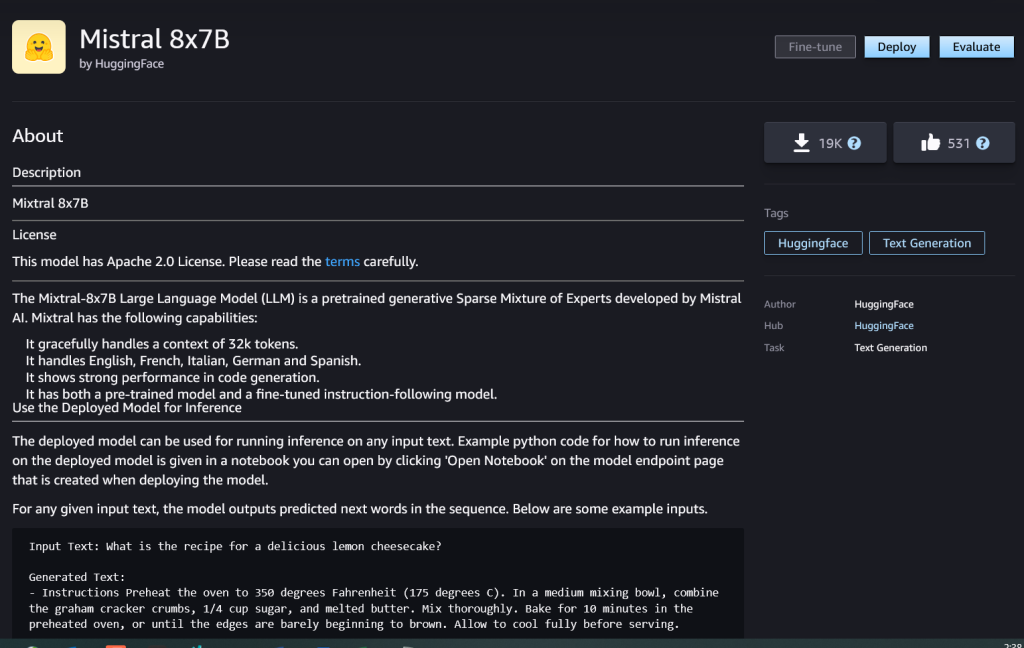

Du kan vælge modelkortet for at se detaljer om modellen, såsom licens, data, der bruges til at træne, og hvordan du bruger den. Du finder også Implementer knappen, som du kan bruge til at implementere modellen og oprette et slutpunkt.

Implementer en model

Implementeringen starter, når du vælger det Implementer. Når implementeringen er færdig, er du oprettet et slutpunkt. Du kan teste slutpunktet ved at videregive en prøveslutningsanmodningsnyttelast eller vælge din testindstilling ved hjælp af SDK. Når du vælger muligheden for at bruge SDK, vil du se eksempelkode, som du kan bruge i din foretrukne notesbogseditor i SageMaker Studio.

For at implementere ved hjælp af SDK starter vi med at vælge Mixtral-8x7B-modellen, specificeret af model_id with value huggingface-llm-mixtral-8x7b. Du kan implementere enhver af de valgte modeller på SageMaker med følgende kode. På samme måde kan du implementere Mixtral-8x7B-instruktion ved hjælp af sit eget model-id:

Dette implementerer modellen på SageMaker med standardkonfigurationer, inklusive standardinstanstypen og standard VPC-konfigurationer. Du kan ændre disse konfigurationer ved at angive ikke-standardværdier i JumpStartModel.

Efter det er implementeret, kan du køre slutninger mod det implementerede slutpunkt gennem SageMaker-prædiktoren:

Eksempler på opfordringer

Du kan interagere med en Mixtral-8x7B-model som enhver standard tekstgenereringsmodel, hvor modellen behandler en inputsekvens og udsender forudsagte næste ord i sekvensen. I dette afsnit giver vi eksempler på prompter.

Generering af kode

Ved at bruge det foregående eksempel kan vi bruge kodegenereringsprompts som følgende:

Du får følgende output:

Stemningsanalyse prompt

Du kan udføre sentimentanalyse ved hjælp af en prompt som følgende med Mixtral 8x7B:

Du får følgende output:

Spørgsmål besvare prompter

Du kan bruge en spørgsmålsbesvarelsesprompt som følgende med Mixtral-8x7B:

Du får følgende output:

Mixtral-8x7B Instruktion

Den instruktionsjusterede version af Mixtral-8x7B accepterer formaterede instruktioner, hvor samtaleroller skal starte med en brugerprompt og veksle mellem brugerinstruktion og assistent (modelsvar). Instruktionsformatet skal overholdes strengt, ellers vil modellen generere suboptimale output. Skabelonen, der bruges til at bygge en prompt til Instruct-modellen, er defineret som følger:

Bemærk, at <s> , </s> er specielle tokens for begyndelsen af strengen (BOS) og slutningen af strengen (EOS), hvorimod [INST] , [/INST] er almindelige strenge.

Følgende kode viser, hvordan du kan formatere prompten i instruktionsformat:

Indhentning af viden

Du kan bruge følgende kode til en prompt til at hente viden:

Du får følgende output:

Kodning

Mixtral-modeller kan demonstrere benchmarked-styrker for kodningsopgaver, som vist i følgende kode:

Matematik og ræsonnement

Mixtral-modeller rapporterer også styrker i matematiknøjagtighed:

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/mixtral-8x7b-is-now-available-in-amazon-sagemaker-jumpstart/

- :har

- :er

- :ikke

- :hvor

- $OP

- 000

- 1

- 10

- 100

- 11

- 12

- 120

- 13

- 130

- 14

- 15 %

- 16

- 17

- 1M

- 200

- 25

- 26 %

- 30

- 32

- 50

- 600

- 7

- 72

- 8

- 9

- a

- evner

- Om

- over

- accelererende

- accepterer

- adgang

- Konti

- nøjagtighed

- opnå

- opnår

- tværs

- aktiv

- tilføjet

- tilføje

- Efter

- mod

- AI

- AI / ML

- algoritmer

- Alle

- også

- Amazon

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- beløb

- an

- analyse

- ,

- og infrastruktur

- Annoncere

- besvare

- enhver

- Apache

- tiltrækkende

- applikationer

- anvendt

- Anvendelse

- arkitektur

- ER

- argument

- artikel

- AS

- Assistant

- At

- til rådighed

- AWS

- tilbage

- Backbone

- baseret

- bash

- batteri

- Bayesiansk

- BE

- fordi

- været

- før

- Begyndelse

- mener

- Bell

- benchmarkes

- Benchmarks

- Bedre

- mellem

- Bill

- fakturerings- og

- Billion

- pin

- købte

- Boks

- Pause

- bringe

- bygge

- Bygning

- indbygget

- virksomhed

- men

- by

- beregne

- ringe

- kaldet

- Opkald

- CAN

- kort

- tilfælde

- tilfælde

- lave om

- chatte

- valg

- Vælg

- vælge

- Chris

- klassificering

- klik

- kode

- Kodning

- kombination

- sammenlignet

- kompileret

- færdiggørelse

- beregningsmæssige

- Compute

- computer

- Computer Vision

- konferencer

- konstant

- Container

- indhold

- sammenhæng

- fortsætter

- kontinuerligt

- kontrol

- Samtale

- Koste

- Omkostninger

- kunne

- skabe

- oprettet

- afgørende

- Kop

- Nuværende

- Kunder

- tilpasning

- tilpasse

- data

- datasikkerhed

- datasæt

- dag

- Dage

- dedikeret

- Standard

- definerede

- demokratisering

- demonstrere

- indsætte

- indsat

- implementering

- implementering

- udruller

- udlede

- detaljer

- udvikle

- udviklet

- Udvikler

- Udvikling

- DICT

- DID

- opdage

- do

- gør

- dollars

- Domæner

- færdig

- ned

- Drop

- Duke

- hertug universitet

- hver

- Økonomisk

- editor

- effektivitet

- Æg

- andet

- muliggøre

- muliggør

- muliggør

- ende

- Endpoint

- Engineering

- Engelsk

- sikre

- Miljø

- EOS

- lige

- Ækvivalent

- etisk

- eksempel

- overstiger

- ophidset

- Eksklusive

- ekspert

- eksperter

- Forklar

- forklaring

- udvidelse

- familie

- hurtigere

- Funktionalitet

- få

- Filer

- Filtre

- Finde

- Fornavn

- efter

- følger

- Til

- format

- Foundation

- fraktion

- Fransk

- fra

- funktion

- fremtiden

- generelle formål

- generere

- genereret

- generation

- generative

- Generativ AI

- Tysk

- få

- Go

- godt

- fik

- Dyrkning

- hader

- Have

- he

- hjælpe

- hjælpe

- hjælper

- hende

- link.

- Høj

- Hills

- hans

- Hvordan

- How To

- HTML

- HTTPS

- Hub

- i

- ICE

- is

- ID

- if

- Illinois

- sygdom

- importere

- vigtigt

- Forbedre

- forbedringer

- in

- omfatter

- Herunder

- Incorporated

- Infrastruktur

- indgang

- indgange

- instans

- anvisninger

- integrere

- integreret

- interagere

- interesser

- grænseflade

- Opfundet

- isolerede

- IT

- italiensk

- ITS

- selv

- jpg

- børn

- viden

- Kyle

- Labs

- landing

- Sprog

- stor

- Efternavn

- lag

- Leads

- læring

- Længde

- lad

- Licens

- ligesom

- synes godt om

- grænser

- LINK

- Liste

- Lytte

- lidt

- LLM

- logik

- leder

- lavere

- maskine

- machine learning

- lavet

- maerker

- Making

- leder

- mange

- tændstikker

- matematik

- matematik

- me

- medium

- blanding

- ML

- MLOps

- tilstand

- model

- modeller

- modificeret

- Måned

- mere

- motorcykel

- meget

- ganget

- Musik

- skal

- my

- Natural

- Natural Language Processing

- Navigation

- negativ

- netværk

- Neutral

- Ny

- næste

- NLP

- Ingen

- Bemærk

- notesbog

- nu

- nummer

- of

- Olie

- on

- engang

- ONE

- kun

- drift

- operativsystem

- Option

- or

- Andet

- Ellers

- ud

- output

- udgange

- uden for

- i løbet af

- egen

- side

- betalt

- brød

- papirer

- parameter

- parametre

- Passing

- lidenskab

- lidenskabelige

- stier

- per

- Udfør

- ydeevne

- phd

- telefon

- plato

- Platon Data Intelligence

- PlatoData

- Punkt

- bærbare

- positiv

- Indlæg

- forud

- forudsagde

- Predictor

- foretrækkes

- forberede

- tidligere

- Main

- proceduremæssige

- behandle

- Processer

- forarbejdning

- Produkt

- Program

- Programmering

- prompter

- velstand

- give

- udbydere

- giver

- offentligt

- offentliggjort

- Python

- Kvarter

- spørgsmål

- hurtigt

- RE

- Læsning

- opskrift

- Rekursiv

- reducere

- henvise

- fast

- frigivet

- indberette

- anmode

- forskning

- forsker

- Ressourcer

- respekteret

- svar

- ansvarlige

- restriktioner

- resultere

- Resultater

- afkast

- afkast

- ridning

- Risiko

- roller

- roller

- Værelse

- Kør

- kører

- s

- SA

- sagemaker

- salt

- skalerbar

- Scale

- Videnskab

- Videnskabsmand

- SDK

- Søg

- Sektion

- sikker

- sikkerhed

- se

- Vælg

- valgt

- udvælgelse

- valg

- senior

- stemningen

- adskille

- Sequence

- Series

- Tjenester

- sæt

- viste

- vist

- Shows

- signifikant

- Tilsvarende

- Simpelt

- siden

- enkelt

- Størrelse

- So

- Social

- Samfund

- Software

- løsninger

- Spansk

- særligt

- specialist

- specificeret

- hastigheder

- udgifterne

- standard

- starte

- påbegyndt

- starter

- state-of-the-art

- statistiske

- Trin

- Steps

- Stadig

- stoppet

- butik

- ligetil

- Strategisk

- strøm

- styrker

- String

- struktureret

- Studio

- sådan

- support

- Støtte

- Understøtter

- systemet

- tager

- opgaver

- smag

- hold

- Teknologier

- skabelon

- prøve

- afprøvet

- Test

- tekst

- at

- Fremtiden

- derefter

- Disse

- de

- denne

- Gennem

- tid

- Tidsserier

- gange

- til

- sammen

- token

- Tokens

- også

- værktøjer

- I alt

- Tog

- Kurser

- sand

- prøv

- tweet

- typen

- ui

- under

- universitet

- unix

- låse

- indtil

- brug

- brug tilfælde

- anvendte

- Bruger

- bruger

- ved brug af

- Ved hjælp af

- Dal

- værdi

- Værdier

- række

- udgave

- video

- Specifikation

- vision

- Besøg

- visuel

- gå

- var

- Vand

- we

- web

- webservices

- web-baseret

- GODT

- Hvad

- Hvad er

- hvornår

- ud fra følgende betragtninger

- som

- hvid

- WHO

- vilje

- med

- inden for

- uden

- ord

- Arbejde

- ville

- skriver

- skriftlig

- Du

- Din

- zephyrnet

Rachna Chadha er Principal Solution Architect AI/ML i Strategic Accounts hos AWS. Rachna er en optimist, der mener, at etisk og ansvarlig brug af kunstig intelligens kan forbedre samfundet i fremtiden og bringe økonomisk og social velstand. I sin fritid kan Rachna godt lide at bruge tid med sin familie, vandreture og lytte til musik.

Rachna Chadha er Principal Solution Architect AI/ML i Strategic Accounts hos AWS. Rachna er en optimist, der mener, at etisk og ansvarlig brug af kunstig intelligens kan forbedre samfundet i fremtiden og bringe økonomisk og social velstand. I sin fritid kan Rachna godt lide at bruge tid med sin familie, vandreture og lytte til musik. Dr. Kyle Ulrich er en anvendt videnskabsmand med

Dr. Kyle Ulrich er en anvendt videnskabsmand med  Christopher Whitten er softwareudvikler på JumpStart-teamet. Han hjælper med at skalere modelvalg og integrere modeller med andre SageMaker-tjenester. Chris brænder for at accelerere AI's allestedsnærværelse på tværs af en række forretningsdomæner.

Christopher Whitten er softwareudvikler på JumpStart-teamet. Han hjælper med at skalere modelvalg og integrere modeller med andre SageMaker-tjenester. Chris brænder for at accelerere AI's allestedsnærværelse på tværs af en række forretningsdomæner. Dr. Fabio Nonato de Paula er en Senior Manager, Specialist GenAI SA, der hjælper modeludbydere og kunder med at skalere generativ AI i AWS. Fabio har en passion for at demokratisere adgangen til generativ AI-teknologi. Uden for arbejdet kan du finde Fabio kørende på sin motorcykel i bakkerne i Sonoma Valley eller læse ComiXology.

Dr. Fabio Nonato de Paula er en Senior Manager, Specialist GenAI SA, der hjælper modeludbydere og kunder med at skalere generativ AI i AWS. Fabio har en passion for at demokratisere adgangen til generativ AI-teknologi. Uden for arbejdet kan du finde Fabio kørende på sin motorcykel i bakkerne i Sonoma Valley eller læse ComiXology. Dr. Ashish Khetan er en Senior Applied Scientist med Amazon SageMaker indbyggede algoritmer og hjælper med at udvikle machine learning algoritmer. Han fik sin ph.d. fra University of Illinois Urbana-Champaign. Han er en aktiv forsker i maskinlæring og statistisk inferens og har publiceret mange artikler i NeurIPS, ICML, ICLR, JMLR, ACL og EMNLP konferencer.

Dr. Ashish Khetan er en Senior Applied Scientist med Amazon SageMaker indbyggede algoritmer og hjælper med at udvikle machine learning algoritmer. Han fik sin ph.d. fra University of Illinois Urbana-Champaign. Han er en aktiv forsker i maskinlæring og statistisk inferens og har publiceret mange artikler i NeurIPS, ICML, ICLR, JMLR, ACL og EMNLP konferencer. Karl Albertsen fører produkt, teknik og videnskab for Amazon SageMaker Algorithms og JumpStart, SageMakers maskinlæringshub. Han brænder for at anvende maskinlæring til at frigøre forretningsværdi.

Karl Albertsen fører produkt, teknik og videnskab for Amazon SageMaker Algorithms og JumpStart, SageMakers maskinlæringshub. Han brænder for at anvende maskinlæring til at frigøre forretningsværdi.