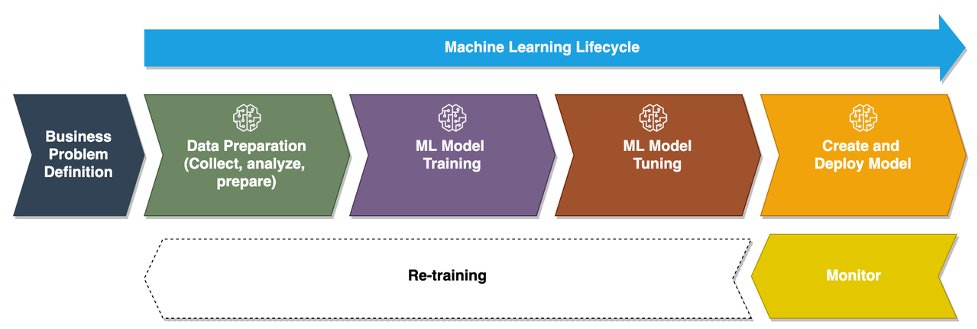

Da Unternehmen von der Ausführung von Ad-hoc-Modellen für maschinelles Lernen (ML) zur Nutzung von KI/ML übergehen, um ihr Geschäft in großem Maßstab zu transformieren, wird die Einführung von ML Operations (MLOps) unvermeidlich. Wie in der folgenden Abbildung dargestellt, beginnt der ML-Lebenszyklus mit der Formulierung eines Geschäftsproblems als ML-Anwendungsfall, gefolgt von einer Reihe von Phasen, darunter Datenvorbereitung, Feature-Engineering, Modellerstellung, Bereitstellung, kontinuierliche Überwachung und Umschulung. Für viele Unternehmen sind viele dieser Schritte noch manuell und lose miteinander integriert. Daher ist es wichtig, den End-to-End-ML-Lebenszyklus zu automatisieren, was häufige Experimente ermöglicht, um bessere Geschäftsergebnisse zu erzielen. Die Datenvorbereitung ist einer der entscheidenden Schritte in diesem Lebenszyklus, da die Genauigkeit des ML-Modells von der Qualität des Trainingsdatensatzes abhängt.

Datenwissenschaftler und ML-Ingenieure verbringen zwischen 70 und 80 % ihrer Zeit mit dem Sammeln, Analysieren, Bereinigen und Transformieren von Daten, die für das Modelltraining erforderlich sind. Amazon SageMaker Data Wrangler ist eine vollständig verwaltete Funktion von Amazon Sage Maker Dadurch können Datenwissenschaftler und ML-Ingenieure Daten für ihre ML-Projekte mit wenig bis gar keinem Code schneller analysieren und vorbereiten. Wenn es um die Operationalisierung eines End-to-End-ML-Lebenszyklus geht, ist die Datenvorbereitung fast immer der erste Schritt im Prozess. Angesichts der Tatsache, dass es viele Möglichkeiten gibt, eine End-to-End-ML-Pipeline aufzubauen, diskutieren wir in diesem Beitrag, wie Sie Data Wrangler einfach in einige der bekannten Workflow-Automatisierungs- und Orchestrierungstechnologien integrieren können.

Lösungsüberblick

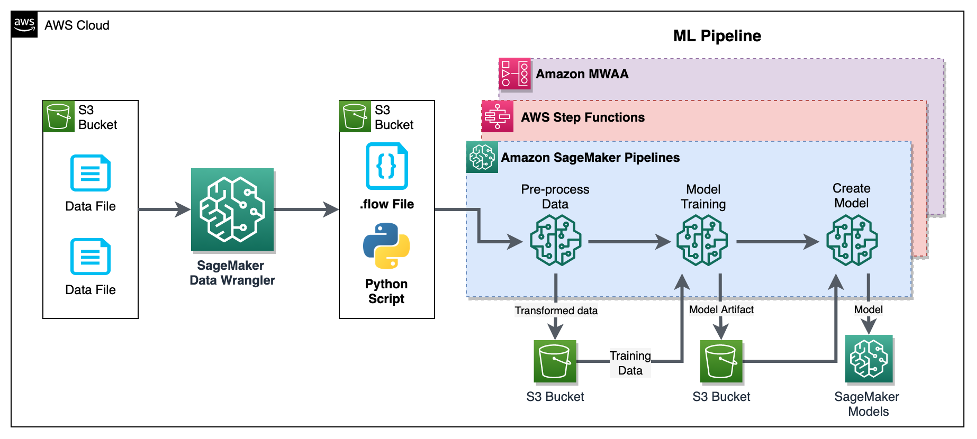

In diesem Beitrag zeigen wir, wie Benutzer die Datenaufbereitung mit Data Wrangler integrieren können Amazon SageMaker-Pipelines, AWS Step-Funktionen und Apache-Luftstrom mit Von Amazon verwalteter Workflow für Apache Airflow (Amazon MWAA). Pipelines ist eine SageMaker-Funktion, die ein speziell entwickelter und benutzerfreundlicher Dienst für kontinuierliche Integration und kontinuierliche Bereitstellung (CI/CD) für ML ist. Step Functions ist ein serverloser, visueller Low-Code-Workflow-Service, der verwendet wird, um AWS-Services zu orchestrieren und Geschäftsprozesse zu automatisieren. Amazon MWAA ist ein verwalteter Orchestrierungsdienst für Apache Airflow, der den Betrieb von End-to-End-Daten und ML-Pipelines vereinfacht.

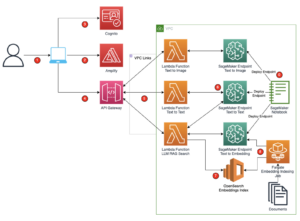

Zu Demonstrationszwecken betrachten wir einen Anwendungsfall zum Vorbereiten von Daten zum Trainieren eines ML-Modells mit dem integrierten SageMaker XGBoost-Algorithmus die uns helfen, betrügerische Fahrzeugversicherungsansprüche zu identifizieren. Wir haben einen synthetisch generierten Satz von Beispieldaten verwendet, um das Modell zu trainieren und ein SageMaker-Modell mit den Modellartefakten aus dem Trainingsprozess zu erstellen. Unser Ziel ist es, diesen Prozess durchgängig zu operationalisieren, indem wir einen ML-Workflow einrichten. Obwohl ML-Workflows aufwändiger sein können, verwenden wir zu Demonstrationszwecken einen minimalen Workflow. Der erste Schritt des Workflows ist die Datenvorbereitung mit Data Wrangler, gefolgt von einem Modelltrainingsschritt und schließlich einem Modellerstellungsschritt. Das folgende Diagramm veranschaulicht unseren Lösungsworkflow.

In den folgenden Abschnitten führen wir Sie durch die Einrichtung eines Data Wrangler-Flows und die Integration von Data Wrangler mit Pipelines, Step Functions und Apache Airflow.

Richten Sie einen Data Wrangler-Flow ein

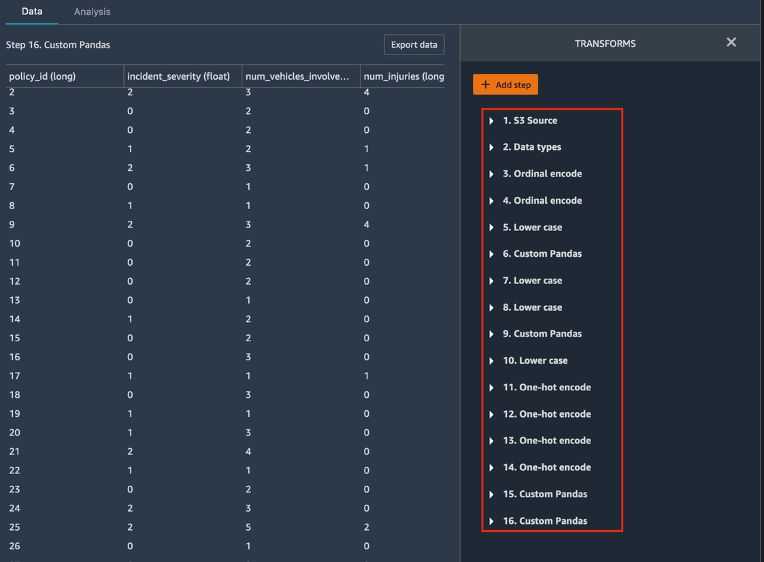

Wir beginnen mit der Erstellung eines Data Wrangler-Flows, auch als a bezeichnet Datenfluss, Verwendung der Datenfluss-UI über das Amazon SageMaker-Studio IDE. Unser Beispieldatensatz besteht aus zwei Datendateien: Ansprüche.csv und kunden.csv, die in einem gespeichert sind Amazon Simple Storage-Service (Amazon S3) Eimer. Wir verwenden die Datenfluss-UI, um Data Wrangler anzuwenden eingebaute Transformationen solche kategoriale Kodierung, String-Formatierung und Imputation zu den Feature-Spalten in jeder dieser Dateien. Wir bewerben uns auch benutzerdefinierte Transformation zu einigen Feature-Spalten mit ein paar Zeilen benutzerdefiniertem Python-Code mit Pandas DataFrame. Der folgende Screenshot zeigt die Transformationen, die auf die Datei „claims.csv“ in der Datenfluss-Benutzeroberfläche angewendet wurden.

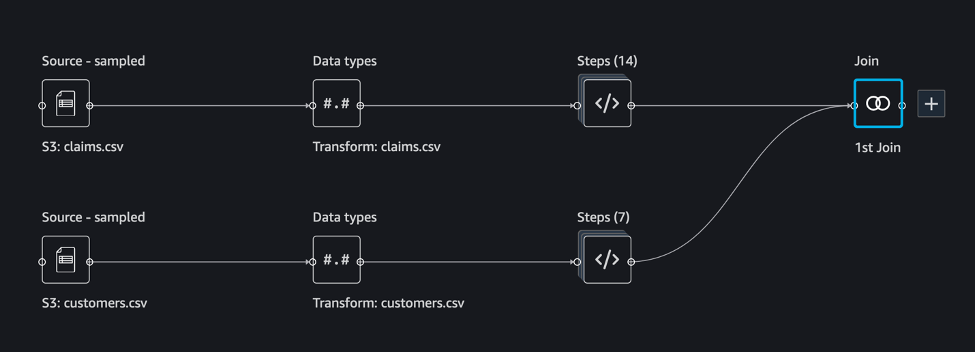

Schließlich führen wir die Ergebnisse der angewandten Transformationen der beiden Datendateien zusammen, um einen einzigen Trainingsdatensatz für unser Modelltraining zu generieren. Wir verwenden den eingebauten Data Wrangler Datensätzen beitreten -Funktion, mit der wir SQL-ähnliche Join-Operationen für Tabellendaten ausführen können. Der folgende Screenshot zeigt den Datenfluss in der Datenfluss-Benutzeroberfläche in Studio. Eine Schritt-für-Schritt-Anleitung zum Erstellen des Datenflusses mit Data Wrangler finden Sie unter GitHub-Repository.

Sie können jetzt die Datenflussdatei (.flow) verwenden, um Datentransformationen an unseren Rohdatendateien durchzuführen. Die Datenfluss-Benutzeroberfläche kann mithilfe des SageMaker SDK automatisch Python-Notebooks generieren, die wir verwenden und direkt in Pipelines integrieren können. Für Schrittfunktionen verwenden wir die AWS Step Functions Data Science Python SDK um unsere Data Wrangler-Verarbeitung in eine Step Functions-Pipeline zu integrieren. Für Amazon MWAA verwenden wir a benutzerdefinierter Airflow-Operator und für Airflow SageMaker-Operator. Wir diskutieren jeden dieser Ansätze im Detail in den folgenden Abschnitten.

Integrieren Sie Data Wrangler in Pipelines

SageMaker Pipelines ist ein natives Workflow-Orchestrierungstool zum Erstellen von ML-Pipelines, die die Vorteile der direkten SageMaker-Integration nutzen. Zusammen mit SageMaker-Modellregistrierung, Pipelines verbessert die Betriebssicherheit und Reproduzierbarkeit Ihrer ML-Workflows. Mit diesen Workflow-Automatisierungskomponenten können Sie Ihre Fähigkeit zum Erstellen, Trainieren, Testen und Bereitstellen von Hunderten von Modellen in der Produktion einfach skalieren. schneller iterieren; Reduzierung von Fehlern aufgrund manueller Orchestrierung; und bauen Sie wiederholbare Mechanismen auf. Jeder Schritt in der Pipeline kann die Herkunft nachverfolgen, und Zwischenschritte können zwischengespeichert werden, um die Pipeline schnell erneut auszuführen. Du kannst Erstellen Sie Pipelines mit dem SageMaker Python SDK.

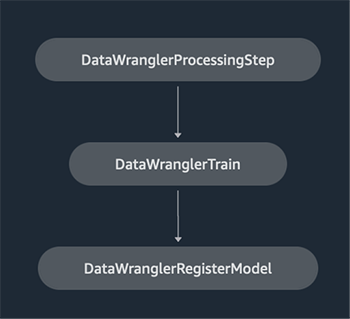

Ein mit SageMaker-Pipelines erstellter Workflow besteht aus einer Abfolge von Schritten, die einen gerichteten azyklischen Graphen (DAG) bilden. In diesem Beispiel beginnen wir mit a Verarbeitungsschritt, das läuft a SageMaker-Verarbeitungsjob basierend auf der Flow-Datei von Data Wrangler, um einen Trainingsdatensatz zu erstellen. Dann fahren wir mit a fort Trainingsschritt, wo wir ein XGBoost-Modell mit dem integrierten XGBoost-Algorithmus von SageMaker und dem im vorherigen Schritt erstellten Trainingsdatensatz trainieren. Nachdem ein Modell trainiert wurde, beenden wir diesen Arbeitsablauf mit a RegisterModel-Schritt um das trainierte Modell bei der SageMaker-Modellregistrierung zu registrieren.

Installation und Anleitung

Um dieses Beispiel auszuführen, verwenden wir ein Jupyter-Notebook, auf dem Python3 auf einem Data Science-Kernel-Image in einer Studio-Umgebung ausgeführt wird. Sie können es auch auf einer Jupyter-Notebook-Instance lokal auf Ihrem Computer ausführen, indem Sie die Anmeldeinformationen einrichten, um die SageMaker-Ausführungsrolle zu übernehmen. Das Notebook ist leichtgewichtig und kann auf einer ml.t3.medium-Instanz ausgeführt werden. Eine ausführliche Schritt-für-Schritt-Anleitung finden Sie in der GitHub-Repository.

Sie können entweder die Exportfunktion in Data Wrangler verwenden, um den Pipelines-Code zu generieren, oder Ihr eigenes Skript von Grund auf neu erstellen. In unserem Beispiel-Repository verwenden wir der Einfachheit halber eine Kombination beider Ansätze. Auf hoher Ebene sind die folgenden Schritte zum Erstellen und Ausführen des Pipelines-Workflows aufgeführt:

- Generieren Sie eine Flow-Datei aus Data Wrangler oder verwenden Sie das Setup-Skript, um eine Flow-Datei aus einer vorkonfigurierten Vorlage zu generieren.

- Erstellen Sie ein Amazon Simple Storage-Service (Amazon S3)-Bucket und laden Sie Ihre Flow-Datei und Ihre Eingabedateien in den Bucket hoch. In unserem Beispielnotebook verwenden wir den standardmäßigen S3-Bucket von SageMaker.

- Befolgen Sie die Anweisungen im Notebook, um ein Processor-Objekt basierend auf der Data Wrangler-Flussdatei und ein Estimator-Objekt mit den Parametern des Trainingsjobs zu erstellen.

- Da wir in unserem Beispiel nur SageMaker-Funktionen und den standardmäßigen S3-Bucket verwenden, können wir die standardmäßige Ausführungsrolle von Studio verwenden. Das Gleiche AWS Identity and Access Management and (IAM)-Rolle wird von der Pipelineausführung, dem Verarbeitungsjob und dem Trainingsjob übernommen. Sie können die Ausführungsrolle je nach Mindestberechtigung weiter anpassen.

- Fahren Sie mit den Anweisungen zum Erstellen einer Pipeline mit Schritten fort, die auf die Processor- und Estimator-Objekte verweisen, und führen Sie dann die Pipeline aus. Die Verarbeitungs- und Trainingsjobs werden in von SageMaker verwalteten Umgebungen ausgeführt und dauern einige Minuten.

- In Studio können Sie die Pipelinedetails anzeigen, um die Pipelineausführung zu überwachen. Sie können die zugrunde liegenden Verarbeitungs- und Trainingsjobs auch von der SageMaker-Konsole oder von überwachen Amazon CloudWatch.

Integrieren Sie Data Wrangler mit Step-Funktionen

Mit Step Functions können Sie komplexe Geschäftslogik als ereignisgesteuerte Low-Code-Workflows ausdrücken, die verschiedene AWS-Services verbinden. Das Step Functions Data Science-SDK ist eine Open-Source-Bibliothek, die es Data Scientists ermöglicht, Workflows zu erstellen, die Datensätze vorverarbeiten und ML-Modelle mit SageMaker und Step Functions erstellen, bereitstellen und überwachen können. Step Functions basiert auf Zustandsmaschinen und Tasks. Step Functions erstellt Workflows aus aufgerufenen Steps Staaten, und drückt diesen Workflow in der aus Amazon States Sprache. Wenn Sie einen Workflow mit dem Step Functions Data Science SDK erstellen, erstellt es einen Zustandsautomaten, der Ihren Workflow und die Schritte in Step Functions darstellt.

Für diesen Anwendungsfall haben wir einen Step Functions-Workflow basierend auf dem in diesem Beitrag verwendeten gemeinsamen Muster erstellt, das einen Verarbeitungsschritt, einen Trainingsschritt und enthält RegisterModel Schritt. In diesem Fall importieren wir diese Schritte aus dem Step Functions Data Science Python SDK. Wir verketten diese Schritte in derselben Reihenfolge, um einen Step Functions-Workflow zu erstellen. Der Arbeitsablauf verwendet die Flow-Datei, die von Data Wrangler generiert wurde, aber Sie können auch Ihre eigene Data Wrangler-Flow-Datei verwenden. Wir verwenden einen Teil des Codes aus dem Data Wrangler wieder Exportfunktion der Einfachheit halber. Wir führen die von der Data Wrangler-Flussdatei generierte Datenvorverarbeitungslogik aus, um einen Trainingsdatensatz zu erstellen, ein Modell mit dem XGBoost-Algorithmus zu trainieren und das trainierte Modellartefakt als SageMaker-Modell zu speichern. Darüber hinaus zeigen wir im GitHub-Repo auch, wie Step Functions es uns ermöglicht, Fehler abzufangen und mit Fehlern und Wiederholungen umzugehen FailStateStep und CatchStateStep.

Das resultierende Flussdiagramm, wie im folgenden Screenshot gezeigt, ist auf der Step Functions-Konsole verfügbar, nachdem der Workflow gestartet wurde. Dies hilft Datenwissenschaftlern und Ingenieuren, den gesamten Workflow und jeden Schritt darin zu visualisieren und für jeden Schritt auf die verknüpften CloudWatch-Protokolle zuzugreifen.

Installation und Anleitung

Um dieses Beispiel auszuführen, verwenden wir ein Python-Notebook, das mit einem Data Science-Kernel in einer Studio-Umgebung ausgeführt wird. Sie können es auch auf einer Python-Notebook-Instance lokal auf Ihrem Computer ausführen, indem Sie die Anmeldeinformationen einrichten, um die SageMaker-Ausführungsrolle zu übernehmen. Das Notebook ist leichtgewichtig und kann beispielsweise auf einer mittleren t3-Instanz ausgeführt werden. Eine ausführliche Schritt-für-Schritt-Anleitung finden Sie in der GitHub-Repository.

Sie können entweder die Exportfunktion in Data Wrangler verwenden, um den Pipelines-Code zu generieren und ihn für Step Functions zu ändern, oder Ihr eigenes Skript von Grund auf neu erstellen. In unserem Beispiel-Repository verwenden wir der Einfachheit halber eine Kombination beider Ansätze. Auf hoher Ebene sind die folgenden Schritte zum Erstellen und Ausführen des Step Functions-Workflows aufgeführt:

- Generieren Sie eine Flow-Datei aus Data Wrangler oder verwenden Sie das Setup-Skript, um eine Flow-Datei aus einer vorkonfigurierten Vorlage zu generieren.

- Erstellen Sie einen S3-Bucket und laden Sie Ihre Flow-Datei und Eingabedateien in den Bucket hoch.

- Konfigurieren Sie Ihre SageMaker-Ausführungsrolle mit den erforderlichen Berechtigungen, wie zuvor erwähnt. Ausführliche Anweisungen finden Sie im GitHub-Repository.

- Befolgen Sie die Anweisungen zum Ausführen des Notebooks im Repository, um einen Arbeitsablauf zu starten. Der Verarbeitungsauftrag wird in einer von SageMaker verwalteten Spark-Umgebung ausgeführt und kann einige Minuten dauern.

- Gehen Sie zur Step Functions-Konsole und verfolgen Sie den Workflow visuell. Sie können auch zu den verknüpften CloudWatch-Protokollen navigieren, um Fehler zu debuggen.

Sehen wir uns hier einige wichtige Abschnitte des Codes an. Um den Workflow zu definieren, definieren wir zunächst die Schritte im Workflow für die Zustandsmaschine Step Function. Der erste Schritt ist die data_wrangler_step für die Datenverarbeitung, die die Data Wrangler-Flussdatei als Eingabe zum Transformieren der Rohdatendateien verwendet. Wir definieren auch einen Modelltrainingsschritt und einen Modellerstellungsschritt namens training_step und model_step, beziehungsweise. Schließlich erstellen wir einen Workflow, indem wir alle von uns erstellten Schritte verketten, wie im folgenden Code gezeigt:

In unserem Beispiel haben wir den Workflow so aufgebaut, dass Jobnamen als Parameter verwendet werden, da sie eindeutig sind und während jeder Pipelineausführung zufällig generiert werden müssen. Wir übergeben diese Namen, wenn der Workflow ausgeführt wird. Sie können den Step Functions-Workflow auch so planen, dass er mit CloudWatch ausgeführt wird (siehe Planen Sie einen serverlosen Workflow mit AWS Step Functions und Amazon CloudWatch), aufgerufen mit Amazon S3-Ereignisse, oder aufgerufen von Amazon EventBridge (sehen Erstellen Sie eine EventBridge-Regel, die einen Step Functions-Workflow auslöst). Zu Demonstrationszwecken können wir den Step Functions-Workflow über die Benutzeroberfläche der Step Functions-Konsole oder mithilfe des folgenden Codes aus dem Notebook aufrufen.

Integrieren Sie Data Wrangler in Apache Airflow

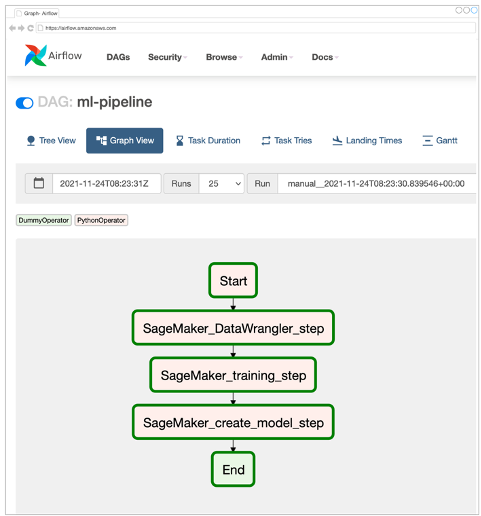

Eine weitere beliebte Methode zum Erstellen von ML-Workflows ist die Verwendung von Apache Airflow. Apache Airflow ist eine Open-Source-Plattform, mit der Sie Workflows programmgesteuert erstellen, planen und überwachen können. Amazon MWAA erleichtert die Einrichtung und den Betrieb von End-to-End-ML-Pipelines mit Apache Airflow in der Cloud in großem Umfang. Eine Airflow-Pipeline besteht aus einer Abfolge von Aufgaben, die auch als a bezeichnet werden Arbeitsablauf.. Ein Workflow ist als DAG definiert, der die Aufgaben und die Abhängigkeiten zwischen ihnen kapselt und definiert, wie sie innerhalb des Workflows ausgeführt werden sollen.

Wir haben einen Airflow-DAG in einer Amazon MWAA-Umgebung erstellt, um unseren MLOps-Workflow zu implementieren. Jede Aufgabe im Workflow ist eine ausführbare Einheit, die in der Programmiersprache Python geschrieben ist und eine Aktion ausführt. Eine Aufgabe kann entweder eine sein Operator oder eine Sensor. In unserem Fall verwenden wir eine Airflow-Python-Operator zusammen mit SageMaker Python-SDK um das Data Wrangler-Python-Skript auszuführen und die nativ unterstützte von Airflow zu verwenden SageMaker-Operatoren um den in SageMaker integrierten XGBoost-Algorithmus zu trainieren und das Modell aus den resultierenden Artefakten zu erstellen. Wir haben auch einen hilfreichen benutzerdefinierten Data Wrangler-Operator erstellt (SageMakerDataWranglerOperator) für Apache Airflow, mit dem Sie Data Wrangler-Flow-Dateien für die Datenverarbeitung verarbeiten können, ohne dass zusätzlicher Code erforderlich ist.

Der folgende Screenshot zeigt den Airflow-DAG mit fünf Schritten zur Implementierung unseres MLOps-Workflows.

Der Schritt „Start“ verwendet einen Python-Operator, um Konfigurationen für die restlichen Schritte im Workflow zu initialisieren. SageMaker_DataWrangler_Step verwendet SageMakerDataWranglerOperator und die Datenflussdatei, die wir zuvor erstellt haben. SageMaker_training_step und SageMaker_create_model_step Verwenden Sie die integrierten SageMaker-Operatoren für das Modelltraining bzw. die Modellerstellung. Unsere Amazon MWAA-Umgebung verwendet den kleinsten Instance-Typ (mw1.small), da der Großteil der Verarbeitung über Verarbeitungsaufträge erfolgt, die einen eigenen Instance-Typ verwenden, der als Konfigurationsparameter innerhalb des Workflows definiert werden kann.

Installation und Anleitung

Detaillierte Schritt-für-Schritt-Installationsanleitungen zum Bereitstellen dieser Lösung finden Sie in unserem GitHub-Repository. Wir haben ein Jupyter-Notebook mit Python-Codezellen verwendet, um den Airflow-DAG einzurichten. Angenommen, Sie haben die Datenflussdatei bereits generiert, finden Sie im Folgenden eine allgemeine Übersicht über die Installationsschritte:

- Erstellen Sie einen S3-Bucket und nachfolgende Ordner, die von Amazon MWAA benötigt werden.

- Erstellen Sie eine Amazon MWAA-Umgebung. Beachten Sie, dass wir für diese Lösung Airflow Version 2.0.2 verwendet haben.

- Erstellen und hochladen Sie a

requirements.txtDatei mit allen Python-Abhängigkeiten, die für die Airflow-Aufgaben erforderlich sind, und laden Sie sie in die/requirementsVerzeichnis im primären S3-Bucket von Amazon MWAA. Dies wird von der verwalteten Airflow-Umgebung verwendet, um die Python-Abhängigkeiten zu installieren. - Laden Sie die

SMDataWranglerOperator.pyDatei an die/dagsVerzeichnis. Dieses Python-Skript enthält Code für den benutzerdefinierten Airflow-Operator für Data Wrangler. Dieser Operator kann für Aufgaben verwendet werden, um beliebige .flow-Dateien zu verarbeiten. - Erstellen und hochladen Sie die

config.pySkript zum/dagsVerzeichnis. Dieses Python-Skript wird für den ersten Schritt unserer DAG verwendet, um Konfigurationsobjekte zu erstellen, die für die verbleibenden Schritte des Workflows erforderlich sind. - Erstellen Sie abschließend die

ml_pipelines.pyDatei an die/dagsVerzeichnis. Dieses Skript enthält die DAG-Definition für den Airflow-Workflow. Hier definieren wir jede der Aufgaben und richten Abhängigkeiten zwischen ihnen ein. Amazon MWAA fragt regelmäßig die/dagsVerzeichnis, um dieses Skript auszuführen, um die DAG zu erstellen oder die vorhandene mit den neuesten Änderungen zu aktualisieren.

Das Folgende ist der Code für SageMaker_DataWrangler_step, die den Brauch verwendet SageMakerDataWranglerOperator. Mit nur wenigen Codezeilen in Ihrem Python-Skript für die DAG-Definition können Sie auf die SageMakerDataWranglerOperator zum Speicherort der Data Wrangler-Flussdatei (der ein S3-Speicherort ist). Hinter den Kulissen verwendet dieser Operator SageMaker Processing-Jobs um die .flow-Datei zu verarbeiten, um die definierten Transformationen auf Ihre Rohdatendateien anzuwenden. Sie können auch die angeben Art der Instanz und Anzahl der vom Data Wrangler-Verarbeitungsjob benötigten Instanzen.

Das config -Parameter akzeptiert ein Wörterbuch (Schlüssel-Wert-Paare) zusätzlicher Konfigurationen, die für den Verarbeitungsauftrag erforderlich sind, z. B. das Ausgabepräfix der endgültigen Ausgabedatei, den Typ der Ausgabedatei (CSV oder Parquet) und den URI für den integrierten Data Wrangler-Container Bild. Der folgende Code ist, was die config Wörterbuch für SageMakerDataWranglerOperator sieht aus wie. Diese Konfigurationen sind für eine SageMaker-Verarbeitung erforderlich Prozessor. Einzelheiten zu jedem dieser Konfigurationsparameter finden Sie unter sagemaker.processing.Processor().

Aufräumen

Um zukünftige Gebühren zu vermeiden, löschen Sie die Ressourcen, die für die von Ihnen implementierten Lösungen erstellt wurden.

- Folge diesen Anleitung wird im GitHub-Repository bereitgestellt, um Ressourcen zu bereinigen, die von der SageMaker Pipelines-Lösung erstellt wurden.

- Folge diesen Anleitung wird im GitHub-Repository bereitgestellt, um Ressourcen zu bereinigen, die von der Step Functions-Lösung erstellt wurden.

- Folge diesen Anleitung wird im GitHub-Repository bereitgestellt, um Ressourcen zu bereinigen, die von der Amazon MWAA-Lösung erstellt wurden.

Zusammenfassung

Dieser Beitrag hat gezeigt, wie Sie Data Wrangler einfach in einige der bekannten Workflow-Automatisierungs- und Orchestrierungstechnologien in AWS integrieren können. Wir haben zunächst einen beispielhaften Anwendungsfall und eine Architektur für die Lösung überprüft, die Data Wrangler für die Datenvorverarbeitung verwendet. Anschließend haben wir gezeigt, wie Sie Data Wrangler mit Pipelines, Step Functions und Amazon MWAA integrieren können.

Als nächsten Schritt können Sie die Codebeispiele und Notebooks in unserem finden und ausprobieren GitHub-Repository Verwenden Sie die detaillierten Anweisungen für jede der in diesem Beitrag besprochenen Lösungen. Um mehr darüber zu erfahren, wie Data Wrangler Ihre ML-Workloads unterstützen kann, besuchen Sie Data Wrangler zur Produktseite und Vorbereiten von ML-Daten mit Amazon SageMaker Data Wrangler.

Über die Autoren

Rodrigo Alarcón ist Senior ML Strategy Solutions Architect bei AWS mit Sitz in Santiago, Chile. In seiner Rolle hilft Rodrigo Unternehmen unterschiedlicher Größe dabei, Geschäftsergebnisse durch cloudbasierte KI- und ML-Lösungen zu erzielen. Seine Interessen umfassen maschinelles Lernen und Cybersicherheit.

Rodrigo Alarcón ist Senior ML Strategy Solutions Architect bei AWS mit Sitz in Santiago, Chile. In seiner Rolle hilft Rodrigo Unternehmen unterschiedlicher Größe dabei, Geschäftsergebnisse durch cloudbasierte KI- und ML-Lösungen zu erzielen. Seine Interessen umfassen maschinelles Lernen und Cybersicherheit.

Ganapathi Krishnamoorthi ist Senior ML Solutions Architect bei AWS. Ganapathi bietet Start-up- und Unternehmenskunden vorschreibende Anleitungen, die ihnen helfen, Cloud-Anwendungen in großem Maßstab zu entwerfen und bereitzustellen. Er ist auf maschinelles Lernen spezialisiert und konzentriert sich darauf, Kunden dabei zu helfen, KI/ML für ihre Geschäftsergebnisse zu nutzen. Wenn er nicht bei der Arbeit ist, erkundet er gerne die Natur und hört Musik.

Ganapathi Krishnamoorthi ist Senior ML Solutions Architect bei AWS. Ganapathi bietet Start-up- und Unternehmenskunden vorschreibende Anleitungen, die ihnen helfen, Cloud-Anwendungen in großem Maßstab zu entwerfen und bereitzustellen. Er ist auf maschinelles Lernen spezialisiert und konzentriert sich darauf, Kunden dabei zu helfen, KI/ML für ihre Geschäftsergebnisse zu nutzen. Wenn er nicht bei der Arbeit ist, erkundet er gerne die Natur und hört Musik.

Anjan Biswas ist Senior AI Services Solutions Architect mit Fokus auf AI/ML und Data Analytics. Anjan ist Teil des weltweiten KI-Serviceteams und arbeitet mit Kunden zusammen, um ihnen zu helfen, Geschäftsprobleme mit KI und ML zu verstehen und Lösungen für diese zu entwickeln. Anjan verfügt über mehr als 14 Jahre Erfahrung in der Arbeit mit globalen Lieferketten-, Fertigungs- und Einzelhandelsorganisationen und hilft Kunden aktiv beim Einstieg und bei der Skalierung von AWS-KI-Services.

Anjan Biswas ist Senior AI Services Solutions Architect mit Fokus auf AI/ML und Data Analytics. Anjan ist Teil des weltweiten KI-Serviceteams und arbeitet mit Kunden zusammen, um ihnen zu helfen, Geschäftsprobleme mit KI und ML zu verstehen und Lösungen für diese zu entwickeln. Anjan verfügt über mehr als 14 Jahre Erfahrung in der Arbeit mit globalen Lieferketten-, Fertigungs- und Einzelhandelsorganisationen und hilft Kunden aktiv beim Einstieg und bei der Skalierung von AWS-KI-Services.

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- Amazon Managed Workflows für Apache Airflow (Amazon MWAA)

- Amazon Sage Maker

- Amazon SageMaker Data Wrangler

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- AWS Maschinelles Lernen

- AWS Step-Funktionen

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Syntax

- Zephyrnet