Wir freuen uns, heute bekannt geben zu können, dass die von Meta entwickelten Llama 2-Grundlagenmodelle für Kunden verfügbar sind Amazon SageMaker-JumpStart. Die Llama 2-Familie großer Sprachmodelle (LLMs) ist eine Sammlung vorab trainierter und fein abgestimmter generativer Textmodelle mit einer Größenordnung von 7 bis 70 Milliarden Parametern. Fein abgestimmte LLMs, Llama-2-Chat genannt, sind für Dialog-Anwendungsfälle optimiert. Sie können diese Modelle ganz einfach ausprobieren und mit SageMaker JumpStart verwenden, einem Hub für maschinelles Lernen (ML), der Zugriff auf Algorithmen, Modelle und ML-Lösungen bietet, sodass Sie schnell mit ML beginnen können.

In diesem Beitrag erklären wir Ihnen, wie Sie Llama 2-Modelle über SageMaker JumpStart verwenden.

Was ist Lama 2?

Llama 2 ist ein autoregressives Sprachmodell, das eine optimierte Transformatorarchitektur verwendet. Llama 2 ist für kommerzielle und Forschungszwecke in englischer Sprache gedacht. Es gibt ihn in verschiedenen Parametergrößen – 7 Milliarden, 13 Milliarden und 70 Milliarden – sowie in vorab trainierten und fein abgestimmten Variationen. Laut Meta nutzen die optimierten Versionen Supervised Fine Tuning (SFT) und Reinforcement Learning with Human Feedback (RLHF), um sich an den menschlichen Präferenzen für Hilfsbereitschaft und Sicherheit auszurichten. Llama 2 wurde mit 2 Billionen Daten-Tokens aus öffentlich zugänglichen Quellen vorab trainiert. Die abgestimmten Modelle sind für assistentenähnlichen Chat gedacht, während vorab trainierte Modelle für eine Vielzahl von Aufgaben zur Erzeugung natürlicher Sprache angepasst werden können. Unabhängig davon, welche Version des Modells ein Entwickler verwendet, ist die Leitfaden zur verantwortungsvollen Nutzung von Meta kann bei der Steuerung zusätzlicher Feinabstimmungen behilflich sein, die möglicherweise erforderlich sind, um die Modelle mit geeigneten Sicherheitsminderungen anzupassen und zu optimieren.

Was ist SageMaker JumpStart?

Mit SageMaker JumpStart können ML-Praktiker aus einer breiten Auswahl an Open-Source-Grundlagenmodellen wählen. ML-Praktiker können Basismodelle für dedizierte Personen bereitstellen Amazon Sage Maker Erstellen Sie Instanzen aus einer netzwerkisolierten Umgebung und passen Sie Modelle mithilfe von SageMaker für die Modellschulung und -bereitstellung an.

Sie können Llama 2 jetzt mit wenigen Klicks entdecken und bereitstellen Amazon SageMaker-Studio oder programmgesteuert über das SageMaker Python SDK, sodass Sie Modellleistung und MLOps-Steuerelemente mit SageMaker-Funktionen wie ableiten können Amazon SageMaker-Pipelines, Amazon SageMaker-Debuggeroder Containerprotokolle. Das Modell wird in einer sicheren AWS-Umgebung und unter Ihrer VPC-Kontrolle bereitgestellt, um die Datensicherheit zu gewährleisten. Llama 2-Modelle sind ab sofort in Amazon SageMaker Studio verfügbar, zunächst in us-east 1 und us-west 2 Regionen.

Entdecken Sie Modelle

Sie können über SageMaker JumpStart in der SageMaker Studio-Benutzeroberfläche und dem SageMaker Python SDK auf die Grundmodelle zugreifen. In diesem Abschnitt erfahren Sie, wie Sie die Modelle in SageMaker Studio entdecken.

SageMaker Studio ist eine integrierte Entwicklungsumgebung (IDE), die eine einzige webbasierte visuelle Schnittstelle bietet, über die Sie auf speziell entwickelte Tools zugreifen können, um alle ML-Entwicklungsschritte durchzuführen, von der Datenvorbereitung bis hin zum Erstellen, Trainieren und Bereitstellen Ihrer ML-Modelle. Weitere Informationen zu den ersten Schritten und zur Einrichtung von SageMaker Studio finden Sie unter Amazon SageMaker-Studio.

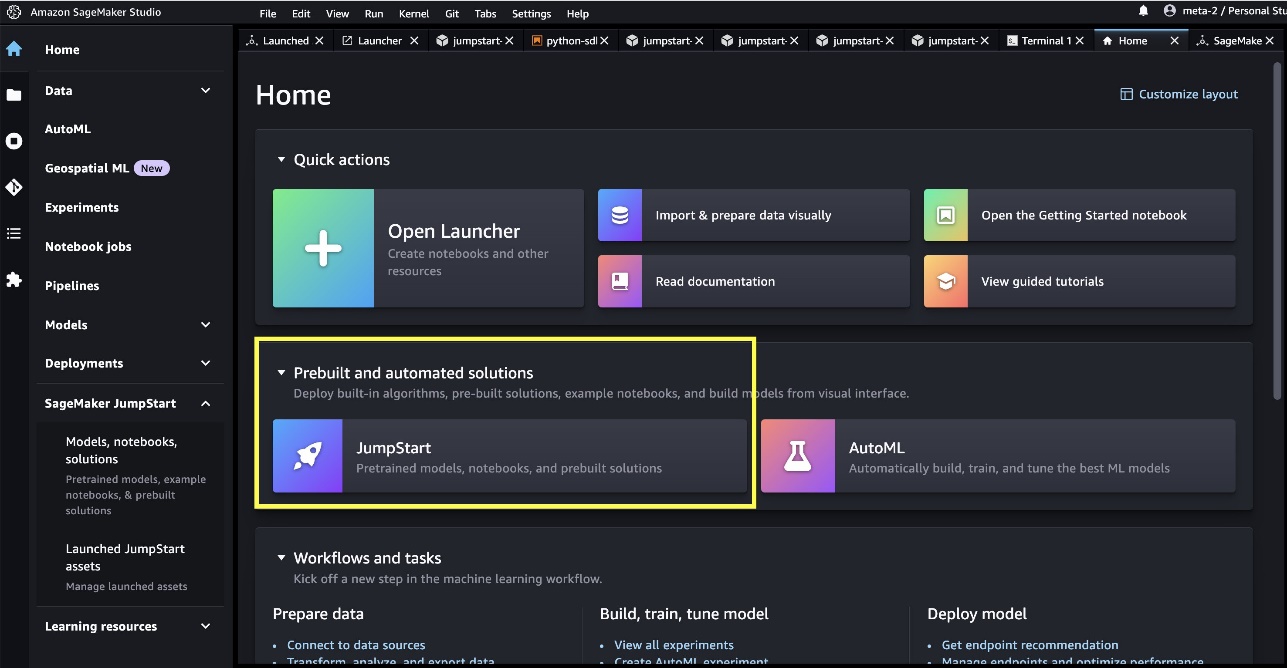

Sobald Sie sich im SageMaker Studio befinden, können Sie unten auf SageMaker JumpStart zugreifen, das vorab trainierte Modelle, Notebooks und vorgefertigte Lösungen enthält Vorgefertigte und automatisierte Lösungen.

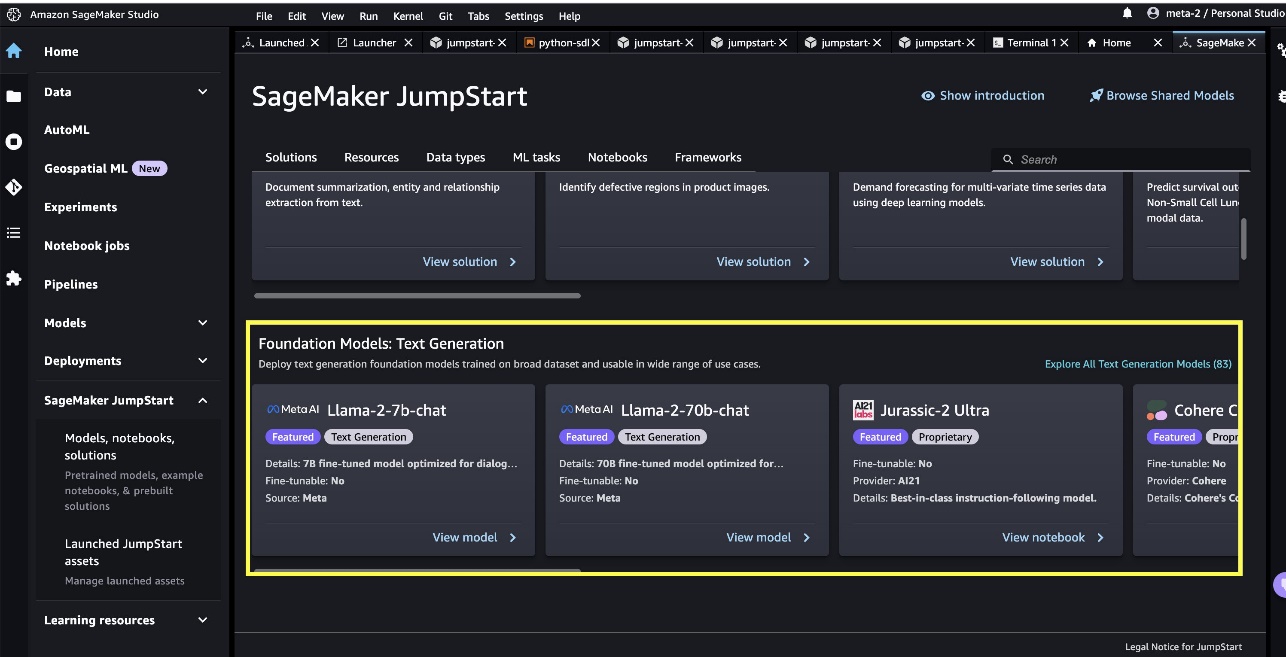

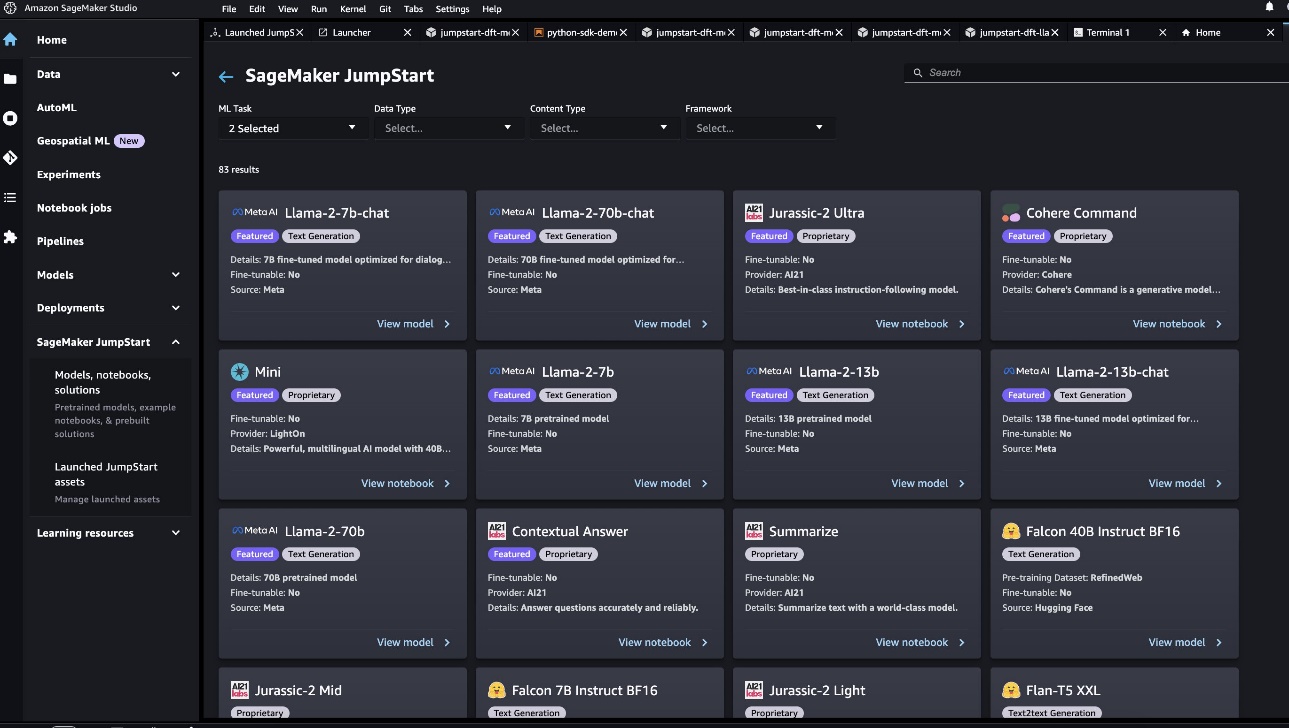

Auf der SageMaker JumpStart-Landingpage können Sie nach Lösungen, Modellen, Notizbüchern und anderen Ressourcen suchen. Im finden Sie zwei Flaggschiff-Llama-2-Modelle Foundation-Modelle: Textgenerierung Karussell. Wenn Sie keine Llama 2-Modelle sehen, aktualisieren Sie Ihre SageMaker Studio-Version, indem Sie sie herunterfahren und neu starten. Weitere Informationen zu Versionsaktualisierungen finden Sie unter Fahren Sie Studio Apps herunter und aktualisieren Sie sie.

Weitere vier Modellvarianten finden Sie auch unter der Auswahl Entdecken Sie alle Modelle zur Textgenerierung oder suchen nach llama im Suchfeld.

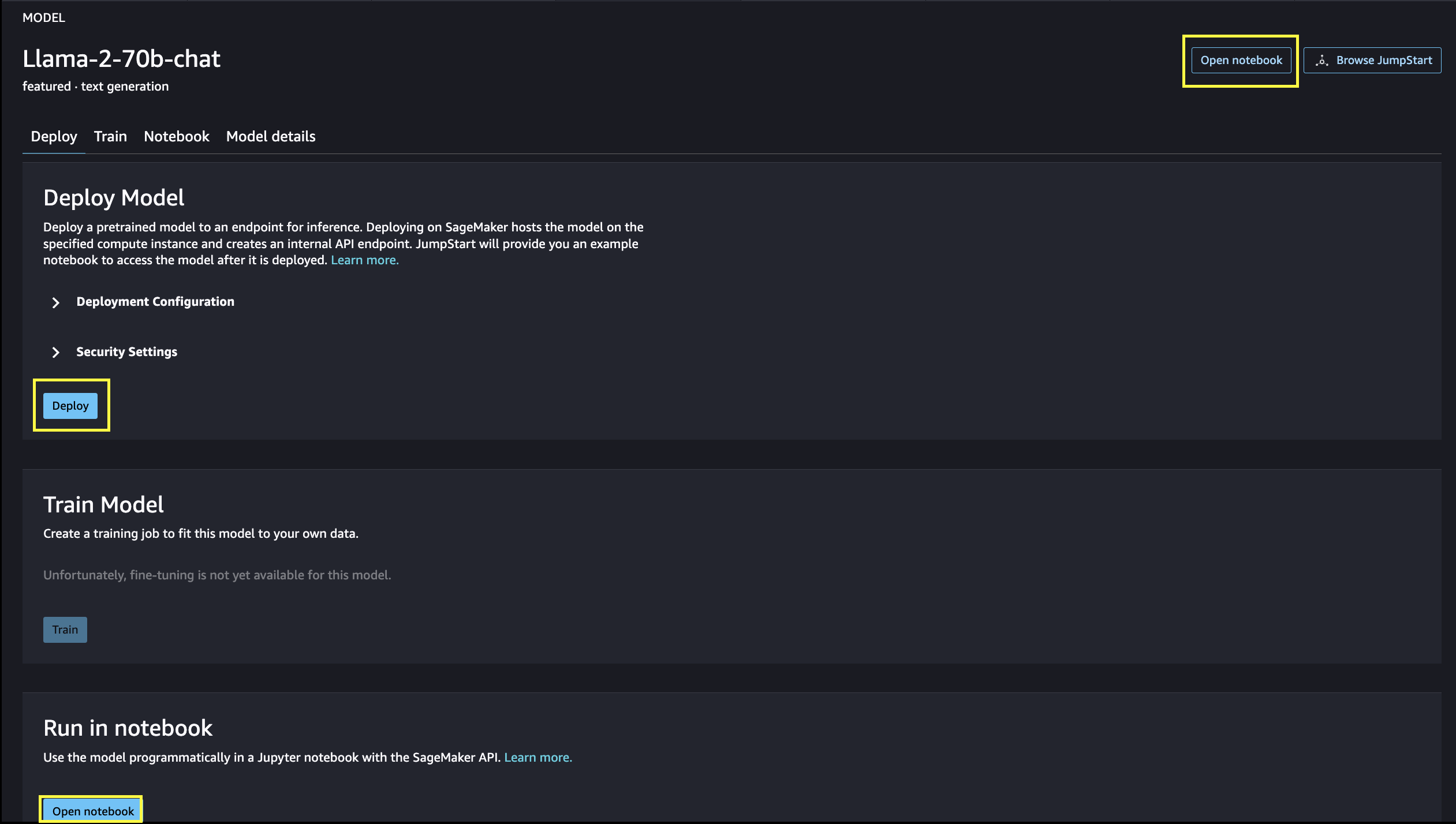

Sie können die Modellkarte auswählen, um Details zum Modell anzuzeigen, z. B. Lizenz, für das Training verwendete Daten und Verwendung. Sie können auch zwei Schaltflächen finden, Deploy und Notizbuch öffnen, die Ihnen bei der Verwendung des Modells helfen.

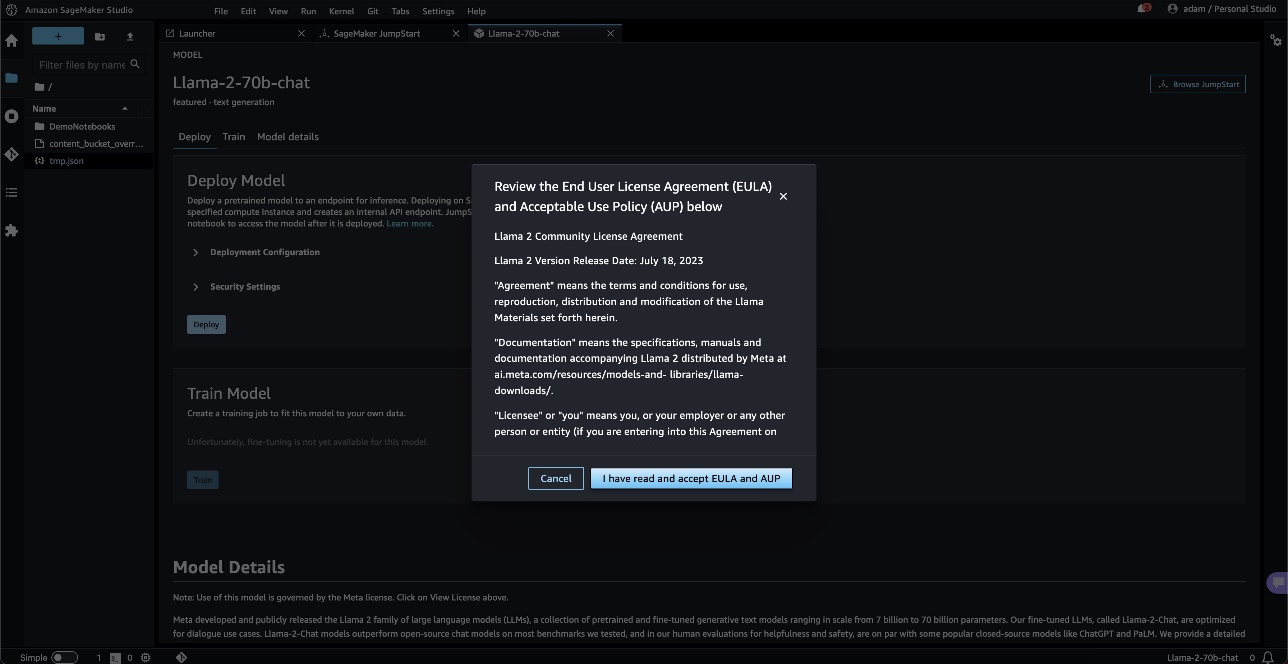

Wenn Sie eine der beiden Schaltflächen auswählen, werden in einem Popup die Endbenutzer-Lizenzvereinbarung und die Richtlinien zur akzeptablen Nutzung angezeigt, die Sie bestätigen müssen.

Nach der Bestätigung fahren Sie mit dem nächsten Schritt fort, um das Modell zu verwenden.

Stellen Sie ein Modell bereit

Wenn Sie wählen Deploy und bestätigen Sie die Bedingungen. Die Modellbereitstellung beginnt. Alternativ können Sie die Bereitstellung über das Beispielnotizbuch durchführen, das angezeigt wird, indem Sie auf klicken Notizbuch öffnen. Das Beispielnotizbuch bietet umfassende Anleitungen zur Bereitstellung des Modells für Rückschlüsse und zur Bereinigung von Ressourcen.

Um die Bereitstellung mithilfe eines Notebooks durchzuführen, wählen wir zunächst ein geeignetes Modell aus, das durch angegeben wird model_id. Sie können jedes der ausgewählten Modelle mit dem folgenden Code auf SageMaker bereitstellen:

Dadurch wird das Modell auf SageMaker mit Standardkonfigurationen bereitgestellt, einschließlich Standardinstanztyp und Standard-VPC-Konfigurationen. Sie können diese Konfigurationen ändern, indem Sie in nicht standardmäßige Werte angeben JumpStartModel. Nach der Bereitstellung können Sie über den SageMaker-Prädiktor Rückschlüsse auf den bereitgestellten Endpunkt ziehen:

Fein abgestimmte Chat-Modelle (Llama-2-7b-chat, Llama-2-13b-chat, Llama-2-70b-chat) akzeptieren einen Chat-Verlauf zwischen dem Benutzer und dem Chat-Assistenten und generieren den nachfolgenden Chat. Die vorab trainierten Modelle (Llama-2-7b, Llama-2-13b, Llama-2-70b) erfordern eine String-Eingabeaufforderung und führen eine Textvervollständigung anhand der bereitgestellten Eingabeaufforderung durch. Siehe den folgenden Code:

Beachten Sie, dass standardmäßig accept_eula ist auf false gesetzt. Sie müssen einstellen accept_eula=true um den Endpunkt erfolgreich aufzurufen. Dadurch akzeptieren Sie die Benutzerlizenzvereinbarung und die Richtlinien zur akzeptablen Nutzung, wie bereits erwähnt. Du kannst auch herunterladen die Lizenzvereinbarung.

Custom_attributes Zur Übergabe der EULA werden Schlüssel/Wert-Paare verwendet. Schlüssel und Wert werden durch getrennt = und Paare werden durch getrennt ;. Wenn der Benutzer denselben Schlüssel mehr als einmal übergibt, wird der letzte Wert beibehalten und an den Skript-Handler übergeben (d. h. in diesem Fall für die bedingte Logik verwendet). Zum Beispiel, wenn accept_eula=false; accept_eula=true wird dann an den Server übergeben accept_eula=true wird aufbewahrt und an den Skripthandler übergeben.

Inferenzparameter steuern den Textgenerierungsprozess am Endpunkt. Die maximale Kontrolle über neue Token bezieht sich auf die Größe der vom Modell generierten Ausgabe. Beachten Sie, dass dies nicht mit der Anzahl der Wörter identisch ist, da das Vokabular des Modells nicht mit dem Vokabular der englischen Sprache übereinstimmt und nicht jedes Token ein Wort der englischen Sprache ist. Die Temperatur steuert die Zufälligkeit der Ausgabe. Höhere Temperaturen führen zu kreativeren und halluzinierteren Ergebnissen. Alle Inferenzparameter sind optional.

Die folgende Tabelle listet alle in SageMaker JumpStart verfügbaren Llama-Modelle zusammen mit dem auf model_ids, Standardinstanztypen und die maximale Anzahl der Gesamttokens (Summe aus der Anzahl der Eingabetokens und der Anzahl der generierten Tokens), die für jedes dieser Modelle unterstützt werden.

| Modell | Modell-ID | Maximale Gesamtanzahl an Token | Standardinstanztyp |

| Lama-2-7b | meta-textgeneration-llama-2-7b | 4096 | ml.g5.2xgroß |

| Lama-2-7b-Chat | meta-textgeneration-llama-2-7b-f | 4096 | ml.g5.2xgroß |

| Lama-2-13b | meta-textgeneration-llama-2-13b | 4096 | ml.g5.12xgroß |

| Lama-2-13b-Chat | meta-textgeneration-llama-2-13b-f | 4096 | ml.g5.12xgroß |

| Lama-2-70b | meta-textgeneration-llama-2-70b | 4096 | ml.g5.48xgroß |

| Lama-2-70b-Chat | meta-textgeneration-llama-2-70b-f | 4096 | ml.g5.48xgroß |

Beachten Sie, dass SageMaker-Endpunkte ein Timeout-Limit von 60 Sekunden haben. Auch wenn das Modell möglicherweise 4096 Token generieren kann, schlägt die Anforderung fehl, wenn die Textgenerierung mehr als 60 Sekunden dauert. Für die Modelle 7B, 13B und 70B empfehlen wir die Einstellung max_new_tokens nicht größer als 1500, 1000 bzw. 500, während die Gesamtzahl der Token weniger als 4 KB beträgt.

Schlussfolgerungen und Beispielaufforderungen für Llama-2-70b

Sie können Lama-Modelle zur Textvervollständigung für jeden beliebigen Textabschnitt verwenden. Durch die Textgenerierung können Sie eine Vielzahl von Aufgaben ausführen, z. B. die Beantwortung von Fragen, Sprachübersetzungen, Stimmungsanalysen und vieles mehr. Die Eingabenutzlast für den Endpunkt sieht wie der folgende Code aus:

Im Folgenden finden Sie einige Beispielaufforderungen und den vom Modell generierten Text. Alle Ausgaben werden mit Inferenzparametern generiert {"max_new_tokens":256, "top_p":0.9, "temperature":0.6}.

Im nächsten Beispiel zeigen wir, wie man Llama-Modelle mit wenigen Schüssen im Kontextlernen verwendet, wobei wir dem Modell Trainingsbeispiele zur Verfügung stellen. Beachten Sie, dass wir nur Rückschlüsse auf das bereitgestellte Modell ziehen und sich die Modellgewichte während dieses Prozesses nicht ändern.

Schlussfolgerungen und Beispielaufforderungen für Llama-2-70b-chat

Bei Llama-2-Chat-Modellen, die für Dialog-Anwendungsfälle optimiert sind, ist die Eingabe in die Endpunkte des Chat-Modells der bisherige Verlauf zwischen dem Chat-Assistenten und dem Benutzer. Sie können Fragen stellen, die sich auf das bisher stattgefundene Gespräch beziehen. Sie können auch die Systemkonfiguration bereitstellen, beispielsweise Personas, die das Verhalten des Chat-Assistenten definieren. Die Eingabenutzlast für den Endpunkt sieht wie der folgende Code aus:

Im Folgenden finden Sie einige Beispielaufforderungen und den vom Modell generierten Text. Alle Ausgaben werden mit den Inferenzparametern generiert {"max_new_tokens": 512, "top_p": 0.9, "temperature": 0.6}.

Im folgenden Beispiel hat der Benutzer mit dem Assistenten ein Gespräch über Sehenswürdigkeiten in Paris geführt. Als nächstes erkundigt sich der Nutzer nach der ersten vom Chat-Assistenten empfohlenen Option.

In den folgenden Beispielen legen wir die Systemkonfiguration fest:

Aufräumen

Nachdem Sie mit der Ausführung des Notebooks fertig sind, stellen Sie sicher, dass Sie alle Ressourcen löschen, damit alle Ressourcen, die Sie im Prozess erstellt haben, gelöscht werden und Ihre Abrechnung gestoppt wird:

Zusammenfassung

In diesem Beitrag haben wir Ihnen gezeigt, wie Sie mit Llama 2-Modellen in SageMaker Studio beginnen. Damit haben Sie Zugriff auf sechs Llama 2-Grundlagenmodelle, die Milliarden von Parametern enthalten. Da die Basismodelle vorab trainiert sind, können sie auch dazu beitragen, die Schulungs- und Infrastrukturkosten zu senken und eine Anpassung an Ihren Anwendungsfall zu ermöglichen. Um mit SageMaker JumpStart zu beginnen, besuchen Sie die folgenden Ressourcen:

Über die Autoren

Juni gewonnen ist Produktmanager bei SageMaker JumpStart. Sein Schwerpunkt liegt darauf, Basismodelle leicht auffindbar und nutzbar zu machen, um Kunden bei der Entwicklung generativer KI-Anwendungen zu unterstützen. Zu seinen Erfahrungen bei Amazon gehören auch mobile Shopping-Anwendungen und die Zustellung auf der letzten Meile.

Juni gewonnen ist Produktmanager bei SageMaker JumpStart. Sein Schwerpunkt liegt darauf, Basismodelle leicht auffindbar und nutzbar zu machen, um Kunden bei der Entwicklung generativer KI-Anwendungen zu unterstützen. Zu seinen Erfahrungen bei Amazon gehören auch mobile Shopping-Anwendungen und die Zustellung auf der letzten Meile.

Vivek Madan ist ein angewandter Wissenschaftler im Amazon SageMaker JumpStart-Team. Er promovierte an der University of Illinois at Urbana-Champaign und war Postdoktorand an der Georgia Tech. Er ist ein aktiver Forscher in den Bereichen maschinelles Lernen und Algorithmendesign und hat Artikel auf Konferenzen von EMNLP, ICLR, COLT, FOCS und SODA veröffentlicht.

Vivek Madan ist ein angewandter Wissenschaftler im Amazon SageMaker JumpStart-Team. Er promovierte an der University of Illinois at Urbana-Champaign und war Postdoktorand an der Georgia Tech. Er ist ein aktiver Forscher in den Bereichen maschinelles Lernen und Algorithmendesign und hat Artikel auf Konferenzen von EMNLP, ICLR, COLT, FOCS und SODA veröffentlicht.  Kyle Ulrich ist angewandter Wissenschaftler im Amazon SageMaker JumpStart-Team. Seine Forschungsinteressen umfassen skalierbare Algorithmen für maschinelles Lernen, Computer Vision, Zeitreihen, Bayes'sche Nichtparametrik und Gaußsche Prozesse. Er promovierte an der Duke University und hat Artikel in NeurIPS, Cell und Neuron veröffentlicht.

Kyle Ulrich ist angewandter Wissenschaftler im Amazon SageMaker JumpStart-Team. Seine Forschungsinteressen umfassen skalierbare Algorithmen für maschinelles Lernen, Computer Vision, Zeitreihen, Bayes'sche Nichtparametrik und Gaußsche Prozesse. Er promovierte an der Duke University und hat Artikel in NeurIPS, Cell und Neuron veröffentlicht.  Dr. Ashish Khetan ist Senior Applied Scientist bei Amazon SageMaker JumpStart und hilft bei der Entwicklung von Algorithmen für maschinelles Lernen. Er promovierte an der University of Illinois Urbana-Champaign. Er ist ein aktiver Forscher im Bereich maschinelles Lernen und statistische Inferenz und hat zahlreiche Artikel auf NeurIPS-, ICML-, ICLR-, JMLR-, ACL- und EMNLP-Konferenzen veröffentlicht.

Dr. Ashish Khetan ist Senior Applied Scientist bei Amazon SageMaker JumpStart und hilft bei der Entwicklung von Algorithmen für maschinelles Lernen. Er promovierte an der University of Illinois Urbana-Champaign. Er ist ein aktiver Forscher im Bereich maschinelles Lernen und statistische Inferenz und hat zahlreiche Artikel auf NeurIPS-, ICML-, ICLR-, JMLR-, ACL- und EMNLP-Konferenzen veröffentlicht.  Sundar Ranganathan ist der globale Leiter der GenAI/Frameworks GTM-Spezialisten bei AWS. Er konzentriert sich auf die Entwicklung einer GTM-Strategie für große Sprachmodelle, GenAI und große ML-Workloads für AWS-Dienste wie Amazon EC2, EKS, EFA, AWS Batch und Amazon SageMaker. Zu seinen Erfahrungen zählen Führungspositionen im Produktmanagement und in der Produktentwicklung bei NetApp, Micron Technology, Qualcomm und Mentor Graphics.

Sundar Ranganathan ist der globale Leiter der GenAI/Frameworks GTM-Spezialisten bei AWS. Er konzentriert sich auf die Entwicklung einer GTM-Strategie für große Sprachmodelle, GenAI und große ML-Workloads für AWS-Dienste wie Amazon EC2, EKS, EFA, AWS Batch und Amazon SageMaker. Zu seinen Erfahrungen zählen Führungspositionen im Produktmanagement und in der Produktentwicklung bei NetApp, Micron Technology, Qualcomm und Mentor Graphics.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Automobil / Elektrofahrzeuge, Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- BlockOffsets. Modernisierung des Eigentums an Umweltkompensationen. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/llama-2-foundation-models-from-meta-are-now-available-in-amazon-sagemaker-jumpstart/

- :hast

- :Ist

- :nicht

- :Wo

- $UP

- 1

- 10

- 100

- 11

- 13

- 15%

- 17

- 19

- 20

- 30

- 31

- 33

- 360-Grad

- 40

- 4k

- 500

- 7

- 70

- 8

- 9

- a

- Fähig

- LiveBuzz

- Akzeptieren

- akzeptabel

- Zugang

- Zugänglichkeit

- zugänglich

- Nach

- anerkennen

- über

- aktiv

- hinzufügen

- Hinzufügen

- Zusätzliche

- Adresse

- Nach der

- aufs Neue

- gegen

- Zustimmung

- AI

- Algorithmus

- Algorithmen

- ausrichten

- Alle

- erlauben

- entlang

- ebenfalls

- immer

- am

- Amazon

- Amazon EC2

- Amazon Sage Maker

- Amazon SageMaker-JumpStart

- Amazon SageMaker-Studio

- Amazon Web Services

- amerikanisch

- an

- Analyse

- und

- und Infrastruktur

- Bekannt geben

- Ein anderer

- beantworten

- jedem

- jemand

- Anwendung

- Anwendungen

- angewandt

- schätzen

- angemessen

- Arc

- Architektur

- SIND

- Kunst

- AS

- helfen

- Assistentin

- At

- Atmosphäre

- Attraktionen

- Automatisiert

- verfügbar

- AWS

- Banane

- basic

- Schlacht

- Bayesianisch

- BE

- schön

- Die Schönheit

- wurde

- weil

- werden

- war

- Bier

- Bevor

- Verhalten

- Beijing

- Glauben

- angenommen

- BESTE

- zwischen

- Rechnungs-

- Milliarde

- Milliarden

- Schwarz

- Box

- Break

- atemberaubend

- breit

- bauen

- Building

- erbaut

- aber

- Taste im nun erscheinenden Bestätigungsfenster nun wieder los.

- by

- namens

- CAN

- Hauptstadt

- Auto

- Karte

- Karussell

- Häuser

- Fälle

- CAT

- Übernehmen

- Schokolade

- Auswählen

- Auswahl

- Stadt

- klassisch

- Code

- Sammlung

- kombiniert

- vereint

- kommt

- Kommen

- kommerziell

- Unternehmen

- Abschluss

- Computer

- Computer Vision

- Kongressbegleitung

- zuversichtlich

- Konfiguration

- betrachtet

- konstante

- Baugewerbe

- enthalten

- Container

- enthält

- Inhalt

- kontextuelle

- fortsetzen

- ständig

- Smartgeräte App

- Steuerung

- Praktische

- Gespräch

- Kosten

- Land

- Mut,

- Abdeckung

- erstellen

- erstellt

- Kreativ (Creative)

- Kultur-

- KULTUR

- Tasse

- Kunden

- Anpassung

- anpassen

- technische Daten

- Datensicherheit

- gewidmet

- Hingabe

- Standard

- definieren

- Lieferanten

- einsetzen

- Einsatz

- Bereitstellen

- Einsatz

- setzt ein

- Design

- entworfen

- erwünscht

- Reiseziel

- Reiseziele

- Details

- entwickeln

- entwickelt

- Entwickler:in / Unternehmen

- Entwicklung

- Entwicklung

- Dialog

- Unterschied

- anders

- schwer

- entdeckt,

- unverwechselbare

- do

- Dokumentationen

- Dabei

- erledigt

- Nicht

- verdoppelt

- nach unten

- Herzog

- Duke University

- im

- e

- jeder

- Früher

- leicht

- Einfache

- Ludwig

- Einstein

- entweder

- ermöglichen

- ermöglichen

- Ende

- End-to-End

- Endpunkt

- Entwicklung

- Englisch

- genießen

- genug

- gewährleisten

- Arbeitsumfeld

- Ausrüstung

- Äther

- Sogar

- Veranstaltungen

- jedermann

- Beispiel

- Beispiele

- aufgeregt

- ERFAHRUNGEN

- Experiment

- Experimente

- express

- FAIL

- Gescheitert

- Messe

- falsch

- Familie

- berühmt

- weit

- Kunststück

- funktions

- Eigenschaften

- Feedback

- Feet

- wenige

- Filme

- Finale

- Endlich

- Finden Sie

- Vorname

- Flaggschiff

- Schwimmer

- Fließt

- konzentriert

- Folgende

- Aussichten für

- vorwärts

- gefunden

- Foundation

- vier

- Frankreich

- Französisch

- für

- voll

- weiter

- Zukunft

- Allgemeines

- erzeugen

- erzeugt

- Generation

- generativ

- Generative KI

- Georgien

- bekommen

- ABSICHT

- Glas

- Global

- Go

- gehen

- Grafik

- groß

- mehr

- bahnbrechend

- Wachsen Sie über sich hinaus

- die Vermittlung von Kompetenzen,

- Guide

- hätten

- Griffe

- passiert

- glücklich

- hart

- harte Arbeit

- Haben

- mit

- he

- ganzer

- Hilfe

- Unternehmen

- hilft

- hier

- hi

- GUTE

- höher

- seine

- historisch

- Geschichte

- Gehäuse

- Ultraschall

- Hilfe

- HTML

- HTTPS

- Nabe

- human

- i

- ikonischen

- Idee

- if

- ii

- Illinois

- Impact der HXNUMXO Observatorien

- importieren

- wichtig

- beeindruckend

- in

- das

- Dazu gehören

- Einschließlich

- Incorporated

- Information

- Infrastruktur

- anfänglich

- Varianten des Eingangssignals:

- inspirierte

- inspirierend

- Instanz

- sofort

- Anleitung

- integriert

- beabsichtigt

- Interessen

- Schnittstelle

- in

- isoliert

- IT

- SEINE

- Reise

- jpg

- nur

- Aufbewahrung

- gehalten

- Wesentliche

- Art

- Wissen

- bekannt

- Landung

- Wahrzeichen

- Sprache

- grosse

- großflächig

- höchste

- Nachname

- Spät

- starten

- Gesetze

- Leadership

- LERNEN

- Lernen und wachsen

- lernen

- am wenigsten

- weniger

- Cholesterinspiegel

- Lizenz

- Lebensdauer

- !

- Gefällt mir

- LIMIT

- Listen

- Kataloge

- ll

- Lama

- Logik

- Lang

- lange Zeit

- suchen

- SIEHT AUS

- ich liebe

- geliebt wird

- senken

- Maschine

- Maschinelles Lernen

- gemacht

- um

- MACHT

- Making

- Management

- Manager

- viele

- Wunder

- Materie

- maximal

- Kann..

- Bedeutung

- messen

- Medien

- mittlere

- erwähnt

- Nachricht

- Meta

- Mikron

- Minute

- Minuten

- Mischung

- ML

- MLOps

- Mobil

- Modell

- für

- Moment

- Monat

- mehr

- vor allem warme

- Am beliebtesten

- Bewegung

- Film

- viel

- Museum

- Museen

- Musik

- Name

- Natürliche

- notwendig,

- Need

- erforderlich

- Netzwerk

- Neu

- New York

- weiter

- nicht

- Notizbuch

- jetzt an

- Anzahl

- und viele

- NY

- of

- bieten

- bieten

- Angebote

- ÖL

- on

- einmal

- EINEM

- einzige

- XNUMXh geöffnet

- Open-Source-

- Optimieren

- optimiert

- Option

- or

- Andere

- Anders

- Andernfalls

- UNSERE

- Möglichkeiten für das Ausgangssignal:

- übrig

- Gesamt-

- Seite

- Paare

- Papier

- Papiere

- Parameter

- Parameter

- Paris

- Teil

- passieren

- Bestanden

- leitet

- passt

- Frieden

- Ausführen

- Leistung

- dauerhaft

- Telefon

- Fotografien

- Physik

- Stück

- Pizza

- Kunststoff

- Plato

- Datenintelligenz von Plato

- PlatoData

- gespielt

- Datenschutzrichtlinien

- Pop-up

- Beliebt

- Post

- Post-

- Predictor

- Vorlieben

- Vorbereitung

- Gegenwart

- früher

- Prozessdefinierung

- anpassen

- Produkt

- Produktentwicklung

- Produktmanagement

- Produkt-Manager

- Vorschläge

- stolz

- die

- vorausgesetzt

- bietet

- Bereitstellung

- Öffentlichkeit

- öffentlichen Verkehrsmitteln

- öffentlich

- veröffentlicht

- Zweck

- setzen

- Python

- Qualcomm

- Fragen

- Direkt

- schnell

- Ramps

- Zufälligkeit

- Angebot

- Bereich

- bereit

- Gründe

- erhalten

- Rezept

- empfehlen

- empfohlen

- bezieht sich

- Ungeachtet

- Regionen

- relativ

- Relativität

- wiederholt

- vertreten

- Anforderung

- erfordert

- Forschungsprojekte

- Forscher

- Downloads

- beziehungsweise

- Reagieren

- REST

- Folge

- Die Ergebnisse

- Flüsse

- Rollen

- Rollen

- Führen Sie

- Laufen

- s

- Sicherheit

- sagemaker

- Salz

- gleich

- skalierbaren

- Skalieren

- Wissenschaftler

- Wissenschaftler

- Sdk

- WASSER

- Suche

- Suche

- Abschnitt

- Verbindung

- Sicherheitdienst

- sehen

- Sehen

- schien

- ausgewählt

- Auswahl

- Auswahl

- senden

- Senior

- Gefühl

- Modellreihe

- Lösungen

- Dienst

- kompensieren

- Einstellung

- Form

- Hai

- Shopping

- sollte

- erklären

- zeigte

- Konzerte

- Herunterfahren

- Bedeutung

- signifikant

- Einfacher

- einfach

- Single

- am Standort

- Seiten

- SIX

- Größe

- Langsam

- klein

- So

- bis jetzt

- Social Media

- Social Media

- Lösungen

- einige

- Quelle

- Quellen

- besondere

- Spezialisten

- angegeben

- Geschwindigkeit

- steht

- Anfang

- begonnen

- Bundesstaat

- Staaten

- statistisch

- Schritt

- Shritte

- gestoppt

- Strategie

- Schnur

- Struktur

- Studio Adressen

- Atemberaubende

- Fach

- Folge

- Erfolg

- Erfolgreich

- so

- Unterstützte

- sicher

- Symbol

- System

- Tabelle

- Nehmen

- nimmt

- und Aufgaben

- Geschmack

- Team

- Tech

- Technologie

- vorübergehend

- AGB

- als

- Vielen Dank

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Die Hauptstadt

- Die Zukunft

- Die Quelle

- die Welt

- ihr

- Sie

- Theorie

- Dort.

- Diese

- vom Nutzer definierten

- think

- fehlen uns die Worte.

- obwohl?

- Durch

- Tiger

- Zeit

- Zeitfolgen

- mal

- Titel

- zu

- heute

- gemeinsam

- Zeichen

- Tokens

- Werkzeuge

- Top

- Gesamt

- Tower

- Training

- Ausbildung

- Transformator

- Übersetzen

- Übersetzungen

- , des Transports

- Billion

- versuchen

- XNUMX

- tippe

- Typen

- ui

- für

- unvergesslich

- einzigartiges

- Universität

- bis

- Aktualisierung

- Updates

- verwendbar

- -

- Anwendungsfall

- benutzt

- Mitglied

- Nutzer

- verwendet

- Verwendung von

- Wert

- Werte

- Vielfalt

- Version

- Versionen

- sehr

- Anzeigen

- Ansichten

- Seh-

- Besuchen Sie

- Besucher

- Volumen

- wollte

- Krieg

- wurde

- we

- Netz

- Web-Services

- Webbasiert

- Webseite

- GUT

- Wal

- Was

- Was ist

- wann

- während

- welche

- während

- warum

- werden wir

- Fenster

- mit

- Word

- Worte

- Arbeiten

- Werk

- weltweit wie ausgehandelt und gekauft ausgeführt wird.

- weltbekannt

- wickeln

- Jahr

- York

- Du

- Ihr

- sich selbst

- Zephyrnet

- PLZ