Wenn Unternehmen Modelle für die Produktion bereitstellen, suchen sie ständig nach Möglichkeiten, die Leistung ihrer Basismodelle (FMs) zu optimieren, die auf den neuesten Beschleunigern ausgeführt werden, z AWS-Inferenz und GPUs, sodass sie ihre Kosten senken und die Antwortlatenz verringern können, um den Endbenutzern das beste Erlebnis zu bieten. Allerdings nutzen einige FMs die verfügbaren Beschleuniger der Instanzen, auf denen sie bereitgestellt werden, nicht vollständig aus, was zu einer ineffizienten Nutzung der Hardwareressourcen führt. Einige Organisationen stellen mehrere FMs auf derselben Instanz bereit, um alle verfügbaren Beschleuniger besser zu nutzen. Dies erfordert jedoch eine komplexe Orchestrierung der Infrastruktur, die zeitaufwändig und schwer zu verwalten ist. Wenn mehrere FMs dieselbe Instanz nutzen, hat jedes FM seine eigenen Skalierungsanforderungen und Nutzungsmuster, was es schwierig macht, vorherzusagen, wann Sie Instanzen hinzufügen oder entfernen müssen. Beispielsweise kann ein Modell zum Betreiben einer Benutzeranwendung verwendet werden, bei der die Nutzung zu bestimmten Zeiten ansteigen kann, während ein anderes Modell möglicherweise ein konsistenteres Nutzungsmuster aufweist. Neben der Optimierung der Kosten möchten Kunden durch die Reduzierung der Latenz das beste Endbenutzererlebnis bieten. Zu diesem Zweck stellen sie häufig mehrere Kopien eines FM bereit, um Anfragen von Benutzern parallel zu bearbeiten. Da FM-Ausgaben von einem einzelnen Satz bis hin zu mehreren Absätzen reichen können, variiert die Zeit, die zum Abschließen der Inferenzanforderung benötigt wird, erheblich, was zu unvorhersehbaren Latenzspitzen führt, wenn die Anforderungen zufällig zwischen Instanzen weitergeleitet werden. Amazon Sage Maker Unterstützt jetzt neue Inferenzfunktionen, die Ihnen helfen, Bereitstellungskosten und Latenz zu reduzieren.

Sie können jetzt auf Inferenzkomponenten basierende Endpunkte erstellen und Modelle für maschinelles Lernen (ML) auf einem SageMaker-Endpunkt bereitstellen. Eine Inferenzkomponente (IC) abstrahiert Ihr ML-Modell und ermöglicht Ihnen die Zuweisung von CPUs, GPUs usw AWS-Neuron Beschleuniger und Skalierungsrichtlinien pro Modell. Inferenzkomponenten bieten die folgenden Vorteile:

- SageMaker platziert und packt Modelle optimal auf ML-Instanzen, um die Auslastung zu maximieren, was zu Kosteneinsparungen führt.

- SageMaker skaliert jedes Modell basierend auf Ihrer Konfiguration nach oben und unten, um die Anforderungen Ihrer ML-Anwendung zu erfüllen.

- SageMaker skaliert, um Instanzen dynamisch hinzuzufügen und zu entfernen, um sicherzustellen, dass die Kapazität verfügbar ist und gleichzeitig die Rechenleistung im Leerlauf auf ein Minimum beschränkt wird.

- Sie können ein Modell auf null Kopien herunterskalieren, um Ressourcen für andere Modelle freizugeben. Sie können auch festlegen, dass wichtige Modelle immer geladen und für den Datenverkehr bereit bleiben.

Mit diesen Funktionen können Sie die Kosten für die Modellbereitstellung im Durchschnitt um 50 % senken. Die Kosteneinsparungen variieren je nach Arbeitslast und Verkehrsmuster. Nehmen wir ein einfaches Beispiel, um zu veranschaulichen, wie das Packen mehrerer Modelle auf einem einzigen Endpunkt die Auslastung maximieren und Kosten sparen kann. Nehmen wir an, Sie haben eine Chat-Anwendung, die Touristen hilft, lokale Bräuche und Best Practices zu verstehen, die auf zwei Varianten von Llama 2 basiert: eine speziell für europäische Besucher und die andere speziell für amerikanische Besucher. Wir erwarten Verkehr für das europäische Modell zwischen 00:01 und 11:59 UTC und für das amerikanische Modell zwischen 12:00 und 23:59 UTC. Anstatt diese Modelle auf ihren eigenen dedizierten Instanzen bereitzustellen, wo sie die Hälfte der Zeit im Leerlauf bleiben, können Sie sie jetzt auf einem einzigen Endpunkt bereitstellen, um Kosten zu sparen. Sie können das amerikanische Modell auf Null herunterskalieren, wenn es nicht benötigt wird, um Kapazität für das europäische Modell freizugeben und umgekehrt. Dadurch können Sie Ihre Hardware effizient nutzen und Verschwendung vermeiden. Dies ist ein einfaches Beispiel mit zwei Modellen, aber Sie können diese Idee problemlos erweitern, um Hunderte von Modellen auf einem einzigen Endpunkt zu packen, der sich automatisch an Ihre Arbeitslast anpasst.

In diesem Beitrag zeigen wir Ihnen die neuen Funktionen von IC-basierten SageMaker-Endpunkten. Wir führen Sie auch durch die Bereitstellung mehrerer Modelle mithilfe von Inferenzkomponenten und APIs. Abschließend erläutern wir einige der neuen Observability-Funktionen und erläutern, wie Sie automatische Skalierungsrichtlinien für Ihre Modelle einrichten und die Instanzskalierung für Ihre Endpunkte verwalten. Sie können Modelle auch über unsere neue vereinfachte, interaktive Benutzererfahrung bereitstellen. Wir unterstützen auch erweiterte Routing-Funktionen, um die Latenz und Leistung Ihrer Inferenz-Workloads zu optimieren.

Bausteine

Werfen wir einen genaueren Blick darauf, wie diese neuen Funktionen funktionieren. Im Folgenden finden Sie einige neue Terminologien für das SageMaker-Hosting:

- Inferenzkomponente – Ein SageMaker-Hostingobjekt, das Sie zum Bereitstellen eines Modells auf einem Endpunkt verwenden können. Sie können eine Inferenzkomponente erstellen, indem Sie Folgendes angeben:

- Das SageMaker-Modell oder die Spezifikation eines SageMaker-kompatiblen Bildes und Modellartefakte.

- Berechnen Sie die Ressourcenanforderungen, die die Anforderungen jeder Kopie Ihres Modells angeben, einschließlich CPU-Kernen, Host-Speicher und Anzahl der Beschleuniger.

- Musterexemplar – Eine Laufzeitkopie einer Inferenzkomponente, die Anfragen bedienen kann.

- Automatische Skalierung verwalteter Instanzen – Eine SageMaker-Hosting-Funktion zum Erhöhen oder Verringern der Anzahl der für einen Endpunkt verwendeten Recheninstanzen. Die Instanzskalierung reagiert auf die Skalierung von Inferenzkomponenten.

Um eine neue Inferenzkomponente zu erstellen, können Sie ein Containerbild und ein Modellartefakt angeben oder SageMaker-Modelle verwenden, die Sie möglicherweise bereits erstellt haben. Sie müssen auch die Anforderungen an die Rechenressourcen angeben, z. B. die Anzahl der Host-CPU-Kerne, den Host-Speicher oder die Anzahl der Beschleuniger, die Ihr Modell ausführen muss.

Wenn Sie eine Inferenzkomponente bereitstellen, können Sie angeben MinCopies um sicherzustellen, dass das Modell bereits in der von Ihnen benötigten Menge geladen ist und für die Bearbeitung von Anfragen bereit ist.

Sie haben auch die Möglichkeit, Ihre Richtlinien so festzulegen, dass Kopien von Inferenzkomponenten auf Null skaliert werden. Wenn beispielsweise keine Last gegen einen IC ausgeführt wird, wird die Modellkopie entladen. Dadurch können Ressourcen freigesetzt werden, die durch aktive Workloads ersetzt werden können, um die Auslastung und Effizienz Ihres Endpunkts zu optimieren.

Wenn Inferenzanforderungen zunehmen oder abnehmen, kann die Anzahl der Kopien Ihrer ICs basierend auf Ihren Richtlinien zur automatischen Skalierung auch vergrößert oder verkleinert werden. SageMaker übernimmt die Platzierung, um die Verpackung Ihrer Modelle hinsichtlich Verfügbarkeit und Kosten zu optimieren.

Wenn Sie außerdem die automatische Skalierung verwalteter Instanzen aktivieren, skaliert SageMaker die Recheninstanzen entsprechend der Anzahl der Inferenzkomponenten, die zu einem bestimmten Zeitpunkt geladen werden müssen, um den Datenverkehr zu bedienen. SageMaker skaliert die Instanzen und packt Ihre Instanzen und Inferenzkomponenten, um die Kosten zu optimieren und gleichzeitig die Modellleistung beizubehalten. Obwohl wir die Verwendung der verwalteten Instanzskalierung empfehlen, haben Sie bei Bedarf auch die Möglichkeit, die Skalierung über die automatische Skalierung der Anwendung selbst zu verwalten.

SageMaker gleicht Inferenzkomponenten neu aus und skaliert die Instanzen herunter, wenn sie von Inferenzkomponenten nicht mehr benötigt werden, und spart so Kosten.

Exemplarische Vorgehensweise für APIs

SageMaker hat eine neue Entität namens eingeführt InferenceComponent. Dadurch werden die Details des Hostings des ML-Modells vom Endpunkt selbst entkoppelt. Der InferenceComponent ermöglicht es Ihnen, Schlüsseleigenschaften für das Hosten des Modells anzugeben, z. B. das SageMaker-Modell, das Sie verwenden möchten, oder die Containerdetails und Modellartefakte. Sie geben außerdem die Anzahl der bereitzustellenden Kopien der Komponenten selbst sowie die Anzahl der erforderlichen Beschleuniger (GPUs, Inf- oder Trn-Beschleuniger) oder CPU (vCPUs) an. Dies bietet Ihnen mehr Flexibilität, einen einzelnen Endpunkt für eine beliebige Anzahl von Modellen zu verwenden, die Sie in Zukunft darauf bereitstellen möchten.

Schauen wir uns die Boto3-API-Aufrufe an, um einen Endpunkt mit einer Inferenzkomponente zu erstellen. Beachten Sie, dass es einige Parameter gibt, auf die wir später in diesem Beitrag eingehen.

Im Folgenden finden Sie Beispielcode für CreateEndpointConfig:

Im Folgenden finden Sie Beispielcode für CreateEndpoint:

Im Folgenden finden Sie Beispielcode für CreateInferenceComponent:

Diese Entkopplung von InferenceComponent zu einem Endpunkt bietet Flexibilität. Sie können mehrere Modelle auf derselben Infrastruktur hosten und sie hinzufügen oder entfernen, wenn sich Ihre Anforderungen ändern. Jedes Modell kann bei Bedarf unabhängig aktualisiert werden. Darüber hinaus können Sie Modelle entsprechend Ihren Geschäftsanforderungen skalieren. InferenceComponent Außerdem können Sie die Kapazität pro Modell steuern. Mit anderen Worten: Sie können bestimmen, wie viele Kopien jedes Modells gehostet werden sollen. Diese vorhersehbare Skalierung hilft Ihnen, die spezifischen Latenzanforderungen für jedes Modell zu erfüllen. Gesamt, InferenceComponent gibt Ihnen viel mehr Kontrolle über Ihre gehosteten Modelle.

In der folgenden Tabelle zeigen wir einen direkten Vergleich des allgemeinen Ansatzes zum Erstellen und Aufrufen eines Endpunkts ohne InferenceComponent und mit InferenceComponent. Beachten Sie, dass CreateModel() jetzt für IC-basierte Endpunkte optional ist.

| Schritt | Modellbasierte Endpunkte | Inferenzkomponentenbasierte Endpunkte |

| 1 | CreateModel(…) | CreateEndpointConfig(…) |

| 2 | CreateEndpointConfig(…) | CreateEndpoint(…) |

| 3 | CreateEndpoint(…) | CreateInferenceComponent(…) |

| 4 | InvokeEndpoint(…) | InvokeEndpoint(InferneceComponentName='value'…) |

Die Einführung InferenceComponent ermöglicht die Skalierung auf Modellebene. Sehen Erfahren Sie mehr über die automatische Skalierung von Instanzen und ICs Weitere Informationen dazu finden Sie hier InferenceComponent Funktioniert mit automatischer Skalierung.

Beim Aufrufen des SageMaker-Endpunkts können Sie jetzt den neuen Parameter angeben InferenceComponentName um das Gewünschte zu treffen InferenceComponentName. SageMaker übernimmt die Weiterleitung der Anfrage an die Instanz, die die Anfrage hostet InferenceComponentName. Siehe folgenden Code:

Standardmäßig verwendet SageMaker eine zufällige Weiterleitung der Anforderungen an die Instanzen, die Ihren Endpunkt unterstützen. Wenn Sie das Routing der am wenigsten ausstehenden Anfragen aktivieren möchten, können Sie die Routing-Strategie in den Endpunktkonfigurationen festlegen RoutingConfig:

Die Weiterleitung der am wenigsten ausstehenden Anfragen erfolgt an die spezifischen Instanzen, die über mehr Kapazität zur Verarbeitung von Anfragen verfügen. Dies sorgt für eine gleichmäßigere Lastverteilung und Ressourcennutzung.

Zusätzlich zu den Modi CreateInferenceComponent, sind die folgenden APIs jetzt verfügbar:

DescribeInferenceComponentDeleteInferenceComponentUpdateInferenceComponentListInferenceComponents

InferenceComponent-Protokolle und -Metriken

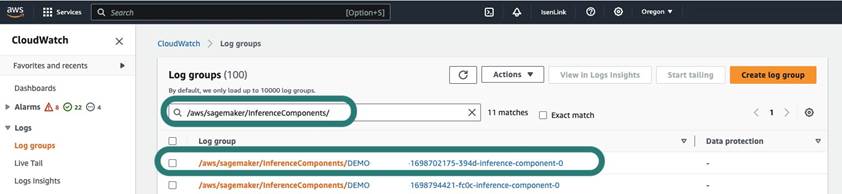

InferenceComponent Protokolle befinden sich in /aws/sagemaker/InferenceComponents/<InferenceComponentName>. Alle an stderr und stdout im Container gesendeten Protokolle werden an diese Protokolle gesendet Amazon CloudWatch.

Mit der Einführung IC-basierter Endpunkte haben Sie nun die Möglichkeit, zusätzliche Instanzmetriken, Inferenzkomponentenmetriken und Aufrufmetriken anzuzeigen.

Für SageMaker-Instanzen können Sie jetzt die verfolgen GPUReservation und CPUReservation Metriken, um die für einen Endpunkt reservierten Ressourcen basierend auf den von Ihnen bereitgestellten Inferenzkomponenten anzuzeigen. Diese Metriken können Ihnen bei der Dimensionierung Ihrer Endpunkt- und Autoscaling-Richtlinien helfen. Sie können auch die aggregierten Metriken anzeigen, die allen auf einem Endpunkt bereitgestellten Modellen zugeordnet sind.

SageMaker stellt auch Metriken auf Inferenzkomponentenebene bereit, die eine detailliertere Ansicht der Ressourcennutzung für die von Ihnen bereitgestellten Inferenzkomponenten zeigen können. Dadurch erhalten Sie einen Überblick über die aggregierte Ressourcenauslastung, z GPUUtilizationNormalized und GPUMemoryUtilizationNormalized für jede von Ihnen bereitgestellte Inferenzkomponente, die keine oder viele Kopien haben kann.

Schließlich stellt SageMaker Aufrufmetriken bereit, die nun Aufrufe für Inferenzkomponenten aggregiert verfolgen (Invocations) oder pro instanziierter Kopie (InvocationsPerCopy)

Eine umfassende Liste der Metriken finden Sie unter SageMaker-Endpunkt-Aufrufmetriken.

Automatische Skalierung auf Modellebene

Um das von uns beschriebene automatische Skalierungsverhalten zu implementieren, definieren Sie beim Erstellen der SageMaker-Endpunktkonfigurations- und Inferenzkomponente die anfängliche Instanzanzahl bzw. die anfängliche Modellkopienanzahl. Nachdem Sie den Endpunkt und die entsprechenden ICs erstellt haben, müssen Sie zum Anwenden der automatischen Skalierung auf IC-Ebene zunächst das Skalierungsziel registrieren und dann die Skalierungsrichtlinie dem IC zuordnen.

Bei der Implementierung der Skalierungsrichtlinie verwenden wir SageMakerInferenceComponentInvocationsPerCopy, eine neue Metrik, die von SageMaker eingeführt wurde. Es erfasst die durchschnittliche Anzahl der Aufrufe pro Modellkopie und Minute.

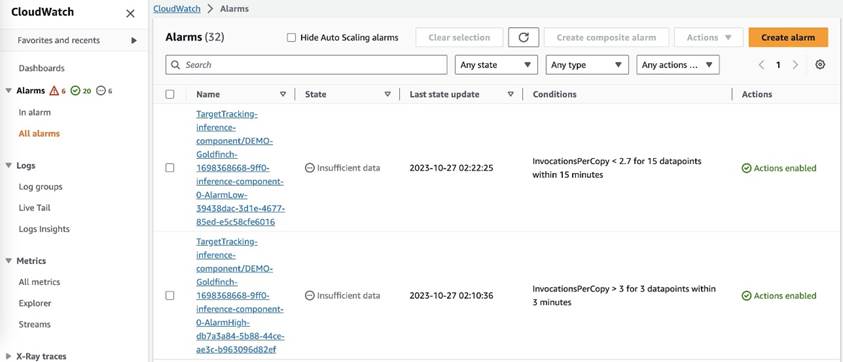

Nachdem Sie die Skalierungsrichtlinie festgelegt haben, erstellt SageMaker zwei CloudWatch-Alarme für jedes Autoscaling-Ziel: einen zum Auslösen der Skalierung bei Alarm für 3 Minuten (drei 1-Minuten-Datenpunkte) und einen zum Auslösen der Skalierung bei Alarm für 15 Minuten (15 1-Minuten-Datenpunkte), wie im folgenden Screenshot gezeigt. Die Zeit zum Auslösen der Skalierungsaktion ist in der Regel 1–2 Minuten länger als diese Minuten, da der Endpunkt einige Zeit benötigt, um Metriken in CloudWatch zu veröffentlichen, und es auch Zeit dafür benötigt AutoScaling reagieren. Die Abkühlzeit ist die Zeitspanne (in Sekunden), die nach Abschluss einer Scale-in- oder Scale-out-Aktivität vergeht, bevor eine andere Scale-out-Aktivität gestartet werden kann. Wenn die Abklingzeit für die Skalierung kürzer ist als die Aktualisierungszeit des Endpunkts, hat sie keine Auswirkungen, da es nicht möglich ist, einen SageMaker-Endpunkt zu aktualisieren, wenn er aktiv ist Aktualisierung Status.

Beachten Sie, dass Sie beim Einrichten der automatischen Skalierung auf IC-Ebene sicherstellen müssen, dass MaxInstanceCount Der Parameter ist gleich oder kleiner als die maximale Anzahl von ICs, die dieser Endpunkt verarbeiten kann. Wenn Ihr Endpunkt beispielsweise nur so konfiguriert ist, dass er in der Endpunktkonfiguration über eine Instanz verfügt und diese Instanz nur maximal vier Kopien des Modells hosten kann, dann MaxInstanceCount sollte gleich oder kleiner als 4 sein. Sie können jedoch auch die verwaltete automatische Skalierungsfunktion von SageMaker verwenden, um die Instanzanzahl basierend auf der erforderlichen Modellkopienanzahl automatisch zu skalieren, um den Bedarf an mehr Rechenressourcen zu decken. Der folgende Codeausschnitt zeigt, wie Sie die Skalierung verwalteter Instanzen während der Erstellung der Endpunktkonfiguration einrichten. Wenn die automatische Skalierung auf IC-Ebene eine höhere Instanzanzahl zum Hosten der Modellkopien erfordert, skaliert SageMaker auf diese Weise automatisch die Instanzanzahl, damit die Skalierung auf IC-Ebene erfolgreich ist.

Sie können mehrere Autoscaling-Richtlinien auf denselben Endpunkt anwenden. Dies bedeutet, dass Sie die traditionelle Autoscaling-Richtlinie auf die mit ICs erstellten Endpunkte anwenden und basierend auf den anderen Endpunktmetriken nach oben und unten skalieren können. Weitere Informationen finden Sie unter Optimieren Sie Ihre Bereitstellungen für maschinelles Lernen mit automatischer Skalierung auf Amazon SageMaker. Obwohl dies möglich ist, empfehlen wir dennoch, die Skalierung verwalteter Instanzen zu verwenden, anstatt die Skalierung selbst zu verwalten.

Zusammenfassung

In diesem Beitrag haben wir eine neue Funktion in der SageMaker-Inferenz vorgestellt, die Ihnen dabei hilft, die Auslastung von Recheninstanzen zu maximieren, auf Hunderte von Modellen zu skalieren und die Kosten zu optimieren und gleichzeitig eine vorhersehbare Leistung zu bieten. Darüber hinaus haben wir eine exemplarische Vorgehensweise für die APIs bereitgestellt und Ihnen gezeigt, wie Sie Inferenzkomponenten für Ihre Workloads konfigurieren und bereitstellen.

Wir unterstützen auch erweiterte Routing-Funktionen um die Latenz und Leistung Ihrer Inferenz-Workloads zu optimieren. SageMaker kann Ihnen dabei helfen, Ihre Inferenz-Workloads im Hinblick auf Kosten und Leistung zu optimieren und Ihnen eine Granularität auf Modellebene für die Verwaltung zu bieten. Wir haben eine erstellt Satz Notizbücher Hier erfahren Sie, wie Sie drei verschiedene Modelle bereitstellen, unterschiedliche Container verwenden und Richtlinien zur automatischen Skalierung in GitHub anwenden. Wir empfehlen Ihnen, mit Notebook 1 zu beginnen und noch heute die neuen Hosting-Funktionen von SageMaker auszuprobieren!

Über die Autoren

James Park ist Lösungsarchitekt bei Amazon Web Services. Er arbeitet mit Amazon.com zusammen, um Technologielösungen auf AWS zu entwerfen, zu erstellen und bereitzustellen, und hat ein besonderes Interesse an KI und maschinellem Lernen. In seiner Freizeit erkundet er gerne neue Kulturen, neue Erfahrungen und bleibt über die neuesten Technologietrends auf dem Laufenden. Sie finden ihn auf LinkedIn.

James Park ist Lösungsarchitekt bei Amazon Web Services. Er arbeitet mit Amazon.com zusammen, um Technologielösungen auf AWS zu entwerfen, zu erstellen und bereitzustellen, und hat ein besonderes Interesse an KI und maschinellem Lernen. In seiner Freizeit erkundet er gerne neue Kulturen, neue Erfahrungen und bleibt über die neuesten Technologietrends auf dem Laufenden. Sie finden ihn auf LinkedIn.

Melanie Li, PhD, ist Senior AI/ML Specialist TAM bei AWS mit Sitz in Sydney, Australien. Sie unterstützt Unternehmenskunden beim Aufbau von Lösungen mit modernsten KI/ML-Tools auf AWS und bietet Anleitungen zur Architektur und Implementierung von ML-Lösungen mit Best Practices. In ihrer Freizeit erkundet sie gerne die Natur und verbringt Zeit mit Familie und Freunden.

Melanie Li, PhD, ist Senior AI/ML Specialist TAM bei AWS mit Sitz in Sydney, Australien. Sie unterstützt Unternehmenskunden beim Aufbau von Lösungen mit modernsten KI/ML-Tools auf AWS und bietet Anleitungen zur Architektur und Implementierung von ML-Lösungen mit Best Practices. In ihrer Freizeit erkundet sie gerne die Natur und verbringt Zeit mit Familie und Freunden.

Markus Karp ist ein ML-Architekt im Amazon SageMaker Service-Team. Er konzentriert sich darauf, Kunden dabei zu helfen, ML-Workloads in großem Umfang zu entwerfen, bereitzustellen und zu verwalten. In seiner Freizeit reist er gerne und entdeckt neue Orte.

Markus Karp ist ein ML-Architekt im Amazon SageMaker Service-Team. Er konzentriert sich darauf, Kunden dabei zu helfen, ML-Workloads in großem Umfang zu entwerfen, bereitzustellen und zu verwalten. In seiner Freizeit reist er gerne und entdeckt neue Orte.

Alan Tan ist Senior Product Manager bei SageMaker und leitet die Bemühungen zur Inferenz großer Modelle. Er setzt sich leidenschaftlich für die Anwendung von maschinellem Lernen im Bereich Analytics ein. Außerhalb der Arbeit genießt er die Natur.

Alan Tan ist Senior Product Manager bei SageMaker und leitet die Bemühungen zur Inferenz großer Modelle. Er setzt sich leidenschaftlich für die Anwendung von maschinellem Lernen im Bereich Analytics ein. Außerhalb der Arbeit genießt er die Natur.

Raghu Ramesha ist Senior ML Solutions Architect im Amazon SageMaker Service-Team. Er konzentriert sich darauf, Kunden bei der Erstellung, Bereitstellung und Migration von ML-Produktions-Workloads in großem Maßstab zu SageMaker zu unterstützen. Er ist auf die Bereiche maschinelles Lernen, KI und Computer Vision spezialisiert und verfügt über einen Master-Abschluss in Informatik von der UT Dallas. In seiner Freizeit reist und fotografiert er gerne.

Raghu Ramesha ist Senior ML Solutions Architect im Amazon SageMaker Service-Team. Er konzentriert sich darauf, Kunden bei der Erstellung, Bereitstellung und Migration von ML-Produktions-Workloads in großem Maßstab zu SageMaker zu unterstützen. Er ist auf die Bereiche maschinelles Lernen, KI und Computer Vision spezialisiert und verfügt über einen Master-Abschluss in Informatik von der UT Dallas. In seiner Freizeit reist und fotografiert er gerne.

Rupinder Grewal ist ein Sr Ai/ML Specialist Solutions Architect bei AWS. Derzeit konzentriert er sich auf die Bereitstellung von Modellen und MLOps auf SageMaker. Vor dieser Funktion hat er als Machine Learning Engineer gearbeitet und Modelle erstellt und gehostet. Außerhalb der Arbeit spielt er gerne Tennis und radelt auf Bergpfaden.

Rupinder Grewal ist ein Sr Ai/ML Specialist Solutions Architect bei AWS. Derzeit konzentriert er sich auf die Bereitstellung von Modellen und MLOps auf SageMaker. Vor dieser Funktion hat er als Machine Learning Engineer gearbeitet und Modelle erstellt und gehostet. Außerhalb der Arbeit spielt er gerne Tennis und radelt auf Bergpfaden.

Dhawal Patel ist Principal Machine Learning Architect bei AWS. Er hat mit Organisationen von großen Unternehmen bis hin zu mittelständischen Startups an Problemen im Zusammenhang mit verteiltem Computing und künstlicher Intelligenz gearbeitet. Er konzentriert sich auf Deep Learning, einschließlich NLP- und Computer Vision-Domänen. Er hilft Kunden, hochleistungsfähige Modellinferenz auf SageMaker zu erreichen.

Dhawal Patel ist Principal Machine Learning Architect bei AWS. Er hat mit Organisationen von großen Unternehmen bis hin zu mittelständischen Startups an Problemen im Zusammenhang mit verteiltem Computing und künstlicher Intelligenz gearbeitet. Er konzentriert sich auf Deep Learning, einschließlich NLP- und Computer Vision-Domänen. Er hilft Kunden, hochleistungsfähige Modellinferenz auf SageMaker zu erreichen.

Saurabh Trikande ist Senior Product Manager für Amazon SageMaker Inference. Er arbeitet leidenschaftlich gerne mit Kunden zusammen und ist motiviert von dem Ziel, maschinelles Lernen zu demokratisieren. Er konzentriert sich auf die Kernherausforderungen im Zusammenhang mit der Bereitstellung komplexer ML-Anwendungen, mandantenfähigen ML-Modellen, Kostenoptimierungen und der leichteren Bereitstellung von Deep-Learning-Modellen. In seiner Freizeit wandert Saurabh gerne, lernt etwas über innovative Technologien, folgt TechCrunch und verbringt Zeit mit seiner Familie.

Saurabh Trikande ist Senior Product Manager für Amazon SageMaker Inference. Er arbeitet leidenschaftlich gerne mit Kunden zusammen und ist motiviert von dem Ziel, maschinelles Lernen zu demokratisieren. Er konzentriert sich auf die Kernherausforderungen im Zusammenhang mit der Bereitstellung komplexer ML-Anwendungen, mandantenfähigen ML-Modellen, Kostenoptimierungen und der leichteren Bereitstellung von Deep-Learning-Modellen. In seiner Freizeit wandert Saurabh gerne, lernt etwas über innovative Technologien, folgt TechCrunch und verbringt Zeit mit seiner Familie.

Lakshmi Ramakrishnan ist Principal Engineer beim Plattformteam von Amazon SageMaker Machine Learning (ML) in AWS und bietet die technische Führung für das Produkt. Er hat über 9 Jahre in verschiedenen technischen Funktionen bei Amazon gearbeitet. Er hat einen Bachelor of Engineering in Informationstechnologie vom National Institute of Technology in Karnataka, Indien, und einen Master of Science in Informatik von der University of Minnesota Twin Cities.

Lakshmi Ramakrishnan ist Principal Engineer beim Plattformteam von Amazon SageMaker Machine Learning (ML) in AWS und bietet die technische Führung für das Produkt. Er hat über 9 Jahre in verschiedenen technischen Funktionen bei Amazon gearbeitet. Er hat einen Bachelor of Engineering in Informationstechnologie vom National Institute of Technology in Karnataka, Indien, und einen Master of Science in Informatik von der University of Minnesota Twin Cities.

David Nienda ist Senior Software Development Engineer im Amazon SageMaker-Team und arbeitet derzeit an der Verbesserung von Arbeitsabläufen für maschinelles Lernen in der Produktion sowie an der Einführung neuer Inferenzfunktionen. In seiner Freizeit versucht er, mit seinen Kindern Schritt zu halten.

David Nienda ist Senior Software Development Engineer im Amazon SageMaker-Team und arbeitet derzeit an der Verbesserung von Arbeitsabläufen für maschinelles Lernen in der Produktion sowie an der Einführung neuer Inferenzfunktionen. In seiner Freizeit versucht er, mit seinen Kindern Schritt zu halten.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/reduce-model-deployment-costs-by-50-on-average-using-sagemakers-latest-features/

- :hast

- :Ist

- :nicht

- :Wo

- $UP

- 1

- 10

- 100

- 114

- 12

- 13

- 15%

- 150

- 16

- 22

- 360

- 362

- 500

- 7

- 9

- a

- Fähigkeit

- Fähig

- Über Uns

- Abstracts

- Beschleuniger

- zugänglich

- Nach

- Erreichen

- Action

- aktiv

- Aktivität

- hinzufügen

- Hinzufügen

- Zusatz

- Zusätzliche

- zusätzlich

- Adresse

- advanced

- Nach der

- gegen

- Aggregat

- AI

- AI / ML

- Alan

- Alarm

- Alle

- erlauben

- erlaubt

- bereits

- ebenfalls

- Obwohl

- immer

- Amazon

- Amazon Sage Maker

- Amazon Web Services

- Amazon.com

- amerikanisch

- Betrag

- an

- Analytik

- und

- Ein anderer

- jedem

- Bienen

- APIs

- Anwendung

- Anwendungen

- Bewerbung

- Anwendung

- Ansatz

- SIND

- Bereich

- künstlich

- künstliche Intelligenz

- AS

- Partnerschaftsräte

- damit verbundenen

- At

- Australien

- Auto

- Im Prinzip so, wie Sie es von Google Maps kennen.

- Verfügbarkeit

- verfügbar

- durchschnittlich

- vermeiden

- AWS

- Unterstützung

- basierend

- BE

- weil

- Bevor

- Verhalten

- Vorteile

- BESTE

- Best Practices

- Besser

- zwischen

- bauen

- Building

- erbaut

- Geschäft

- aber

- by

- namens

- Aufrufe

- CAN

- Fähigkeiten

- capability

- fähig

- Kapazität

- Captures

- sicher

- Herausforderungen

- herausfordernd

- Übernehmen

- Auswählen

- Orte

- Code

- COM

- Vergleich

- abschließen

- Wird abgeschlossen

- Komplex

- Komponente

- Komponenten

- umfassend

- Berechnen

- Computer

- Computerwissenschaften

- Computer Vision

- Computing

- Konfiguration

- konfiguriert

- konsistent

- ständig

- verbrauchenden

- Container

- Behälter

- Smartgeräte App

- Kernbereich

- Dazugehörigen

- Kosten

- Einsparmaßnahmen

- Kosten

- könnte

- erstellen

- erstellt

- schafft

- Erstellen

- Schaffung

- Zur Zeit

- Kunden

- Zoll

- Dallas

- technische Daten

- Datenpunkte

- Datum

- verringern

- gewidmet

- tief

- tiefe Lernen

- tiefer

- Standard

- definieren

- Grad

- vertiefen

- Demokratisierung

- zeigt

- Abhängig

- einsetzen

- Einsatz

- Bereitstellen

- Einsatz

- Implementierungen

- beschrieben

- Design

- erwünscht

- Detail

- Details

- Bestimmen

- Entwicklung

- anders

- schwer

- verteilt

- Verteiltes rechnen

- do

- Domains

- Nicht

- nach unten

- im

- dynamisch

- jeder

- leicht

- bewirken

- Effizienz

- effizient

- Bemühungen

- ermöglichen

- freigegeben

- ermöglicht

- ermutigen

- Endpunkt

- Ingenieur

- Entwicklung

- gewährleisten

- Unternehmen

- Unternehmen

- Einheit

- gleich

- Europäische

- Beispiel

- erwarten

- ERFAHRUNGEN

- Erfahrungen

- ERKUNDEN

- Möglichkeiten sondieren

- erweitern

- Familie

- Merkmal

- Eigenschaften

- Feld

- Finden Sie

- Vorname

- Flexibilität

- konzentriert

- Folgende

- Aussichten für

- Foundation

- vier

- Frei

- Freunde

- für

- voll

- Außerdem

- Zukunft

- bekommen

- gif

- GitHub

- ABSICHT

- gegeben

- gibt

- Kundenziele

- GPU

- GPUs

- körnig

- die Vermittlung von Kompetenzen,

- Hälfte

- Griff

- Hände

- Hardware

- Haben

- he

- Hilfe

- Unternehmen

- hilft

- hier (auf dänisch)

- GUTE

- High-Level

- ihm

- seine

- Hit

- hält

- Gastgeber

- gehostet

- Hosting

- STUNDEN

- Ultraschall

- Hilfe

- aber

- http

- HTTPS

- hunderte

- Idee

- Leerlauf

- if

- veranschaulichen

- Image

- implementieren

- Umsetzung

- wichtig

- Verbesserung

- in

- In anderen

- Einschließlich

- Erhöhung

- unabhängig

- Indien

- ineffizient

- Information

- Informatik

- Infrastruktur

- Anfangs-

- innovativ

- innovative Technologien

- Instanz

- beantragen müssen

- Institut

- Intelligenz

- interaktive

- Interesse

- in

- eingeführt

- Einleitung

- IT

- SEINE

- selbst

- jpg

- Behalten

- Aufbewahrung

- Wesentliche

- Kinder

- grosse

- Große Unternehmen

- zuletzt

- Latency

- später

- neueste

- Start

- Leadership

- führenden

- lernen

- am wenigsten

- Niveau

- Gefällt mir

- Liste

- Lama

- Belastung

- aus einer regionalen

- located

- länger

- aussehen

- suchen

- liebt

- Maschine

- Maschinelles Lernen

- um

- Making

- verwalten

- verwaltet

- Management

- Manager

- flächendeckende Gesundheitsprogramme

- viele

- Master

- Meister

- Maximieren

- maximal

- Kann..

- Mittel

- Triff

- Memory

- Metrisch

- Metrik

- migriert

- Minimum

- Minute

- Minuten

- ML

- MLOps

- Modell

- für

- mehr

- motiviert

- Mountain

- viel

- mehrere

- National

- Natur

- Need

- erforderlich

- Bedürfnisse

- Neu

- Nlp

- nicht

- beachten

- Notizbuch

- jetzt an

- Anzahl

- Objekt

- of

- bieten

- vorgenommen,

- on

- EINEM

- einzige

- auf zu

- Optimieren

- Optimierung

- Option

- or

- Orchesterbearbeitung

- Organisationen

- Andere

- UNSERE

- im Freien

- Ausgänge

- aussen

- hervorragend

- übrig

- Gesamt-

- besitzen

- Pack

- Parallel

- Parameter

- Parameter

- besondere

- leidenschaftlich

- Schnittmuster

- Muster

- für

- Leistung

- Zeit

- phd

- Fotografie

- Ort

- Platzierung

- Länder/Regionen

- Plan

- Plattform

- Plato

- Datenintelligenz von Plato

- PlatoData

- spielend

- Punkte

- Politik durchzulesen

- Datenschutzrichtlinien

- möglich

- Post

- Werkzeuge

- Praktiken

- vorhersagen

- Vorhersagbar

- Erhaltung

- Principal

- Vor

- Probleme

- Prozessdefinierung

- Produkt

- Produkt-Manager

- Produktion

- immobilien

- die

- vorausgesetzt

- bietet

- Bereitstellung

- veröffentlichen

- Menge

- zufällig

- Angebot

- Bereich

- Reagieren

- Reagiert

- bereit

- Neuverteilung

- empfehlen

- Veteran

- Reduzierung

- siehe

- Registrieren

- bezogene

- entfernen

- Entfernen

- ersetzt

- Anforderung

- Zugriffe

- erfordern

- falls angefordert

- Voraussetzungen:

- erfordert

- reserviert

- Ressourcen

- Downloads

- beziehungsweise

- Antwort

- Rollen

- Rollen

- Routen

- Routing

- Führen Sie

- Laufen

- Laufzeit

- sagemaker

- SageMaker-Inferenz

- gleich

- Speichern

- Ersparnisse

- Skalieren

- Waage

- Skalierung

- Wissenschaft

- Sekunden

- sehen

- auf der Suche nach

- Senior

- geschickt

- Satz

- brauchen

- Lösungen

- Dienst

- kompensieren

- Einstellung

- mehrere

- Teilen

- sie

- sollte

- erklären

- zeigte

- gezeigt

- bedeutend

- Einfacher

- vereinfachte

- Single

- sitzen

- Größe

- kleinere

- Schnipsel

- So

- Software

- Software-Entwicklung

- Lösungen

- einige

- Spezialist

- spezialisiert

- spezifisch

- Spezifikation

- verbringen

- Ausgabe

- Spitze

- Spikes

- Anfang

- Startups

- State-of-the-art

- Status

- bleiben

- Immer noch

- Strategie

- erfolgreich

- so

- Zuführung

- Support

- Unterstützt

- sicher

- Sydney

- Tabelle

- Nehmen

- nimmt

- Target

- Team

- TechCrunch

- Technische

- Technologies

- Technologie

- Tennis

- Terminologie

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Die Gegend

- Die Zukunft

- ihr

- Sie

- dann

- Dort.

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- diejenigen

- nach drei

- Durch

- Zeit

- zu

- Werkzeuge

- verfolgen sind

- traditionell

- der Verkehr

- Reise

- Trends

- auslösen

- Zwilling

- XNUMX

- verstehen

- Universität

- unberechenbar

- Aktualisierung

- aktualisiert

- Anwendungsbereich

- -

- benutzt

- Mitglied

- Benutzererfahrung

- Nutzer

- verwendet

- Verwendung von

- gewöhnlich

- UTC

- Nutzen

- Schraubstock

- Anzeigen

- Seh-

- Besucher

- Spaziergang

- Walkthrough

- wollen

- Abfall / Verschnitt

- Weg..

- Wege

- we

- Netz

- Web-Services

- GUT

- wann

- während

- welche

- während

- werden wir

- mit

- ohne

- Worte

- Arbeiten

- gearbeitet

- Workflows

- arbeiten,

- Werk

- Jahr

- Du

- Ihr

- sich selbst

- Zephyrnet

- Null