Zusammenfassung ist die Technik, umfangreiche Informationen in einer kompakten und aussagekräftigen Form zusammenzufassen und gilt als Eckpfeiler effizienter Kommunikation in unserem informationsreichen Zeitalter. In einer Welt voller Daten spart die Zusammenfassung langer Texte in kurzen Zusammenfassungen Zeit und hilft, fundierte Entscheidungen zu treffen. Durch die Zusammenfassung werden Inhalte komprimiert, was Zeit spart und die Klarheit verbessert, indem Informationen prägnant und kohärent dargestellt werden. Zusammenfassungen sind für die Entscheidungsfindung und die Verwaltung großer Inhaltsmengen von unschätzbarem Wert.

Zusammenfassungsmethoden haben ein breites Anwendungsspektrum für verschiedene Zwecke, wie zum Beispiel:

- Nachrichtenaggregation - Nachrichtenaggregation Dabei werden Nachrichtenartikel in einem Newsletter für die Medienbranche zusammengefasst

- Zusammenfassung von Rechtsdokumenten - Zusammenfassung von Rechtsdokumenten hilft Juristen dabei, wichtige rechtliche Informationen aus umfangreichen Dokumenten wie Geschäftsbedingungen und Verträgen zu extrahieren

- Wissenschaftliche Forschung – Durch die Zusammenfassung werden wichtige Informationen aus wissenschaftlichen Arbeiten kommentiert, indiziert, komprimiert und vereinfacht

- Kuratierung von Inhalten für Blogs und Websites – Sie können ansprechende und originelle Inhaltszusammenfassungen für Leser erstellen, insbesondere im Marketing

- Finanzberichte und Marktanalysen – Sie können extrahieren Finanzielle Einblicke aus Berichten und erstellen Sie Zusammenfassungen für Investorenpräsentationen in der Finanzbranche

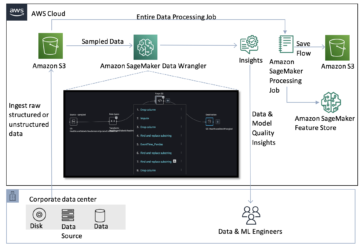

Mit den Fortschritten in der Verarbeitung natürlicher Sprache (NLP), Sprachmodellen und generativer KI ist das Zusammenfassen von Texten unterschiedlicher Länge leichter zugänglich geworden. Werkzeuge wie LangChain, kombiniert mit einem großen Sprachmodell (LLM), unterstützt von Amazonas Grundgestein or Amazon SageMaker-JumpStart, vereinfachen Sie den Implementierungsprozess.

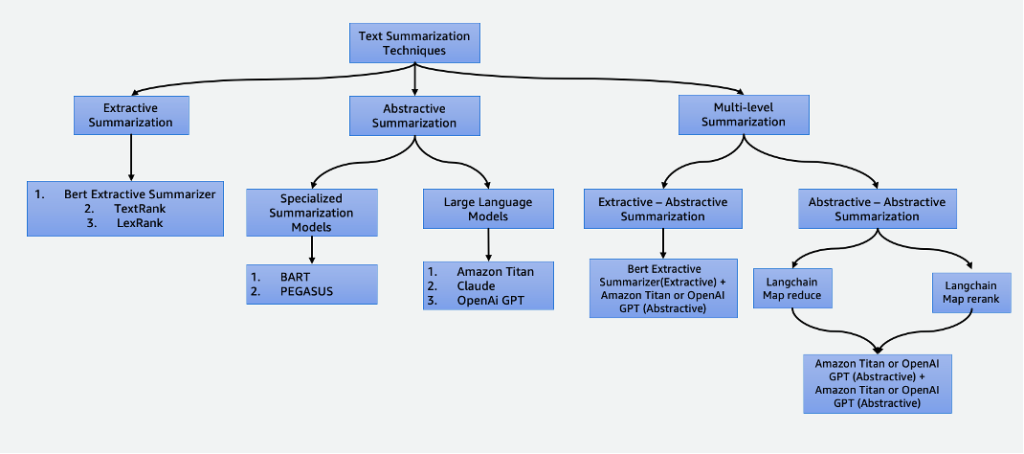

Dieser Beitrag befasst sich mit den folgenden Zusammenfassungstechniken:

- Extraktive Zusammenfassung mit dem extraktiven Zusammenfassungsprogramm BERT

- Abstrakte Zusammenfassung mithilfe spezieller Zusammenfassungsmodelle und LLMs

- Zwei mehrstufige Zusammenfassungstechniken:

- Extraktiv-abstraktive Zusammenfassung mithilfe der extraktiv-abstraktiven Inhaltszusammenfassungsstrategie (EACSS)

- Abstraktiv-abstraktive Zusammenfassung mittels Map Reduce und Map ReRank

Das vollständige Codebeispiel finden Sie im GitHub Repo. Sie können Starten Sie diese Lösung in Amazon SageMaker-Studio.

Klicken Sie hier, um die AWS-Konsole zu öffnen und folgen Sie uns.

Arten von Zusammenfassungen

Es gibt verschiedene Techniken zum Zusammenfassen von Text, die grob in zwei Hauptansätze eingeteilt werden können: extraktiv und abstrakt Zusammenfassung. Darüber hinaus umfassen mehrstufige Zusammenfassungsmethoden eine Reihe von Schritten, die sowohl extraktive als auch abstrakte Techniken kombinieren. Diese mehrstufigen Ansätze sind beim Umgang mit Texten mit Token, die länger als die Grenze eines LLM sind, von Vorteil und ermöglichen das Verständnis komplexer Erzählungen.

Extraktive Zusammenfassung

Die extraktive Zusammenfassung ist eine Technik, die in der NLP- und Textanalyse verwendet wird, um eine Zusammenfassung durch Extrahieren von Schlüsselsätzen zu erstellen. Anstatt wie bei der abstrakten Zusammenfassung neue Sätze oder Inhalte zu generieren, beruht die extraktive Zusammenfassung auf der Identifizierung und Herausnahme der relevantesten und informativsten Teile des Originaltextes, um eine komprimierte Version zu erstellen.

Die extraktive Zusammenfassung ist zwar vorteilhaft, da sie den ursprünglichen Inhalt bewahrt und eine hohe Lesbarkeit gewährleistet, indem wichtige Sätze direkt aus dem Quelltext entnommen werden, sie weist jedoch Einschränkungen auf. Es mangelt an Kreativität, ist nicht in der Lage, neue Sätze zu formulieren und übersieht möglicherweise nuancierte Details, wodurch möglicherweise wichtige Informationen fehlen. Darüber hinaus kann es zu langen Zusammenfassungen kommen, die den Leser manchmal mit übermäßigen und unerwünschten Informationen überfordern. Es gibt viele extraktive Zusammenfassungstechniken, wie z TextRank und LexRank. In diesem Beitrag konzentrieren wir uns auf den BERT Extractive Summierer.

BERT-Extraktivzusammenfassung

Das BERT-Extraktivzusammenfassung ist eine Art extraktives Zusammenfassungsmodell, das das BERT-Sprachmodell verwendet, um die wichtigsten Sätze aus einem Text zu extrahieren. BERT ist ein vorab trainiertes Sprachmodell, das für eine Vielzahl von Aufgaben, einschließlich Textzusammenfassung, fein abgestimmt werden kann. Es funktioniert, indem die Sätze zunächst mithilfe von BERT in den Text eingebettet werden. Dadurch wird für jeden Satz eine Vektordarstellung erstellt, die seine Bedeutung und seinen Kontext erfasst. Das Modell verwendet dann einen Clustering-Algorithmus, um die Sätze in Cluster zu gruppieren. Für die Zusammenfassung werden die Sätze ausgewählt, die der Mitte jedes Clusters am nächsten liegen.

Im Vergleich zu LLMs besteht der Vorteil des extraktiven Zusammenfassungsprogramms BERT darin, dass es relativ einfach ist, das Modell zu trainieren und bereitzustellen, und dass es besser erklärbar ist. Der Nachteil ist, dass die Zusammenfassung nicht kreativ ist und keine Sätze generiert. Es werden nur Sätze aus dem Originaltext ausgewählt. Dies schränkt die Fähigkeit ein, komplexe oder nuancierte Texte zusammenzufassen.

Abstrakte Zusammenfassung

Die abstrakte Zusammenfassung ist eine Technik, die in der NLP- und Textanalyse verwendet wird, um eine Zusammenfassung zu erstellen, die über die bloße Extraktion von Sätzen oder Phrasen aus dem Quelltext hinausgeht. Anstatt vorhandene Inhalte auszuwählen und neu zu organisieren, werden durch die abstrakte Zusammenfassung neue Sätze oder Phrasen generiert, die die Kernbedeutung und die Hauptgedanken des Originaltextes in einer komprimierteren und kohärenteren Form erfassen. Dieser Ansatz erfordert, dass das Modell den Inhalt des Textes versteht und ihn auf eine Weise ausdrückt, die im Quellmaterial nicht unbedingt vorhanden ist.

Spezialisierte Zusammenfassungsmodelle

Diese vorab trainierten Modelle natürlicher Sprache, wie z BART und PEGASUSsind speziell auf Textzusammenfassungsaufgaben zugeschnitten. Sie verwenden Encoder-Decoder-Architekturen und haben im Vergleich zu ihren Gegenstücken kleinere Parameter. Diese reduzierte Größe ermöglicht eine einfache Feinabstimmung und Bereitstellung auf kleineren Instanzen. Es ist jedoch wichtig zu beachten, dass diese Zusammenfassungsmodelle auch mit kleineren Eingabe- und Ausgabetokengrößen ausgestattet sind. Im Gegensatz zu ihren allgemeineren Gegenstücken sind diese Modelle ausschließlich für Zusammenfassungsaufgaben konzipiert. Daher besteht der für diese Modelle erforderliche Input lediglich aus dem Text, der zusammengefasst werden muss.

Große Sprachmodelle

A großes Sprachmodell bezieht sich auf jedes Modell, das anhand umfangreicher und vielfältiger Datensätze trainiert wird, typischerweise durch selbstüberwachtes Lernen in großem Maßstab, und das an eine Vielzahl spezifischer nachgelagerter Aufgaben angepasst werden kann. Diese Modelle haben eine größere Parametergröße und eine bessere Leistung bei Aufgaben. Bemerkenswert ist, dass sie wesentlich größere Eingabe-Token-Größen aufweisen, einige sogar bis 100,000, wie zum Beispiel Anthropic Claude. Um eines dieser Modelle zu nutzen, bietet AWS den vollständig verwalteten Service Amazon Bedrock an. Wenn Sie mehr Kontrolle über den Modellentwicklungslebenszyklus benötigen, können Sie LLMs über SageMaker bereitstellen.

Aufgrund ihrer Vielseitigkeit erfordern diese Modelle spezifische Aufgabenanweisungen, die durch Eingabetext bereitgestellt werden schnelles Engineering. Dieser kreative Prozess führt je nach Modelltyp und Eingabetext zu unterschiedlichen Ergebnissen. Die Wirksamkeit sowohl der Modellleistung als auch der Qualität der Eingabeaufforderung hat erheblichen Einfluss auf die endgültige Qualität der Modellausgaben. Im Folgenden finden Sie einige Tipps für technische Aufforderungen zur Zusammenfassung:

- Fügen Sie den zusammenzufassenden Text ein – Geben Sie den Text ein, der zusammengefasst werden soll. Dies dient als Ausgangsmaterial für die Zusammenfassung.

- Definieren Sie die Aufgabe – Machen Sie deutlich, dass das Ziel die Textzusammenfassung ist. Beispiel: „Fassen Sie den folgenden Text zusammen: [Eingabetext].“

- Kontext bereitstellen – Bieten Sie eine kurze Einführung oder einen Kontext für den gegebenen Text, der zusammengefasst werden muss. Dies hilft dem Modell, den Inhalt und Kontext zu verstehen. Zum Beispiel: „Sie erhalten den folgenden Artikel über künstliche Intelligenz und ihre Rolle im Gesundheitswesen: [Eingabetext].“

- Fordern Sie die Zusammenfassung an – Fordern Sie das Modell auf, eine Zusammenfassung des bereitgestellten Textes zu erstellen. Machen Sie sich klar über die gewünschte Länge oder das gewünschte Format der Zusammenfassung. Zum Beispiel: „Bitte erstellen Sie eine kurze Zusammenfassung des angegebenen Artikels über Künstliche Intelligenz und ihre Rolle im Gesundheitswesen: [Eingabetext].“

- Legen Sie Einschränkungen oder Längenrichtlinien fest – Optional können Sie die Länge der Zusammenfassung steuern, indem Sie eine gewünschte Wortanzahl, Satzanzahl oder Zeichenbegrenzung angeben. Beispiel: „Bitte erstellen Sie eine Zusammenfassung, die nicht länger als 50 Wörter ist: [Eingabetext].“

Effektives Prompt Engineering ist von entscheidender Bedeutung, um sicherzustellen, dass die generierten Zusammenfassungen korrekt und relevant sind und auf die beabsichtigte Zusammenfassungsaufgabe abgestimmt sind. Verfeinern Sie die Eingabeaufforderung für optimale Zusammenfassungsergebnisse mit Experimenten und Iterationen. Nachdem Sie die Wirksamkeit der Eingabeaufforderungen festgestellt haben, können Sie sie mithilfe von wiederverwenden Eingabeaufforderungsvorlagen.

Mehrstufige Zusammenfassung

Für kürzere Texte sind extraktive und abstrakte Zusammenfassungen sinnvoll. Wenn der Eingabetext jedoch das maximale Token-Limit des Modells überschreitet, ist eine mehrstufige Zusammenfassung erforderlich. Bei der mehrstufigen Zusammenfassung handelt es sich um eine Kombination verschiedener Zusammenfassungstechniken, beispielsweise extraktiver und abstrakter Methoden, um längere Texte effektiv zu verdichten, indem mehrere Ebenen von Zusammenfassungsprozessen angewendet werden. In diesem Abschnitt diskutieren wir zwei mehrstufige Zusammenfassungstechniken: die extraktiv-abstraktive Zusammenfassung und die abstraktiv-abstraktive Zusammenfassung.

Extraktiv-abstraktive Zusammenfassung

Bei der extraktiv-abstraktiven Zusammenfassung wird zunächst eine extraktive Zusammenfassung des Textes erstellt. Anschließend wird ein abstraktes Zusammenfassungssystem verwendet, um die extraktive Zusammenfassung zu verfeinern und sie prägnanter und informativer zu machen. Dies erhöht die Genauigkeit, da informativere Zusammenfassungen im Vergleich zu alleinigen extraktiven Methoden bereitgestellt werden.

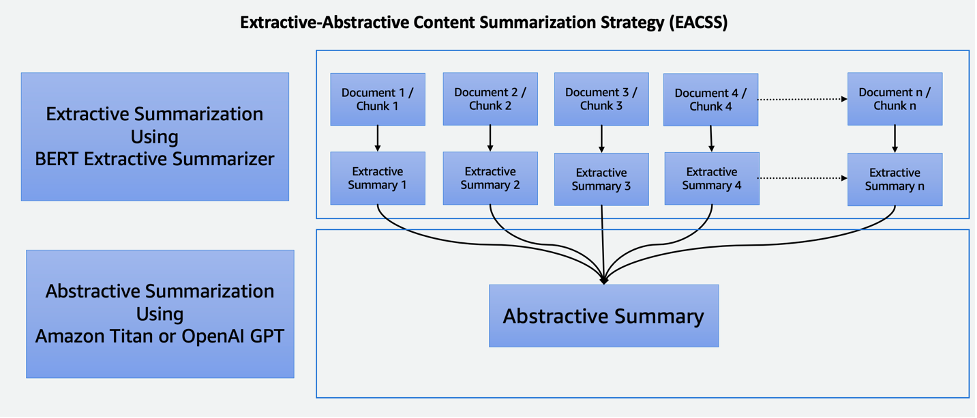

Strategie zur extraktiv-abstrakten Inhaltszusammenfassung

Die EACSS-Technik kombiniert die Stärken zweier leistungsstarker Techniken: des extraktiven BERT-Zusammenfassungsprogramms für die extraktive Phase und der LLMs für die abstrahierende Phase, wie im folgenden Diagramm dargestellt.

EACSS bietet mehrere Vorteile, darunter die Erhaltung wichtiger Informationen, verbesserte Lesbarkeit und Anpassungsfähigkeit. Allerdings ist die Implementierung von EACSS rechenintensiv und komplex. Es besteht das Risiko eines potenziellen Informationsverlusts, und die Qualität der Zusammenfassung hängt stark von der Leistung der zugrunde liegenden Modelle ab. Daher ist eine sorgfältige Modellauswahl und -optimierung für die Erzielung optimaler Ergebnisse unerlässlich. Die Implementierung umfasst die folgenden Schritte:

- Der erste Schritt besteht darin, das große Dokument, beispielsweise ein Buch, in kleinere Abschnitte zu unterteilen Stücke. Diese Abschnitte werden je nach gewünschter Granularität der Zusammenfassung als Sätze, Absätze oder sogar Kapitel definiert.

- Für die extraktive Phase verwenden wir den BERT Extractive Summierer. Diese Komponente funktioniert, indem sie die Sätze in jeden Block einbettet und dann einen Clustering-Algorithmus verwendet, um Sätze zu identifizieren, die den Schwerpunkten des Clusters am nächsten liegen. Dieser Extraktionsschritt trägt dazu bei, die wichtigsten und relevantesten Inhalte aus jedem Block zu bewahren.

- Nachdem wir für jeden Block extraktive Zusammenfassungen erstellt haben, fahren wir mit der Phase der abstrakten Zusammenfassung fort. Hier nutzen wir LLMs, die für ihre Fähigkeit bekannt sind, kohärente und kontextrelevante Zusammenfassungen zu erstellen. Diese Modelle verwenden die extrahierten Zusammenfassungen als Eingabe und erstellen abstrakte Zusammenfassungen, die das Wesentliche des Originaldokuments erfassen und gleichzeitig Lesbarkeit und Kohärenz gewährleisten.

Durch die Kombination extraktiver und abstrakter Zusammenfassungstechniken bietet dieser Ansatz eine effiziente und umfassende Möglichkeit, umfangreiche Dokumente wie Bücher zusammenzufassen. Es stellt sicher, dass wichtige Informationen extrahiert werden und ermöglicht gleichzeitig die Erstellung prägnanter und für Menschen lesbarer Zusammenfassungen, was es zu einem wertvollen Werkzeug für verschiedene Anwendungen im Bereich der Dokumentenzusammenfassung macht.

Abstraktiv-abstraktive Zusammenfassung

Bei der abstrakt-abstraktiven Zusammenfassung handelt es sich um einen Ansatz, bei dem abstrakte Methoden sowohl zum Extrahieren als auch zum Generieren von Zusammenfassungen verwendet werden. Es bietet bemerkenswerte Vorteile, darunter verbesserte Lesbarkeit, Kohärenz und die Flexibilität, Länge und Details der Zusammenfassung anzupassen. Es zeichnet sich durch die Sprachgenerierung aus, die Paraphrasierung ermöglicht und Redundanz vermeidet. Es gibt jedoch Nachteile. Es ist beispielsweise rechenintensiv und ressourcenintensiv, und seine Qualität hängt stark von der Effektivität der zugrunde liegenden Modelle ab, die sich, wenn sie nicht gut trainiert oder vielseitig sind, auf die Qualität der generierten Zusammenfassungen auswirken können. Die Auswahl der Modelle ist entscheidend, um diese Herausforderungen zu bewältigen und qualitativ hochwertige abstrakte Zusammenfassungen sicherzustellen. Für die abstrakt-abstraktive Zusammenfassung diskutieren wir zwei Strategien: Map Reduce und Map ReRank.

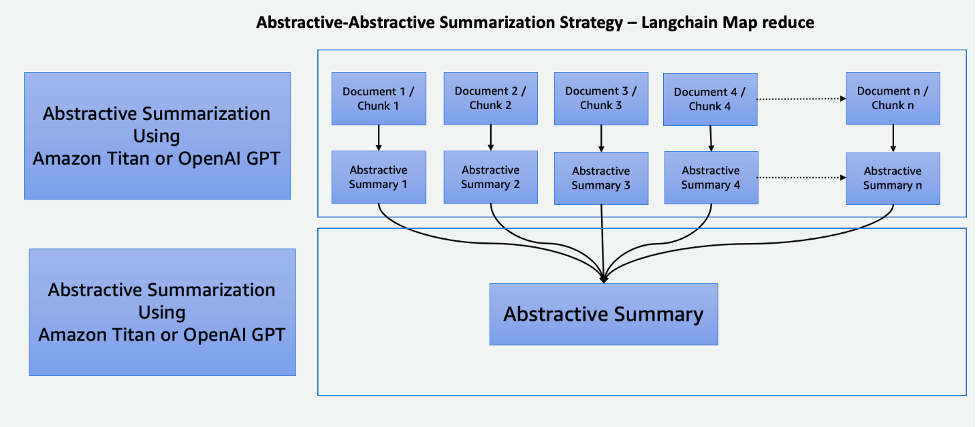

Kartenreduzierung mit LangChain

Dieser zweistufige Prozess umfasst a Map-Schritt und ein Reduce-Schritt, wie im folgenden Diagramm dargestellt. Mit dieser Technik können Sie eine Eingabe zusammenfassen, die länger ist als das Eingabe-Token-Limit des Modells.

Der Prozess besteht aus drei Hauptschritten:

- Die Korpora werden in kleinere Teile aufgeteilt, die in das Token-Limit des LLM passen.

- Wir verwenden einen Map-Schritt, um individuell eine LLM-Kette anzuwenden, die alle wichtigen Informationen aus jeder Passage extrahiert und deren Ausgabe als neue Passage verwendet. Abhängig von der Größe und Struktur der Korpora kann dies in Form von übergreifenden Themen oder kurzen Zusammenfassungen erfolgen.

- Der Reduce-Schritt kombiniert die Ausgabepassagen aus dem Map-Schritt oder einem Reduce-Schritt so, dass sie zum Token-Limit passen, und speist es in das LLM ein. Dieser Vorgang wird wiederholt, bis die endgültige Ausgabe eine einzelne Passage ist.

Der Vorteil dieser Technik besteht darin, dass sie hoch skalierbar und parallelisierbar ist. Die gesamte Verarbeitung in jedem Schritt ist unabhängig voneinander, wodurch die Vorteile verteilter Systeme oder serverloser Dienste und einer geringeren Rechenzeit genutzt werden.

Ordnen Sie ReRank mithilfe von LangChain zu

Diese Kette führt für jedes Dokument eine erste Eingabeaufforderung durch, die nicht nur versucht, eine Aufgabe zu erledigen, sondern auch eine Bewertung dafür gibt, wie sicher die Antwort ist. Die Antwort mit der höchsten Punktzahl wird zurückgegeben.

Diese Technik ist Map Reduce sehr ähnlich, hat jedoch den Vorteil, dass insgesamt weniger Aufrufe erforderlich sind, was den Zusammenfassungsprozess rationalisiert. Die Einschränkung liegt jedoch in der Unfähigkeit, Informationen über mehrere Dokumente hinweg zusammenzuführen. Diese Einschränkung macht es am effektivsten in Szenarien, in denen eine einzelne, unkomplizierte Antwort von einem einzelnen Dokument erwartet wird, wodurch es für komplexere oder vielschichtigere Informationsabrufaufgaben, die mehrere Quellen umfassen, weniger geeignet ist. Um die Eignung dieser Methode für bestimmte Zusammenfassungsanforderungen zu bestimmen, ist eine sorgfältige Betrachtung des Kontexts und der Art der Daten unerlässlich.

Cohere ReRank verwendet ein semantikbasiertes Reranking-System, das die Bedeutung der Suchanfrage eines Benutzers über die Keyword-Relevanz hinaus kontextualisiert. Es wird sowohl mit Vektorspeichersystemen als auch mit schlüsselwortbasierten Suchmaschinen verwendet, was ihm Flexibilität verleiht.

Vergleich von Zusammenfassungstechniken

Jede Zusammenfassungstechnik hat ihre eigenen einzigartigen Vor- und Nachteile:

- Bei der extraktiven Zusammenfassung bleibt der ursprüngliche Inhalt erhalten und gewährleistet eine gute Lesbarkeit, es mangelt jedoch an Kreativität und kann zu langen Zusammenfassungen führen.

- Abstrakte Zusammenfassung bietet zwar Kreativität und generiert prägnante, flüssige Zusammenfassungen, birgt jedoch das Risiko unbeabsichtigter Inhaltsänderungen, Herausforderungen bei der Sprachgenauigkeit und ressourcenintensiver Entwicklung.

- Die extraktiv-abstraktive mehrstufige Zusammenfassung fasst große Dokumente effektiv zusammen und bietet eine größere Flexibilität bei der Feinabstimmung des extraktiven Teils der Modelle. Allerdings ist es teuer, zeitaufwändig und es mangelt an Parallelisierung, was die Parameteroptimierung zu einer Herausforderung macht.

- Die abstrakt-abstrakte mehrstufige Zusammenfassung fasst auch große Dokumente effektiv zusammen und zeichnet sich durch verbesserte Lesbarkeit und Kohärenz aus. Es ist jedoch rechenintensiv und ressourcenintensiv und hängt stark von der Wirksamkeit der zugrunde liegenden Modelle ab.

Eine sorgfältige Modellauswahl ist bei diesem Ansatz von entscheidender Bedeutung, um Herausforderungen zu mindern und qualitativ hochwertige abstrakte Zusammenfassungen sicherzustellen. Die folgende Tabelle fasst die Funktionen für jeden Zusammenfassungstyp zusammen.

| Aspekt | Extraktive Zusammenfassung | Abstraktive Zusammenfassung | Mehrstufige Zusammenfassung |

| Erstellen Sie kreative und ansprechende Zusammenfassungen | Nein | Ja | Ja |

| Behalten Sie den Originalinhalt bei | Ja | Nein | Nein |

| Bringen Sie Informationsbewahrung und Kreativität in Einklang | Nein | Ja | Ja |

| Geeignet für kurze, objektive Texte (Eingabetextlänge kleiner als maximale Token des Modells) | Ja | Ja | Nein |

| Effektiv für längere, komplexe Dokumente wie Bücher (Eingabetextlänge größer als maximale Token des Modells) | Nein | Nein | Ja |

| Kombiniert Extraktion und Inhaltsgenerierung | Nein | Nein | Ja |

Mehrstufige Zusammenfassungstechniken eignen sich für lange und komplexe Dokumente, bei denen die Länge des Eingabetexts das Token-Limit des Modells überschreitet. Die folgende Tabelle vergleicht diese Techniken.

| Technik | Vorteile | Nachteile |

| EACSS (extraktiv-abstraktiv) | Behält wichtige Informationen bei und ermöglicht die Feinabstimmung des extraktiven Teils der Modelle. | Rechenintensiv, potenzieller Informationsverlust und fehlende Parallelisierung. |

| Kartenreduzierung (abstraktiv-abstraktiv) | Skalierbar und parallelisierbar, mit weniger Rechenzeit. Die beste Technik, um kreative und prägnante Zusammenfassungen zu erstellen. | Speicherintensiver Prozess. |

| Map ReRank (abstraktiv-abstraktiv) | Optimierte Zusammenfassung mit semantischem Ranking. | Begrenzte Informationszusammenführung. |

Tipps zum Zusammenfassen von Texten

Berücksichtigen Sie beim Zusammenfassen von Text die folgenden Best Practices:

- Beachten Sie die Gesamttokengröße – Seien Sie darauf vorbereitet, den Text aufzuteilen, wenn er die Token-Grenzwerte des Modells überschreitet, oder verwenden Sie bei der Verwendung von LLMs mehrere Zusammenfassungsebenen.

- Beachten Sie die Art und Anzahl der Datenquellen – Die Kombination von Informationen aus mehreren Quellen erfordert möglicherweise Transformationen, klare Organisation und Integrationsstrategien. LangChain-Zeug verfügt über eine Integration in eine Vielzahl von Datenquellen und Dokumenttypen. Durch den Einsatz dieser Technik wird der Prozess der Kombination von Texten aus verschiedenen Dokumenten und Datenquellen vereinfacht.

- Beachten Sie die Modellspezialisierung – Einige Modelle können bei bestimmten Arten von Inhalten herausragen, haben aber bei anderen Schwierigkeiten. Möglicherweise gibt es fein abgestimmte Modelle, die besser für Ihren Textbereich geeignet sind.

- Verwenden Sie für große Textmengen eine mehrstufige Zusammenfassung – Für Texte, die die Token-Grenzwerte überschreiten, sollten Sie einen mehrstufigen Zusammenfassungsansatz in Betracht ziehen. Beginnen Sie mit einer allgemeinen Zusammenfassung, um die Hauptideen festzuhalten, und fassen Sie dann schrittweise Unterabschnitte oder Kapitel zusammen, um detailliertere Einblicke zu erhalten.

- Fassen Sie den Text nach Themen zusammen – Dieser Ansatz hilft, einen logischen Fluss aufrechtzuerhalten und Informationsverluste zu reduzieren, und priorisiert die Aufbewahrung wichtiger Informationen. Wenn Sie LLMs verwenden, erstellen Sie klare und spezifische Eingabeaufforderungen, die das Modell anleiten, ein bestimmtes Thema anstelle des gesamten Textkörpers zusammenzufassen.

Zusammenfassung

Die Zusammenfassung ist in unserem informationsreichen Zeitalter ein wichtiges Werkzeug, das die effiziente Destillation umfangreicher Informationen in prägnante und aussagekräftige Formen ermöglicht. Es spielt in verschiedenen Bereichen eine zentrale Rolle und bietet zahlreiche Vorteile. Die Zusammenfassung spart Zeit, indem sie wichtige Inhalte aus umfangreichen Dokumenten schnell übermittelt, unterstützt die Entscheidungsfindung durch die Extraktion wichtiger Informationen und verbessert das Verständnis in der Bildung und bei der Kuratierung von Inhalten.

Dieser Beitrag bietet einen umfassenden Überblick über verschiedene Zusammenfassungstechniken, einschließlich extraktiver, abstrakter und mehrstufiger Ansätze. Mit Tools wie LangChain und Sprachmodellen können Sie die Leistungsfähigkeit der Zusammenfassung nutzen, um die Kommunikation zu optimieren, die Entscheidungsfindung zu verbessern und das volle Potenzial umfangreicher Informationsbestände auszuschöpfen. Die Vergleichstabelle in diesem Beitrag kann Ihnen dabei helfen, die am besten geeigneten Zusammenfassungstechniken für Ihre Projekte zu ermitteln. Darüber hinaus dienen die im Beitrag geteilten Tipps als wertvolle Richtlinien, um Wiederholungsfehler beim Experimentieren mit LLMs zur Textzusammenfassung zu vermeiden. Diese praktischen Ratschläge befähigen Sie, das gewonnene Wissen anzuwenden und so eine erfolgreiche und effiziente Zusammenfassung in den Projekten sicherzustellen.

Bibliographie

Über die Autoren

Nick Biso ist Machine Learning Engineer bei AWS Professional Services. Er löst komplexe organisatorische und technische Herausforderungen mithilfe von Data Science und Engineering. Darüber hinaus erstellt und implementiert er KI/ML-Modelle in der AWS Cloud. Seine Leidenschaft erstreckt sich auch auf seine Vorliebe für Reisen und vielfältige kulturelle Erlebnisse.

Nick Biso ist Machine Learning Engineer bei AWS Professional Services. Er löst komplexe organisatorische und technische Herausforderungen mithilfe von Data Science und Engineering. Darüber hinaus erstellt und implementiert er KI/ML-Modelle in der AWS Cloud. Seine Leidenschaft erstreckt sich auch auf seine Vorliebe für Reisen und vielfältige kulturelle Erlebnisse.

Suhas Chowdary Jonnalagadda ist Datenwissenschaftler bei AWS Global Services. Es ist ihm eine Leidenschaft, Unternehmenskunden dabei zu helfen, ihre komplexesten Probleme mit der Leistungsfähigkeit von KI/ML zu lösen. Er hat Kunden bei der Transformation ihrer Geschäftslösungen in verschiedenen Branchen unterstützt, darunter Finanzen, Gesundheitswesen, Bankwesen, E-Commerce, Medien, Werbung und Marketing.

Suhas Chowdary Jonnalagadda ist Datenwissenschaftler bei AWS Global Services. Es ist ihm eine Leidenschaft, Unternehmenskunden dabei zu helfen, ihre komplexesten Probleme mit der Leistungsfähigkeit von KI/ML zu lösen. Er hat Kunden bei der Transformation ihrer Geschäftslösungen in verschiedenen Branchen unterstützt, darunter Finanzen, Gesundheitswesen, Bankwesen, E-Commerce, Medien, Werbung und Marketing.

Tabby Ward ist ein leitender Cloud-Architekt/Strategischer technischer Berater mit umfangreicher Erfahrung in der Migration von Kunden und der Modernisierung ihrer Anwendungs-Workloads und Services zu AWS. Mit über 25 Jahren Erfahrung in der Entwicklung und Architektur von Software ist sie für ihre tiefgreifenden Fähigkeiten bekannt und dafür, dass sie sich mit Geschick das Vertrauen von Kunden und Partnern beim Entwurf von Architekturen und Lösungen für mehrere Tech-Stacks und Cloud-Anbieter erarbeitet.

Tabby Ward ist ein leitender Cloud-Architekt/Strategischer technischer Berater mit umfangreicher Erfahrung in der Migration von Kunden und der Modernisierung ihrer Anwendungs-Workloads und Services zu AWS. Mit über 25 Jahren Erfahrung in der Entwicklung und Architektur von Software ist sie für ihre tiefgreifenden Fähigkeiten bekannt und dafür, dass sie sich mit Geschick das Vertrauen von Kunden und Partnern beim Entwurf von Architekturen und Lösungen für mehrere Tech-Stacks und Cloud-Anbieter erarbeitet.

Shyam Desai ist Cloud Engineer für Big Data und maschinelle Lerndienste bei AWS. Er unterstützt Big-Data-Anwendungen und -Kunden auf Unternehmensebene mit einer Kombination aus Software-Engineering-Expertise und Datenwissenschaft. Er verfügt über umfassende Kenntnisse in Computer Vision und Bildgebungsanwendungen für künstliche Intelligenz sowie in biomedizinischen und bioinformatischen Anwendungen.

Shyam Desai ist Cloud Engineer für Big Data und maschinelle Lerndienste bei AWS. Er unterstützt Big-Data-Anwendungen und -Kunden auf Unternehmensebene mit einer Kombination aus Software-Engineering-Expertise und Datenwissenschaft. Er verfügt über umfassende Kenntnisse in Computer Vision und Bildgebungsanwendungen für künstliche Intelligenz sowie in biomedizinischen und bioinformatischen Anwendungen.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/techniques-for-automatic-summarization-of-documents-using-language-models/

- :hast

- :Ist

- :nicht

- :Wo

- 1

- 100

- 11

- 20

- 25

- 50

- 7

- 8

- 9

- a

- Fähigkeit

- LiveBuzz

- akademisch

- zugänglich

- Genauigkeit

- genau

- Erreichen

- über

- Zusatz

- zusätzlich

- Fortschritte

- Vorteil

- vorteilhaft

- Vorteilen

- Marketings

- Beratung

- Berater

- Nach der

- Alter

- Anhäufung

- AI

- AI / ML

- AIDS

- Algorithmus

- ausgerichtet

- Alle

- Zulassen

- erlaubt

- allein

- entlang

- ebenfalls

- Obwohl

- Amazon

- Amazon Web Services

- an

- Analyse

- und

- beantworten

- Anthropisch

- jedem

- Anwendung

- Anwendungen

- Bewerben

- Anwendung

- Ansatz

- Ansätze

- SIND

- Feld

- Artikel

- Artikel

- künstlich

- künstliche Intelligenz

- AS

- At

- automatische

- vermeiden

- Vermeidung von

- bewusst

- AWS

- Professionelle AWS-Services

- Bankinggg

- basierend

- BE

- werden

- wird

- Sein

- BESTE

- Best Practices

- Besser

- Beyond

- Big

- Big Data

- biomedizinische

- Blogs

- Körper

- Körper

- buchen

- Bücher

- beide

- Break

- breit

- allgemein

- baut

- Geschäft

- aber

- Taste im nun erscheinenden Bestätigungsfenster nun wieder los.

- by

- Aufrufe

- CAN

- Fähigkeiten

- fähig

- Erfassung

- Captures

- vorsichtig

- Center

- sicher

- Kette

- Herausforderungen

- herausfordernd

- Kapitel

- Charakter

- Clarity

- klar

- klicken Sie auf

- Cloud

- Cluster

- Clustering

- Code

- KOHÄRENT

- Kombination

- kombiniert

- vereint

- Vereinigung

- wie die

- kommt

- Kommunikation

- kompakt

- verglichen

- Vergleich

- abschließen

- Komplex

- Komponente

- umfassend

- inbegriffen

- Berechnen

- Computer

- Computer Vision

- prägnant

- Bedingungen

- Geht davon

- Berücksichtigung

- besteht

- Konsul (Console)

- Einschränkungen

- verbrauchenden

- Inhalt

- Inhalt curation

- Kontext

- Smartgeräte App

- Kernbereich

- Eckstein

- könnte

- Kollegen

- Handwerk

- erstellen

- Kreativ (Creative)

- Kreativität

- kritischem

- wichtig

- Kultur-

- curation

- Kunden

- technische Daten

- Datenwissenschaft

- Datenwissenschaftler

- Datensätze

- Behandlung

- Decision Making

- Entscheidungen

- definiert

- Abhängig

- hängt

- einsetzen

- Einsatz

- setzt ein

- Design

- entworfen

- erwünscht

- Detail

- detailliert

- Details

- Bestimmen

- Entwicklung

- Entwicklung

- anders

- Direkt

- Nachteil

- diskutieren

- verteilt

- verteilte Systeme

- verschieden

- Dokument

- Unterlagen

- Tut nicht

- Domain

- Domains

- nach unten

- Nachteile

- jeder

- Gesamt-Einnahmen abzüglich Provision

- erleichtern

- E-EINKAUF

- Bildungswesen

- Effektiv

- effektiv

- Wirksamkeit

- effizient

- Einbettung

- anstellen

- befähigt

- ermöglicht

- ermöglichen

- Eingriff

- Ingenieur

- Entwicklung

- Motor (en)

- verbesserte

- Verbessert

- gewährleisten

- sorgt

- Gewährleistung

- Unternehmen

- Unternehmensebene

- Era

- Fehler

- insbesondere

- Essenz

- essential

- etablierten

- Sogar

- Beispiel

- überschreiten

- übersteigt

- Excel

- übermäßig

- ausschließlich

- Exekutive

- vorhandenen

- erwartet

- teuer

- ERFAHRUNGEN

- Erfahrungen

- Experimente

- Expertise

- express

- erweitert

- umfangreiche

- Langjährige Erfahrung

- Extrakt

- Extraktion

- KONZENTRAT

- Merkmal

- Weniger

- Finale

- Finanzen

- Vorname

- passen

- Flexibilität

- Fluss

- Setzen Sie mit Achtsamkeit

- folgen

- Folgende

- Aussichten für

- unten stehende Formular

- Format

- Formen

- gefunden

- für

- voller

- voll

- Außerdem

- gewonnen

- allgemeiner Zweck

- erzeugen

- erzeugt

- erzeugt

- Erzeugung

- Generation

- generativ

- Generative KI

- gegeben

- gibt

- Unterstützung

- Global

- Goes

- gehen

- mehr

- Gruppe an

- Guide

- Richtlinien

- Geschirr

- Haben

- he

- Gesundheitswesen

- schwer

- Hilfe

- dazu beigetragen,

- Unternehmen

- hilft

- hier (auf dänisch)

- hier

- GUTE

- High-Level

- hochwertige

- höchste

- hoch

- seine

- Ultraschall

- aber

- HTML

- HTTPS

- für Menschen lesbar

- Ideen

- identifizieren

- Identifizierung

- if

- Imaging

- Impact der HXNUMXO Observatorien

- Implementierung

- Umsetzung

- wichtig

- zu unterstützen,

- Verbesserung

- in

- Unfähigkeit

- Dazu gehören

- Einschließlich

- integrieren

- unabhängig

- Indizes

- Individuell

- Branchen

- beeinflussen

- Information

- informativ

- informiert

- Anfangs-

- Varianten des Eingangssignals:

- Einblicke

- beantragen müssen

- Anleitung

- Integration

- Intelligenz

- beabsichtigt

- in

- Einleitung

- unschätzbar

- Investor

- beteiligen

- IT

- Iterationen

- SEINE

- jpg

- Wesentliche

- Wissen

- bekannt

- Sprache

- grosse

- größer

- Lagen

- lernen

- Rechtlich

- Länge

- weniger

- Cholesterinspiegel

- liegt

- Lebenszyklus

- Gefällt mir

- LIMIT

- Einschränkung

- Einschränkungen

- Grenzen

- LLM

- logisch

- Lang

- länger

- Verlust

- senken

- Maschine

- Maschinelles Lernen

- Main

- halten

- um

- MACHT

- Making

- verwaltet

- flächendeckende Gesundheitsprogramme

- viele

- Karte

- Markt

- Marketing

- Ihres Materials

- maximal

- Kann..

- Bedeutung

- sinnvoll

- Medien

- bloß

- Merge

- Verschmelzung

- Methode

- Methodologien

- Methoden

- Migration

- Kommt demnächst...

- Mildern

- Modell

- für

- Modernisierung

- mehr

- Zudem zeigt

- vor allem warme

- schlauer bewegen

- facettenreich

- mehrere

- Erzählungen

- Natürliche

- Verarbeitung natürlicher Sprache

- Natur

- Notwendig

- notwendig,

- Need

- Bedürfnisse

- Neu

- News

- Newsletter

- Nlp

- nicht

- bemerkenswert

- vor allem

- beachten

- Roman

- Anzahl

- und viele

- Ziel

- of

- bieten

- bieten

- Angebote

- on

- EINEM

- einzige

- XNUMXh geöffnet

- optimal

- or

- Organisation

- organisatorisch

- Original

- Andere

- Anders

- UNSERE

- Ergebnisse

- Möglichkeiten für das Ausgangssignal:

- Ausgänge

- übrig

- Gesamt-

- übergreifend

- Überblick

- überwältigend

- besitzen

- Parameter

- Parameter

- Teil

- besondere

- Durchgang

- Leidenschaft & KREATIVITÄT

- leidenschaftlich

- Ausführen

- Leistung

- Phase

- Sätze

- zentrale

- Plato

- Datenintelligenz von Plato

- PlatoData

- spielt

- Post

- Potenzial

- möglicherweise

- Werkzeuge

- angetriebene

- größte treibende

- Praktisch

- Praxis

- Praktiken

- bereit

- Gegenwart

- Presentations

- Erhaltung

- Erhaltung

- Principal

- priorisiert

- Probleme

- Prozessdefinierung

- anpassen

- Verarbeitung

- produziert

- produziert

- Professionell

- Profis

- zunehmend

- Projekte

- Eingabeaufforderungen

- vorausgesetzt

- Anbieter

- bietet

- Bereitstellung

- Ziehen

- Zwecke

- Qualität

- Angebot

- Rangliste

- Leser

- anerkannt

- Veteran

- Reduziert

- bezeichnet

- bezieht sich

- verfeinern

- verhältnismäßig

- Relevanz

- relevant

- sich auf

- Neuorganisation

- wiederholt

- repetitiv

- Meldungen

- Darstellung

- erfordern

- falls angefordert

- erfordert

- Ressourcen

- ressourcenintensiv

- Antwort

- Einschränkung

- Folge

- Die Ergebnisse

- Beibehaltung

- Wiederverwendung

- Risiko

- Rollen

- läuft

- sagemaker

- Einsparung

- skalierbaren

- Skalieren

- Szenarien

- Wissenschaft

- Wissenschaftler

- Ergebnis

- Wertung

- Suche

- Suchmaschinen

- Abschnitt

- Abschnitte

- ausgewählt

- Auswahl

- Auswahl

- Satz

- Modellreihe

- brauchen

- Serverlos

- dient

- Lösungen

- Dienst

- mehrere

- von Locals geführtes

- sie

- Short

- bedeutend

- ähnlich

- Vereinfacht

- vereinfachen

- Single

- Singular

- beträchtlich

- Größe

- Größen

- kleinere

- Software

- Softwareentwicklung

- allein

- Lösungen

- LÖSEN

- Löst

- einige

- manchmal

- Quelle

- Quellen

- spezialisiert

- spezifisch

- speziell

- gespalten

- Stacks

- steht

- Anfang

- Bundesstaat

- Schritt

- Shritte

- speichern

- einfach

- Strategien

- Strategie

- rationalisieren

- Rationalisierung

- Stärken

- Struktur

- Kämpfen

- im Wesentlichen

- erfolgreich

- so

- Anzug

- geeignet

- zusammenfassen

- ZUSAMMENFASSUNG

- Unterstützt

- schnell

- System

- Systeme und Techniken

- Tabelle

- zugeschnitten

- Nehmen

- nimmt

- Aufgabe

- und Aufgaben

- Tech

- Technische

- Technik

- Techniken

- AGB

- Text

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Die Projekte

- Die Quelle

- ihr

- Sie

- Themen

- dann

- Dort.

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- nach drei

- Durch

- Zeit

- Tipps

- zu

- Zeichen

- Tokens

- Werkzeug

- Werkzeuge

- Thema

- Themen

- Gesamt

- Training

- Ausbildung

- Transformationen

- Transformieren

- reisen

- Vertrauen

- Abstimmung

- XNUMX

- tippe

- Typen

- typisch

- nicht fähig

- erfährt

- zugrunde liegen,

- verstehen

- Verständnis

- einzigartiges

- nicht wie

- öffnen

- bis

- unerwünscht

- -

- benutzt

- verwendet

- Verwendung von

- Nutzen

- wertvoll

- Vielfalt

- verschiedene

- Variieren

- riesig

- vielseitig

- Version

- sehr

- Seh-

- lebenswichtig

- Volumen

- Weg..

- we

- Netz

- Web-Services

- GUT

- wann

- welche

- während

- ganze

- breit

- Wikipedia

- mit

- .

- Word

- Worte

- Werk

- weltweit wie ausgehandelt und gekauft ausgeführt wird.

- Jahr

- Erträge

- Du

- Ihr

- Zephyrnet