Viele digitale Künstler, Architekten, Ingenieure und Spieleentwickler verlassen sich heute auf 3D-Modelle. Die Erstellung dieser digitalen Objekte ist jedoch oft ein zeitaufwändiger und komplizierter Prozess. Neue Modelle der künstlichen Intelligenz (KI) könnten eine Lösung bieten.

KI-generierte Kunst hat in letzter Zeit viel Bekanntheit erlangt, allerdings hauptsächlich in Form von 2D-Bildern. Jetzt haben mehrere Unternehmen eine Software für maschinelles Lernen angekündigt, die noch einen Schritt weiter gehen und Referenztexte oder -bilder in 3D-Designs umwandeln kann.

Generative KI heute

Im September 2022 Google stellte ein Text-zu-3D-Modell vor namens DreamFusion. Dieser Algorithmus baut auf einem früheren Algorithmus namens Dream Fields auf, der 2021 veröffentlicht wurde und in dem Forscher mit einer Bibliothek von 3D-Modellen mit Textbeschriftungen trainierten. DreamFusion benötigt jedoch keine vorhandenen 3D-Modelle, um Ihre Anforderungen zu verstehen, was es viel praktischer macht.

Zwei Monate später veröffentlichte der Grafikkartenriese Nvidia ein ähnliches Modell. Ihre Software mit dem Namen Magic3D ist von außen fast identisch. Sie geben eine Beschreibung des gewünschten 3D-Modells ein, und der Algorithmus rendert eines. Nvidias Lösung behauptet jedoch, doppelt so schnell zu sein.

Die dritte große generative 3D-KI, die Sie heute finden werden, stammt von OpenAI, den Machern von ChatGPT und Dall-E. Dieses Modell, Point-E, erstellt auch 3D-Renderings aus dem Text, kann dies jedoch in so wenig wie möglich tun ein bis zwei Minuten auf einer einzelnen GPU.

„Point-E erstellt 3D-Renderings aus einem Text in nur ein bis zwei Minuten auf einer einzigen GPU.“

Wie generative 3D-Modelle funktionieren

Während alle drei großen KI-Lösungen zur Generierung von 3D-Modellen heute einzigartige Vorteile und spezifische Ansätze haben, folgen sie demselben allgemeinen Prozess. Hier ist ein genauerer Blick darauf, wie diese Algorithmen funktionieren.

Training der KI auf Referenzen

Frühe Ansätze für diese Art von KI, wie Dream Fields, trainierten sie an 3D-Modellen und ihren Textetiketten. Dadurch bleiben ihnen jedoch nicht viele Trainingsdaten, was ihren Umfang einschränkt. Aus diesem Grund lernen neuere Modelle stattdessen, 3D-Modelle aus beschrifteten 2D-Bildern zu generieren.

Die heutige KI zur Generierung von 3D-Modellen beginnt mit Text-zu-Bild-Algorithmen. Folglich füttert man ihn in der ersten Stufe des Trainings mit beschrifteten 2D-Bildern, wie einem Bild eines Hundes mit dem begleitenden Text „Hund“. Diese Daten sind viel besser zugänglich, da nur ImageNet gehostet wird mehr als 14 Millionen beschriftete Bilder, daher ist es eine bessere Möglichkeit, die KI zu trainieren.

Schon nach kurzer Zeit sollten Sie über ein Modell verfügen, das 2D-Bilder ziemlich genau mit Textbeschreibungen verknüpfen kann. Sie können dann damit fortfahren, ihm beizubringen, diese in 3D-Renderings umzuwandeln.

„3D-Modelle generierende KI beginnt mit Text-zu-Bild-Algorithmen.“

Interpolation

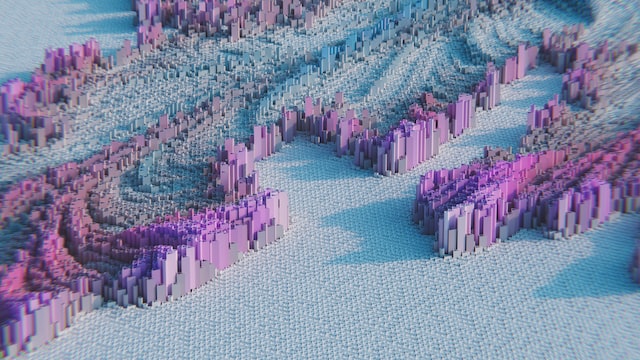

Der nächste Schritt bei der Generierung von 3D-Modellen mit KI ist eine Interpolation. Dabei werden mehrere 2D-Bilder desselben Motivs aus verschiedenen Blickwinkeln kombiniert, um eine 3D-Version zu erstellen.

Die zugrunde liegende Technologie, die diesen Prozess ermöglicht, ist ein neurales Strahlungsfeld (NeRF). NeRFs sind neuronale Netzwerke, die mehrere Ansichten eines Objekts betrachten und bestimmen, wo sich jeder Betrachtungswinkel im Raum befindet. Sie können sie dann zusammensetzen und die Bereiche glätten, in denen sich verschiedene Ansichten überschneiden, um ein zusammenhängendes 3D-Modell zu erstellen.

Traditionell arbeiten NeRFs mit Fotos eines Objekts aus mehreren Blickwinkeln. In einem Text-zu-3D-Modell erzeugen sie jedoch ihre eigenen 2D-Bilder aus verschiedenen Blickwinkeln, bevor sie sie kombinieren. Wie Sie vielleicht erwarten, ist dies ein bemerkenswert komplexer Prozess, aber die jüngsten Fortschritte haben ihn viel schneller gemacht.

Optimierung von 3D-Modellen

Das Produkt, das Sie aus einem Durchgang durch eines dieser NeRFs erhalten, hat wahrscheinlich eine niedrige Auflösung und kann Fehler enthalten. Folglich ist es wichtig, alle 3D-Modelle, die nach dem Interpolationsprozess herauskommen, zu bereinigen und zu optimieren.

Einige KI-Lösungen von heute, wie Googles DreamFusion, führen das Rendering durch mehrere Interpolationsprozesse, um Rauschen zu entfernen und die Auflösung zu verbessern. Nvidias Magic3D verwendet ein zweites Diffusionsmodell das Rauschen reduziert und es entsprechend dem ursprünglichen 2D verfeinert, um seine Auflösung zu erhöhen.

Auch nach dieser Optimierung müssen Sie die Modelle möglicherweise bereinigen. Aus diesem Grund stellen diese Lösungen sie als anpassbare Datei dar, die Sie bearbeiten können, um ihre Auflösung, Form, Farbe, Beleuchtung und andere Faktoren zu ändern.

Einschränkungen und Möglichkeiten

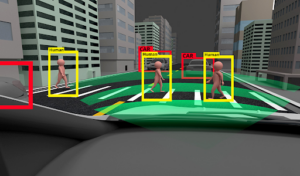

So wie Heimautomatisierungssysteme die Sicherheit bequemer und zugänglicher machen, kann die Automatisierung der 3D-Bilderzeugung viele Arbeitsabläufe rationalisieren. Künstler könnten Spiele entwickeln bzw Erstellen Sie digitale Szenen viel schneller wenn es um Filme geht, da sie nicht so viel Zeit für die Modellerstellung aufwenden würden. Bauzeitpläne könnten sich auch verkürzen, da Architekten 3D-Blaupausen in kürzerer Zeit erstellen.

Diese Algorithmen bergen jedoch immer noch einige Bedenken. KI-generierte Kunst als Ganzes ist unter Beschuss geraten, weil die Arbeiten einiger Künstler ohne ihre Erlaubnis in Trainingsdatensätzen erschienen sind, was die Tür zu urheberrechtlichen und ethischen Komplikationen öffnet. Andere befürchten, dass diese Tools die Beschäftigung und Bezahlung menschlicher Künstler bedrohen könnten.

Mit dem Wachstum der KI-Kunst müssen die Unternehmen, die sie bauen und verwenden, diese Komplikationen berücksichtigen. Mit einem durchdachten, menschenzentrierten Ansatz könnten diese Modelle jedoch revolutionäre Werkzeuge sein, um Künstlern bei der Arbeit zu helfen, anstatt sie zu ersetzen.

„Die Automatisierung der 3D-Bilderzeugung kann viele Arbeitsabläufe rationalisieren.“

Künstliche Intelligenz könnte das 3D-Rendering revolutionieren

Die KI wechselte in relativ kurzer Zeit von der Generierung von 2D-Bildern zum Rendern von 3D-Modellen. Dieser Schritt nach vorne öffnet die Tür zu einer beeindruckenden Bandbreite an Möglichkeiten, solange Data Scientists und Endbenutzer vorsichtig mit der Technologie umgehen.

Während sich die KI-3D-Modellgenerierung noch in einem frühen Stadium befindet, könnte sie digitale Kunst und Design revolutionieren. Branchen von der Architektur bis zum Filmemachen könnten dadurch effizienter werden.

Lesen Sie auch Werden Maschinen künstlerischer als Menschen?

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- AIIOT-Technologie

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Zephyrnet