In einer zunehmend datenzentrierten Welt müssen sich Unternehmen darauf konzentrieren, sowohl wertvolle physische Informationen zu sammeln als auch die Informationen zu generieren, die sie benötigen, aber nicht einfach erfassen können. Datenzugriff, Regulierung und Compliance sind eine zunehmende Reibungsquelle für Innovationen in den Bereichen Analytik und künstliche Intelligenz (KI).

Für stark regulierte Sektoren wie Finanzdienstleistungen, Gesundheitswesen, Biowissenschaften, Automobil, Robotik und Fertigung ist das Problem sogar noch größer. Es verursacht Hindernisse für Systemdesign, Datenaustausch (intern und extern), Monetarisierung, Analytik und maschinelles Lernen (ML).

Synthetische Daten sind ein Werkzeug, das viele Datenherausforderungen angeht, insbesondere KI- und Analyseprobleme wie Datenschutz, Einhaltung gesetzlicher Vorschriften, Zugänglichkeit, Datenknappheit und Voreingenommenheit. Dazu gehören auch Datenaustausch und Time-to-Data (und damit Time-to-Market).

Synthetische Daten werden algorithmisch generiert. Es spiegelt statistische Eigenschaften und Muster aus den Quelldaten wider. Aber wichtig ist, dass es keine sensiblen, privaten oder persönlichen Datenpunkte enthält.

Sie stellen Fragen zu den synthetischen Daten und erhalten die gleichen Antworten wie bei den echten Daten.

In unserer früheren Post, Wir haben gezeigt, wie kontradiktorische Netzwerke wie Generative Adversarial Networks (GANS) verwendet werden, um tabellarische Datensätze zu generieren, um das Training von Kreditbetrugsmodellen zu verbessern.

Damit Geschäftsbeteiligte synthetische Daten für ihre ML- und Analyseprojekte verwenden, ist es unerlässlich, nicht nur sicherzustellen, dass die generierten synthetischen Daten dem Zweck und den erwarteten nachgelagerten Anwendungen entsprechen, sondern auch, dass sie in der Lage sind, die Qualität von zu messen und nachzuweisen die generierten Daten.

Angesichts zunehmender rechtlicher und ethischer Verpflichtungen zur Wahrung der Privatsphäre ist eine der Stärken synthetischer Daten die Fähigkeit, sensible und ursprüngliche Informationen während ihrer Synthese zu entfernen. Daher benötigen wir neben der Qualität auch Metriken, um das Risiko eines eventuellen Durchsickerns privater Informationen zu bewerten und zu beurteilen, ob der Generierungsprozess nicht aus dem „Speichern“ oder Kopieren von Originaldaten besteht.

Um all dies zu erreichen, können wir die Qualität synthetischer Daten in Dimensionen abbilden, die den Nutzern, Stakeholdern und uns helfen, die generierten Daten besser zu verstehen.

Die drei Dimensionen der Bewertung der Qualität synthetischer Daten

Die generierten synthetischen Daten werden an drei Schlüsseldimensionen gemessen:

- Fidelity

- Dienstprogramm

- Datenschutz

Dies sind einige der Fragen zu allen generierten synthetischen Daten, die von einem Bericht über die Qualität synthetischer Daten beantwortet werden sollten:

- Wie ähnlich sind diese synthetischen Daten im Vergleich zum ursprünglichen Trainingssatz?

- Wie nützlich sind diese synthetischen Daten für unsere nachgelagerten Anwendungen?

- Sind Informationen aus den ursprünglichen Trainingsdaten in die synthetischen Daten eingedrungen?

- Wurden Daten, die in der realen Welt als sensibel gelten (aus anderen Datensätzen, die nicht zum Trainieren des Modells verwendet werden), versehentlich von unserem Modell synthetisiert?

Die Metriken, die jede dieser Dimensionen für die Endbenutzer übersetzen, sind etwas flexibel. Denn die zu generierenden Daten können sich in Verteilung, Größe und Verhalten unterscheiden. Sie sollten auch einfach zu verstehen und zu interpretieren sein.

Letztendlich müssen die Metriken vollständig datengesteuert sein und keine Vorkenntnisse oder domänenspezifischen Informationen erfordern. Wenn der Benutzer jedoch spezifische Regeln und Beschränkungen anwenden möchte, die auf eine bestimmte Geschäftsdomäne anwendbar sind, dann sollte er in der Lage sein, diese während des Syntheseprozesses zu definieren, um sicherzustellen, dass die domänenspezifische Treue eingehalten wird.

Wir betrachten jede dieser Metriken in den folgenden Abschnitten genauer.

Metriken zum Verständnis der Wiedergabetreue

In jedem Data-Science-Projekt müssen wir verstehen, ob eine bestimmte Stichprobenpopulation für das zu lösende Problem relevant ist. Ebenso müssen wir für den Prozess der Bewertung der Relevanz der generierten synthetischen Daten diese im Hinblick auf bewerten Treue im Vergleich zum Original.

Visuelle Darstellungen dieser Metriken erleichtern das Verständnis. Wir konnten veranschaulichen, ob die Kardinalität und das Verhältnis der Kategorien eingehalten wurden, die Korrelationen zwischen den verschiedenen Variablen beibehalten wurden und so weiter.

Die Visualisierung der Daten hilft nicht nur bei der Bewertung der Qualität der synthetischen Daten, sondern fügt sich auch als einer der ersten Schritte im Data-Science-Lebenszyklus ein, um die Daten besser zu verstehen.

Lassen Sie uns genauer auf einige Genauigkeitsmetriken eingehen.

Explorative statistische Vergleiche

Bei den explorativen statistischen Vergleichen werden die Merkmale der ursprünglichen und synthetischen Datensätze anhand wichtiger statistischer Maße untersucht, wie z. B. Mittelwert, Median, Standardabweichung, eindeutige Werte, fehlende Werte, Minima, Maxima, Quartilbereiche für kontinuierliche Merkmale und die Anzahl der Datensätze pro Kategorie, fehlende Werte pro Kategorie und die häufigsten Zeichen für kategoriale Attribute.

Dieser Vergleich sollte zwischen dem ursprünglichen Hold-out-Datensatz und den synthetischen Daten durchgeführt werden. Diese Auswertung würde zeigen, ob die verglichenen Datensätze statistisch ähnlich sind. Wenn dies nicht der Fall ist, wissen wir, welche Funktionen und Maßnahmen anders sind. Sie sollten erwägen, die synthetischen Daten mit anderen Parametern neu zu trainieren und zu regenerieren, wenn ein signifikanter Unterschied festgestellt wird.

Dieser Test dient als anfängliches Screening, um sicherzustellen, dass die synthetischen Daten eine angemessene Treue zum ursprünglichen Datensatz aufweisen und daher sinnvollerweise strengeren Tests unterzogen werden können.

Histogramm-Ähnlichkeitswert

Der Histogramm-Ähnlichkeitswert misst die marginalen Verteilungen jedes Merkmals der synthetischen und ursprünglichen Datensätze.

Der Ähnlichkeitswert ist zwischen null und eins begrenzt, wobei ein Wert von eins anzeigt, dass die Verteilungen der synthetischen Daten die Verteilungen der Originaldaten perfekt überlappen.

Eine Punktzahl nahe eins würde den Benutzern die Gewissheit geben, dass der Holdout-Datensatz und der synthetische Datensatz statistisch ähnlich sind.

Gegenseitige Informationspunktzahl

Der Mutual Information Score misst die gegenseitige Abhängigkeit zweier Merkmale, numerisch oder kategorisch, und gibt an, wie viele Informationen aus einem Merkmal durch Beobachtung eines anderen gewonnen werden können.

Gegenseitige Informationen können nichtlineare Beziehungen messen und ein umfassenderes Verständnis der synthetischen Datenqualität liefern, da sie uns das Ausmaß der Beibehaltung der Beziehungen der Variablen verstehen lassen.

Eine Punktzahl von eins zeigt an, dass die gegenseitige Abhängigkeit zwischen Merkmalen in den synthetischen Daten perfekt erfasst wurde.

Korrelationswert

Der Korrelationswert misst, wie gut die Korrelationen im Originaldatensatz in den synthetischen Daten erfasst wurden.

Korrelationen zwischen zwei oder mehr Spalten sind äußerst wichtig für ML-Anwendungen, die dabei helfen, Beziehungen zwischen Merkmalen und der Zielvariablen aufzudecken und ein gut trainiertes Modell zu erstellen.

Der Korrelationswert ist zwischen null und eins begrenzt, wobei ein Wert von eins anzeigt, dass die Korrelationen perfekt aufeinander abgestimmt sind.

Im Gegensatz zu strukturierten Tabellendaten, auf die wir häufig bei Datenproblemen stoßen, weisen einige Arten von strukturierten Daten ein bestimmtes Verhalten auf, bei dem frühere Beobachtungen die nächste Beobachtung wahrscheinlich beeinflussen. Diese werden als Zeitreihen oder sequentielle Daten bezeichnet – zum Beispiel ein Datensatz mit stündlichen Messungen der Raumtemperatur.

Dieses Verhalten bedeutet, dass bestimmte Metriken definiert werden müssen, die speziell die Qualität dieser Zeitreihendatensätze messen können

Autokorrelations- und Partial-Autokorrelations-Score

Obwohl die Autokorrelation der Korrelation ähnlich ist, zeigt sie die Beziehung einer Zeitreihe zu ihrem aktuellen Wert in Bezug auf ihre vorherigen Werte. Das Entfernen der Effekte der vorherigen Zeitverzögerungen ergibt eine teilweise Autokorrelation. Daher misst der Autokorrelationswert, wie gut die synthetischen Daten die signifikanten Autokorrelationen oder Teilkorrelationen aus dem ursprünglichen Datensatz erfasst haben.

Metriken zum Verständnis des Nutzens

Nun haben wir vielleicht statistisch festgestellt, dass die synthetischen Daten dem ursprünglichen Datensatz ähnlich sind. Darüber hinaus müssen wir auch bewerten, wie gut der synthetisierte Datensatz bei gängigen datenwissenschaftlichen Problemen abschneidet, wenn er mit mehreren ML-Algorithmen trainiert wird.

Verwenden der folgenden Nutzen Metriken möchten wir Vertrauen aufbauen, dass wir bei nachgelagerten Anwendungen tatsächlich eine Leistung in Bezug auf die Leistung der ursprünglichen Daten erzielen können.

Vorhersagepunktzahl

Die Messung der Leistung synthetischer Daten im Vergleich zu den ursprünglichen realen Daten kann durch ML-Modelle erfolgen. Die nachgelagerte Modellbewertung erfasst die Qualität der synthetischen Daten, indem die Leistung von ML-Modellen verglichen wird, die sowohl mit den synthetischen als auch mit den ursprünglichen Datensätzen trainiert und anhand zurückgehaltener Testdaten aus dem ursprünglichen Datensatz validiert wurden. Dies bietet eine Train Synthetic Test Real (TSTR)-Score und einem Trainieren Sie Real Test Real (TRTR) Punktzahl bzw.

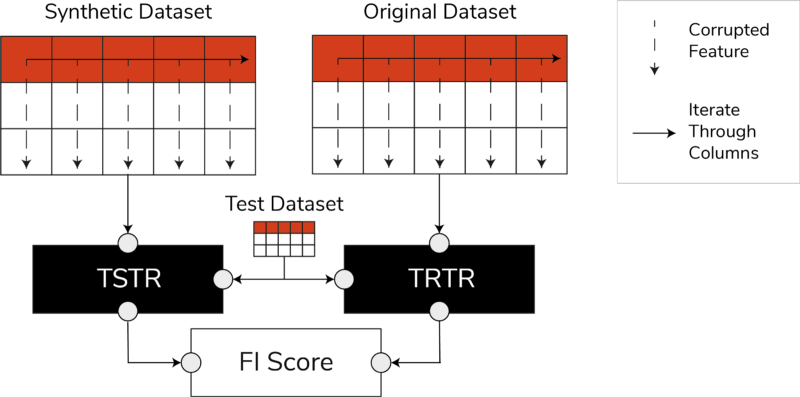

TSTR-, TRTR-Scores und der Feature Importance Score (Bild vom Autor)

Der Score enthält eine breite Palette der vertrauenswürdigsten ML-Algorithmen für Regressions- oder Klassifizierungsaufgaben. Die Verwendung mehrerer Klassifikatoren und Regressoren stellt sicher, dass die Punktzahl für die meisten Algorithmen verallgemeinerbar ist, sodass die synthetischen Daten in Zukunft als nützlich angesehen werden können.

Wenn der TSTR-Score und der TRTR-Score am Ende vergleichbar sind, weist dies darauf hin, dass die synthetischen Daten die Qualität haben, um effektive ML-Modelle für reale Anwendungen zu trainieren.

Feature-Importance-Score

Der Feature-Importance-Score (FI) ist eng mit dem Prediction Score verwandt und erweitert ihn, indem er den TSTR- und TRTR-Scores Interpretierbarkeit hinzufügt.

Der F1-Score vergleicht die Änderungen und die Stabilität der erhaltenen Wichtigkeitsreihenfolge des Merkmals mit dem Vorhersage-Score. Ein synthetischer Datensatz wird als hochgradig nützlich angesehen, wenn er die gleiche Rangordnung der Merkmalswichtigkeit wie die ursprünglichen realen Daten ergibt.

QScore

Um sicherzustellen, dass ein Modell, das mit unseren neu generierten Daten trainiert wurde, dieselben Antworten auf dieselben Fragen liefert wie ein Modell, das mit den Originaldaten trainiert wurde, verwenden wir den Qscore. Dies misst die nachgelagerte Leistung der synthetischen Daten, indem viele zufällige, auf Aggregation basierende Abfragen sowohl für die synthetischen als auch für die ursprünglichen (und zurückgehaltenen) Datensätze ausgeführt werden.

Die Idee dabei ist, dass beide Abfragen ähnliche Ergebnisse zurückgeben sollten.

Ein hoher QScore stellt sicher, dass nachgelagerte Anwendungen, die Abfrage- und Aggregationsvorgänge verwenden, einen nahezu gleichen Wert wie der ursprüngliche Datensatz bieten können.

Metriken zum Verständnis der Privatsphäre

Mit der Datenschutz Vorschriften bereits vorhanden, ist es eine ethische Verpflichtung und eine gesetzliche Anforderung, sicherzustellen, dass sensible Informationen geschützt sind.

Bevor diese synthetischen Daten frei geteilt und für nachgelagerte Anwendungen verwendet werden können, müssen wir die Datenschutzmetriken berücksichtigen, die den Beteiligten helfen können zu verstehen, wo die generierten synthetischen Daten im Vergleich zu den ursprünglichen Daten in Bezug auf den Umfang der durchgesickerten Informationen stehen. Darüber hinaus müssen wir kritische Entscheidungen darüber treffen, wie die synthetischen Daten geteilt und verwendet werden können.

Genaues Spielergebnis

Eine direkte und intuitive Bewertung der Privatsphäre besteht darin, unter den synthetischen Aufzeichnungen nach Kopien der echten Daten zu suchen. Der exakte Match-Score zählt die Anzahl der echten Datensätze, die im synthetischen Satz gefunden werden können.

Die Punktzahl sollte Null sein, was besagt, dass in den synthetischen Daten keine echten Informationen vorhanden sind. Diese Metrik dient als Überprüfungsmechanismus, bevor wir weitere Datenschutzmetriken auswerten.

Datenschutzbewertung der Nachbarn

Darüber hinaus misst der Datenschutzwert der Nachbarn das Verhältnis der synthetischen Aufzeichnungen, die den echten möglicherweise zu ähnlich sind. Dies bedeutet, dass sie, obwohl sie keine direkten Kopien sind, potenzielle Punkte für das Eindringen in die Privatsphäre und eine Quelle nützlicher Informationen für Inferenzangriffe sind.

Die Punktzahl wird berechnet, indem eine hochdimensionale Suche nach den nächsten Nachbarn an den synthetischen Daten durchgeführt wird, die mit den Originaldaten überlappt sind.

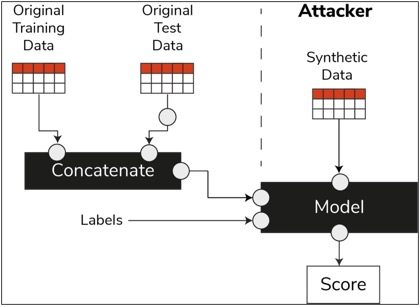

Zugehörigkeits-Inferenz-Score

Im Data-Science-Lebenszyklus benötigt ein Modell nach dem Training keinen Zugriff mehr auf die Trainingsgebiete und kann Vorhersagen zu unsichtbaren Daten treffen. In ähnlicher Weise können in unserem Fall, sobald das Synthesizermodell trainiert ist, Proben synthetischer Daten generiert werden, ohne dass die Originaldaten benötigt werden.

Durch eine Art von Angriff genannt „Angriff auf Mitgliedschaftsrückschlüsse“, können Angreifer versuchen, die Daten offenzulegen, die zum Erstellen der synthetischen Daten verwendet wurden, ohne Zugriff auf die Originaldaten zu haben. Dies führt zu einer Beeinträchtigung der Privatsphäre.

Der Membership-Inference-Score misst die Wahrscheinlichkeit, dass ein Membership-Inference-Angriff erfolgreich ist.

Eine niedrige Punktzahl deutet darauf hin, dass der Schluss gezogen werden kann, dass ein bestimmter Datensatz ein Mitglied des Trainingsdatensatzes war, der zur Erstellung der synthetischen Daten geführt hat. Mit anderen Worten, die Angriffe können auf Details eines individuellen Datensatzes schließen und dadurch die Privatsphäre gefährden.

Ein hoher Membership Inference Score weist darauf hin, dass ein Angreifer wahrscheinlich nicht feststellen kann, ob ein bestimmter Datensatz Teil des ursprünglichen Datensatzes war, der zum Erstellen der synthetischen Daten verwendet wurde. Das bedeutet auch, dass die Informationen keiner Person durch die synthetischen Daten kompromittiert wurden.

Das Holdout-Konzept

Eine wichtige bewährte Methode, die wir befolgen müssen, besteht darin, sicherzustellen, dass die synthetischen Daten allgemein genug sind und die ursprünglichen Daten, auf denen sie trainiert wurden, nicht übertreffen. In einem typischen Data-Science-Ablauf legen wir beim Erstellen von ML-Modellen wie einem Random-Forest-Klassifikator Testdaten beiseite, trainieren die Modelle mit den Trainingsdaten und werten die Metriken anhand unsichtbarer Testdaten aus.

In ähnlicher Weise behalten wir für synthetische Daten eine Stichprobe der Originaldaten beiseite – allgemein als Hold-out-Datensatz oder unsichtbar zurückgehaltene Testdaten bezeichnet – und bewerten die generierten synthetischen Daten anhand des Hold-out-Datensatzes.

Es wird erwartet, dass der Holdout-Datensatz eine Darstellung der Originaldaten ist, die jedoch noch nicht gesehen wurden, als die synthetischen Daten generiert wurden. Daher ist es wichtig, ähnliche Werte für alle Metriken zu haben, wenn man das Original mit dem Holdout und den synthetischen Datensätzen vergleicht.

Wenn ähnliche Ergebnisse erzielt werden, können wir feststellen, dass die synthetischen Datenpunkte nicht das Ergebnis des Auswendiglernens der ursprünglichen Datenpunkte sind, während die gleiche Genauigkeit und Nützlichkeit beibehalten wird.

Abschließende Gedanken

Die Welt beginnt, die strategische Bedeutung synthetischer Daten zu verstehen. Als Data Scientists und Datengeneratoren ist es unsere Pflicht, Vertrauen in die von uns generierten synthetischen Daten aufzubauen und sicherzustellen, dass sie einem bestimmten Zweck dienen.

Synthetische Daten entwickeln sich zu einem Muss im Data-Science-Entwicklungs-Toolkit. MIT Technology Review hat bekannt synthetische Daten als eine der bahnbrechenden Technologien des Jahres 2022. Wir können uns nicht vorstellen, KI-Modelle mit hervorragendem Wert ohne synthetische Daten zu bauen, behauptet Gartner.

Laut McKinsey, synthetische Daten minimieren Kosten und Barrieren, die Sie sonst bei der Entwicklung von Algorithmen oder beim Zugriff auf Daten hätten.

Bei der Generierung synthetischer Daten geht es darum, die nachgelagerten Anwendungen zu kennen und die Kompromisse zwischen den verschiedenen Dimensionen für die Qualität synthetischer Daten zu verstehen.

Zusammenfassung

Als Nutzer der synthetischen Daten ist es wichtig, den Kontext des Anwendungsfalls zu definieren, für den jede synthetische Probe in Zukunft verwendet wird. Wie bei realen Daten hängt die Qualität der synthetischen Daten vom beabsichtigten Anwendungsfall sowie den für die Synthese gewählten Parametern ab.

Beispielsweise ist es für einen Anwendungsfall zur Betrugserkennung nützlich, Ausreißer in den synthetischen Daten wie in den Originaldaten beizubehalten. In einem Anwendungsfall im Gesundheitswesen mit Datenschutzbedenken ist dies jedoch nicht sinnvoll, da es sich bei Ausreißern im Allgemeinen um Informationslecks handeln könnte.

Darüber hinaus besteht ein Kompromiss zwischen Treue, Nützlichkeit und Privatsphäre. Daten können nicht für alle drei gleichzeitig optimiert werden. Diese Metriken ermöglichen es den Beteiligten, das Wesentliche für jeden Anwendungsfall zu priorisieren und die Erwartungen an die generierten synthetischen Daten zu verwalten.

Letztendlich, wenn wir die Werte jeder Metrik sehen und wenn sie die Erwartungen erfüllen, können sich die Beteiligten auf die Lösungen verlassen, die sie unter Verwendung der synthetischen Daten erstellen.

Die Anwendungsfälle für strukturierte synthetische Daten decken ein breites Anwendungsspektrum ab, von Testdaten für die Softwareentwicklung bis hin zur Erstellung synthetischer Kontrollarme in klinischen Studien.

Erkunden Sie diese Möglichkeiten oder erstellen Sie einen PoC, um den Wert zu demonstrieren.

Faris Haddad ist Data & Insights Lead im AABG Strategic Pursuits Team. Er hilft Unternehmen, erfolgreich datengetrieben zu werden.

Faris Haddad ist Data & Insights Lead im AABG Strategic Pursuits Team. Er hilft Unternehmen, erfolgreich datengetrieben zu werden.

- Fortgeschritten (300)

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- Amazon Machine Learning

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- AWS Maschinelles Lernen

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Syntax

- Technische Anleitung

- Zephyrnet