Der Erfolg generativer KI-Anwendungen in einer Vielzahl von Branchen hat die Aufmerksamkeit und das Interesse von Unternehmen auf der ganzen Welt geweckt, die die Errungenschaften der Wettbewerber reproduzieren und übertreffen oder neue und spannende Anwendungsfälle lösen möchten. Diese Kunden suchen nach Basismodellen wie TII Falcon, Stable Diffusion XL oder GPT-3.5 von OpenAI als Motoren, die die generative KI-Innovation vorantreiben.

Foundation-Modelle sind eine Klasse generativer KI-Modelle, die dank der riesigen Mengen unstrukturierter Daten, auf denen sie trainiert wurden, in der Lage sind, menschenähnliche Inhalte zu verstehen und zu generieren. Diese Modelle haben verschiedene Aufgaben im Bereich Computer Vision (CV) und Verarbeitung natürlicher Sprache (NLP) revolutioniert, darunter Bilderzeugung, Übersetzung und Beantwortung von Fragen. Sie dienen als Bausteine für viele KI-Anwendungen und sind zu einem entscheidenden Bestandteil bei der Entwicklung fortschrittlicher intelligenter Systeme geworden.

Der Einsatz von Stiftungsmodellen kann jedoch mit erheblichen Herausforderungen verbunden sein, insbesondere im Hinblick auf Kosten und Ressourcenbedarf. Diese Modelle sind für ihre Größe bekannt, die oft zwischen Hunderten Millionen und Milliarden Parametern liegt. Ihre Größe erfordert umfangreiche Rechenressourcen, einschließlich leistungsstarker Hardware und erheblicher Speicherkapazität. Tatsächlich erfordert die Bereitstellung von Basismodellen in der Regel mindestens eine (häufig mehrere) GPUs, um die Rechenlast effizient zu bewältigen. Beispielsweise erfordert das TII Falcon-40B Instruct-Modell mindestens eine ml.g5.12xlarge-Instanz, um erfolgreich in den Speicher geladen zu werden, erzielt jedoch die beste Leistung mit größeren Instanzen. Infolgedessen kann der Return on Investment (ROI) der Bereitstellung und Wartung dieser Modelle zu niedrig sein, um einen geschäftlichen Nutzen zu beweisen, insbesondere während Entwicklungszyklen oder bei Spitzenlasten. Dies ist auf die laufenden Kosten zurückzuführen, die durch GPU-betriebene Instanzen für lange Sitzungen, möglicherweise rund um die Uhr, entstehen.

Anfang dieses Jahres haben wir es angekündigt Amazonas Grundgestein, eine serverlose API für den Zugriff auf Basismodelle von Amazon und unseren generativen KI-Partnern. Obwohl es sich derzeit in der privaten Vorschau befindet, können Sie mit seiner serverlosen API Basismodelle von Amazon, Anthropic, Stability AI und AI21 verwenden, ohne selbst Endpunkte bereitstellen zu müssen. Allerdings haben Open-Source-Modelle von Communities wie Hugging Face stark zugenommen, und nicht jedes davon wurde über Amazon Bedrock verfügbar gemacht.

In diesem Beitrag gehen wir auf diese Situationen ein und lösen das Problem des Risikos hoher Kosten durch den Einsatz großer Fundamentmodelle Amazon Sage Maker asynchrone Endpunkte für Amazon SageMaker-JumpStart. Dies kann dazu beitragen, die Kosten der Architektur zu senken, da der Endpunkt nur dann ausgeführt werden kann, wenn sich Anforderungen in der Warteschlange befinden, und dies nur für eine kurze Lebensdauer, während er auf Null herunterskaliert wird, wenn keine Anforderungen auf die Bearbeitung warten. Das klingt für viele Anwendungsfälle großartig; Ein Endpunkt, der auf Null herunterskaliert wurde, führt jedoch zu einer Kaltstartzeit, bevor er Schlussfolgerungen liefern kann.

Lösungsüberblick

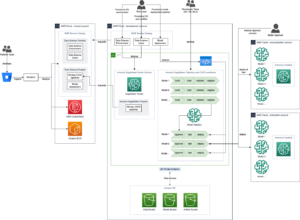

Das folgende Diagramm zeigt unsere Lösungsarchitektur.

Die von uns bereitgestellte Architektur ist sehr einfach:

- Die Benutzeroberfläche ist ein Notebook, das durch eine Web-Benutzeroberfläche ersetzt werden kann, die auf Streamlit oder einer ähnlichen Technologie basiert. In unserem Fall ist das Notebook ein Amazon SageMaker-Studio Notebook, läuft auf einer ml.m5.large-Instanz mit dem PyTorch 2.0 Python 3.10 CPU-Kernel.

- Das Notebook fragt den Endpunkt auf drei Arten ab: das SageMaker Python SDK, das AWS SDK for Python (Boto3) und LangChain.

- Der Endpunkt läuft asynchron auf SageMaker und auf dem Endpunkt stellen wir das Falcon-40B Instruct-Modell bereit. Es entspricht derzeit dem neuesten Stand der Technik in Bezug auf Instruct-Modelle und ist in SageMaker JumpStart verfügbar. Mit einem einzigen API-Aufruf können wir das Modell auf dem Endpunkt bereitstellen.

Was ist die asynchrone Inferenz von SageMaker?

Die asynchrone SageMaker-Inferenz ist neben Echtzeit-Endpunkten, Batch-Inferenz und serverloser Inferenz eine der vier Bereitstellungsoptionen in SageMaker. Weitere Informationen zu den verschiedenen Bereitstellungsoptionen finden Sie unter Stellen Sie Modelle für Inferenz bereit.

Die asynchrone Inferenz von SageMaker stellt eingehende Anfragen in die Warteschlange und verarbeitet sie asynchron. Dadurch eignet sich diese Option ideal für Anfragen mit großen Nutzlastgrößen von bis zu 1 GB, langen Verarbeitungszeiten und Latenzanforderungen nahezu in Echtzeit. Der Hauptvorteil, den es jedoch beim Umgang mit großen Basismodellen bietet, insbesondere während eines Proof of Concept (POC) oder während der Entwicklung, ist die Möglichkeit, asynchrone Inferenz so zu konfigurieren, dass sie auf eine Instanzanzahl von Null skaliert wird, wenn keine Anfragen dazu vorliegen Prozess und spart dadurch Kosten. Weitere Informationen zur asynchronen SageMaker-Inferenz finden Sie unter Asynchrone Inferenz. Das folgende Diagramm veranschaulicht diese Architektur.

Um einen asynchronen Inferenzendpunkt bereitzustellen, müssen Sie einen erstellen AsyncInferenceConfig Objekt. Wenn Sie erstellen AsyncInferenceConfig ohne Angabe seiner Argumente die Standardeinstellung S3OutputPath wird sein s3://sagemaker-{REGION}-{ACCOUNTID}/async-endpoint-outputs/{UNIQUE-JOB-NAME} und S3FailurePath wird sein s3://sagemaker-{REGION}-{ACCOUNTID}/async-endpoint-failures/{UNIQUE-JOB-NAME}.

Was ist SageMaker JumpStart?

Unser Modell stammt von SageMaker JumpStart, einer Funktion von SageMaker, die den Weg des maschinellen Lernens (ML) beschleunigt, indem sie vorab trainierte Modelle, Lösungsvorlagen und Beispielnotizbücher anbietet. Es bietet Zugriff auf eine breite Palette vorab trainierter Modelle für verschiedene Problemtypen, sodass Sie Ihre ML-Aufgaben auf einer soliden Grundlage beginnen können. SageMaker JumpStart bietet außerdem Lösungsvorlagen für gängige Anwendungsfälle und Beispielnotizbücher zum Lernen. Mit SageMaker JumpStart können Sie den Zeit- und Arbeitsaufwand für den Start Ihrer ML-Projekte durch Lösungseinführungen mit nur einem Klick und umfassende Ressourcen für praktische ML-Erfahrung reduzieren.

Der folgende Screenshot zeigt ein Beispiel einiger der Modelle, die auf der SageMaker JumpStart-Benutzeroberfläche verfügbar sind.

Stellen Sie das Modell bereit

Unser erster Schritt besteht darin, das Modell in SageMaker bereitzustellen. Dazu können wir die Benutzeroberfläche für SageMaker JumpStart oder das SageMaker Python SDK verwenden, das eine API bereitstellt, mit der wir das Modell auf dem asynchronen Endpunkt bereitstellen können:

Dieser Anruf kann etwa 10 Minuten dauern. Während dieser Zeit wird der Endpunkt hochgefahren, der Container wird zusammen mit den Modellartefakten auf den Endpunkt heruntergeladen, die Modellkonfiguration wird von SageMaker JumpStart geladen und dann wird der asynchrone Endpunkt über einen DNS-Endpunkt verfügbar gemacht. Um sicherzustellen, dass unser Endpunkt auf Null herunterskaliert werden kann, müssen wir die automatische Skalierung auf dem asynchronen Endpunkt mithilfe von Application Auto Scaling konfigurieren. Sie müssen zunächst Ihre Endpunktvariante bei Application Auto Scaling registrieren, eine Skalierungsrichtlinie definieren und dann die Skalierungsrichtlinie anwenden. In dieser Konfiguration verwenden wir eine benutzerdefinierte Metrik mit CustomizedMetricSpecification, Rief ApproximateBacklogSizePerInstance, wie im folgenden Code gezeigt. Für eine detaillierte Liste von Amazon CloudWatch Die mit Ihrem asynchronen Inferenzendpunkt verfügbaren Metriken finden Sie unter Überwachung mit CloudWatch.

Sie können überprüfen, ob diese Richtlinie erfolgreich festgelegt wurde, indem Sie zur SageMaker-Konsole navigieren und „ Endpunkte für Inferenz im Navigationsbereich und suchen Sie nach dem Endpunkt, den wir gerade bereitgestellt haben.

Rufen Sie den asynchronen Endpunkt auf

Um den Endpunkt aufzurufen, müssen Sie die Anforderungsnutzlast darin platzieren Amazon Simple Storage-Service (Amazon S3) und stellen Sie als Teil des einen Zeiger auf diese Nutzlast bereit InvokeEndpointAsync Anfrage. Beim Aufruf stellt SageMaker die Anfrage zur Verarbeitung in die Warteschlange und gibt als Antwort eine Kennung und einen Ausgabeort zurück. Bei der Verarbeitung platziert SageMaker das Ergebnis am Amazon S3-Speicherort. Sie können optional auswählen, ob Sie Erfolgs- oder Fehlerbenachrichtigungen erhalten möchten Amazon Simple Notification Service (Amazon SNS).

SageMaker Python-SDK

Nach Abschluss der Bereitstellung wird eine zurückgegeben AsyncPredictor Objekt. Um eine asynchrone Inferenz durchzuführen, müssen Sie Daten auf Amazon S3 hochladen und verwenden predict_async() Methode mit dem S3-URI als Eingabe. Es wird ein zurückgegeben AsyncInferenceResponse Objekt, und Sie können das Ergebnis mit dem überprüfen get_response() Methode.

Wenn Sie alternativ regelmäßig nach einem Ergebnis suchen und es bei der Generierung zurückgeben möchten, verwenden Sie die predict() Methode. Wir verwenden diese zweite Methode im folgenden Code:

Boto3

Lassen Sie uns nun das erkunden invoke_endpoint_async Methode von Boto3 sagemaker-runtime Klient. Es ermöglicht Entwicklern, einen SageMaker-Endpunkt asynchron aufzurufen und ein Token für die Fortschrittsverfolgung und den späteren Abruf der Antwort bereitzustellen. Boto3 bietet keine Möglichkeit, wie das SageMaker Python SDK auf den Abschluss der asynchronen Inferenz zu warten get_result() Betrieb. Daher machen wir uns die Tatsache zunutze, dass Boto3 die Inferenzausgabe in Amazon S3 im speichert response["OutputLocation"]. Wir können die folgende Funktion verwenden, um darauf zu warten, dass die Inferenzdatei in Amazon S3 geschrieben wird:

Mit dieser Funktion können wir nun den Endpunkt abfragen:

LangChain

LangChain ist ein Open-Source-Framework, das im Oktober 2022 von Harrison Chase eingeführt wurde. Es vereinfacht die Entwicklung von Anwendungen mithilfe großer Sprachmodelle (LLMs), indem es Integrationen mit verschiedenen Systemen und Datenquellen ermöglicht. LangChain ermöglicht Dokumentenanalyse, Zusammenfassung, Chatbot-Erstellung, Code-Analyse und mehr. Dank der Beiträge von Hunderten von Entwicklern und erheblicher Finanzierung durch Risikokapitalfirmen erfreut es sich immer größerer Beliebtheit. LangChain ermöglicht die Verbindung von LLMs mit externen Quellen und ermöglicht so die Erstellung dynamischer, datenresponsiver Anwendungen. Es bietet Bibliotheken, APIs und Dokumentation, um den Entwicklungsprozess zu optimieren.

LangChain stellt mit seinem Framework Bibliotheken und Beispiele für die Verwendung von SageMaker-Endpunkten bereit, wodurch es einfacher wird, auf SageMaker gehostete ML-Modelle als „Gehirn“ der Kette zu verwenden. Weitere Informationen zur Integration von LangChain in SageMaker finden Sie im SageMaker-Endpunkt in der LangChain-Dokumentation.

Eine der Einschränkungen der aktuellen Implementierung von LangChain besteht darin, dass asynchrone Endpunkte nicht nativ unterstützt werden. Um einen asynchronen Endpunkt für LangChain zu verwenden, müssen wir eine neue Klasse definieren, SagemakerAsyncEndpoint, das erweitert die SagemakerEndpoint Klasse, die bereits in LangChain verfügbar ist. Darüber hinaus stellen wir Ihnen folgende Informationen zur Verfügung:

- Der S3-Bucket und das Präfix, in dem die asynchrone Inferenz die Eingaben (und Ausgaben) speichert.

- Eine maximale Anzahl von Sekunden, die vor einer Zeitüberschreitung gewartet werden soll

- An

updated _call()Funktion zum Abfragen des Endpunktsinvoke_endpoint_async()stattinvoke_endpoint() - Eine Möglichkeit, den asynchronen Endpunkt aufzuwecken, wenn er sich im Kaltstart befindet (auf Null herunterskaliert)

Um das neu erstellte zu überprüfen SagemakerAsyncEndpointKönnen Sie bitte zuerst die sagemaker_async_endpoint.py Datei verfügbar auf GitHub.

Aufräumen

Wenn Sie mit dem Testen der Generierung von Schlussfolgerungen vom Endpunkt fertig sind, denken Sie daran, den Endpunkt zu löschen, um zusätzliche Kosten zu vermeiden:

Zusammenfassung

Beim Einsatz großer Fundamentmodelle wie TII Falcon ist die Kostenoptimierung von entscheidender Bedeutung. Diese Modelle erfordern leistungsstarke Hardware und erhebliche Speicherkapazität, was zu hohen Infrastrukturkosten führt. Die asynchrone Inferenz von SageMaker, eine Bereitstellungsoption, die Anfragen asynchron verarbeitet, reduziert die Kosten, indem die Instanzanzahl auf Null skaliert wird, wenn keine ausstehenden Anfragen vorliegen. In diesem Beitrag haben wir gezeigt, wie man große SageMaker JumpStart-Grundlagenmodelle auf asynchronen SageMaker-Endpunkten bereitstellt. Wir haben Codebeispiele mit dem SageMaker Python SDK, Boto3 und LangChain bereitgestellt, um verschiedene Methoden zum Aufrufen asynchroner Endpunkte und zum Abrufen von Ergebnissen zu veranschaulichen. Diese Techniken ermöglichen es Entwicklern und Forschern, die Kosten zu optimieren und gleichzeitig die Fähigkeiten von Basismodellen für fortgeschrittene Sprachverständnissysteme zu nutzen.

Weitere Informationen zu asynchroner Inferenz und SageMaker JumpStart finden Sie in den folgenden Beiträgen:

Über den Autor

David Gallitelli ist ein Specialist Solutions Architect für AI/ML in der EMEA-Region. Er hat seinen Sitz in Brüssel und arbeitet eng mit Kunden in den Benelux-Ländern zusammen. Er ist Entwickler, seit er sehr jung war und begann im Alter von 7 Jahren zu programmieren. Er begann an der Universität AI/ML zu lernen und hat sich seitdem darin verliebt.

David Gallitelli ist ein Specialist Solutions Architect für AI/ML in der EMEA-Region. Er hat seinen Sitz in Brüssel und arbeitet eng mit Kunden in den Benelux-Ländern zusammen. Er ist Entwickler, seit er sehr jung war und begann im Alter von 7 Jahren zu programmieren. Er begann an der Universität AI/ML zu lernen und hat sich seitdem darin verliebt.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Automobil / Elektrofahrzeuge, Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- ChartPrime. Verbessern Sie Ihr Handelsspiel mit ChartPrime. Hier zugreifen.

- BlockOffsets. Modernisierung des Eigentums an Umweltkompensationen. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/optimize-deployment-cost-of-amazon-sagemaker-jumpstart-foundation-models-with-amazon-sagemaker-asynchronous-endpoints/

- :hast

- :Ist

- :nicht

- :Wo

- $UP

- 1

- 10

- 100

- 12

- 13

- 15%

- 1M

- 2022

- 25

- 7

- a

- Fähig

- LiveBuzz

- beschleunigt

- Akzeptiert

- Zugang

- Leistungen

- über

- Aktivität

- zusätzlich

- advanced

- Vorteil

- Nach der

- Alter

- AI

- KI-Modelle

- AI / ML

- Zulassen

- erlaubt

- bereits

- ebenfalls

- Obwohl

- Amazon

- Amazon Sage Maker

- Amazon SageMaker-JumpStart

- Amazon Web Services

- Betrag

- Beträge

- an

- Analyse

- und

- angekündigt

- Ein anderer

- Anthropisch

- jedem

- Bienen

- APIs

- Anwendung

- Anwendungen

- Bewerben

- Architektur

- SIND

- Argumente

- Kunst

- AS

- At

- Aufmerksamkeit

- angezogen

- Auto

- verfügbar

- durchschnittlich

- vermeiden

- AWS

- basierend

- BE

- werden

- war

- Bevor

- Sein

- BESTE

- größer

- Milliarden

- Blockiert

- Körper

- Break

- Brüssel

- Building

- erbaut

- Geschäft

- aber

- by

- rufen Sie uns an!

- namens

- CAN

- Fähigkeiten

- capability

- fähig

- Kapazität

- Häuser

- Fälle

- Kette

- Ketten

- Herausforderungen

- Gebühren

- Verfolgungsjagd

- Chatbot

- aus der Ferne überprüfen

- Auswählen

- Auswahl

- Klasse

- Auftraggeber

- eng

- Code

- Kälte

- wie die

- kommt

- gemeinsam

- Communities

- Unternehmen

- Konkurrenz

- abschließen

- Abgeschlossene Verkäufe

- Wird abgeschlossen

- Komponente

- umfassend

- Computer

- Computer Vision

- konzept

- Konfiguration

- Verbindung

- Konsul (Console)

- Container

- Inhalt

- Beiträge

- Kosten

- Kosten

- erstellen

- erstellt

- Schaffung

- wichtig

- Strom

- Zur Zeit

- Original

- Kunden

- Schneiden

- Kosten senken

- Zyklen

- technische Daten

- Behandlung

- Standard

- definieren

- Anforderungen

- Synergie

- einsetzen

- Einsatz

- Bereitstellen

- Einsatz

- detailliert

- Entwickler

- Entwickler:in / Unternehmen

- Entwickler

- Entwicklung

- DICT

- anders

- Rundfunk

- Größe

- behindert

- dns

- do

- Dokument

- Dokumentation

- Tut nicht

- erledigt

- nach unten

- zwei

- im

- dynamisch

- e

- einfacher

- effizient

- Anstrengung

- sonst

- EMEA

- ermöglichen

- ermöglicht

- Endpunkt

- Motor (en)

- genug

- Fehler

- insbesondere

- Jedes

- Beispiel

- Beispiele

- Außer

- Ausnahme

- unterhaltsame Programmpunkte

- Kosten

- ERFAHRUNGEN

- ERKUNDEN

- ausgesetzt

- erweitert

- umfangreiche

- extern

- extra

- Gesicht

- Tatsache

- Gefallen

- falsch

- Merkmal

- Reichen Sie das

- Firmen

- Vorname

- Folgende

- Aussichten für

- Foundation

- vier

- Unser Ansatz

- für

- Funktion

- Finanzierung

- gewonnen

- erzeugt

- Erzeugung

- Generation

- generativ

- Generative KI

- GitHub

- gut

- GPUs

- groß

- persönlichem Wachstum

- Griff

- Hardware

- Haben

- mit

- he

- Hilfe

- hier

- GUTE

- gehostet

- Ultraschall

- Hilfe

- aber

- HTML

- http

- HTTPS

- hunderte

- hunderte Millionen

- ideal

- Kennzeichnung

- if

- zeigt

- Image

- Implementierung

- importieren

- in

- Einschließlich

- Eingehende

- zeigt

- Branchen

- Information

- Infrastruktur

- Innovation

- Varianten des Eingangssignals:

- Eingänge

- Instanz

- beantragen müssen

- Integriert

- Integrationen

- Intelligent

- Interesse

- Schnittstelle

- in

- einführen

- Investition

- IT

- SEINE

- Reise

- jpg

- JSON

- nur

- bekannt

- Sprache

- grosse

- Latency

- später

- ins Leben gerufen

- startet

- führenden

- LERNEN

- lernen

- am wenigsten

- Bibliotheken

- Gefällt mir

- Grenzen

- Liste

- Belastung

- Standorte

- Lang

- suchen

- Los

- ich liebe

- Sneaker

- Maschine

- Maschinelles Lernen

- gemacht

- Main

- Aufrechterhaltung

- um

- Making

- viele

- max

- maximal

- Memory

- Methode

- Methoden

- Metrisch

- Metrik

- Millionen

- Minuten

- ML

- Modell

- für

- mehr

- Name

- Natürliche

- Verarbeitung natürlicher Sprache

- navigieren

- Menü

- Need

- Neu

- neu

- weiter

- Nlp

- nicht

- Notizbuch

- Benachrichtigung

- Benachrichtigungen

- jetzt an

- Anzahl

- Objekt

- Oktober

- of

- bieten

- bieten

- Angebote

- vorgenommen,

- on

- EINEM

- einzige

- Open-Source-

- Betrieb

- Optimieren

- Optimierung

- Option

- Optionen

- or

- UNSERE

- Möglichkeiten für das Ausgangssignal:

- Brot

- Parameter

- Teil

- besonders

- schwebend

- Ausführen

- führt

- ein Bild

- Ort

- Länder/Regionen

- Plato

- Datenintelligenz von Plato

- PlatoData

- PoC

- Datenschutzrichtlinien

- Popularität

- möglich

- Post

- BLOG-POSTS

- möglicherweise

- Werkzeuge

- größte treibende

- Praktisch

- Prognose

- Predictor

- Vorspann

- privat

- Aufgabenstellung:

- Prozessdefinierung

- anpassen

- Verarbeitung

- Fortschritt

- Projekte

- Beweis

- Proof of Concept

- Belegen

- die

- vorausgesetzt

- bietet

- Bereitstellung

- Python

- Pytorch

- Abfragen

- Frage

- erhöhen

- Angebot

- Bereich

- Lesen Sie mehr

- bereit

- Echtzeit

- erhalten

- Veteran

- reduziert

- Region

- Registrieren

- merken

- entfernen

- ersetzt

- Anforderung

- Zugriffe

- erfordern

- falls angefordert

- Voraussetzungen:

- erfordert

- Forscher

- Ressourcen

- Downloads

- Antwort

- Folge

- Die Ergebnisse

- Rückkehr

- Rückgabe

- Überprüfen

- revolutioniert

- riskieren

- ROI

- Führen Sie

- Laufen

- sagemaker

- Einsparung

- skalierbaren

- Skalieren

- Skalierung

- Sdk

- Zweite

- Sekunden

- SELF

- brauchen

- Serverlos

- Lösungen

- Sessions

- kompensieren

- Short

- gezeigt

- Konzerte

- signifikant

- ähnlich

- Einfacher

- da

- Single

- Umstände

- Größe

- Größen

- solide

- Lösung

- Lösungen

- LÖSEN

- einige

- Quellen

- Spezialist

- gesponnen

- Stabilität

- stabil

- Anfang

- begonnen

- Beginnen Sie

- Bundesstaat

- Schritt

- Stoppen

- Lagerung

- speichern

- einfach

- rationalisieren

- wesentlich

- Erfolg

- Erfolgreich

- so

- Support

- Unterstützt

- sicher

- übertreffen

- Systeme und Techniken

- Nehmen

- Target

- und Aufgaben

- Techniken

- Technologie

- Vorlagen

- AGB

- Testen

- Vielen Dank

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Der Staat

- ihr

- Sie

- dann

- Dort.

- damit

- deswegen

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- dieses Jahr

- nach drei

- Durch

- während

- Zeit

- mal

- zeitliche Koordinierung

- zu

- gemeinsam

- Zeichen

- auch

- Tracking

- trainiert

- Übersetzungen

- was immer dies auch sein sollte.

- versuchen

- Typen

- ui

- für

- Verständnis

- Universität

- bis

- auf

- us

- -

- Mitglied

- Benutzerschnittstelle

- Verwendung von

- gewöhnlich

- Wert

- Variante

- verschiedene

- riesig

- wagen

- überprüfen

- sehr

- Seh-

- warten

- Warten

- Wake

- Aufwachen

- wollen

- wurde

- Weg..

- Wege

- we

- Netz

- Web-Services

- wann

- ob

- welche

- während

- WHO

- breit

- Große Auswahl

- werden wir

- mit

- ohne

- Gewonnen

- Werk

- Das weltweit

- würde

- geschrieben

- Jahr

- Du

- jung

- Ihr

- sich selbst

- Zephyrnet

- Null