Videopeliteollisuudella on arvioitu yli 3 miljardin käyttäjäkunnan maailmanlaajuisesti1. Se koostuu valtavista määristä pelaajia, jotka ovat käytännössä vuorovaikutuksessa toistensa kanssa joka ikinen päivä. Valitettavasti, kuten todellisessa maailmassa, kaikki pelaajat eivät kommunikoi asianmukaisesti ja kunnioittavasti. Pyrkiessään luomaan ja ylläpitämään sosiaalisesti vastuullista peliympäristöä AWS Professional Services -palvelua pyydettiin rakentamaan mekanismi, joka havaitsee sopimattoman kielen (myrkyllisen puheen) online-pelaajien vuorovaikutuksessa. Liiketoiminnan kokonaistuloksena oli parantaa organisaation toimintaa automatisoimalla olemassa oleva manuaalinen prosessi ja parantaa käyttökokemusta lisäämällä nopeutta ja laatua pelaajien välisten sopimattomien vuorovaikutusten havaitsemisessa, mikä lopulta edistää puhtaampaa ja terveellisempää peliympäristöä.

Asiakkaan pyyntö oli luoda englanninkielinen ilmaisin, joka luokittelee ääni- ja tekstiotteita omiin mukautettujen myrkyllisten kielten luokkiin. He halusivat ensin määrittää, onko annettu kielenote myrkyllinen, ja sitten luokitella otteen tiettyyn asiakkaan määrittelemään myrkyllisyysluokkaan, kuten kiroukseen tai loukkaavaan kielenkäyttöön.

AWS ProServe ratkaisi tämän käyttötapauksen Generative AI Innovation Centerin (GAIIC) ja ProServe ML Delivery Teamin (MLDT) yhteisellä ponnistelulla. AWS GAIIC on AWS ProServen ryhmä, joka yhdistää asiakkaat ja asiantuntijat kehittämään generatiivisia tekoälyratkaisuja monenlaisiin yrityskäyttötapauksiin käyttämällä proof of concept (PoC) -rakenteita. AWS ProServe MLDT vie sitten PoC:n tuotannon läpi skaalaamalla, karkaisemalla ja integroimalla ratkaisun asiakkaalle.

Tämä asiakaskäyttötapaus esitellään kahdessa erillisessä postauksessa. Tämä viesti (osa 1) on syvällinen sukellus tieteelliseen metodologiaan. Siinä selitetään ratkaisun takana oleva ajatusprosessi ja kokeilu, mukaan lukien mallin koulutus- ja kehitysprosessi. Osassa 2 perehdytään tuotantoratkaisuun, selitetään suunnittelupäätökset, tiedonkulku sekä mallin koulutus- ja käyttöönottoarkkitehtuurin havainnollistaminen.

Tämä viesti käsittelee seuraavia aiheita:

- Haasteet, jotka AWS ProServe joutui ratkaisemaan tässä käyttötapauksessa

- Historiallinen konteksti suurista kielimalleista (LLM) ja siitä, miksi tämä tekniikka sopii täydellisesti tähän käyttötapaukseen

- AWS GAIIC:n PoC ja AWS ProServe MLDT:n ratkaisu datatieteen ja koneoppimisen (ML) näkökulmasta

Datan haaste

Suurin haaste, jonka AWS ProServe kohtasi myrkyllisen kielen luokittelijan koulutuksessa, oli saada asiakkaalta tarpeeksi merkittyjä tietoja, jotta tarkka malli voidaan opettaa tyhjästä. AWS sai noin 100 näytettä merkittyä dataa asiakkaalta, mikä on paljon vähemmän kuin 1,000 XNUMX näytettä, jota suositellaan LLM:n hienosäätöön datatiedeyhteisössä.

Luontaisena lisähaasteena luonnollisen kielen käsittelyn (NLP) luokittimien on historian tiedetty olevan erittäin kalliita kouluttaa ja vaativat suuren joukon sanastoa, joka tunnetaan nimellä corpus, tuottaa tarkkoja ennusteita. Tiukka ja tehokas NLP-ratkaisu, jos tarjotaan riittävä määrä merkittyä dataa, olisi kouluttaa mukautettu kielimalli käyttämällä asiakkaan merkittyjä tietoja. Mallia opetettaisiin pelkästään pelaajien pelisanastolla, jolloin se räätälöidään peleissä havaittuun kieleen. Asiakkaalla oli sekä kustannus- että aikarajoitteita, jotka tekivät tästä ratkaisusta kannattamattoman. AWS ProServe joutui löytämään ratkaisun tarkan kielen myrkyllisyysluokittajan kouluttamiseen suhteellisen pienellä merkityllä tietojoukolla. Ratkaisu löytyi ns siirrä oppimista.

Siirto-oppimisen ideana on käyttää valmiiksi koulutetun mallin tietoa ja soveltaa sitä erilaiseen, mutta suhteellisen samanlaiseen ongelmaan. Jos esimerkiksi kuvan luokittelija on koulutettu ennustamaan, sisältääkö kuva kissan, voit käyttää mallin koulutuksen aikana hankkimaa tietoa muiden eläinten, kuten tiikerien, tunnistamiseen. Tätä kielenkäyttötapausta varten AWS ProServen oli löydettävä aiemmin koulutettu kielten luokitin, joka oli koulutettu tunnistamaan myrkyllinen kieli ja hienosäätämään sitä asiakkaan merkittyjen tietojen avulla.

Ratkaisu oli löytää ja hienosäätää LLM myrkyllisen kielen luokittelua varten. LLM:t ovat hermoverkkoja, joita on koulutettu käyttämällä valtavaa määrää parametreja, tyypillisesti miljardeja, käyttämällä merkitsemätöntä dataa. Ennen kuin siirryt AWS-ratkaisuun, seuraavassa osiossa on yleiskatsaus LLM:ien historiaan ja niiden historiallisiin käyttötapauksiin.

Hyödynnä LLM:ien voimaa

LLM:t ovat äskettäin tulleet keskipisteeksi yrityksille, jotka etsivät uusia ML-sovelluksia, siitä lähtien, kun ChatGPT valloitti julkisen mielen jakamisen olemalla historian nopeimmin kasvava kuluttajasovellus.2, saavuttaa 100 miljoonaa aktiivista käyttäjää tammikuussa 2023, vain 2 kuukautta sen julkaisun jälkeen. LLM:t eivät kuitenkaan ole uusi teknologia ML-avaruudessa. Niitä on käytetty laajasti NLP-tehtävien suorittamiseen, kuten tunteiden analysointiin, tiivistelmien tekemiseen, avainsanojen poimimiseen, puheen kääntämiseen ja tekstin luokitteluun.

Tekstin peräkkäisyyden vuoksi toistuvat neuroverkot (RNN:t) olivat olleet NLP-mallinnuksen huippua. Tarkemmin sanottuna kooderi-dekooderi verkkoarkkitehtuuri muotoiltiin, koska se loi RNN-rakenteen, joka pystyy ottamaan mielivaltaisen pituisen syötteen ja generoimaan mielivaltaisen pituisen lähdön. Tämä oli ihanteellinen NLP-tehtäviin, kuten kääntämiseen, jossa yhden kielen tuloslause voitiin ennustaa toisen kielen syöttölauseesta, tyypillisesti eri sanamäärällä syötteen ja tulosteen välillä. Transformer-arkkitehtuuri3 (Vaswani, 2017) oli läpimurto parannus enkooderi-dekooderiin; se esitteli käsitteen itse huomiota, jonka ansiosta malli pystyi keskittämään huomionsa eri sanoihin syöttö- ja lähtölauseissa. Tyypillisessä kooderi-dekooderissa malli tulkitsee jokaisen sanan samalla tavalla. Koska malli prosessoi peräkkäin syöttölauseen jokaisen sanan, alussa oleva semanttinen tieto saattaa kadota lauseen loppuun mennessä. Itsehuomiomekanismi muutti tämän lisäämällä huomiokerroksen sekä enkooderi- että dekooderilohkoon, jotta malli saattoi asettaa eri painotuksia syöttölauseesta tietyille sanoille generoidessaan tiettyä sanaa tuloslausekkeessa. Näin syntyi muuntajamallin perusta.

Muuntaja-arkkitehtuuri oli perusta kahdelle tunnetuimmasta ja suosituimmasta LLM:stä, joita käytetään nykyään, Transformersin bidirectional Encoder Representations (BERT) -muodossa.4 (Radford, 2018) ja Generative Pretraained Transformer (GPT)5 (Devlin 2018). GPT-mallin myöhemmät versiot, nimittäin GPT3 ja GPT4, ovat moottori, joka käyttää ChatGPT-sovellusta. Viimeinen osa reseptiä, joka tekee LLM:istä niin tehokkaita, on kyky tislata tietoa laajoista tekstikappaleista ilman laajaa etiketöintiä tai esikäsittelyä ULMFit-nimisen prosessin avulla. Tässä menetelmässä on esikoulutusvaihe, jossa voidaan kerätä yleistä tekstiä ja mallia koulutetaan tehtävään ennustaa seuraava sana aiempien sanojen perusteella; etuna tässä on se, että kaikki koulutukseen käytettävä teksti tulee luonnostaan esimerkittynä tekstin järjestyksen perusteella. LLM:t pystyvät todella oppimaan Internetin mittakaavan datasta. Esimerkiksi alkuperäinen BERT-malli oli esikoulutettu BookCorpuksessa ja kokonaisissa englanninkielisissä Wikipedian tekstiaineistoissa.

Tämä uusi mallinnusparadigma on synnyttänyt kaksi uutta käsitettä: perusmallit (FM) ja generatiivinen tekoäly. Toisin kuin mallin opettaminen tyhjästä tehtäväkohtaisilla tiedoilla, mikä on tavanomainen tapaus klassisessa ohjatussa oppimisessa, LLM:t on esikoulutettu poimimaan yleistietoa laajasta tekstitietojoukosta ennen kuin niitä mukautetaan tiettyihin tehtäviin tai alueisiin, joilla on paljon pienempi. tietojoukko (tyypillisesti satojen näytteiden luokkaa). Uusi ML-työnkulku alkaa nyt esikoulutetulla mallilla, jota kutsutaan perusmalliksi. On tärkeää rakentaa oikealle perustalle, ja vaihtoehtoja, kuten uusia, on yhä enemmän Amazon Titan FM:t, jonka AWS julkaisee osana Amazonin kallioperä. Näitä uusia malleja pidetään myös generatiivisina, koska niiden tuotokset ovat ihmisen tulkittavissa ja samassa tietotyypissä kuin syöttödata. Vaikka aiemmat ML-mallit olivat kuvailevia, kuten kissojen ja koirien kuvien luokittelu, LLM:t ovat generatiivisia, koska niiden tulos on seuraava syöttösanoihin perustuva sanajoukko. Sen avulla he voivat käyttää interaktiivisia sovelluksia, kuten ChatGPT:tä, jotka voivat olla ilmeikkäitä luomassaan sisällössä.

Hugging Face on tehnyt yhteistyötä AWS:n kanssa demokratisoida FM-lähetyksiä ja tehdä niistä helppo pääsy ja niiden avulla rakentaa. Hugging Face on luonut a Transformers API joka yhdistää yli 50 erilaista muuntaja-arkkitehtuuria erilaisissa ML-kehyksissä, mukaan lukien pääsy valmiiksi koulutettuihin mallipainoihin. Malli Hub, joka on kasvanut yli 200,000 XNUMX malliksi tämän viestin kirjoittamisen jälkeen. Seuraavissa osioissa perehdymme konseptin todisteeseen, ratkaisuun sekä testatuihin ja pohjaksi valittuihin FM:ihin tämän myrkyllisen puheluokituksen käyttötapauksen ratkaisemiseksi asiakkaalle.

AWS GAIIC todiste konseptista

AWS GAIIC päätti kokeilla LLM-perustusmalleja BERT-arkkitehtuurilla hienosäätääkseen myrkyllistä kielen luokittelijaa. Hugging Facen mallikeskuksesta testattiin yhteensä kolme mallia:

Kaikki kolme malliarkkitehtuuria perustuvat BERTweet arkkitehtuuri. BERTweet on koulutettu perustuen Roberta koulutusta edeltävä menettely. RoBERTa-esikoulutusmenettely on tulos BERT-esikoulutuksen replikaatiotutkimuksesta, jossa arvioitiin hyperparametrien virityksen ja harjoitussarjan koon vaikutukset BERT-mallien koulutusreseptin parantamiseksi.6 (Liu 2019). Kokeessa pyrittiin löytämään esikoulutusmenetelmä, joka paransi BERT:n suorituskykyä muuttamatta taustalla olevaa arkkitehtuuria. Tutkimuksen päätelmissä todettiin, että seuraavat koulutusta edeltävät muutokset paransivat merkittävästi BERT:n suorituskykyä:

- Mallin kouluttaminen suuremmilla erillä enemmän dataa varten

- Poistetaan seuraavan lauseen ennakointiobjekti

- Harjoittelu pidemmillä sarjoilla

- Muuttaa dynaamisesti harjoitustietoihin sovellettavaa peittokuviota

Bertweet-perusmalli käyttää edellistä RoBERTa-tutkimuksen esikoulutusmenettelyä alkuperäisen BERT-arkkitehtuurin esiopettamiseen käyttämällä 850 miljoonaa englanninkielistä twiittiä. Se on ensimmäinen julkinen laajamittainen kielimalli, joka on esikoulutettu englanninkielisiä twiittejä varten.

Tweettejä käyttävien valmiiksi koulutettujen FM-laitteiden uskottiin sopivan käyttötapaukseen kahdesta pääasiallisesta teoreettisesta syystä:

- Tweetin pituus on hyvin samanlainen kuin nettipelikeskusteluista löytyvän sopimattoman tai myrkyllisen lauseen pituus

- Tweetit tulevat väestöstä, jolla on suuri määrä erilaisia käyttäjiä, samanlainen kuin pelialustojen väestö

AWS päätti ensin hienosäätää BERTweetin asiakkaan merkityillä tiedoilla saadakseen lähtötilanteen. Sitten päätti hienosäätää kahta muuta FM-ääntä bertweet-base-offensive- ja bert-weet-base-hate-sovelluksissa, jotka oli edelleen esikoulutettu erityisesti merkityksellisemmille myrkyllisille twiiteille, jotta saavutettaisiin mahdollisesti suurempi tarkkuus. Bertweet-base-hyökkäysmalli käyttää perus BertTweet FM:ää ja on edelleen esikoulutettu 14,100 XNUMX huomautuksilla varustetulle twiitille, joita pidettiin loukkaavina.7 (Zampieri 2019). Bertweet-base-hate -malli käyttää myös BertTweet FM -perusmallia, mutta se on edelleen esikoulutettu 19,600 XNUMX vihapuheena pidetyssä twiitissä.8 (Basilia 2019).

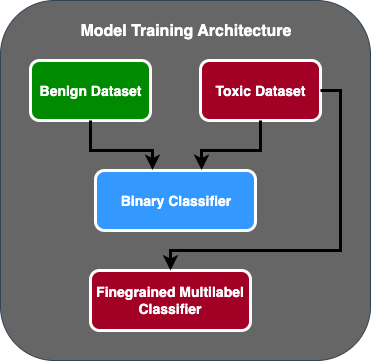

Parantaakseen edelleen PoC-mallin suorituskykyä AWS GAIIC teki kaksi suunnittelupäätöstä:

- Luotiin kaksivaiheinen ennustevirta, jossa ensimmäinen malli toimii binääriluokittajana, joka luokittelee, onko teksti myrkyllinen vai myrkytön. Toinen malli on hienorakeinen malli, joka luokittelee tekstin asiakkaan määrittämien myrkyllisten tyyppien perusteella. Vain jos ensimmäinen malli ennustaa tekstin myrkyllisenä, se siirtyy toiseen malliin.

- Laajensi harjoitustietoja ja lisäsi osajoukon kolmannen osapuolen leimaamaa myrkyllistä tekstiä julkisesta Kaggle-kilpailusta (Jigsaw Myrkyllisyys) asiakkaalta saatuihin alkuperäisiin 100 näytteeseen. He kartoittivat Jigsaw-tarrat niihin liittyviin asiakkaan määrittämiin myrkyllisyystarroihin ja tekivät 80 %:n jaon harjoitustietona ja 20 %:n jaon testitiedona mallin validoimiseksi.

AWS GAIIC käytetty Amazon Sage Maker muistikirjat suorittamaan hienosäätökokeilunsa ja havaitsivat, että bertweet-base-hyökkäysmalli saavutti validointijoukon parhaat pisteet. Seuraavassa taulukossa on yhteenveto havaituista mittauspisteistä.

| Malli | Tarkkuus | Palauttaa mieleen | F1 | AUC |

| Binaarinen | .92 | .90 | .91 | .92 |

| Hienojakoinen | .81 | .80 | .81 | .89 |

Tästä hetkestä lähtien GAIIC luovutti PoC:n AWS ProServe ML Delivery Teamille PoC:n tuotantoa varten.

AWS ProServe ML Delivery Team -ratkaisu

Malliarkkitehtuurin tuotantoa varten asiakas pyysi AWS ProServe ML Delivery Teamiä (MLDT) luomaan ratkaisun, joka on skaalautuva ja helppo ylläpitää. Kaksivaiheisessa mallissa oli muutamia ylläpitohaasteita:

- Mallit vaatisivat kaksinkertaisen määrän malliseurantaa, mikä tekee uudelleenkoulutuksen ajoituksesta epäjohdonmukaista. Joskus yksi malli on ehkä koulutettava uudelleen useammin kuin toinen.

- Kahden mallin käyttökustannukset kasvavat yhden sijaan.

- Päättelyn nopeus hidastuu, koska päättely kulkee kahden mallin läpi.

Vastatakseen näihin haasteisiin AWS ProServe MLDT:n täytyi keksiä, kuinka kaksivaiheinen malliarkkitehtuuri muutetaan yhden mallin arkkitehtuuriksi, samalla kun pystyttiin säilyttämään kaksivaiheisen arkkitehtuurin tarkkuus.

Ratkaisu oli kysyä ensin asiakkaalta lisää harjoitustietoja ja sitten hienosäätää bertweet-base-offensive -malli kaikissa tarroissa, mukaan lukien myrkyttömät näytteet, yhdeksi malliksi. Ajatuksena oli, että yhden mallin hienosäätäminen, jossa on enemmän dataa, johtaisi samanlaisiin tuloksiin kuin kaksivaiheisen malliarkkitehtuurin hienosäätö pienemmällä datamäärällä. Kaksivaiheisen malliarkkitehtuurin hienosäätämiseksi AWS ProServe MLDT päivitti esikoulutetun mallin usean etiketin luokituspään sisältämään yhden ylimääräisen solmun, joka edustaa myrkytöntä luokkaa.

Seuraavassa on esimerkkikoodi siitä, kuinka voit hienosäätää esikoulutetun mallin Hugging Face -mallikeskittimestä käyttämällä muuntajaalustaa ja muuttamalla mallin usean etiketin luokituspäätä ennustamaan halutun luokkamäärän. AWS ProServe MLDT käytti tätä suunnitelmaa perustana hienosäädölle. Se olettaa, että junatiedot ja validointitiedot ovat valmiina ja oikeassa syöttömuodossa.

Ensin tuodaan Python-moduulit sekä haluttu esikoulutettu malli Hugging Face -mallikeskuksesta:

Tämän jälkeen esikoulutettu malli ladataan ja valmistetaan hienosäätöä varten. Tämä on vaihe, jossa määritetään myrkyllisten luokkien lukumäärä ja kaikki malliparametrit:

Mallin hienosäätö alkaa syöttämällä polkuja koulutus- ja validointitietosarjoihin:

AWS ProServe MLDT vastaanotti vielä noin 5,000 3,000 merkittyä datanäytettä, joista 2,000 5,000 oli myrkytöntä ja 80 20 myrkyllistä, ja hienosääti kaikki kolme bertweet-pohjaista mallia yhdistämällä kaikki tarrat yhdeksi malliksi. He käyttivät näitä tietoja PoC:n XNUMX XNUMX näytteen lisäksi uusien yksivaiheisten mallien hienosäätämiseen käyttämällä samaa XNUMX % junasarjaa, XNUMX % testisarjaa. Seuraava taulukko osoittaa, että suorituskykypisteet olivat verrattavissa kaksivaiheisen mallin arvoihin.

| Malli | Tarkkuus | Palauttaa mieleen | F1 | AUC |

| bertweet-base (1-vaihe) | .76 | .72 | .74 | .83 |

| bertweet-base-hate (1-vaihe) | .85 | .82 | .84 | .87 |

| bertweet-base-hyökkäys (1-vaihe) | .88 | .83 | .86 | .89 |

| bertweet-base-hyökkäys (2-vaihe) | .91 | .90 | .90 | .92 |

Yksivaiheisen mallin lähestymistapa paransi kustannuksia ja ylläpitoa, mutta alensi tarkkuutta vain 3 %. Punnitusten jälkeen asiakas valitsi AWS ProServe MLDT:n tuotantoon yksivaiheisen mallin.

Hienosäätämällä yhtä mallia, jossa on enemmän merkittyjä tietoja, AWS ProServe MLDT pystyi toimittamaan ratkaisun, joka täytti asiakkaan mallin tarkkuuden kynnyksen, sekä toimittamaan heidän pyynnöstään helpon huollon, alentaen samalla kustannuksia ja lisäämällä kestävyyttä.

Yhteenveto

Suuri peliasiakas etsi tapaa havaita myrkyllistä kieltä viestintäkanavissaan edistääkseen sosiaalisesti vastuullista peliympäristöä. AWS GAIIC loi myrkyllisen kielenilmaisimen PoC:n hienosäätämällä LLM:ää myrkyllisen kielen havaitsemiseksi. AWS ProServe MLDT päivitti sitten mallin koulutusvirran kaksivaiheisesta yksivaiheiseen lähestymistapaan ja tuotti LLM:n asiakkaalle käytettäväksi mittakaavassa.

Tässä viestissä AWS osoittaa LLM:n hienosäädön tehokkuuden ja käytännöllisyyden tämän asiakkaan käyttötapauksen ratkaisemiseksi, jakaa kontekstin perustusmallien ja LLM:ien historiaan ja esittelee AWS Generative AI Innovation Centerin ja AWS ProServe ML:n välisen työnkulun. Toimitustiimi. Tämän sarjan seuraavassa postauksessa sukeltamme syvemmälle siihen, kuinka AWS ProServe MLDT tuotti tuloksena olevan yksivaiheisen mallin SageMakerin avulla.

Jos olet kiinnostunut työskentelemään AWS:n kanssa luodaksesi generatiivisen tekoälyratkaisun, ota yhteyttä GAIIC. He arvioivat käyttötapauksesi, rakentavat generatiiviseen tekoälyyn perustuvan konseptin todisteen ja heillä on vaihtoehtoja laajentaa yhteistyötä AWS:n kanssa, jotta tuloksena oleva PoC voidaan ottaa käyttöön tuotantoon.

Viitteet

- Pelaajien demografiset tiedot: Faktoja ja tilastoja maailman suosituimmasta harrastuksesta

- ChatGPT teki nopeimmin kasvavan käyttäjäkunnan ennätyksen – analyytikkohuomautus

- Vaswani et al., "Huomio on kaikki mitä tarvitset"

- Radford et al., "Kielen ymmärtämisen parantaminen generatiivisen esikoulutuksen avulla"

- Devlin et al., "BERT: Pre-Training of Deep Bidirectional Transformers for Language Understanding"

- Yinhan Liu et al., "RoBERTa: A Robustly Optimized BERT Pretraining Approach"

- Marcos Zampieri ym., "SemEval-2019 Tehtävä 6: Loukkaavan kielen tunnistaminen ja luokittelu sosiaalisessa mediassa (OffensEval)"

- Valerio Basile et al., "SemEval-2019 Task 5: Monikielinen havaitseminen vihapuheesta maahanmuuttajia ja naisia vastaan Twitterissä"

Tietoja kirjoittajista

James Poquiz on AWS Professional Services -tutkija Orange Countyssa, Kaliforniassa. Hän on suorittanut tietojenkäsittelytieteen BS-tutkinnon Kalifornian yliopistosta Irvinestä, ja hänellä on useiden vuosien kokemus työskentelystä data-alalla useissa eri tehtävissä. Nykyään hän työskentelee skaalautuvien ML-ratkaisujen toteuttamisessa ja käyttöönotossa saavuttaakseen liiketoimintatuloksia AWS-asiakkaille.

James Poquiz on AWS Professional Services -tutkija Orange Countyssa, Kaliforniassa. Hän on suorittanut tietojenkäsittelytieteen BS-tutkinnon Kalifornian yliopistosta Irvinestä, ja hänellä on useiden vuosien kokemus työskentelystä data-alalla useissa eri tehtävissä. Nykyään hän työskentelee skaalautuvien ML-ratkaisujen toteuttamisessa ja käyttöönotossa saavuttaakseen liiketoimintatuloksia AWS-asiakkaille.

Han mies on Senior Data Science & Machine Learning Manager AWS Professional Services -palvelussa San Diegossa, Kaliforniassa. Hän on koulutukseltaan tekniikan tohtori Northwestern Universitystä ja hänellä on usean vuoden kokemus liikkeenjohdon konsulttina, joka neuvoo asiakkaita valmistuksessa, rahoituspalveluissa ja energia-alalla. Nykyään hän työskentelee intohimoisesti useiden eri toimialojen avainasiakkaiden kanssa kehittääkseen ja ottaakseen käyttöön ML- ja GenAI-ratkaisuja AWS:ssä.

Han mies on Senior Data Science & Machine Learning Manager AWS Professional Services -palvelussa San Diegossa, Kaliforniassa. Hän on koulutukseltaan tekniikan tohtori Northwestern Universitystä ja hänellä on usean vuoden kokemus liikkeenjohdon konsulttina, joka neuvoo asiakkaita valmistuksessa, rahoituspalveluissa ja energia-alalla. Nykyään hän työskentelee intohimoisesti useiden eri toimialojen avainasiakkaiden kanssa kehittääkseen ja ottaakseen käyttöön ML- ja GenAI-ratkaisuja AWS:ssä.

Safa Tinaztepe on täyden pinon datatieteilijä, jolla on AWS Professional Services. Hän on suorittanut tietojenkäsittelytieteen BS-tutkinnon Emory Universitystä ja hän on kiinnostunut MLOpsista, hajautetuista järjestelmistä ja web3:sta.

Safa Tinaztepe on täyden pinon datatieteilijä, jolla on AWS Professional Services. Hän on suorittanut tietojenkäsittelytieteen BS-tutkinnon Emory Universitystä ja hän on kiinnostunut MLOpsista, hajautetuista järjestelmistä ja web3:sta.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. Autot / sähköautot, hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- BlockOffsets. Ympäristövastuun omistuksen nykyaikaistaminen. Pääsy tästä.

- Lähde: https://aws.amazon.com/blogs/machine-learning/aws-performs-fine-tuning-on-a-large-language-model-llm-to-classify-toxic-speech-for-a-large-gaming-company/

- :on

- :On

- :ei

- :missä

- 000

- 1

- 100

- 14

- 16

- 19

- 200

- 2017

- 2018

- 2019

- 2023

- 50

- 7

- a

- kyky

- pystyy

- Meistä

- pääsy

- tarkkuus

- tarkka

- Saavuttaa

- saavutettu

- aktiivinen

- säädökset

- lisä-

- lisää

- Lisäksi

- osoite

- neuvoo

- Jälkeen

- vastaan

- AI

- AL

- Kaikki

- sallittu

- mahdollistaa

- Myös

- Amazon

- Amazon Web Services

- määrä

- määrät

- an

- analyytikko

- analysointi

- ja

- eläimet

- Toinen

- Kaikki

- Hakemus

- sovellukset

- sovellettu

- käyttää

- lähestymistapa

- asianmukaisesti

- suunnilleen

- arkkitehtuuri

- OVAT

- perustelut

- Art

- AS

- arvioida

- liittyvä

- olettaa

- At

- huomio

- automatisointi

- AWS

- AWS-asiantuntijapalvelut

- pohja

- perustua

- Lähtötilanne

- perusta

- BE

- koska

- tulevat

- ollut

- ennen

- Alku

- takana

- ovat

- alle

- hyödyttää

- PARAS

- välillä

- suurempi

- Miljardi

- miljardeja

- Tukkia

- syntynyt

- sekä

- läpimurto

- laaja

- rakentaa

- rakentaa

- liiketoiminta

- yritykset

- mutta

- by

- CA

- Kalifornia

- nimeltään

- CAN

- kykenee

- kiinni

- tapaus

- tapauksissa

- KISSA

- luokat

- luokittelu

- Kategoria

- Kissat

- keskus

- tietty

- haaste

- haasteet

- muuttunut

- muuttuviin

- kanavat

- ChatGPT

- valitsi

- valittu

- luokka

- luokat

- luokittelu

- luokitella

- asiakkaat

- koodi

- yhteistyö

- yhdistely

- Tulla

- tulee

- tiedottaa

- Viestintä

- yhteisö

- yritys

- vertailukelpoinen

- kilpailu

- tietokone

- Tietojenkäsittelyoppi

- käsite

- käsitteet

- johtopäätös

- harkittu

- muodostuu

- rajoitteet

- konsultti

- kuluttaja

- sisältää

- pitoisuus

- tausta

- korjata

- Hinta

- kallis

- kustannukset

- voisi

- lääni

- Covers

- luoda

- luotu

- asiakassuhde

- asiakas

- Asiakkaat

- tiedot

- tietojenkäsittely

- tietojen tutkija

- aineistot

- päivä

- päätti

- päätökset

- katsotaan

- syvä

- syväsukellus

- syvempää

- määritellä

- määritelty

- toimittaa

- toimitettu

- toimitus

- kaivaa

- demokratisoida

- Väestötiedot

- osoittaa

- levityspinnalta

- käyttöönotto

- Malli

- haluttu

- havaita

- Detection

- Määrittää

- kehittää

- Kehitys

- DID

- Diego

- eri

- erilaiset

- jaettu

- hajautetut järjestelmät

- ei

- verkkotunnuksen

- verkkotunnuksia

- kaksinkertainen

- dubattuna

- aikana

- E&T

- kukin

- helpottaa

- helppo

- Tehokas

- tehokkuuden

- vaikutukset

- vaivaa

- loppu

- energia

- Moottori

- Tekniikka

- Englanti

- parantaa

- tarpeeksi

- enter

- Koko

- ympäristö

- aikakausi

- arvioidaan

- arvioitu

- EVER

- Joka

- esimerkki

- olemassa

- experience

- kokeilu

- kokeiluja

- asiantuntijat

- Selittää

- selitetään

- tutkia

- ilmeikäs

- laajentaa

- laaja

- laajasti

- lisää

- uute

- Kasvot

- kohtasi

- tosiasiat

- Muoti

- nopein

- nopeimmin kasvava

- harvat

- Kuva

- lopullinen

- taloudellinen

- rahoituspalvelut

- Löytää

- Etunimi

- sovittaa

- virtaus

- Keskittää

- jälkeen

- varten

- muoto

- löytyi

- perusta

- puitteet

- alkaen

- edelleen

- saadut

- peli

- Pelit

- pelaamista

- Peliteollisuus

- kokosi

- general

- tuottaa

- tuottaa

- generatiivinen

- Generatiivinen AI

- saada

- tietty

- Goes

- menee

- Ryhmä

- Kasvava

- täysikasvuinen

- HAD

- Olla

- ottaa

- he

- pää

- terveellisempiä

- tätä

- korkeampi

- historiallinen

- historiallisesti

- historia

- Miten

- Miten

- Kuitenkin

- HTTPS

- Napa

- ihmisen

- Sadat

- Hyperparametrien viritys

- ajatus

- ihanteellinen

- identtinen

- tunnistaminen

- if

- kuva

- kuvien

- Maahanmuuttajat

- toteuttaa

- täytäntöönpanosta

- tuoda

- tärkeä

- tuonti

- parantaa

- parani

- parannus

- parannuksia

- in

- sisältää

- Mukaan lukien

- lisää

- teollisuus

- tiedot

- luontainen

- luonnostaan

- Innovaatio

- panos

- Integrointi

- vuorovaikutuksessa

- vuorovaikutukset

- vuorovaikutteinen

- kiinnostunut

- etu

- tulee

- käyttöön

- Esittelee

- IT

- SEN

- tammikuu

- palapeli

- yhteinen

- vain

- avain

- avainsanat

- tuntemus

- tunnettu

- merkinnät

- tarrat

- Kieli

- suuri

- laaja

- myöhemmin

- asettaa

- kerros

- oppiminen

- Pituus

- vähemmän

- pitää

- OTK

- kuormitus

- kauemmin

- näköinen

- menetetty

- Erä

- Alentaminen

- kone

- koneoppiminen

- tehty

- tärkein

- ylläpitää

- huolto

- tehdä

- TEE

- Tekeminen

- mies

- johto

- johtaja

- manuaalinen

- valmistus

- monet

- massiivinen

- Saattaa..

- mekanismi

- Media

- tapasi

- menetelmä

- Metodologia

- metrinen

- miljoona

- ML

- MLOps

- malli

- mallintaminen

- mallit

- Muutokset

- Moduulit

- seuranta

- kk

- lisää

- eniten

- Suosituin

- paljon

- nimittäin

- Luonnollinen

- Luonnollinen kielen käsittely

- luonto

- tarvitaan

- verkko

- verkot

- hermoverkkoihin

- Uusi

- seuraava

- NLP

- solmu

- nyt

- numero

- numerot

- saada

- of

- pois

- hyökkäys

- usein

- on

- ONE

- verkossa

- online-pelaamista

- vain

- Operations

- vastakkainen

- optimoitu

- Vaihtoehdot

- or

- Oranssi

- tilata

- alkuperäinen

- Muut

- ulos

- Tulos

- tuloksiin

- ulostulo

- yli

- yleinen

- yleiskatsaus

- oma

- paria

- paradigma

- parametri

- parametrit

- osa

- kumppanuuteen

- Hyväksytty

- Ohi

- Kuvio

- täydellinen

- Suorittaa

- suorituskyky

- suorittaa

- vaihe

- phd

- lausekkeet

- kappale

- foorumi

- Platon

- Platonin tietotieto

- PlatonData

- pelataan

- soitin

- pelaajat

- Ole hyvä

- PoC

- Kohta

- Suosittu

- väestö

- Kirje

- Viestejä

- mahdollisesti

- teho

- voimakas

- valtuudet

- Tarkkuus

- ennustaa

- ennusti

- ennustamiseen

- ennustus

- Ennusteet

- ennustaa

- edellinen

- aiemmin

- Ongelma

- menettelyt

- prosessi

- Prosessit

- käsittely

- tuottaa

- tuotanto

- HYVYYS

- ammatillinen

- edistää

- Edistäminen

- todiste

- todiste käsitteestä

- mikäli

- tarjoaa

- julkinen

- laittaa

- Python

- laatu

- alue

- tavoittaa

- päästäisiin

- valmis

- todellinen

- todellinen maailma

- syistä

- sai

- äskettäin

- resepti

- tunnistaa

- suositeltu

- ennätys

- suhteellisesti

- vapauta

- julkaistu

- merkityksellinen

- replikointi

- edustaa

- edellyttää

- vastuullinen

- Vastuullinen pelaaminen

- johtua

- Saatu ja

- tulokset

- Reuters

- oikein

- tiukka

- Nousta

- kestävyys

- roolit

- ajaa

- juoksu

- sagemaker

- sama

- San

- San Diego

- skaalautuva

- Asteikko

- skaalaus

- tiede

- tieteellinen

- Tiedemies

- raapia

- Toinen

- Osa

- osiot

- vanhempi

- tuomita

- näkemys

- erillinen

- Järjestys

- Sarjat

- palvelee

- Palvelut

- setti

- Setit

- useat

- osakkeet

- malliesimerkki

- Näytä

- samankaltainen

- koska

- single

- Koko

- hidastuu

- pieni

- pienempiä

- So

- sosiaalinen

- sosiaalinen media

- sosiaalisesti

- Yksin

- ratkaisu

- Ratkaisumme

- SOLVE

- Solving

- jonkin verran

- pyrittiin

- Tila

- erityinen

- erityisesti

- puhe

- nopeus

- jakaa

- alkaa

- Osavaltio

- tilastot

- Vaihe

- Yhä

- rakenne

- tutkimus

- merkittävästi

- niin

- riittävä

- järjestelmät

- taulukko

- Räätälöity

- vie

- ottaen

- Tehtävä

- tehtävät

- joukkue-

- Elektroniikka

- testi

- testattu

- kuin

- että

- -

- Valtion

- heidän

- Niitä

- sitten

- teoreettinen

- Siellä.

- Nämä

- ne

- tätä

- ajatus

- kolmella

- kynnys

- Kautta

- Näin

- aika

- kertaa

- ajoitus

- Titaani

- että

- tänään

- Aiheet

- Yhteensä

- Juna

- koulutettu

- koulutus

- siirtää

- muuntaja

- muuntajat

- Kääntäminen

- todella

- VUORO

- piipittää

- tweets

- kaksi

- tyyppi

- tyypit

- tyypillinen

- tyypillisesti

- Lopulta

- taustalla oleva

- ymmärtäminen

- valitettavasti

- yliopisto

- University of California

- päivitetty

- käyttää

- käyttölaukku

- käytetty

- käyttäjä

- Käyttäjäkokemus

- Käyttäjät

- käyttötarkoituksiin

- käyttämällä

- VAHVISTA

- validointi

- lajike

- valtava

- versiot

- pystysuunnassa

- hyvin

- kautta

- Video

- videopelit

- käytännössä

- Ääni

- vs

- haluta

- halusi

- oli

- Tapa..

- we

- verkko

- verkkopalvelut

- Web3

- punnitus

- HYVIN

- tunnettu

- olivat

- kun

- onko

- joka

- vaikka

- miksi

- leveä

- Laaja valikoima

- wikipedia

- tulee

- with

- sisällä

- ilman

- Naiset

- sana

- sanoja

- työnkulku

- työskentely

- toimii

- maailman-

- olisi

- kirjoittaminen

- vuotta

- Voit

- Sinun

- zephyrnet