Tietokonenäkö (CV) on yksi yleisimmistä koneoppimisen (ML) ja syväoppimisen sovelluksista. Käyttötapaukset vaihtelevat itse ajavista autoista, sisällön moderointiin sosiaalisen median alustoilla, syövän havaitsemiseen ja automaattiseen vikojen havaitsemiseen. Amazonin tunnistus on täysin hallittu palvelu, joka pystyy suorittamaan CV-tehtäviä, kuten objektien havaitsemisen, videosegmenttien havaitsemisen, sisällön moderoinnin ja paljon muuta, jotta saadaan tietoa tiedoista ilman aikaisempaa ML-kokemusta. Joissakin tapauksissa voidaan tarvita räätälöityä ratkaisua palvelun ohella tietyn ongelman ratkaisemiseksi.

Tässä postauksessa käsittelemme alueita, joissa CV:tä voidaan soveltaa tapauksiin, joissa esineiden asento, niiden sijainti ja suunta ovat tärkeitä. Yksi tällainen käyttötapa olisi asiakkaille suunnatut mobiilisovellukset, joissa vaaditaan kuvan lataus. Se voi johtua vaatimustenmukaisuudesta tai johdonmukaisen käyttökokemuksen tarjoamisesta ja sitoutumisen parantamisesta. Esimerkiksi verkkokaupan alustoilla tuotteiden esityskulmalla on vaikutusta tämän tuotteen ostoasteeseen. Yksi tällainen tapaus on auton sijainnin havaitseminen. Näytämme, kuinka voit yhdistää tunnettuja ML-ratkaisuja jälkikäsittelyyn ratkaistaksesi tämän ongelman AWS-pilvessä.

Käytämme syväoppimismalleja tämän ongelman ratkaisemiseksi. ML-algoritmien harjoitteleminen asennon estimointia varten vaatii paljon asiantuntemusta ja mukautettuja harjoitustietoja. Molemmat vaatimukset ovat vaikeita ja kalliita saavuttaa. Siksi esittelemme kaksi vaihtoehtoa: toisen, joka ei vaadi ML-asiantuntemusta ja käyttää Amazon Rekognitionia, ja toisen, joka käyttää Amazon Sage Maker kouluttaa ja ottaa käyttöön mukautetun ML-mallin. Ensimmäisessä vaihtoehdossa käytämme Amazon Rekognition -sovellusta auton renkaiden tunnistamiseen. Päättelemme sitten auton suunnan pyörien asennoista käyttämällä sääntöpohjaista järjestelmää. Toisessa vaihtoehdossa tunnistamme pyörät ja muut auton osat käyttämällä Detectron malli. Näitä käytetään jälleen päättämään auton sijainti sääntöpohjaisella koodilla. Toinen vaihtoehto vaatii ML-kokemusta, mutta on myös muokattavampi. Sitä voidaan käyttää kuvan jatkokäsittelyyn, esimerkiksi koko auton rajaamiseen. Molempia vaihtoehtoja voidaan harjoitella julkisesti saatavilla olevilla tietojoukoilla. Lopuksi näytämme, kuinka voit integroida tämän auton asennontunnistusratkaisun olemassa olevaan verkkosovellukseesi käyttämällä palveluita, kuten Amazon API -yhdyskäytävä ja AWS vahvistaa.

Ratkaisun yleiskatsaus

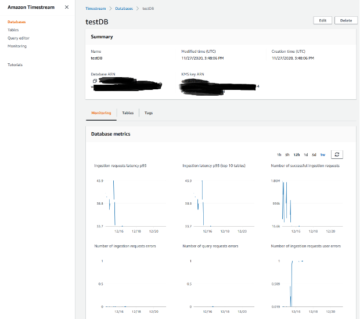

Seuraava kaavio kuvaa ratkaisuarkkitehtuuria.

Ratkaisu koostuu Amplifyssa toimivasta verkkosovelluksesta, johon käyttäjä voi ladata kuvan ja hakea joko Amazon Rekognition -mallia tai mukautettua Detectron-mallia auton sijainnin tunnistamiseksi. Jokaiselle vaihtoehdolle isännöimme AWS Lambda toiminto API-yhdyskäytävän takana, joka on alttiina valesovelluksellemme. Määritimme Lambda-toimintomme toimimaan joko SageMakerissa tai Amazon Rekognitionissa koulutetun Detectron-mallin kanssa.

Edellytykset

Tätä kävelyä varten sinulla tulisi olla seuraavat edellytykset:

Luo palvelimeton sovellus Amazon Rekognitionin avulla

Ensimmäinen vaihtoehtomme osoittaa, kuinka voit havaita auton suunnan kuvista Amazon Rekognitionin avulla. Ajatuksena on käyttää Amazon Rekognitionia auton ja sen pyörien sijainnin tunnistamiseen ja suorittaa sitten jälkikäsittelyä auton suunnan johtamiseksi näistä tiedoista. Koko ratkaisu otetaan käyttöön Lambdalla, kuten kuvassa on esitetty Github-arkisto. Tämä kansio sisältää kaksi päätiedostoa: Docker-tiedoston, joka määrittää Docker-kuvan, joka toimii Lambda-toiminnossamme, ja app.py tiedosto, joka on Lambda-toiminnon päätulopiste:

Lambda-funktio odottaa tapahtumaa, joka sisältää otsikon ja rungon, jossa rungon tulisi olla kuva, joka on merkittävä base64-dekoodatuksi objektiksi. Kuvan perusteella Amazon Rekognition detect_labels -toimintoa kutsutaan lambda-funktiosta käyttämällä Boto3. Funktio palauttaa yhden tai useamman tunnisteen jokaiselle kuvan objektille ja rajoitusruudun tiedot kaikille havaittuille objektitunnisteille osana vastausta sekä muita tietoja, kuten määritetyn nimiön luotettavuus, havaitun tarran esi-isat, mahdolliset tunnisteen aliakset ja luokat, joihin tunnistettu tarra kuuluu. Suoritamme toiminnon Amazon Rekognitionin palauttamien tarrojen perusteella label_image, joka laskee auton kulman havaituista pyöristä seuraavasti:

Huomaa, että sovellus edellyttää, että kuvassa on vain yksi auto, ja palauttaa virheilmoituksen, jos näin ei ole. Jälkikäsittely voidaan kuitenkin mukauttaa tarjoamaan tarkempia suuntakuvauksia, kattamaan useita autoja tai laskemaan monimutkaisempien kohteiden suunnan.

Paranna pyörän tunnistusta

Pyöräntunnistuksen tarkkuuden parantamiseksi edelleen voit käyttää Amazon Rekognition mukautetut etiketit. Samoin kuin hienosäätö SageMakerilla mukautetun ML-mallin kouluttamiseen ja käyttöönottoon, voit tuoda omat merkittyjä tietojasi, jotta Amazon Rekognition voi tuottaa sinulle mukautetun kuva-analyysimallin muutamassa tunnissa. Rekognition Custom Labels -tunnisteiden avulla tarvitset vain pienen joukon harjoituskuvia, jotka ovat omia käyttötapauksiasi, tässä tapauksessa autokuvia tietyissä kulmissa, koska se hyödyntää Amazon Rekognitionin olemassa olevia ominaisuuksia, joiden avulla voit harjoitella kymmenien miljoonien kuvien avulla. monia luokkia. Rekognition Custom Labels voidaan integroida vain muutamalla napsautuksella ja pienillä muokkauksilla Lambda-toimintoon, jota käytämme Amazon Rekognition -standardiratkaisussa.

Kouluta malli käyttämällä SageMaker-koulutustyötä

Toisessa vaihtoehdossamme koulutamme mukautetun syväoppimismallin SageMakerissa. Käytämme Detectron2-kehys autonosien segmentointiin. Näitä segmenttejä käytetään sitten päättämään auton sijainti.

Detectron2-kehys on kirjasto, joka tarjoaa huippuluokan tunnistus- ja segmentointialgoritmit. Detectron tarjoaa erilaisia Mask R-CNN -malleja, jotka on koulutettu kuuluisalle COCO (Common Objects in Context) -tietojoukolle. Rakennamme auton esineiden tunnistusmallimme siirtooppimisen avulla hienosäätääksemme esikoulutetun Mask R-CNN -mallin autonosien segmentointi tietojoukko. Tämän tietojoukon avulla voimme kouluttaa mallin, joka pystyy havaitsemaan pyörät, mutta myös muut autonosat. Tätä lisätietoa voidaan edelleen käyttää korin kulman laskennassa suhteessa kuvaan.

Tietojoukko sisältää huomautettuja tietoja auton osista, joita käytetään esineiden havaitsemiseen ja semanttiseen segmentointitehtäviin: noin 500 kuvaa sedaneista, avoautoista ja urheiluautoista (SUV), otettuna useissa näkymissä (edestä, takaa ja sivulta). Jokaiseen kuvaan on merkitty 18 maskia ja rajoitusruutua, jotka edustavat auton eri osia, kuten renkaita, peilejä, valoja sekä etu- ja takalasia. Muokkasimme pyörien perusmerkintöjä siten, että jokaista pyörää pidetään yksittäisenä kohteena sen sijaan, että pidettäisiin kaikkia kuvassa olevia pyöriä yhtenä kohteena.

Käytämme Amazonin yksinkertainen tallennuspalvelu (Amazon S3) tallentaaksesi Detectron-mallin koulutukseen käytetyn tietojoukon yhdessä koulutettujen malliartefaktien kanssa. Lisäksi Docker-säiliö, joka toimii Lambda-toiminnossa, on tallennettu Amazonin elastisten säiliörekisteri (Amazon ECR). Lambda-toiminnon Docker-säilöä tarvitaan koodin suorittamiseen tarvittavien kirjastojen ja riippuvuuksien sisällyttämiseen. Vaihtoehtoisesti voisimme käyttää Lambda kerrokset, mutta se on rajoitettu 250 Mt:n purettuun käyttöönoton pakattuun kokokiintiöön, ja Lambda-toimintoon voidaan lisätä enintään viisi tasoa.

Ratkaisumme perustuu SageMakeriin: laajennamme esirakennettua SageMaker Docker -säiliöt PyTorchin suorittamiseksi mukautettua PyTorchiamme koulutuskoodi. Seuraavaksi käytämme SageMaker Python SDK:ta käärimään harjoituskuvan SageMaker PyTorch -estimaattoriksi seuraavien koodinpätkien mukaisesti:

Lopuksi aloitamme koulutustyön soittamalla fit() toiminto luodussa PyTorch-estimaattorissa. Kun koulutus on päättynyt, koulutettu malliartefaktti tallennetaan Amazon S3:n istuntoämpäriin käytettäväksi päättelyputkessa.

Ota malli käyttöön SageMakerin ja päättelyputkien avulla

Käytämme myös SageMakeria isännöimään päätelmäpäätepistettä, joka käyttää mukautettua Detectron-malliamme. Täysi infrastruktuuri, jota käytetään ratkaisumme käyttöönotossa, on varustettu AWS CDK:lla. Voimme isännöidä mukautettua malliamme a SageMaker reaaliaikainen päätepiste soittamalla deploy PyTorch-estimaattorissa. Tämä on toinen kerta, kun laajennamme valmiiksi rakennettua SageMaker PyTorch -säilöä sisältämään PyTorch Detectronin. Käytämme sitä päättelykomentosarjan suorittamiseen ja koulutetun PyTorch-mallimme isännöimiseen seuraavasti:

Huomaa, että käytimme käyttöönotossa ml.g4dn.xlarge GPU:ta, koska se on pienin saatavilla oleva GPU ja riittää tähän esittelyyn. Kaksi komponenttia on määritettävä meidän päättelyskripti: mallin lastaus ja mallin tarjoilu. Toiminto model_fn() käytetään lataamaan koulutettu malli, joka on osa isännöityä Docker-säilöä ja löytyy myös Amazon S3:sta ja palauttaa malliobjektin, jota voidaan käyttää mallin palvelemiseen seuraavasti:

Toiminto predict_fn() suorittaa ennusteen ja palauttaa tuloksen. Sen lisäksi, että käytämme koulutettua malliamme, käytämme maskin R-CNN-mallin esikoulutettua versiota, joka on koulutettu COCO-tietojoukolla, poimimaan kuvan pääauton. Tämä on ylimääräinen jälkikäsittelyvaihe sellaisten kuvien käsittelyssä, joissa on useampi kuin yksi auto. Katso seuraava koodi:

Samoin kuin Amazon Rekognition -ratkaisussa, rajoituslaatikot ennustivat wheel luokka suodatetaan tunnistuslähdöistä ja syötetään jälkikäsittelymoduuliin korin sijainnin arvioimiseksi lähtöön nähden.

Lopuksi paransimme myös Detectron-ratkaisun jälkikäsittelyä. Se käyttää myös eri autonosien segmenttejä ratkaisun päättelemiseen. Esimerkiksi aina kun etupuskuri havaitaan, mutta takapuskuria ei ole, oletetaan, että meillä on etunäkymä autosta ja vastaava kulma lasketaan.

Yhdistä ratkaisusi verkkosovellukseen

Vaiheet mallin päätepisteiden yhdistämiseksi Amplifyyn ovat seuraavat:

- Kloonaa AWS CDK -pinon luoma sovellusvarasto nimeltä

car-angle-detection-website-repo. Varmista, että etsit sitä alueelta, jota käytit käyttöönottoon. - Kopioi kunkin käyttöönotetun Lambda-toiminnon API-yhdyskäytävän päätepisteet tiedostoon

index.htmltiedosto edelliseen arkistoon (on paikkamerkkejä, joihin päätepiste on sijoitettava). Seuraava koodi on esimerkki siitä, miltä tämä .html-tiedoston osa näyttää:

- Tallenna HTML-tiedosto ja työnnä koodimuutos etäpäähaaraan.

Tämä päivittää käyttöönoton HTML-tiedoston. Sovellus on nyt valmis käytettäväksi.

- Siirry Amplify-konsoliin ja etsi luomasi projekti.

Sovelluksen URL-osoite tulee näkyviin, kun käyttöönotto on valmis.

- Siirry URL-osoitteeseen ja pidä hauskaa käyttöliittymän kanssa.

Yhteenveto

Onnittelut! Olemme ottaneet käyttöön täydellisen palvelimettoman arkkitehtuurin, jossa käytimme Amazon Rekognitionia, mutta annoimme myös vaihtoehdon omalle mukautetulle mallillesi, tämä esimerkki on saatavilla osoitteessa GitHub. Jos tiimilläsi ei ole ML-asiantuntemusta tai tarpeeksi mukautettuja tietoja mallin kouluttamiseen, voit valita vaihtoehdon, joka käyttää Amazon Rekognitionia. Jos haluat enemmän hallita malliasi, haluat muokata sitä edelleen ja sinulla on tarpeeksi tietoa, voit valita SageMaker-ratkaisun. Jos sinulla on joukko datatieteilijöitä, he saattavat myös haluta parantaa malleja edelleen ja valita mukautetun ja joustavamman vaihtoehdon. Voit laittaa Lambda-toiminnon ja API-yhdyskäytävän verkkosovelluksesi taakse käyttämällä jompaakumpaa kahdesta vaihtoehdosta. Voit myös käyttää tätä lähestymistapaa eri käyttötapauksissa, joita varten saatat haluta mukauttaa koodia.

Tämän palvelimettoman arkkitehtuurin etuna on, että rakennuspalikat ovat täysin vaihdettavissa. Mahdollisuudet ovat lähes rajattomat. Aloita siis tänään!

Kuten aina, AWS suhtautuu myönteisesti palautteeseen. Lähetä kommentteja tai kysymyksiä.

Tietoja Tekijät

Michael Wallner on vanhempi konsultti Data & AI -palvelussa AWS Professional Services -palvelussa ja on intohimoinen siihen, että asiakkaat voivat matkallaan tulla datapohjaisiksi ja AWSomeiksi AWS-pilvessä. Lisäksi hän haluaa ajatella isosti asiakkaiden kanssa innovoidakseen ja keksiäkseen heille uusia ideoita.

Michael Wallner on vanhempi konsultti Data & AI -palvelussa AWS Professional Services -palvelussa ja on intohimoinen siihen, että asiakkaat voivat matkallaan tulla datapohjaisiksi ja AWSomeiksi AWS-pilvessä. Lisäksi hän haluaa ajatella isosti asiakkaiden kanssa innovoidakseen ja keksiäkseen heille uusia ideoita.

Aamna Najmi on tietotutkija, jolla on AWS Professional Services. Hän on intohimoinen auttamaan asiakkaita innovoimaan Big Data- ja tekoälytekniikoilla, jotta he voivat hyödyntää datasta liiketoiminta-arvoa ja oivalluksia. Hänellä on kokemusta työskentelystä tietoalusta- ja AI/ML-projekteissa terveydenhuollon ja biotieteiden alalla. Vapaa-ajallaan hän nauttii puutarhanhoidosta ja matkustamisesta uusiin paikkoihin.

Aamna Najmi on tietotutkija, jolla on AWS Professional Services. Hän on intohimoinen auttamaan asiakkaita innovoimaan Big Data- ja tekoälytekniikoilla, jotta he voivat hyödyntää datasta liiketoiminta-arvoa ja oivalluksia. Hänellä on kokemusta työskentelystä tietoalusta- ja AI/ML-projekteissa terveydenhuollon ja biotieteiden alalla. Vapaa-ajallaan hän nauttii puutarhanhoidosta ja matkustamisesta uusiin paikkoihin.

David Sauerwein on vanhempi datatutkija AWS Professional Services -palvelussa, jossa hän mahdollistaa asiakkaiden AI/ML-matkansa AWS-pilvessä. David keskittyy digitaalisiin kaksosiin, ennustamiseen ja kvanttilaskentaan. Hän on valmistunut teoreettisen fysiikan tohtoriksi Innsbruckin yliopistosta, Itävallasta. Hän oli myös tohtorintutkijana ja tohtorintutkijana Max-Planck-Institute for Quantum Opticsissa Saksassa. Vapaa-ajallaan hän rakastaa lukea, hiihtää ja viettää aikaa perheen kanssa.

David Sauerwein on vanhempi datatutkija AWS Professional Services -palvelussa, jossa hän mahdollistaa asiakkaiden AI/ML-matkansa AWS-pilvessä. David keskittyy digitaalisiin kaksosiin, ennustamiseen ja kvanttilaskentaan. Hän on valmistunut teoreettisen fysiikan tohtoriksi Innsbruckin yliopistosta, Itävallasta. Hän oli myös tohtorintutkijana ja tohtorintutkijana Max-Planck-Institute for Quantum Opticsissa Saksassa. Vapaa-ajallaan hän rakastaa lukea, hiihtää ja viettää aikaa perheen kanssa.

Srikrishna Chaitanya Konduru on vanhempi tietotutkija, jolla on AWS Professional -palvelut. Hän tukee asiakkaita AWS:n ML-sovellusten prototyyppien luomisessa ja operatiivisessa käytössä. Srikrishna keskittyy tietokonenäköön ja NLP:hen. Hän johtaa myös ML-alustan suunnittelu- ja käyttötapausten tunnistamishankkeita asiakkaille eri toimialoilla. Srikrishna on valmistunut biolääketieteen tekniikasta RWTH Aachenin yliopistosta Saksasta, ja hän keskittyy lääketieteelliseen kuvantamiseen.

Srikrishna Chaitanya Konduru on vanhempi tietotutkija, jolla on AWS Professional -palvelut. Hän tukee asiakkaita AWS:n ML-sovellusten prototyyppien luomisessa ja operatiivisessa käytössä. Srikrishna keskittyy tietokonenäköön ja NLP:hen. Hän johtaa myös ML-alustan suunnittelu- ja käyttötapausten tunnistamishankkeita asiakkaille eri toimialoilla. Srikrishna on valmistunut biolääketieteen tekniikasta RWTH Aachenin yliopistosta Saksasta, ja hän keskittyy lääketieteelliseen kuvantamiseen.

Ahmed Mansour on tietotutkija AWS Professional Services -palvelussa. Hän tarjoaa teknistä tukea asiakkaille heidän AI/ML-matkallaan AWS-pilvessä. Ahmed keskittyy NLP:n sovelluksiin proteiinidomeeniin yhdessä RL:n kanssa. Hän on valmistunut tekniikan tohtoriksi Münchenin teknisestä yliopistosta Saksasta. Vapaa-ajallaan hän käy mielellään kuntosalilla ja leikkii lastensa kanssa.

Ahmed Mansour on tietotutkija AWS Professional Services -palvelussa. Hän tarjoaa teknistä tukea asiakkaille heidän AI/ML-matkallaan AWS-pilvessä. Ahmed keskittyy NLP:n sovelluksiin proteiinidomeeniin yhdessä RL:n kanssa. Hän on valmistunut tekniikan tohtoriksi Münchenin teknisestä yliopistosta Saksasta. Vapaa-ajallaan hän käy mielellään kuntosalilla ja leikkii lastensa kanssa.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. Autot / sähköautot, hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- BlockOffsets. Ympäristövastuun omistuksen nykyaikaistaminen. Pääsy tästä.

- Lähde: https://aws.amazon.com/blogs/machine-learning/build-and-train-computer-vision-models-to-detect-car-positions-in-images-using-amazon-sagemaker-and-amazon-rekognition/

- :on

- :On

- :ei

- :missä

- 1

- 10

- 100

- 11

- 12

- 13

- 15%

- 17

- 19

- 22

- 250

- 500

- 7

- 9

- a

- Meistä

- tarkkuus

- poikki

- sopeuttaa

- mukautukset

- lisä-

- lisä-

- lisäinformaatio

- osoite

- Etu

- Jälkeen

- uudelleen

- AI

- AI / ML

- algoritmit

- Kaikki

- mahdollistaa

- pitkin

- Myös

- aina

- Amazon

- Amazonin tunnistus

- Amazon Sage Maker

- Amazon Web Services

- an

- analyysi

- ja

- Toinen

- Kaikki

- api

- sovelluksen

- Hakemus

- sovellukset

- NLP:n sovellukset

- sovellettu

- lähestymistapa

- suunnilleen

- arkkitehtuuri

- OVAT

- alueet

- keinotekoinen

- tekoäly

- AS

- arvioida

- osoitettu

- oletettu

- At

- Itävalta

- Automatisoitu

- saatavissa

- AWS

- AWS-asiantuntijapalvelut

- takaisin

- pohja

- perustua

- BE

- koska

- tulevat

- takana

- ovat

- kuuluu

- lisäksi

- Iso

- Big Data

- biolääketieteen

- Blocks

- elin

- sekä

- Laatikko

- laatikot

- Sivuliike

- tuoda

- rakentaa

- Rakentaminen

- rakennettu

- liiketoiminta

- mutta

- Ostaminen

- by

- laskea

- laskettu

- laskee

- soittamalla

- CAN

- Syöpä

- kyvyt

- auto

- autot

- tapaus

- tapauksissa

- luokat

- keskus

- muuttaa

- Valita

- luokka

- pilvi

- coco

- koodi

- yhdistää

- kommentit

- Yhteinen

- täydellinen

- täysin

- monimutkainen

- noudattaminen

- osat

- laskeminen

- laskelmat

- tietokone

- Tietokoneen visio

- luottamus

- määritetty

- kytkeä

- harkittu

- ottaen huomioon

- johdonmukainen

- muodostuu

- Console

- konsultti

- Kontti

- sisältää

- pitoisuus

- tausta

- ohjaus

- vastaava

- kallis

- voisi

- kattaa

- luotu

- sato

- asiakassuhde

- Asiakkaat

- muokattavissa

- räätälöidä

- tiedot

- Tietoalusta

- tietojen tutkija

- data-driven

- aineistot

- David

- sopimus

- syvä

- syvä oppiminen

- määrittelee

- esittely

- osoittaa

- osoittaa

- riippuvuudet

- sijoittaa

- käyttöön

- käyttöönotto

- Malli

- yksityiskohdat

- havaita

- havaittu

- Detection

- eri

- digitaalinen

- Digitaaliset kaksoset

- useat

- do

- Satamatyöläinen

- ei

- verkkotunnuksen

- Dont

- kukin

- vaikutus

- myöskään

- muu

- mahdollistaa

- mahdollistaa

- päätepiste

- sitoumus

- Tekniikka

- parantaa

- tarpeeksi

- merkintä

- virhe

- tapahtuma

- esimerkki

- olemassa

- olemassa

- odottaa

- experience

- asiantuntemus

- avoin

- laajentaa

- lisää

- uute

- perhe

- kuuluisa

- palaute

- harvat

- filee

- Asiakirjat

- Vihdoin

- Etunimi

- joustava

- Keskittää

- keskittyy

- jälkeen

- seuraa

- varten

- löytyi

- Puitteet

- Ilmainen

- alkaen

- etuosa

- koko

- täysin

- hauska

- toiminto

- tehtävät

- edelleen

- portti

- Saksa

- saada

- tietty

- lasi-

- Go

- GPU

- kuntosali

- Kova

- Olla

- he

- terveydenhuollon

- auttaa

- hänen

- hänen

- isäntä

- isännöi

- TUNTIA

- Miten

- Kuitenkin

- HTML

- HTTPS

- ajatus

- ideoita

- Tunnistaminen

- if

- havainnollistaa

- kuva

- kuvien

- Imaging

- tärkeä

- parantaa

- parani

- in

- sisältää

- henkilökohtainen

- teollisuus

- tiedot

- Infrastruktuuri

- aloitteita

- innovoida

- panos

- oivalluksia

- esimerkki

- sen sijaan

- yhdistää

- integroitu

- Älykkyys

- tulee

- kutsuttuihin

- IT

- SEN

- Job

- matka

- jpg

- json

- vain

- avain

- Lasten

- Merkki

- tarrat

- kerrokset

- Liidit

- oppiminen

- kirjastot

- Kirjasto

- elämä

- Life Sciences

- pitää

- tykkää

- rajallinen

- rajaton

- kuormitus

- lastaus

- sijainti

- näköinen

- ulkonäkö

- Erä

- rakastaa

- kone

- koneoppiminen

- tärkein

- tehdä

- onnistui

- monet

- kartoitus

- naamio

- Maskit

- matematiikka

- maksimi

- Media

- lääketieteellinen

- ehkä

- miljoonia

- ML

- Puhelinnumero

- Mobiilisovellukset

- malli

- mallit

- maltillisuus

- muokattu

- Moduulit

- lisää

- Lisäksi

- eniten

- moninkertainen

- nimetty

- Tarve

- tarvitaan

- tarpeet

- Uusi

- seuraava

- NLP

- Nro

- nyt

- objekti

- Objektin tunnistus

- esineet

- saada

- of

- on

- ONE

- verkossa

- verkkokaupoissa

- vain

- Mahdollisuudet

- optiikka

- Vaihtoehto

- Vaihtoehdot

- or

- Muut

- meidän

- ulos

- ulostulo

- yli

- oma

- pakattu

- pari

- osa

- osat

- intohimoinen

- Suorittaa

- suorittaa

- Fysiikka

- poimia

- putki

- paikat

- foorumi

- Platforms

- Platon

- Platonin tietotieto

- PlatonData

- Pelaa

- Ole hyvä

- Kohta

- aiheuttaa

- Asennon arvio

- sijainti

- kantoja

- mahdollinen

- Kirje

- ennustaa

- ennusti

- ennustus

- Predictor

- edellytyksiä

- esittää

- Aikaisempi

- Ongelma

- tuottaa

- Tuotteet

- Tuotteemme

- ammatillinen

- projekti

- hankkeet

- Proteiini

- prototyyppien

- toimittaa

- tarjoaa

- julkisesti

- Työnnä

- laittaa

- Python

- pytorch

- Kvantti

- Kvanttioptiikka

- kysymykset

- alue

- hinta

- Lue

- valmis

- reaaliaikainen

- syistä

- alue

- suhteellinen

- kaukosäädin

- säilytyspaikka

- edustavat

- edellyttää

- tarvitaan

- vaatimukset

- Vaatii

- tutkija

- vastaus

- johtua

- palata

- Tuotto

- ajaa

- juoksu

- toimii

- sagemaker

- SC

- tieteet

- Tiedemies

- tutkijat

- sdk

- Toinen

- Osa

- nähdä

- segmentti

- jakautuminen

- segmentit

- self-ajo

- vanhempi

- serverless

- palvelu

- Palvelut

- palvelevat

- Istunto

- setti

- useat

- hän

- Ostokset

- shouldnt

- näyttää

- esitetty

- puoli

- samankaltainen

- Yksinkertainen

- Koko

- pieni

- So

- sosiaalinen

- sosiaalinen media

- sosiaalisen median alustoja

- ratkaisu

- Ratkaisumme

- SOLVE

- jonkin verran

- erityinen

- viettää

- Urheilu

- pino

- standardi

- Alkaa

- alkoi

- huippu-

- Vaihe

- Askeleet

- Levytila

- verkkokaupasta

- tallennettu

- antaa

- niin

- riittävä

- toimitetaan

- tuki

- Tukee

- varma

- järjestelmä

- otettava

- Napauttaa

- tehtävät

- TD

- joukkue-

- Tekninen

- Technologies

- kymmeniä

- kuin

- että

- -

- heidän

- Niitä

- sitten

- teoreettinen

- Siellä.

- siksi

- Nämä

- ne

- Ajattelu

- tätä

- Kautta

- aika

- että

- ylin

- Juna

- koulutettu

- koulutus

- siirtää

- Matkustaminen

- Kaksoset

- kaksi

- ui

- yliopisto

- Päivitykset

- URL

- us

- käyttää

- käyttölaukku

- käytetty

- käyttäjä

- Käyttäjäkokemus

- käyttötarkoituksiin

- käyttämällä

- hyödyllisyys

- validointi

- arvo

- lajike

- Ajoneuvot

- versio

- pystysuora

- pystysuunnassa

- hyvin

- Video

- Näytä

- näkymät

- näkyvä

- visio

- läpikäynti

- haluta

- oli

- we

- verkko

- Web-sovellus

- verkkopalvelut

- suhtautuu

- tunnettu

- olivat

- Mitä

- Pyörä

- kun

- aina kun

- joka

- koko

- tulee

- with

- ilman

- työskentely

- olisi

- kääri

- Voit

- Sinun

- zephyrnet