Suoratoiston dynaamisessa maailmassa Amazon Music, jokainen kappaleen, podcastin tai soittolistan haku sisältää tarinan, tunnelman tai tunteiden tulvan, joka odottaa paljastumista. Nämä haut toimivat porttina uusiin löytöihin, rakkaisiin kokemuksiin ja pysyviin muistoihin. Hakupalkki ei tarkoita vain kappaleen löytämistä; Kyse on miljoonista aktiivisista käyttäjistä, jotka aloittavat henkilökohtaisen matkansa Amazon Musicin rikkaaseen ja monipuoliseen maailmaan.

Ylivertaisen asiakaskokemuksen tarjoaminen käyttäjien etsimän musiikin löytämiseksi välittömästi edellyttää alustaa, joka on sekä älykäs että reagoiva. Amazon Music käyttää tekoälyn voimaa tämän saavuttamiseen. Asiakaskokemuksen optimointi samalla kun hallitaan koulutuskustannuksia ja hakupalkin ominaisuuksia, kuten reaaliaikaista oikeinkirjoituksen tarkistusta ja vektorihakua, tukevien tekoälymallien päätelmiä on vaikeaa ruuhka-aikoina.

Amazon Sage Maker tarjoaa kokonaisvaltaisen joukon palveluita, joiden avulla Amazon Music voi rakentaa, kouluttaa ja ottaa käyttöön AWS-pilvessä vähällä vaivalla. SageMakerin avulla voit keskittyä koneoppimismalleidesi (ML) parissa työskentelemiseen, eikä tarvitse huolehtia esimerkiksi infrastruktuurista. Osana jaetun vastuun mallia SageMaker varmistaa, että tarjoamansa palvelut ovat luotettavia, tehokkaita ja skaalautuvia, ja samalla varmistat, että ML-mallien sovellus hyödyntää SageMakerin tarjoamia ominaisuuksia parhaalla mahdollisella tavalla.

Tässä viestissä käymme läpi Amazon Musicin matkan optimoidakseen suorituskykyä ja kustannuksia SageMakerin ja NVIDIA Triton Inference Serverin sekä TensorRT:n avulla. Sukellamme syvälle näyttämään, kuinka tämä näennäisesti yksinkertainen, mutta monimutkainen hakupalkki toimii, varmistaen katkeamattoman matkan Amazon Musicin universumiin pienistä turhauttavista kirjoitusvirheistä ja osuvista reaaliaikaisista hakutuloksista.

Amazon SageMaker ja NVIDIA: Nopeat ja tarkat vektorihaku- ja oikolukuominaisuudet

Amazon Music tarjoaa laajan kirjaston, jossa on yli 100 miljoonaa kappaletta ja miljoonia podcast-jaksoja. Oikean kappaleen tai podcastin löytäminen voi kuitenkin olla haastavaa, varsinkin jos et tiedä tarkkaa nimeä, esittäjää tai albumin nimeä tai haettu kysely on hyvin laaja, kuten "uutiset podcastit".

Amazon Music on ottanut kaksitahoisen lähestymistavan parantaakseen haku- ja hakuprosessia. Ensimmäinen askel on ottaa käyttöön vektorihaku (tunnetaan myös nimellä upotuspohjainen haku), ML-tekniikka, joka voi auttaa käyttäjiä löytämään etsimäänsä osuvimman sisällön sisällön semantiikan avulla. Toinen vaihe sisältää Transformer-pohjaisen oikeinkirjoituksen korjausmallin lisäämisen hakupinoon. Tämä voi olla erityisen hyödyllistä haettaessa musiikkia, koska käyttäjät eivät välttämättä aina tiedä kappaleen tai esittäjän nimen tarkkaa kirjoitusasua. Oikeinkirjoituksen korjaus voi auttaa käyttäjiä löytämään etsimänsä musiikin, vaikka he tekisivät kirjoitusvirheen hakukyselyssään.

Transformer-mallien ottaminen käyttöön haku- ja hakuputkessa (vektorihakuun tarvittavassa kyselyn upotuksen sukupolvessa ja oikeinkirjoituksen korjauksessa generatiivisessa Seq2Seq Transformer -mallissa) voi johtaa kokonaisviiveen huomattavaan lisääntymiseen, mikä vaikuttaa negatiivisesti asiakaskokemukseen. Siksi meille tuli ensisijainen tavoite optimoida reaaliaikainen päättelyviive vektorihaun ja oikeinkirjoituksen korjausmalleissa.

Amazon Music ja NVIDIA ovat kokoontuneet tuodakseen parhaan mahdollisen asiakaskokemuksen hakupalkkiin käyttämällä SageMakeria nopean ja tarkan oikolukuominaisuuksien sekä reaaliaikaisten semanttisten hakuehdotusten toteuttamiseen vektorihakupohjaisilla tekniikoilla. Ratkaisu sisältää SageMaker-isännöinnin, joka perustuu G5-instanssiin, joka käyttää NVIDIA A10G Tensor Core -grafiikkasuorittimia, SageMaker-tuettua NVIDIA Triton Inference Server Containeria ja NVIDIA TensorRT mallin muoto. Amazon Music on parantanut hakupalkin suorituskykyä vähentämällä oikeinkirjoituksen tarkistusmallin päättelyviivettä 25 millisekuntiin ruuhkahuipun aikana ja vähentämällä hakukyselyn upotetun sukupolven viivettä keskimäärin 63 % ja kustannuksia 73 % verrattuna suoritinpohjaiseen johtopäätökseen.

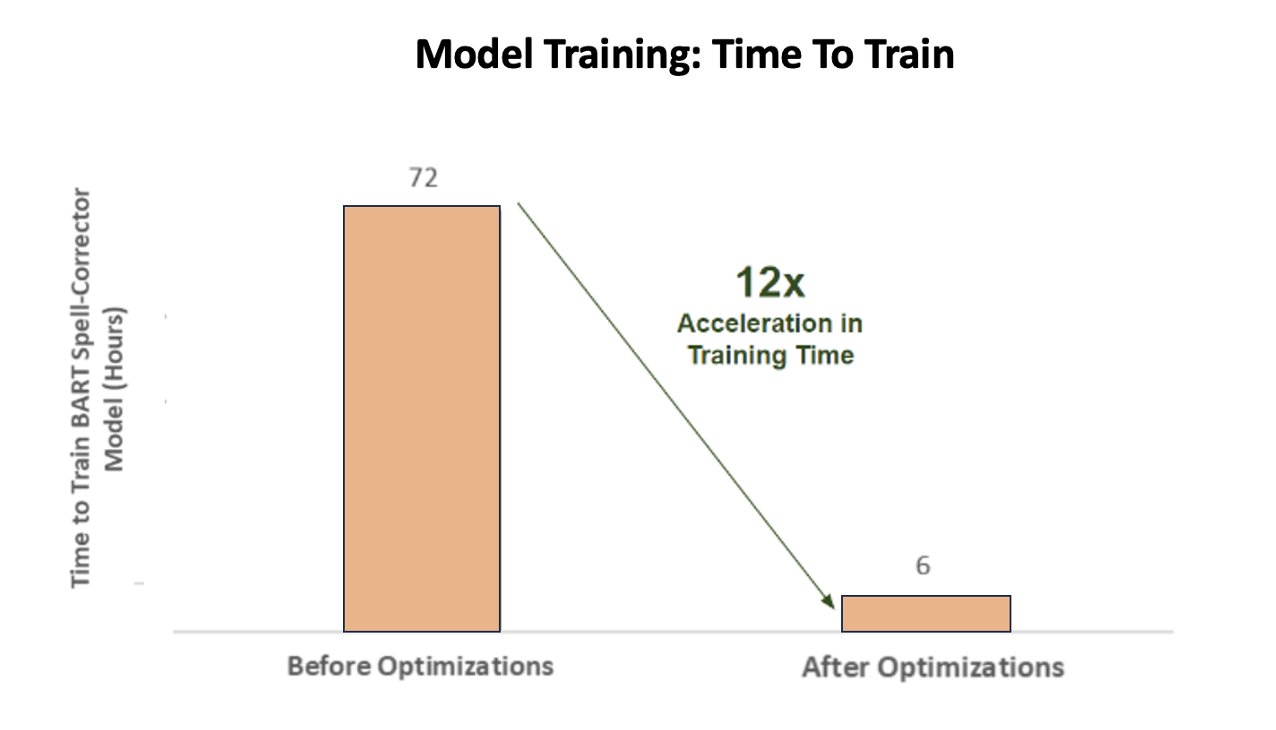

Lisäksi kun AI-mallia opetettiin tuottamaan tarkkoja tuloksia, Amazon Music saavutti 12-kertaisen kiihtyvyyden harjoitusajassa BART-sekvenssistä sekvenssiin oikeinkirjoituksen korjausmuuntajamallissaan, mikä säästää sekä aikaa että rahaa optimoimalla GPU-käyttönsä.

Amazon Music teki yhteistyötä NVIDIA:n kanssa priorisoidakseen asiakkaiden hakukokemusta ja luodakseen hakupalkin, jossa on hyvin optimoidut oikoluku- ja vektorihakutoiminnot. Seuraavissa osioissa kerromme lisää siitä, kuinka nämä optimoinnit organisoitiin.

Harjoittelun optimointi NVIDIA Tensor Core -grafiikkasuorittimilla

NVIDIA Tensor Core GPU:n käyttö suurten kielimallien harjoittelua varten ei riitä sen todellisen potentiaalin hyödyntämiseen. On olemassa tärkeitä optimointivaiheita, jotka on suoritettava harjoittelun aikana, jotta GPU:n käyttöaste voidaan maksimoida. Alikäyttöinen grafiikkasuoritin johtaa kuitenkin epäilemättä resurssien tehottomaan käyttöön, pidentyneeseen koulutusjaksoon ja kohonneisiin käyttökustannuksiin.

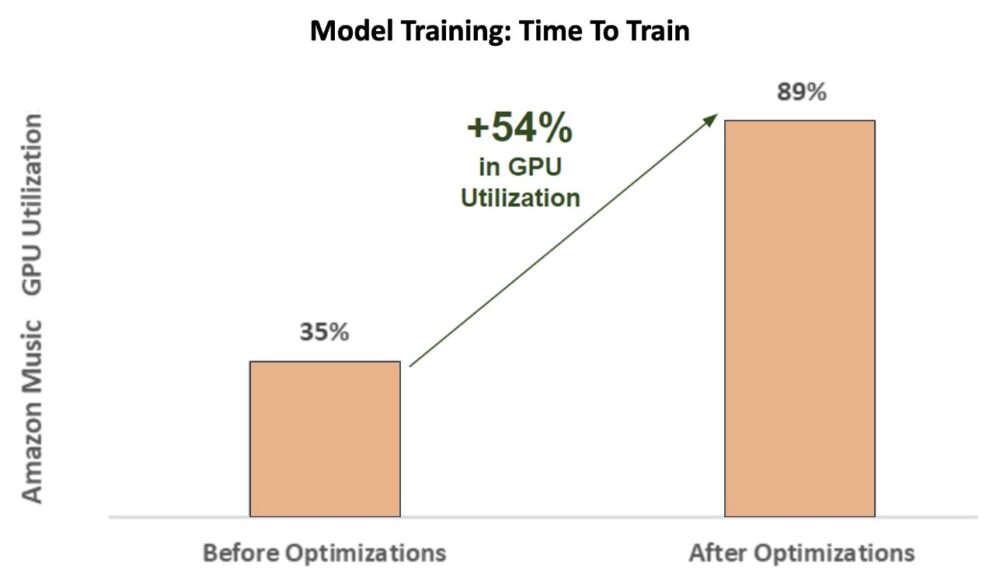

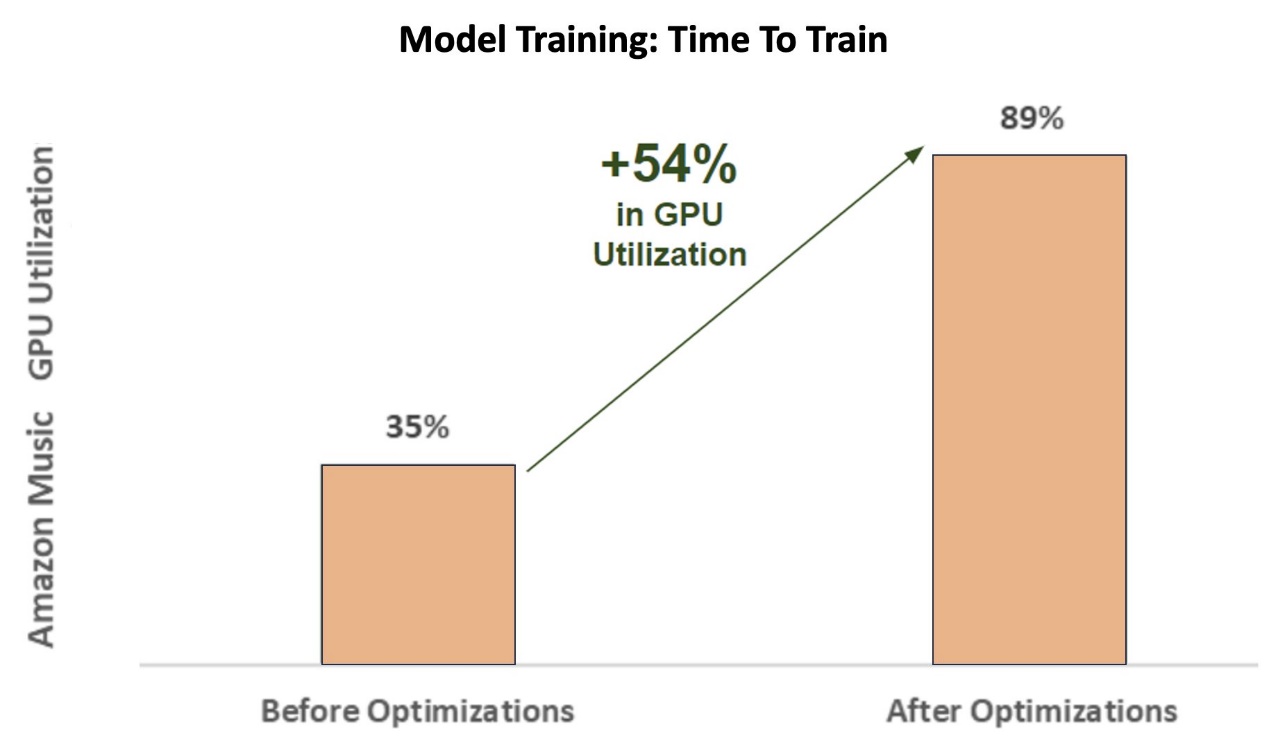

Harjoittelun alkuvaiheissa oikeinkirjoituksen korjaaja BART (bart-pohja) muuntajamalli SageMaker ml.p3.24xlarge -esiintymässä (8 NVIDIA V100 Tensor Core GPU:ta), Amazon Musicin GPU-käyttöaste oli noin 35 %. Maksimoidakseen NVIDIA-grafiikkasuorittimella kiihdytetyn koulutuksen edut AWS- ja NVIDIA-ratkaisuarkkitehdit tukivat Amazon Musicia optimointialueiden tunnistamisessa, erityisesti eräkoon ja tarkkuusparametrien ympärillä. Nämä kaksi ratkaisevaa parametria vaikuttavat syväoppimismallien koulutuksen tehokkuuteen, nopeuteen ja tarkkuuteen.

Tuloksena saadut optimoinnit tuottivat uuden ja parannetun V100 GPU:n käyttöasteen, joka on tasaisesti noin 89 %, mikä lyhensi Amazon Musicin harjoitusaikaa dramaattisesti 3 päivästä 5–6 tuntiin. Muuttamalla eräkokoa 32:sta 256:een ja käyttämällä optimointitekniikoita, kuten juoksua automaattinen sekoitettu tarkkuusharjoittelu FP32-tarkkuuden sijaan Amazon Music pystyi säästämään sekä aikaa että rahaa.

Seuraava kaavio havainnollistaa 54 %:n prosenttiyksikön kasvua GPU-käytössä optimoinnin jälkeen.

Seuraava kuva havainnollistaa harjoitusajan kiihtymistä.

Tämä eräkoon kasvu mahdollisti NVIDIA GPU:n käsittelemään huomattavasti enemmän dataa samanaikaisesti useiden Tensor Cores -ydinten välillä, mikä nopeuttaa harjoitusaikaa. On kuitenkin tärkeää säilyttää herkkä tasapaino muistin kanssa, koska suuremmat eräkoot vaativat enemmän muistia. Sekä eräkoon kasvattaminen että sekalaisen tarkkuuden käyttäminen voivat olla kriittisiä NVIDIA Tensor Core -grafiikkasuorittimien tehon vapauttamisessa.

Kun malli oli koulutettu konvergenssiin, oli aika optimoida johtopäätösten käyttöönotto Amazon Musicin hakupalkissa.

Oikeinkirjoituksen korjaus: BART-mallin päättely

SageMaker G5 -esiintymien ja NVIDIA Triton Inference Serverin (avoimen lähdekoodin päätelmiä palveleva ohjelmisto) sekä NVIDIA TensorRT:n, SDK:n, joka on tehokas syväoppimispäätelmä, joka sisältää päätelmien optimoijan ja suoritusajan, avulla Amazon Music rajoittaa oikeinkirjoituksen tarkistusta BART. (bart-pohja) mallipalvelimen johtopäätösviive on vain 25 millisekuntia ruuhkahuipun aikana. Tämä sisältää yleiskulut, kuten kuormituksen tasapainottamisen, esikäsittelyn, mallin päättelyn ja jälkikäsittelyajat.

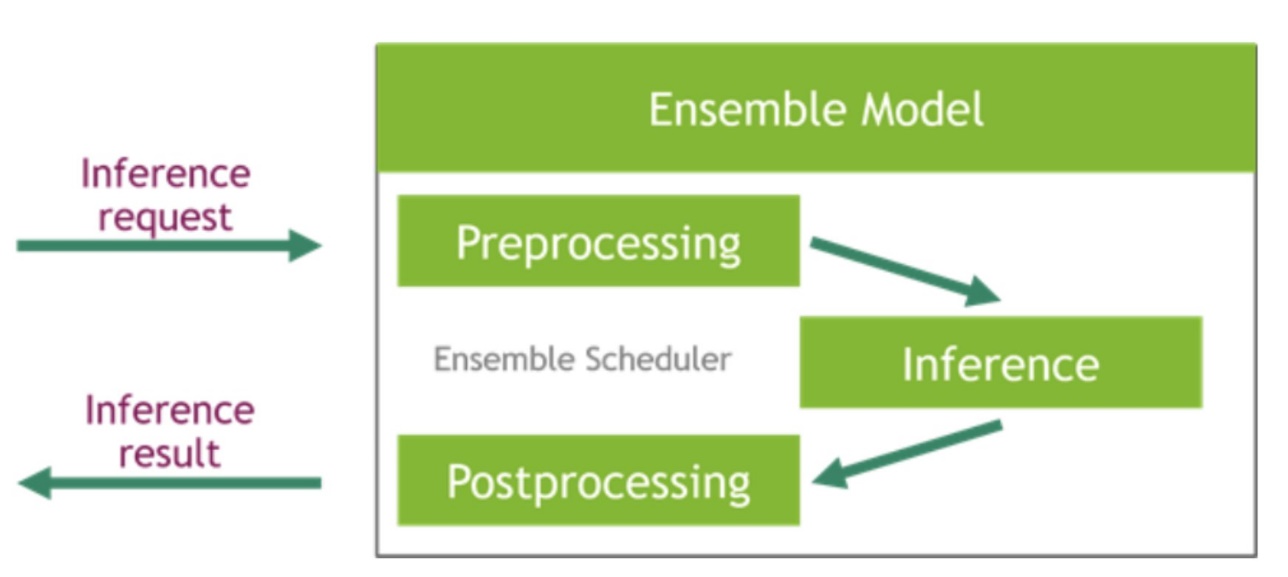

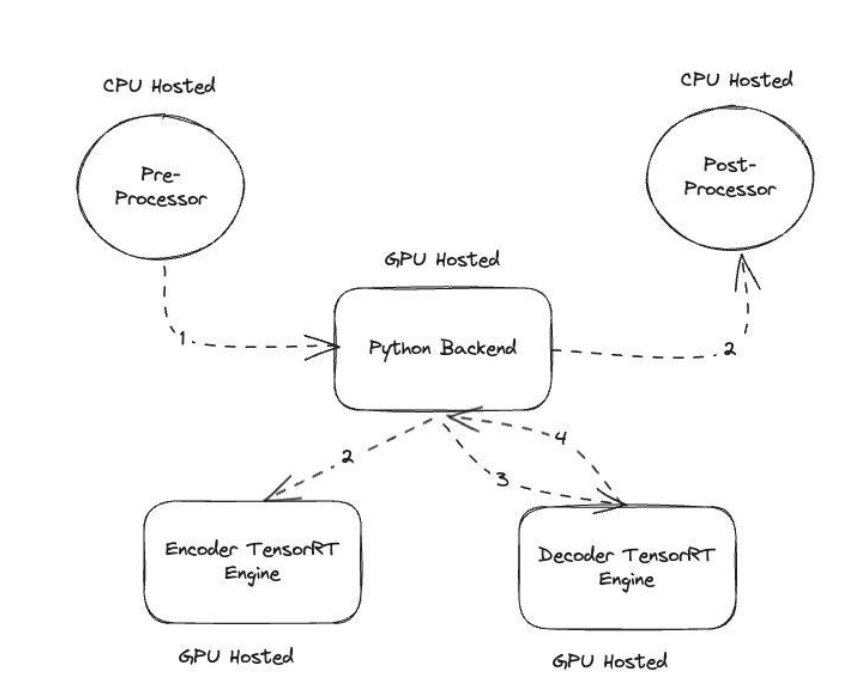

NVIDIA Triton Inference Server tarjoaa kaksi erilaista taustaa: yksi mallien isännöintiin GPU:lla ja Python-tausta, johon voit tuoda oman mukautetun koodisi käytettäväksi esi- ja jälkikäsittelyvaiheissa. Seuraava kuva havainnollistaa mallikokonaisuus.

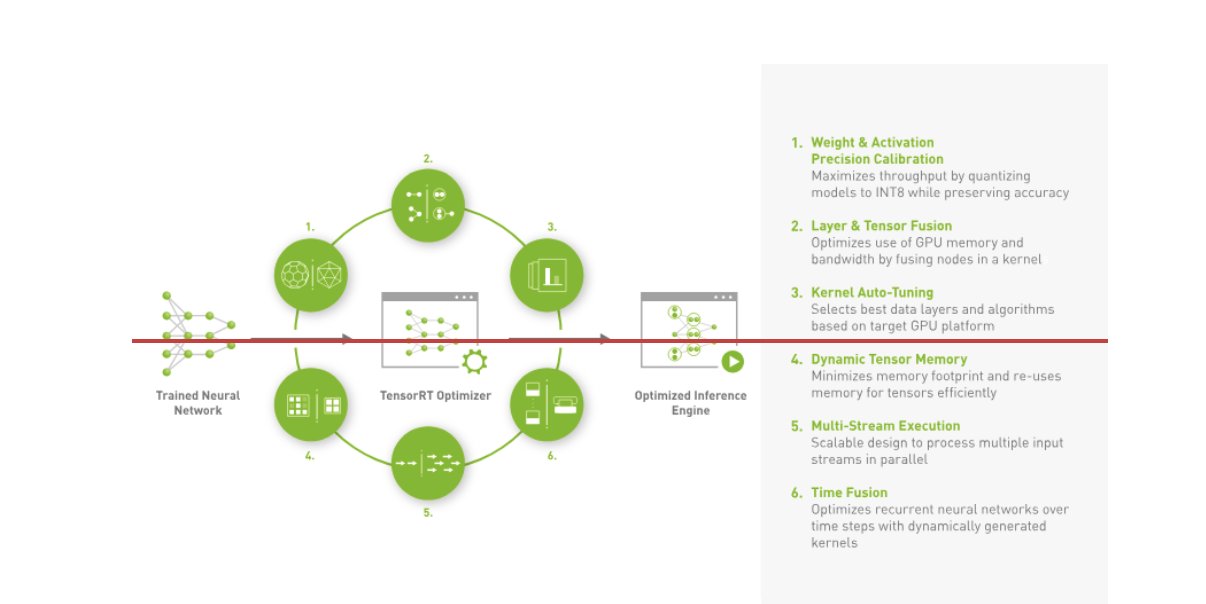

Amazon Music rakensi BARTin päätelmäputki suorittamalla sekä esikäsittelyvaiheet (tekstin tokenointi) että jälkikäsittelyvaiheet (tunnisteet tekstiksi) prosessoreissa, kun taas mallin suoritusvaihe suoritetaan NVIDIA A10G Tensor Core -grafiikkasuorittimet. Python-taustajärjestelmä on esi- ja jälkikäsittelyvaiheiden keskellä ja vastaa kommunikaatiosta TensorRT-muunnettujen BART-mallien sekä enkooderi-/dekooderiverkkojen kanssa. TensorRT tehostaa päättelyn suorituskykyä tarkalla kalibroinnilla, kerrosten ja tensorien yhdistämisellä, ytimen automaattisella virityksellä, dynaamisella tensorimuistilla, usean virran suorituskyvyllä ja aikafuusiolla.

Seuraava kuva havainnollistaa avainmoduulien korkean tason suunnittelua, jotka muodostavat oikeinkirjoituksen korjaajan BART-mallin päättelyputken.

Vektorihaku: Kyselyn upottaminen sukupolvilauseen BERT-mallin päättelyyn

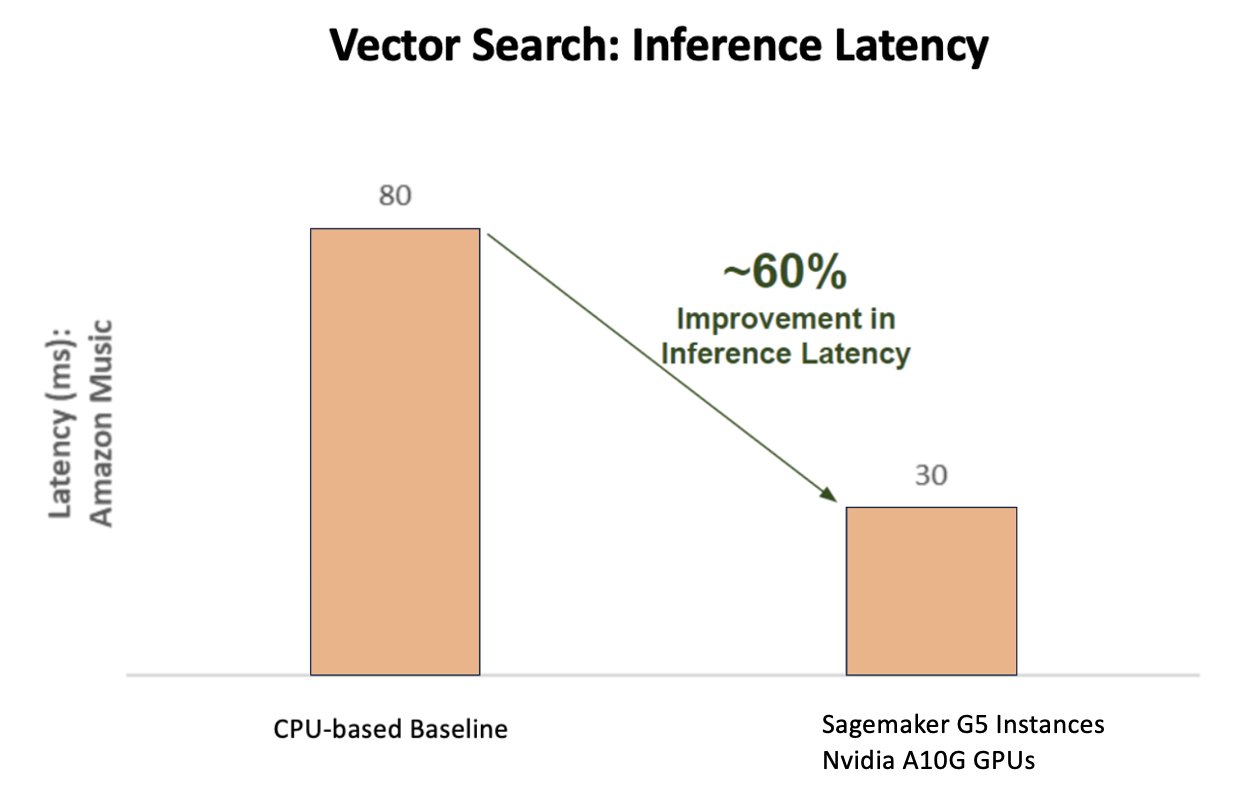

Seuraava kaavio havainnollistaa 60 %:n parannusta latenssissa (palvella p90 800–900 TPS), kun käytetään NVIDIA AI Inference Platform -alustaa verrattuna suoritinpohjaiseen perustilaan.

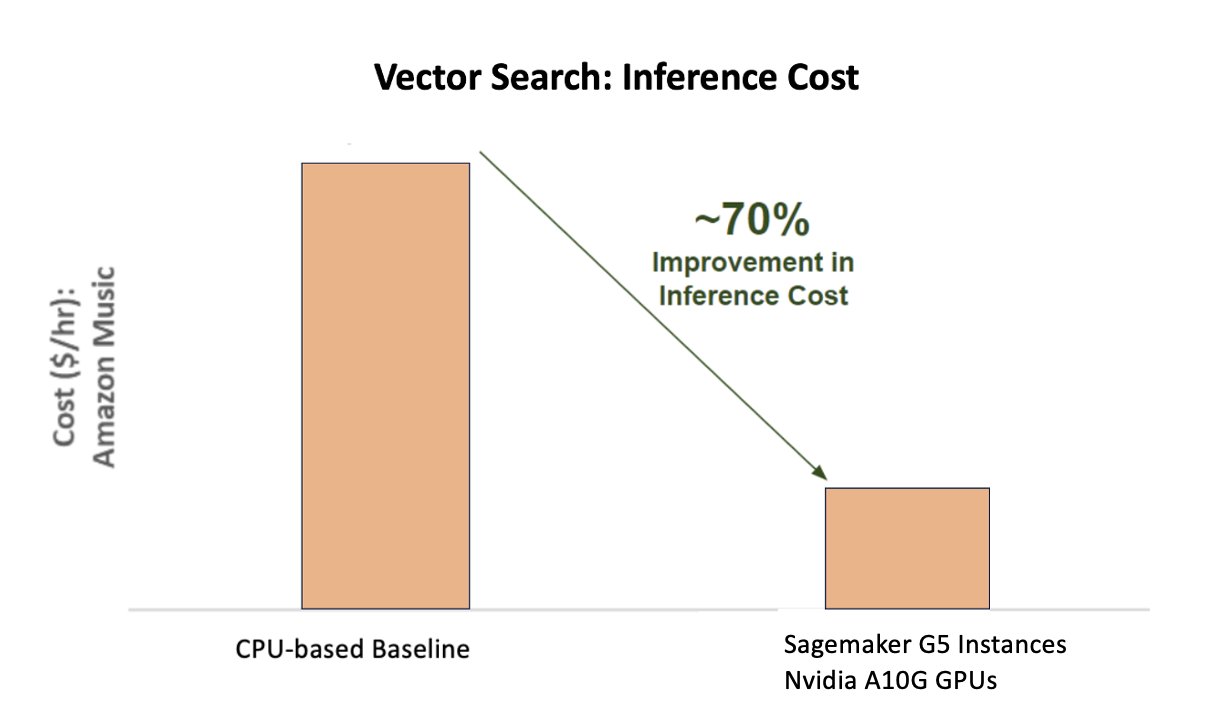

Seuraavassa kaaviossa näkyy 70 %:n parannus kustannuksissa NVIDIA AI Inference Platformia käytettäessä suoritinpohjaiseen perustilaan verrattuna.

Seuraava kuva havainnollistaa SDK:ta tehokkaan syväoppimisen päättelyyn. Se sisältää syvän oppimisen päättelyn optimoijan ja suoritusajan, joka tarjoaa alhaisen viiveen ja suuren suorituskyvyn päättelysovelluksille.

Saavuttaakseen nämä tulokset Amazon Music kokeili useita erilaisia Tritonin käyttöönottoparametreja käyttämällä Triton mallin analysaattori, työkalu, joka auttaa löytämään parhaan NVIDIA Triton -mallikokoonpanon tehokkaan päättelyn käyttämiseksi. Mallin päättelyn optimoimiseksi Triton tarjoaa ominaisuuksia, kuten dynaamisen eräajon ja samanaikaisen mallin suorituksen, ja sillä on kehystuki muille joustavuusominaisuuksille. Dynaaminen eräajo kerää päättelypyynnöt ja ryhmittelee ne saumattomasti kohortteihin suorituskyvyn maksimoimiseksi ja varmistaa samalla reaaliaikaiset vastaukset Amazon Musicin käyttäjille. Samanaikaisen mallin suorituskyky parantaa entisestään päättelyn suorituskykyä isännöimällä useita kopioita mallista samassa GPU:ssa. Lopuksi hyödyntämällä Triton mallin analysaattori, Amazon Music pystyi huolellisesti hienosäätämään dynaamisen erän ja mallin samanaikaisuuspäätelmien isännöintiparametreja löytääkseen optimaaliset asetukset, jotka maksimoivat päättelyn suorituskyvyn käyttämällä simuloitua liikennettä.

Yhteenveto

Konfiguraatioiden optimointi Triton Inference Serverin ja TensorRT:n avulla SageMakerissa antoi Amazon Musicille erinomaisia tuloksia sekä koulutuksessa että päättelyputkissa. SageMaker-alusta on päästä päähän avoin alusta tuotantoälylle, joka tarjoaa nopean arvonnousun ja monipuolisuuden, joka tukee kaikkia tärkeimpiä tekoälyn käyttötapauksia sekä laitteistoissa että ohjelmistoissa. Optimoimalla V100 GPU:n käytön koulutukseen ja vaihtamalla prosessoreista G5-instanssiin käyttämällä NVIDIA A10G Tensor Core -grafiikkasuorittimia sekä käyttämällä optimoituja NVIDIA-ohjelmistoja, kuten Triton Inference Server ja TensorRT, Amazon Musicin kaltaiset yritykset voivat säästää aikaa ja rahaa sekä parantaa suorituskykyä molemmissa. koulutusta ja päätelmiä, jotka johtavat suoraan parempaan asiakaskokemukseen ja alhaisempiin käyttökustannuksiin.

SageMaker hoitaa ML-harjoittelun ja isännöinnin erilaisten raskaiden nostojen, jolloin Amazon Music voi tarjota luotettavia, skaalautuvia ML-operaatioita sekä laitteistoissa että ohjelmistoissa.

Suosittelemme sinua tarkistamaan, että työkuormasi on optimoitu SageMakerin avulla, arvioimalla aina laitteisto- ja ohjelmistovalinnasi nähdäksesi, onko olemassa tapoja saavuttaa parempi suorituskyky pienemmillä kustannuksilla.

Lisätietoja NVIDIA AI:stä AWS:ssä on seuraavassa:

Tietoja kirjoittajista

Siddharth Sharma on koneoppimisen tekninen johtaja Amazon Musicin Science & Modeling -tiimissä. Hän on erikoistunut haku-, haku-, luokitus- ja NLP-mallinnusongelmiin. Siddharthilla on rikas tausta työskennellessään laajamittaisissa koneoppimisongelmissa, jotka ovat herkkiä viiveelle, kuten mainosten kohdistaminen, monimuotoinen haku, hakukyselyn ymmärtäminen jne. Ennen työskentelyään Amazon Musicilla Siddharth työskenteli sellaisissa yrityksissä kuin Meta, Walmart Labs, Rakuten verkkokauppakeskeisiin ML-ongelmiin. Siddharth työskenteli uransa alkuvaiheessa lahden alueen mainosteknologia-alan startup-yritysten kanssa.

Siddharth Sharma on koneoppimisen tekninen johtaja Amazon Musicin Science & Modeling -tiimissä. Hän on erikoistunut haku-, haku-, luokitus- ja NLP-mallinnusongelmiin. Siddharthilla on rikas tausta työskennellessään laajamittaisissa koneoppimisongelmissa, jotka ovat herkkiä viiveelle, kuten mainosten kohdistaminen, monimuotoinen haku, hakukyselyn ymmärtäminen jne. Ennen työskentelyään Amazon Musicilla Siddharth työskenteli sellaisissa yrityksissä kuin Meta, Walmart Labs, Rakuten verkkokauppakeskeisiin ML-ongelmiin. Siddharth työskenteli uransa alkuvaiheessa lahden alueen mainosteknologia-alan startup-yritysten kanssa.

Tarun Sharma on ohjelmistokehityspäällikkö, joka johtaa Amazon Music Search Relevance:tä. Hänen tiedemiehistä ja ML-insinööreistä koostuva tiimi on vastuussa asiayhteyteen liittyvien ja henkilökohtaisten hakutulosten tarjoamisesta Amazon Musicin asiakkaille.

Tarun Sharma on ohjelmistokehityspäällikkö, joka johtaa Amazon Music Search Relevance:tä. Hänen tiedemiehistä ja ML-insinööreistä koostuva tiimi on vastuussa asiayhteyteen liittyvien ja henkilökohtaisten hakutulosten tarjoamisesta Amazon Musicin asiakkaille.

James Park on ratkaisuarkkitehti Amazon Web Servicesissä. Hän työskentelee Amazon.comin kanssa suunnitella, rakentaa ja ottaa käyttöön teknologiaratkaisuja AWS:ssä, ja hän on erityisen kiinnostunut tekoälystä ja koneoppimisesta. Vapaa-ajallaan hän etsii uusia kulttuureja, uusia kokemuksia ja pysyy ajan tasalla uusimpien teknologiatrendien kanssa. Löydät hänet osoitteessa LinkedIn.

James Park on ratkaisuarkkitehti Amazon Web Servicesissä. Hän työskentelee Amazon.comin kanssa suunnitella, rakentaa ja ottaa käyttöön teknologiaratkaisuja AWS:ssä, ja hän on erityisen kiinnostunut tekoälystä ja koneoppimisesta. Vapaa-ajallaan hän etsii uusia kulttuureja, uusia kokemuksia ja pysyy ajan tasalla uusimpien teknologiatrendien kanssa. Löydät hänet osoitteessa LinkedIn.

Kshitiz Gupta on NVIDIA:n ratkaisuarkkitehti. Hän nauttii pilviasiakkaiden kouluttamisesta NVIDIAn tarjoamista GPU-AI-tekniikoista ja heidän avustamisestaan heidän koneoppimis- ja syväoppimissovellustensa nopeuttamisessa. Työn ulkopuolella hän nauttii juoksemisesta, patikoinnista ja villieläinten katselusta.

Kshitiz Gupta on NVIDIA:n ratkaisuarkkitehti. Hän nauttii pilviasiakkaiden kouluttamisesta NVIDIAn tarjoamista GPU-AI-tekniikoista ja heidän avustamisestaan heidän koneoppimis- ja syväoppimissovellustensa nopeuttamisessa. Työn ulkopuolella hän nauttii juoksemisesta, patikoinnista ja villieläinten katselusta.

Jiahong Liu on ratkaisuarkkitehti NVIDIA:n Cloud Service Provider -tiimissä. Hän auttaa asiakkaita ottamaan käyttöön koneoppimis- ja tekoälyratkaisuja, jotka hyödyntävät NVIDIA:n nopeutettua tietojenkäsittelyä vastaamaan heidän koulutus- ja päättelyhaasteisiinsa. Vapaa-ajallaan hän nauttii origamista, tee-se-itse-projekteista ja koripallon pelaamisesta.

Jiahong Liu on ratkaisuarkkitehti NVIDIA:n Cloud Service Provider -tiimissä. Hän auttaa asiakkaita ottamaan käyttöön koneoppimis- ja tekoälyratkaisuja, jotka hyödyntävät NVIDIA:n nopeutettua tietojenkäsittelyä vastaamaan heidän koulutus- ja päättelyhaasteisiinsa. Vapaa-ajallaan hän nauttii origamista, tee-se-itse-projekteista ja koripallon pelaamisesta.

Tugrul Konuk on NVIDIA:n vanhempi ratkaisuarkkitehti, joka on erikoistunut laajamittaiseen koulutukseen, multimodaaliseen syväoppimiseen ja korkean suorituskyvyn tieteelliseen laskemiseen. Ennen NVIDIAa hän työskenteli energiateollisuudessa keskittyen laskennallisen kuvantamisen algoritmien kehittämiseen. Osana tohtorintutkintoaan hän työskenteli fysiikkaan perustuvan syväoppimisen parissa numeerisia simulaatioita varten. Vapaa-ajallaan hän lukee, soittaa kitaraa ja pianoa.

Tugrul Konuk on NVIDIA:n vanhempi ratkaisuarkkitehti, joka on erikoistunut laajamittaiseen koulutukseen, multimodaaliseen syväoppimiseen ja korkean suorituskyvyn tieteelliseen laskemiseen. Ennen NVIDIAa hän työskenteli energiateollisuudessa keskittyen laskennallisen kuvantamisen algoritmien kehittämiseen. Osana tohtorintutkintoaan hän työskenteli fysiikkaan perustuvan syväoppimisen parissa numeerisia simulaatioita varten. Vapaa-ajallaan hän lukee, soittaa kitaraa ja pianoa.

Rohil Bhargava on NVIDIA:n tuotemarkkinointipäällikkö, joka keskittyy NVIDIA-sovelluskehysten ja SDK:iden käyttöönottoon tietyillä CSP-alustoilla.

Rohil Bhargava on NVIDIA:n tuotemarkkinointipäällikkö, joka keskittyy NVIDIA-sovelluskehysten ja SDK:iden käyttöönottoon tietyillä CSP-alustoilla.

Eliuth Triana Isaza on NVIDIA:n kehittäjäsuhdepäällikkö, joka antaa Amazonin AI MLOpsille, DevOpsille, tutkijoille ja AWS:n teknisille asiantuntijoille mahdollisuuden hallita NVIDIA-laskentapinoa Generative AI Foundation -mallien nopeuttamiseksi ja optimoimiseksi, jotka kattavat tietojen kuroinnin, GPU-koulutuksen, mallin päättelyn ja tuotannon käyttöönoton AWS GPU -esiintymissä. . Lisäksi Eliuth on intohimoinen maastopyöräilijä, hiihtäjä, tennis- ja pokerinpelaaja.

Eliuth Triana Isaza on NVIDIA:n kehittäjäsuhdepäällikkö, joka antaa Amazonin AI MLOpsille, DevOpsille, tutkijoille ja AWS:n teknisille asiantuntijoille mahdollisuuden hallita NVIDIA-laskentapinoa Generative AI Foundation -mallien nopeuttamiseksi ja optimoimiseksi, jotka kattavat tietojen kuroinnin, GPU-koulutuksen, mallin päättelyn ja tuotannon käyttöönoton AWS GPU -esiintymissä. . Lisäksi Eliuth on intohimoinen maastopyöräilijä, hiihtäjä, tennis- ja pokerinpelaaja.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://aws.amazon.com/blogs/machine-learning/how-amazon-music-uses-sagemaker-with-nvidia-to-optimize-ml-training-and-inference-performance-and-cost/

- :on

- :On

- :ei

- :missä

- $ YLÖS

- 100

- 12

- 25

- 32

- 35%

- 7

- 8

- a

- pystyy

- Meistä

- kiihtyi

- kiihtyvä

- kiihtyvyys

- pääsy

- suorittaa

- tarkkuus

- tarkka

- Saavuttaa

- saavutettu

- poikki

- aktiivinen

- Lisäksi

- osoite

- hyväksymällä

- mainokset

- vaikuttavat

- Jälkeen

- AI

- AI-mallit

- ai käyttötapauksia

- Albumi

- algoritmit

- Kaikki

- sallia

- sallittu

- Salliminen

- mahdollistaa

- Myös

- aina

- Amazon

- Amazon Web Services

- Amazon.com

- an

- ja

- Hakemus

- sovellukset

- lähestymistapa

- arkkitehdit

- OVAT

- ALUE

- alueet

- noin

- taiteilija

- AS

- avustaminen

- avustaa

- At

- keskimäärin

- AWS

- taustaosa

- Balance

- tasapainotus

- baari

- perustua

- Lähtötilanne

- Koripallo

- Lahti

- BE

- tuli

- koska

- Hyödyt

- PARAS

- Paremmin

- lisäämällä

- boosteja

- sekä

- tuoda

- laaja

- rakentaa

- rakennettu

- by

- CAN

- kyvyt

- valmiudet

- kaapata

- joka

- Ura

- huolellisesti

- tapauksissa

- haasteet

- haastava

- Kaavio

- tarkastaa

- vaalia

- valintoja

- asiakkaat

- pilvi

- koodi

- KOM

- Tulla

- viestiä

- Yritykset

- verrattuna

- laskennallinen

- tietojenkäsittely

- samanaikainen

- Konfigurointi

- Kontti

- pitoisuus

- Lähentyminen

- Ydin

- Hinta

- kustannukset

- veneet

- kriittinen

- ratkaiseva

- CSP

- Curation

- asiakassuhde

- asiakas

- asiakaskokemus

- Asiakkaat

- tiedot

- Päivämäärä

- päivää

- vähentynyt

- syvä

- syvä oppiminen

- viiveet

- toimittaa

- tuottaa

- Antaa

- Kysyntä

- sijoittaa

- levityspinnalta

- käyttöönotto

- Malli

- Kehittäjä

- kehittämällä

- Kehitys

- eri

- vaikea

- suoraan

- sukellus

- useat

- DIY

- Dont

- rajusti

- aikana

- dynaaminen

- e

- verkkokaupan

- Varhainen

- valistaa

- tehokkuus

- tehokas

- vaivaa

- korkea

- upottamisen

- tunteet

- käyttämällä

- valtuuttamisesta

- käytössä

- kannustaa

- päittäin

- energia

- Engineers

- Parantaa

- tarpeeksi

- varmistamalla

- erityisesti

- jne.

- arviointiin

- Jopa

- Joka

- teloitus

- experience

- Elämykset

- asiantuntijat

- FAST

- Ominaisuudet

- Kuva

- Vihdoin

- Löytää

- löytäminen

- Etunimi

- Joustavuus

- tulva

- Keskittää

- keskityttiin

- tarkennus

- jälkeen

- varten

- muoto

- perusta

- Puitteet

- puitteet

- alkaen

- turhauttava

- täysin

- toiminnallisuudet

- edelleen

- fuusio

- portti

- sukupolvi

- generatiivinen

- Generatiivinen AI

- GPU

- GPU

- Vetimet

- tapahtua

- Palvelimet

- Olla

- he

- raskas

- raskas nosto

- auttaa

- hyödyllinen

- auttaa

- Korkea

- korkean tason

- korkea suorituskyky

- häntä

- hänen

- pitää

- hotellit

- TUNTIA

- Miten

- Kuitenkin

- HTML

- HTTPS

- tunnistaminen

- if

- havainnollistaa

- Imaging

- toteuttaa

- tärkeä

- parantaa

- parani

- parannus

- in

- sisältää

- Kasvaa

- kasvoi

- lisää

- teollisuus

- tehoton

- vaikutus

- Infrastruktuuri

- ensimmäinen

- esimerkki

- heti

- sen sijaan

- korko

- tulee

- esitellä

- käyttöön

- IT

- SEN

- matka

- jpg

- vain

- avain

- laji

- Tietää

- tunnettu

- Labs

- Kieli

- suuri

- laaja

- suurempi

- kestävä

- Viive

- uusin

- kerros

- johtaa

- johtava

- OPPIA

- oppiminen

- Vaikutusvalta

- Kirjasto

- nosto

- pitää

- rajat

- kuormitus

- näköinen

- Matala

- alentaa

- kone

- koneoppiminen

- ylläpitää

- merkittävä

- tehdä

- TEE

- johtaja

- toimitusjohtaja

- Marketing

- mestari

- Maksimoida

- Saattaa..

- Muistoja

- Muisti

- Meta

- Keskimmäinen

- miljoona

- miljoonia

- millisekuntia

- minimi

- virhe

- sekoitettu

- ML

- MLOps

- malli

- mallintaminen

- mallit

- Moduulit

- raha

- lisää

- eniten

- Vuori

- multi

- moninkertainen

- Musiikki

- täytyy

- nimi

- tarvitaan

- negatiivisesti

- verkot

- Uusi

- NLP

- Nvidia

- of

- kampanja

- Tarjoukset

- on

- ONE

- vain

- avata

- avoimen lähdekoodin

- toiminta

- toiminta-

- Operations

- optimaalinen

- optimointi

- Optimoida

- optimoitu

- optimoimalla

- or

- orkestroinut

- tilata

- Muut

- ulos

- ulkopuolella

- erinomainen

- yli

- yleinen

- oma

- parametrit

- osa

- erityinen

- erityisesti

- kumppanuuteen

- intohimoinen

- Peak

- osuus

- suorituskyky

- henkilöstö

- yksilöllinen

- phd

- putki

- foorumi

- Platforms

- Platon

- Platonin tietotieto

- PlatonData

- soitin

- pelaa

- podcast

- podcastit

- Kohta

- pokeri

- mahdollinen

- Kirje

- mahdollinen

- teho

- powered

- Tarkkuus

- Aikaisempi

- Asettaa etusijalle

- prioriteetti

- ongelmia

- prosessi

- Tuotteet

- tuotanto

- hankkeet

- toimittaa

- toimittaja

- tarjoaa

- tarjoamalla

- Python

- nopea

- Sijoitus

- Lukeminen

- reaaliaikainen

- vähentämällä

- katso

- liittyvä

- suhteet

- Merkitys

- merkityksellinen

- luotettava

- pyynnöt

- Vaatii

- Esittelymateriaalit

- vasteet

- vastuu

- vastuullinen

- herkkä

- Saatu ja

- tulokset

- Rikas

- oikein

- juoksu

- toimii

- runtime

- sagemaker

- sama

- Säästä

- tallentaa

- skaalautuva

- Asteikko

- tiede

- tieteellinen

- tutkijat

- sdk

- sdks

- saumattomasti

- Haku

- haut

- haku

- Toinen

- osiot

- nähdä

- etsiä

- näennäisesti

- semantiikka

- vanhempi

- sensible

- tuomita

- palvella

- palvelin

- palvelu

- Palveluntarjoaja

- Palvelut

- palvelevat

- setti

- settings

- useat

- Jaa:

- yhteinen

- Näytä

- merkittävä

- merkittävästi

- Yksinkertainen

- istuu

- Koko

- koot

- fiksu

- Tuotteemme

- ohjelmistokehitys

- ratkaisu

- Ratkaisumme

- laulu

- lähde

- jännitys

- erikoistunut

- erikoistunut

- erityinen

- nopeus

- LOITSU

- oikeinkirjoitus

- käytetty

- pino

- Aloita

- Startups

- pysyminen

- tasainen

- Vaihe

- Askeleet

- Tarina

- streaming

- niin

- esimies

- tuki

- Tuetut

- varma

- otettava

- ottaen

- kohdistaminen

- joukkue-

- teknologia

- Tekninen

- tekniikka

- tekniikat

- Technologies

- Elektroniikka

- teksti

- että

- -

- heidän

- Niitä

- Siellä.

- siksi

- Nämä

- ne

- asiat

- tätä

- Kautta

- suoritusteho

- aika

- kertaa

- Otsikko

- että

- yhdessä

- tokenization

- tokens

- otti

- työkalu

- ylin

- tps

- liikenne

- Juna

- koulutettu

- koulutus

- muuntaja

- Trendit

- Triton

- totta

- kaksi

- ymmärtäminen

- epäilemättä

- CasinoUniverse

- lukituksen

- paljastettiin

- us

- käyttää

- käytetty

- Käyttäjät

- käyttötarkoituksiin

- käyttämällä

- Hyödyntämällä

- arvo

- valtava

- monipuolisuus

- hyvin

- odotus

- kävellä

- Walmart

- oli

- katsomassa

- tavalla

- we

- verkko

- verkkopalvelut

- HYVIN

- olivat

- kun

- taas

- vaikka

- tulee

- with

- Referenssit

- työskenteli

- työskentely

- toimii

- maailman-

- huoli

- vielä

- tuotti

- Voit

- Sinun

- zephyrnet