Tänään meillä on ilo ilmoittaa, että Metan kehittämät Code Llama -meikkipohjamallit ovat asiakkaiden saatavilla kautta Amazon SageMaker JumpStart ottaa käyttöön yhdellä napsautuksella päättelyn suorittamiseksi. Code Llama on huippuluokan kielimalli (LLM), joka pystyy tuottamaan koodia ja luonnollista kieltä koodista sekä koodin että luonnollisen kielen kehotteista. Voit kokeilla tätä mallia SageMaker JumpStartilla, koneoppimiskeskuksella (ML), joka tarjoaa pääsyn algoritmeihin, malleihin ja ML-ratkaisuihin, jotta voit nopeasti aloittaa ML:n käytön. Tässä viestissä käymme läpi Code Llama -mallin löytämisen ja käyttöönoton SageMaker JumpStartin kautta.

Code Lama

Code Llama on malli, jonka on julkaissut Meta joka on rakennettu Llama 2:n päälle. Tämä huippuluokan malli on suunniteltu parantamaan kehittäjien ohjelmointitehtävien tuottavuutta auttamalla heitä luomaan korkealaatuista, hyvin dokumentoitua koodia. Mallit loistavat Pythonissa, C++:ssa, Javassa, PHP:ssä, C#:ssa, TypeScriptissä ja Bashissa, ja ne voivat säästää kehittäjien aikaa ja tehostaa ohjelmistojen työnkulkua.

Sitä on kolme muunnelmaa, jotka on suunniteltu kattamaan monenlaisia sovelluksia: perusmalli (Code Llama), Python-erikoismalli (Code Llama Python) ja ohjeita seuraava malli luonnollisen kielen ohjeiden ymmärtämiseen (Code Llama Instruct). Kaikista Code Llama -versioista on neljä kokoa: 7B, 13B, 34B ja 70B parametrit. 7B- ja 13B-kanta- ja ohjeversiot tukevat täyttöä ympäröivän sisällön perusteella, joten ne sopivat ihanteellisesti koodiavustajasovelluksiin. Mallit suunniteltiin käyttämällä Llama 2:ta pohjana, ja sitten niitä harjoiteltiin 500 miljardilla koodidatan tunnisteella, ja Python-erikoisversio oli koulutettu 100 miljardin lisätokenin avulla. Code Llama -mallit tarjoavat vakaat sukupolvet, joissa on jopa 100,000 16,000 kontekstimerkkiä. Kaikki mallit on koulutettu 100,000 XNUMX merkin sarjoihin, ja niissä on parannuksia jopa XNUMX XNUMX tunnuksella.

Malli on saatavilla samalla alla yhteisön lisenssi nimellä Llama 2.

Perusmallit SageMakerissa

SageMaker JumpStart tarjoaa pääsyn useisiin malleihin suosituista mallikeskittymistä, mukaan lukien Hugging Face, PyTorch Hub ja TensorFlow Hub, joita voit käyttää ML-kehitystyönkulussa SageMakerissa. Viimeaikaiset edistysaskeleet ML:ssä ovat synnyttäneet uuden malliluokan, joka tunnetaan nimellä perusmallit, jotka on tyypillisesti koulutettu miljardeihin parametreihin ja jotka ovat mukautettavissa monenlaisiin käyttötapauksiin, kuten tekstin yhteenvetoon, digitaalisen taiteen luomiseen ja kielten kääntämiseen. Koska nämä mallit ovat kalliita kouluttaa, asiakkaat haluavat käyttää olemassa olevia esikoulutettuja perusmalleja ja hienosäätää niitä tarpeen mukaan sen sijaan, että kouluttaisivat mallit itse. SageMaker tarjoaa kuratoidun luettelon malleista, joista voit valita SageMaker-konsolista.

Löydät SageMaker JumpStartista eri mallien tarjoajien perustusmalleja, joiden avulla pääset nopeasti alkuun perusmallien kanssa. Löydät eri tehtäviin tai mallintoimittajiin perustuvia perusmalleja ja voit helposti tarkastella mallien ominaisuuksia ja käyttöehtoja. Voit myös kokeilla näitä malleja käyttämällä testikäyttöliittymän widgetiä. Kun haluat käyttää perusmallia mittakaavassa, voit tehdä sen poistumatta SageMakerista käyttämällä mallintoimittajien valmiita muistikirjoja. Koska mallit isännöidään ja otetaan käyttöön AWS:ssä, voit olla varma, että tietojasi, riippumatta siitä, käytetäänkö niitä mallin arvioimiseen tai käyttöön, ei koskaan jaeta kolmansille osapuolille.

Tutustu Code Llama -malliin SageMaker JumpStartissa

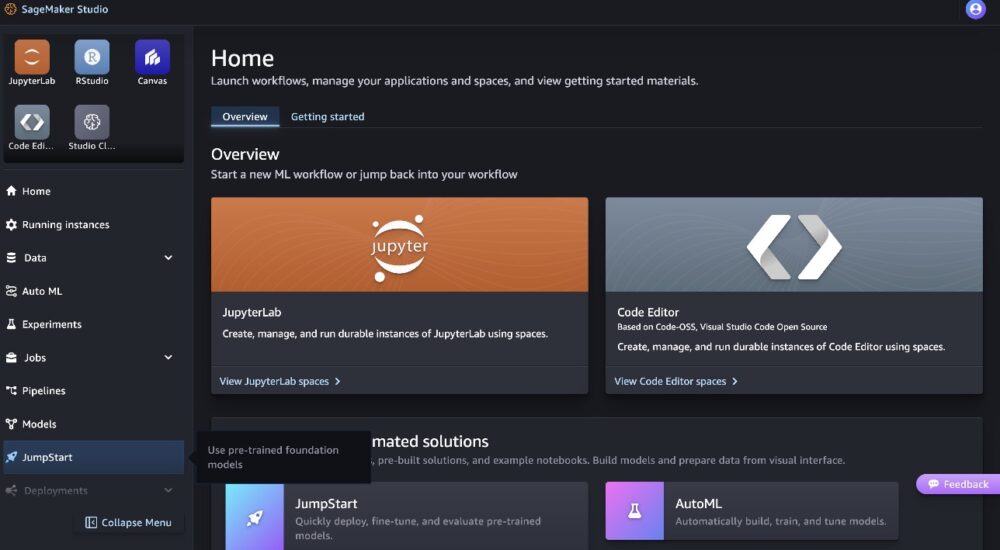

Ota Code Llama 70B -malli käyttöön suorittamalla seuraavat vaiheet Amazon SageMaker Studio:

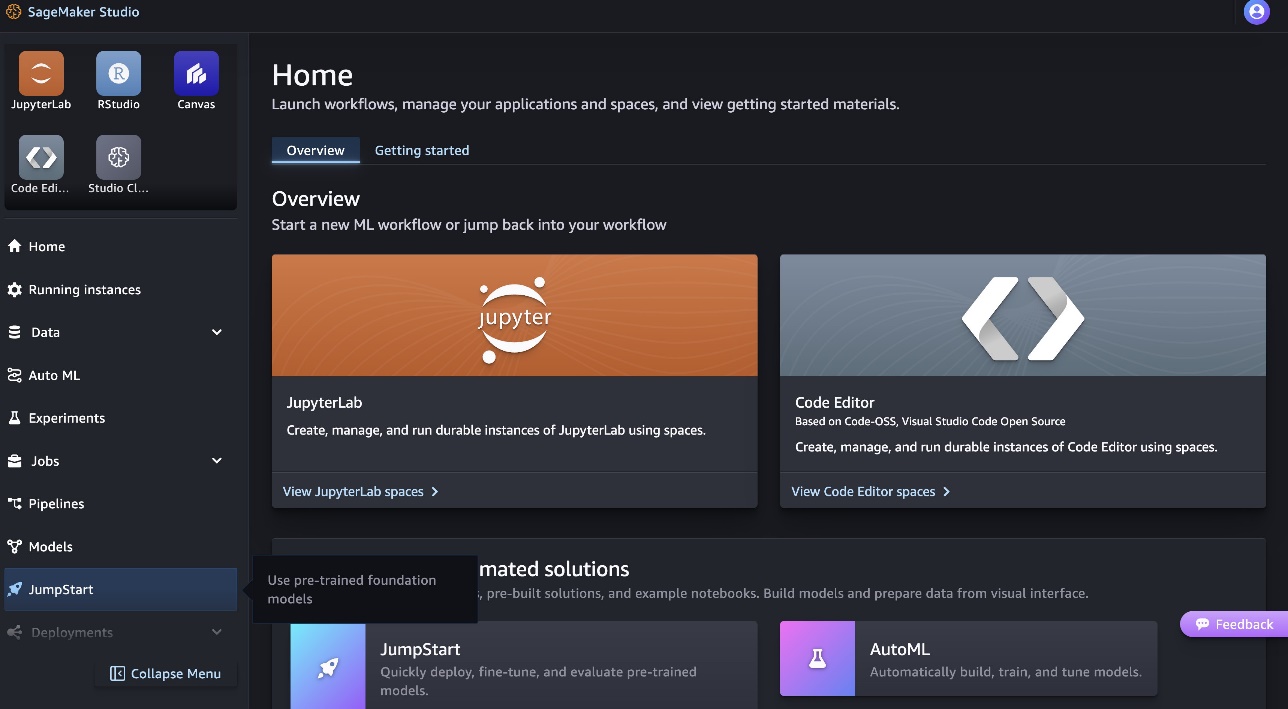

- Valitse SageMaker Studion kotisivulta Kaapelikäynnistys navigointipaneelissa.

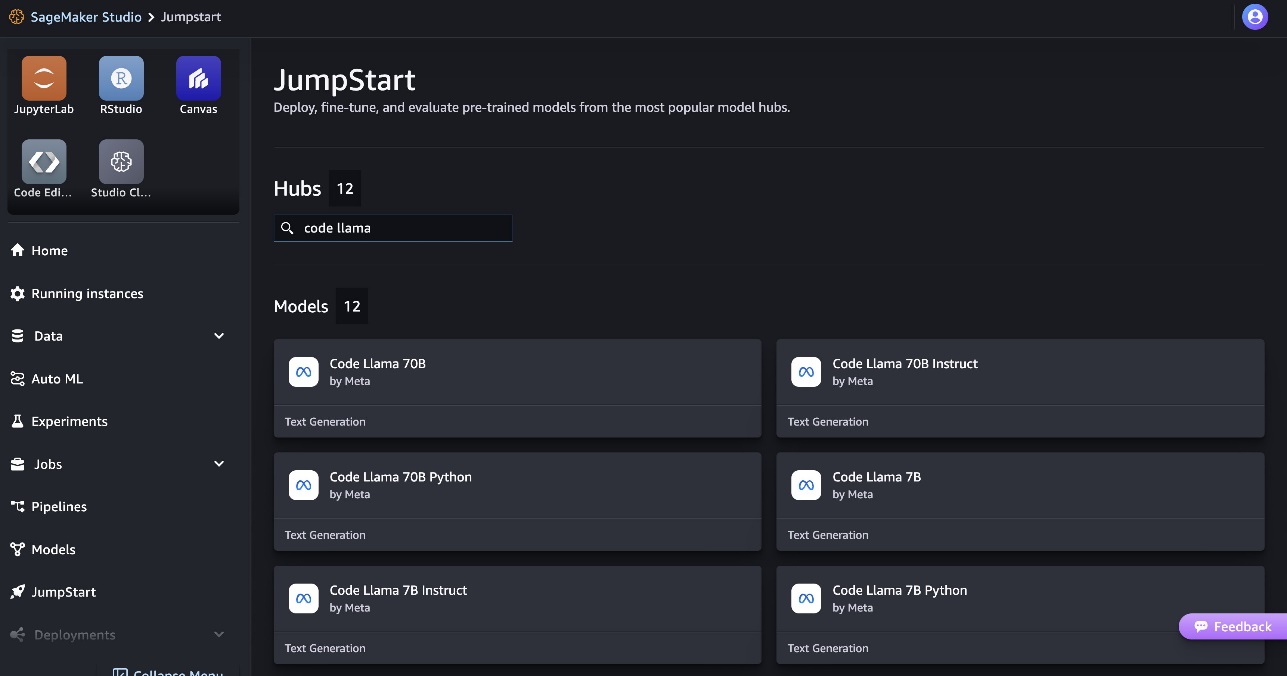

- Etsi Code Llama -malleja ja valitse Code Llama 70B malli näytetystä malliluettelosta.

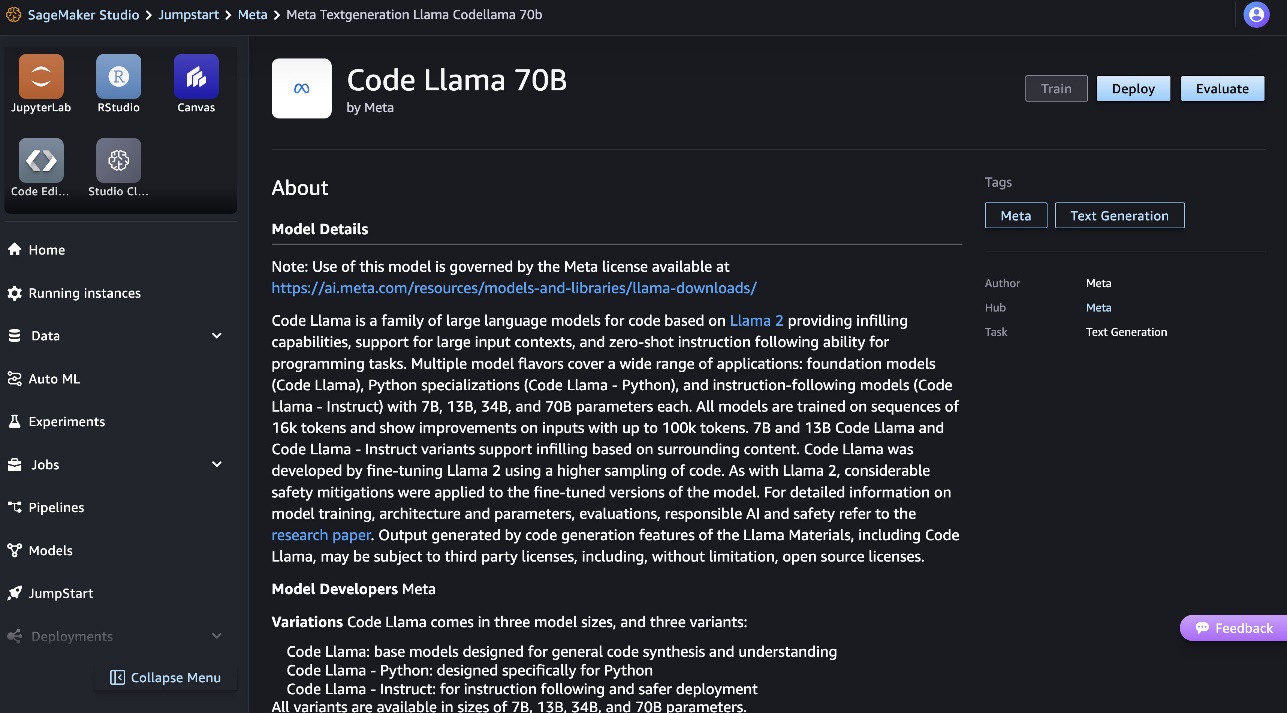

Lisätietoja mallista löydät Code Llama 70B mallikortista.

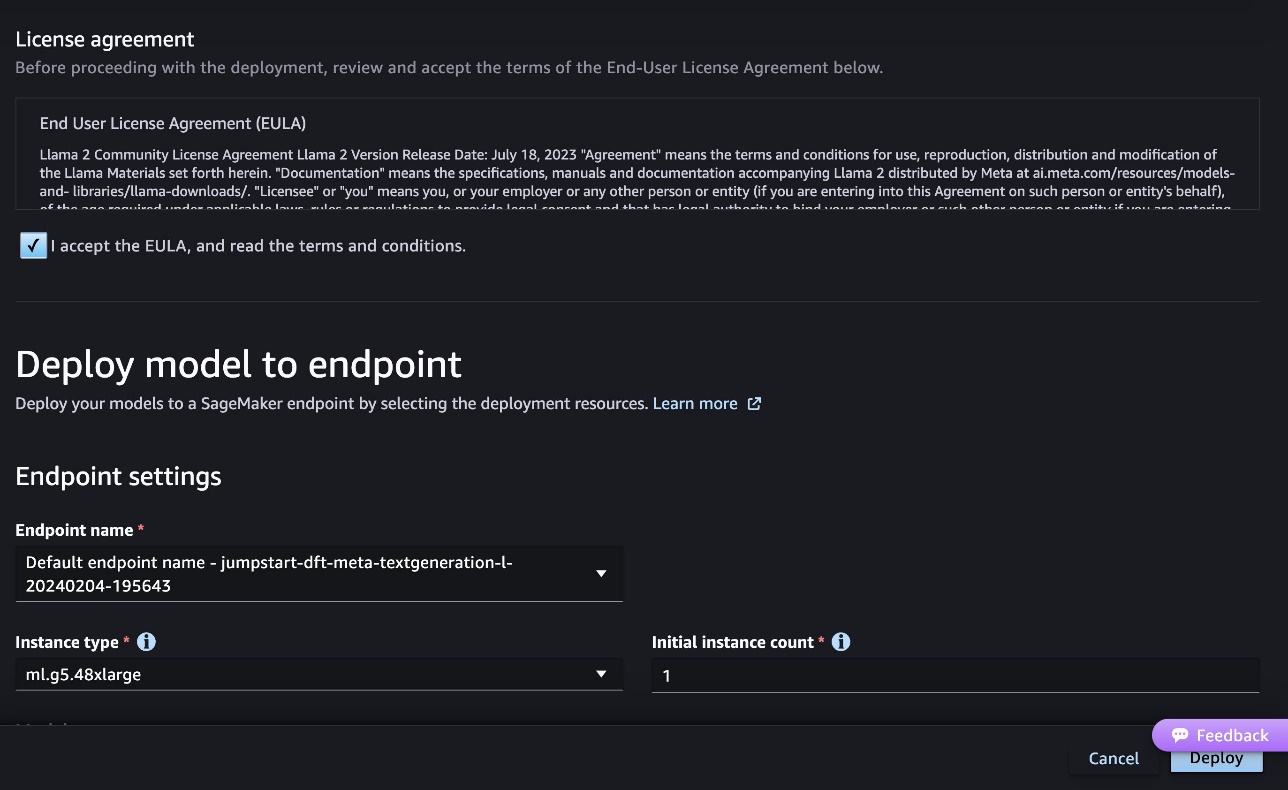

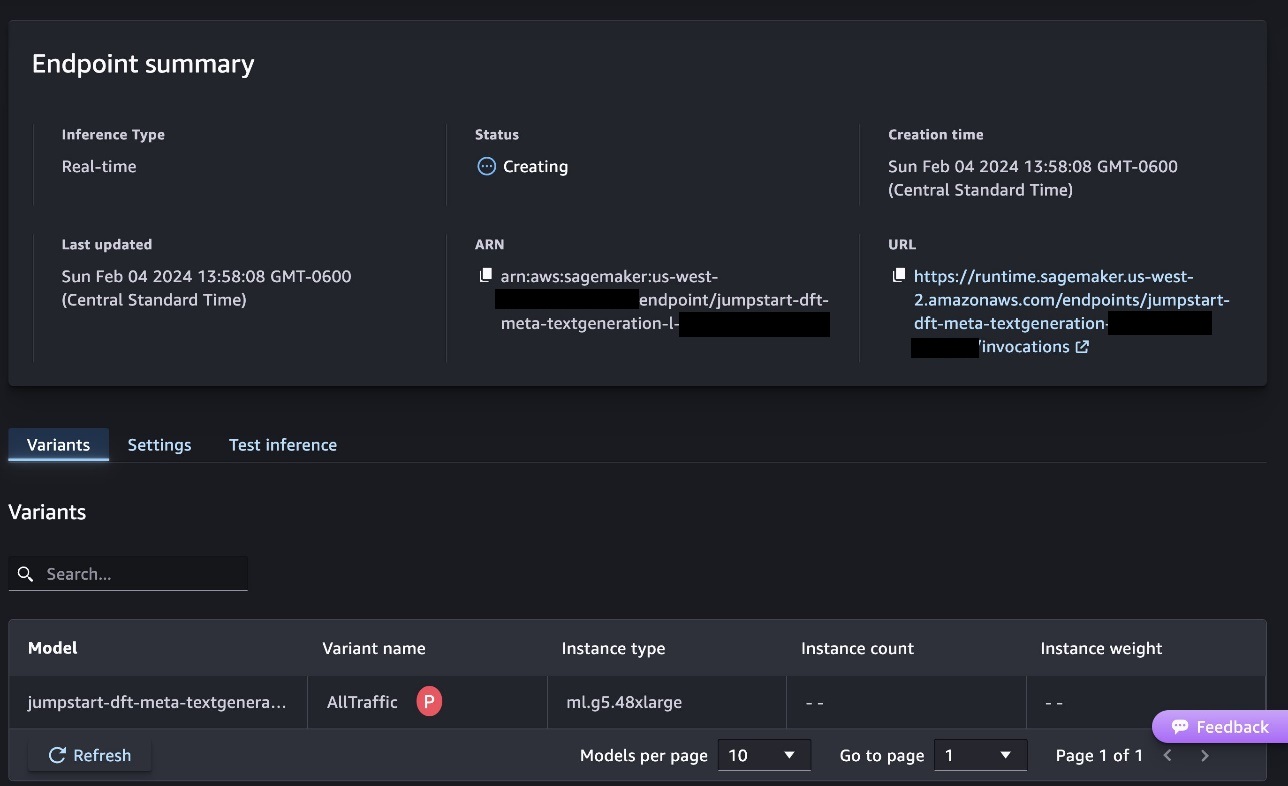

Seuraava kuvakaappaus näyttää päätepisteen asetukset. Voit muuttaa asetuksia tai käyttää oletusasetuksia.

- Hyväksy loppukäyttäjän lisenssisopimus (EULA) ja valitse Sijoittaa.

Tämä aloittaa päätepisteen käyttöönottoprosessin seuraavan kuvakaappauksen mukaisesti.

Ota malli käyttöön SageMaker Python SDK:n kanssa

Vaihtoehtoisesti voit ottaa käyttöön esimerkkimuistikirjan kautta valitsemalla Avaa Muistikirja Classic Studion mallitietosivulla. Esimerkkimuistikirja tarjoaa päästä päähän -ohjeita mallin käyttöönotosta päättelyyn ja resurssien puhdistamiseen.

Ottaaksesi käyttöön kannettavan tietokoneen, aloitamme valitsemalla sopivan mallin, jonka määrittelee model_id. Voit ottaa käyttöön mitä tahansa valituista malleista SageMakerissa seuraavalla koodilla:

Tämä ottaa mallin käyttöön SageMakerissa oletuskokoonpanoilla, mukaan lukien oletusinstanssityypit ja oletusarvoiset VPC-kokoonpanot. Voit muuttaa näitä määrityksiä määrittämällä ei-oletusarvoja JumpStartModel. Huomaa, että oletuksena accept_eula asetetaan False. Sinun on asetettava accept_eula=True ottaaksesi päätepisteen käyttöön onnistuneesti. Näin tekemällä hyväksyt aiemmin mainitun käyttöoikeussopimuksen ja hyväksyttävän käyttökäytännön. Voit myös download lisenssisopimus.

Kutsu SageMaker-päätepiste

Kun päätepiste on otettu käyttöön, voit tehdä päätelmiä käyttämällä Boto3:a tai SageMaker Python SDK:ta. Seuraavassa koodissa käytämme SageMaker Python SDK:ta mallin kutsumiseen johtopäätösten tekemiseksi ja vastauksen tulostamiseen:

Toiminto print_response ottaa hyötykuorman, joka koostuu hyötykuormasta ja mallivastauksesta, ja tulostaa tulosteen. Code Llama tukee monia parametreja suorittaessaan päätelmiä:

- Maksimi pituus – Malli luo tekstiä, kunnes tulosteen pituus (joka sisältää syötekontekstin pituuden) saavuttaa

max_length. Jos määritetään, sen on oltava positiivinen kokonaisluku. - max_new_tones – Malli luo tekstiä, kunnes tulosteen pituus (ilman syöttökontekstin pituutta) saavuttaa

max_new_tokens. Jos määritetään, sen on oltava positiivinen kokonaisluku. - palkkien lukumäärä – Tämä määrittää ahneessa haussa käytettyjen säteiden lukumäärän. Jos määritetään, sen on oltava suurempi tai yhtä suuri kokonaisluku kuin

num_return_sequences. - no_repeat_ngram_size – Malli varmistaa, että sanajono

no_repeat_ngram_sizeei toistu tulosjaksossa. Jos määritetään, sen on oltava positiivinen kokonaisluku, joka on suurempi kuin 1. - lämpötila – Tämä ohjaa lähdön satunnaisuutta. Korkeampi

temperaturetuloksena on tulossekvenssi, jossa on pieni todennäköisyys sanoja ja pienempitemperaturetuloksena on tulossekvenssi, jossa on suuren todennäköisyyden sanoja. Jostemperatureon 0, se johtaa ahneeseen dekoodaukseen. Jos määritetään, sen on oltava positiivinen float. - aikainen_pysähdys - Jos

True, tekstin luominen on valmis, kun kaikki sädehypoteesit saavuttavat lauseen lopussa. Jos määritetään, sen on oltava Boolen arvo. - do_sample - Jos

True, malli ottaa näytteitä seuraavasta sanasta todennäköisyyden mukaan. Jos määritetään, sen on oltava Boolen arvo. - top_k – Jokaisessa tekstin luomisen vaiheessa malli ottaa näytteitä vain

top_ktodennäköisimmin sanoja. Jos määritetään, sen on oltava positiivinen kokonaisluku. - top_p – Jokaisessa tekstin luomisen vaiheessa malli ottaa näytteitä pienimmästä mahdollisesta sanajoukosta kumulatiivisella todennäköisyydellä

top_p. Jos määritetty, sen on oltava kelluva 0 ja 1 välillä. - return_full_text - Jos

True, syöttöteksti on osa ulostulotekstiä. Jos määritetään, sen on oltava Boolen arvo. Sen oletusarvo onFalse. - pysäkki – Jos määritetty, sen on oltava merkkijonoluettelo. Tekstin luominen pysähtyy, jos jokin määritetyistä merkkijonoista luodaan.

Voit määrittää minkä tahansa näiden parametrien osajoukon kutsuessasi päätepistettä. Seuraavaksi näytämme esimerkin päätepisteen kutsumisesta näillä argumenteilla.

Koodin valmistuminen

Seuraavat esimerkit osoittavat, kuinka koodin viimeistely suoritetaan, kun odotettu päätepisteen vastaus on kehotteen luonnollinen jatko.

Suoritamme ensin seuraavan koodin:

Saamme seuraavan tuloksen:

Seuraavaa esimerkkiä varten suoritamme seuraavan koodin:

Saamme seuraavan tuloksen:

Koodin luonti

Seuraavat esimerkit osoittavat Python-koodin luomisen Code Llaman avulla.

Suoritamme ensin seuraavan koodin:

Saamme seuraavan tuloksen:

Seuraavaa esimerkkiä varten suoritamme seuraavan koodin:

Saamme seuraavan tuloksen:

Nämä ovat esimerkkejä koodiin liittyvistä tehtävistä Code Llama 70B:llä. Mallin avulla voit luoda vieläkin monimutkaisempaa koodia. Suosittelemme kokeilemaan sitä omien koodiin liittyvien käyttötapausten ja esimerkkien avulla!

Puhdistaa

Kun olet testannut päätepisteet, varmista, että poistat SageMaker-päätepäätepisteet ja mallin kulujen välttämiseksi. Käytä seuraavaa koodia:

Yhteenveto

Tässä viestissä esittelimme Code Llama 70B:n SageMaker JumpStartissa. Code Llama 70B on huippuluokan malli koodin luomiseen luonnollisen kielen kehotteista ja koodista. Voit ottaa mallin käyttöön muutamalla yksinkertaisella vaiheella SageMaker JumpStartissa ja käyttää sitä sitten koodiin liittyvien tehtävien suorittamiseen, kuten koodin luomiseen ja koodin täyttöön. Seuraavaksi kokeile mallin käyttöä omien koodiin liittyvien käyttötapausten ja tietojen kanssa.

Tietoja kirjoittajista

Tohtori Kyle Ulrich on soveltuva tutkija Amazon SageMaker JumpStart -tiimin kanssa. Hänen tutkimusalueitaan ovat skaalautuvat koneoppimisalgoritmit, tietokonenäkö, aikasarjat, Bayesin ei-parametrit ja Gaussin prosessit. Hänen tohtorinsa on Duken yliopistosta ja hän on julkaissut artikkeleita NeurIPS-, Cell- ja Neuron-julkaisuissa.

Tohtori Kyle Ulrich on soveltuva tutkija Amazon SageMaker JumpStart -tiimin kanssa. Hänen tutkimusalueitaan ovat skaalautuvat koneoppimisalgoritmit, tietokonenäkö, aikasarjat, Bayesin ei-parametrit ja Gaussin prosessit. Hänen tohtorinsa on Duken yliopistosta ja hän on julkaissut artikkeleita NeurIPS-, Cell- ja Neuron-julkaisuissa.

Tohtori Farooq Sabir on AWS:n vanhempi tekoäly- ja koneoppimisen asiantuntijaratkaisuarkkitehti. Hänellä on tohtorin ja MS:n tutkinnot sähkötekniikasta Texasin yliopistosta Austinista ja MS-tutkinto tietojenkäsittelytieteestä Georgia Institute of Technologysta. Hänellä on yli 15 vuoden työkokemus ja hän haluaa myös opettaa ja mentoroida korkeakouluopiskelijoita. AWS:ssä hän auttaa asiakkaita muotoilemaan ja ratkaisemaan liiketoimintaongelmiaan datatieteen, koneoppimisen, tietokonenäön, tekoälyn, numeerisen optimoinnin ja niihin liittyvien alojen aloilla. Hän asuu Dallasissa, Texasissa, ja hän ja hänen perheensä rakastavat matkustamista ja pitkiä matkoja.

Tohtori Farooq Sabir on AWS:n vanhempi tekoäly- ja koneoppimisen asiantuntijaratkaisuarkkitehti. Hänellä on tohtorin ja MS:n tutkinnot sähkötekniikasta Texasin yliopistosta Austinista ja MS-tutkinto tietojenkäsittelytieteestä Georgia Institute of Technologysta. Hänellä on yli 15 vuoden työkokemus ja hän haluaa myös opettaa ja mentoroida korkeakouluopiskelijoita. AWS:ssä hän auttaa asiakkaita muotoilemaan ja ratkaisemaan liiketoimintaongelmiaan datatieteen, koneoppimisen, tietokonenäön, tekoälyn, numeerisen optimoinnin ja niihin liittyvien alojen aloilla. Hän asuu Dallasissa, Texasissa, ja hän ja hänen perheensä rakastavat matkustamista ja pitkiä matkoja.

Kesäkuu voitti on SageMaker JumpStartin tuotepäällikkö. Hän keskittyy tekemään perusmalleista helposti löydettäviä ja käyttökelpoisia auttamaan asiakkaita luomaan luovia tekoälysovelluksia. Hänen kokemukseensa Amazonista kuuluu myös mobiiliostossovellus ja viimeinen mailitoimitus.

Kesäkuu voitti on SageMaker JumpStartin tuotepäällikkö. Hän keskittyy tekemään perusmalleista helposti löydettäviä ja käyttökelpoisia auttamaan asiakkaita luomaan luovia tekoälysovelluksia. Hänen kokemukseensa Amazonista kuuluu myös mobiiliostossovellus ja viimeinen mailitoimitus.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://aws.amazon.com/blogs/machine-learning/code-llama-70b-is-now-available-in-amazon-sagemaker-jumpstart/

- :on

- :On

- :ei

- :missä

- $ YLÖS

- 000

- 1

- 10

- 100

- 11

- 12

- 13

- 14

- 15 vuotta

- 15%

- 16

- 22

- 25

- 500

- 7

- 80

- 9

- a

- Meistä

- Hyväksyä

- hyväksyttävä

- hyväksyminen

- pääsy

- ennakot

- sopimus

- AI

- algoritmit

- Kaikki

- Myös

- Amazon

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Amazon Web Services

- an

- ja

- Ilmoittaa

- Kaikki

- Hakemus

- sovellukset

- sovellettu

- sopiva

- OVAT

- perustelut

- Art

- keinotekoinen

- tekoäly

- Keinotekoinen älykkyys ja koneoppiminen

- AS

- Avustaja

- varma

- At

- Austin

- saatavissa

- välttää

- AWS

- pohja

- perustua

- kemut

- Bayes

- BE

- Palkki

- koska

- välillä

- Miljardi

- Miljardeja tokeneja

- miljardeja

- sekä

- kupla

- rakentaa

- rakennettu

- liiketoiminta

- by

- C + +

- soittaa

- CAN

- kykenee

- kortti

- kuljettaa

- tapauksissa

- Kategoria

- solu

- muuttaa

- ominaisuudet

- maksut

- Valita

- valita

- luokka

- klassinen

- puhdas

- napsauttaa

- koodi

- College

- Tulla

- tulee

- täydellinen

- valmistuminen

- monimutkainen

- tietokone

- Tietojenkäsittelyoppi

- Tietokoneen visio

- Koostuu

- Console

- pitoisuus

- tausta

- jatkaminen

- valvonta

- kattaa

- luoda

- kuratoitu

- Asiakkaat

- Dallas

- tiedot

- tietojenkäsittely

- Dekoodaus

- oletusarvo

- toimitus

- osoittaa

- sijoittaa

- käyttöön

- käyttöönotto

- lauennut

- suunniteltu

- yksityiskohta

- kehitetty

- kehittäjille

- Kehitys

- eri

- digitaalinen

- digitaalinen taide

- löytää

- do

- tekee

- verkkotunnuksia

- Herttua

- herttua yliopisto

- kukin

- Aikaisemmin

- helposti

- tehokas

- mahdollistaa

- kannustaa

- loppu

- päittäin

- päätepiste

- suunniteltu

- Tekniikka

- varmistaa

- yhtäläinen

- virhe

- arviointiin

- Jopa

- esimerkki

- Esimerkit

- kunnostautua

- Paitsi

- innoissaan

- lukuun ottamatta

- olemassa

- odotettu

- kallis

- experience

- räjähdysmäinen

- Kasvot

- perhe

- harvat

- Löytää

- Etunimi

- kellua

- keskittyy

- jälkeen

- varten

- perusta

- perustava

- neljä

- alkaen

- toiminto

- tuottaa

- syntyy

- synnyttää

- tuottaa

- sukupolvi

- sukupolvet

- generatiivinen

- Generatiivinen AI

- Georgia

- saada

- tietty

- Go

- suurempi

- Ahne

- ohjaus

- Olla

- he

- auttaa

- auttaa

- auttaa

- korkealaatuisia

- korkeampi

- hänen

- pitää

- Etusivu

- isäntä

- isännöi

- Miten

- Miten

- HTTPS

- Napa

- navat

- i

- ihanteellinen

- if

- tuoda

- parantaa

- parannuksia

- in

- sisältää

- sisältää

- Mukaan lukien

- inkrementaalinen

- tiedot

- panos

- tuloa

- esimerkki

- Instituutti

- ohjeet

- Älykkyys

- etu

- käyttöön

- IT

- Jaava

- jpg

- tunnettu

- Kyle

- Kieli

- suuri

- Sukunimi

- oppiminen

- jättäen

- Pituus

- Lisenssi

- todennäköisyys

- Todennäköisesti

- tykkää

- Lista

- liekki

- OTK

- Pitkät

- rakkaus

- alentaa

- kone

- koneoppiminen

- tehty

- tehdä

- Tekeminen

- johtaja

- monet

- mainitsi

- opastaja

- Meta

- maili

- ML

- Puhelinnumero

- malli

- mallit

- lisää

- tehokkaampi

- eniten

- MS

- täytyy

- Luonnollinen

- suunnistus

- Tarve

- tarvitaan

- ei ikinä

- Uusi

- seuraava

- huomata

- muistikirja

- nyt

- numero

- of

- on

- ONE

- yhdet

- vain

- optimointi

- Vaihtoehdot

- or

- meidän

- ulos

- ulostulo

- yli

- oma

- sivulla

- lasi

- paperit

- parametrit

- osa

- osapuolet

- varten

- Suorittaa

- esittävä

- phd

- PHP

- Platon

- Platonin tietotieto

- PlatonData

- politiikka

- Suosittu

- positiivinen

- mahdollinen

- Kirje

- mahdollinen

- Predictor

- Painaa

- tulosteet

- ongelmia

- prosessi

- Prosessit

- Tuotteet

- tuotepäällikkö

- tuottavuus

- Ohjelmointi

- ohjeita

- toimittaa

- tarjoajat

- tarjoaa

- julkaistu

- Python

- pytorch

- nopeasti

- satunnaisuuden

- alue

- pikemminkin

- tavoittaa

- saavuttaa

- äskettäinen

- liittyvä

- julkaistu

- toistuva

- tutkimus

- Esittelymateriaalit

- vastaus

- REST

- tulokset

- palata

- käänteinen

- arviot

- Nousta

- tie

- ajaa

- juoksu

- sagemaker

- SageMaker-johtopäätös

- sama

- Säästä

- skaalautuva

- Asteikko

- tiede

- Tiedemies

- sdk

- Haku

- valittu

- valitsemalla

- vanhempi

- tuomita

- Järjestys

- Sarjat

- Palvelut

- setti

- settings

- yhteinen

- Ostokset

- näyttää

- esitetty

- Näytä

- Yksinkertainen

- koot

- So

- Tuotteemme

- Ratkaisumme

- SOLVE

- jonkin verran

- asiantuntija

- erikoistunut

- määritelty

- määrittelemällä

- vakaa

- Alkaa

- alkoi

- huippu-

- Vaihe

- Askeleet

- Lopettaa

- jono

- Opiskelijat

- studio

- Onnistuneesti

- niin

- tuki

- Tukee

- varma

- ympäröivä

- vie

- tehtävät

- joukkue-

- Elektroniikka

- tensorflow

- ehdot

- testi

- testattu

- texas

- teksti

- kuin

- että

- -

- heidän

- Niitä

- itse

- sitten

- Nämä

- kolmas

- kolmannet osapuolet

- tätä

- kolmella

- Kautta

- aika

- Aikasarja

- että

- symbolinen

- tokens

- ylin

- Juna

- koulutettu

- Kääntäminen

- matkustaa

- ylitys

- totta

- yrittää

- tyyppi

- konekirjoitusteksti

- tyypillisesti

- ui

- varten

- ymmärtäminen

- yliopisto

- asti

- käyttökelpoinen

- Käyttö

- käyttää

- käytetty

- käyttäjä

- käyttämällä

- arvo

- arvot

- lajike

- versio

- kautta

- visio

- kävellä

- haluta

- we

- verkko

- verkkopalvelut

- HYVIN

- olivat

- kun

- onko

- joka

- vaikka

- leveä

- vekotin

- tulee

- with

- sisällä

- ilman

- sana

- sanoja

- Referenssit

- työnkulku

- työnkulkuja

- kirjoittaa

- vuotta

- Voit

- Sinun

- zephyrnet