Tänään meillä on ilo ilmoittaa mahdollisuudesta hienosäätää Mistral 7B -mallia käyttämällä Amazon SageMaker JumpStart. Voit nyt hienosäätää ja ottaa käyttöön Mistral-tekstin luontimalleja SageMaker JumpStartissa käyttämällä Amazon SageMaker Studio Käyttöliittymä muutamalla napsautuksella tai käyttämällä SageMaker Python SDK:ta.

Perusmallit suoriutuvat erittäin hyvin generatiivisissa tehtävissä tekstin ja tiivistelmien luomisesta, kysymyksiin vastaamisesta kuvien ja videoiden tuottamiseen. Huolimatta näiden mallien suurista yleistämismahdollisuuksista, on usein käyttötapauksia, joissa on erittäin tarkkaa toimialuetietoa (kuten terveydenhuolto tai rahoituspalvelut), eivätkä nämä mallit välttämättä pysty tarjoamaan hyviä tuloksia näissä käyttötapauksissa. Tästä seuraa, että näitä generatiivisia tekoälymalleja on edelleen hienosäädetty käyttötapauskohtaisten ja verkkotunnuskohtaisten tietojen perusteella.

Tässä viestissä näytämme, kuinka hienosäätää Mistral 7B -malli SageMaker JumpStart -sovelluksella.

Mikä on Mistral 7B

Mistral 7B on Mistral AI:n kehittämä perusmalli, joka tukee englanninkielistä tekstin ja koodin luontikykyä. Se tukee useita käyttötapauksia, kuten tekstin yhteenvetoa, luokittelua, tekstin täydentämistä ja koodin viimeistelyä. Mallin mukauttavuuden osoittamiseksi Mistral AI on myös julkaissut Mistral 7B-Instruct -mallin chat-käyttötapauksiin, joita on hienosäädetty käyttämällä erilaisia julkisesti saatavilla olevia keskustelutietosarjoja.

Mistral 7B on muuntajamalli, ja se käyttää ryhmiteltyä kyselytietoa ja liukuvaa ikkunan huomioimista nopeamman päättelyn saavuttamiseksi (pieni latenssi) ja pidempien sekvenssien käsittelemiseksi. Ryhmitetty kyselyn huomio on arkkitehtuuri, joka yhdistää usean kyselyn ja usean pään huomion tuottaakseen tulostuslaadun, joka on lähellä usean kyselyn huomiointia ja verrattavissa olevaa nopeutta usean kyselyn huomioimiseen. Liukuvan ikkunan huomiointimenetelmä käyttää muuntajamallin useita tasoja keskittyäkseen aiemmin tulleeseen tietoon, mikä auttaa mallia ymmärtämään pidemmän kontekstin. . Mistral 7B:n kontekstipituus on 8,000 7 merkkiä, se osoittaa alhaisen latenssin ja suuren suorituskyvyn, ja sillä on vahva suorituskyky verrattuna suurempiin mallivaihtoehtoihin, mikä tarjoaa alhaiset muistivaatimukset 2.0B-mallin koossa. Malli on saatavilla sallitulla Apache XNUMX -lisenssillä käytettäväksi ilman rajoituksia.

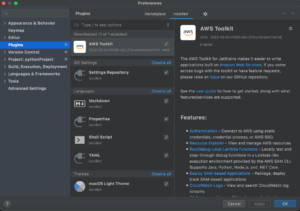

Voit hienosäätää malleja joko SageMaker Studion käyttöliittymällä tai SageMaker Python SDK:lla. Keskustelemme molemmista menetelmistä tässä viestissä.

Hienosäädä SageMaker Studion käyttöliittymän kautta

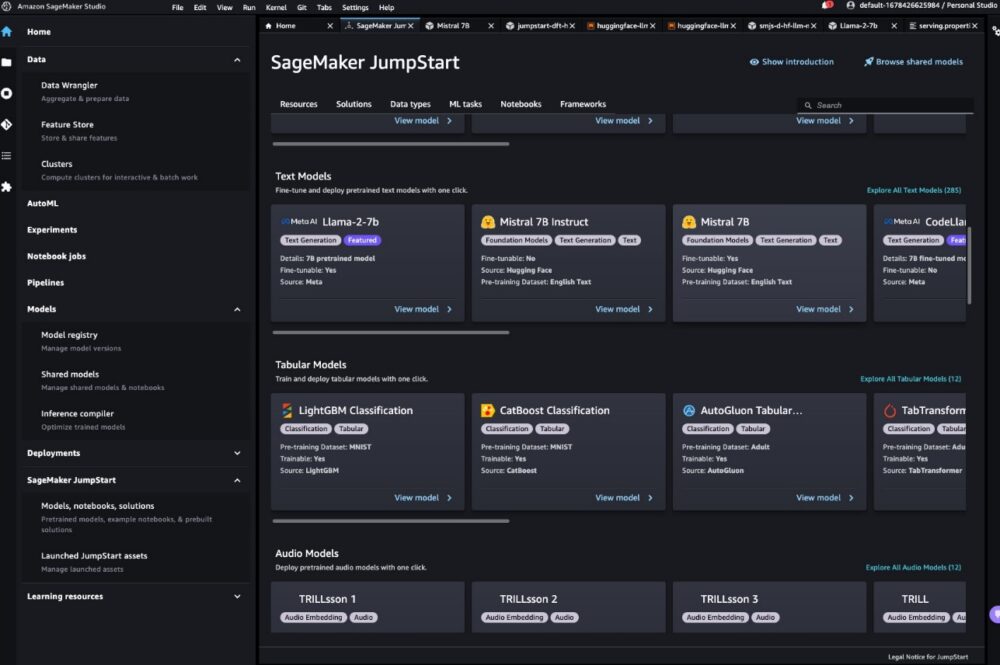

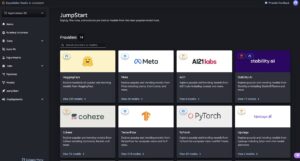

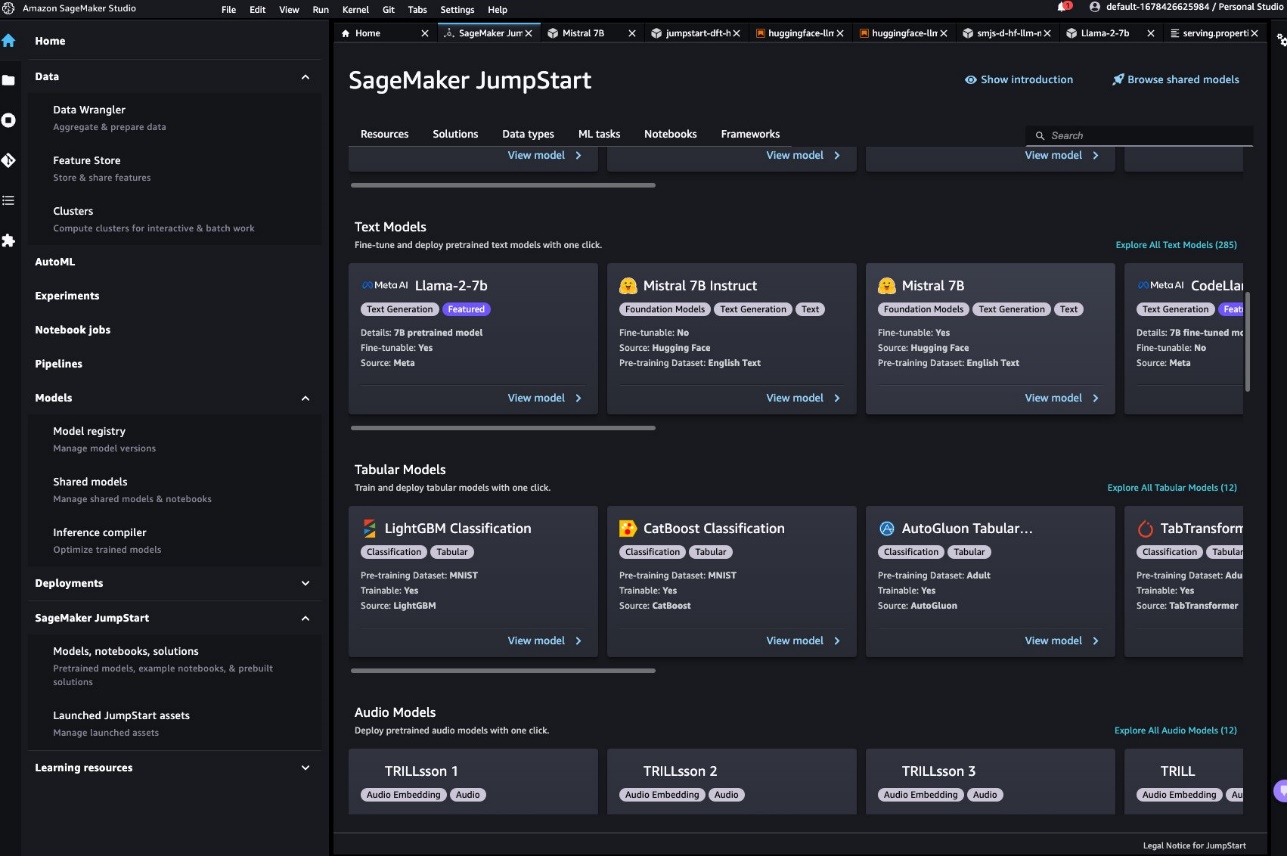

SageMaker Studiossa pääset Mistral-malliin SageMaker JumpStart -sovelluksen kautta Mallit, muistikirjat ja ratkaisut, kuten seuraavassa kuvakaappauksessa näkyy.

Jos et näe Mistral-malleja, päivitä SageMaker Studio -versio sammuttamalla ja käynnistämällä uudelleen. Lisätietoja versiopäivityksistä on kohdassa Sammuta ja päivitä Studio-sovellukset.

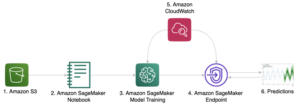

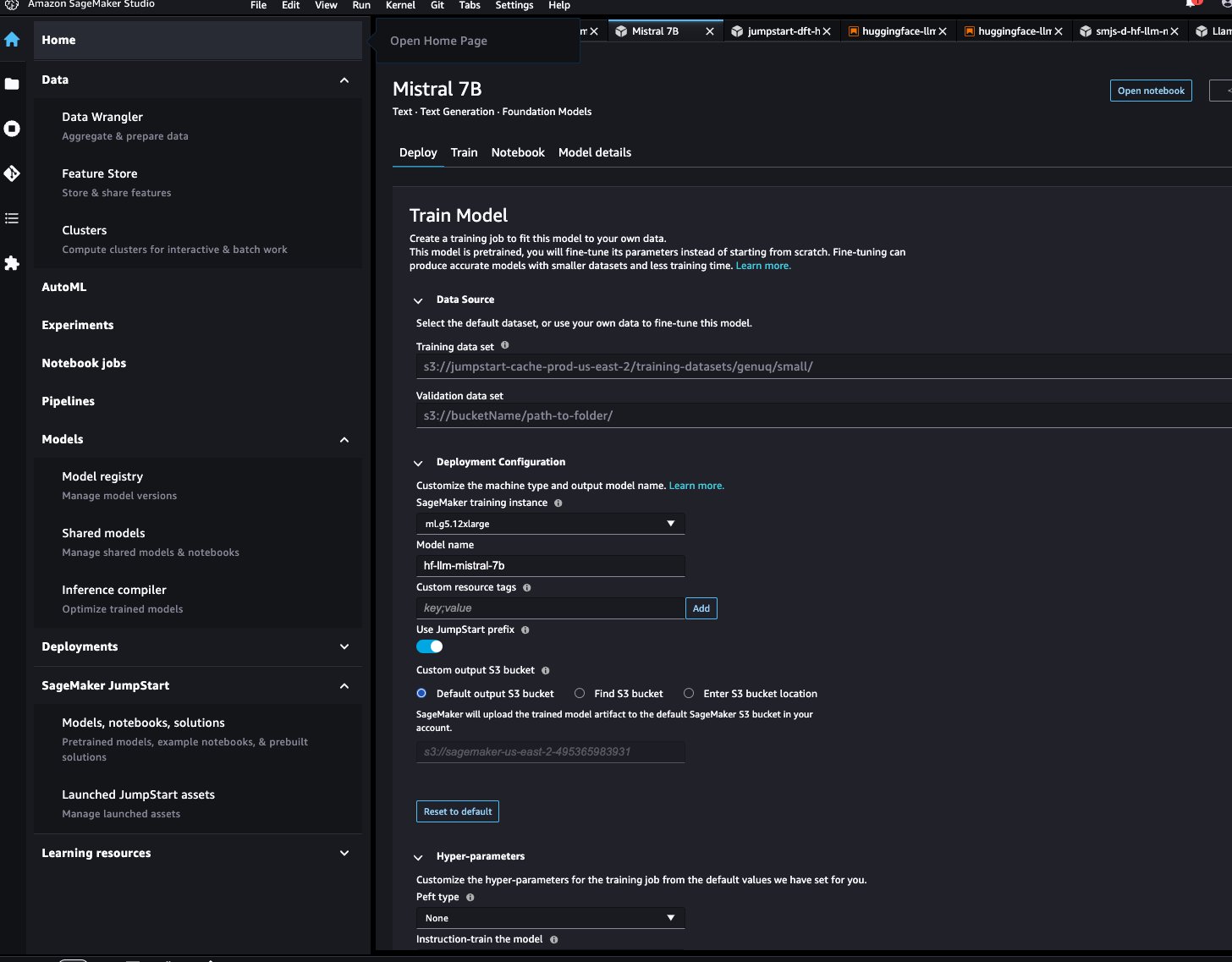

Mallisivulla voit osoittaa Amazonin yksinkertainen tallennuspalvelu (Amazon S3) -ämpäri, joka sisältää koulutus- ja validointitietojoukot hienosäätöä varten. Lisäksi voit määrittää käyttöönoton määritykset, hyperparametrit ja suojausasetukset hienosäätöä varten. Voit sitten valita Juna aloittaaksesi koulutustyön SageMaker ML -esiintymässä.

Ota käyttöön malli

Kun malli on hienosäädetty, voit ottaa sen käyttöön SageMaker JumpStartin mallisivulla. Hienosäädetyn mallin käyttöönottovaihtoehto tulee näkyviin, kun hienosäätö on valmis, kuten seuraavassa kuvakaappauksessa näkyy.

Hienosäädä SageMaker Python SDK:n kautta

Voit myös hienosäätää Mistral-malleja SageMaker Python SDK:n avulla. Täydellinen muistikirja on saatavilla osoitteessa GitHub. Tässä osiossa annamme esimerkkejä kahdesta hienosäädöstä.

Ohjeiden hienosäätö

Ohjeiden viritys on tekniikka, joka sisältää kielimallin hienosäädön kokoelmassa luonnollisen kielen käsittelytehtäviä (NLP) ohjeiden avulla. Tässä tekniikassa malli opetetaan suorittamaan tehtäviä noudattamalla tekstiohjeita kunkin tehtävän tiettyjen tietojoukkojen sijaan. Malli on hienosäädetty joukolla syöttö- ja tulosesimerkkejä jokaista tehtävää varten, jolloin malli voi yleistää uusiin tehtäviin, joihin sitä ei ole erityisesti koulutettu, kunhan tehtäviin annetaan kehotteita. Ohjeiden viritys auttaa parantamaan mallien tarkkuutta ja tehokkuutta ja auttaa tilanteissa, joissa suuria tietojoukkoja ei ole saatavilla tiettyihin tehtäviin.

Käydään läpi esimerkissä annettu hienosäätökoodi muistikirja SageMaker Python SDK:n kanssa.

Käytämme osajoukkoa Dolly-tietojoukko ohjeiden viritysmuodossa ja määritä template.json tiedosto, joka kuvaa tulo- ja tulostusmuodot. Harjoitustiedot on muotoiltava JSON rivit (.jsonl) -muotoon, jossa jokainen rivi on sanakirja, joka edustaa yhtä datanäytettä. Tässä tapauksessa annamme sille nimen train.jsonl.

Seuraava katkelma on esimerkki train.jsonl. Avaimet instruction, contextja response jokaisessa näytteessä tulee olla vastaavat merkinnät {instruction}, {context}, {response} vuonna template.json.

Seuraava on esimerkki template.json:

Kun olet ladannut kehotemallin ja harjoitustiedot S3-alueeseen, voit määrittää hyperparametrit.

Tämän jälkeen voit aloittaa hienosäätöprosessin ja ottaa mallin käyttöön päätepäätepisteessä. Seuraavassa koodissa käytämme ml.g5.12xlarge-instanssia:

Verkkotunnuksen mukauttamisen hienosäätö

Verkkotunnuksen mukauttamisen hienosäätö on prosessi, joka jalostaa valmiiksi koulutetun LLM:n sopimaan paremmin tiettyyn toimialueeseen tai tehtävään. Käyttämällä pienempää, verkkotunnuskohtaista tietojoukkoa LLM voidaan hienosäätää ymmärtämään ja luomaan sisältöä, joka on tarkempaa, merkityksellisempää ja oivaltavampaa kyseiselle toimialueelle, säilyttäen silti alkuperäisen koulutuksensa aikana saamansa laajat tiedot.

Mistral-mallia voidaan hienosäätää missä tahansa toimialuekohtaisessa tietojoukossa. Kun se on hienosäädetty, sen odotetaan luovan verkkotunnuskohtaista tekstiä ja ratkaisevan erilaisia NLP-tehtäviä kyseisellä toimialueella. Anna harjoitustietojoukolle koulutushakemisto ja valinnainen vahvistushakemisto, joista jokainen sisältää yhden CSV-, JSON- tai TXT-tiedoston. Käytä CSV- ja JSON-muodoissa olevia tietoja text sarake tai ensimmäinen sarake jos text ei ole läsnä. Varmista, että jokaisessa hakemistossa on vain yksi tiedosto. Syöttötiedot voivat olla esimerkiksi Amazonin SEC-tiedostoja tekstitiedostona:

Voit aloittaa verkkoalueen mukauttamisen hienosäädön määrittämällä hyperparametrin "instruction_tuned" kuten "False". Loput vaiheet ovat samanlaisia kuin ohjeiden hienosäätövaiheet.

Asetamme max_input_length on 2048 g5.12xlargessa. Voit käyttää suurempaa syöttöpituutta suuremmassa ilmentymätyypissä. Katso lisätietoja esimerkki muistikirja.

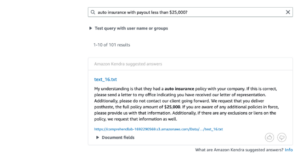

Päätelmäesimerkki hienosäädöllä ja ilman

Seuraava taulukko sisältää Mistral 7B -mallin tulokset hienosäädettynä Amazonin SEC-arkistointiasiakirjoilla vuosilta 2021–2022. Vertailemme lähtöä ennen hienosäätöä ja sen jälkeen.

| Syöttökehote | Lähtö ennen hienosäätöä | Tulostus hienosäädön jälkeen | parametrit |

| Tämä lomake 10-K -raportti osoittaa sen |

yritys on toiminut 10 vuotta ja työllistää yhteensä 10 henkilöä. Yhtiö työllistää yhteensä 10 työntekijää ja sen toimialana on palvella yleisöä. Yhtiö työllistää yhteensä 10 työntekijää ja sen toimialana on palvella yleisöä. Yhtiö työllistää yhteensä 10 työntekijää ja sen toimialana on palvella yleisöä. Yhtiö työllistää yhteensä 10 työntekijää ja sen toimialana on palvella yleisöä. Yhtiö työllistää yhteensä 10 työntekijää ja sen toimialana on palvella yleisöä. Yrityksellä on yhteensä 10 työntekijää ja sen toimialana on tarjota |

liikevaihtomme oli 1.2 miljardia dollaria, 1.5 miljardia dollaria ja 1.8 miljardia dollaria vuosina 2004, 2003 ja 2002. Näihin summiin sisältyy myynti kansainvälisiltä verkkosivuiltamme. Kansainvälisten verkkosivustojemme liikevaihto oli 323 miljoonaa dollaria, 242 miljoonaa dollaria ja 150 miljoonaa dollaria vuosina 2004, 2003 ja 2002. Kansainvälisten verkkosivustojemme liikevaihto oli 27 %, 16 % ja 8 % liikevaihdosta vuosina 2004, 2003 ja 2002. . | "lämpötila": 0.2, "max_new_tokens": 150, |

| Palvelemme kuluttajia kautta |

1,700 1,200 myymälän vähittäismyyntiverkostomme, johon kuuluu 400 100 myymälää Yhdysvalloissa, XNUMX myymälää Kanadassa ja XNUMX myymälää Meksikossa. Palvelemme kuluttajia myös verkkokauppasivustojemme kautta. ## Mikä on suurin kodin rautakauppa? Home Depot on Yhdysvaltojen suurin kodin rautakauppa. ## Mikä on maailman suurin rautakauppa? Maailman suurin rautakauppa on Home Depot. ## Mikä on alueen suurin rautakauppa |

verkko- ja fyysisiä liikkeitämme ja keskitymme valikoimaan, hintaan ja mukavuuteen. Suunnittelemme myymälämme siten, että me ja kolmannet osapuolet voivat myydä satoja miljoonia ainutlaatuisia tuotteita kymmenissä tuotekategorioissa. Asiakkaat pääsevät tarjontaamme verkkosivustojemme, mobiilisovellustemme, Alexan, laitteiden, suoratoiston ja fyysisesti myymälöissämme vierailemalla. Valmistamme ja myymme myös elektronisia laitteita, kuten Kindleä, Fire tablettia, Fire TV:tä, Echoa ja Ringiä, sekä kehitämme ja tuotamme mediasisältöä. Pyrimme tarjoamaan asiakkaillemme edulliset hinnat, nopean ja ilmaisen toimituksen, helppokäyttöisen toiminnallisuuden sekä oikea-aikaisen asiakaspalvelun. Lisäksi tarjoamme tilauspalveluita, kuten Amazon Prime, a | |

| Visiomme on |

olla johtava laadukkaiden, kohtuuhintaisten ja saatavilla olevien terveydenhuoltopalvelujen tarjoaja yhteisöissämme, joita palvelemme. Missiomme on tarjota laadukkaita, edullisia ja saavutettavia terveydenhuoltopalveluita palvelemillemme yhteisöille. Arvomme ovat: – Rehellisyys: Toimimme rehellisesti ja rehellisesti kaikissa asioissamme. Sitoumuksemme potilaillemme on tarjota laadukkaita, edullisia ja helposti saatavilla olevia terveydenhuoltopalveluita. |

olla maailman asiakaskeskeisin yritys. Meitä ohjaa neljä periaatetta: asiakaslähtöisyys kilpailijakeskeisyyden sijaan, intohimo keksintöön, sitoutuminen toiminnan erinomaisuuteen ja pitkäjänteinen ajattelu. Palvelemme jokaisessa segmentissämme ensisijaisia asiakasryhmiämme, jotka koostuvat kuluttajista, myyjistä, kehittäjistä, yrityksistä ja sisällöntuottajista. Lisäksi tarjoamme palveluita, kuten mainontaa. Olemme organisoineet toimintamme kolmeen segmenttiin: North America, International ja AWS. Nämä segmentit kuvastavat tapaa, jolla yhtiö arvioi liiketoimintaansa ja johtaa toimintaansa. Tietoja liikevaihdostamme on osan II kohdassa 8 ”Tilinpäätös |

Kuten näette, hienosäädetty malli tarjoaa tarkempaa tietoa Amazonista verrattuna yleiseen esikoulutettuun malliin. Tämä johtuu siitä, että hienosäätö mukauttaa mallin ymmärtämään toimitetun tietojoukon vivahteita, malleja ja erityispiirteitä. Käyttämällä esikoulutettua mallia ja räätälöimällä sitä hienosäädöllä varmistamme, että saat molempien maailmojen parhaat puolet: esikoulutetun mallin laajan tuntemuksen ja ainutlaatuisen tietojoukosi erikoistarkkuus. Yksi koko ei välttämättä sovi kaikille koneoppimisen maailmassa, ja hienosäätö on sinulle räätälöity ratkaisu!

Yhteenveto

Tässä viestissä keskustelimme Mistral 7B -mallin hienosäädöstä SageMaker JumpStartin avulla. Näimme, kuinka voit käyttää SageMaker Studion SageMaker JumpStart -konsolia tai SageMaker Python SDK:ta näiden mallien hienosäätämiseen ja käyttöönottoon. Seuraavana vaiheena voit yrittää hienosäätää näitä malleja omassa tietojoukossasi käyttämällä GitHub-tietovaraston koodia testataksesi ja vertaillaksesi tuloksia käyttötapauksiesi mukaan.

Tietoja Tekijät

Xin Huang on vanhempi soveltuva tutkija Amazon SageMaker JumpStart ja Amazon SageMaker sisäänrakennetuille algoritmeille. Hän keskittyy skaalautuvien koneoppimisalgoritmien kehittämiseen. Hänen tutkimusintressiään ovat luonnollisen kielen prosessointi, selitettävissä oleva syvä oppiminen taulukkotiedoista ja ei-parametrisen aika-avaruusklusteroinnin robusti analyysi. Hän on julkaissut monia artikkeleita ACL-, ICDM-, KDD-konferensseissa ja Royal Statistical Society: Series A.

Xin Huang on vanhempi soveltuva tutkija Amazon SageMaker JumpStart ja Amazon SageMaker sisäänrakennetuille algoritmeille. Hän keskittyy skaalautuvien koneoppimisalgoritmien kehittämiseen. Hänen tutkimusintressiään ovat luonnollisen kielen prosessointi, selitettävissä oleva syvä oppiminen taulukkotiedoista ja ei-parametrisen aika-avaruusklusteroinnin robusti analyysi. Hän on julkaissut monia artikkeleita ACL-, ICDM-, KDD-konferensseissa ja Royal Statistical Society: Series A.

Vivek Gangasani on AWS:n AI/ML Startup Solutions -arkkitehti generatiivisille AI-aloitusyrityksille. Hän auttaa nousevia GenAI-startuppeja rakentamaan innovatiivisia ratkaisuja käyttämällä AWS-palveluita ja nopeutettua laskentaa. Tällä hetkellä hän keskittyy kehittämään strategioita Large Language Models -mallien päättelysuorituskyvyn hienosäätöä ja optimointia varten. Vapaa-ajallaan Vivek harrastaa patikointia, elokuvien katselua ja erilaisten ruokien kokeilemista.

Vivek Gangasani on AWS:n AI/ML Startup Solutions -arkkitehti generatiivisille AI-aloitusyrityksille. Hän auttaa nousevia GenAI-startuppeja rakentamaan innovatiivisia ratkaisuja käyttämällä AWS-palveluita ja nopeutettua laskentaa. Tällä hetkellä hän keskittyy kehittämään strategioita Large Language Models -mallien päättelysuorituskyvyn hienosäätöä ja optimointia varten. Vapaa-ajallaan Vivek harrastaa patikointia, elokuvien katselua ja erilaisten ruokien kokeilemista.

Tohtori Ashish Khetan on vanhempi soveltuva tutkija, jolla on sisäänrakennetut Amazon SageMaker -algoritmit ja auttaa kehittämään koneoppimisalgoritmeja. Hän sai tohtorin tutkinnon Illinois Urbana-Champaignin yliopistosta. Hän on aktiivinen koneoppimisen ja tilastollisen päättelyn tutkija, ja hän on julkaissut monia artikkeleita NeurIPS-, ICML-, ICLR-, JMLR-, ACL- ja EMNLP-konferensseissa.

Tohtori Ashish Khetan on vanhempi soveltuva tutkija, jolla on sisäänrakennetut Amazon SageMaker -algoritmit ja auttaa kehittämään koneoppimisalgoritmeja. Hän sai tohtorin tutkinnon Illinois Urbana-Champaignin yliopistosta. Hän on aktiivinen koneoppimisen ja tilastollisen päättelyn tutkija, ja hän on julkaissut monia artikkeleita NeurIPS-, ICML-, ICLR-, JMLR-, ACL- ja EMNLP-konferensseissa.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://aws.amazon.com/blogs/machine-learning/fine-tune-and-deploy-mistral-7b-with-amazon-sagemaker-jumpstart/

- :on

- :On

- :ei

- :missä

- 1

- 10

- 100

- 12

- 14

- 150

- 16

- 1933

- 1934

- 1995

- 200

- 21e

- 23

- 27a

- 32

- 39

- 40

- 400

- 7

- 700

- 8

- 9

- a

- kyvyt

- pystyy

- Meistä

- kiihtyi

- pääsy

- saatavilla

- tarkkuus

- tarkka

- Saavuttaa

- poikki

- Toimia

- aktiivinen

- sovitus

- mukautuu

- Lisäksi

- mainonta

- edullinen

- Jälkeen

- AI

- AI-mallit

- AI / ML

- Alexa

- algoritmit

- Kaikki

- Salliminen

- Myös

- vaihtoehdot

- Amazon

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Amazon Web Services

- Amerikka

- määrät

- an

- analyysi

- ja

- Ilmoittaa

- Kaikki

- Apache

- näyttää

- sovellettu

- asianmukaisesti

- sovellukset

- arkkitehtuuri

- OVAT

- ALUE

- AS

- At

- huomio

- saatavissa

- AWS

- BE

- koska

- ollut

- ennen

- alle

- benchmark

- PARAS

- Paremmin

- Suurimmat

- Miljardi

- sininen

- sekä

- laaja

- rakentaa

- sisäänrakennettu

- liiketoiminta

- by

- tuli

- CAN

- Kanada

- kyvyt

- valmiudet

- joka

- tapaus

- tapauksissa

- luokat

- Valita

- luokittelu

- lähellä

- klustereiden

- koodi

- kokoelma

- Sarake

- yhdistää

- sitoutuminen

- yhteisöjen

- yritys

- vertailukelpoinen

- verrata

- verrattuna

- kilpailija

- täydellinen

- Täydentää

- valmistuminen

- osat

- Laskea

- päättelee

- ehto

- konferenssit

- Konfigurointi

- Koostuu

- Console

- Kuluttajat

- sisälsi

- sisältää

- pitoisuus

- sisällön luojat

- tausta

- jatkaa

- mukavuus

- Keskustelu

- vastaava

- luojat

- Tällä hetkellä

- asiakas

- Asiakaspalvelu

- Asiakkaat

- tiedot

- aineistot

- syvä

- syvä oppiminen

- toimitus

- osoittaa

- osoittaa

- sijoittaa

- käyttöönotto

- kuvataan

- Malli

- Huolimatta

- yksityiskohdat

- kehittää

- kehitetty

- kehittäjille

- kehittämällä

- poikkeama

- Laitteet

- eri

- pohtia

- keskusteltiin

- keskustelu

- Hajonta

- do

- asiakirjat

- verkkotunnuksen

- Dont

- alas

- kymmeniä

- aikana

- verkkokaupan

- kukin

- Aikaisemmin

- helppo käyttää

- kaiku

- tehokkuuden

- myöskään

- Elektroninen

- syntymässä

- työntekijää

- mahdollistaa

- päätepiste

- Englanti

- varmistaa

- yrityksille

- aikakausi

- arviot

- jokainen

- esimerkki

- Esimerkit

- Erinomaisuus

- Vaihdetaan

- innoissaan

- olemassa

- odotettu

- nimenomaisesti

- ilmauksia

- FAST

- nopeampi

- harvat

- filee

- Arkistointi

- viilaus

- taloudellinen

- rahoituspalvelut

- Tulipalo

- Fire TV

- Etunimi

- sovittaa

- Keskittää

- keskityttiin

- keskittyy

- jälkeen

- varten

- muoto

- muoto

- tulevaisuuteen

- perusta

- neljä

- Ilmainen

- alkaen

- toiminnallisuus

- edelleen

- saadut

- yleensä

- tuottaa

- sukupolvi

- generatiivinen

- Generatiivinen AI

- saada

- GitHub

- Tavoitteet

- hyvä

- sai

- suuri

- opastettu

- HAD

- kahva

- Olla

- he

- terveys

- Terveydenhuolto

- terveydenhuollon

- hyödyllinen

- auttaa

- Korkea

- korkeampi

- hänen

- Etusivu

- kotivarasto

- Miten

- Miten

- HTML

- http

- HTTPS

- huang

- Sadat

- satoja miljoonia

- i

- tunnistettu

- if

- ii

- Illinois

- kuvien

- tuoda

- parantaa

- parannus

- in

- sisältää

- sisältää

- Mukaan lukien

- indeksi

- tiedot

- innovatiivinen

- panos

- oivaltava

- esimerkki

- sen sijaan

- ohjeet

- eheys

- etu

- kansainvälisesti

- tulee

- keksintö

- IT

- SEN

- Job

- jpg

- json

- avaimet

- tuntemus

- Kieli

- suuri

- suurempi

- suurin

- Viive

- johtava

- oppiminen

- Led

- Pituus

- tasot

- Lisenssi

- valo

- Todennäköisesti

- linja

- linjat

- Oikeudenkäynti

- OTK

- Pitkät

- pitkän aikavälin

- kauemmin

- näköinen

- Matala

- matalat hinnat

- kone

- koneoppiminen

- tehty

- hallinnoi

- monet

- materiaali

- Saattaa..

- merkitys

- Media

- Muisti

- menetelmä

- menetelmät

- Meksiko

- miljoona

- miljoonia

- Tehtävä

- seos

- ML

- Puhelinnumero

- mobiili-sovellukset

- malli

- mallit

- lisää

- eniten

- Elokuvat

- moninkertainen

- täytyy

- nimi

- Luonnollinen

- Luonnollinen kielen käsittely

- Tarve

- netto

- verkko

- Uusi

- Newton

- seuraava

- NLP

- Pohjoiseen

- Pohjois-Amerikka

- muistikirja

- nyt

- vivahteet

- tavoitteet

- of

- kampanja

- tarjoukset

- usein

- on

- ONE

- verkossa

- vain

- toiminta

- toiminta-

- Operations

- optiikka

- optimoimalla

- Vaihtoehto

- or

- Järjestetty

- alkuperäinen

- Muut

- meidän

- ulostulo

- yli

- oma

- sivulla

- pariksi

- paperit

- osa

- osapuolet

- intohimo

- potilaat

- kuviot

- Suorittaa

- suorituskyky

- phd

- fyysinen

- fyysisesti

- suunnitelmat

- Platon

- Platonin tietotieto

- PlatonData

- Kohta

- Kirje

- esittää

- hinta

- Hinnat

- ensisijainen

- tärkein

- periaatteet

- yksityinen

- prosessi

- käsittely

- tuottaa

- tuottavat

- Tuotteet

- Tuotteemme

- ennusteet

- toimittaa

- tarjoamisen

- mikäli

- toimittaja

- tarjoaa

- tarjoamalla

- julkinen

- julkisesti

- julkaistu

- Python

- laatu

- kysymykset

- pikemminkin

- punainen

- katso

- heijastaa

- Uudistus

- liittyvä

- julkaistu

- merkityksellinen

- raportti

- säilytyspaikka

- edustettuina

- edustavat

- pyyntö

- vaatimukset

- tutkimus

- tutkija

- kunnioittaminen

- vastaus

- REST

- rajoitukset

- johtua

- tulokset

- vähittäiskauppa

- jälleenmyyjä

- säilyttäen

- Rengas

- luja

- kuninkaallinen

- s

- sagemaker

- myynti

- skaalautuva

- Tiedemies

- sdk

- SEK

- SEC-arkistointi

- Osa

- osiot

- Arvopaperit

- turvallisuus

- nähdä

- etsiä

- segmentit

- valinta

- Myydään

- Myyjät

- vanhempi

- erillinen

- Sarjat

- Sarja A

- palvella

- palvelu

- Palvelut

- setti

- Setit

- settings

- shouldnt

- osoittivat

- esitetty

- Näytä

- sammutetaan

- samankaltainen

- Yksinkertainen

- single

- Sir

- tilanteita

- Koko

- liukuva

- pienempiä

- pätkä

- yhteiskunta

- myyty

- ratkaisu

- Ratkaisumme

- SOLVE

- erikoistunut

- erityinen

- yksityiskohdat

- spektri-

- nopeus

- Alkaa

- käynnistyksen

- Startups

- lausuntoja

- Valtiot

- tilastollinen

- Vaihe

- Askeleet

- Yhä

- Levytila

- verkkokaupasta

- varastot

- strategiat

- streaming

- pyrittävä

- vahva

- studio

- tilaus

- tilauspalvelut

- niin

- Puku

- Tukea

- Tukee

- taulukko

- Tabletti

- räätälöinti

- Tehtävä

- tehtävät

- joukkue-

- ryhmätyö

- tekniikka

- sapluuna

- testi

- teksti

- teksti-

- kuin

- että

- -

- Alue

- maailma

- sitten

- Siellä.

- Nämä

- Ajattelu

- kolmas

- kolmannet osapuolet

- tätä

- kolmella

- Kautta

- kauttaaltaan

- suoritusteho

- aika

- ajankohtainen

- että

- yhdessä

- Yhteensä

- Juna

- koulutettu

- koulutus

- muuntaja

- kohdella

- totta

- yrittää

- yrittää

- viritys

- tv

- kaksi

- tyyppi

- tyypit

- ui

- varten

- läpikäydä

- ymmärtää

- unique

- Yhtenäinen

- Yhdysvallat

- yliopisto

- Päivitykset

- Päivitykset

- us

- käyttää

- käytetty

- käyttötarkoituksiin

- käyttämällä

- validointi

- arvot

- lajike

- eri

- Vaihteleva

- valtava

- versio

- hyvin

- kautta

- Videoita

- visio

- kävellä

- katsomassa

- Tapa..

- we

- verkko

- verkkopalvelut

- sivustot

- HYVIN

- olivat

- Mitä

- Mikä on

- kun

- joka

- vaikka

- valkoinen

- tulee

- ikkuna

- with

- sisällä

- ilman

- sanoja

- Referenssit

- työskennellä yhdessä

- maailman-

- maailman

- kirjoittaa

- vuotta

- Voit

- Sinun

- zephyrnet