Koneoppimismallien (ML) parantuessa datatieteilijät, ML-insinöörit ja tutkijat ovat siirtäneet enemmän huomiota tietojen laadun määrittelyyn ja parantamiseen. Tämä on johtanut tietokeskeisen lähestymistavan syntymiseen ML:ssä ja erilaisissa tekniikoissa mallin suorituskyvyn parantamiseksi keskittymällä tietovaatimuksiin. Näiden tekniikoiden soveltaminen antaa ML:n harjoittajille mahdollisuuden vähentää ML-mallin harjoittamiseen tarvittavan datan määrää.

Osana tätä lähestymistapaa on noussut esiin kehittyneitä data-alajoukon valintatekniikoita, jotka nopeuttavat koulutusta vähentämällä syötetyn datan määrää. Tämä prosessi perustuu siihen, että valitaan automaattisesti tietty määrä pisteitä, jotka arvioivat suuremman tietojoukon jakautumista, ja käytetään sitä koulutukseen. Tämän tyyppisen tekniikan soveltaminen vähentää ML-mallin harjoittamiseen tarvittavaa aikaa.

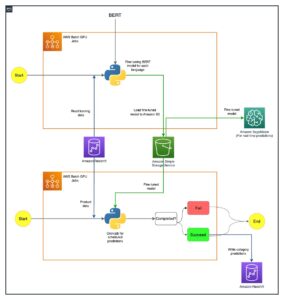

Tässä viestissä kuvaamme datakeskeisten tekoälyperiaatteiden soveltamista Amazon SageMaker Ground Totuus, kuinka toteuttaa tietoosajoukon valintatekniikoita käyttämällä JOHDOT arkisto päällä Amazon Sage Maker vähentääksesi alkuperäisen mallin harjoittamiseen tarvittavan tiedon määrää ja kuinka suorittaa kokeiluja tätä lähestymistapaa käyttäen Amazon SageMaker -kokeilut.

Tietokeskeinen lähestymistapa koneoppimiseen

Ennen kuin sukellat kehittyneempiin tietokeskeisiin tekniikoihin, kuten datan osajoukkojen valintaan, voit parantaa tietojoukkojasi useilla tavoilla soveltamalla tietomerkintäprosessisi taustalla olevia periaatteita. Tätä varten Ground Truth tukee erilaisia mekanismeja etikettien yhtenäisyyden ja tietojen laadun parantamiseksi.

Tarran johdonmukaisuus on tärkeää mallin suorituskyvyn parantamiseksi. Ilman sitä mallit eivät voi tuottaa päätösrajaa, joka erottaa jokaisen eri luokkiin kuuluvan pisteen. Yksi tapa varmistaa johdonmukaisuus on käyttää huomautusten konsolidointi Ground Truthissa, jonka avulla voit näyttää tietyn esimerkin useille merkintälaitteille ja käyttää koottua tunnistetta, joka on toimitettu kyseisen esimerkin pohjatotuudeksi. Etiketin ero mitataan Ground Truthin luomalla luottamuspisteellä. Jos merkinnöissä on eroja, tarkista, onko etiketöijille toimitetuissa merkintäohjeissa epäselvyyksiä, jotka voidaan poistaa. Tämä lähestymistapa lieventää yksittäisten leimainten harhojen vaikutuksia, mikä on keskeistä tarrojen johdonmukaisuuden lisäämisessä.

Toinen tapa parantaa mallin suorituskykyä keskittymällä tietoihin on kehittää menetelmiä tarrojen virheiden analysoimiseksi, kun ne löytävät tärkeimmän parannettavan tiedon osajoukon. voit tehdä tämän harjoitustietojoukollesi yhdistämällä manuaalisia toimenpiteitä, joihin kuuluu sukeltaminen merkittyihin esimerkkeihin ja amazonin pilvikello Ground Truth -merkintätöiden luomat lokit ja mittaukset. On myös tärkeää tarkastella virheitä, joita malli tekee johtopäätöshetkellä, jotta voimme ohjata seuraavaa merkintä iteraatiota tietojoukollemme. Näiden mekanismien lisäksi Amazon SageMaker selkeyttää antaa datatieteilijöille ja ML-insinööreille mahdollisuuden suorittaa algoritmeja, kuten KernelSHAP jotta he voivat tulkita mallinsa tekemiä ennusteita. Kuten mainittiin, syvempi selitys mallin ennusteisiin voidaan yhdistää alkuperäiseen merkintäprosessiin sen parantamiseksi.

Lopuksi voit heittää esiin meluisia tai liian tarpeettomia esimerkkejä. Näin voit lyhentää harjoitusaikaa poistamalla esimerkkejä, jotka eivät paranna mallin suorituskykyä. Tietyn tietojoukon hyödyllisen osajoukon tunnistaminen manuaalisesti on kuitenkin vaikeaa ja aikaa vievää. Tässä viestissä kuvattujen data-alajoukon valintatekniikoiden soveltaminen antaa sinun automatisoida tämän prosessin vakiintuneiden puitteiden mukaisesti.

Käytä tapausta

Kuten mainittiin, datakeskeinen tekoäly keskittyy mallin syötteen parantamiseen eikä itse mallin arkkitehtuuriin. Kun olet soveltanut näitä periaatteita tietojen merkitsemisen tai ominaisuuksien suunnittelun aikana, voit jatkaa keskittymistä mallin syöttämiseen käyttämällä datan osajoukon valintaa harjoituksen aikana.

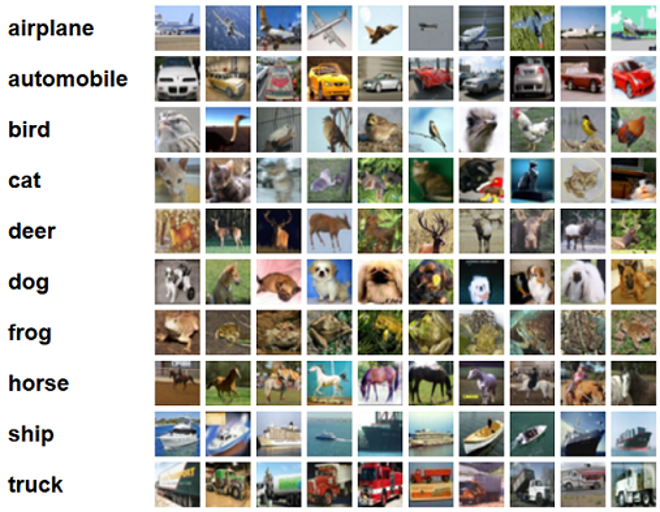

Tässä viestissä käytämme yleistyspohjaista tietoosajoukon valintaa tehokkaan ja vankan oppimisen takaamiseksi (GLISTER), joka on yksi monista CORDS-tietovarastossa toteutetuista data-alajoukon valintatekniikoista ResNet-18 mallia minimoidaksesi ajan, joka kuluu mallin kouluttamiseen luokittelua varten CIFAR-10 kuvia. Seuraavassa on joitakin esimerkkikuvia, joiden vastaavat tunnisteet on vedetty CIFAR-10-tietojoukosta.

ResNet-18:aa käytetään usein luokittelutehtäviin. Se on 18-kerroksinen syvä konvoluutiohermoverkko. CIFAR-10-aineistoa käytetään usein erilaisten tekniikoiden ja lähestymistapojen validiteetin arvioimiseen ML:ssä. Se koostuu 60,000 32 32 × 10 värikuvasta, jotka on merkitty XNUMX luokkaan.

Seuraavissa osioissa näytämme, kuinka GLISTER voi auttaa sinua jossain määrin vastaamaan seuraavaan kysymykseen:

Kuinka monta prosenttia tietystä tietojoukosta voimme käyttää ja silti saavuttaa hyvän mallin suorituskyvyn harjoittelun aikana?

GLISTERin käyttäminen harjoitusalgoritmiisi lisää murtoluvun hyperparametriksi harjoitusalgoritmiisi. Tämä edustaa prosenttiosuutta annetusta tietojoukosta, jota haluat käyttää. Kuten minkä tahansa hyperparametrin kohdalla, mallillesi ja tiedollesi parhaan tuloksen tuottavan arvon löytäminen vaatii viritystä. Emme mene syvällisesti hyperparametrien viritykseen tässä viestissä. Lisätietoja on kohdassa Optimoi hyperparametrit Amazon SageMakerin automaattisen mallin virityksen avulla.

Suoritamme useita testejä SageMaker Experimentsin avulla mitataksemme lähestymistavan vaikutusta. Tulokset vaihtelevat alkuperäisen tietojoukon mukaan, joten on tärkeää testata lähestymistapaa tietoihimme nähden eri kokoisilla osajoukoilla.

Vaikka keskustelemme GLISTERin käyttämisestä kuvissa, voit myös soveltaa sitä koulutusalgoritmeihin, jotka työskentelevät jäsenneltyjen tai taulukkomuotoisten tietojen kanssa.

Tietojen osajoukon valinta

Tietojen osajoukon valinnan tarkoituksena on nopeuttaa koulutusprosessia minimoimalla vaikutukset tarkkuuteen ja lisäämällä mallin kestävyyttä. Tarkemmin sanottuna GLISTER-ONLINE valitsee alijoukon mallin oppiessa yrittämällä maksimoida kyseisen harjoitustietojen osajoukon loki-todennäköisyyden määrittämässäsi vahvistusjoukossa. Tietojen osajoukon valinnan optimointi tällä tavalla lieventää kohinaa ja luokkaepätasapainoa, jota esiintyy usein todellisissa tietojoukoissa, ja sallii osajoukon valintastrategian mukautua mallin oppiessa.

Alkuperäisen GLISTER paperia kuvaa nopeuteen/tarkkuuteen liittyvää kompromissia eri data-alajoukkojen koolla, kuten a LeNet malli:

| Osajoukon koko | pyörimisnopeuden | tarkkuus |

| 10% | 6x | -3% |

| 30% | 2.5x | -1.20% |

| 50% | 1.5x | -0.20% |

Mallin kouluttamiseksi suoritamme a SageMaker koulutustyötä käyttämällä mukautettua harjoitusskriptiä. Olemme myös jo ladaneet kuvatietojoukkomme kohteeseen Amazonin yksinkertainen tallennuspalvelu (Amazon S3). Kuten missä tahansa SageMaker-koulutustyössä, meidän on määritettävä Estimator esine. PyTorch-estimaattori alkaen sagemaker.pytorch paketin avulla voimme suorittaa oman harjoitusskriptimme hallitussa PyTorch-säiliössä. The inputs muuttuja välitetty estimaattorille .fit toiminto sisältää sanakirjan koulutus- ja validointitietojoukon S3 sijainnista.

- train.py komentosarja suoritetaan, kun koulutustyö käynnistetään. Tässä komentosarjassa tuomme ResNet-18-mallin CORDS-kirjastosta ja välitämme sille tietojoukossamme olevien luokkien määrän seuraavasti:

Sitten käytämme gen_dataset toiminto CORDSista koulutus-, validointi- ja testitietojoukon luomiseen:

Jokaisesta tietojoukosta luomme vastaavan PyTorch-datalataimen:

Lopuksi käytämme näitä tiedonlataajia luomaan a GLISTERDataLoader CORDS-kirjastosta. Se käyttää GLISTER-ONLINE-valintastrategian toteutusta, joka soveltaa osajoukon valintaa, kun päivitämme mallia koulutuksen aikana, kuten aiemmin tässä viestissä on käsitelty.

Objektin luomiseksi välitämme valintastrategiakohtaiset argumentit muodossa a DotMap esine yhdessä train_loader, validation_loaderja logger:

- GLISTERDataLoader voidaan nyt käyttää tavallisena tiedonlataajana harjoitussilmukassa. Se valitsee data-alajoukot seuraavaa harjoituserää varten, kun malli oppii tämän mallin häviön perusteella. Kuten edellisestä taulukosta käy ilmi, data-alajoukon valintastrategian lisääminen antaa meille mahdollisuuden lyhentää harjoitusaikaa merkittävästi jopa data-alijoukon valinnan lisävaiheella, mutta tarkkuudessa on vain vähän kompromisseja.

Datatieteilijöiden ja ML-insinöörien on usein arvioitava lähestymistavan pätevyys vertaamalla sitä johonkin lähtötasoon. Näytämme kuinka tämä tehdään seuraavassa osiossa.

Kokeilun seuranta

Voit käyttää SageMaker Experiments -ohjelmaa data-alajoukon valintamenetelmän validiteetin mittaamiseen. Katso lisätietoja Seuraavan sukupolven Amazon SageMaker Experiments – Järjestä, seuraa ja vertaile koneoppimiskoulutuksiasi laajasti.

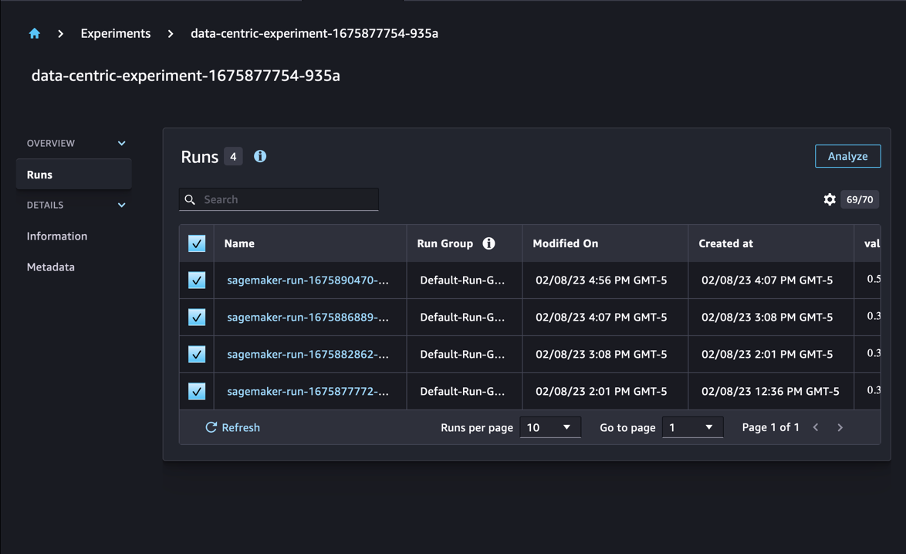

Meidän tapauksessamme suoritamme neljä koetta: perusviivan käyttämättä data-alajoukon valintaa ja kolme muuta koetta poikkeavilla fraction parametrit, jotka edustavat osajoukon kokoa suhteessa kokonaistietojoukkoon. Luonnollisesti pienemmällä fraction Parametrin pitäisi johtaa lyhyempiin harjoitusaikaan, mutta myös pienempään mallin tarkkuuteen.

Tässä postauksessa jokainen harjoitusajo on edustettuna a Run SageMaker Experimentsissa. Kaikki kokeiluamme liittyvät ajot on ryhmitelty yhden alle Experiment esine. Ajot voidaan liittää yhteiseen kokeiluun luotaessa Estimator SDK:n kanssa. Katso seuraava koodi:

Osana mukautettua harjoitusohjelmaasi voit kerätä juoksumittareita käyttämällä load_run:

Sitten käyttämällä edellisen operaation palauttamaa run-objektia, voit kerätä datapisteitä epookkia kohden kutsumalla run.log_metric(name, value, step) ja toimitetaan metriikan nimi, arvo ja nykyinen aikakausinumero.

Lähestymistapamme validiteetin mittaamiseksi keräämme mittareita, jotka vastaavat harjoituksen menetystä, harjoittelun tarkkuutta, validoinnin menetystä, validoinnin tarkkuutta ja aikakauden loppuunsaattamista. Sitten koulutustehtävien suorittamisen jälkeen voimme tarkista kokeilumme tulokset in Amazon SageMaker Studio tai SageMaker Experiments SDK:n kautta.

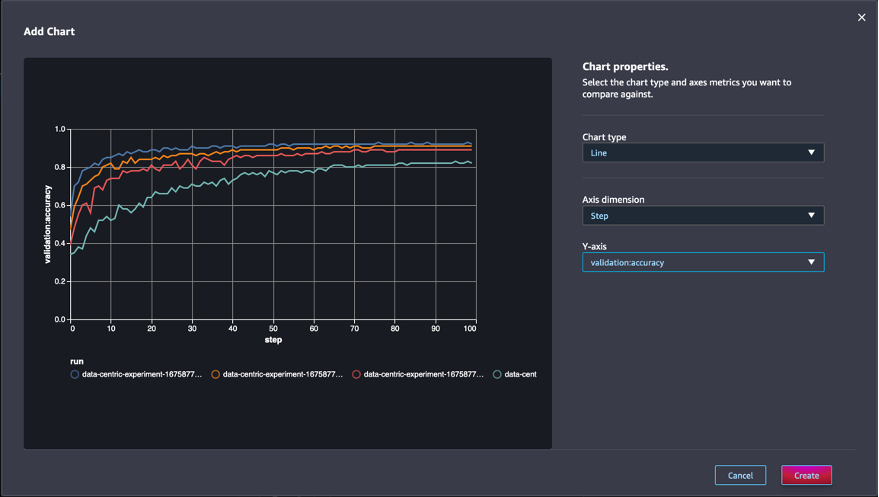

Jos haluat tarkastella validointitarkkuuksia Studiossa, valitse Analysoida kokeessa Toimii sivu.

Lisää kaavio, aseta kaavion ominaisuudet ja valitse luoda. Kuten seuraavassa kuvakaappauksessa näkyy, näet käyrän validointitarkkuuksista kullakin aikakaudella kaikille ajoille.

SDK:n avulla voit myös noutaa kokeiluihin liittyviä tietoja Pandas-tietokehyksenä:

Valinnaisesti koulutustehtävät voidaan lajitella. Voisimme lisätä esimerkiksi "metrics.validation:accuracy.max" arvona sort_by parametri välitetty ExperimentAnalytics palauttaaksesi vahvistustarkkuuden mukaisen tuloksen.

Kuten odotettiin, kokeilumme osoittavat, että GLISTERin ja data-alajoukon valinnan soveltaminen harjoitusalgoritmiin vähentää harjoitusaikaa. Kun suoritat perusharjoitusalgoritmiamme, mediaaniaika yksittäisen aikakauden suorittamiseen on noin 27 sekuntia. Sitä vastoin GLISTERin käyttäminen alijoukon valitsemiseen, joka vastaa 50 %, 30 % ja 10 % kokonaistietojoukosta, johtaa noin 13, 8.5 ja 2.75 sekunnin ajanjaksoon ml.p3.2xsuurissa tapauksissa. .

Havaitsemme myös suhteellisen minimaalisen vaikutuksen validoinnin tarkkuuteen, varsinkin kun käytetään 50 %:n data-alajoukkoja. 100 kauden harjoittelun jälkeen perusviiva tuottaa 92.72 %:n validointitarkkuuden. Sitä vastoin GLISTERin käyttäminen 50 %, 30 % ja 10 % koko tietojoukosta vastaavan osajoukon valitsemiseen johtaa 91.42 %:n, 89.76 %:n ja 82.82 %:n validointitarkkuuteen.

Yhteenveto

SageMaker Ground Truth ja SageMaker Experiments mahdollistavat tietokeskeisen lähestymistavan koneoppimiseen antamalla datatieteilijät ja ML-insinöörit tuottaa johdonmukaisempia tietojoukkoja ja seurata edistyneempien tekniikoiden vaikutuksia niiden toteuttaessa niitä mallinrakennusvaiheessa. Tietokeskeisen lähestymistavan käyttöönotto ML:ssä mahdollistaa mallin vaatiman tiedon määrän vähentämisen ja sen kestävyyden parantamisen.

Kokeile ja kerro meille mielipiteesi kommenteissa.

Tietoja kirjoittajista

Nicolas Bernier on ratkaisuarkkitehti, osa AWS:n Kanadan julkisen sektorin tiimiä. Hän suorittaa parhaillaan maisterintutkintoa Deep Learningin tutkimusalueella ja hänellä on viisi AWS-sertifikaattia, mukaan lukien ML Specialty Certification. Nicolas haluaa intohimoisesti auttaa asiakkaita syventämään AWS-tietoaan tekemällä yhteistyötä heidän kanssaan muuttaakseen heidän liiketoimintansa haasteet teknisiksi ratkaisuiksi.

Nicolas Bernier on ratkaisuarkkitehti, osa AWS:n Kanadan julkisen sektorin tiimiä. Hän suorittaa parhaillaan maisterintutkintoa Deep Learningin tutkimusalueella ja hänellä on viisi AWS-sertifikaattia, mukaan lukien ML Specialty Certification. Nicolas haluaa intohimoisesti auttaa asiakkaita syventämään AWS-tietoaan tekemällä yhteistyötä heidän kanssaan muuttaakseen heidän liiketoimintansa haasteet teknisiksi ratkaisuiksi.

Givanildo Alves on prototyyppiarkkitehti Amazon Web Services -palvelun prototyyppi- ja pilvisuunnittelutiimin kanssa, ja hän auttaa asiakkaita innovoimaan ja nopeuttamaan näyttämällä AWS:n mahdollisuuksien taitoa, koska hän on jo toteuttanut useita tekoälyn ympärillä olevia prototyyppejä. Hän on tehnyt pitkän uran ohjelmistosuunnittelussa ja työskennellyt aiemmin ohjelmistokehitysinsinöörinä osoitteessa Amazon.com.br.

Givanildo Alves on prototyyppiarkkitehti Amazon Web Services -palvelun prototyyppi- ja pilvisuunnittelutiimin kanssa, ja hän auttaa asiakkaita innovoimaan ja nopeuttamaan näyttämällä AWS:n mahdollisuuksien taitoa, koska hän on jo toteuttanut useita tekoälyn ympärillä olevia prototyyppejä. Hän on tehnyt pitkän uran ohjelmistosuunnittelussa ja työskennellyt aiemmin ohjelmistokehitysinsinöörinä osoitteessa Amazon.com.br.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- Platoblockchain. Web3 Metaverse Intelligence. Tietoa laajennettu. Pääsy tästä.

- Lähde: https://aws.amazon.com/blogs/machine-learning/use-a-data-centric-approach-to-minimize-the-amount-of-data-required-to-train-amazon-sagemaker-models/

- :On

- $ YLÖS

- 000

- 1

- 10

- 100

- 7

- 8

- a

- Meistä

- kiihdyttää

- tarkkuus

- Saavuttaa

- poikki

- sopeuttaa

- Lisäksi

- lisä-

- kehittynyt

- Jälkeen

- vastaan

- AI

- algoritmi

- algoritmit

- Kaikki

- Salliminen

- mahdollistaa

- jo

- Amazon

- Amazon Sage Maker

- Amazon Web Services

- Amazon.com

- epäselvyys

- määrä

- Analytics

- analysoida

- ja

- vastaus

- sovellettu

- käyttää

- Hakeminen

- lähestymistapa

- lähestymistavat

- arkkitehtuuri

- OVAT

- ALUE

- perustelut

- noin

- Art

- keinotekoinen

- tekoäly

- AS

- At

- yrittää

- huomio

- automatisoida

- automaattisesti

- automaattisesti

- AWS

- takaisin

- perustua

- Lähtötilanne

- BE

- PARAS

- puolueellisuus

- Rakentaminen

- liiketoiminta

- by

- soittamalla

- CAN

- kanadalainen

- Ura

- tapaus

- keskeinen

- Certification

- sertifikaatit

- haasteet

- Kaavio

- Valita

- luokka

- luokat

- luokittelu

- luokitella

- asiakkaat

- pilvi

- koodi

- kerätä

- väri

- KOM

- yhdistelmä

- Tulla

- kommentit

- Yhteinen

- verrattain

- verrata

- vertaamalla

- täydellinen

- kokoonpanossa

- johtavat

- luottamus

- Harkita

- johdonmukainen

- vakauttaminen

- Kontti

- sisältää

- jatkaa

- kontrasti

- edistävät

- vastaava

- voisi

- luoda

- Luominen

- Nykyinen

- Tällä hetkellä

- asiakassuhde

- Asiakkaat

- tiedot

- datapisteet

- aineistot

- päätös

- syvä

- syvä oppiminen

- Syventää

- syvempää

- määrittelemällä

- Aste

- osoittaa

- osoittivat

- Riippuen

- syvyys

- kuvata

- on kuvattu

- kehittämällä

- Kehitys

- eri

- erilaiset

- vaikea

- pohtia

- keskusteltiin

- jakelu

- Eroavuus

- tekee

- Dont

- ajaa

- aikana

- kukin

- Aikaisemmin

- vaikutukset

- tehokas

- ponnisteluja

- syntyminen

- mahdollistaa

- insinööri

- Tekniikka

- Engineers

- varmistaa

- aikakausi

- aikakausia

- Vastaava

- virheet

- erityisesti

- vakiintunut

- arvioida

- Jopa

- Joka

- esimerkki

- Esimerkit

- odotettu

- kokeilu

- selitys

- Ominaisuus

- löytäminen

- Keskittää

- keskittyy

- tarkennus

- seurannut

- jälkeen

- seuraa

- varten

- löytyi

- jae

- puitteet

- alkaen

- toiminto

- syntyy

- sukupolvi

- tietty

- Go

- hyvä

- Maa

- Olla

- ottaa

- auttaa

- auttaa

- pitää

- Miten

- Miten

- Kuitenkin

- HTML

- http

- HTTPS

- Hyperparametrien viritys

- tunnistaa

- tunnistaminen

- kuva

- kuvien

- epätasapaino

- Vaikutus

- toteuttaa

- täytäntöönpano

- täytäntöön

- täytäntöönpanosta

- tuoda

- tärkeä

- parantaa

- parani

- parantaminen

- in

- Mukaan lukien

- lisää

- henkilökohtainen

- tiedot

- ensimmäinen

- innovoida

- panos

- esimerkki

- ohjeet

- Älykkyys

- esitellä

- IT

- iteraatio

- SEN

- itse

- Job

- Työpaikat

- Tietää

- tuntemus

- Merkki

- merkinnät

- tarrat

- suurempi

- käynnistettiin

- oppiminen

- Led

- Kirjasto

- pitää

- Lista

- vähän

- sijainti

- Pitkät

- katso

- pois

- kone

- koneoppiminen

- tehty

- TEE

- Tekeminen

- onnistui

- manuaalinen

- käsin

- monet

- maisterin

- max

- Maksimoida

- mitata

- mainitsi

- menetelmät

- metrinen

- Metrics

- minimi

- minimointia

- ML

- malli

- mallit

- lisää

- eniten

- moninkertainen

- nimi

- Tarve

- verkko

- neuroverkkomallien

- seuraava

- Nicolas

- Melu

- numero

- objekti

- tarkkailla

- of

- on

- ONE

- toiminta

- optimoimalla

- Muuta

- yleinen

- oma

- paketti

- sivulla

- pandas

- parametri

- parametrit

- osa

- Hyväksytty

- intohimoinen

- osuus

- Suorittaa

- suorituskyky

- vaihe

- Platon

- Platonin tietotieto

- PlatonData

- Kohta

- pistettä

- mahdollinen

- Kirje

- Ennusteet

- edellinen

- aiemmin

- periaatteet

- prosessi

- tuottaa

- ominaisuudet

- prototyyppejä

- prototyyppien

- mikäli

- julkinen

- tarkoitus

- pytorch

- laatu

- määrä

- kysymys

- pikemminkin

- todellinen maailma

- vähentää

- Vähentynyt

- vähentää

- vähentämällä

- alue

- säännöllinen

- liittyvä

- poistettu

- poistamalla

- säilytyspaikka

- edustettuina

- edustaa

- tarvitaan

- vaatimukset

- Vaatii

- tutkimus

- Tutkijat

- ne

- johtua

- tulokset

- palata

- luja

- kestävyys

- ajaa

- juoksu

- sagemaker

- tutkijat

- sdk

- sekuntia

- Osa

- osiot

- sektori

- valitsemalla

- valinta

- palvella

- Palvelut

- Istunto

- setti

- useat

- shouldnt

- näyttää

- esitetty

- merkittävästi

- Yksinkertainen

- single

- Koko

- koot

- pienempiä

- So

- Tuotteemme

- ohjelmistokehitys

- ohjelmistotuotanto

- Ratkaisumme

- jonkin verran

- lähde

- Erikoisuus

- erityinen

- erityisesti

- nopeus

- Vaihe

- Yhä

- Levytila

- Strategia

- jäsennelty

- studio

- toimittaa

- Tukee

- taulukko

- vie

- tehtävät

- joukkue-

- Tekninen

- tekniikat

- testi

- testit

- että

- -

- heidän

- Niitä

- Nämä

- kolmella

- Kautta

- aika

- kertaa

- että

- taskulamppu

- toronto

- raita

- Juna

- koulutus

- koulutukset

- Kääntää

- varten

- taustalla oleva

- Päivitykset

- ladattu

- us

- käyttää

- validointi

- arvo

- eri

- Näytä

- Tapa..

- tavalla

- verkko

- verkkopalvelut

- HYVIN

- Mitä

- joka

- vaikka

- tulee

- with

- sisällä

- ilman

- työskenteli

- työskentely

- Voit

- Sinun

- zephyrnet