Tammikuussa 2024, Amazon Sage Maker julkaisi uuden version (0.26.0) Large Model Inference (LMI) Deep Learning Containers (DLC) -säilöistä. Tämä versio tarjoaa tuen uusille malleille (mukaan lukien Mixture of Experts), suorituskyvyn ja käytettävyyden parannuksia päättelytaustajärjestelmissä sekä uuden sukupolven yksityiskohtia, jotka parantavat hallintaa ja ennusteiden selitettävyyttä (kuten sukupolven valmistumisen syy ja merkkitason lokin todennäköisyydet).

LMI DLC:t tarjoavat matalan koodin käyttöliittymän, joka yksinkertaistaa huippuluokan päättelyn optimointitekniikoiden ja laitteiston käyttöä. LMI mahdollistaa tensorin rinnakkaisuuden soveltamisen; uusimmat tehokkaat huomio-, eräajo-, kvantisointi- ja muistinhallintatekniikat; token-suoratoisto; ja paljon muuta, vaatimalla vain mallitunnuksen ja valinnaiset malliparametrit. SageMakerin LMI-lisäosien avulla voit nopeuttaa arvon saavuttamista generatiivinen tekoäly (AI) sovelluksia, kuormittaa infrastruktuuriin liittyviä raskaita nostoja ja optimoida suuria kielimalleja (LLM) valitsemillesi laitteille saavuttaaksesi luokkansa parhaan hinta-suorituskyvyn.

Tässä viestissä tutkimme tässä julkaisussa esiteltyjä uusimpia ominaisuuksia, tarkastelemme suorituskyvyn vertailuarvoja ja annamme yksityiskohtaisen oppaan uusien LLM:ien käyttöönotosta korkean suorituskyvyn LMI DLC:illä.

Uusia ominaisuuksia LMI DLC:issä

Tässä osiossa keskustelemme uusista ominaisuuksista LMI-taustajärjestelmissä ja tarkastelemme joitakin muita, jotka ovat taustakohtaisia. LMI tukee tällä hetkellä seuraavia taustaohjelmia:

- LMI-hajautettu kirjasto – Tämä on AWS-kehys OSS:n inspiroimien päätelmien tekemiseen LLM:iden kanssa parhaan mahdollisen viiveen ja tuloksen tarkkuuden saavuttamiseksi.

- LMI vLLM – Tämä on muistitehokkaan AWS-taustatoteutus vLLM päätelmäkirjasto

- LMI TensorRT-LLM työkalupakki – Tämä on AWS-taustatoteutus NVIDIA TensorRT-LLM, joka luo GPU-spesifisiä moottoreita suorituskyvyn optimoimiseksi eri GPU:illa

- LMI DeepSpeed – Tämä on AWS-sovitus Syvä nopeus, joka lisää todellisen jatkuvan eräajon, SmoothQuant-kvantisoinnin ja mahdollisuuden säätää dynaamisesti muistia päättelyn aikana

- LMI NeuronX – Voit käyttää tätä käyttöönottoon AWS Inferentia2 ja AWS Trainium-pohjaiset ilmentymät, joissa on todellista jatkuvaa eräajoa ja nopeutuksia AWS Neuron SDK

Seuraavassa taulukossa on yhteenveto äskettäin lisätyistä sekä yleisistä että taustakohtaisista ominaisuuksista.

|

Yleisiä taustaohjelmissa |

|||

|

|||

|

Taustakohtainen |

|||

|

LMI-hajautettu |

vLLM | TensorRT-LLM |

NeuronX |

|

|

|

|

Uusia malleja tuetaan

Uusia suosittuja malleja tuetaan kaikissa taustajärjestelmissä, kuten Mistral-7B (kaikki taustaohjelmat), MoE-pohjainen Mixtral (kaikki taustaohjelmat paitsi Transformers-NeuronX) ja Llama2-70B (Transformers-NeuronX).

Konteksti-ikkunan laajennustekniikat

Rotary Positional Embedding (RoPE) -pohjainen kontekstin skaalaus on nyt saatavilla LMI-Dist-, vLLM- ja TensorRT-LLM-taustajärjestelmissä. RoPE-skaalaus mahdollistaa mallin sekvenssin pituuden pidentämisen päättelyn aikana käytännössä mihin tahansa kokoon ilman hienosäätöä.

Seuraavassa on kaksi tärkeää seikkaa köyden käytössä:

- Mallin hämmennys – Kun sarjan pituus kasvaa, niin voi mallin hämmennys. Tätä vaikutusta voidaan osittain kompensoida suorittamalla minimaalista hienosäätöä tulosekvensseille, jotka ovat suurempia kuin alkuperäisessä harjoituksessa käytetyt. Katso lisätietoja siitä, kuinka RoPE vaikuttaa mallin laatuun Köyden pidentäminen.

- Päätelmän suorituskyky – Pidemmät sekvenssipituudet kuluttavat suuremman kiihdytin suuren kaistanleveyden muistia (HBM). Tämä lisääntynyt muistin käyttö voi vaikuttaa haitallisesti kiihdytin käsittelemien samanaikaisten pyyntöjen määrään.

Lisätty sukupolven tiedot

Saat nyt kaksi hienorakeista yksityiskohtaa sukupolvituloksista:

- lopetussyy – Tämä antaa syyn sukupolven loppuun saattamiseen, joka voi olla suurimman sukupolven pituuden saavuttaminen, lauseen lopun (EOS) luominen tai käyttäjän määrittämän lopetustunnuksen luominen. Se palautetaan viimeisen suoratoistetun sekvenssin kanssa.

- log_probs – Tämä palauttaa mallin määrittämän lokin todennäköisyyden kullekin suoratoistetun sekvenssiosan tunnukselle. Voit käyttää näitä karkeana arviona mallin luotettavuudesta laskemalla sekvenssin yhteisen todennäköisyyden

log_probsyksittäisistä tokeneista, mikä voi olla hyödyllistä mallin tulosten pisteytyksen ja luokittelun kannalta. Muista, että LLM-merkkien todennäköisyydet ovat yleensä liian luotettavia ilman kalibrointia.

Voit ottaa sukupolven tulosten käyttöön lisäämällä LMI:n syöttöhyötykuormaan tiedot tiedot=True jättäen kaikki muut parametrit ennalleen:

payload = {“inputs”:“your prompt”,

“parameters”:{max_new_tokens”:256,...,“details”:True}

}Konsolidoidut konfigurointiparametrit

Lopuksi myös LMI-konfiguraatioparametrit on konsolidoitu. Lisätietoja kaikista yleisistä ja taustaohjelmistokohtaisista käyttöönoton määritysparametreista on kohdassa Suuret mallin päättelyasetukset.

LMI-hajautettu taustaohjelma

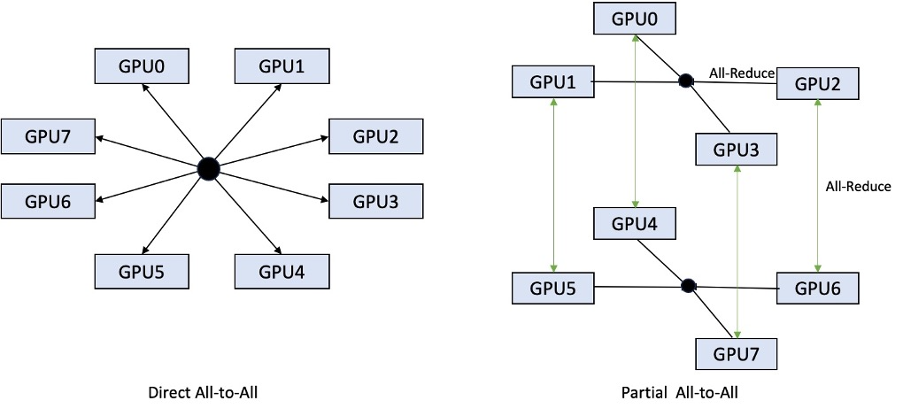

AWS re:Invent 2023:ssa LMI-Dist lisäsi uusia, optimoituja yhteistoimintoja nopeuttaakseen GPU:iden välistä tiedonsiirtoa, mikä johti pienempään latenssiin ja korkeampaan suorituskykyyn malleissa, jotka ovat liian suuria yhdelle GPU:lle. Nämä ryhmät ovat saatavilla yksinomaan SageMakerille p4d-esiintymille.

Kun edellinen iteraatio tuki vain jakamista kaikissa kahdeksassa grafiikkasuorittimessa, LMI 8 ottaa käyttöön tuen tensorin rinnakkaisasteelle 0.26.0 osittaisessa all-to-all -mallissa. Tämä voidaan yhdistää SageMakerin päättelykomponentit, jonka avulla voit määrittää tarkasti, kuinka monta kiihdytintä tulee varata kullekin päätepisteen takana käyttöönotetulle mallille. Yhdessä nämä ominaisuudet mahdollistavat paremman taustalla olevan ilmentymän resurssien käytön hallinnan, jolloin voit lisätä mallien monivuokrausta isännöimällä eri malleja yhden päätepisteen takana tai hienosäätää käyttöönoton kokonaiskapasiteettia mallin ja liikenteen ominaisuuksien mukaan.

Seuraavassa kuvassa verrataan suoria all-to-all ja osittaista all-to-all-peliä.

TensorRT-LLM taustaohjelma

NVIDIA:n TensorRT-LLM esiteltiin osana edellistä LMI DLC -julkaisua (0.25.0), joka mahdollistaa huippuluokan GPU-suorituskyvyn ja optimoinnit, kuten SmoothQuantin, FP8:n ja jatkuvan eräajon LLM:ille käytettäessä NVIDIA GPU:ia.

TensorRT-LLM edellyttää, että mallit on käännetty tehokkaiksi moottoreiksi ennen käyttöönottoa. LMI TensorRT-LLM DLC pystyy automaattisesti laatimaan luettelon tuetuista malleista juuri-in-time (JIT) ennen palvelimen käynnistämistä ja mallin lataamista reaaliaikaista päättelyä varten. DLC:n versio 0.26.0 laajentaa tuettujen mallien luetteloa JIT-käännöksiä varten ja esittelee Baichuan-, ChatGLM-, GPT2-, GPT-J-, InternLM-, Mistral-, Mixtral-, Qwen-, SantaCoder- ja StarCoder-mallit.

JIT-kääntäminen lisää useita minuutteja päätepisteiden valmisteluun ja skaalausaikaan, joten on aina suositeltavaa kääntää mallisi etukäteen. Katso opas tämän tekemiseen ja luettelo tuetuista malleista TensorRT-LLM mallien ennakko-oppitunti. Jos valitsemaasi mallia ei vielä tueta, katso TensorRT-LLM manuaalinen mallien opetusohjelma kääntääksesi minkä tahansa muun mallin, jota TensorRT-LLM tukee.

Lisäksi LMI paljastaa nyt alkuperäisen TensorRT-LLM SmootQuant -kvantisoinnin parametrein, joilla ohjataan alfaa ja skaalauskerrointa tunnuksen tai kanavan mukaan. Lisätietoja liittyvistä kokoonpanoista on kohdassa TensorRT-LLM.

vLLM-taustajärjestelmä

LMI DLC:hen sisältyvä vLLM:n päivitetty julkaisu sisältää jopa 50 % suorituskyvyn parannuksia, jotka perustuvat CUDA-kuvaajatilaan innokkaan tilan sijaan. CUDA-kaaviot nopeuttavat GPU-työkuormaa käynnistämällä useita GPU-toimintoja kerralla sen sijaan, että ne käynnistäisivät ne erikseen, mikä vähentää yleiskustannuksia. Tämä on erityisen tehokas pienille malleille, kun käytetään tensorin rinnakkaisuutta.

Lisätty suorituskyky tulee kompromissina lisätyn GPU-muistin kulutuksen kanssa. CUDA-kaaviotila on nyt oletuksena vLLM-taustajärjestelmässä, joten jos käytettävissä olevan GPU-muistin määrä on rajoitettu, voit option.enforce_eager=True pakottaaksesi PyTorchin innokkaan tilan.

Transformers-NeuronX taustaohjelma

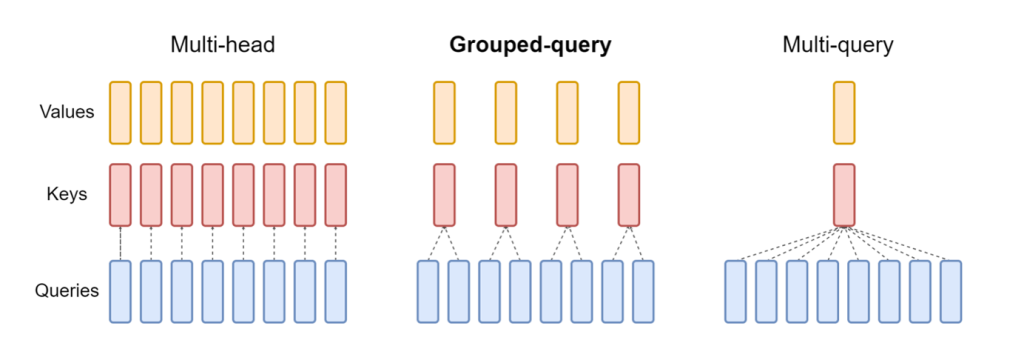

Päivitetty julkaisu NeuronX LMI NeuronX DLC:hen sisältyvät mallit, kuten Mistral-7B ja LLama2-70B, sisältävät nyt ryhmäkyselyn huomiomekanismin. Ryhmitetty kyselyn huomio on tärkeä optimointi oletusmuuntajan huomiomekanismiin, jossa mallia opetetaan vähemmällä avain- ja arvopäillä kuin kyselypäillä. Tämä pienentää GPU-muistin KV-välimuistin kokoa, mikä mahdollistaa suuremman samanaikaisuuden ja parantaa hinta-suorituskykyä.

Seuraava kuva havainnollistaa usean pään, ryhmäkyselyn ja usean kyselyn huomiomenetelmiä (lähde).

Erilaisia KV-välimuistin jakamisstrategioita on saatavana erityyppisiin työkuormiin sopiviksi. Lisätietoja jakostrategioista on kohdassa Ryhmitettyjen kyselyjen huomion (GQA) tuki. Voit ottaa käyttöön haluamasi strategian (shard-over-headsesimerkiksi) seuraavalla koodilla:

Lisäksi NeuronX DLC:n uusi toteutus tuo TransformerNeuronX:n välimuistirajapinnan, joka mahdollistaa pääsyn KV-välimuistiin. Sen avulla voit lisätä ja poistaa KV-välimuistirivejä uusista pyynnöistä samalla, kun luovutat eräpäätelmiä. Ennen tämän API:n käyttöönottoa KV-välimuisti laskettiin uudelleen uusille lisätyille pyynnöille. Verrattuna LMI V7:ään (0.25.0), olemme parantaneet latenssia yli 33 % samanaikaisilla pyynnöillä ja tuemme paljon suurempaa suorituskykyä.

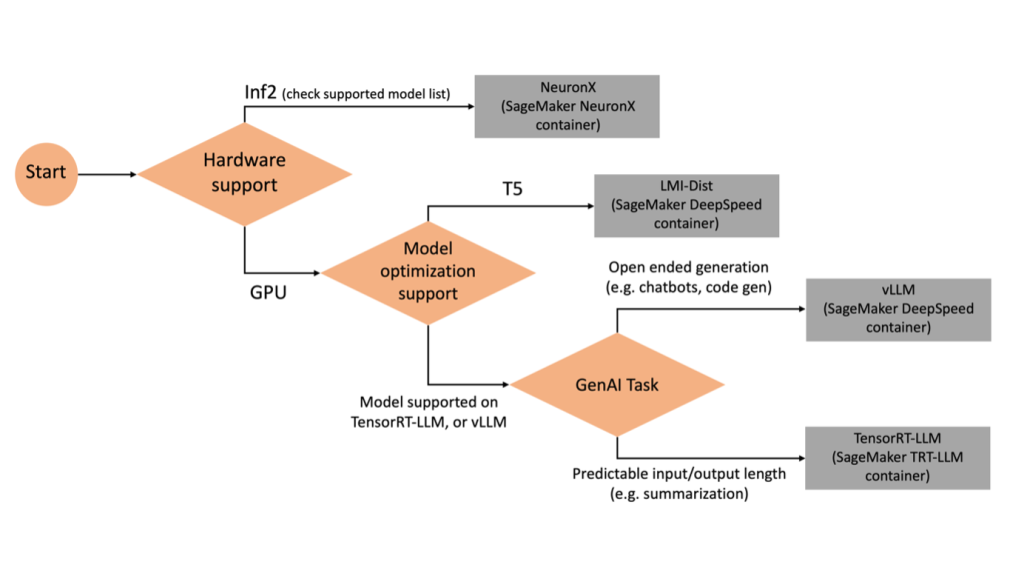

Oikean taustaohjelman valinta

Voit päättää, mitä taustajärjestelmää käytetään valitun mallin ja tehtävän perusteella, käyttämällä seuraavaa vuokaaviota. Katso yksittäiset taustakäyttöoppaat ja tuetut mallit LMI-taustajärjestelmän käyttöoppaat.

Ota Mixtral käyttöön LMI DLC:llä lisämääritteillä

Käydään läpi, kuinka voit ottaa käyttöön Mixtral-8x7B-mallin LMI 0.26.0 -säiliöllä ja luoda lisätietoja, kuten log_prob ja finish_reason osana tuotantoa. Keskustelemme myös siitä, kuinka voit hyötyä näistä lisäominaisuuksista sisällön luomisen käyttötapauksessa.

Täydellinen muistikirja yksityiskohtaisine ohjeineen on saatavilla osoitteessa GitHub repo.

Aloitamme tuomalla kirjastot ja määrittämällä istuntoympäristön:

Voit käyttää SageMaker LMI -säilöjä mallien isännöimiseen ilman ylimääräistä päättelykoodia. Voit määrittää mallipalvelimen joko ympäristömuuttujien tai a serving.properties tiedosto. Vaihtoehtoisesti sinulla voi olla a model.py tiedosto esi- tai jälkikäsittelyä varten ja a requirements.txt tiedosto kaikista lisäpaketteista, jotka on asennettava.

Tässä tapauksessa käytämme serving.properties tiedosto määrittääksesi parametrit ja mukauttamalla LMI-säilön toimintaa. Katso lisätietoja osoitteesta GitHub repo. Repo selittää yksityiskohtaiset tiedot eri konfigurointiparametreista, jotka voit asettaa. Tarvitsemme seuraavat avainparametrit:

- moottori – Määrittää DJL:n käytettävän ajonaikaisen moottorin. Tämä ohjaa sirpalointia ja mallin latausstrategiaa mallin kiihdyttimissä.

- option.model_id – Määrittää Amazonin yksinkertainen tallennuspalvelu (Amazon S3) Valmiiksi koulutetun mallin URI tai mallin arkistoon isännöidyn esikoulutetun mallin mallitunnus Halaaminen kasvot. Tässä tapauksessa annamme mallin tunnuksen Mixtral-8x7B-mallille.

- option.tensor_parallel_degree – Asettaa niiden GPU-laitteiden määrän, joihin Acceleraten on osioitava malli. Tämä parametri ohjaa myös työntekijöiden määrää mallia kohti, jotka käynnistetään, kun DJL-palvelu suoritetaan. Asetamme tähän arvoon

max(maksimi GPU nykyisessä koneessa). - option.rolling_batch – Mahdollistaa jatkuvan annostelun kiihdyttimien käytön ja kokonaissuorituskyvyn optimoimiseksi. Käytämme TensorRT-LLM-säiliössä

auto. - option.model_loading_timeout – Asettaa aikakatkaisuarvon mallin lataamiselle ja lataamiselle päätelmien suorittamiseksi.

- option.max_rolling_batch – Asettaa jatkuvan erän enimmäiskoon ja määrittää, kuinka monta sekvenssiä voidaan käsitellä samanaikaisesti samanaikaisesti.

Pakkaamme serving.properties määritystiedosto tar.gz-muodossa, jotta se täyttää SageMaker-isännöintivaatimukset. Konfiguroimme DJL LMI -kontin tensorrtllm taustamoottorina. Lisäksi määritämme säilön uusimman version (0.26.0).

Seuraavaksi lataamme paikallisen tarball-tiedoston (sisältää serving.properties määritystiedosto) S3-etuliitteeksi. Käytämme DJL-säilön ja Amazon S3 -sijainnin kuva-URIa, johon artefakteja palveleva malli ladattiin, luodaksemme SageMaker-malliobjektin.

Osana LMI 0.26.0:aa voit nyt käyttää kahta hienorakeista lisätietoa luodusta lähdöstä:

- log_probs – Tämä on mallin kullekin suoratoistetussa sekvenssikappaleessa olevalle tokenille määrittämä loki-todennäköisyys. Voit käyttää näitä karkeana arviona mallin luotettavuudesta laskemalla sekvenssin yhteisen todennäköisyyden yksittäisten merkkien logaritmistodennäköisyyksien summana, mikä voi olla hyödyllistä mallin tulosten pisteytyksen ja rankaisemisen kannalta. Muista, että LLM-merkkien todennäköisyydet ovat yleensä liian luotettavia ilman kalibrointia.

- lopetussyy – Tämä on syy sukupolven valmistumiseen, mikä voi olla suurimman sukupolven pituuden saavuttaminen, EOS-tunnuksen luominen tai käyttäjän määrittämän lopetustunnuksen luominen. Tämä palautetaan viimeisen suoratoistetun sekvenssin kanssa.

Voit ottaa nämä käyttöön ohittamalla "details"=True osana panostasi malliin.

Katsotaanpa, kuinka voit luoda nämä tiedot. Käytämme sisällöntuotantoesimerkkiä ymmärtääksemme niiden sovelluksen.

Määritämme a LineIterator helper-luokka, jolla on toimintoja, jotka hakevat laiskasti tavuja vastausvirrasta, puskuroivat ne ja jakavat puskurin riveiksi. Ajatuksena on palvella tavuja puskurista samalla, kun haetaan lisää tavuja virrasta asynkronisesti.

Luo ja käytä token-todennäköisyyttä lisätietona

Harkitse käyttötapausta, jossa luomme sisältöä. Erityisesti meidän tehtävämme on kirjoittaa lyhyt kappale säännöllisen harjoittelun eduista elämäntapapainotteiselle verkkosivustolle. Haluamme tuottaa sisältöä ja tulostaa jonkin verran suuntaa antavaa pistemäärää mallin luotettavuudesta luotuun sisältöön.

Kutsumme mallin päätepistettä kehotteellamme ja tallennamme luodun vastauksen. Asetamme "details": True ajonaikaisena parametrina mallin syötössä. Koska lokin todennäköisyys luodaan jokaiselle lähtötunnisteelle, lisäämme yksittäiset lokitodennäköisyydet luetteloon. Kaappaamme vastauksesta myös koko luodun tekstin.

Yleisen luottamuspisteen laskemiseksi laskemme kaikkien yksittäisten merkkien todennäköisyyksien keskiarvon ja saamme sen jälkeen eksponentiaalisen arvon välillä 0 ja 1. Tämä on päätellyt kokonaisluottamuspisteemme luodulle tekstille, joka tässä tapauksessa on kappale hyödyistä säännöllisestä harjoituksesta.

Tämä oli yksi esimerkki siitä, kuinka voit luoda ja käyttää log_prob, sisällön luomisen käyttötapauksen yhteydessä. Vastaavasti voit käyttää log_prob luokituksen käyttötapausten luottamuspisteiden mittana.

Vaihtoehtoisesti voit käyttää sitä yleiseen tulossarjaan tai lausetason pisteytykseen arvioidaksesi parametrien, kuten lämpötilan, vaikutusta luotuun tuotteeseen.

Luo ja käytä viimeistelyn syytä lisätietona

Jatketaan samaa käyttötapausta, mutta tällä kertaa meidän tehtävänä on kirjoittaa pidempi artikkeli. Lisäksi haluamme varmistaa, että tulostetta ei katkaista sukupolven pituusongelmien (maksimaalinen tunnuksen pituus) tai pysäytystunnusten havaitsemisen vuoksi.

Tämän saavuttamiseksi käytämme finish_reason attribuutti tuotteeseen, tarkkaile sen arvoa ja jatka luomista, kunnes koko tulos on luotu.

Määrittelemme päättelyfunktion, joka ottaa hyötykuorman syötteen ja kutsuu SageMaker-päätepisteen, suoratoistaa vastauksen ja käsittelee vastauksen poimiakseen luodun tekstin. Hyötykuorma sisältää kehotetekstin syötteinä ja parametreina, kuten maksimitunnukset ja yksityiskohdat. Vastaus luetaan virrassa ja käsitellään rivi riviltä luodun tekstitunnisteen poimimiseksi luetteloksi. Poimimme yksityiskohtia, kuten finish_reason. Kutsumme päättelyfunktiota silmukassa (ketjutetut pyynnöt) ja lisäämme kontekstia joka kerta ja seuraamme luotujen merkkien ja lähetettyjen pyyntöjen määrää, kunnes malli on valmis.

Kuten näemme, vaikka max_new_token parametrin arvoksi on asetettu 256, käytämme tulosteen osana finish_reason detail -attribuuttia useiden pyyntöjen ketjuttamiseksi päätepisteeseen, kunnes koko tulos on luotu.

Vastaavasti voit käyttää stop_reason havaitsemaan tietylle tehtävälle määritetyn riittämättömän tulostusjakson pituuden tai tahattoman valmistumisen ihmisen pysäyttämisjakson vuoksi.

Yhteenveto

Tässä viestissä kävimme läpi AWS LMI -säilön version 0.26.0. Korostimme keskeisiä suorituskyvyn parannuksia, uuden mallin tukea ja uusia käytettävyysominaisuuksia. Näiden ominaisuuksien avulla voit paremmin tasapainottaa kustannukset ja suorituskykyominaisuudet ja tarjota paremman kokemuksen loppukäyttäjillesi.

Lisätietoja LMI DLC -ominaisuuksista on kohdassa Mallin rinnakkaisuus ja suuren mallin päättely. Olemme innoissamme nähdessämme, kuinka käytät näitä SageMakerin uusia ominaisuuksia.

Tietoja kirjoittajista

João Moura on AWS:n vanhempi AI/ML Specialist Solutions -arkkitehti. João auttaa AWS-asiakkaita – pienistä startupeista suuriin yrityksiin – kouluttamaan ja ottamaan käyttöön suuria malleja tehokkaasti sekä rakentamaan laajemmin ML-alustoja AWS:lle.

João Moura on AWS:n vanhempi AI/ML Specialist Solutions -arkkitehti. João auttaa AWS-asiakkaita – pienistä startupeista suuriin yrityksiin – kouluttamaan ja ottamaan käyttöön suuria malleja tehokkaasti sekä rakentamaan laajemmin ML-alustoja AWS:lle.

Rahul Sharma on AWS:n vanhempi ratkaisuarkkitehti, joka auttaa AWS:n asiakkaita suunnittelemaan ja rakentamaan AI/ML-ratkaisuja. Ennen AWS:ään liittymistään Rahul on työskennellyt useita vuosia rahoitus- ja vakuutusalalla auttaen asiakkaita rakentamaan data- ja analyyttisiä alustoja.

Rahul Sharma on AWS:n vanhempi ratkaisuarkkitehti, joka auttaa AWS:n asiakkaita suunnittelemaan ja rakentamaan AI/ML-ratkaisuja. Ennen AWS:ään liittymistään Rahul on työskennellyt useita vuosia rahoitus- ja vakuutusalalla auttaen asiakkaita rakentamaan data- ja analyyttisiä alustoja.

Qing Lan on ohjelmistokehitysinsinööri AWS:ssä. Hän on työskennellyt useiden haastavien tuotteiden parissa Amazonissa, mukaan lukien korkean suorituskyvyn ML-johtopäätösratkaisut ja korkean suorituskyvyn lokijärjestelmä. Qingin tiimi lanseerasi onnistuneesti ensimmäisen Billion-parametrin mallin Amazon Advertisingissä erittäin alhaisella latenssilla. Qingillä on syvällinen tietämys infrastruktuurin optimoinnista ja Deep Learning -kiihdytyksestä.

Qing Lan on ohjelmistokehitysinsinööri AWS:ssä. Hän on työskennellyt useiden haastavien tuotteiden parissa Amazonissa, mukaan lukien korkean suorituskyvyn ML-johtopäätösratkaisut ja korkean suorituskyvyn lokijärjestelmä. Qingin tiimi lanseerasi onnistuneesti ensimmäisen Billion-parametrin mallin Amazon Advertisingissä erittäin alhaisella latenssilla. Qingillä on syvällinen tietämys infrastruktuurin optimoinnista ja Deep Learning -kiihdytyksestä.

Jian Sheng on ohjelmistokehitysinsinööri Amazon Web Servicesissä, joka on työskennellyt useiden koneoppimisjärjestelmien keskeisten näkökohtien parissa. Hän on ollut avaintekijä SageMaker Neo -palvelussa keskittyen syväoppimisen kokoamiseen ja kehyksen suoritusajan optimointiin. Viime aikoina hän on ohjannut ponnistelujaan ja osallistunut koneoppimisjärjestelmän optimointiin suuria mallipäätelmiä varten.

Jian Sheng on ohjelmistokehitysinsinööri Amazon Web Servicesissä, joka on työskennellyt useiden koneoppimisjärjestelmien keskeisten näkökohtien parissa. Hän on ollut avaintekijä SageMaker Neo -palvelussa keskittyen syväoppimisen kokoamiseen ja kehyksen suoritusajan optimointiin. Viime aikoina hän on ohjannut ponnistelujaan ja osallistunut koneoppimisjärjestelmän optimointiin suuria mallipäätelmiä varten.

Tyler Osterberg on AWS:n ohjelmistokehitysinsinööri. Hän on erikoistunut korkean suorituskyvyn koneoppimispäätelmien luomiseen SageMakerissa. Viime aikoina hän on keskittynyt Inferentia Deep Learning Containers -säilöjen suorituskyvyn optimointiin SageMaker-alustalla. Tyler on erinomainen toteuttamaan tehokkaita isännöintiratkaisuja suurille kielimalleille ja parantamaan käyttökokemusta uusinta teknologiaa käyttämällä.

Tyler Osterberg on AWS:n ohjelmistokehitysinsinööri. Hän on erikoistunut korkean suorituskyvyn koneoppimispäätelmien luomiseen SageMakerissa. Viime aikoina hän on keskittynyt Inferentia Deep Learning Containers -säilöjen suorituskyvyn optimointiin SageMaker-alustalla. Tyler on erinomainen toteuttamaan tehokkaita isännöintiratkaisuja suurille kielimalleille ja parantamaan käyttökokemusta uusinta teknologiaa käyttämällä.

Rupinder Grewal on vanhempi AI/ML Specialist Solutions -arkkitehti AWS:llä. Tällä hetkellä hän keskittyy mallien ja MLO:iden tarjoamiseen Amazon SageMakerissa. Ennen tätä tehtävää hän työskenteli koneoppimisinsinöörinä mallien rakentamisessa ja isännöinnissa. Työn ulkopuolella hän pelaa tennistä ja pyöräilee vuoristopoluilla.

Rupinder Grewal on vanhempi AI/ML Specialist Solutions -arkkitehti AWS:llä. Tällä hetkellä hän keskittyy mallien ja MLO:iden tarjoamiseen Amazon SageMakerissa. Ennen tätä tehtävää hän työskenteli koneoppimisinsinöörinä mallien rakentamisessa ja isännöinnissa. Työn ulkopuolella hän pelaa tennistä ja pyöräilee vuoristopoluilla.

Dhawal Patel on AWS:n koneoppimisarkkitehti. Hän on työskennellyt organisaatioiden kanssa suurista yrityksistä keskikokoisiin startup-yrityksiin hajautettuun tietojenkäsittelyyn ja tekoälyyn liittyvien ongelmien parissa. Hän keskittyy syväoppimiseen, mukaan lukien NLP- ja Computer Vision -alueet. Hän auttaa asiakkaita tekemään korkean suorituskyvyn mallipäätelmiä SageMakerissa.

Dhawal Patel on AWS:n koneoppimisarkkitehti. Hän on työskennellyt organisaatioiden kanssa suurista yrityksistä keskikokoisiin startup-yrityksiin hajautettuun tietojenkäsittelyyn ja tekoälyyn liittyvien ongelmien parissa. Hän keskittyy syväoppimiseen, mukaan lukien NLP- ja Computer Vision -alueet. Hän auttaa asiakkaita tekemään korkean suorituskyvyn mallipäätelmiä SageMakerissa.

Raghu Ramesha on vanhempi ML-ratkaisuarkkitehti Amazon SageMaker Service -tiimissä. Hän keskittyy auttamaan asiakkaita rakentamaan, ottamaan käyttöön ja siirtämään ML-tuotannon työmäärät SageMakeriin suuressa mittakaavassa. Hän on erikoistunut koneoppimiseen, tekoälyyn ja tietokonenäköalueisiin, ja hänellä on tietojenkäsittelytieteen maisterin tutkinto UT Dallasista. Vapaa-ajallaan hän nauttii matkustamisesta ja valokuvaamisesta.

Raghu Ramesha on vanhempi ML-ratkaisuarkkitehti Amazon SageMaker Service -tiimissä. Hän keskittyy auttamaan asiakkaita rakentamaan, ottamaan käyttöön ja siirtämään ML-tuotannon työmäärät SageMakeriin suuressa mittakaavassa. Hän on erikoistunut koneoppimiseen, tekoälyyn ja tietokonenäköalueisiin, ja hänellä on tietojenkäsittelytieteen maisterin tutkinto UT Dallasista. Vapaa-ajallaan hän nauttii matkustamisesta ja valokuvaamisesta.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://aws.amazon.com/blogs/machine-learning/boost-inference-performance-for-mixtral-and-llama-2-models-with-new-amazon-sagemaker-containers/

- :on

- :On

- :ei

- :missä

- $ YLÖS

- 1

- 10

- 100

- 125

- 13

- 14

- 15%

- 2023

- 2024

- 212

- 25

- 26%

- 27

- 7

- 8

- 9

- 98

- a

- kyky

- Meistä

- kiihdyttää

- kiihtyvyys

- kiihdytin

- kiihdyttimiä

- pääsy

- suorittaa

- tarkkuus

- Saavuttaa

- poikki

- sovitus

- lisätä

- lisä-

- Lisäominaisuudet

- lisää

- lisä-

- Lisäksi

- Lisää

- säätää

- haitallisesti

- mainonta

- vaikuttaa

- aggregaatti

- AI

- AI / ML

- Kaikki

- kohdennetaan

- Salliminen

- mahdollistaa

- pitkin

- Alpha

- Myös

- aina

- Amazon

- Amazon Sage Maker

- Amazon Web Services

- määrä

- an

- analyyttinen

- ja

- Kaikki

- api

- API

- Hakemus

- sovellukset

- käyttää

- OVAT

- artikkeli

- keinotekoinen

- tekoäly

- AS

- näkökohdat

- osoitettu

- At

- huomio

- attribuutteja

- automaattisesti

- saatavissa

- AWS

- AWS uudelleen: keksintö

- takaisin

- taustaosa

- taustoja

- Balance

- kaistanleveys

- perustua

- annostelu-

- BE

- koska

- ollut

- ennen

- käyttäytyminen

- takana

- ovat

- Viitearvot

- hyödyttää

- Hyödyt

- PARAS

- Paremmin

- välillä

- Iso

- elin

- edistää

- sekä

- Tauko

- laajasti

- puskuri

- rakentaa

- Rakentaminen

- mutta

- by

- Kätkö

- laskea

- soittaa

- Puhelut

- CAN

- kyvyt

- kaapata

- tapaus

- tapauksissa

- ketju

- kahlittu

- haastava

- Kanava

- ominaisuudet

- Kaavio

- tarkastaa

- valinta

- luokka

- luokittelu

- koodi

- Kollektiivinen

- yhdistetty

- tulee

- Yhteinen

- Viestintä

- verrattuna

- koottu

- täydellinen

- valmistuminen

- tietokone

- Tietojenkäsittelyoppi

- Tietokoneen visio

- tietojenkäsittely

- samanaikainen

- johtavat

- luottamus

- Konfigurointi

- konfigurointi

- näkökohdat

- kuluttaa

- kulutus

- Kontti

- Kontit

- sisältää

- pitoisuus

- Sisällön luominen

- tausta

- jatkaa

- jatkuva

- osaltaan

- avustaja

- ohjaus

- valvonta

- Hinta

- voisi

- crafting

- luoda

- luo

- Nykyinen

- Tällä hetkellä

- Asiakkaat

- räätälöidä

- leikkaamisreuna

- huipputeknologiaa

- Dallas

- tiedot

- päättää

- päätös

- syvä

- syvä oppiminen

- oletusarvo

- määritellä

- määrittelemällä

- Aste

- sijoittaa

- käyttöön

- levityspinnalta

- käyttöönotto

- Malli

- haluttu

- yksityiskohta

- yksityiskohtainen

- yksityiskohdat

- havaita

- Kehitys

- Laitteet

- kaavio

- eri

- ohjata

- suunnattu

- pohtia

- jaettu

- hajautettu laskenta

- do

- verkkotunnuksia

- alas

- lataaminen

- asemat

- kaksi

- aikana

- dynaamisesti

- kukin

- innokas

- vaikutus

- Tehokas

- tehokas

- tehokkaasti

- ponnisteluja

- myöskään

- upottamisen

- mahdollistaa

- mahdollistaa

- mahdollistaa

- loppu

- päätepiste

- Moottori

- insinööri

- Moottorit

- parantaa

- yrityksille

- Koko

- ympäristö

- EOS

- arvio

- arvioida

- Jopa

- tutkia

- esimerkki

- Paitsi

- innoissaan

- yksinomaan

- teloitus

- experience

- Elämykset

- asiantuntijat

- selittää

- tutkia

- räjähdysmäinen

- laajentaminen

- uute

- otteet

- tekijä

- Ominaisuus

- Ominaisuudet

- Featuring

- Haettu

- vähemmän

- Kuva

- filee

- rahoittaa

- viimeistely

- Etunimi

- virtaus

- Keskittää

- keskittyy

- tarkennus

- jälkeen

- varten

- voima

- muoto

- Puitteet

- Ilmainen

- alkaen

- ruokkivat

- koko

- toiminto

- tehtävät

- yleensä

- tuottaa

- syntyy

- tuottaa

- sukupolvi

- saada

- tietty

- antaa

- Go

- GPU

- gpu:n suorituskyky

- GPU

- kaavio

- kaaviot

- suurempi

- kasvaa

- ohjaavat

- Oppaat

- luovuttamalla

- kahva

- Palvelimet

- Olla

- he

- päät

- raskas

- raskas nosto

- auttaa

- auttaa

- Korkea

- korkea suorituskyky

- korkeampi

- Korostettu

- hänen

- pitää

- isäntä

- isännöi

- hotellit

- Miten

- Miten

- HTML

- http

- HTTPS

- ihmisen

- ID

- ajatus

- if

- havainnollistaa

- kuva

- täytäntöönpano

- täytäntöönpanosta

- tuoda

- tärkeä

- tuovan

- parani

- parannuksia

- parantaminen

- in

- perusteellinen

- mukana

- Mukaan lukien

- Kasvaa

- kasvoi

- Lisäykset

- lisäys

- alustava

- henkilökohtainen

- Erikseen

- pääteltyihin

- tiedot

- Infrastruktuuri

- ensimmäinen

- panos

- tuloa

- sisällä

- innoittamana

- asennetaan

- esimerkki

- sen sijaan

- ohjeet

- vakuutus

- Älykkyys

- vuorovaikutuksessa

- liitäntä

- tulee

- käyttöön

- Esittelee

- käyttöön

- kysymykset

- IT

- iteraatio

- SEN

- tammikuu

- JIT

- tuloaan

- yhteinen

- jpeg

- jpg

- json

- vain

- avain

- tuntemus

- Kieli

- suuri

- Suuret yritykset

- suurempi

- Sukunimi

- Viive

- uusin

- käynnistettiin

- käynnistäminen

- OPPIA

- oppiminen

- jättäen

- Pituus

- Taso

- kirjastot

- nosto

- pitää

- linja

- linjat

- Lista

- liekki

- OTK

- lastaus

- paikallinen

- sijainti

- log

- hakkuu

- kauemmin

- Matala

- alentaa

- kone

- koneoppiminen

- tehdä

- onnistui

- johto

- manuaalinen

- monet

- maisterin

- ottelu

- max

- maksimi

- tarkoittaa

- mitata

- mekanismi

- Meets

- Muisti

- menetelmät

- Metrics

- vaeltaa

- minimi

- minuuttia

- seos

- ML

- MLOps

- tila

- malli

- mallit

- monitori

- lisää

- Vuori

- paljon

- moninkertainen

- nimi

- syntyperäinen

- Tarve

- tarpeet

- NEO

- Uusi

- Uudet ominaisuudet

- hiljattain

- seuraava

- NLP

- Ei eristetty

- muistikirja

- nyt

- numero

- numpy

- Nvidia

- objekti

- of

- kampanja

- Tarjoukset

- offset

- on

- ONE

- vain

- Operations

- optimointi

- optimointeja

- Optimoida

- optimoitu

- optimoimalla

- Vaihtoehto

- or

- organisaatioiden

- alkuperäinen

- Meitä

- Muut

- Muuta

- meidän

- ulostulo

- lähdöt

- ulkopuolella

- yli

- yleinen

- yläpuolella

- paketti

- paketit

- Parallel

- parametri

- parametrit

- osa

- erityisesti

- Ohimenevä

- Ohi

- Kuvio

- varten

- suorituskyky

- valokuvaus

- foorumi

- Platforms

- Platon

- Platonin tietotieto

- PlatonData

- pelaa

- Suosittu

- sijainti

- mahdollinen

- Kirje

- ennustus

- esittää

- edellinen

- Pääasiallinen

- Painaa

- Aikaisempi

- todennäköisyydet

- ongelmia

- Käsitelty

- Prosessit

- tuotanto

- Tuotteemme

- ominaisuudet

- toimittaa

- tarjoamalla

- pytorch

- laatu

- kysymys

- nostaa

- alainen

- Sijoitus

- RE

- päästäisiin

- Lue

- Lukeminen

- reaaliaikainen

- reason

- äskettäin

- suositeltu

- vähentää

- katso

- alue

- säännöllinen

- säännöllisesti

- liittyvä

- vapauta

- poistaa

- säilytyspaikka

- pyyntö

- pyynnöt

- tarvitaan

- vaatimukset

- Vaatii

- resurssi

- vastaus

- Saatu ja

- tulokset

- palata

- Tuotto

- oikein

- Rooli

- ajaa

- toimii

- runtime

- sagemaker

- sama

- Asteikko

- skaalaus

- tiede

- pisteet

- pisteytys

- Osa

- sektori

- nähdä

- etsiä

- valittu

- SELF

- vanhempi

- lähetetty

- Järjestys

- palvella

- palvelin

- palvelu

- Palvelut

- palvelevat

- Istunto

- setti

- Setit

- useat

- sharding

- Sharma

- shouldnt

- samalla lailla

- Yksinkertainen

- yksinkertaistetaan

- single

- Koko

- pieni

- So

- Tuotteemme

- ohjelmistokehitys

- Ratkaisumme

- jonkin verran

- asiantuntija

- erikoistunut

- erityisesti

- määritelty

- nopeus

- käytetty

- Alkaa

- alkoi

- Aloita

- Startups

- huippu-

- Yhä

- stop

- Levytila

- strategiat

- Strategia

- virta

- virtasi

- streaming

- puroihin

- studio

- Myöhemmin

- Onnistuneesti

- niin

- Puku

- tuki

- Tuetut

- Tukee

- varma

- järjestelmä

- järjestelmät

- taulukko

- vie

- Tehtävä

- joukkue-

- tekniikat

- Elektroniikka

- tennis

- teksti

- kuin

- että

- -

- nivel

- Linja

- heidän

- Niitä

- Nämä

- tätä

- ne

- vaikka?

- Kautta

- suoritusteho

- aika

- että

- yhdessä

- symbolinen

- tokens

- liian

- raita

- liikenne

- Juna

- koulutettu

- koulutus

- muuntaja

- Matkustaminen

- puu

- totta

- yrittää

- kaksi

- Tyler

- tyypit

- ennallaan

- taustalla oleva

- ymmärtää

- ymmärtäminen

- asti

- Päivitykset

- päivitetty

- ladattu

- käytettävyys

- Käyttö

- käyttää

- käyttölaukku

- käytetty

- hyödyllinen

- käyttäjä

- käyttämällä

- arvo

- eri

- versio

- hyvin

- käytännössä

- visio

- kävellä

- käveli

- haluta

- oli

- we

- verkko

- verkkopalvelut

- Verkkosivu

- HYVIN

- Mitä

- kun

- joka

- vaikka

- KUKA

- tulee

- ikkuna

- with

- sisällä

- ilman

- Referenssit

- työskenteli

- työntekijöitä

- työskentely

- kirjoittaminen

- vuotta

- vielä

- Voit

- Sinun

- zephyrnet