A mai napon örömmel jelentjük be, hogy a Meta által kifejlesztett Llama 2 alapozó modellek elérhetőek az ügyfelek számára Amazon SageMaker JumpStart. A Llama 2 nagy nyelvi modellek (LLM) családja előre betanított és finomhangolt generatív szövegmodellek gyűjteménye, 7 milliárdtól 70 milliárdig terjedő skálán. A finomhangolt LLM-ek, az úgynevezett Llama-2-chat, párbeszédes felhasználási esetekre vannak optimalizálva. Könnyedén kipróbálhatja ezeket a modelleket, és használhatja őket a SageMaker JumpStarttal, amely egy gépi tanulási (ML) központ, amely hozzáférést biztosít az algoritmusokhoz, modellekhez és ML-megoldásokhoz, így gyorsan elkezdheti az ML használatát.

Ebben a bejegyzésben végigvezetjük a Llama 2 modellek használatát a SageMaker JumpStart segítségével.

Mi az a Llama 2

A Llama 2 egy automatikusan regresszív nyelvi modell, amely optimalizált transzformátor architektúrát használ. A Llama 2 angol nyelvű kereskedelmi és kutatási használatra készült. Számos paraméterméretben – 7 milliárd, 13 milliárd és 70 milliárd –, valamint előre betanított és finomhangolt variációkban kapható. A Meta szerint a hangolt változatok felügyelt finomhangolást (SFT) és megerősítő tanulást emberi visszacsatoláson (RLHF) használnak, hogy igazodjanak az emberi preferenciákhoz a segítőkészség és a biztonság érdekében. A Llama 2-t 2 billió tokennyi, nyilvánosan elérhető forrásból származó adatra képezték ki. A hangolt modellek asszisztens-szerű csevegésre szolgálnak, míg az előre betanított modellek különféle természetes nyelvgenerálási feladatokra adaptálhatók. Függetlenül attól, hogy a fejlesztő a modell melyik verzióját használja, a felelős használati útmutató a Metától segíthet a további finomhangolásokban, amelyek szükségesek lehetnek a modellek testreszabásához és optimalizálásához a megfelelő biztonsági intézkedésekkel.

Mi az a SageMaker JumpStart

A SageMaker JumpStart segítségével az ML gyakorlói a nyílt forráskódú alapozó modellek széles választékából választhatnak. Az ML gyakorlói alapmodelleket telepíthetnek dedikált Amazon SageMaker példányokat egy hálózattól elszigetelt környezetből, és testreszabhatja a modelleket a SageMaker segítségével a modell betanítására és telepítésére.

Most már néhány kattintással felfedezheti és üzembe helyezheti a Llama 2-t Amazon SageMaker Studio vagy programozottan a SageMaker Python SDK-n keresztül, lehetővé téve a modell teljesítményének és az MLOps vezérlők származtatását a SageMaker funkciókkal, mint pl. Amazon SageMaker csővezetékek, Amazon SageMaker Debuggervagy konténernaplókat. A modellt AWS biztonságos környezetben és az Ön VPC-vezérlése alatt helyezik üzembe, így biztosítva az adatbiztonságot. A Llama 2 modellek ma elérhetőek az Amazon SageMaker Stúdióban, kezdetben us-east 1 és a us-west 2 régiók.

Fedezze fel a modelleket

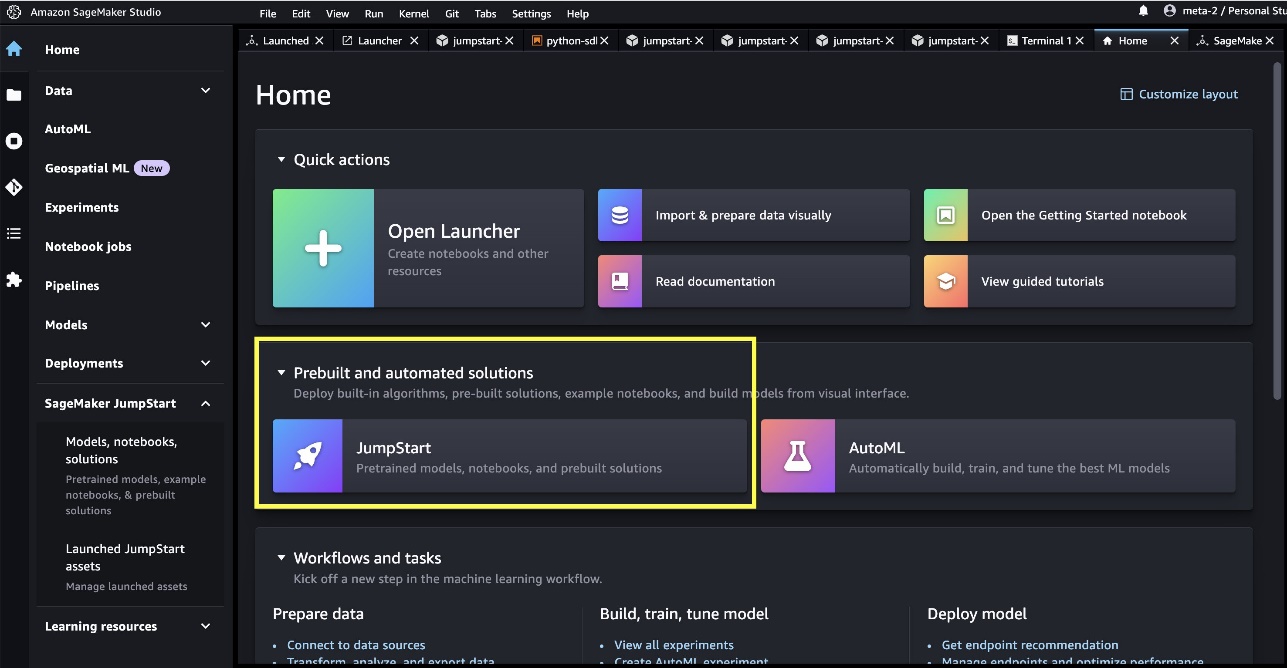

Az alapmodelleket a SageMaker JumpStart segítségével érheti el a SageMaker Studio UI-ban és a SageMaker Python SDK-ban. Ebben a részben áttekintjük, hogyan fedezheti fel a modelleket a SageMaker Stúdióban.

A SageMaker Studio egy integrált fejlesztői környezet (IDE), amely egyetlen web-alapú vizuális felületet biztosít, ahol hozzáférhet a célra épített eszközökhöz az ML fejlesztési lépések elvégzéséhez, az adatok előkészítésétől az ML modellek felépítéséig, betanításáig és telepítéséig. A SageMaker Studio megkezdésével és beállításával kapcsolatos további részletekért lásd: Amazon SageMaker Studio.

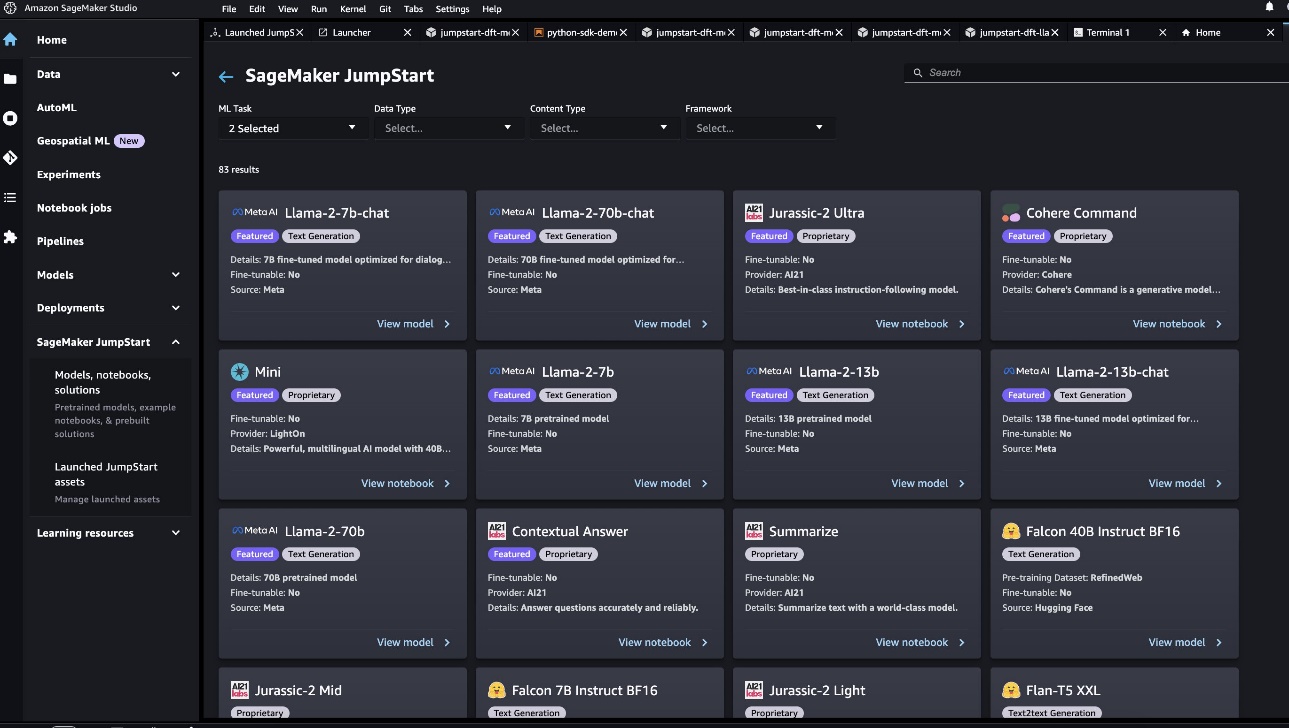

A SageMaker Studio használata után elérheti a SageMaker JumpStart alkalmazást, amely előre betanított modelleket, notebookokat és előre elkészített megoldásokat tartalmaz. Előre elkészített és automatizált megoldások.

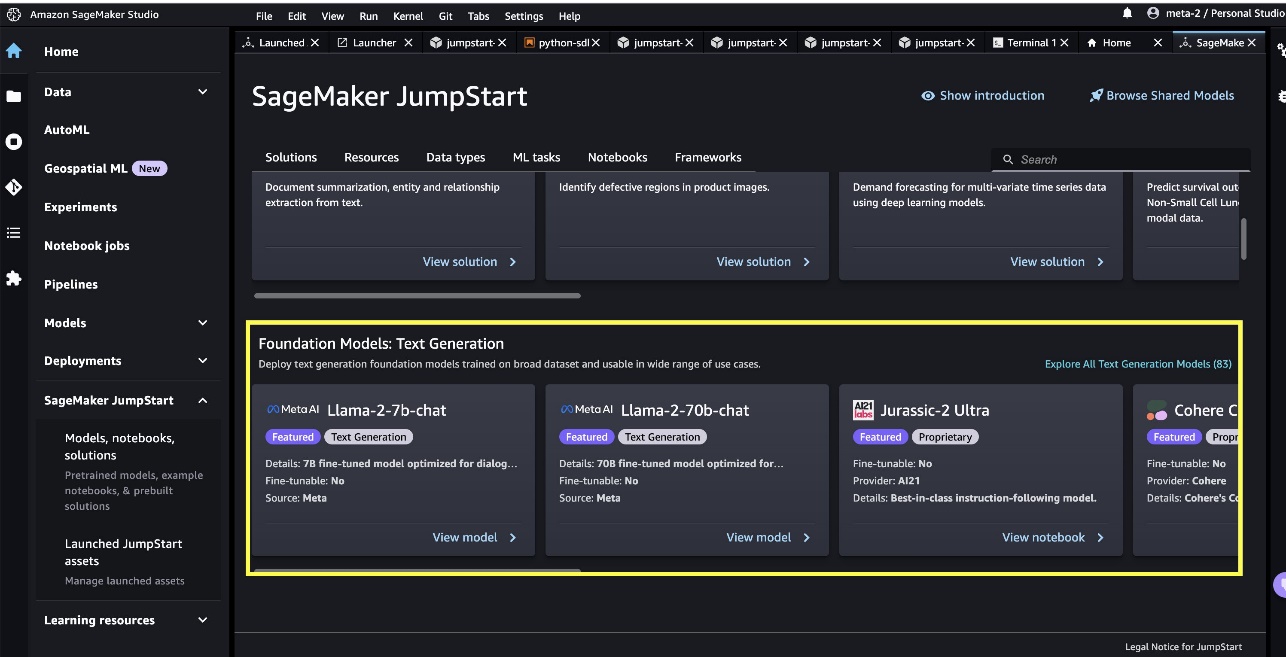

A SageMaker JumpStart nyitóoldalán megoldások, modellek, notebookok és egyéb források között böngészhet. Két zászlóshajó Llama 2 modellt találhat az oldalon Alapozó modellek: Szöveggenerálás körhinta. Ha nem látja a Llama 2 modelleket, frissítse a SageMaker Studio verzióját úgy, hogy leállítja és újraindítja. A verziófrissítésekkel kapcsolatos további információkért lásd: Állítsa le és frissítse a Studio alkalmazásokat.

Választással további négy modellváltozatot is találhat Fedezze fel az összes szöveggenerációs modellt vagy keres llama a keresőmezőbe.

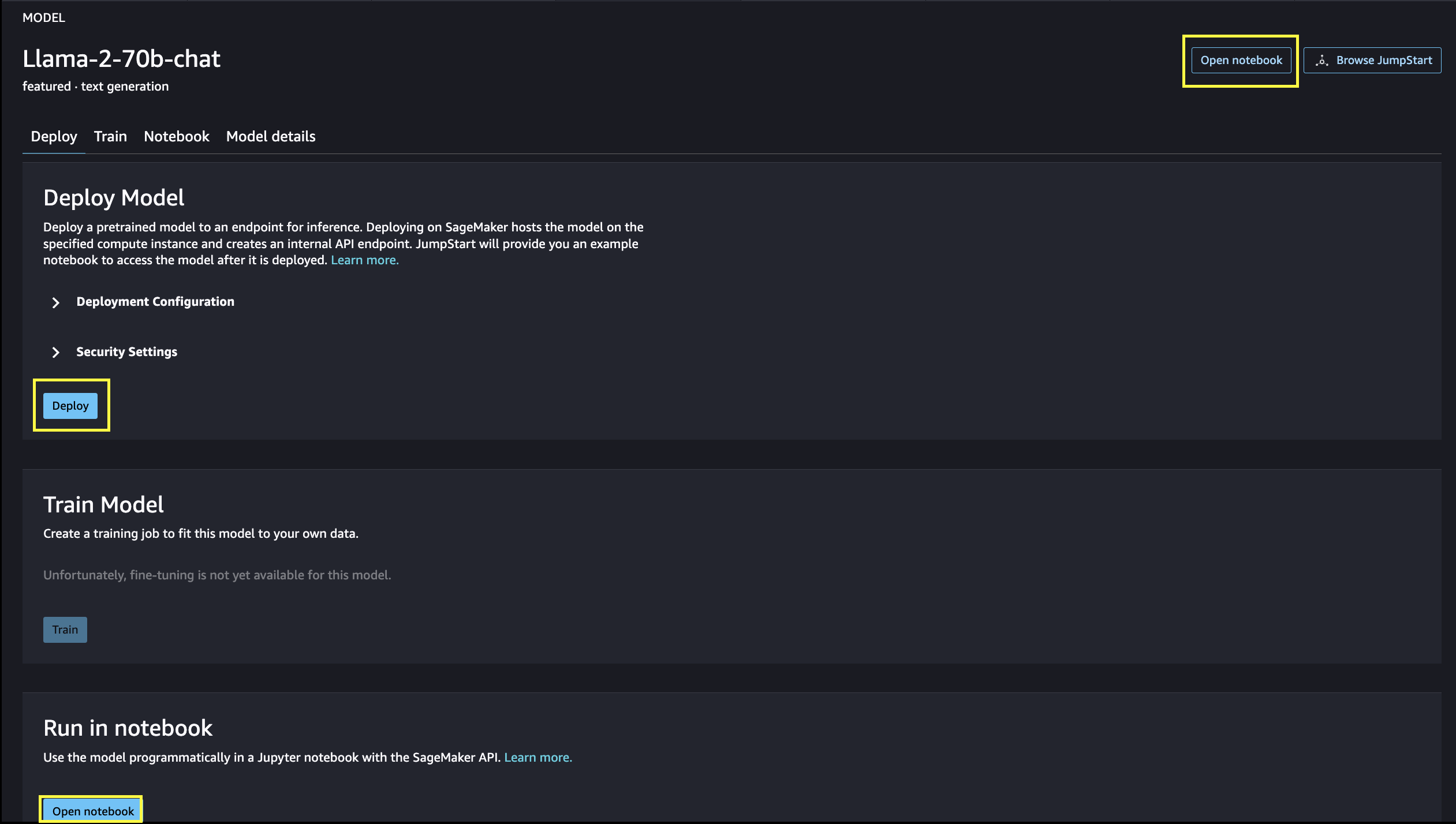

A modellkártya kiválasztásával megtekintheti a modell részleteit, például a licencet, a betanításhoz használt adatokat és a használat módját. Két gombot is találhat, Telepítése és a Nyissa meg a Jegyzetfüzetet, amelyek segítenek a modell használatában.

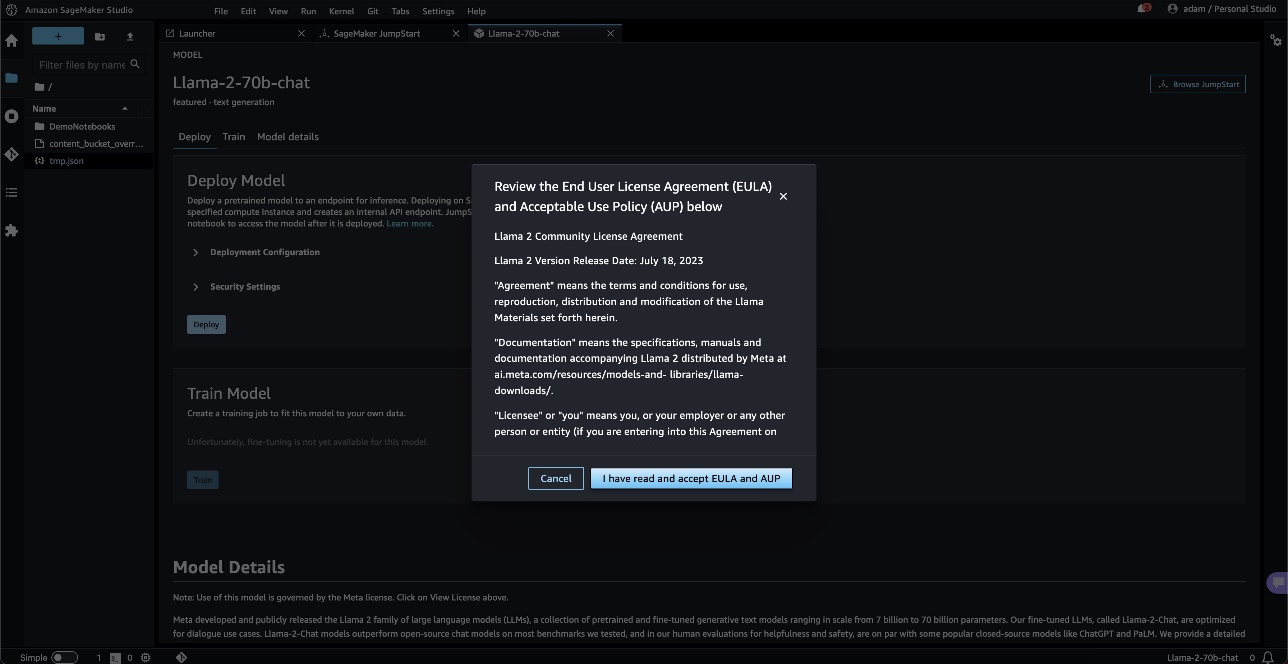

Ha bármelyik gombot választja, egy felugró ablakban megjelenik a végfelhasználói licencszerződés és az elfogadható használati szabályzat, amelyet tudomásul kell venni.

A nyugtázás után továbblép a modell használatának következő lépésére.

Telepítsen egy modellt

Ha úgy dönt Telepítése és nyugtázza a feltételeket, megkezdődik a modell bevezetése. Alternatív megoldásként telepítheti a példa-jegyzetfüzeten keresztül, amely a választással megjelenik Nyissa meg a Jegyzetfüzetet. A példajegyzetfüzet teljes körű útmutatást nyújt a modell telepítéséhez a következtetések levonásához és az erőforrások tisztításához.

A notebook használatával történő üzembe helyezéshez először kiválasztjuk a megfelelő modellt, amelyet a model_id. A kiválasztott modellek bármelyikét üzembe helyezheti a SageMakerben a következő kóddal:

Ez a SageMaker modellt alapértelmezett konfigurációkkal telepíti, beleértve az alapértelmezett példánytípust és az alapértelmezett VPC-konfigurációkat. Módosíthatja ezeket a konfigurációkat a nem alapértelmezett értékek megadásával JumpStartModel. A telepítés után a SageMaker előrejelzőn keresztül következtetéseket futtathat a telepített végponttal kapcsolatban:

A finomhangolt csevegési modellek (Llama-2-7b-chat, Llama-2-13b-chat, Llama-2-70b-chat) elfogadják a csevegés előzményeit a felhasználó és a csevegési asszisztens között, és létrehozzák a következő csevegést. Az előre betanított modellek (Llama-2-7b, Llama-2-13b, Llama-2-70b) karakterlánc-promptot igényelnek, és a szövegkiegészítést a megadott prompton hajtják végre. Lásd a következő kódot:

Vegye figyelembe, hogy alapértelmezés szerint accept_eula hamisra van állítva. Be kell állítani accept_eula=true a végpont sikeres meghívásához. Ezzel elfogadja a felhasználói licencszerződést és a korábban említett elfogadható használati szabályzatot. Te is letöltés a licencszerződést.

Custom_attributes Az EULA átadására kulcs/érték párokat használnak. A kulcs és az érték a következővel van elválasztva = és a párokat a ;. Ha a felhasználó többször is átadja ugyanazt a kulcsot, akkor az utolsó érték megmarad, és átadja a szkriptkezelőnek (azaz ebben az esetben feltételes logikára használják). Például ha accept_eula=false; accept_eula=true akkor átkerül a szerverhez accept_eula=true megőrzi és átadja a szkriptkezelőnek.

A következtetési paraméterek vezérlik a szöveggenerálási folyamatot a végponton. A maximális új tokenek vezérlése a modell által generált kimenet méretére vonatkozik. Vegye figyelembe, hogy ez nem azonos a szavak számával, mert a modell szókincse nem egyezik meg az angol nyelv szókincsével, és előfordulhat, hogy az egyes token nem angol nyelvű szó. A hőmérséklet szabályozza a kimenet véletlenszerűségét. A magasabb hőmérséklet kreatívabb és hallucináltabb kimeneteket eredményez. Az összes következtetési paraméter nem kötelező.

A következő táblázat felsorolja a SageMaker JumpStartban elérhető összes Llama modellt, valamint a model_ids, alapértelmezett példánytípusok és az egyes modelleknél támogatott teljes tokenek maximális száma (a bemeneti tokenek számának és a generált tokenek számának összege).

| Modell neve | Modellazonosító | Max Total Tokens | Alapértelmezett példánytípus |

| Láma-2-7b | meta-szöveggeneráció-láma-2-7b | 4096 | ml.g5.2xnagy |

| Láma-2-7b-csevegés | meta-szöveggeneráció-láma-2-7b-f | 4096 | ml.g5.2xnagy |

| Láma-2-13b | meta-szöveggeneráció-láma-2-13b | 4096 | ml.g5.12xnagy |

| Láma-2-13b-csevegés | meta-szöveggeneráció-láma-2-13b-f | 4096 | ml.g5.12xnagy |

| Láma-2-70b | meta-szöveggeneráció-láma-2-70b | 4096 | ml.g5.48xnagy |

| Láma-2-70b-csevegés | meta-szöveggeneráció-láma-2-70b-f | 4096 | ml.g5.48xnagy |

Vegye figyelembe, hogy a SageMaker végpontok időkorlátja 60 másodperc. Így, bár a modell képes lehet 4096 tokent generálni, ha a szöveggenerálás több mint 60 másodpercet vesz igénybe, a kérés sikertelen lesz. A 7B, 13B és 70B modellekhez javasoljuk a beállítást max_new_tokens nem lehet nagyobb 1500-nál, 1000-nél és 500-nál, miközben a tokenek teljes száma 4K alatt marad.

Következtetési és példakérdések a Llama-2-70b-hez

A Llama modelleket bármilyen szövegrészhez használhatja a szöveg kiegészítésére. A szöveggenerálás révén különféle feladatokat hajthat végre, mint például kérdések megválaszolása, nyelvi fordítás, hangulatelemzés és még sok más. A végpontba bevitt hasznos terhelés a következő kódhoz hasonlóan néz ki:

Az alábbiakban néhány példa-parancssor és a modell által generált szöveg található. Minden kimenet következtetési paraméterekkel jön létre {"max_new_tokens":256, "top_p":0.9, "temperature":0.6}.

A következő példában bemutatjuk, hogyan kell használni a láma modelleket néhány felvételes kontextuson belüli tanulással, ahol a modell számára elérhető képzési mintákat biztosítunk. Vegye figyelembe, hogy csak a telepített modellre vonunk le következtetéseket, és a folyamat során a modell súlya nem változik.

Következtetési és példakérdések a Llama-2-70b-chathez

A párbeszédes felhasználási esetekre optimalizált Llama-2-Chat modelleknél a csevegési modell végpontjainak bemenete a csevegési asszisztens és a felhasználó közötti korábbi történet. Kérdéseket tehet fel az eddigi beszélgetéssel összefüggésben. Megadhatja a rendszerkonfigurációt is, például személyeket, amelyek meghatározzák a csevegési asszisztens viselkedését. A végpont bemeneti hasznos terhelése a következő kódhoz hasonlóan néz ki:

Az alábbiakban néhány példa-parancssor és a modell által generált szöveg található. Minden kimenet a következtetési paraméterekkel generálódik {"max_new_tokens": 512, "top_p": 0.9, "temperature": 0.6}.

A következő példában a felhasználó beszélgetést folytatott az asszisztenssel Párizs turisztikai helyszíneiről. Ezután a felhasználó a chat-asszisztens által javasolt első lehetőségről érdeklődik.

A következő példákban beállítjuk a rendszer konfigurációját:

Tisztítsuk meg

Miután befejezte a jegyzetfüzet futtatását, mindenképpen töröljön minden erőforrást, így a folyamat során létrehozott összes erőforrás törlődik, és a számlázás leáll:

Következtetés

Ebben a bejegyzésben megmutattuk, hogyan kezdje el a Llama 2 modelleket a SageMaker Stúdióban. Ezzel hat Llama 2 alapozó modellhez férhet hozzá, amelyek több milliárd paramétert tartalmaznak. Mivel az alapmodellek előre betanítottak, segíthetnek csökkenteni a képzési és infrastrukturális költségeket, és lehetővé teszik a testreszabást az Ön használati esetéhez. A SageMaker JumpStart használatának megkezdéséhez keresse fel a következő forrásokat:

A szerzőkről

June nyert a SageMaker JumpStart termékmenedzsere. Arra összpontosít, hogy az alapmodelleket könnyen felfedezhetővé és használhatóvá tegye, hogy segítse az ügyfeleket generatív AI-alkalmazások létrehozásában. Az Amazonnál szerzett tapasztalatai közé tartozik a mobil vásárlási alkalmazás és az utolsó mérföldes szállítás is.

June nyert a SageMaker JumpStart termékmenedzsere. Arra összpontosít, hogy az alapmodelleket könnyen felfedezhetővé és használhatóvá tegye, hogy segítse az ügyfeleket generatív AI-alkalmazások létrehozásában. Az Amazonnál szerzett tapasztalatai közé tartozik a mobil vásárlási alkalmazás és az utolsó mérföldes szállítás is.

Dr. Vivek Madan az Amazon SageMaker JumpStart csapatának alkalmazott tudósa. PhD fokozatát az Illinoisi Egyetemen szerezte, az Urbana-Champaign-ben, és a Georgia Tech posztdoktori kutatója volt. Aktív kutatója a gépi tanulásnak és az algoritmustervezésnek, és publikált előadásokat EMNLP, ICLR, COLT, FOCS és SODA konferenciákon.

Dr. Vivek Madan az Amazon SageMaker JumpStart csapatának alkalmazott tudósa. PhD fokozatát az Illinoisi Egyetemen szerezte, az Urbana-Champaign-ben, és a Georgia Tech posztdoktori kutatója volt. Aktív kutatója a gépi tanulásnak és az algoritmustervezésnek, és publikált előadásokat EMNLP, ICLR, COLT, FOCS és SODA konferenciákon.  Dr. Kyle Ulrich az Amazon SageMaker JumpStart csapatának alkalmazott tudósa. Kutatási területei közé tartoznak a skálázható gépi tanulási algoritmusok, a számítógépes látás, az idősorok, a Bayes-féle nem-paraméterek és a Gauss-folyamatok. Doktori fokozatát a Duke Egyetemen szerezte, és publikációkat publikált a NeurIPS-ben, a Cell-ben és a Neuron-ban.

Dr. Kyle Ulrich az Amazon SageMaker JumpStart csapatának alkalmazott tudósa. Kutatási területei közé tartoznak a skálázható gépi tanulási algoritmusok, a számítógépes látás, az idősorok, a Bayes-féle nem-paraméterek és a Gauss-folyamatok. Doktori fokozatát a Duke Egyetemen szerezte, és publikációkat publikált a NeurIPS-ben, a Cell-ben és a Neuron-ban.  Dr. Ashish Khetan az Amazon SageMaker JumpStart vezető alkalmazott tudósa, és segít gépi tanulási algoritmusok fejlesztésében. PhD fokozatát az Illinois Urbana-Champaign Egyetemen szerezte. A gépi tanulás és a statisztikai következtetések aktív kutatója, és számos közleményt publikált NeurIPS, ICML, ICLR, JMLR, ACL és EMNLP konferenciákon.

Dr. Ashish Khetan az Amazon SageMaker JumpStart vezető alkalmazott tudósa, és segít gépi tanulási algoritmusok fejlesztésében. PhD fokozatát az Illinois Urbana-Champaign Egyetemen szerezte. A gépi tanulás és a statisztikai következtetések aktív kutatója, és számos közleményt publikált NeurIPS, ICML, ICLR, JMLR, ACL és EMNLP konferenciákon.  Sundar Ranganathan az AWS GenAI/Frameworks GTM specialistáinak globális vezetője. GTM-stratégia fejlesztésére összpontosít nagy nyelvi modellekhez, GenAI-hoz és nagyszabású ML-munkaterhelésekhez olyan AWS-szolgáltatásokban, mint az Amazon EC2, EKS, EFA, AWS Batch és Amazon SageMaker. Tapasztalatai közé tartozik a termékmenedzsment és termékfejlesztés vezetői szerepe a NetApp-nál, a Micron Technology-nál, a Qualcommnál és a Mentor Graphicsnál.

Sundar Ranganathan az AWS GenAI/Frameworks GTM specialistáinak globális vezetője. GTM-stratégia fejlesztésére összpontosít nagy nyelvi modellekhez, GenAI-hoz és nagyszabású ML-munkaterhelésekhez olyan AWS-szolgáltatásokban, mint az Amazon EC2, EKS, EFA, AWS Batch és Amazon SageMaker. Tapasztalatai közé tartozik a termékmenedzsment és termékfejlesztés vezetői szerepe a NetApp-nál, a Micron Technology-nál, a Qualcommnál és a Mentor Graphicsnál.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Autóipar / elektromos járművek, Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- BlockOffsets. A környezetvédelmi ellentételezési tulajdon korszerűsítése. Hozzáférés itt.

- Forrás: https://aws.amazon.com/blogs/machine-learning/llama-2-foundation-models-from-meta-are-now-available-in-amazon-sagemaker-jumpstart/

- :van

- :is

- :nem

- :ahol

- $ UP

- 1

- 10

- 100

- 11

- 13

- 15%

- 17

- 19

- 20

- 30

- 31

- 33

- 360 fokos

- 40

- 4k

- 500

- 7

- 70

- 8

- 9

- a

- Képes

- Rólunk

- Elfogad!

- elfogadható

- hozzáférés

- megközelíthetőség

- hozzáférhető

- Szerint

- elismerni

- át

- aktív

- hozzá

- hozzáadásával

- További

- cím

- Után

- újra

- ellen

- Megállapodás

- AI

- algoritmus

- algoritmusok

- összehangolása

- Minden termék

- lehetővé

- mentén

- Is

- mindig

- am

- amazon

- Amazon EC2

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon SageMaker Studio

- Az Amazon Web Services

- Amerikai

- an

- elemzés

- és a

- és az infrastruktúra

- bejelent

- Másik

- válasz

- bármilyen

- bárki

- Alkalmazás

- alkalmazások

- alkalmazott

- méltányol

- megfelelő

- Ív

- építészet

- VANNAK

- Művészet

- AS

- segít

- Helyettes

- At

- Légkör

- látnivalók

- Automatizált

- elérhető

- AWS

- Banán

- alapvető

- Csata

- bayesi

- BE

- szép

- szépség

- lett

- mert

- válik

- óta

- sör

- előtt

- viselkedés

- Peking

- Hisz

- úgy

- BEST

- között

- számlázás

- Billió

- milliárd

- Fekete

- Doboz

- szünet

- lélegzetelállító

- széles

- épít

- Épület

- épült

- de

- gomb

- by

- hívott

- TUD

- tőke

- autó

- kártya

- körhinta

- eset

- esetek

- CAT

- változik

- Csokoládé

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a

- választja

- Város

- klasszikus

- kód

- gyűjtemény

- kombinált

- kombájnok

- jön

- érkező

- kereskedelmi

- vállalat

- befejezés

- számítógép

- Számítógépes látás

- konferenciák

- magabiztos

- Configuration

- figyelembe vett

- állandó

- építés

- tartalmaz

- Konténer

- tartalmaz

- tartalom

- szövegre vonatkozó

- folytatódik

- folyamatosan

- ellenőrzés

- ellenőrzések

- Kényelmes

- Beszélgetés

- kiadások

- ország

- bátorság

- terjed

- teremt

- készítette

- Kreatív

- kulturális

- kultúra

- Csésze

- Ügyfelek

- testreszabás

- testre

- dátum

- adatbiztonság

- elszánt

- ajánlás

- alapértelmezett

- meghatározott

- kézbesítés

- telepíteni

- telepített

- bevezetéséhez

- bevetés

- bevet

- Design

- tervezett

- kívánatos

- rendeltetési hely

- úticél

- részletek

- Fejleszt

- fejlett

- Fejlesztő

- fejlesztése

- Fejlesztés

- Párbeszéd

- különbség

- különböző

- nehéz

- felfedez

- megkülönböztető

- do

- dokumentumfilmek

- Ennek

- csinált

- ne

- megduplázódott

- le-

- Herceg

- herceg egyetem

- alatt

- e

- minden

- Korábban

- könnyen

- könnyű

- Edward

- Einstein

- bármelyik

- lehetővé

- lehetővé téve

- végén

- végtől végig

- Endpoint

- Mérnöki

- Angol

- élvez

- elég

- biztosítására

- Környezet

- felszerelés

- Éter

- Még

- események

- mindenki

- példa

- példák

- izgatott

- tapasztalat

- kísérlet

- kísérletek

- expressz

- FAIL

- Sikertelen

- igazságos

- hamis

- család

- híres

- messze

- tett

- jellegű

- Jellemzők

- Visszacsatolás

- láb

- kevés

- filmek

- utolsó

- Végül

- Találjon

- vezetéknév

- zászlóshajó

- Úszó

- flow

- koncentrál

- következő

- A

- Előre

- talált

- Alapítvány

- négy

- Franciaország

- francia

- ból ből

- teljesen

- további

- jövő

- általános

- generál

- generált

- generáció

- nemző

- Generatív AI

- Grúzia

- kap

- Ad

- üveg

- Globális

- Go

- megy

- grafika

- nagy

- nagyobb

- úttörő

- Nő

- útmutatást

- útmutató

- kellett

- Fogantyúk

- történt

- boldog

- Kemény

- kemény munka

- Legyen

- tekintettel

- he

- fej

- segít

- segít

- segít

- itt

- hi

- Magas

- <p></p>

- övé

- történeti

- történelem

- ház

- Hogyan

- How To

- HTML

- HTTPS

- Kerékagy

- emberi

- i

- ikonszerű

- ötlet

- if

- ii

- Illinois

- Hatás

- importál

- fontos

- hatásos

- in

- tartalmaz

- magában foglalja a

- Beleértve

- Bejegyzett

- információ

- Infrastruktúra

- alapvetően

- bemenet

- inspirálta

- inspiráló

- példa

- azonnal

- utasítás

- integrált

- szándékolt

- érdekek

- Felület

- bele

- izolált

- IT

- ITS

- utazás

- jpg

- éppen

- tartás

- tartotta

- Kulcs

- Kedves

- Ismer

- ismert

- leszállási

- tájékozódási pont

- nyelv

- nagy

- nagyarányú

- legnagyobb

- keresztnév

- Késő

- indít

- törvények

- Vezetés

- TANUL

- Tanulj és nőj

- tanulás

- legkevésbé

- kevesebb

- szintek

- Engedély

- élet

- fény

- mint

- LIMIT

- listák

- irodalom

- ll

- Láma

- logika

- Hosszú

- hosszú idő

- keres

- MEGJELENÉS

- szerelem

- szeretett

- alacsonyabb

- gép

- gépi tanulás

- készült

- csinál

- KÉSZÍT

- Gyártás

- vezetés

- menedzser

- sok

- csoda

- Anyag

- maximális

- Lehet..

- jelenti

- intézkedés

- Média

- közepes

- említett

- üzenet

- meta

- mikron

- perc

- Perc

- keverék

- ML

- MLOps

- Mobil

- modell

- modellek

- pillanat

- hónap

- több

- a legtöbb

- Legnepszerubb

- mozgás

- film

- sok

- múzeum

- Múzeumok

- zene

- név

- Természetes

- elengedhetetlen

- Szükség

- szükséges

- hálózat

- Új

- New York

- következő

- nem

- jegyzetfüzet

- Most

- szám

- számos

- NY

- of

- ajánlat

- felajánlás

- Ajánlatok

- Olaj

- on

- egyszer

- ONE

- csak

- nyitva

- nyílt forráskódú

- Optimalizálja

- optimalizált

- opció

- or

- Más

- Egyéb

- másképp

- mi

- ki

- teljesítmény

- felett

- átfogó

- oldal

- párok

- Papír

- papírok

- paraméter

- paraméterek

- Párizs

- rész

- elhalad

- Elmúlt

- bérletek

- múlt

- béke

- Teljesít

- teljesítmény

- állandó

- telefon

- fényképek

- Fizika

- darab

- Pizza

- műanyag

- Plató

- Platón adatintelligencia

- PlatoData

- játszott

- politika

- pop-up

- Népszerű

- állás

- postai

- Predictor

- preferenciák

- előkészítése

- be

- előző

- folyamat

- Folyamatok

- Termékek

- termékfejlesztés

- termékmenedzsment

- termék menedzser

- javaslatok

- büszke

- ad

- feltéve,

- biztosít

- amely

- nyilvános

- tömegközlekedési

- nyilvánosan

- közzétett

- cél

- tesz

- Piton

- Qualcomm

- Kérdések

- Quick

- gyorsan

- rámpák

- véletlenszerűség

- hatótávolság

- kezdve

- kész

- miatt

- kap

- recept

- ajánl

- ajánlott

- kifejezés

- Tekintet nélkül

- régiók

- relatív

- relativitás

- megismételt

- képvisel

- kérni

- megköveteli,

- kutatás

- kutató

- Tudástár

- illetőleg

- Reagálni

- REST

- eredményez

- Eredmények

- Folyó

- Szerep

- szerepek

- futás

- futás

- s

- Biztonság

- sagemaker

- só

- azonos

- skálázható

- Skála

- Tudós

- tudósok

- sdk

- SEA

- Keresés

- keres

- Rész

- biztonság

- biztonság

- lát

- látás

- Úgy tűnt

- kiválasztott

- kiválasztása

- kiválasztás

- küld

- idősebb

- érzés

- Series of

- Szolgáltatások

- szolgáló

- készlet

- beállítás

- Alak

- cápa

- Bevásárlás

- kellene

- előadás

- kimutatta,

- Műsorok

- leállítás

- jelentőség

- jelentős

- Egyszerű

- egyszerűen

- egyetlen

- weboldal

- Webhely (ek)

- SIX

- Méret

- Lassan

- kicsi

- So

- eddig

- Közösség

- Közösségi média

- Megoldások

- néhány

- forrás

- Források

- speciális

- szakemberek

- meghatározott

- sebesség

- állványok

- kezdet

- kezdődött

- Állami

- Államok

- statisztikai

- Lépés

- Lépései

- megállt

- Stratégia

- Húr

- struktúra

- stúdió

- Lenyűgöző

- tárgy

- későbbi

- siker

- sikeresen

- ilyen

- Támogatott

- biztos

- szimbólum

- rendszer

- táblázat

- Vesz

- tart

- feladatok

- íz

- csapat

- tech

- Technológia

- ideiglenes

- feltételek

- mint

- Kösz

- hogy

- A

- Főváros

- A jövő

- The Source

- a világ

- azok

- Őket

- elmélet

- Ott.

- Ezek

- ők

- dolgok

- Szerintem

- ezt

- bár?

- Keresztül

- tigris

- idő

- Idősorok

- alkalommal

- Cím

- nak nek

- Ma

- együtt

- jelképes

- tokenek

- szerszámok

- felső

- Végösszeg

- Tower

- Vonat

- Képzések

- transzformátor

- fordít

- Fordítás

- szállítás

- Trillió

- megpróbál

- kettő

- típus

- típusok

- ui

- alatt

- felejthetetlen

- egyedi

- egyetemi

- -ig

- Frissítések

- Frissítés

- használható

- használ

- használati eset

- használt

- használó

- Felhasználók

- használ

- segítségével

- érték

- Értékek

- fajta

- változat

- verzió

- nagyon

- keresztül

- Megnézem

- nézetek

- látomás

- Látogat

- látogató

- kötet

- kívánatos

- háború

- volt

- we

- háló

- webes szolgáltatások

- web-alapú

- weboldal

- JÓL

- Bálna

- Mit

- Mi

- amikor

- mivel

- ami

- míg

- miért

- lesz

- ablakok

- val vel

- szó

- szavak

- Munka

- művek

- világ

- világhírű

- betakar

- év

- york

- te

- A te

- magad

- zephyrnet

- Postai irányítószám