Ma örömmel jelentjük be, hogy a Meta által kifejlesztett Code Llama alapozó modellek elérhetőek az ügyfelek számára Amazon SageMaker JumpStart egy kattintással üzembe helyezhető a következtetés futtatásához. A Code Llama egy korszerű nagynyelvi modell (LLM), amely képes kódot és természetes nyelvet generálni a kódról mind a kódból, mind a természetes nyelvi promptokból. A Code Llama kutatási és kereskedelmi használatra ingyenes. Kipróbálhatja ezt a modellt a SageMaker JumpStarttal, egy gépi tanulási (ML) központtal, amely hozzáférést biztosít algoritmusokhoz, modellekhez és ML-megoldásokhoz, így gyorsan elkezdheti az ML használatát. Ebben a bejegyzésben bemutatjuk, hogyan lehet felfedezni és telepíteni a Code Llama modellt a SageMaker JumpStart segítségével.

Mi az a Code Llama

A Code Llama által kiadott modell meta amely a Llama 2-re épül, és egy korszerű modell, amelyet a fejlesztők programozási feladatainak termelékenységének javítására terveztek azáltal, hogy segíti őket kiváló minőségű, jól dokumentált kód létrehozásában. A modellek a legmodernebb teljesítményt mutatják Python, C++, Java, PHP, C#, TypeScript és Bash nyelven, és megtakaríthatják a fejlesztők idejét, és hatékonyabbá tehetik a szoftveres munkafolyamatokat. Három változatban kapható, amelyeket úgy terveztek, hogy az alkalmazások széles skáláját lefedjék: az alapmodell (Code Llama), egy Python-specifikus modell (Code Llama-Python) és egy utasítást követő modell a természetes nyelvi utasítások megértéséhez (Code Llama-Instruct). ). Minden Code Llama változat három méretben kapható: 7B, 13B és 34B paraméterekkel. A 7B és 13B alap- és utasításváltozatok támogatják a környező tartalom alapján történő kitöltést, így ideálisak kódsegéd alkalmazásokhoz.

A modelleket a Llama 2 alapján tervezték, majd 500 milliárd kódadat tokenre tanították, a Python speciális verzióját pedig növekményes 100 milliárd tokenre. A Code Llama modellek stabil generációkat biztosítanak akár 100,000 16,000 kontextusjelzővel. Minden modell 100,000 XNUMX tokenből álló sorozatokra van kiképezve, és akár XNUMX XNUMX tokennel is javítottak a bemeneteken.

A modell ugyanezen cím alatt érhető el közösségi engedély, mint Llama 2.

Mi az a SageMaker JumpStart

A SageMaker JumpStart segítségével az ML gyakorlói a legjobban teljesítő alapozó modellek egyre növekvő listájából választhatnak. Az ML gyakorlói alapmodelleket telepíthetnek dedikált Amazon SageMaker példányokat egy hálózattól elszigetelt környezetben, és testreszabhatja a modelleket a SageMaker segítségével a modell betanítására és telepítésére.

Most már néhány kattintással felfedezheti és telepítheti a Code Llama modelleket Amazon SageMaker Studio vagy programozottan a SageMaker Python SDK-n keresztül, lehetővé téve a modell teljesítményének és az MLOps vezérlők származtatását a SageMaker funkciókkal, mint pl. Amazon SageMaker csővezetékek, Amazon SageMaker Debuggervagy konténernaplókat. A modellt biztonságos AWS-környezetben és az Ön VPC-vezérlése alatt helyezik üzembe, így biztosítva az adatbiztonságot. A Code Llama modellek felfedezhetők és telepíthetők az Egyesült Államok keleti (Észak-Virginia), nyugati (Oregon) és európai (Írország) régióiban.

Az ügyfeleknek el kell fogadniuk az EULA-t a SageMaker SDK modellvízum telepítéséhez.

Fedezze fel a modelleket

A Code Llama alapozó modelleket a SageMaker JumpStart segítségével érheti el a SageMaker Studio UI-ban és a SageMaker Python SDK-ban. Ebben a részben áttekintjük, hogyan fedezheti fel a modelleket a SageMaker Stúdióban.

A SageMaker Studio egy integrált fejlesztői környezet (IDE), amely egyetlen web-alapú vizuális felületet biztosít, ahol hozzáférhet a célra épített eszközökhöz az ML fejlesztési lépések elvégzéséhez, az adatok előkészítésétől az ML modellek felépítéséig, betanításáig és telepítéséig. A SageMaker Studio megkezdésével és beállításával kapcsolatos további részletekért lásd: Amazon SageMaker Studio.

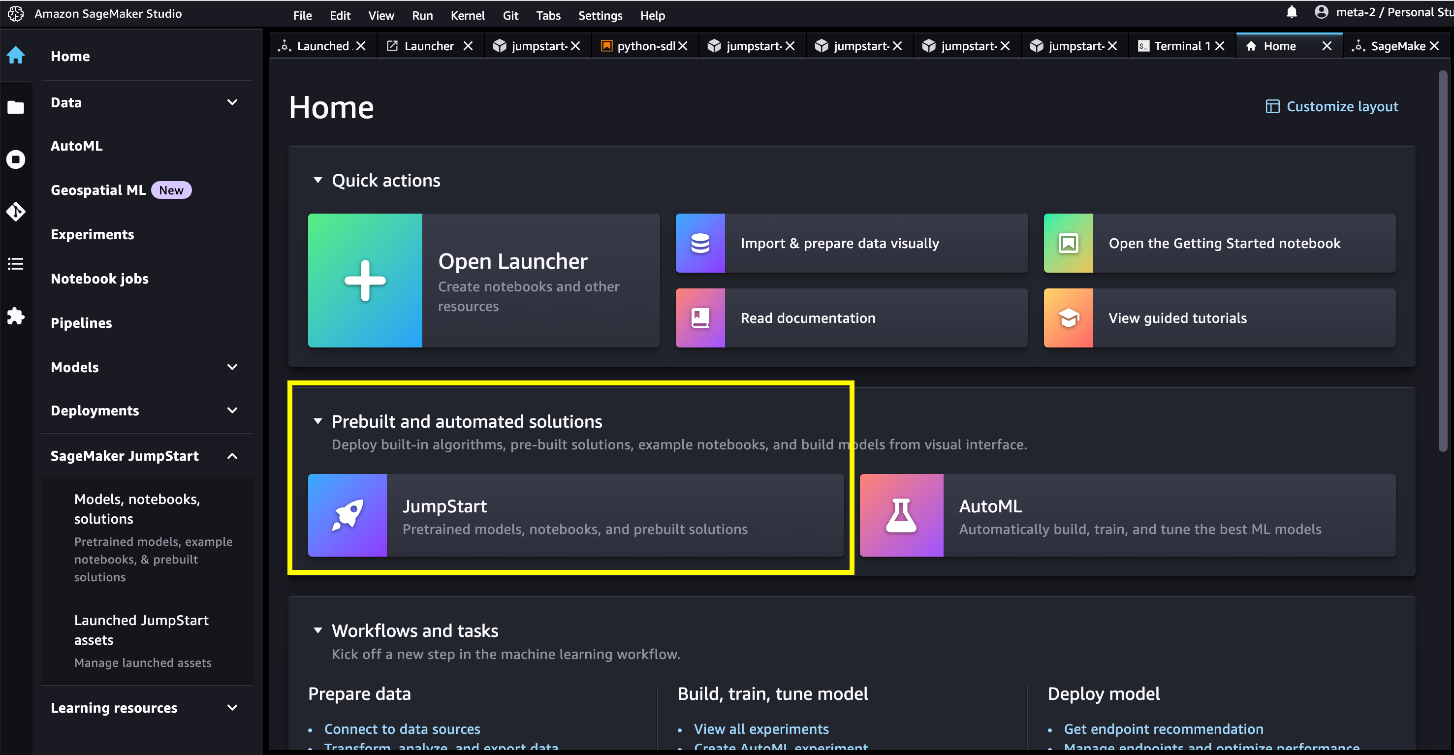

A SageMaker Studio alkalmazásban elérheti a SageMaker JumpStart programot, amely előre betanított modelleket, notebookokat és előre elkészített megoldásokat tartalmaz. Előre elkészített és automatizált megoldások.

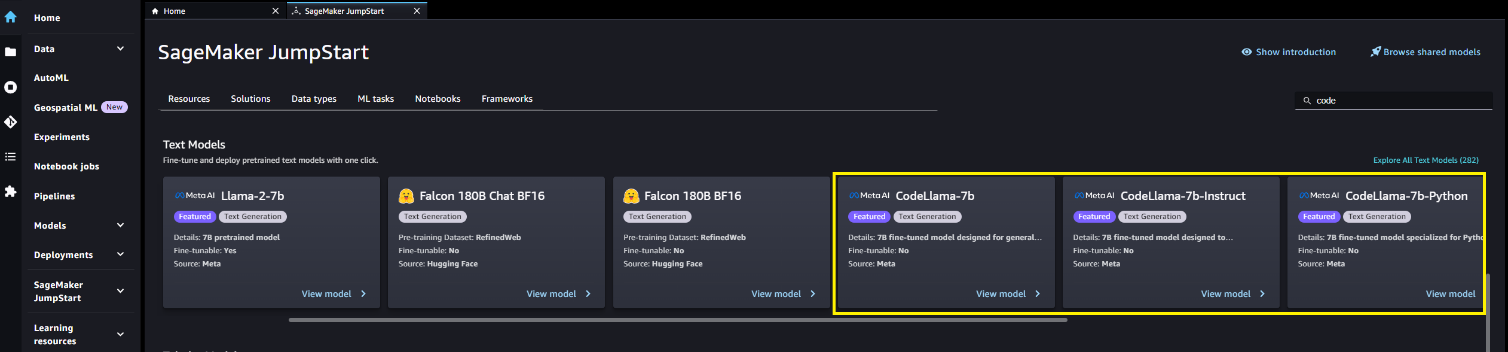

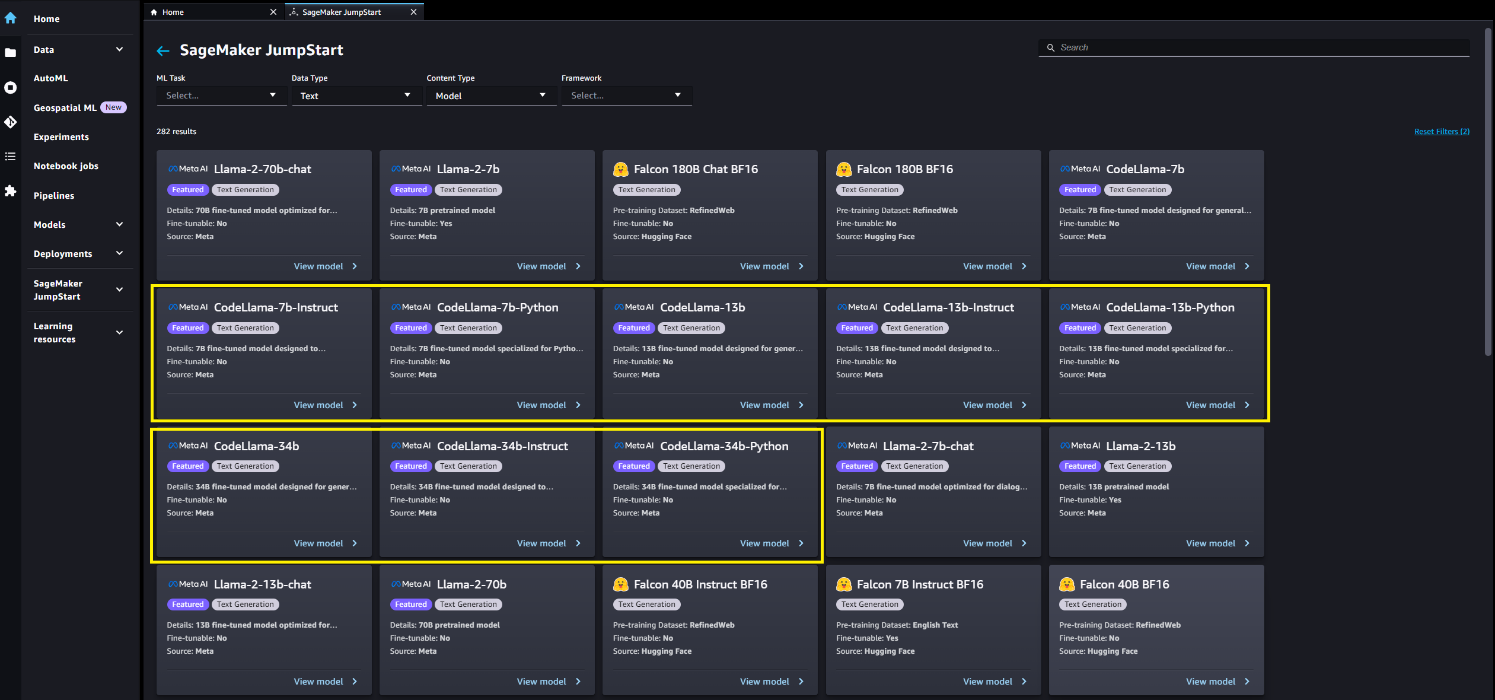

A SageMaker JumpStart nyitóoldalán megoldások, modellek, notebookok és egyéb források között böngészhet. Code Llama modelleket találhat a Alapozási modellek: Szöveggenerálás körhinta.

Választással más modellváltozatokat is találhat Fedezze fel az összes szöveggenerációs modellt vagy Code Llama keresése.

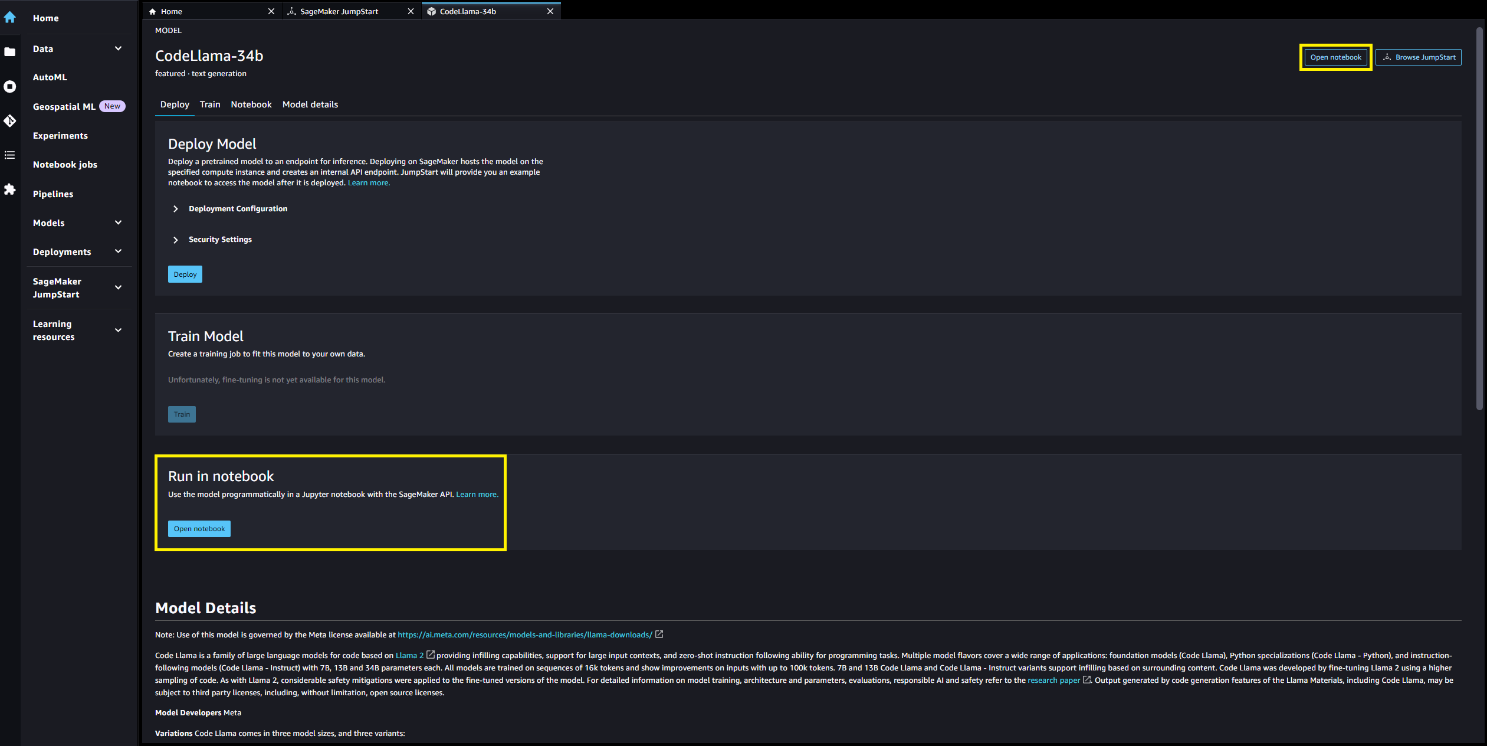

A modellkártya kiválasztásával megtekintheti a modell részleteit, például a licencet, a betanításhoz használt adatokat és a használat módját. Két gombot is talál, Telepítése és a Nyissa meg a Jegyzetfüzetet, amely segít a modell használatában.

Telepítése

Ha úgy dönt Telepítése és nyugtázza a feltételeket, a telepítés megkezdődik. Alternatív megoldásként a példajegyzetfüzeten keresztül is telepítheti, ha kiválasztja Nyissa meg a Jegyzetfüzetet. A példajegyzetfüzet, amely teljes körű útmutatást nyújt a modell telepítéséhez a következtetések levonásához és az erőforrások tisztításához.

A notebook használatával történő telepítéshez először kiválasztjuk a megfelelő modellt, amelyet a model_id. A kiválasztott modellek bármelyikét üzembe helyezheti a SageMakerben a következő kóddal:

Ez a SageMaker modellt alapértelmezett konfigurációkkal telepíti, beleértve az alapértelmezett példánytípust és az alapértelmezett VPC-konfigurációkat. Módosíthatja ezeket a konfigurációkat a nem alapértelmezett értékek megadásával JumpStartModel. A telepítés után a SageMaker előrejelzőn keresztül következtetéseket futtathat a telepített végponttal kapcsolatban:

Vegye figyelembe, hogy alapértelmezés szerint accept_eula be van állítva false. Be kell állítani accept_eula=true a végpont sikeres meghívásához. Ezzel elfogadja a felhasználói licencszerződést és a korábban említett elfogadható használati szabályzatot. Te is letöltés a licencszerződést.

Custom_attributes Az EULA átadására kulcs/érték párokat használnak. A kulcsot és az értéket =, a párokat pedig ; választja el. Ha a felhasználó többször is átadja ugyanazt a kulcsot, akkor az utolsó érték megmarad, és átadja a szkriptkezelőnek (ebben az esetben a feltételes logikához használjuk). Például ha accept_eula=false; accept_eula=true akkor átkerül a szerverhez accept_eula=true megőrzi és átadja a szkriptkezelőnek.

A következtetési paraméterek vezérlik a szöveggenerálási folyamatot a végponton. A maximális új tokenek vezérlése a modell által generált kimenet méretére vonatkozik. Vegye figyelembe, hogy ez nem azonos a szavak számával, mert a modell szókincse nem egyezik meg az angol nyelv szókincsével, és előfordulhat, hogy az egyes token nem angol nyelvű szó. A hőmérséklet szabályozza a kimenet véletlenszerűségét. A magasabb hőmérséklet kreatívabb és hallucináltabb kimeneteket eredményez. Az összes következtetési paraméter nem kötelező.

A következő táblázat felsorolja a SageMaker JumpStartban elérhető összes Code Llama modellt, a modellazonosítókkal, az alapértelmezett példánytípusokkal és a maximálisan támogatott tokenekkel (a bemeneti tokenek számának és az összes egyidejű kéréshez generált tokenek számának összege), amelyek mindegyike támogatott. ezeket a modelleket.

| Modell neve | Modellazonosító | Alapértelmezett példánytípus | Maximálisan támogatott tokenek |

| CodeLlama-7b | meta-textgeneration-láma-codellama-7b | ml.g5.2xnagy | 10000 |

| CodeLlama-7b-Utasítás | meta-textgeneration-llama-codellama-7b-utasítás | ml.g5.2xnagy | 10000 |

| CodeLlama-7b-Python | meta-textgeneration-llama-codellama-7b-python | ml.g5.2xnagy | 10000 |

| CodeLlama-13b | meta-textgeneration-láma-codellama-13b | ml.g5.12xnagy | 32000 |

| CodeLlama-13b-Utasítás | meta-textgeneration-llama-codellama-13b-utasítás | ml.g5.12xnagy | 32000 |

| CodeLlama-13b-Python | meta-textgeneration-llama-codellama-13b-python | ml.g5.12xnagy | 32000 |

| CodeLlama-34b | meta-textgeneration-láma-codellama-34b | ml.g5.48xnagy | 48000 |

| CodeLlama-34b-Utasítás | meta-textgeneration-llama-codellama-34b-utasítás | ml.g5.48xnagy | 48000 |

| CodeLlama-34b-Python | meta-textgeneration-llama-codellama-34b-python | ml.g5.48xnagy | 48000 |

Míg a Code Llama modelleket 16,000 7 token környezeti hosszon képezték ki, a modellek jó teljesítményről számoltak be még nagyobb kontextusablakokon. Az előző táblázatban a maximálisan támogatott tokenek oszlop a támogatott kontextusablak felső korlátja az alapértelmezett példánytípuson. Mivel a Code Llama 10,000B modell csak 5.2 13 tokent tud támogatni egy ml.g34xlarge példányon, javasoljuk, hogy telepítsen egy XNUMXB vagy XNUMXB modellverziót, ha nagyobb környezetre van szükség az alkalmazáshoz.

Alapértelmezés szerint minden modell működik kódgenerálási feladatokra. Az alap- és az utasításmodell egyaránt válaszol a kitöltési feladatokra, bár az alapmodell a legtöbb mintalekérdezésnél jobb minőségű kimenettel rendelkezik. Végül csak az utasításmodellek dolgoznak az utasítási feladatokon. A következő táblázat azt szemlélteti, hogy mely modellek teljesítettek jó (Jó) és közepes teljesítményt (Mérsékelt) a demó notebookok példalekérdezései során.

| . | Kódgenerálás | Kódfeltöltés | Kód utasításai |

| CodeLlama-7b | Jó | Jó | N / A |

| CodeLlama-7b-Utasítás | Jó | Mérsékelt | Jó |

| CodeLlama-7b-Python | Jó | N / A | N / A |

| CodeLlama-13b | Jó | Jó | N / A |

| CodeLlama-13b-Utasítás | Jó | Mérsékelt | Jó |

| CodeLlama-13b-Python | Jó | N / A | N / A |

| CodeLlama-34b | Jó | N / A | N / A |

| CodeLlama-34b-Utasítás | Jó | N / A | Jó |

| CodeLlama-34b-Python | Jó | N / A | N / A |

Kódgenerálás

A következő példákat a CodeLlama-34b-Instruct modellen futtattuk hasznos terhelési paraméterekkel "parameters": {"max_new_tokens": 256, "temperature": 0.2, "top_p": 0.9}:

Kód kitöltés

A kód kitöltése magában foglalja a generált kód visszaadását a környező kontextusban. Ez eltér a kódgenerálási feladattól, mert az előtag kódszegmensen kívül a modell egy kódszegmens utótaggal is rendelkezik. A finomhangolás során speciális tokeneket használtak az előtag kezdetének (<PRE>), az utótag eleje (<SUF>), és a közepének eleje (<MID>). A modell bemeneti szekvenciáinak a következő formátumok valamelyikében kell lenniük:

- előtag-utótag-közép -

<PRE> {prefix} <SUF>{suffix} <MID> - utótag-előtag-közép -

<PRE> <SUF>{suffix} <MID> {prefix}

A következő példák a prefix-suffix-middle formátumot használják a CodeLlama-7b modellen hasznos teherrel parameters {"max_new_tokens": 256, "temperature": 0.05, "top_p": 0.9}:

Kód utasításai

A Meta a Code Llama utasításokra hangolt változatát is biztosította. Az ebben a szakaszban található példalekérdezések csak ezekre az utasításokkal hangolt Code Llama modellekre alkalmazhatók, amelyek modellazonosító-utasítás utótaggal rendelkező modellek. Az utasítások Code Llama formátuma megegyezik a Llama-2-chat prompt formátumával, amelyet részletezünk A Llama 2 alapozó modellek már elérhetőek a SageMaker JumpStartban

Egy egyszerű felhasználói kérdés a következőképpen nézhet ki:

Hozzáadhat egy rendszerpromptot is a következő szintaxissal:

Végül párbeszédes interakciót folytathat a modellel, ha az összes korábbi felhasználói felszólítást és asszisztensi választ belefoglalja a bevitelbe:

Ezek a példák a CodeLlama-13b-Instruct modellen futottak, hasznos terhelési paraméterekkel „paraméterek”: {"max_new_tokens": 512, "temperature": 0.2, "top_p": 0.9}:

Tisztítsuk meg

Miután befejezte a jegyzetfüzet futtatását, ne felejtsen el törölni minden erőforrást, amelyet a folyamat során hozott létre, hogy a számlázás leálljon. Használja a következő kódot:

Következtetés

Ebben a bejegyzésben megmutattuk, hogyan kezdje el a Code Llama modelleket a SageMaker Studio-ban, és hogyan telepítse a modellt a kód és a természetes nyelv kód generálására mind a kódból, mind a természetes nyelvű promptokból. Mivel az alapmodellek előre betanítottak, csökkenthetik a képzési és infrastrukturális költségeket, és lehetővé teszik a testreszabást az Ön használati esetéhez. A kezdéshez látogasson el a SageMaker JumpStart oldalra a SageMaker Studio alkalmazásban.

Tudástár

A szerzőkről

Gabriel Synnaeve a Meta Facebook AI Research (FAIR) csapatának kutatási igazgatója. A Meta előtt Gabriel posztdoktori ösztöndíjas volt Emmanuel Dupoux csapatában a párizsi École Normale Supérieure-ben, ahol a csecsemők nyelvelsajátításának visszafejtésén dolgozott. Gabriel a Grenoble-i Egyetemen szerzett PhD fokozatot a valós idejű stratégiai játékok mesterséges intelligenciájára alkalmazott bayesi modellezésből.

Gabriel Synnaeve a Meta Facebook AI Research (FAIR) csapatának kutatási igazgatója. A Meta előtt Gabriel posztdoktori ösztöndíjas volt Emmanuel Dupoux csapatában a párizsi École Normale Supérieure-ben, ahol a csecsemők nyelvelsajátításának visszafejtésén dolgozott. Gabriel a Grenoble-i Egyetemen szerzett PhD fokozatot a valós idejű stratégiai játékok mesterséges intelligenciájára alkalmazott bayesi modellezésből.

Eissa Jamil partnermérnök RL, generatív AI a Meta-nál.

Eissa Jamil partnermérnök RL, generatív AI a Meta-nál.

Dr. Kyle Ulrich az Amazon SageMaker JumpStart csapatának alkalmazott tudósa. Kutatási területei közé tartoznak a skálázható gépi tanulási algoritmusok, a számítógépes látás, az idősorok, a Bayes-féle nem-paraméterek és a Gauss-folyamatok. Doktori fokozatát a Duke Egyetemen szerezte, és publikációkat publikált a NeurIPS-ben, a Cell-ben és a Neuron-ban.

Dr. Kyle Ulrich az Amazon SageMaker JumpStart csapatának alkalmazott tudósa. Kutatási területei közé tartoznak a skálázható gépi tanulási algoritmusok, a számítógépes látás, az idősorok, a Bayes-féle nem-paraméterek és a Gauss-folyamatok. Doktori fokozatát a Duke Egyetemen szerezte, és publikációkat publikált a NeurIPS-ben, a Cell-ben és a Neuron-ban.

Dr. Ashish Khetan az Amazon SageMaker JumpStart vezető alkalmazott tudósa, és segít gépi tanulási algoritmusok fejlesztésében. PhD fokozatát az Illinois Urbana-Champaign Egyetemen szerezte. A gépi tanulás és a statisztikai következtetések aktív kutatója, és számos közleményt publikált NeurIPS, ICML, ICLR, JMLR, ACL és EMNLP konferenciákon.

Dr. Ashish Khetan az Amazon SageMaker JumpStart vezető alkalmazott tudósa, és segít gépi tanulási algoritmusok fejlesztésében. PhD fokozatát az Illinois Urbana-Champaign Egyetemen szerezte. A gépi tanulás és a statisztikai következtetések aktív kutatója, és számos közleményt publikált NeurIPS, ICML, ICLR, JMLR, ACL és EMNLP konferenciákon.

Vivek Singh a SageMaker JumpStart termékmenedzsere. Arra összpontosít, hogy lehetővé tegye az ügyfelek számára a SageMaker JumpStart beépítését, hogy leegyszerűsítsék és felgyorsítsák a generatív AI-alkalmazások létrehozására irányuló ML-útjukat.

Vivek Singh a SageMaker JumpStart termékmenedzsere. Arra összpontosít, hogy lehetővé tegye az ügyfelek számára a SageMaker JumpStart beépítését, hogy leegyszerűsítsék és felgyorsítsák a generatív AI-alkalmazások létrehozására irányuló ML-útjukat.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://aws.amazon.com/blogs/machine-learning/code-llama-code-generation-models-from-meta-are-now-available-via-amazon-sagemaker-jumpstart/

- :van

- :is

- :nem

- :ahol

- ][p

- $ UP

- 000

- 1

- 10

- 100

- 12

- 13

- 15%

- 16

- 24

- 28

- 30

- 36

- 500

- 7

- 700

- 8

- 9

- a

- Rólunk

- gyorsul

- Elfogad!

- elfogadható

- hozzáférés

- elismerni

- beszerzés

- aktív

- hozzá

- mellett

- Után

- ellen

- Megállapodás

- AI

- ai kutatás

- algoritmusok

- Minden termék

- mentén

- Is

- amazon

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Az Amazon Web Services

- an

- és a

- és az infrastruktúra

- bejelent

- válaszok

- bármilyen

- Alkalmazás

- alkalmazások

- alkalmazott

- megfelelő

- VANNAK

- AS

- Helyettes

- At

- Automatizált

- elérhető

- AWS

- bázis

- alapján

- horpadás

- bayesi

- BE

- mert

- óta

- előtt

- kezdődik

- Kezdet

- Jobb

- között

- számlázás

- Billió

- Milliárd token

- mindkét

- Bontás

- épít

- Épület

- épült

- de

- by

- C + +

- TUD

- képes

- kártya

- körhinta

- eset

- CD

- változik

- karakter

- Gyerekek

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a

- választja

- osztály

- kettyenés

- kód

- Oszlop

- hogyan

- jön

- kereskedelmi

- számítógép

- Számítógépes látás

- egyidejű

- konferenciák

- Konzol

- Konténer

- tartalmaz

- tartalom

- kontextus

- kontextusok

- ellenőrzés

- ellenőrzések

- társalgó

- kiadások

- terjed

- teremt

- készítette

- Kreatív

- Jelenlegi

- Ügyfelek

- testreszabás

- testre

- dátum

- adatbiztonság

- Nap

- elszánt

- alapértelmezett

- demó

- telepíteni

- telepített

- bevezetéséhez

- bevetés

- bevet

- tervezett

- részlet

- részletek

- Fejleszt

- fejlett

- fejlesztők

- Fejlesztés

- különbség

- különböző

- Igazgató

- könyvtárak

- felfedez

- do

- Ennek

- csinált

- letöltések

- Herceg

- herceg egyetem

- alatt

- minden

- Korábban

- Keleti

- hatékony

- lehetővé

- lehetővé téve

- végén

- végtől végig

- Endpoint

- mérnök

- manipulált

- Angol

- biztosítására

- Környezet

- Európa

- Még

- példa

- példák

- Kivéve

- izgatott

- kizárás

- exponenciális

- kiterjesztés

- gyár

- igazságos

- hamis

- Jellemzők

- fickó

- kevés

- Fájlok

- Végül

- Találjon

- vezetéknév

- koncentrál

- követ

- következő

- A

- formátum

- Alapítvány

- Ingyenes

- ból ből

- funkció

- Games

- generált

- generáló

- generáció

- generációk

- nemző

- Generatív AI

- kap

- megy

- Ad

- adott

- Go

- jó

- kapott

- Növekvő

- útmutatást

- kellett

- kéz

- Legyen

- he

- segít

- segít

- segít

- itt

- Magas

- <p></p>

- övé

- vendéglátó

- Hogyan

- How To

- HTML

- HTTPS

- Kerékagy

- i

- ID

- ideális

- ids

- if

- Illinois

- illusztrálja

- importál

- javul

- fejlesztések

- in

- tartalmaz

- Beleértve

- Infrastruktúra

- bemenet

- bemenet

- telepíteni

- telepítés

- példa

- utasítás

- integrált

- kölcsönhatás

- érdekek

- Felület

- Írország

- izolált

- IT

- ITS

- Jáva

- JavaScript

- utazás

- tartotta

- Kulcs

- kulcsok

- Kyle

- leszállási

- nyelv

- nagy

- nagyobb

- legnagyobb

- keresztnév

- tanulás

- balra

- Hossz

- hadd

- Engedély

- mint

- LIMIT

- Lista

- listák

- Láma

- LLM

- helyi

- logika

- néz

- hasonló

- alacsonyabb

- gép

- gépi tanulás

- készült

- Többség

- csinál

- Gyártás

- menedzser

- Menedzserek

- sok

- jel

- maximális

- Lehet..

- eszközök

- említett

- meta

- Középső

- ML

- MLOps

- modell

- modellezés

- modellek

- módosított

- Hónap

- több

- hatékonyabb

- kell

- Természetes

- Szükség

- hálózat

- Új

- csomópont

- csomópontok

- Egyik sem

- jegyzetfüzet

- Most

- szám

- of

- on

- Fedélzeti

- egyszer

- ONE

- csak

- or

- érdekében

- Oregon

- Más

- ki

- teljesítmény

- felett

- csomag

- oldal

- párok

- papírok

- paraméterek

- Párizs

- partner

- elhalad

- Elmúlt

- bérletek

- Teljesít

- teljesítmény

- phd

- PHP

- fütyülés

- Plató

- Platón adatintelligencia

- PlatoData

- politika

- állás

- potenciális

- Predictor

- előkészítése

- előző

- Előzetes

- folyamat

- Folyamatok

- Termékek

- termék menedzser

- termelékenység

- Programozás

- ad

- feltéve,

- biztosít

- közzétett

- Piton

- világítás

- lekérdezések

- gyorsan

- véletlenszerűség

- real-time

- kapott

- ajánl

- utal

- kifejezés

- régiók

- felszabaduló

- eltávolítása

- eltávolított

- Számolt

- raktár

- kéri

- kötelező

- kutatás

- kutató

- Tudástár

- Reagálni

- válaszok

- eredményez

- Eredmények

- visszatérés

- visszatérő

- Visszatér

- jobb

- gyökér

- futás

- futás

- s

- sagemaker

- azonos

- Megtakarítás

- skálázható

- Tudós

- forgatókönyv

- sdk

- Keresés

- keres

- másodperc

- Rész

- biztonság

- biztonság

- részes

- kiválasztott

- kiválasztása

- MAGA

- idősebb

- Series of

- szerver

- Szolgáltatások

- készlet

- kellene

- előadás

- kimutatta,

- Egyszerű

- egyszerűsítése

- óta

- egyetlen

- Méret

- méretek

- So

- szoftver

- Megoldások

- speciális

- specializált

- különleges

- meghatározott

- osztott

- stabil

- kezdet

- kezdődött

- csúcs-

- statisztikai

- Lépései

- megállt

- Stratégia

- Húr

- stúdió

- sikeresen

- ilyen

- összegek

- támogatás

- Támogatott

- biztos

- környező

- szintaxis

- rendszer

- táblázat

- Feladat

- feladatok

- csapat

- megmondja

- feltételek

- szöveg

- mint

- hogy

- A

- azok

- Őket

- akkor

- Ezek

- ők

- ezt

- bár?

- három

- Keresztül

- idő

- Idősorok

- nak nek

- jelképes

- tokenek

- szerszámok

- felső

- Vonat

- kiképzett

- Képzések

- fa

- igaz

- megpróbál

- kettő

- típus

- típusok

- Gépelt

- ui

- alatt

- megértés

- egyetemi

- us

- használ

- használati eset

- használt

- használó

- segítségével

- érték

- Értékek

- Változat

- fajta

- változat

- keresztül

- Megnézem

- Virginia

- Visa

- látomás

- Látogat

- látogatott

- séta

- volt

- Út..

- módon

- we

- háló

- webes szolgáltatások

- web-alapú

- voltak

- Nyugati

- Mit

- Mi

- ami

- széles

- lesz

- ablak

- ablakok

- val vel

- belül

- szó

- szavak

- Munka

- munkafolyamatok

- dolgozó

- ír

- te

- A te

- zephyrnet