A radiológiai jelentések átfogó, terjedelmes dokumentumok, amelyek leírják és értelmezik a radiológiai képalkotó vizsgálat eredményeit. Egy tipikus munkafolyamat során a radiológus felügyeli, elolvassa és értelmezi a képeket, majd tömören összefoglalja a legfontosabb megállapításokat. Az összefoglaló (ill benyomás) a jelentés legfontosabb része, mert segít a klinikusoknak és a betegeknek a jelentés kritikus tartalmára összpontosítani, amely információkat tartalmaz a klinikai döntéshozatalhoz. A tiszta és hatásos benyomás megteremtése sokkal több erőfeszítést igényel, mint a megállapítások egyszerű újraírása. Az egész folyamat ezért fáradságos, időigényes és hibás. Gyakran évekbe telik edzés hogy az orvosok kellő szakértelmet gyűjtsenek össze tömör és informatív radiológiai jelentés-összefoglalók megírásában, tovább hangsúlyozva a folyamat automatizálásának jelentőségét. Ezenkívül a jelentés megállapításainak összegzésének automatikus generálása kritikus a radiológiai jelentésekhez. Lehetővé teszi a jelentések lefordítását ember által olvasható nyelvre, ezáltal enyhítve a betegek terhét, hogy hosszas és homályos jelentéseket olvassanak.

A probléma megoldására a generatív mesterséges intelligencia használatát javasoljuk, amely egy olyan típusú mesterséges intelligencia, amely új tartalmakat és ötleteket hozhat létre, beleértve a beszélgetéseket, történeteket, képeket, videókat és zenét. A generatív mesterséges intelligencia a gépi tanulási (ML) modelleken alapul – nagyon nagy modellek, amelyeket előre megtanítottak hatalmas mennyiségű adatra, és amelyeket általában alapmodelleknek (FM) neveznek. Az ML legújabb fejlesztései (konkrétan a transzformátor alapú neurális hálózati architektúra feltalálása) olyan modellek megjelenéséhez vezettek, amelyek több milliárd paramétert vagy változót tartalmaznak. Az ebben a bejegyzésben javasolt megoldás az előre betanított nagy nyelvi modellek (LLM-ek) finomhangolását használja, hogy segítsen összefoglalni a radiológiai jelentések eredményei alapján.

Ez a bejegyzés egy stratégiát mutat be a nyilvánosan elérhető LLM-ek finomhangolására az AWS-szolgáltatások segítségével végzett radiológiai jelentések összegzésére. Az LLM-ek figyelemreméltó képességeket mutattak be a természetes nyelv megértésében és generálásában, alapmodellként szolgálva, amely különféle területekhez és feladatokhoz illeszthető. Az előre betanított modell használatának jelentős előnyei vannak. Csökkenti a számítási költségeket, csökkenti a szénlábnyomot, és lehetővé teszi a legmodernebb modellek használatát anélkül, hogy a semmiből kelljen betanítania egyet.

Megoldásunk a FLAN-T5 XL FM, használ Amazon SageMaker JumpStart, amely egy ML-központ, amely algoritmusokat, modelleket és ML-megoldásokat kínál. Bemutatjuk, hogyan lehet ezt megvalósítani egy notebook segítségével Amazon SageMaker Studio. Az előre betanított modell finomhangolása magában foglalja a konkrét adatok további képzését, hogy javítsa a teljesítményt egy eltérő, de kapcsolódó feladaton. Ez a megoldás magában foglalja a FLAN-T5 XL modell finomhangolását, amely a továbbfejlesztett változata T5 (Text-to-Text Transfer Transformer) általános célú LLM-ek. A T5 átkeretezi a természetes nyelvi feldolgozási (NLP) feladatokat egységes szöveg-szöveg formátumba, ellentétben BERTI-stílusú modellek, amelyek csak egy osztálycímkét vagy a bemenet tartományát képesek kiadni. Összefoglaló feladatra van finomhangolva a MIMIC-CXR adatkészlet.

A megoldás áttekintése

Ebben a részben megoldásunk kulcsfontosságú összetevőit tárgyaljuk: a feladat stratégiájának megválasztását, az LLM finomhangolását és az eredmények értékelését. Illusztráljuk a megoldás architektúráját és a megoldás megvalósításának lépéseit is.

Határozza meg a feladat stratégiáját

Különféle stratégiák léteznek a klinikai jelentések összefoglalásának automatizálására. Használhatnánk például egy speciális nyelvi modellt, amelyet a semmiből a klinikai jelentések alapján készítettek elő. Alternatív megoldásként közvetlenül finomhangolhatunk egy nyilvánosan elérhető általános célú nyelvi modellt a klinikai feladat elvégzéséhez. Finomhangolt tartomány-agnosztikus modell használata szükséges lehet olyan környezetben, ahol a képzés a nyelvi modell a semmiből túl költséges. Ebben a megoldásban az utóbbi megközelítést mutatjuk be a FLAN -T5 XL modell használatával, amelyet a radiológiai jelentések összegzésének klinikai feladatára finomítunk. A következő diagram a modell munkafolyamatát mutatja be.

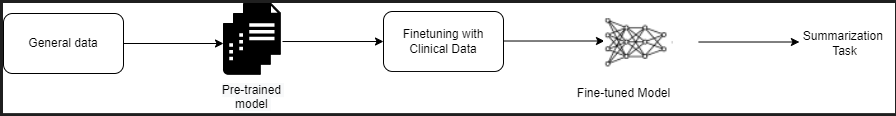

Egy tipikus radiológiai jelentés jól szervezett és tömör. Az ilyen jelentések gyakran három fő részből állnak:

- Háttér – Általános információkat nyújt a páciens demográfiai adatairól, alapvető információkat a páciensről, a klinikai anamnézisről és a vonatkozó kórtörténetről, valamint a vizsgálati eljárások részleteiről

- Álláspontja – Részletes vizsgálati diagnózist és eredményeket mutat be

- nyomtatás – Tömören összefoglalja a legszembetűnőbb megállapításokat vagy a leletek értelmezését a szignifikancia értékelésével és a megfigyelt rendellenességek alapján lehetséges diagnózissal

A radiológiai jelentések leletrészének felhasználásával a megoldás létrehozza a lenyomat részt, amely megfelel az orvosok összesítésének. A következő ábra egy radiológiai jelentés példája.

Finomhangoljon egy általános célú LLM-et klinikai feladathoz

Ebben a megoldásban egy FLAN-T5 XL modellt finomhangolunk (a modell összes paraméterének hangolása és a feladatra optimalizálása). Finomhangoljuk a modellt a klinikai tartomány adatkészletével MIMIC-CXR, amely a mellkas röntgenfelvételeinek nyilvánosan elérhető adatkészlete. A modell SageMaker Jumpstart segítségével történő finomhangolásához címkézett példákat kell megadni {prompt, befejezés} párok formájában. Ebben az esetben a {Findings, Impression} párokat használjuk a MIMIC-CXR adatkészletben lévő eredeti jelentésekből. A következtetéshez a következő példában látható promptot használunk:

![]()

A modell finomhangolása gyorsított számítástechnikán van ml.p3.16xnagy példány 64 virtuális CPU-val és 488 GiB memóriával. Az érvényesítéshez az adatkészlet 5%-át véletlenszerűen választottuk ki. A SageMaker edzési munka finomhangolással eltelt ideje 38,468 11 másodperc volt (körülbelül XNUMX óra).

Értékelje az eredményeket

Amikor a képzés befejeződött, kritikus az eredmények értékelése. A keletkezett benyomás mennyiségi elemzéséhez használjuk PIROS (Recall-Oriented Understudy for Gisting Evaluation), az összegzés értékelésének leggyakrabban használt mérőszáma. Ez a mérőszám összehasonlítja az automatikusan készített összefoglalót egy hivatkozással vagy hivatkozások halmazával (ember által előállított) összefoglalóval vagy fordítással. A ROUGE1 átfedésére utal unigramok (minden szó) a jelölt (a modell kimenete) és a referenciaösszefoglalók között. A ROUGE2 átfedésére utal nagyok (két szó) a jelölt és a referenciaösszefoglalók között. A ROUGEL egy mondatszintű mérőszám, és a két szövegrész közötti leghosszabb közös részsorozatra (LCS) utal. Figyelmen kívül hagyja az újsorokat a szövegben. A ROUGELsum egy összefoglaló szintű mérőszám. Ennél a mérőszámnál a szövegben az újsorokat nem hagyja figyelmen kívül, hanem mondathatárként értelmezi. Az LCS ezután kiszámításra kerül az egyes referencia- és jelöltmondatpárok között, majd kiszámításra kerül az unió-LCS. Ezen pontszámok egy adott referencia- és jelöltmondat-halmazra történő összesítéséhez az átlagot számítják ki.

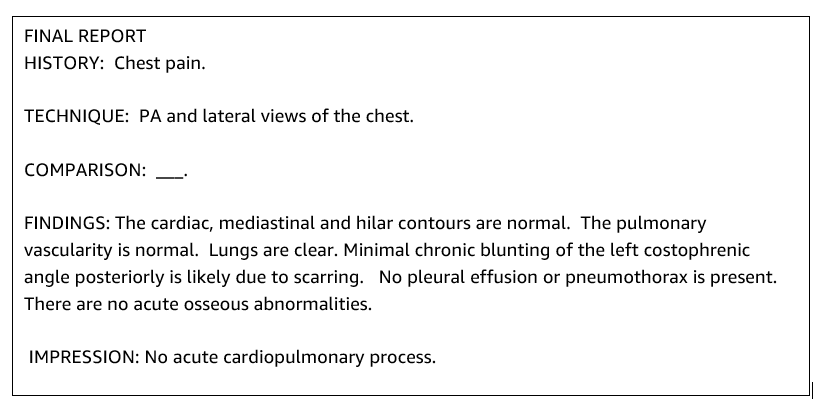

Bejárás és építészet

A következő ábrán látható általános megoldás-architektúra elsősorban egy SageMaker Studio-t használó modellfejlesztő környezetből, egy SageMaker végponttal rendelkező modelltelepítésből és egy jelentéskészítő irányítópultból áll Amazon QuickSight.

A következő szakaszokban bemutatjuk a SageMaker JumpStartban elérhető LLM finomhangolását a SageMaker Python SDK-n keresztüli tartományspecifikus feladatok összefoglalásához. Különösen a következő témákat tárgyaljuk:

- A fejlesztői környezet beállításának lépései

- A radiológiai jelentés adatkészleteinek áttekintése, amelyek alapján a modell finomhangolásra és értékelésre kerül

- A FLAN-T5 XL modell finomhangolásának bemutatója a SageMaker JumpStart programozással a SageMaker Python SDK-val

- Az előre betanított és finomhangolt modellek következtetése, értékelése

- Az előre betanított modell és a finomhangolt modellek eredményeinek összehasonlítása

A megoldás elérhető a Radiológiai jelentés megjelenítésének generálása generatív mesterséges intelligencia használatával, nagy nyelvi modellel az AWS-en GitHub repo.

Előfeltételek

A kezdéshez szüksége van egy AWS-fiók amelyben a SageMaker Studio használható. Létre kell hoznia egy felhasználói profilt a SageMaker Studio számára, ha még nem rendelkezik ilyennel.

A bejegyzésben használt képzési példány típusa: ml.p3.16xlarge. Vegye figyelembe, hogy a p3 példánytípus szolgáltatáskvóta-korlát növelését igényli.

A MIMIC CXR adatkészlet adathasználati szerződéssel érhető el, amelyhez felhasználói regisztráció és egy hitelesítési folyamat elvégzése szükséges.

Állítsa be a fejlesztői környezetet

A fejlesztői környezet beállításához létre kell hoznia egy S3 tárolót, konfigurálhat egy jegyzetfüzetet, létrehozhat végpontokat és telepítheti a modelleket, valamint létrehozhat egy QuickSight irányítópultot.

Hozzon létre egy S3 vödröt

Hozzon létre egy S3 vödröt hívott llm-radiology-bucket a képzési és értékelési adatkészletek tárolására. Ez a modell műtermékének tárolására is szolgál a modellfejlesztés során.

Konfiguráljon egy notebookot

Hajtsa végre a következő lépéseket:

- Indítsa el a SageMaker Studio programot a SageMaker konzolról vagy a AWS parancssori interfész (AWS CLI).

A tartományba való belépéssel kapcsolatos további információkért lásd: Bekapcsolva az Amazon SageMaker domainbe.

- Újat csinálni SageMaker Studio notebook a jelentésadatok tisztításához és a modell finomhangolásához. Egy ml.t3.medium 2vCPU+4GiB notebook példányt használunk Python 3 kernellel.

- A notebookon belül telepítse a megfelelő csomagokat, mint pl

nest-asyncio,IPyWidgets(interaktív widgetek a Jupyter notebookhoz), és a SageMaker Python SDK:

Az előre betanított és finomhangolt modellek következtetéséhez, hozzon létre egy végpontot, és telepítse az egyes modelleket a jegyzetfüzetben a következőképpen:

- Hozzon létre egy modellobjektumot a Model osztályból, amely telepíthető egy HTTPS-végpontra.

- Hozzon létre egy HTTPS-végpontot a modellobjektum előre beépítettével

deploy()eljárás:

Hozzon létre egy QuickSight irányítópultot

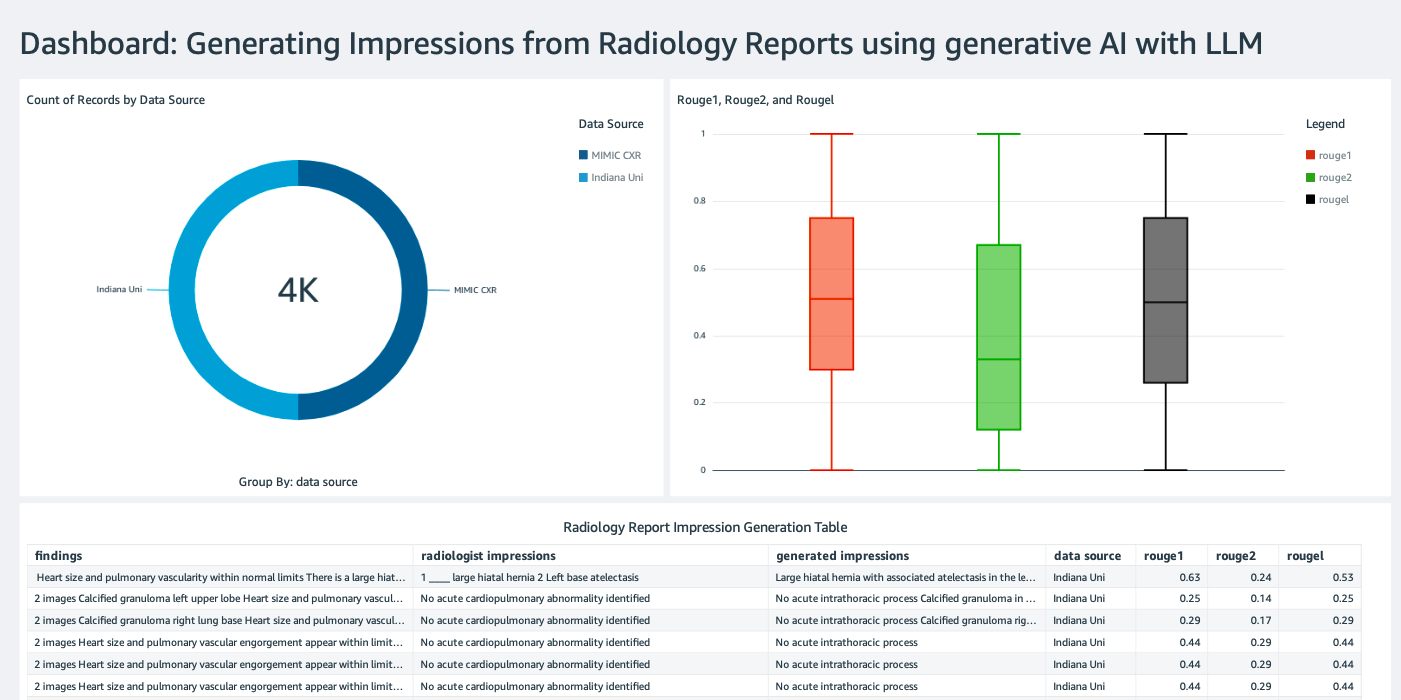

Hozzon létre egy QuickSight irányítópult Athena adatforrással következtetés eredményeként Amazon egyszerű tárolási szolgáltatás (Amazon S3), hogy összehasonlítsa a következtetési eredményeket az alapigazsággal. A következő képernyőképen látható egy példa irányítópultunk.

Radiológiai jelentések adatkészletei

A modell most finomhangolásra került, az összes modellparaméter hangolásra került 91,544 XNUMX, a MIMIC-CXR v2.0 adatkészlet. Mivel csak a radiológiai jelentés szöveges adatait használtuk, csak egy tömörített jelentésfájlt töltöttünk le (mimic-cxr-reports.zip) a MIMIC-CXR webhelyről. Most 2,000 jelentésben értékeljük a finomhangolt modellt (a továbbiakban: a dev1 adatkészlet) a különállóból tartotta ennek az adatkészletnek a részhalmazát. További 2,000 radiológiai jelentést használunk (a továbbiakban: dev2) a mellkasröntgen-gyűjtemény finomhangolt modelljének kiértékeléséhez a Indiana Egyetem kórházi hálózata. Az összes adatkészletet JSON-fájlként olvassa be, és feltölti az újonnan létrehozott S3-tárolóba llm-radiology-bucket. Vegye figyelembe, hogy alapértelmezés szerint az összes adatkészlet nem tartalmaz védett egészségügyi információkat (PHI). minden érzékeny információ helyére három egymást követő aláhúzás (___) a szolgáltatók.

Finomhangolás a SageMaker Python SDK-val

A finomhangoláshoz a model_id ként van megadva huggingface-text2text-flan-t5-xl a SageMaker JumpStart modellek listájából. A training_instance_type be van állítva ml.p3.16xlarge és a inference_instance_type mint ml.g5.2xnagy. A képzési adatok JSON formátumban kerülnek kiolvasásra az S3 tárolóból. A következő lépés a kiválasztott model_id használata a SageMaker JumpStart erőforrás URI-k kibontásához, beleértve image_uri (A Amazon Elastic Container Registry (Amazon ECR) URI a Docker-képhez), model_uri (az előre betanított modelltermék Amazon S3 URI), és script_uri (az edzés forgatókönyve):

Ezenkívül egy kimeneti hely mappaként van beállítva az S3 tárolóban.

Csak egy hiperparaméter, az epochok módosul 3-ra, a többi pedig alapértelmezettként van beállítva:

A képzési mutatók, mint pl eval_loss (érvényesítés elvesztése esetén), loss (edzéskiesés esetén), és epoch a követendő elemek meghatározása és listája:

A SageMaker JumpStart erőforrás-URI-kat használjuk (image_uri, model_uri, script_uri). A Becslő osztályhoz egy entry_point paraméter. Ebben az esetben a JumpStart használja transfer_learning.py. A betanítási feladat nem fut, ha ez az érték nincs beállítva.

Ez a képzési munka órákig is eltarthat; ezért ajánlatos a várakozás paramétert False értékre állítani, és figyelni a betanítási feladat állapotát a SageMaker konzolon. Használja a TrainingJobAnalytics funkció az edzési mutatók nyomon követésére különböző időbélyegeknél:

Következtetési végpontok telepítése

Az összehasonlítás érdekében következtetési végpontokat alkalmazunk mind az előre betanított, mind a finomhangolt modellekhez.

Először kérje le a következtetés Docker-kép URI-ját a használatával model_id, és használja ezt az URI-t az előre betanított modell SageMaker modellpéldányának létrehozásához. Telepítse az előre betanított modellt egy HTTPS-végpont létrehozásával a modellobjektum előre beépítettével deploy() módszer. A SageMaker API-n keresztüli következtetés futtatásához győződjön meg arról, hogy átadta a Predictor osztályt.

Ismételje meg az előző lépést a finomhangolt modell SageMaker modellpéldányának létrehozásához, és hozzon létre egy végpontot a modell üzembe helyezéséhez.

Értékelje a modelleket

Először állítsa be az összegzett szöveg hosszát, a modellkimenetek számát (1-nél nagyobbnak kell lennie, ha több összegzést kell létrehozni), és a nyalábok számát sugárkeresés.

Készítse el a következtetési kérelmet JSON hasznos adatként, és használja az előre betanított és finomhangolt modellek végpontjainak lekérdezésére.

Számítsa ki az aggregált ROUGE pontszámok (ROUGE1, ROUGE2, ROUGEL, ROUGELsum) a korábban leírtak szerint.

Hasonlítsa össze az eredményeket

Az alábbi táblázat az értékelési eredményeket mutatja be dev1 és a dev2 adatkészletek. Az értékelés eredménye tovább dev1 (2,000 lelet a MIMIC CXR Radiológiai Jelentésből) körülbelül 38 százalékpontos javulást mutat az összesített átlagban ROUGE1 és ROUGE2 pontszámokat az előre kiképzett modellhez képest. A dev2 esetében 31 százalékpontos és 25 százalékpontos javulás figyelhető meg a ROUGE1 és ROUGE2 pontszámokban. Összességében a finomhangolás 38.2 százalékpontos és 31.3 százalékpontos javulást eredményezett a ROUGELsum pontszámában a dev1 és a dev2 adatkészletek, ill.

|

Értékelés adatbázisba |

Előképzett modell | Finomhangolt modell | ||||||

| ROUGE1 | ROUGE2 | ROUGEL | ROUGELsum | ROUGE1 | ROUGE2 | ROUGEL | ROUGELsum | |

dev1 |

0.2239 | 0.1134 | 0.1891 | 0.1891 | 0.6040 | 0.4800 | 0.5705 | 0.5708 |

dev2 |

0.1583 | 0.0599 | 0.1391 | 0.1393 | 0.4660 | 0.3125 | 0.4525 | 0.4525 |

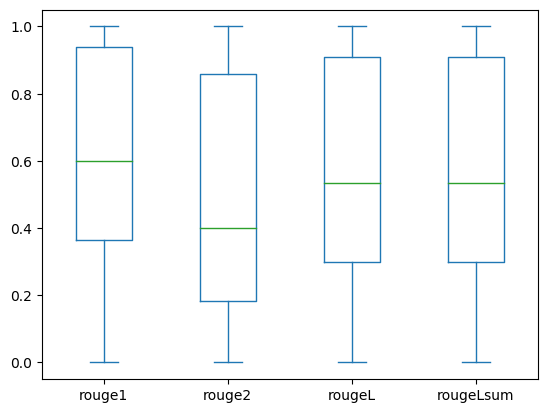

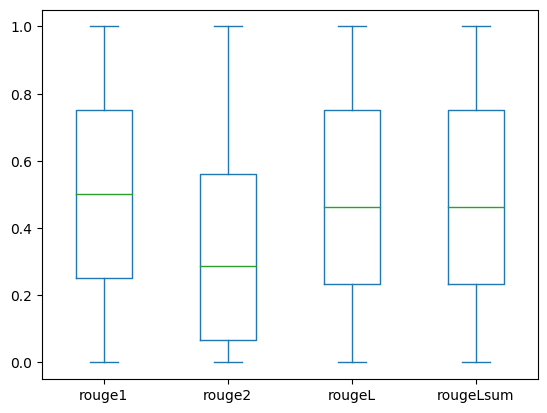

A következő dobozdiagramok a ROUGE pontszámok eloszlását mutatják be dev1 és a dev2 a finomhangolt modell segítségével értékelt adatkészletek.

|

|

(a): dev1 |

(b): dev2 |

A következő táblázat azt mutatja, hogy az értékelési adatkészletek ROUGE-pontszámai megközelítőleg azonos mediánnal és átlaggal rendelkeznek, ezért szimmetrikus eloszlásúak.

| Datasets | Hangjegyek | Gróf | Jelenteni | Std Deviation | Minimális | 25% százalékos | 50% százalékos | 75% százalékos | Maximális |

dev1 |

ROUGE1 | 2000.00 | 0.6038 | 0.3065 | 0.0000 | 0.3653 | 0.6000 | 0.9384 | 1.0000 |

| ROUGE 2 | 2000.00 | 0.4798 | 0.3578 | 0.0000 | 0.1818 | 0.4000 | 0.8571 | 1.0000 | |

| ROUGE L | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

| ROUGELsum | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

dev2 |

ROUGE 1 | 2000.00 | 0.4659 | 0.2525 | 0.0000 | 0.2500 | 0.5000 | 0.7500 | 1.0000 |

| ROUGE 2 | 2000.00 | 0.3123 | 0.2645 | 0.0000 | 0.0664 | 0.2857 | 0.5610 | 1.0000 | |

| ROUGE L | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 | |

| ROUGE Lsum | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 |

Tisztítsuk meg

A jövőbeni költségek elkerülése érdekében törölje a következő kóddal létrehozott erőforrásokat:

Következtetés

Ebben a bejegyzésben bemutattuk, hogyan lehet finomhangolni egy FLAN-T5 XL modellt egy klinikai tartomány-specifikus összegzési feladathoz a SageMaker Studio segítségével. A bizalom növelése érdekében összehasonlítottuk az előrejelzéseket az alapigazságokkal, és az eredményeket ROUGE mérőszámok segítségével értékeltük ki. Kimutattuk, hogy egy adott feladatra finomhangolt modell jobb eredményeket ad, mint egy általános NLP-feladatra előre betanított modell. Szeretnénk felhívni a figyelmet arra, hogy az általános célú LLM finomhangolása teljesen kiküszöböli az előképzés költségeit.

Bár az itt bemutatott munka a mellkasröntgen-jelentésekre összpontosít, lehetőség van arra, hogy nagyobb, változatos anatómiával és módozatú adathalmazokra is kiterjesszék, mint például az MRI és a CT, amelyek esetében a radiológiai jelentések összetettebbek lehetnek több lelettel. Ilyen esetekben a radiológusok kritikussági sorrendben állíthatják elő a benyomásokat, és javaslatokat tehetnek a nyomon követésre. Ezenkívül egy visszacsatolási hurok létrehozása ehhez az alkalmazáshoz lehetővé tenné a radiológusok számára, hogy idővel javítsák a modell teljesítményét.

Amint azt ebben a bejegyzésben bemutattuk, a finomhangolt modell magas ROUGE-pontszámú radiológiai jelentések esetén generál benyomásokat. Megpróbálhatja finomhangolni az LLM-eket a különböző részlegektől származó egyéb, tartomány-specifikus orvosi jelentéseken.

A szerzőkről

Dr. Adewale Akinfaderin az AWS egészségügyi és élettudományi vezető adatkutatója. Szakértelme reprodukálható és teljes körű AI/ML módszerek, gyakorlati megvalósítások, valamint a globális egészségügyi ügyfelek segítése interdiszciplináris problémák skálázható megoldásainak megfogalmazásában és fejlesztésében. Két diplomája van fizikából és egy mérnöki doktori fokozata.

Dr. Adewale Akinfaderin az AWS egészségügyi és élettudományi vezető adatkutatója. Szakértelme reprodukálható és teljes körű AI/ML módszerek, gyakorlati megvalósítások, valamint a globális egészségügyi ügyfelek segítése interdiszciplináris problémák skálázható megoldásainak megfogalmazásában és fejlesztésében. Két diplomája van fizikából és egy mérnöki doktori fokozata.

Priya Padate Senior Partner Solutions Architect, széleskörű szakértelemmel az egészségügy és az élettudományok területén az AWS-nél. A Priya piacra lépési stratégiákat hajt végre partnereivel, és megoldásfejlesztést hajt végre az AI/ML-alapú fejlesztés felgyorsítása érdekében. Szenvedélyesen használja a technológiát az egészségügyi ágazat átalakítására, hogy jobb betegellátási eredményeket érjen el.

Priya Padate Senior Partner Solutions Architect, széleskörű szakértelemmel az egészségügy és az élettudományok területén az AWS-nél. A Priya piacra lépési stratégiákat hajt végre partnereivel, és megoldásfejlesztést hajt végre az AI/ML-alapú fejlesztés felgyorsítása érdekében. Szenvedélyesen használja a technológiát az egészségügyi ágazat átalakítására, hogy jobb betegellátási eredményeket érjen el.

Ekta Walia Bhullar, PhD, az AWS Healthcare and Life Sciences (HCLS) professzionális szolgáltatások üzletágának vezető AI/ML tanácsadója. Nagy tapasztalattal rendelkezik az AI/ML egészségügyi területen belüli alkalmazása terén, különösen a radiológiában. Munkán kívül, amikor nem a radiológiában beszél MI-ről, szeret futni és túrázni.

Ekta Walia Bhullar, PhD, az AWS Healthcare and Life Sciences (HCLS) professzionális szolgáltatások üzletágának vezető AI/ML tanácsadója. Nagy tapasztalattal rendelkezik az AI/ML egészségügyi területen belüli alkalmazása terén, különösen a radiológiában. Munkán kívül, amikor nem a radiológiában beszél MI-ről, szeret futni és túrázni.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Autóipar / elektromos járművek, Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- ChartPrime. Emelje fel kereskedési játékát a ChartPrime segítségével. Hozzáférés itt.

- BlockOffsets. A környezetvédelmi ellentételezési tulajdon korszerűsítése. Hozzáférés itt.

- Forrás: https://aws.amazon.com/blogs/machine-learning/automatically-generate-impressions-from-findings-in-radiology-reports-using-generative-ai-on-aws/

- :van

- :is

- :nem

- :ahol

- $ UP

- 000

- 1

- 100

- 11

- 116

- 125

- 16

- 20

- 22

- 25

- 26%

- 29

- 31

- 36

- 7

- 700

- 8

- 9

- 91

- a

- Képes

- Rólunk

- gyorsul

- felgyorsult

- igénybe vett

- elérni

- felhalmozásra

- Ezen kívül

- fejlesztések

- ellen

- összesítés

- Megállapodás

- AI

- AI / ML

- algoritmusok

- Minden termék

- lehetővé teszi, hogy

- már

- Is

- teljesen

- amazon

- Amazon SageMaker

- Az Amazon Web Services

- Összegek

- an

- elemzés

- és a

- Másik

- bármilyen

- api

- Alkalmazás

- megközelítés

- körülbelül

- építészet

- VANNAK

- érv

- AS

- értékelés

- At

- Automatikus

- automatikusan

- automatizálás

- elérhető

- átlagos

- elkerülése érdekében

- AWS

- bázis

- alapján

- BE

- mert

- előtt

- hogy

- Előnyök

- Jobb

- között

- nagyobb

- milliárd

- mindkét

- határait

- Doboz

- teher

- üzleti

- de

- by

- hívott

- TUD

- jelölt

- képességek

- szén

- ami

- eset

- esetek

- megváltozott

- díjak

- választja

- osztály

- Takarításra

- világos

- Klinikai

- klinikusok

- kód

- gyűjtemény

- Közös

- általában

- összehasonlítani

- képest

- teljes

- befejezés

- bonyolult

- alkatrészek

- átfogó

- számítás

- számítástechnika

- tömör

- bizalom

- folyamatos

- áll

- Konzol

- szaktanácsadó

- tartalmaz

- Konténer

- tartalom

- tartalom

- kontraszt

- beszélgetések

- megfelel

- Költség

- drága

- kiadások

- tudott

- Pár

- teremt

- készítette

- létrehozása

- kritikai

- kritikusság

- szokás

- Ügyfelek

- műszerfal

- dátum

- adattudós

- adatkészletek

- Döntéshozatal

- alapértelmezett

- meghatározott

- Fok

- Demográfiai

- bizonyítani

- igazolták

- mutatja

- osztályok

- telepíteni

- telepített

- bevetés

- leírni

- leírt

- részletes

- részletek

- Fejleszt

- Fejlesztés

- különböző

- közvetlenül

- megvitatni

- megbeszélése

- megosztott

- terjesztés

- Dokkmunkás

- Orvosok

- dokumentumok

- domain

- domainek

- ne

- húz

- hajtás

- meghajtók

- alatt

- minden

- Korábban

- erőfeszítés

- bármelyik

- megszünteti

- más

- lehetővé

- lehetővé teszi

- végtől végig

- Endpoint

- Mérnöki

- fokozott

- elég

- Egész

- Környezet

- korszak

- korszakok

- hiba

- különösen

- alapvető

- értékelni

- értékelték

- értékelő

- értékelés

- vizsgálat

- példa

- példák

- kivégez

- kiterjesztett

- tapasztalat

- szakvélemény

- kiterjedt

- Átfogó tapasztalat

- kivonat

- nem sikerül

- hamis

- Visszacsatolás

- Ábra

- filé

- Fájlok

- megállapítások

- Összpontosít

- koncentrál

- következő

- következik

- A

- forma

- formátum

- Alapítvány

- ból ből

- funkció

- további

- Továbbá

- jövő

- általános

- Általános rendeltetésű

- generál

- generált

- generál

- generáció

- nemző

- Generatív AI

- kap

- adott

- Globális

- Piacra megy

- diplomás

- nagyobb

- Földi

- Legyen

- tekintettel

- he

- Egészség

- egészségügyi információ

- egészségügyi

- egészségügyi ágazat

- segít

- segít

- segít

- itt

- Magas

- kiemelve

- Túra

- övé

- történelem

- vendéglátó

- NYITVATARTÁS

- Hogyan

- How To

- HTML

- http

- HTTPS

- Kerékagy

- HuggingFace

- emberi

- ID

- ötletek

- azonosított

- if

- illusztrálja

- kép

- képek

- Leképezés

- hatásos

- végre

- megvalósítások

- importál

- fontos

- javul

- javulás

- in

- tartalmaz

- Beleértve

- Növelje

- ipar

- információ

- tájékoztató

- bemenet

- telepíteni

- példa

- interaktív

- értelmezés

- bele

- Találmány

- IT

- Munka

- Állások

- json

- éppen

- csak egy

- Tart

- Kulcs

- Címke

- nyelv

- nagy

- indít

- tanulás

- Led

- Hossz

- élet

- Life Sciences

- mint

- Kedvencek

- LIMIT

- vonal

- Lista

- Listázott

- LLM

- található

- elhelyezkedés

- le

- gép

- gépi tanulás

- csinál

- Lehet..

- jelent

- orvosi

- közepes

- Memory design

- módszer

- mód

- metrikus

- Metrics

- esetleg

- Perc

- ML

- modell

- modellek

- monitor

- több

- a legtöbb

- MRI

- sok

- többszörös

- zene

- kell

- név

- Természetes

- Természetes nyelvi feldolgozás

- elengedhetetlen

- Szükség

- hálózat

- neurális hálózat

- Új

- újonnan

- következő

- NLP

- jegyzetfüzet

- Most

- szám

- tárgy

- kapott

- of

- felajánlás

- gyakran

- on

- Beszállás

- ONE

- csak

- optimalizálása

- or

- érdekében

- eredeti

- Más

- mi

- ki

- eredmények

- teljesítmény

- kívül

- felett

- átfogó

- felülírás

- áttekintés

- csomagok

- pár

- párok

- paraméter

- paraméterek

- rész

- különös

- partner

- partnerek

- elhalad

- szenvedélyes

- ösvény

- beteg

- betegek

- százalék

- Teljesít

- teljesítmény

- phd

- Fizika

- darabok

- Plató

- Platón adatintelligencia

- PlatoData

- pont

- pont

- állás

- potenciális

- powered

- Gyakorlati

- Tippek

- Predictor

- bemutatott

- ajándékot

- elsősorban

- Probléma

- problémák

- folyamat

- feldolgozás

- Készült

- szakmai

- profil

- javasol

- javasolt

- védett

- feltéve,

- szolgáltatók

- biztosít

- nyilvánosan

- Piton

- mennyiségi

- Olvass

- Olvasás

- új

- ajánlások

- ajánlott

- csökkenti

- referenciák

- említett

- kifejezés

- regex

- Bejegyzés

- összefüggő

- figyelemre méltó

- helyébe

- jelentést

- Jelentő

- Jelentések

- kérni

- kötelező

- megköveteli,

- forrás

- Tudástár

- illetőleg

- REST

- eredményez

- Eredmények

- Visszatér

- Emelkedik

- futás

- futás

- sagemaker

- azonos

- skálázható

- TUDOMÁNYOK

- Tudós

- kaparni

- sdk

- Keresés

- másodperc

- Rész

- szakaszok

- lát

- kiválasztott

- idősebb

- érzékeny

- mondat

- különálló

- szolgáltatás

- Szolgáltatások

- szolgáló

- készlet

- beállítás

- beállítások

- ő

- kellene

- kimutatta,

- mutatott

- Műsorok

- jelentőség

- jelentős

- Egyszerű

- egyszerűen

- kicsi

- So

- megoldások

- Megoldások

- SOLVE

- néhány

- arasz

- specializált

- különleges

- kifejezetten

- meghatározott

- kezdet

- kezdődött

- csúcs-

- Állapot

- Lépés

- Lépései

- Még mindig

- tárolás

- tárolni

- TÖRTÉNETEK

- stratégiák

- Stratégia

- stúdió

- ilyen

- ÖSSZEFOGLALÓ

- biztos

- táblázat

- Vesz

- tart

- Feladat

- feladatok

- Technológia

- mint

- hogy

- A

- Őket

- akkor

- Ott.

- ezáltal

- ebből adódóan

- Ezek

- ezt

- azok

- három

- Keresztül

- idő

- nak nek

- is

- Témakörök

- vágány

- Vonat

- Képzések

- átruházás

- Átalakítás

- transzformátor

- Fordítás

- igazság

- megpróbál

- kettő

- típus

- tipikus

- aláhúzás

- megértés

- egységes

- egység

- egyetemi

- feltöltve

- használ

- használt

- használó

- használ

- segítségével

- érvényesítés

- érték

- Értékek

- különféle

- Hatalmas

- változat

- keresztül

- Videók

- Tényleges

- várjon

- volt

- we

- háló

- webes szolgáltatások

- weboldal

- amikor

- ami

- míg

- szélesség

- lesz

- val vel

- belül

- nélkül

- szó

- szavak

- Munka

- munkafolyamat

- lenne

- írás

- röntgen

- év

- te

- A te

- zephyrnet