Peluncuran ChatGPT dan meningkatnya popularitas AI generatif telah menangkap imajinasi pelanggan yang penasaran tentang bagaimana mereka dapat menggunakan teknologi ini untuk menciptakan produk dan layanan baru di AWS, seperti chatbot perusahaan, yang lebih bersifat percakapan. Posting ini menunjukkan kepada Anda bagaimana Anda dapat membuat UI web, yang kami sebut Chat Studio, untuk memulai percakapan dan berinteraksi dengan model dasar yang tersedia di Mulai Lompatan Amazon SageMaker seperti Llama 2, Difusi Stabil, dan model lain yang tersedia Amazon SageMaker. Setelah Anda menerapkan solusi ini, pengguna dapat memulai dengan cepat dan merasakan kemampuan beberapa model dasar dalam AI percakapan melalui antarmuka web.

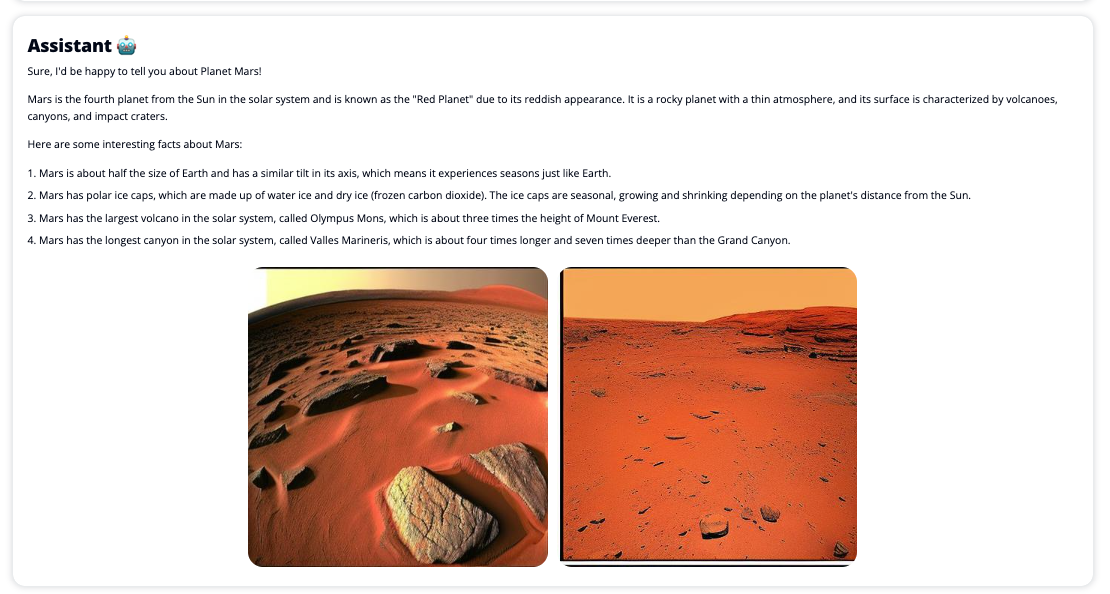

Chat Studio juga dapat secara opsional memanggil titik akhir model Difusi Stabil untuk mengembalikan kolase gambar dan video yang relevan jika pengguna meminta media untuk ditampilkan. Fitur ini dapat membantu meningkatkan pengalaman pengguna dengan penggunaan media sebagai aset yang menyertai respons. Ini hanyalah salah satu contoh bagaimana Anda dapat memperkaya Chat Studio dengan integrasi tambahan untuk mencapai tujuan Anda.

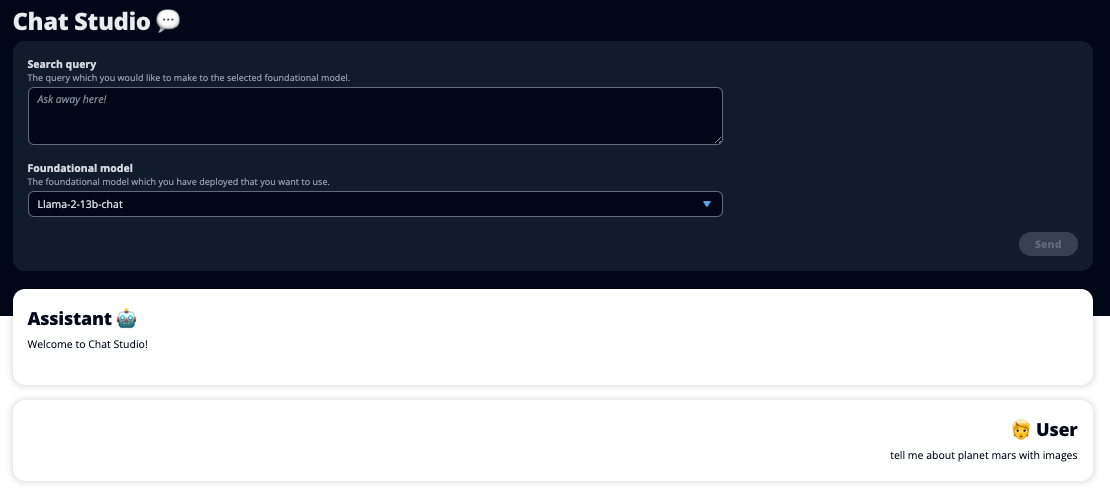

Tangkapan layar berikut menunjukkan contoh tampilan kueri dan respons pengguna.

Model bahasa besar

Chatbot AI generatif seperti ChatGPT didukung oleh model bahasa besar (LLM), yang didasarkan pada jaringan saraf pembelajaran mendalam yang dapat dilatih pada teks tak berlabel dalam jumlah besar. Penggunaan LLM memungkinkan pengalaman percakapan yang lebih baik yang sangat mirip dengan interaksi dengan manusia nyata, menumbuhkan rasa keterhubungan dan meningkatkan kepuasan pengguna.

Model fondasi SageMaker

Pada tahun 2021, Institut Kecerdasan Buatan yang Berpusat pada Manusia di Stanford menyebut beberapa LLM sebagai model pondasi. Model dasar telah dilatih sebelumnya pada kumpulan data umum yang besar dan luas dan dimaksudkan sebagai landasan untuk pengoptimalan lebih lanjut dalam berbagai kasus penggunaan, mulai dari menghasilkan seni digital hingga klasifikasi teks multibahasa. Model pondasi ini populer di kalangan pelanggan karena melatih model baru dari awal memerlukan waktu dan biaya mahal. SageMaker JumpStart menyediakan akses ke ratusan model fondasi yang dikelola dari penyedia sumber terbuka dan kepemilikan pihak ketiga.

Ikhtisar solusi

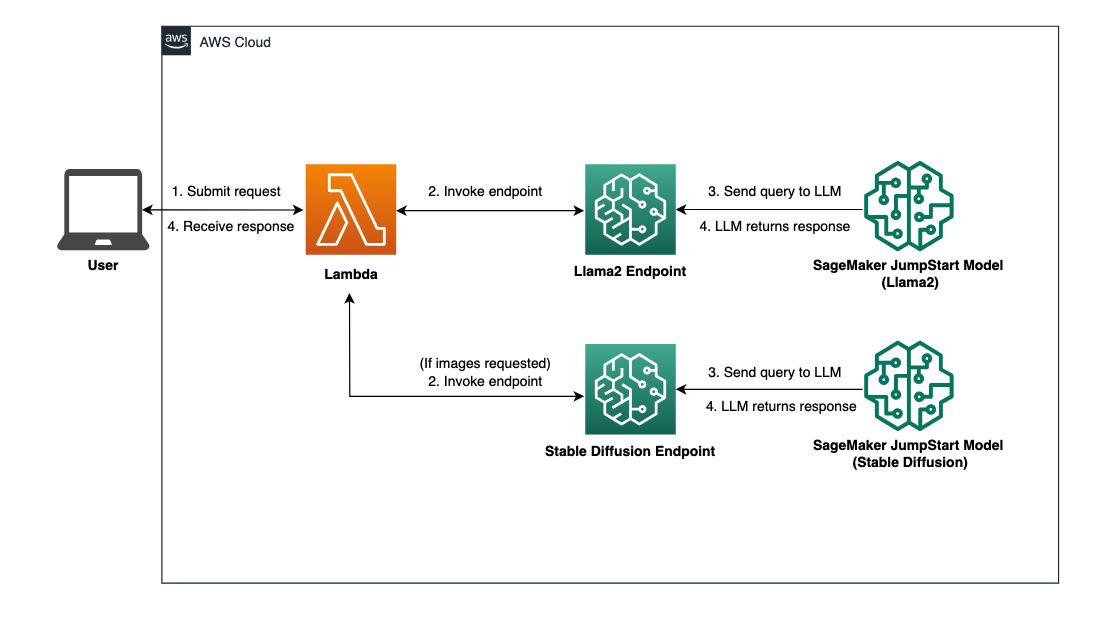

Postingan ini membahas alur kerja kode rendah untuk menerapkan LLM terlatih dan kustom melalui SageMaker, dan membuat UI web untuk berinteraksi dengan model yang diterapkan. Kami membahas langkah-langkah berikut:

- Menerapkan model fondasi SageMaker.

- Menyebarkan AWS Lambda dan Identitas AWS dan Manajemen Akses (IAM) izin menggunakan Formasi AWS Cloud.

- Siapkan dan jalankan antarmuka pengguna.

- Secara opsional, tambahkan model fondasi SageMaker lainnya. Langkah ini memperluas kemampuan Chat Studio untuk berinteraksi dengan model dasar tambahan.

- Secara opsional, terapkan aplikasi menggunakan Amplifikasi AWS. Langkah ini menyebarkan Chat Studio ke web.

Lihat diagram berikut untuk gambaran umum arsitektur solusi.

Prasyarat

Untuk menelusuri solusi, Anda harus memiliki prasyarat berikut:

- An Akun AWS dengan hak istimewa pengguna IAM yang memadai.

npmdiinstal di lingkungan lokal Anda. Untuk petunjuk cara instalasinpm, mengacu pada Mengunduh dan menginstal Node.js dan npm.- Kuota layanan 1 untuk titik akhir SageMaker yang sesuai. Untuk Obrolan Llama 2 13b, kami menggunakan instance ml.g5.48xlarge dan untuk Difusi Stabil 2.1, kami menggunakan instance ml.p3.2xlarge.

Untuk meminta penambahan kuota layanan, pada Konsol AWS Service Quotas, navigasi ke Layanan AWS, SageMaker, dan permintaan peningkatan kuota layanan menjadi nilai 1 untuk ml.g5.48xlarge untuk penggunaan titik akhir dan ml.p3.2xlarge untuk penggunaan titik akhir.

Permintaan kuota layanan mungkin memerlukan waktu beberapa jam untuk disetujui, bergantung pada ketersediaan jenis instans.

Menerapkan model fondasi SageMaker

SageMaker adalah layanan pembelajaran mesin (ML) yang terkelola sepenuhnya bagi pengembang untuk dengan cepat membangun dan melatih model ML dengan mudah. Selesaikan langkah-langkah berikut untuk menerapkan model dasar Obrolan Llama 2 13b dan Difusi Stabil 2.1 menggunakan Studio Amazon SageMaker:

- Buat domain SageMaker. Untuk instruksi, lihat Onboarding ke Domain Amazon SageMaker menggunakan Penyiapan cepat.

Sebuah domain menyiapkan semua penyimpanan dan memungkinkan Anda menambahkan pengguna untuk mengakses SageMaker.

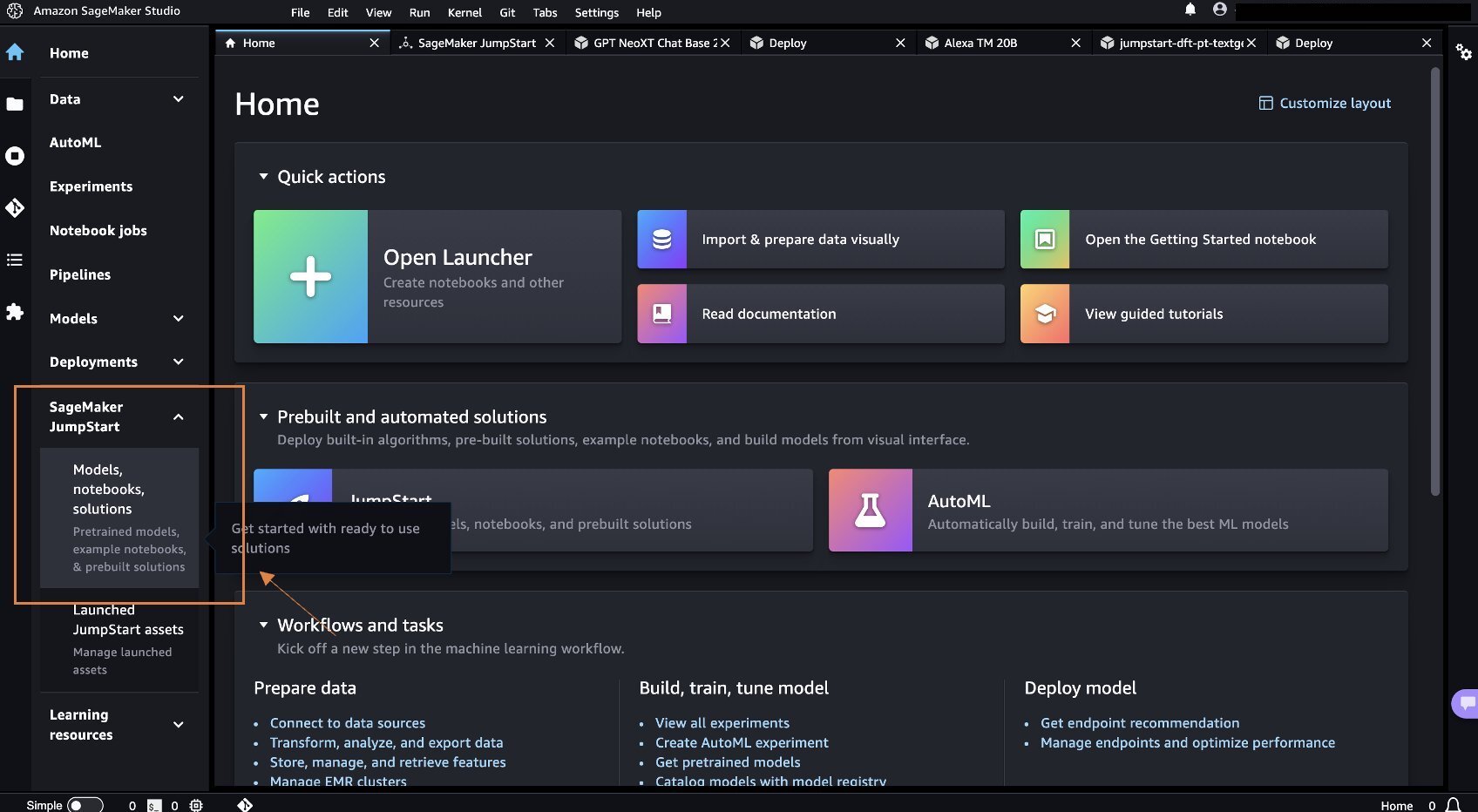

- Di konsol SageMaker, pilih studio di panel navigasi, lalu pilih Buka Studio.

- Setelah meluncurkan Studio, di bawah SageMaker JumpStart di panel navigasi, pilih Model, notebook, solusi.

- Di bilah pencarian, cari Obrolan Llama 2 13b.

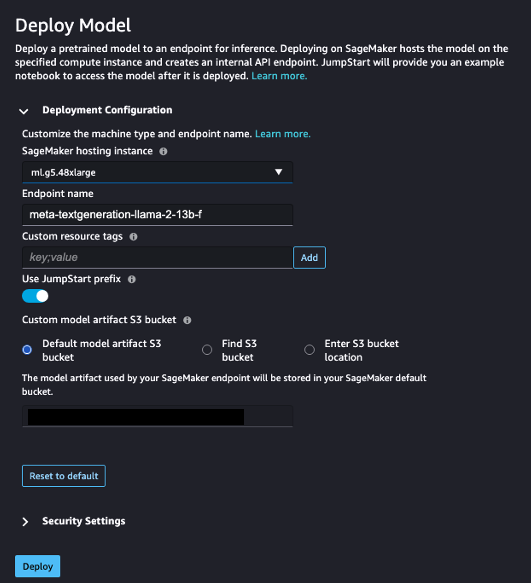

- Bawah Konfigurasi Penerapan, Untuk Contoh hosting SageMaker, pilih ml.g5.48xbesar dan untuk Nama titik akhir, Masuk

meta-textgeneration-llama-2-13b-f. - Pilih Menyebarkan.

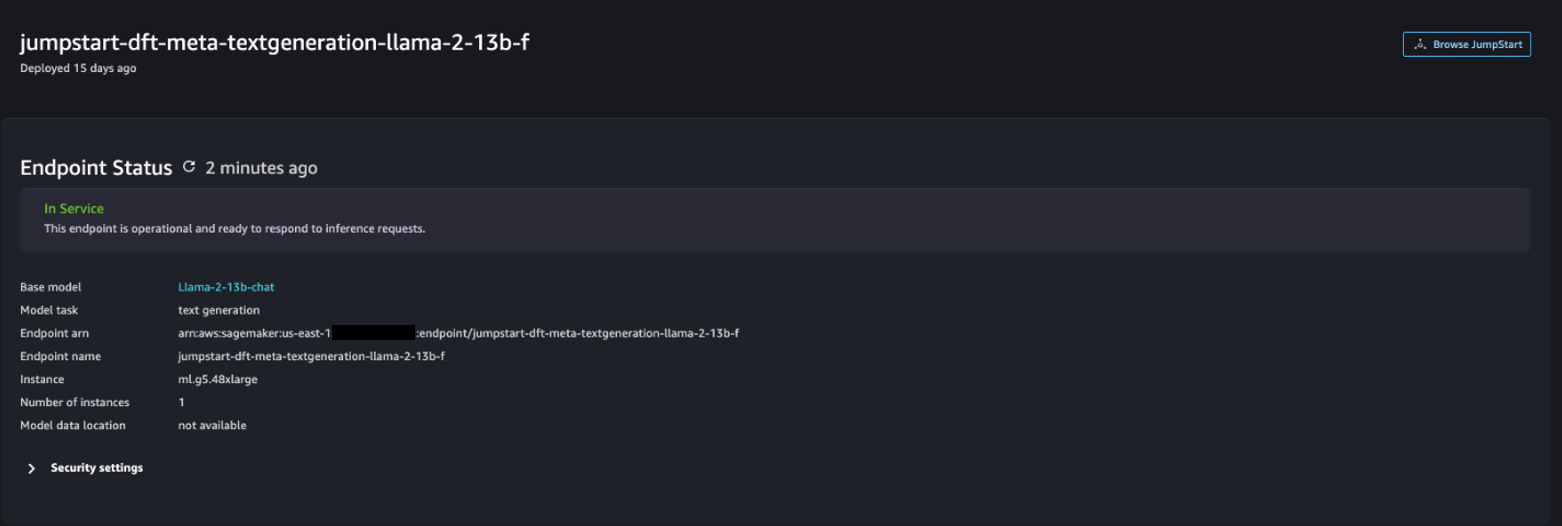

Setelah penerapan berhasil, Anda akan dapat melihat In Service status.

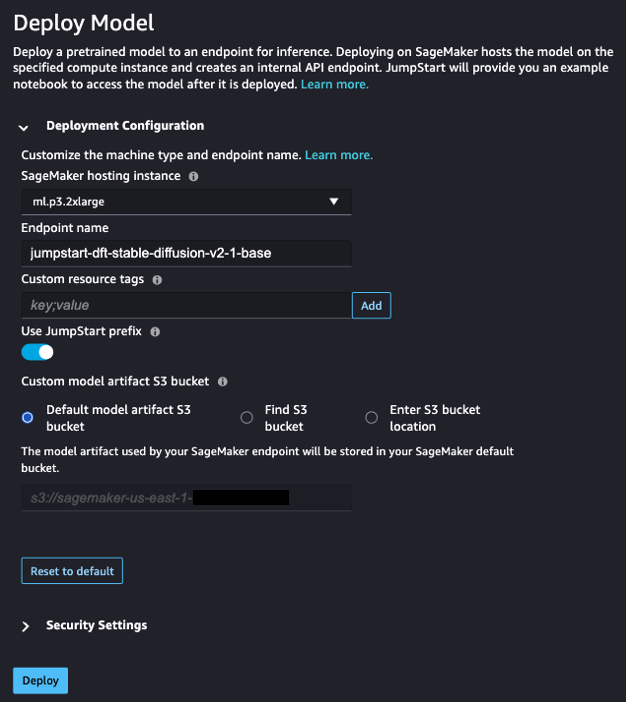

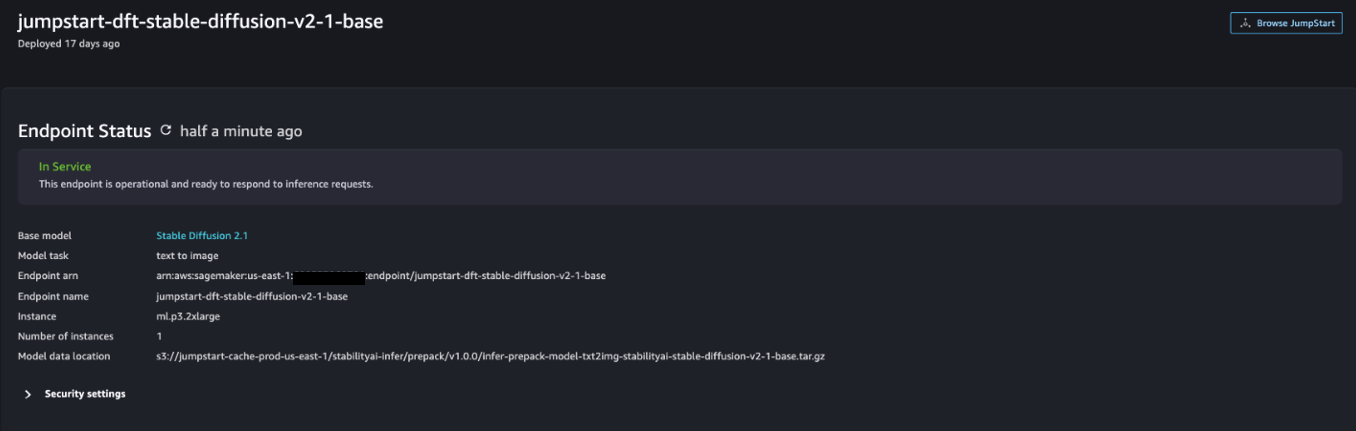

- pada Model, notebook, solusi halaman, cari Difusi Stabil 2.1.

- Bawah Konfigurasi Penerapan, Untuk Contoh hosting SageMaker, pilih ml.p3.2xbesar dan untuk Nama titik akhir, Masuk

jumpstart-dft-stable-diffusion-v2-1-base. - Pilih Menyebarkan.

Setelah penerapan berhasil, Anda akan dapat melihat In Service status.

Terapkan izin Lambda dan IAM menggunakan AWS CloudFormation

Bagian ini menjelaskan bagaimana Anda dapat meluncurkan tumpukan CloudFormation yang menerapkan fungsi Lambda yang memproses permintaan pengguna Anda dan memanggil titik akhir SageMaker yang Anda terapkan, dan menerapkan semua izin IAM yang diperlukan. Selesaikan langkah-langkah berikut:

- Arahkan ke folder Repositori GitHub dan unduh templat CloudFormation (

lambda.cfn.yaml) ke mesin lokal Anda. - Di konsol CloudFormation, pilih Buat tumpukan menu drop-down dan pilih Dengan sumber daya baru (standar).

- pada Tentukan template halaman, pilih Unggah file templat dan Pilih File.

- Pilih

lambda.cfn.yamlfile yang Anda unduh, lalu pilih Selanjutnya. - pada Tentukan detail tumpukan halaman, masukkan nama tumpukan dan kunci API yang Anda peroleh di prasyarat, lalu pilih Selanjutnya.

- pada Konfigurasikan opsi tumpukan halaman, pilih Selanjutnya.

- Tinjau dan akui perubahannya, lalu pilih Kirim.

Siapkan UI web

Bagian ini menjelaskan langkah-langkah untuk menjalankan UI web (dibuat menggunakan Sistem Desain Cloudscape) di mesin lokal Anda:

- Di konsol IAM, navigasikan ke pengguna

functionUrl. - pada Kredensial Keamanan tab, pilih Buat kunci akses.

- pada Akses praktik & alternatif terbaik utama halaman, pilih Command Line Interface (CLI) Dan pilihlah Selanjutnya.

- pada Tetapkan tag deskripsi halaman, pilih Buat kunci akses.

- Salin kunci akses dan kunci akses rahasia.

- Pilih Done.

- Arahkan ke folder Repositori GitHub dan unduh

react-llm-chat-studiokode. - Luncurkan folder di IDE pilihan Anda dan buka terminal.

- Navigasi ke

src/configs/aws.jsondan masukkan access key dan secret access key yang Anda peroleh. - Masukkan perintah berikut di terminal:

- Open http://localhost:3000 di browser Anda dan mulailah berinteraksi dengan model Anda!

Untuk menggunakan Chat Studio, pilih model dasar pada menu drop-down dan masukkan kueri Anda di kotak teks. Untuk mendapatkan gambar yang dihasilkan AI beserta responsnya, tambahkan frasa “dengan gambar” di akhir kueri Anda.

Tambahkan model fondasi SageMaker lainnya

Anda dapat lebih memperluas kemampuan solusi ini dengan menyertakan model fondasi SageMaker tambahan. Karena setiap model mengharapkan format masukan dan keluaran yang berbeda saat memanggil titik akhir SageMaker, Anda perlu menulis beberapa kode transformasi dalam fungsi Lambda callSageMakerEndpoints untuk berinteraksi dengan model.

Bagian ini menjelaskan langkah-langkah umum dan perubahan kode yang diperlukan untuk mengimplementasikan model tambahan pilihan Anda. Perhatikan bahwa pengetahuan dasar bahasa Python diperlukan untuk Langkah 6–8.

- Di SageMaker Studio, terapkan model dasar SageMaker pilihan Anda.

- Pilih SageMaker JumpStart dan Luncurkan aset JumpStart.

- Pilih titik akhir model yang baru Anda terapkan dan pilih Buka Buku Catatan.

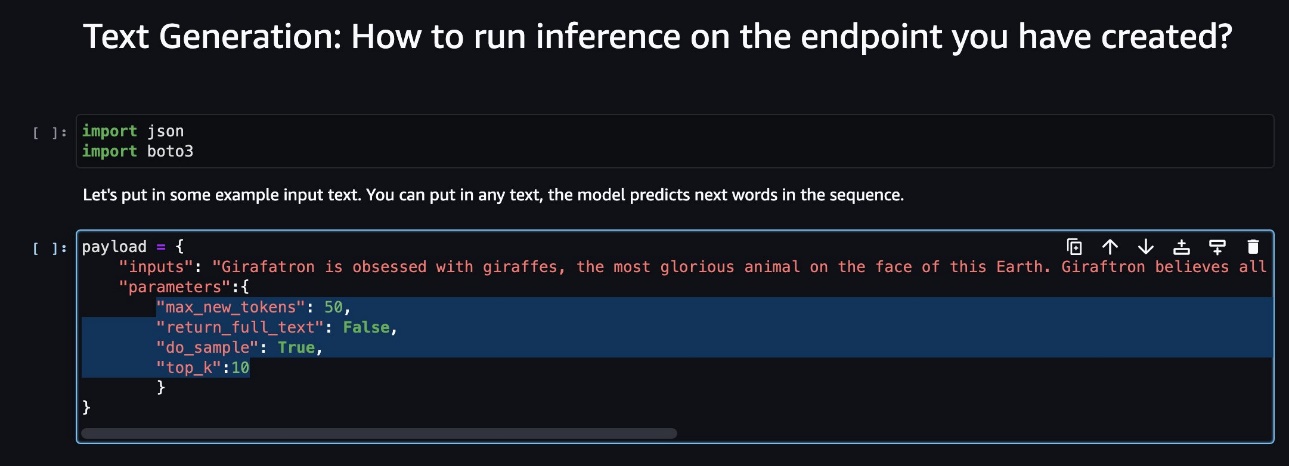

- Di konsol notebook, temukan parameter payload.

Ini adalah bidang yang diharapkan oleh model baru saat memanggil titik akhir SageMaker. Tangkapan layar berikut menunjukkan sebuah contoh.

- Di konsol Lambda, navigasikan ke

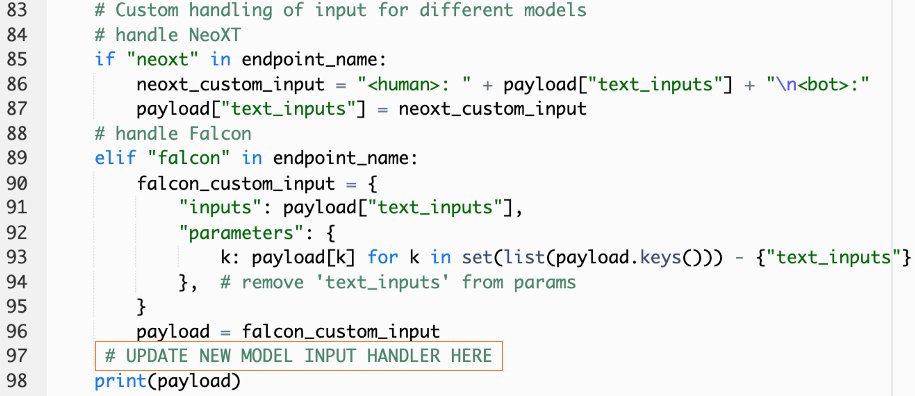

callSageMakerEndpoints. - Tambahkan pengendali masukan khusus untuk model baru Anda.

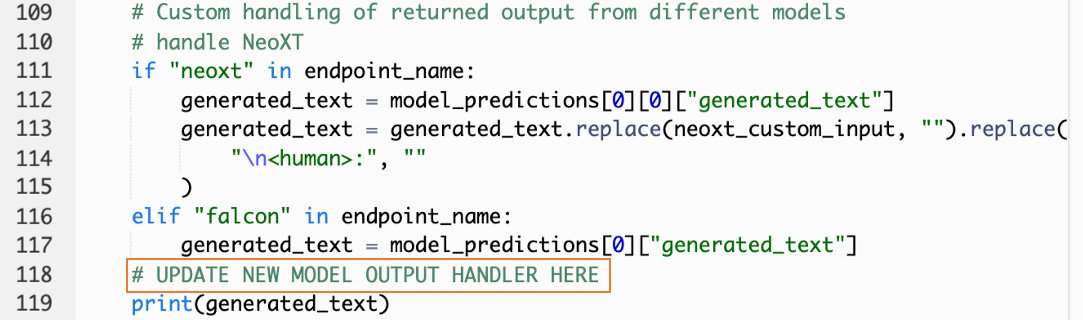

Pada tangkapan layar berikut, kami mengubah input untuk Falcon 40B Instruct BF16 dan GPT NeoXT Chat Base 20B FP16. Anda dapat memasukkan logika parameter khusus seperti yang ditunjukkan untuk menambahkan logika transformasi input dengan mengacu pada parameter payload yang Anda salin.

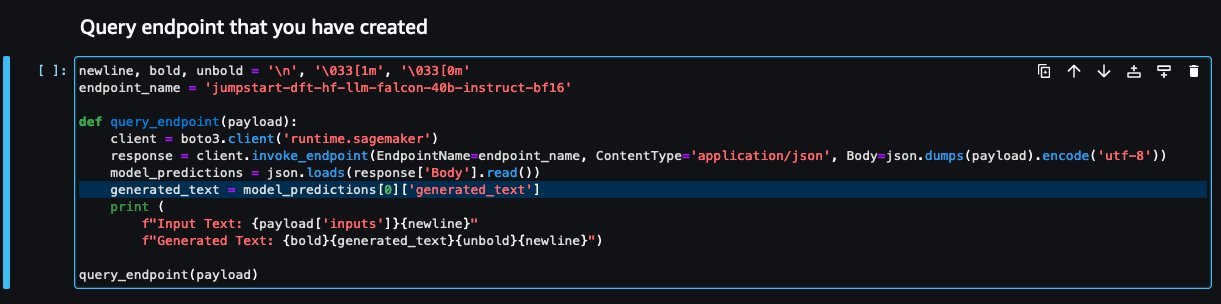

- Kembali ke konsol notebook dan temukan

query_endpoint.

Fungsi ini memberi Anda gambaran bagaimana mengubah keluaran model untuk mengekstrak respons teks akhir.

- Dengan mengacu pada kode di

query_endpoint, tambahkan pengendali keluaran khusus untuk model baru Anda.

- Pilih Menyebarkan.

- Buka IDE Anda, luncurkan

react-llm-chat-studiokode, dan navigasikan kesrc/configs/models.json. - Tambahkan nama model dan titik akhir model Anda, lalu masukkan parameter payload dari Langkah 4 di bawah

payloadmenggunakan format berikut: - Segarkan browser Anda untuk mulai berinteraksi dengan model baru Anda!

Terapkan aplikasi menggunakan Amplify

Amplify adalah solusi lengkap yang memungkinkan Anda menyebarkan aplikasi Anda dengan cepat dan efisien. Bagian ini menjelaskan langkah-langkah untuk menyebarkan Chat Studio ke Amazon CloudFront distribusi menggunakan Amplify jika Anda ingin berbagi aplikasi Anda dengan pengguna lain.

- Arahkan ke folder

react-llm-chat-studiofolder kode yang Anda buat sebelumnya. - Masukkan perintah berikut di terminal dan ikuti instruksi pengaturan:

- Inisialisasi proyek Amplify baru dengan menggunakan perintah berikut. Berikan nama proyek, terima konfigurasi default, dan pilih Kunci akses AWS ketika diminta untuk memilih metode otentikasi.

- Host proyek Amplify dengan menggunakan perintah berikut. Memilih Amazon CloudFront dan S3 ketika diminta untuk memilih mode plugin.

- Terakhir, bangun dan terapkan proyek dengan perintah berikut:

- Setelah penerapan berhasil, buka URL yang disediakan di browser Anda dan mulailah berinteraksi dengan model Anda!

Membersihkan

Untuk menghindari timbulnya biaya di masa mendatang, selesaikan langkah-langkah berikut:

- Hapus tumpukan CloudFormation. Untuk instruksi, lihat Menghapus tumpukan di konsol AWS CloudFormation.

- Hapus titik akhir SageMaker JumpStart. Untuk instruksi, lihat Hapus Titik Akhir dan Sumber Daya.

- Hapus domain SageMaker. Untuk instruksi, lihat Hapus Domain Amazon SageMaker.

Kesimpulan

Dalam postingan ini, kami menjelaskan cara membuat UI web untuk berinteraksi dengan LLM yang diterapkan di AWS.

Dengan solusi ini, Anda dapat berinteraksi dengan LLM Anda dan mengadakan percakapan dengan cara yang mudah digunakan untuk menguji atau mengajukan pertanyaan LLM, dan mendapatkan kolase gambar dan video jika diperlukan.

Anda dapat memperluas solusi ini dengan berbagai cara, seperti mengintegrasikan model pondasi tambahan, berintegrasi dengan Amazon Kendra untuk mengaktifkan penelusuran cerdas yang didukung ML untuk memahami konten perusahaan, dan banyak lagi!

Kami mengundang Anda untuk bereksperimen LLM terlatih berbeda yang tersedia di AWS, atau membangun di atas atau bahkan membuat LLM Anda sendiri di SageMaker. Beri tahu kami pertanyaan dan temuan Anda di komentar, dan bersenang-senanglah!

Tentang penulis

Jarrett Yeo Shan Wei adalah Associate Cloud Architect di Layanan Profesional AWS yang mencakup Sektor Publik di seluruh ASEAN dan merupakan advokat untuk membantu pelanggan melakukan modernisasi dan migrasi ke cloud. Dia telah memperoleh lima sertifikasi AWS, dan juga telah menerbitkan makalah penelitian tentang ansambel mesin peningkat gradien di Konferensi Internasional AI ke-8. Di waktu luangnya, Jarrett berfokus dan berkontribusi pada bidang AI generatif di AWS.

Jarrett Yeo Shan Wei adalah Associate Cloud Architect di Layanan Profesional AWS yang mencakup Sektor Publik di seluruh ASEAN dan merupakan advokat untuk membantu pelanggan melakukan modernisasi dan migrasi ke cloud. Dia telah memperoleh lima sertifikasi AWS, dan juga telah menerbitkan makalah penelitian tentang ansambel mesin peningkat gradien di Konferensi Internasional AI ke-8. Di waktu luangnya, Jarrett berfokus dan berkontribusi pada bidang AI generatif di AWS.

Tammy Lim Lee Xin adalah Associate Cloud Architect di AWS. Dia menggunakan teknologi untuk membantu pelanggan memberikan hasil yang diinginkan dalam perjalanan adopsi cloud dan sangat tertarik dengan AI/ML. Di luar pekerjaan dia suka bepergian, mendaki gunung, dan menghabiskan waktu bersama keluarga dan teman.

Tammy Lim Lee Xin adalah Associate Cloud Architect di AWS. Dia menggunakan teknologi untuk membantu pelanggan memberikan hasil yang diinginkan dalam perjalanan adopsi cloud dan sangat tertarik dengan AI/ML. Di luar pekerjaan dia suka bepergian, mendaki gunung, dan menghabiskan waktu bersama keluarga dan teman.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/create-a-web-ui-to-interact-with-llms-using-amazon-sagemaker-jumpstart/

- :memiliki

- :adalah

- $NAIK

- 1

- 10

- 120

- 160

- 2021

- 3000

- 320

- 7

- 8

- 8th

- a

- Sanggup

- Tentang Kami

- Setuju

- mengakses

- mengakui

- di seluruh

- menambahkan

- Tambahan

- Adopsi

- pengacara

- Setelah

- AI

- AI / ML

- Semua

- memungkinkan

- sepanjang

- juga

- Amazon

- Amazon SageMaker

- Mulai Lompatan Amazon SageMaker

- Amazon Web Services

- memperkuat

- an

- dan

- api

- Aplikasi

- disetujui

- arsitektur

- ADALAH

- Seni

- buatan

- kecerdasan buatan

- AS

- Asean

- meminta

- Aktiva

- Menghubungkan

- At

- mencapai

- Otentikasi

- tersedianya

- tersedia

- menghindari

- AWS

- Formasi AWS Cloud

- Layanan Profesional AWS

- bar

- mendasarkan

- berdasarkan

- dasar

- BE

- karena

- TERBAIK

- Praktik Terbaik

- Lebih baik

- meningkatkan

- Kotak

- luas

- Browser

- membangun

- by

- panggilan

- Panggilan

- CAN

- Bisa Dapatkan

- kemampuan

- kemampuan

- ditangkap

- kasus

- sertifikasi

- Perubahan

- beban

- chatbots

- ChatGPT

- pilihan

- Pilih

- klasifikasi

- rapat

- awan

- adopsi cloud

- kode

- komentar

- lengkap

- Konferensi

- konfigurasi

- koneksi

- konsul

- Konten

- berkontribusi

- Percakapan

- percakapan

- AI percakapan

- Sesuai

- menutupi

- penutup

- membuat

- dibuat

- membuat

- ingin tahu

- adat

- pelanggan

- data

- mendalam

- belajar mendalam

- Default

- menyampaikan

- Tergantung

- menyebarkan

- dikerahkan

- penggelaran

- penyebaran

- menyebarkan

- deskripsi

- Mendesain

- diinginkan

- rincian

- pengembang

- berbeda

- Difusi

- digital

- digital Art

- ditampilkan

- distribusi

- domain

- Download

- Terdahulu

- memudahkan

- efisien

- aktif

- akhir

- Titik akhir

- mempertinggi

- memperkaya

- Enter

- Enterprise

- Lingkungan Hidup

- Bahkan

- Setiap

- contoh

- contoh

- mengharapkan

- mahal

- pengalaman

- eksperimen

- menjelaskan

- memperpanjang

- Meluas

- ekstrak

- keluarga

- Fitur

- beberapa

- Fields

- File

- terakhir

- Menemukan

- Temuan

- lima

- berfokus

- mengikuti

- berikut

- Untuk

- format

- membina

- Prinsip Dasar

- dasar

- Gratis

- teman

- dari

- sepenuhnya

- fungsi

- lebih lanjut

- masa depan

- Umum

- data umum

- menghasilkan

- generatif

- AI generatif

- mendapatkan

- memberikan

- Anda

- Memiliki

- he

- membantu

- membantu

- -nya

- memegang

- tuan

- JAM

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- HTML

- http

- HTTPS

- Manusia

- Ratusan

- ide

- identitas

- if

- gambar

- imajinasi

- melaksanakan

- ditingkatkan

- in

- memasukkan

- Meningkatkan

- menunjukkan

- memasukkan

- install

- diinstal

- Instalasi

- contoh

- Lembaga

- instruksi

- mengintegrasikan

- integrasi

- Intelijen

- Cerdas

- berinteraksi

- berinteraksi

- interaksi

- Antarmuka

- Internasional

- ke

- mengundang

- NYA

- perjalanan

- jpg

- hanya

- hanya satu

- kunci

- Tahu

- pengetahuan

- bahasa

- besar

- jalankan

- peluncuran

- pengetahuan

- Lee

- membiarkan

- 'like'

- baris

- Llama

- LLM

- lokal

- logika

- melihat

- terlihat seperti

- mencintai

- mesin

- Mesin belajar

- berhasil

- cara

- Mungkin..

- berarti

- Media

- Pelajari

- menu

- metode

- bermigrasi

- ML

- mode

- model

- model

- memodernisasi

- lebih

- beberapa

- harus

- nama

- Arahkan

- Navigasi

- perlu

- Perlu

- jaringan

- saraf

- saraf jaringan

- New

- produk baru

- baru saja

- simpul

- Node.js

- mencatat

- buku catatan

- diperoleh

- of

- on

- ONE

- Buka

- open source

- Opsi

- or

- Lainnya

- hasil

- keluaran

- di luar

- ikhtisar

- sendiri

- halaman

- pane

- kertas

- parameter

- parameter

- bergairah

- Izin

- plato

- Kecerdasan Data Plato

- Data Plato

- Plugin

- Populer

- kepopuleran

- Pos

- didukung

- praktek

- disukai

- prasyarat

- hak

- proses

- Produk

- profesional

- proyek

- hak milik

- memberikan

- disediakan

- penyedia

- menyediakan

- publik

- diterbitkan

- Ular sanca

- Pertanyaan

- Cepat

- segera

- menaikkan

- jarak

- nyata

- lihat

- referensi

- relevan

- permintaan

- permintaan

- wajib

- penelitian

- menyerupai

- Sumber

- tanggapan

- kembali

- Naik

- Run

- pembuat bijak

- kepuasan

- adegan

- menggaruk

- screenshot

- Pencarian

- Rahasia

- Bagian

- sektor

- melihat

- memilih

- rasa

- melayani

- layanan

- Layanan

- set

- set

- penyiapan

- Share

- dia

- harus

- Menunjukkan

- Pertunjukkan

- potongan

- larutan

- beberapa

- sumber

- Pengeluaran

- stabil

- tumpukan

- standar

- Stanford

- awal

- mulai

- Status

- Langkah

- Tangga

- penyimpanan

- studio

- seperti itu

- cukup

- Mengambil

- Dibutuhkan

- Teknologi

- Template

- terminal

- uji

- teks

- Klasifikasi Teks

- bahwa

- Grafik

- mereka

- kemudian

- Ini

- mereka

- pihak ketiga

- ini

- meskipun?

- Melalui

- waktu

- untuk

- puncak

- Pelatihan VE

- terlatih

- Pelatihan

- Mengubah

- Transformasi

- berubah

- mengetik

- ui

- bawah

- pemahaman

- URL

- us

- penggunaan

- menggunakan

- Pengguna

- Pengguna Pengalaman

- User Interface

- user-friendly

- Pengguna

- kegunaan

- menggunakan

- nilai

- berbagai

- Video

- berjalan

- berjalan

- cara

- we

- jaringan

- layanan web

- Apa

- ketika

- yang

- SIAPA

- lebar

- Rentang luas

- akan

- ingin

- dengan

- Kerja

- alur kerja

- menulis

- ya

- Kamu

- Anda

- zephyrnet.dll