Hari ini, kami sangat gembira mengumumkan bahwa model fondasi Code Llama, yang dikembangkan oleh Meta, tersedia untuk pelanggan melalui Mulai Lompatan Amazon SageMaker untuk diterapkan dengan satu klik untuk menjalankan inferensi. Code Llama adalah model bahasa besar (LLM) canggih yang mampu menghasilkan kode dan bahasa alami tentang kode baik dari kode maupun perintah bahasa alami. Anda dapat mencoba model ini dengan SageMaker JumpStart, hub pembelajaran mesin (ML) yang menyediakan akses ke algoritme, model, dan solusi ML sehingga Anda dapat memulai ML dengan cepat. Dalam postingan ini, kita akan membahas cara menemukan dan menerapkan model Code Llama melalui SageMaker JumpStart.

Kode Lama

Code Llama adalah model yang dirilis oleh meta yang dibangun di atas Llama 2. Model canggih ini dirancang untuk meningkatkan produktivitas tugas pemrograman bagi pengembang dengan membantu mereka membuat kode berkualitas tinggi dan terdokumentasi dengan baik. Model ini unggul dalam Python, C++, Java, PHP, C#, TypeScript, dan Bash, serta berpotensi menghemat waktu pengembang dan membuat alur kerja perangkat lunak lebih efisien.

Muncul dalam tiga varian, dirancang untuk mencakup berbagai macam aplikasi: model dasar (Code Llama), model khusus Python (Code Llama Python), dan model mengikuti instruksi untuk memahami instruksi bahasa alami (Code Llama Instruct). Semua varian Code Llama hadir dalam empat ukuran: parameter 7B, 13B, 34B, dan 70B. Varian dasar dan instruksi 7B dan 13B mendukung pengisian berdasarkan konten di sekitarnya, menjadikannya ideal untuk aplikasi asisten kode. Model tersebut dirancang menggunakan Llama 2 sebagai basis dan kemudian dilatih pada 500 miliar token data kode, dengan versi khusus Python dilatih pada tambahan 100 miliar token. Model Code Llama menyediakan generasi stabil dengan hingga 100,000 token konteks. Semua model dilatih pada urutan 16,000 token dan menunjukkan peningkatan pada input hingga 100,000 token.

Model ini tersedia dengan model yang sama lisensi komunitas sebagai Llama 2.

Model fondasi di SageMaker

SageMaker JumpStart menyediakan akses ke berbagai model dari hub model populer, termasuk Hugging Face, PyTorch Hub, dan TensorFlow Hub, yang dapat Anda gunakan dalam alur kerja pengembangan ML Anda di SageMaker. Kemajuan terkini dalam ML telah memunculkan kelas model baru yang dikenal sebagai model pondasi, yang biasanya dilatih tentang miliaran parameter dan dapat disesuaikan dengan berbagai kategori kasus penggunaan, seperti peringkasan teks, pembuatan seni digital, dan terjemahan bahasa. Karena model ini mahal untuk dilatih, pelanggan ingin menggunakan model pondasi yang telah dilatih sebelumnya dan menyempurnakannya sesuai kebutuhan, daripada melatih sendiri model tersebut. SageMaker menyediakan daftar model pilihan yang dapat Anda pilih di konsol SageMaker.

Anda dapat menemukan model pondasi dari penyedia model yang berbeda dalam SageMaker JumpStart, memungkinkan Anda memulai model pondasi dengan cepat. Anda dapat menemukan model dasar berdasarkan tugas atau penyedia model yang berbeda, dan dengan mudah meninjau karakteristik model dan ketentuan penggunaan. Anda juga dapat mencoba model ini menggunakan widget pengujian UI. Saat Anda ingin menggunakan model dasar dalam skala besar, Anda dapat melakukannya tanpa meninggalkan SageMaker dengan menggunakan notebook bawaan dari penyedia model. Karena model dihosting dan diterapkan di AWS, Anda dapat yakin bahwa data Anda, baik digunakan untuk mengevaluasi atau menggunakan model dalam skala besar, tidak pernah dibagikan kepada pihak ketiga.

Temukan model Kode Llama di SageMaker JumpStart

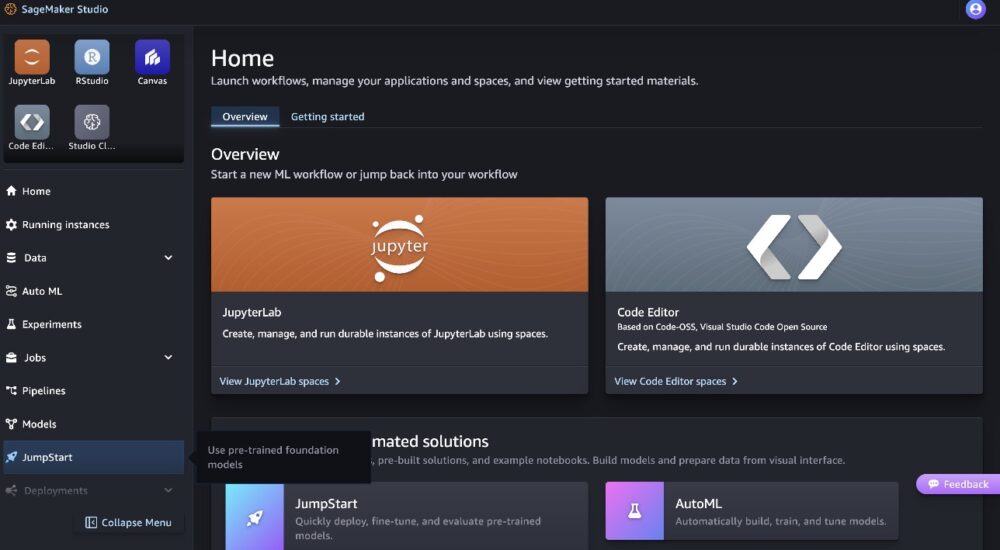

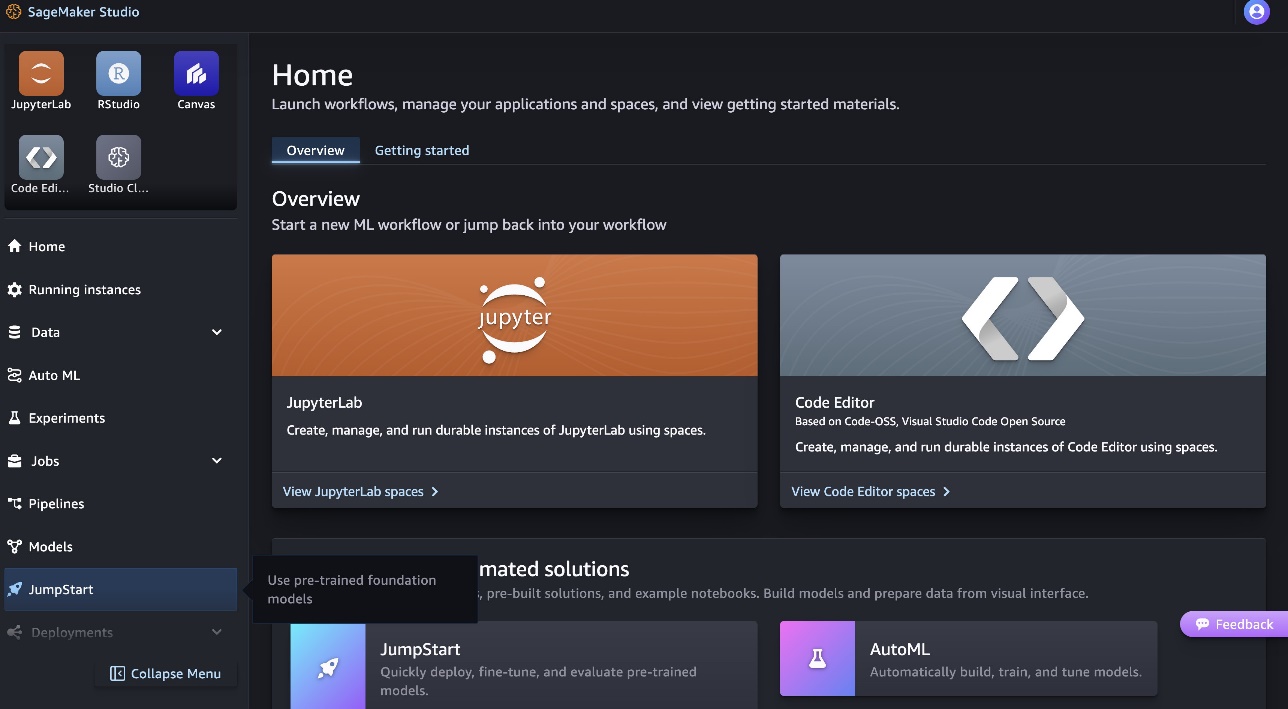

Untuk menyebarkan model Code Llama 70B, selesaikan langkah-langkah berikut Studio Amazon SageMaker:

- Di halaman beranda SageMaker Studio, pilih Tingkatkan di panel navigasi.

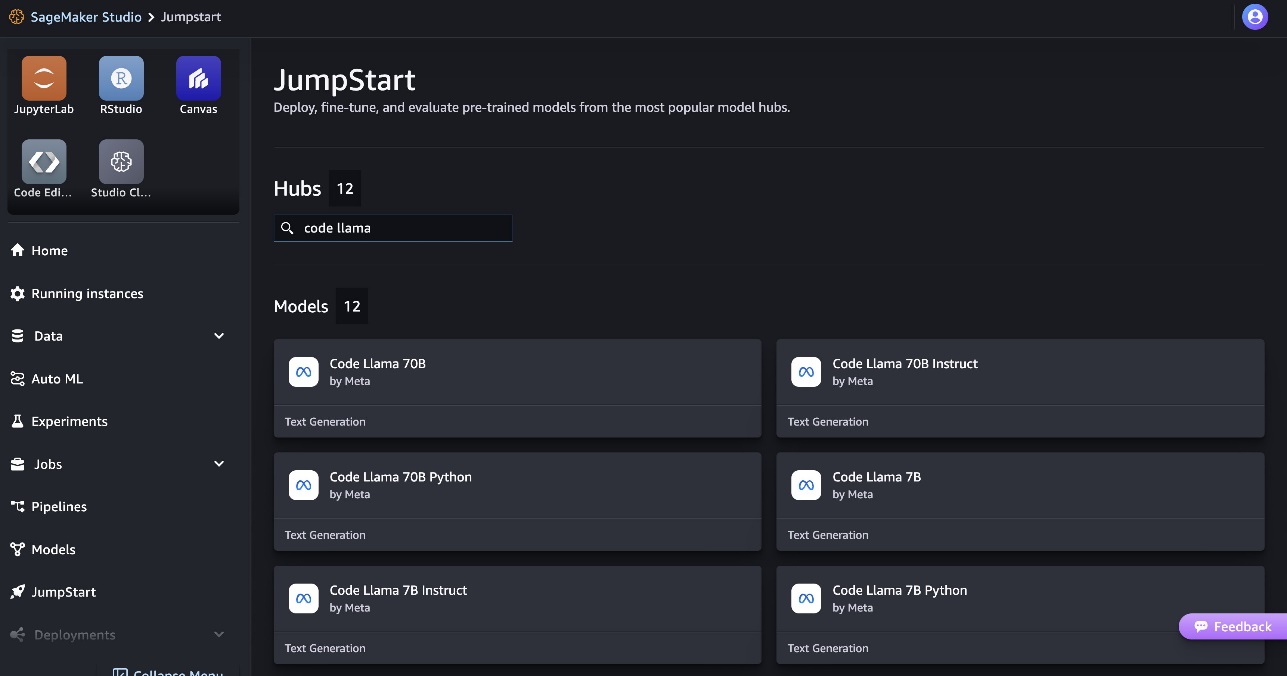

- Cari model Code Llama dan pilih model Code Llama 70B dari daftar model yang ditampilkan.

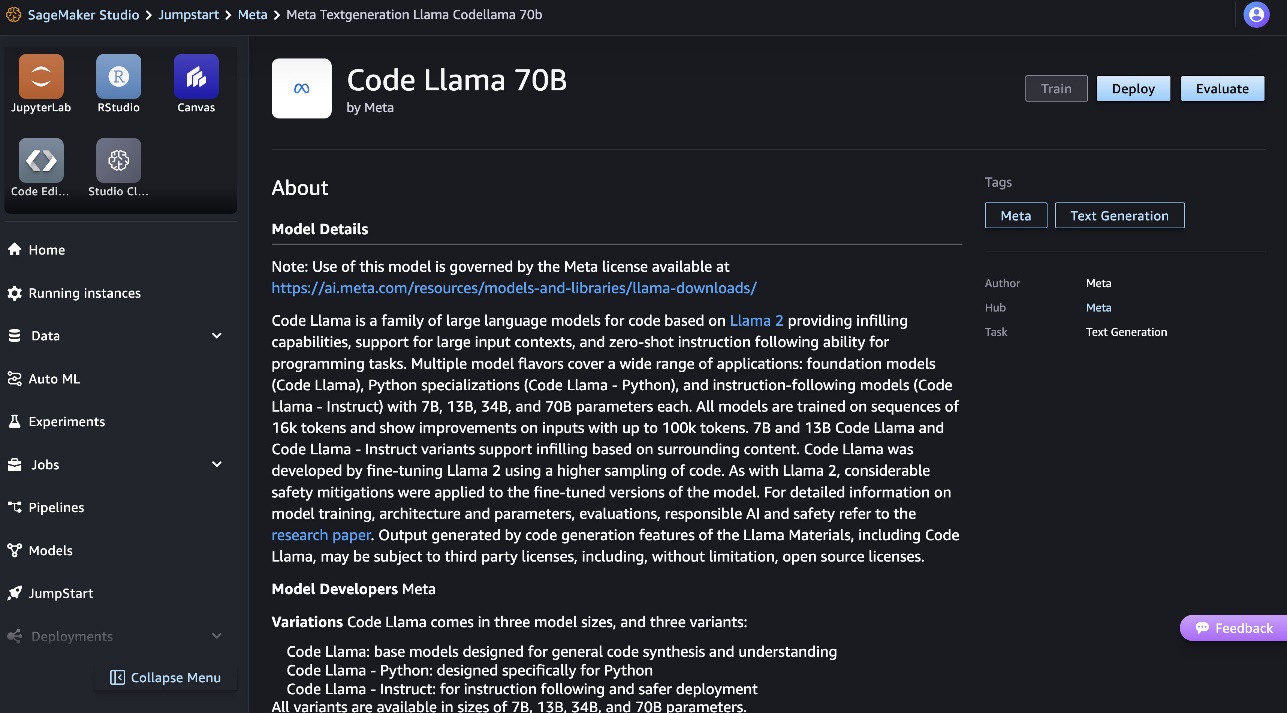

Anda dapat menemukan informasi lebih lanjut tentang model pada kartu model Kode Llama 70B.

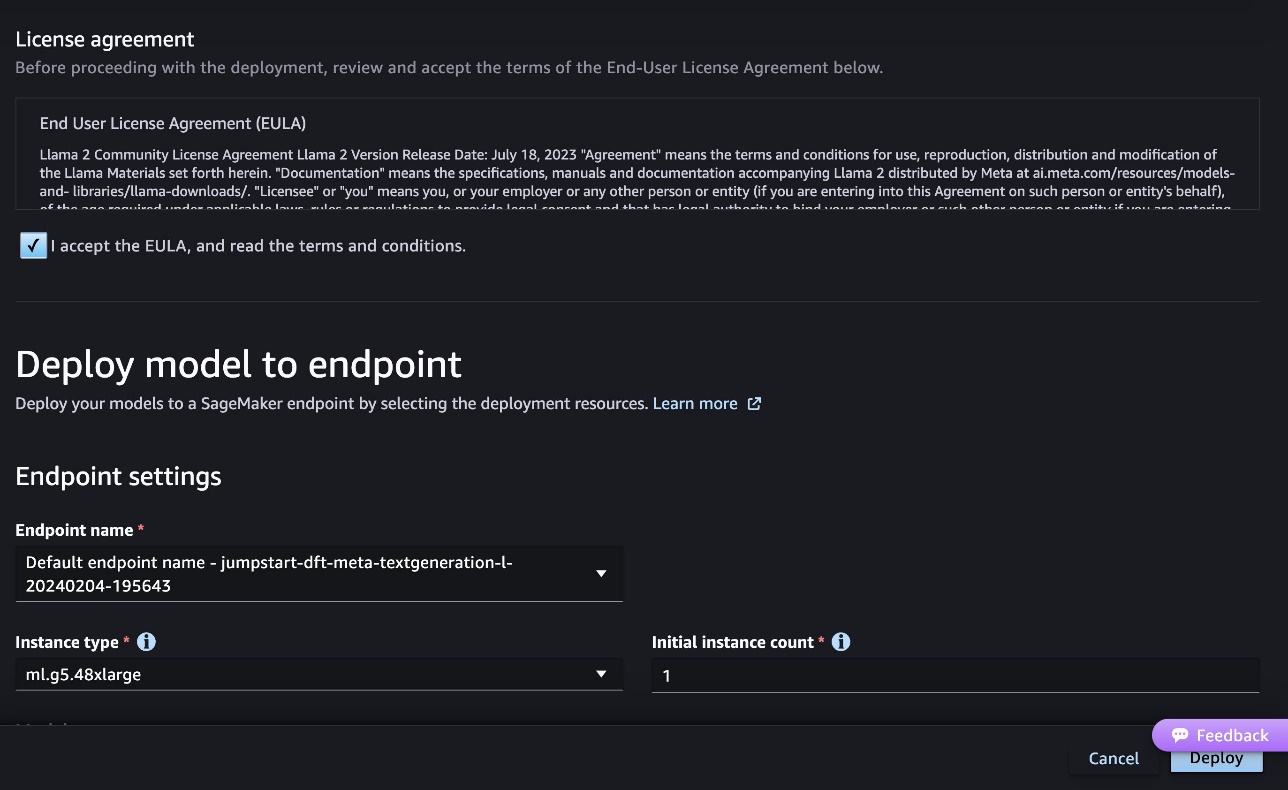

Tangkapan layar berikut menunjukkan pengaturan titik akhir. Anda dapat mengubah opsi atau menggunakan opsi default.

- Terima Perjanjian Lisensi Pengguna Akhir (EULA) dan pilih Menyebarkan.

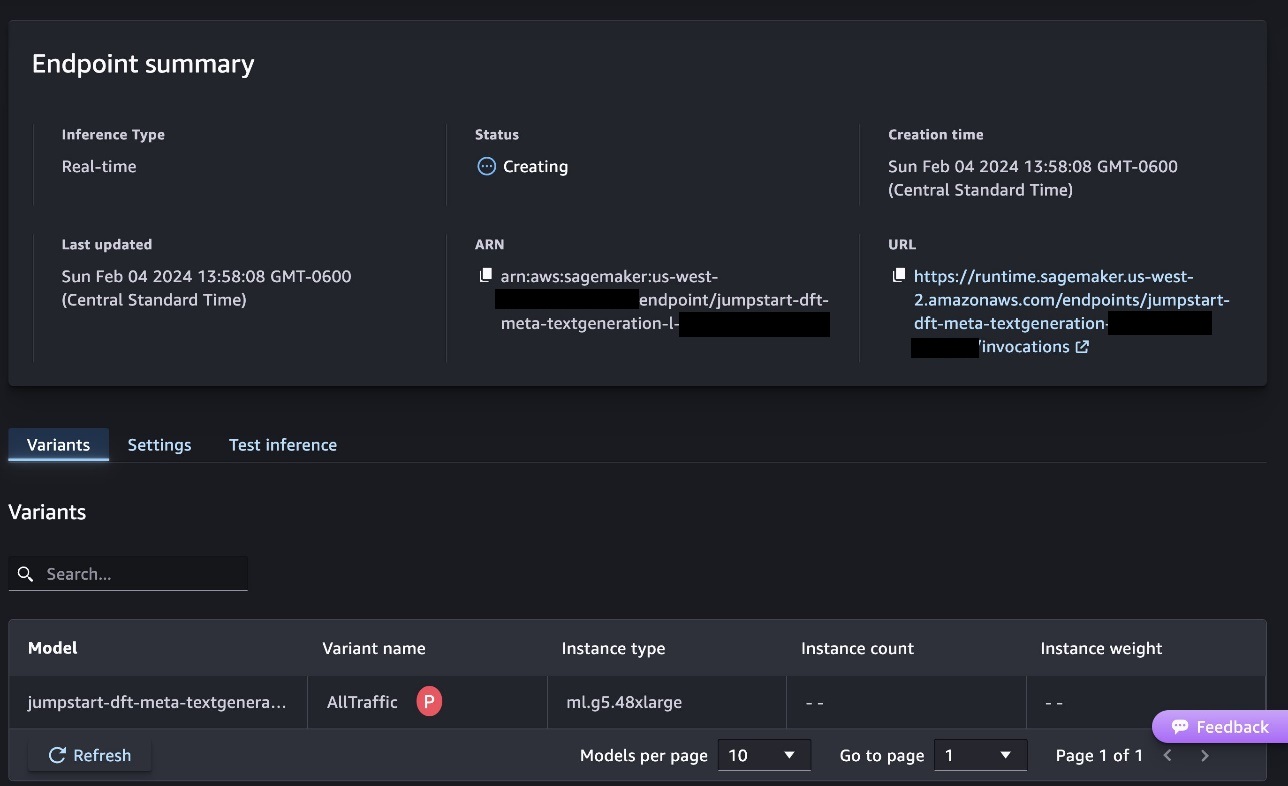

Ini akan memulai proses penerapan titik akhir, seperti yang ditunjukkan pada tangkapan layar berikut.

Terapkan model dengan SageMaker Python SDK

Alternatifnya, Anda dapat menyebarkan melalui contoh buku catatan dengan memilih Buka Buku Catatan dalam halaman detail model Studio Klasik. Contoh notebook memberikan panduan menyeluruh tentang cara menyebarkan model untuk inferensi dan membersihkan sumber daya.

Untuk menerapkan menggunakan notebook, kita mulai dengan memilih model yang sesuai, yang ditentukan oleh model_id. Anda dapat menerapkan salah satu model yang dipilih di SageMaker dengan kode berikut:

Ini menyebarkan model pada SageMaker dengan konfigurasi default, termasuk jenis instans default dan konfigurasi VPC default. Anda dapat mengubah konfigurasi ini dengan menentukan nilai non-default di JumpStartModel. Perhatikan bahwa secara default, accept_eula diatur ke False. Anda perlu mengatur accept_eula=True untuk menyebarkan titik akhir dengan sukses. Dengan melakukan ini, Anda menerima perjanjian lisensi pengguna dan kebijakan penggunaan yang dapat diterima seperti yang disebutkan sebelumnya. Anda juga bisa Download perjanjian lisensi.

Panggil titik akhir SageMaker

Setelah titik akhir disebarkan, Anda dapat melakukan inferensi dengan menggunakan Boto3 atau SageMaker Python SDK. Dalam kode berikut, kami menggunakan SageMaker Python SDK untuk memanggil model untuk inferensi dan mencetak responsnya:

Fungsi print_response mengambil payload yang terdiri dari payload dan respon model dan mencetak hasilnya. Kode Llama mendukung banyak parameter saat melakukan inferensi:

- panjang maksimal – Model menghasilkan teks hingga panjang output (yang mencakup panjang konteks input) tercapai

max_length. Jika ditentukan, itu harus berupa bilangan bulat positif. - max_new_tokens – Model menghasilkan teks hingga panjang keluaran (tidak termasuk panjang konteks masukan) tercapai

max_new_tokens. Jika ditentukan, itu harus berupa bilangan bulat positif. - nomor_balok – Ini menentukan jumlah balok yang digunakan dalam pencarian serakah. Jika ditentukan, maka harus berupa bilangan bulat yang lebih besar dari atau sama dengan

num_return_sequences. - no_repeat_ngram_size – Model memastikan bahwa urutan kata-kata

no_repeat_ngram_sizetidak diulang dalam urutan output. Jika ditentukan, itu harus bilangan bulat positif lebih besar dari 1. - suhu – Ini mengontrol keacakan dalam keluaran. Lebih tinggi

temperaturemenghasilkan urutan keluaran dengan kata-kata dengan probabilitas rendah, dan lebih rendahtemperaturemenghasilkan urutan keluaran dengan kata-kata dengan probabilitas tinggi. Jikatemperatureadalah 0, ini menghasilkan decoding serakah. Jika ditentukan, itu harus berupa pelampung positif. - awal_berhenti - Jika

True, pembuatan teks selesai ketika semua hipotesis balok mencapai akhir token kalimat. Jika ditentukan, itu harus Boolean. - lakukan_sampel - Jika

True, model mengambil sampel kata berikutnya sesuai kemungkinannya. Jika ditentukan, itu harus Boolean. - teratas_k – Dalam setiap langkah pembuatan teks, model hanya mengambil sampel dari

top_kkata-kata yang paling mungkin. Jika ditentukan, itu harus berupa bilangan bulat positif. - atas_p – Dalam setiap langkah pembuatan teks, model mengambil sampel dari kumpulan kata sekecil mungkin dengan probabilitas kumulatif

top_p. Jika ditentukan, itu harus berupa float antara 0 dan 1. - return_full_text - Jika

True, teks masukan akan menjadi bagian dari teks keluaran yang dihasilkan. Jika ditentukan, itu harus Boolean. Nilai defaultnya adalahFalse. - berhenti – Jika ditentukan, itu harus berupa daftar string. Pembuatan teks berhenti jika salah satu dari string tertentu dihasilkan.

Anda dapat menentukan subset mana pun dari parameter ini saat memanggil titik akhir. Selanjutnya, kami menunjukkan contoh cara memanggil titik akhir dengan argumen ini.

Pelengkapan kode

Contoh berikut menunjukkan cara melakukan penyelesaian kode ketika respons titik akhir yang diharapkan merupakan kelanjutan alami dari perintah.

Pertama-tama kita jalankan kode berikut:

Kami mendapatkan output berikut:

Untuk contoh berikutnya, kami menjalankan kode berikut:

Kami mendapatkan output berikut:

Pembuatan kode

Contoh berikut menunjukkan pembuatan kode Python menggunakan Code Llama.

Pertama-tama kita jalankan kode berikut:

Kami mendapatkan output berikut:

Untuk contoh berikutnya, kami menjalankan kode berikut:

Kami mendapatkan output berikut:

Ini adalah beberapa contoh tugas terkait kode yang menggunakan Kode Llama 70B. Anda dapat menggunakan model tersebut untuk menghasilkan kode yang lebih rumit. Kami mendorong Anda untuk mencobanya menggunakan kasus dan contoh penggunaan terkait kode Anda sendiri!

Membersihkan

Setelah Anda menguji titik akhir, pastikan Anda menghapus titik akhir inferensi SageMaker dan model untuk menghindari dikenakan biaya. Gunakan kode berikut:

Kesimpulan

Dalam postingan ini, kami memperkenalkan Kode Llama 70B di SageMaker JumpStart. Kode Llama 70B adalah model canggih untuk menghasilkan kode dari perintah bahasa alami serta kode. Anda dapat menerapkan model dengan beberapa langkah sederhana di SageMaker JumpStart dan kemudian menggunakannya untuk menjalankan tugas terkait kode seperti pembuatan kode dan pengisian kode. Sebagai langkah selanjutnya, coba gunakan model dengan kasus penggunaan dan data terkait kode Anda sendiri.

Tentang penulis

Dr.Kyle Ulrich adalah Ilmuwan Terapan di tim Amazon SageMaker JumpStart. Minat penelitiannya meliputi algoritma pembelajaran mesin yang dapat diskalakan, visi komputer, deret waktu, non-parametrik Bayesian, dan proses Gaussian. Gelar PhD-nya berasal dari Duke University dan dia telah menerbitkan makalah di NeurIPS, Cell, dan Neuron.

Dr.Kyle Ulrich adalah Ilmuwan Terapan di tim Amazon SageMaker JumpStart. Minat penelitiannya meliputi algoritma pembelajaran mesin yang dapat diskalakan, visi komputer, deret waktu, non-parametrik Bayesian, dan proses Gaussian. Gelar PhD-nya berasal dari Duke University dan dia telah menerbitkan makalah di NeurIPS, Cell, dan Neuron.

Dr.Farooq Sabir adalah Arsitek Solusi Spesialis Kecerdasan Buatan dan Pembelajaran Mesin Senior di AWS. Dia memegang gelar PhD dan MS di bidang Teknik Listrik dari University of Texas di Austin dan MS di bidang Ilmu Komputer dari Georgia Institute of Technology. Dia memiliki lebih dari 15 tahun pengalaman kerja dan juga suka mengajar dan membimbing mahasiswa. Di AWS, dia membantu pelanggan merumuskan dan memecahkan masalah bisnis mereka dalam ilmu data, pembelajaran mesin, visi komputer, kecerdasan buatan, pengoptimalan numerik, dan domain terkait. Berbasis di Dallas, Texas, dia dan keluarganya suka bepergian dan melakukan perjalanan jauh.

Dr.Farooq Sabir adalah Arsitek Solusi Spesialis Kecerdasan Buatan dan Pembelajaran Mesin Senior di AWS. Dia memegang gelar PhD dan MS di bidang Teknik Listrik dari University of Texas di Austin dan MS di bidang Ilmu Komputer dari Georgia Institute of Technology. Dia memiliki lebih dari 15 tahun pengalaman kerja dan juga suka mengajar dan membimbing mahasiswa. Di AWS, dia membantu pelanggan merumuskan dan memecahkan masalah bisnis mereka dalam ilmu data, pembelajaran mesin, visi komputer, kecerdasan buatan, pengoptimalan numerik, dan domain terkait. Berbasis di Dallas, Texas, dia dan keluarganya suka bepergian dan melakukan perjalanan jauh.

Juni Won adalah manajer produk di SageMaker JumpStart. Dia berfokus untuk membuat model dasar mudah ditemukan dan digunakan untuk membantu pelanggan membangun aplikasi AI generatif. Pengalamannya di Amazon juga mencakup aplikasi belanja seluler dan pengiriman jarak jauh.

Juni Won adalah manajer produk di SageMaker JumpStart. Dia berfokus untuk membuat model dasar mudah ditemukan dan digunakan untuk membantu pelanggan membangun aplikasi AI generatif. Pengalamannya di Amazon juga mencakup aplikasi belanja seluler dan pengiriman jarak jauh.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/code-llama-70b-is-now-available-in-amazon-sagemaker-jumpstart/

- :memiliki

- :adalah

- :bukan

- :Di mana

- $NAIK

- 000

- 1

- 10

- 100

- 11

- 12

- 13

- 14

- 15 tahun

- 15%

- 16

- 22

- 25

- 500

- 7

- 80

- 9

- a

- Tentang Kami

- Setuju

- diterima

- penerimaan

- mengakses

- uang muka

- Persetujuan

- AI

- algoritma

- Semua

- juga

- Amazon

- Amazon SageMaker

- Mulai Lompatan Amazon SageMaker

- Amazon Web Services

- an

- dan

- Mengumumkan

- Apa pun

- Aplikasi

- aplikasi

- terapan

- sesuai

- ADALAH

- argumen

- Seni

- buatan

- kecerdasan buatan

- Kecerdasan Buatan dan Pembelajaran Mesin

- AS

- Asisten

- terjamin

- At

- austin

- tersedia

- menghindari

- AWS

- mendasarkan

- berdasarkan

- menampar

- Bayesian

- BE

- Balok

- karena

- antara

- Milyar

- Miliar token

- miliaran

- kedua

- gelembung

- membangun

- dibangun di

- bisnis

- by

- C + +

- panggilan

- CAN

- mampu

- kartu

- membawa

- kasus

- Kategori

- sel

- perubahan

- karakteristik

- beban

- Pilih

- memilih

- kelas

- klasik

- membersihkan

- Klik

- kode

- Perguruan tinggi

- bagaimana

- datang

- lengkap

- penyelesaian

- rumit

- komputer

- Komputer Ilmu

- Visi Komputer

- Terdiri dari

- konsul

- Konten

- konteks

- kelanjutan

- kontrol

- menutupi

- membuat

- dikuratori

- pelanggan

- Dallas

- data

- ilmu data

- decoding

- Default

- pengiriman

- mendemonstrasikan

- menyebarkan

- dikerahkan

- penyebaran

- menyebarkan

- dirancang

- rinci

- dikembangkan

- pengembang

- Pengembangan

- berbeda

- digital

- digital Art

- menemukan

- do

- melakukan

- domain

- Duke

- universitas adipati

- setiap

- Terdahulu

- mudah

- efisien

- memungkinkan

- mendorong

- akhir

- ujung ke ujung

- Titik akhir

- direkayasa

- Teknik

- Memastikan

- sama

- kesalahan

- mengevaluasi

- Bahkan

- contoh

- contoh

- Excel

- Kecuali

- gembira

- tidak termasuk

- ada

- diharapkan

- mahal

- pengalaman

- eksponensial

- Menghadapi

- keluarga

- beberapa

- Menemukan

- Pertama

- Mengapung

- berfokus

- berikut

- Untuk

- Prinsip Dasar

- dasar

- empat

- dari

- fungsi

- menghasilkan

- dihasilkan

- menghasilkan

- menghasilkan

- generasi

- Generasi

- generatif

- AI generatif

- Georgia

- mendapatkan

- diberikan

- Go

- lebih besar

- Serakah

- bimbingan

- Memiliki

- he

- membantu

- membantu

- membantu

- berkualitas tinggi

- lebih tinggi

- -nya

- memegang

- Beranda

- tuan rumah

- host

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- HTTPS

- Pusat

- hub

- i

- ideal

- if

- mengimpor

- memperbaiki

- perbaikan

- in

- memasukkan

- termasuk

- Termasuk

- inkremental

- informasi

- memasukkan

- input

- contoh

- Lembaga

- instruksi

- Intelijen

- kepentingan

- diperkenalkan

- IT

- Jawa

- jpg

- dikenal

- kyle

- bahasa

- besar

- Terakhir

- pengetahuan

- meninggalkan

- Panjang

- Lisensi

- kemungkinan

- Mungkin

- 'like

- Daftar

- Llama

- LLM

- Panjang

- cinta

- menurunkan

- mesin

- Mesin belajar

- terbuat

- membuat

- Membuat

- manajer

- banyak

- tersebut

- penasihat

- meta

- mil

- ML

- mobil

- model

- model

- lebih

- lebih efisien

- paling

- MS

- harus

- Alam

- Navigasi

- Perlu

- dibutuhkan

- tak pernah

- New

- berikutnya

- mencatat

- buku catatan

- sekarang

- jumlah

- of

- on

- ONE

- yang

- hanya

- optimasi

- Opsi

- or

- kami

- di luar

- keluaran

- lebih

- sendiri

- halaman

- pane

- dokumen

- parameter

- bagian

- pihak

- untuk

- Melakukan

- melakukan

- phd

- PHP

- plato

- Kecerdasan Data Plato

- Data Plato

- kebijaksanaan

- Populer

- positif

- mungkin

- Pos

- potensi

- Predictor

- Mencetak

- cetakan

- masalah

- proses

- proses

- Produk

- manajer produk

- produktifitas

- Pemrograman

- meminta

- memberikan

- penyedia

- menyediakan

- diterbitkan

- Ular sanca

- pytorch

- segera

- keserampangan

- jarak

- agak

- mencapai

- Mencapai

- baru

- terkait

- dirilis

- ulang

- penelitian

- Sumber

- tanggapan

- ISTIRAHAT

- Hasil

- kembali

- membalikkan

- ulasan

- Naik

- jalan

- Run

- berjalan

- pembuat bijak

- Inferensi SageMaker

- sama

- Save

- terukur

- Skala

- Ilmu

- ilmuwan

- SDK

- Pencarian

- terpilih

- memilih

- senior

- putusan pengadilan

- Urutan

- Seri

- Layanan

- set

- pengaturan

- berbagi

- tas

- Menunjukkan

- ditunjukkan

- Pertunjukkan

- Sederhana

- ukuran

- So

- Perangkat lunak

- Solusi

- MEMECAHKAN

- beberapa

- spesialis

- khusus

- ditentukan

- menentukan

- stabil

- awal

- mulai

- state-of-the-art

- Langkah

- Tangga

- Berhenti

- Tali

- Siswa

- studio

- berhasil

- seperti itu

- mendukung

- Mendukung

- yakin

- Sekitarnya

- Dibutuhkan

- tugas

- tim

- Teknologi

- tensorflow

- istilah

- uji

- diuji

- texas

- teks

- dari

- bahwa

- Grafik

- mereka

- Mereka

- diri

- kemudian

- Ini

- Ketiga

- Pihak ketiga

- ini

- tiga

- Melalui

- waktu

- Seri waktu

- untuk

- token

- Token

- puncak

- Pelatihan VE

- terlatih

- Terjemahan

- perjalanan

- melintasi

- benar

- mencoba

- mengetik

- Naskah

- khas

- ui

- bawah

- pemahaman

- universitas

- sampai

- dapat digunakan

- penggunaan

- menggunakan

- bekas

- Pengguna

- menggunakan

- nilai

- Nilai - Nilai

- variasi

- versi

- melalui

- penglihatan

- berjalan

- ingin

- we

- jaringan

- layanan web

- BAIK

- adalah

- ketika

- apakah

- yang

- sementara

- lebar

- Widget

- akan

- dengan

- dalam

- tanpa

- Word

- kata

- Kerja

- alur kerja

- Alur kerja

- menulis

- tahun

- Kamu

- Anda

- zephyrnet.dll