Karena pembelajaran mesin (ML) menjadi semakin umum di berbagai industri, organisasi menemukan kebutuhan untuk melatih dan melayani model ML dalam jumlah besar untuk memenuhi beragam kebutuhan pelanggan mereka. Khususnya untuk penyedia perangkat lunak sebagai layanan (SaaS), kemampuan untuk melatih dan melayani ribuan model secara efisien dan hemat biaya sangat penting untuk tetap kompetitif di pasar yang berkembang pesat.

Melatih dan melayani ribuan model membutuhkan infrastruktur yang kuat dan dapat diskalakan, di situlah tempatnya Amazon SageMaker bisa membantu. SageMaker adalah platform yang terkelola sepenuhnya yang memungkinkan pengembang dan ilmuwan data membangun, melatih, dan menerapkan model ML dengan cepat, sekaligus menawarkan manfaat hemat biaya menggunakan infrastruktur AWS Cloud.

Dalam postingan ini, kami mengeksplorasi bagaimana Anda dapat menggunakan fitur SageMaker, termasuk Pemrosesan SageMaker Amazon, tugas pelatihan SageMaker, dan titik akhir multi-model (MME) SageMaker, untuk melatih dan melayani ribuan model dengan cara yang hemat biaya. Untuk memulai dengan solusi yang dijelaskan, Anda dapat merujuk ke notebook terlampir di GitHub.

Kasus penggunaan: Perkiraan energi

Untuk postingan ini, kami berperan sebagai perusahaan ISV yang membantu pelanggan mereka menjadi lebih berkelanjutan dengan melacak konsumsi energi mereka dan memberikan prakiraan. Perusahaan kami memiliki 1,000 pelanggan yang ingin lebih memahami penggunaan energi mereka dan membuat keputusan berdasarkan informasi tentang cara mengurangi dampak lingkungan mereka. Untuk melakukannya, kami menggunakan kumpulan data sintetis dan melatih model ML berdasarkan nabi untuk setiap pelanggan untuk membuat prakiraan konsumsi energi. Dengan SageMaker, kami dapat melatih dan melayani 1,000 model ini secara efisien, memberi pelanggan kami wawasan yang akurat dan dapat ditindaklanjuti tentang penggunaan energi mereka.

Ada tiga fitur dalam dataset yang dihasilkan:

- ID Pelanggan – Ini adalah pengidentifikasi bilangan bulat untuk setiap pelanggan, mulai dari 0–999.

- timestamp – Ini adalah nilai tanggal/waktu yang menunjukkan waktu pengukuran konsumsi energi. Stempel waktu dihasilkan secara acak antara tanggal mulai dan berakhir yang ditentukan dalam kode.

- konsumsi – Ini adalah nilai float yang menunjukkan konsumsi energi, diukur dalam beberapa satuan arbitrer. Nilai konsumsi dihasilkan secara acak antara 0–1,000 dengan musiman sinusoidal.

Ikhtisar solusi

Untuk melatih dan melayani ribuan model ML secara efisien, kita dapat menggunakan fitur SageMaker berikut:

- Pengolahan SageMaker – Pemrosesan SageMaker adalah layanan persiapan data yang dikelola sepenuhnya yang memungkinkan Anda melakukan tugas pemrosesan data dan evaluasi model pada data input Anda. Anda dapat menggunakan Pemrosesan SageMaker untuk mengubah data mentah menjadi format yang diperlukan untuk pelatihan dan inferensi, serta untuk menjalankan evaluasi batch dan online model Anda.

- Pekerjaan pelatihan SageMaker – Anda dapat menggunakan tugas pelatihan SageMaker untuk melatih model pada berbagai algoritme dan tipe data masukan, dan menentukan sumber daya komputasi yang diperlukan untuk pelatihan.

- MME SageMaker – Titik akhir multi-model memungkinkan Anda menghosting beberapa model pada satu titik akhir, yang memudahkan untuk menyajikan prediksi dari beberapa model menggunakan satu API. MME SageMaker dapat menghemat waktu dan sumber daya dengan mengurangi jumlah titik akhir yang diperlukan untuk melayani prediksi dari beberapa model. MME mendukung hosting model yang didukung CPU dan GPU. Perhatikan bahwa dalam skenario kami, kami menggunakan 1,000 model, tetapi ini bukan batasan dari layanan itu sendiri.

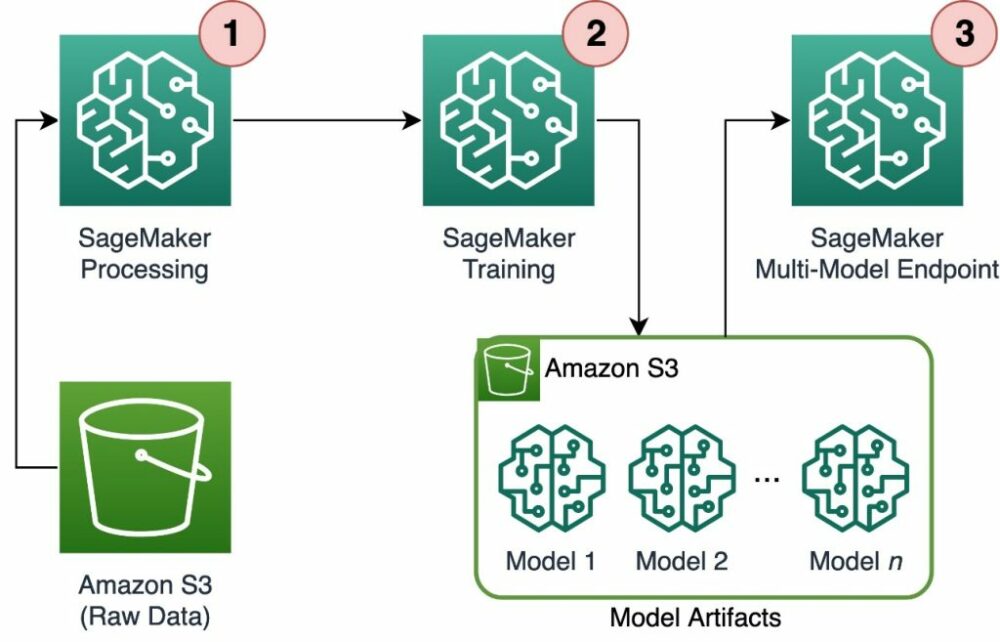

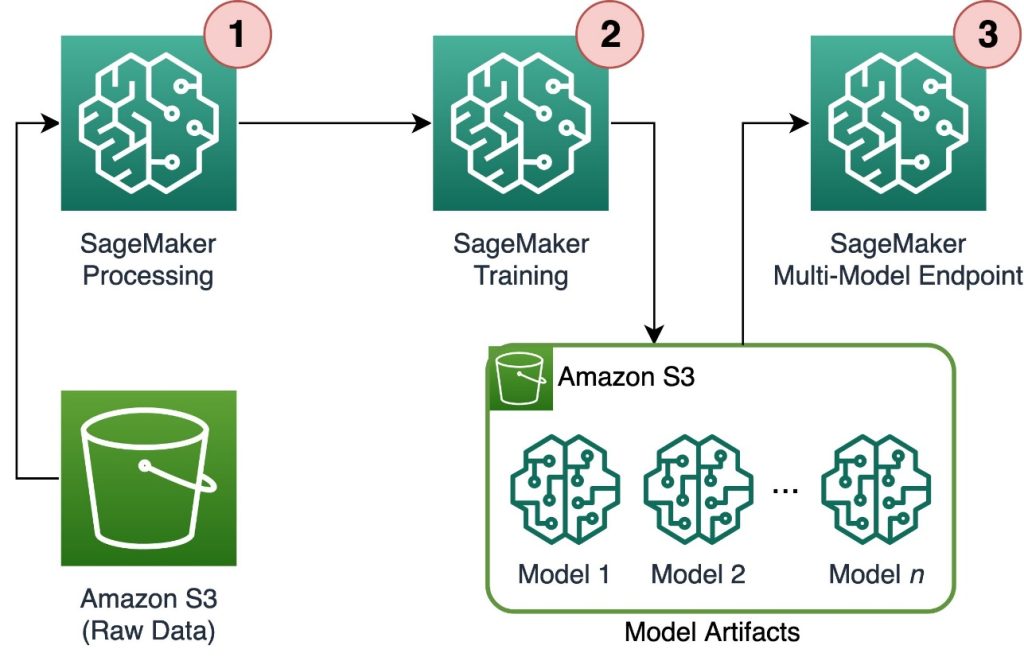

Diagram berikut menggambarkan arsitektur solusi.

Alur kerja meliputi langkah-langkah berikut:

- Kami menggunakan Pemrosesan SageMaker untuk melakukan praproses data dan membuat satu file CSV per pelanggan dan menyimpannya Layanan Penyimpanan Sederhana Amazon (Amazon S3).

- Tugas pelatihan SageMaker dikonfigurasi untuk membaca output tugas Pemrosesan SageMaker dan mendistribusikannya dalam mode round-robin ke instans pelatihan. Perhatikan bahwa ini juga dapat dicapai dengan Pipa Amazon SageMaker.

- Artefak model disimpan di Amazon S3 oleh tugas pelatihan, dan disajikan langsung dari MME SageMaker.

Skalakan pelatihan ke ribuan model

Menskalakan pelatihan ribuan model dimungkinkan melalui distribution parameter dari PelatihanInput di SageMaker Python SDK, yang memungkinkan Anda menentukan cara data didistribusikan ke beberapa instans pelatihan untuk tugas pelatihan. Ada tiga pilihan untuk distribution parameter: FullyReplicated, ShardedByS3Key, dan ShardedByRecord. itu ShardedByS3Key opsi berarti bahwa data pelatihan dipecah oleh kunci objek S3, dengan setiap instans pelatihan menerima subset data yang unik, menghindari duplikasi. Setelah data disalin oleh SageMaker ke wadah pelatihan, kita dapat membaca folder dan struktur file untuk melatih model unik per file pelanggan. Berikut ini adalah cuplikan kode contoh:

Setiap tugas pelatihan SageMaker menyimpan model yang disimpan di /opt/ml/model folder wadah pelatihan sebelum mengarsipkannya di a model.tar.gz file, lalu mengunggahnya ke Amazon S3 setelah menyelesaikan tugas pelatihan. Power user juga dapat mengotomatiskan proses ini dengan SageMaker Pipelines. Saat menyimpan beberapa model melalui tugas pelatihan yang sama, SageMaker akan membuat satu model model.tar.gz file yang berisi semua model terlatih. Ini berarti bahwa, untuk menyajikan model, kita perlu membongkar arsipnya terlebih dahulu. Untuk menghindari ini, kami menggunakan pos pemeriksaan untuk menyimpan status masing-masing model. SageMaker menyediakan fungsionalitas untuk menyalin titik pemeriksaan yang dibuat selama tugas pelatihan ke Amazon S3. Di sini, pos pemeriksaan perlu disimpan di lokasi yang ditentukan sebelumnya, dengan defaultnya /opt/ml/checkpoints. Pos pemeriksaan ini dapat digunakan untuk melanjutkan pelatihan di lain waktu atau sebagai model untuk diterapkan di titik akhir. Untuk ringkasan tingkat tinggi tentang cara platform pelatihan SageMaker mengelola jalur penyimpanan untuk dataset pelatihan, artefak model, pos pemeriksaan, dan output antara penyimpanan AWS Cloud dan tugas pelatihan di SageMaker, lihat Folder Penyimpanan Pelatihan Amazon SageMaker untuk Dataset Pelatihan, Pos Pemeriksaan, Artefak Model, dan Keluaran.

Kode berikut menggunakan fiktif model.save() fungsi di dalam train.py skrip yang berisi logika pelatihan:

Menskalakan inferensi ke ribuan model dengan MME SageMaker

MME SageMaker memungkinkan Anda menyajikan beberapa model sekaligus dengan membuat konfigurasi titik akhir yang mencakup daftar semua model yang akan ditayangkan, lalu membuat titik akhir menggunakan konfigurasi titik akhir tersebut. Tidak perlu menerapkan ulang titik akhir setiap kali Anda menambahkan model baru karena titik akhir akan secara otomatis melayani semua model yang disimpan di jalur S3 yang ditentukan. Ini dicapai dengan Server Multi Model (MMS), kerangka kerja sumber terbuka untuk melayani model ML yang dapat dipasang di penampung untuk menyediakan ujung depan yang memenuhi persyaratan untuk API penampung MME baru. Selain itu, Anda dapat menggunakan server model lain termasuk Layanan obor dan Pelaut. MMS dapat dipasang di wadah khusus Anda melalui Perangkat Inferensi SageMaker. Untuk mempelajari lebih lanjut tentang cara mengonfigurasi Dockerfile Anda untuk menyertakan MMS dan menggunakannya untuk melayani model Anda, lihat Bangun Kontainer Anda Sendiri untuk Titik Akhir Multi-Model SageMaker.

Cuplikan kode berikut menunjukkan cara membuat MME menggunakan SageMaker Python SDK:

Saat MME aktif, kita dapat memanggilnya untuk menghasilkan prediksi. Pemanggilan dapat dilakukan di AWS SDK apa pun serta dengan SageMaker Python SDK, seperti yang ditampilkan dalam cuplikan kode berikut:

Saat memanggil model, model awalnya dimuat dari Amazon S3 pada instans, yang dapat menyebabkan cold start saat memanggil model baru. Model yang sering digunakan di-cache di memori dan di disk untuk menyediakan inferensi latensi rendah.

Kesimpulan

SageMaker adalah platform yang andal dan hemat biaya untuk melatih dan melayani ribuan model ML. Fitur-fiturnya, termasuk Pemrosesan SageMaker, tugas pelatihan, dan MME, memungkinkan organisasi untuk melatih dan melayani ribuan model secara efisien dalam skala besar, sekaligus mendapatkan keuntungan dari penghematan biaya menggunakan infrastruktur AWS Cloud. Untuk mempelajari selengkapnya tentang cara menggunakan SageMaker untuk melatih dan melayani ribuan model, lihat Data proses, Latih Model dengan Amazon SageMaker dan Host beberapa model dalam satu wadah di belakang satu titik akhir.

Tentang Penulis

Davide Gallitelli adalah Arsitek Solusi Spesialis untuk AI/ML di wilayah EMEA. Dia berbasis di Brussel dan bekerja sama dengan pelanggan di seluruh Benelux. Dia telah menjadi pengembang sejak dia masih sangat muda, mulai membuat kode pada usia 7 tahun. Dia mulai belajar AI/ML di universitas, dan telah jatuh cinta padanya sejak saat itu.

Davide Gallitelli adalah Arsitek Solusi Spesialis untuk AI/ML di wilayah EMEA. Dia berbasis di Brussel dan bekerja sama dengan pelanggan di seluruh Benelux. Dia telah menjadi pengembang sejak dia masih sangat muda, mulai membuat kode pada usia 7 tahun. Dia mulai belajar AI/ML di universitas, dan telah jatuh cinta padanya sejak saat itu.

Maurit de Groot adalah Arsitek Solusi di Amazon Web Services, berbasis di Amsterdam. Dia suka mengerjakan topik terkait pembelajaran mesin dan memiliki kecenderungan untuk memulai. Di waktu luangnya, dia menikmati bermain ski dan bermain squash.

Maurit de Groot adalah Arsitek Solusi di Amazon Web Services, berbasis di Amsterdam. Dia suka mengerjakan topik terkait pembelajaran mesin dan memiliki kecenderungan untuk memulai. Di waktu luangnya, dia menikmati bermain ski dan bermain squash.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Otomotif / EV, Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- BlockOffset. Modernisasi Kepemilikan Offset Lingkungan. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/scale-training-and-inference-of-thousands-of-ml-models-with-amazon-sagemaker/

- :memiliki

- :adalah

- :bukan

- :Di mana

- 000

- 000 Pelanggan

- 1

- 10

- 100

- 12

- 15%

- 20

- 7

- a

- kemampuan

- Tentang Kami

- tepat

- dicapai

- di seluruh

- menambahkan

- tambahan

- keuntungan

- Setelah

- usia

- AI / ML

- algoritma

- Semua

- mengizinkan

- memungkinkan

- sudah

- juga

- Amazon

- Amazon SageMaker

- Amazon Web Services

- amsterdam

- an

- dan

- Apa pun

- api

- Lebah

- arsitektur

- arsip

- ADALAH

- argumen

- AS

- menganggap

- At

- mengotomatisasikan

- secara otomatis

- menghindari

- menghindari

- AWS

- berdasarkan

- BE

- karena

- menjadi

- menjadi

- menjadi

- sebelum

- di belakang

- makhluk

- menguntungkan

- Manfaat

- Lebih baik

- antara

- kedua

- Brussels

- membangun

- tapi

- by

- panggilan

- CAN

- kasus

- kelas

- rapat

- awan

- infrastruktur cloud

- Cloud Storage

- kode

- dingin

- perusahaan

- kompetitif

- penyelesaian

- menghitung

- konfigurasi

- dikonfigurasi

- konsumsi

- Wadah

- Wadah

- hemat biaya

- membuat

- dibuat

- menciptakan

- membuat

- sangat penting

- adat

- pelanggan

- pelanggan

- data

- Persiapan data

- pengolahan data

- kumpulan data

- Tanggal

- keputusan

- Default

- menetapkan

- definisi

- menyebarkan

- dijelaskan

- Pengembang

- pengembang

- langsung

- menampilkan

- mendistribusikan

- didistribusikan

- beberapa

- do

- dilakukan

- selama

- setiap

- Mudah

- efisien

- EMEA

- aktif

- memungkinkan

- akhir

- Titik akhir

- energi

- Konsumsi Energi

- lingkungan

- evaluasi

- evaluasi

- Setiap

- berkembang

- contoh

- menyelidiki

- Jatuh

- Fashion

- Fitur

- File

- File

- temuan

- Pertama

- Mengapung

- berikut

- Untuk

- Untuk Startups

- perkiraan

- format

- Kerangka

- sering

- dari

- depan

- Ujung depan

- sepenuhnya

- fungsi

- fungsi

- menghasilkan

- dihasilkan

- mendapatkan

- GitHub

- he

- membantu

- membantu

- di sini

- tingkat tinggi

- -nya

- tuan rumah

- tuan

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- HTML

- http

- HTTPS

- identifier

- menggambarkan

- Dampak

- mengimpor

- in

- memasukkan

- termasuk

- Termasuk

- makin

- menunjukkan

- sendiri-sendiri

- industri

- informasi

- Infrastruktur

- mulanya

- memasukkan

- input

- dalam

- wawasan

- diinstal

- contoh

- ke

- IT

- NYA

- Diri

- Pekerjaan

- Jobs

- jpg

- json

- kunci

- besar

- kemudian

- BELAJAR

- pengetahuan

- 'like

- pembatasan

- Daftar

- hidup

- lokal

- tempat

- logika

- cinta

- mesin

- Mesin belajar

- membuat

- MEMBUAT

- berhasil

- mengelola

- Pasar

- berarti

- cara

- Pelajari

- Memori

- ML

- model

- model

- saat

- lebih

- beberapa

- nama

- Perlu

- dibutuhkan

- kebutuhan

- New

- tidak

- buku catatan

- jumlah

- nomor

- obyek

- of

- menawarkan

- on

- ONE

- secara online

- open source

- pilihan

- Opsi

- or

- urutan

- organisasi

- OS

- Lainnya

- kami

- Perusahaan kita

- di luar

- keluaran

- sendiri

- parameter

- tertentu

- lulus

- path

- untuk

- Melakukan

- periode

- gambar

- Platform

- plato

- Kecerdasan Data Plato

- Data Plato

- bermain

- mungkin

- Pos

- kekuasaan

- kuat

- Prediksi

- Predictor

- persiapan

- lazim

- proses

- pengolahan

- memberikan

- penyedia

- menyediakan

- menyediakan

- Ular sanca

- segera

- dihasilkan secara acak

- jarak

- mulai

- cepat

- Mentah

- Baca

- real-time

- menerima

- menurunkan

- mengurangi

- wilayah

- Persyaratan

- membutuhkan

- Sumber

- mengakibatkan

- lanjut

- kuat

- Peran

- Run

- SaaS

- pembuat bijak

- Pipa SageMaker

- sama

- Save

- terukur

- Skala

- skenario

- ilmuwan

- SDK

- melayani

- Server

- layanan

- Layanan

- porsi

- set

- pecah

- ditunjukkan

- Pertunjukkan

- Sederhana

- sejak

- tunggal

- potongan

- Perangkat lunak

- perangkat lunak sebagai layanan

- larutan

- Solusi

- beberapa

- spesialis

- ditentukan

- awal

- mulai

- Mulai

- Startups

- Negara

- Tangga

- penyimpanan

- menyimpan

- tersimpan

- toko

- menyimpan

- struktur

- RINGKASAN

- mendukung

- berkelanjutan

- sintetis

- target

- tugas

- bahwa

- Grafik

- Negara

- mereka

- kemudian

- Sana.

- Ini

- ini

- ribuan

- tiga

- di seluruh

- waktu

- untuk

- Topik

- Pelacakan

- Pelatihan VE

- terlatih

- Pelatihan

- Mengubah

- jenis

- memahami

- unik

- satuan

- universitas

- atas

- penggunaan

- menggunakan

- bekas

- Pengguna

- kegunaan

- menggunakan

- nilai

- Nilai - Nilai

- variasi

- sangat

- melalui

- W

- ingin

- adalah

- Cara..

- we

- jaringan

- layanan web

- BAIK

- ketika

- yang

- sementara

- SIAPA

- lebar

- Rentang luas

- akan

- dengan

- dalam

- Kerja

- alur kerja

- bekerja

- akan

- Kamu

- muda

- Anda

- zephyrnet.dll