Pengantar

Sesekali, seseorang dapat mengambil konsep abstrak yang tampaknya terlalu samar untuk dipelajari secara formal dan menawarkan definisi formal yang elegan. Claude Shannon melakukannya dengan informasi, dan Andrey Kolmogorov melakukannya dengan keserampangan. Selama beberapa tahun terakhir, para peneliti telah mencoba melakukan hal yang sama untuk konsep keadilan dalam pembelajaran mesin. Sayangnya, ini lebih rumit. Tidak hanya konsepnya lebih sulit untuk didefinisikan, tetapi juga tidak mungkin untuk satu definisi memenuhi semua metrik keadilan yang diinginkan. Arvind Narayanan, seorang ilmuwan komputer di Universitas Princeton, telah berperan penting dalam mengontekstualisasikan berbagai pandangan dan membantu bidang baru ini memantapkan dirinya.

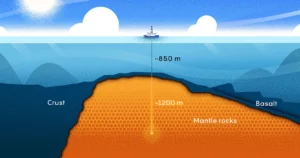

Karirnya telah menjangkau semua tingkat abstraksi, dari teori hingga kebijakan, tetapi perjalanan yang akhirnya menghasilkan pekerjaannya saat ini dimulai pada tahun 2006. Tahun itu, Netflix mensponsori sebuah kompetisi yang akan memberikan $1 juta kepada siapa pun yang meningkatkan keakuratan sistem rekomendasi mereka dengan 10%. Netflix menyediakan kumpulan data pengguna yang konon anonim dan peringkatnya, dengan informasi pengenal pribadi dihapus. Namun Narayanan menunjukkan bahwa dengan teknik statistik yang canggih, Anda hanya memerlukan sedikit titik data untuk mengungkap identitas pengguna “anonim” dalam kumpulan data.

Sejak saat itu, Narayanan berfokus pada bidang lain di mana teori bertemu dengan praktik. Melalui Proyek Transparansi dan Akuntabilitas Web Princeton, timnya mengungkap cara diam-diam situs web melacak pengguna dan mengekstrak data sensitif. Timnya menemukan bahwa grup seperti National Security Agency dapat menggunakan data penjelajahan web (khususnya, cookie yang ditempatkan oleh pihak ketiga) tidak hanya untuk menemukan identitas dunia nyata pengguna, tetapi juga untuk merekonstruksi 62% hingga 73% dari riwayat penjelajahan mereka. . Mereka menunjukkan bahwa - untuk riff pada terkenal New Yorker gambar kartun — di internet, situs web sekarang mengetahui bahwa Anda adalah seekor anjing.

Dalam beberapa tahun terakhir, Narayanan telah berubah secara khusus Mesin belajar — aplikasi kecerdasan buatan yang memberi mesin kemampuan untuk belajar dari data. Sementara dia menyambut kemajuan AI, dia menunjukkan bagaimana sistem seperti itu bisa gagal bahkan dengan niat baik, dan bagaimana teknologi yang bermanfaat ini bisa menjadi alat untuk membenarkan diskriminasi. Dalam hal ini, titik-titik yang tampaknya tidak berhubungan yang telah menentukan lintasan penelitian Narayanan membentuk semacam konstelasi.

Quanta berbicara dengan Narayanan tentang karyanya tentang de-anonimisasi, pentingnya intuisi statistik, dan banyak jebakan sistem AI. Wawancara telah diringkas dan diedit untuk kejelasan.

Pengantar

Apakah Anda selalu ingin melakukan penelitian matematika dan sains?

Saya tumbuh dengan sangat tertarik pada keduanya, tetapi terutama pada matematika. Saya pandai memecahkan teka-teki dan bahkan sukses di Olimpiade Matematika Internasional. Tapi saya memiliki kesalahpahaman besar tentang perbedaan antara pemecahan teka-teki dan penelitian matematika.

Sejak awal, saya memfokuskan penelitian saya pada kriptografi, terutama kriptografi teoretis, karena saya masih bekerja di bawah khayalan bahwa saya sangat pandai matematika. Dan kemudian sisa karir saya adalah perjalanan untuk menyadari bahwa sebenarnya itu bukan kekuatan saya sama sekali.

Itu pasti menjadi latar belakang yang bagus untuk pekerjaan de-anonimisasi Anda.

Kamu benar. Apa yang memungkinkan penelitian de-anonimisasi adalah keterampilan yang saya sebut intuisi statistik. Ini sebenarnya bukan pengetahuan matematika formal. Itu bisa memiliki intuisi di kepala Anda seperti: "Jika saya mengambil kumpulan data yang rumit ini dan menerapkan transformasi ini padanya, apa hasil yang masuk akal?"

Intuisi mungkin sering salah, dan tidak apa-apa. Tetapi penting untuk memiliki intuisi karena dapat membimbing Anda menuju jalan yang mungkin bermanfaat.

Pengantar

Bagaimana intuisi statistik membantu pekerjaan Anda pada data Netflix?

Saya telah mencoba menyusun skema anonimisasi untuk data dimensi tinggi. Ini benar-benar gagal, tetapi dalam proses kegagalan saya mengembangkan intuisi bahwa data dimensi tinggi tidak dapat dianonimkan secara efektif. Tentu saja Netflix, dengan pesaingnya, mengklaim telah melakukan hal itu.

Saya memiliki skeptisisme alami terhadap pernyataan pemasaran perusahaan, jadi saya termotivasi untuk membuktikan bahwa mereka salah. Penasihat saya, Vitaly Shmatikov, dan saya mengerjakannya selama beberapa minggu yang intens. Begitu kami menyadari bahwa pekerjaan itu benar-benar berdampak, saya mulai melakukan lebih banyak.

Apa dampak keseluruhannya? Apakah Anda mendapat kabar dari Netflix dan perusahaan lain yang datanya ternyata tidak terlalu anonim?

Nah, salah satu dampak positifnya adalah memacu ilmu pengetahuan privasi diferensial. Tetapi dalam hal bagaimana perusahaan bereaksi, ada beberapa reaksi yang berbeda. Dalam banyak kasus, perusahaan yang seharusnya merilis kumpulan data ke publik sekarang tidak lagi melakukannya — mereka mempersenjatai privasi sebagai cara untuk melawan upaya transparansi.

Facebook dikenal melakukan hal ini. Saat peneliti membuka Facebook dan berkata, “Kami memerlukan akses ke beberapa data ini untuk mempelajari bagaimana informasi menyebar di platform,” Facebook sekarang dapat mengatakan, “Tidak, kami tidak dapat memberikannya kepada Anda. Itu akan membahayakan privasi pengguna kami.”

Anda pernah menulis a kertas berpendapat bahwa istilah "informasi yang dapat diidentifikasi secara pribadi" dapat menyesatkan. Bagaimana?

Saya pikir ada kebingungan di antara pembuat kebijakan yang timbul dari dua cara berbeda dalam penggunaan istilah tersebut. Salah satunya adalah informasi tentang Anda yang sangat sensitif, seperti nomor jaminan sosial Anda. Arti lainnya adalah informasi yang dapat diindeks ke dalam beberapa kumpulan data dan dengan demikian digunakan untuk menemukan lebih banyak informasi tentang Anda.

Keduanya memiliki arti yang berbeda. Saya tidak punya daging sapi dengan konsep PII dalam pengertian pertama. Potongan informasi tertentu tentang orang sangat sensitif, dan kita harus memperlakukannya dengan lebih hati-hati. Namun meskipun alamat email Anda belum tentu sangat sensitif bagi kebanyakan orang, itu tetap merupakan pengidentifikasi unik yang dapat digunakan untuk menemukan Anda di kumpulan data lain. Selama kombinasi atribut tentang seseorang tersedia untuk orang lain di dunia, hanya itu yang Anda perlukan untuk de-anonimisasi.

Pengantar

Bagaimana Anda akhirnya mempelajari keadilan?

Saya mengajar kursus keadilan dan pembelajaran mesin pada tahun 2017. Itu memberi saya gambaran bagus tentang masalah terbuka di lapangan. Dan bersamaan dengan itu, saya memberikan ceramah berjudul “21 Definisi Kewajaran dan Politiknya.” Saya menjelaskan bahwa berkembangnya definisi teknis bukan karena alasan teknis, tetapi karena ada pertanyaan moral yang murni di jantung semua ini. Tidak mungkin Anda memiliki satu kriteria statistik tunggal yang mencakup semua keinginan normatif — semua hal yang Anda inginkan. Pembicaraan diterima dengan baik, jadi keduanya meyakinkan saya bahwa saya harus mulai membahas topik ini.

Kamu juga memberikan ceramah dalam mendeteksi minyak ular AI, yang juga diterima dengan baik. Bagaimana hubungannya dengan keadilan dalam pembelajaran mesin?

Jadi motivasi untuk ini adalah jelas ada banyak inovasi teknis asli yang terjadi di AI, seperti program text-to-image DALL E 2 atau program catur AlfaZero. Sungguh menakjubkan bahwa kemajuan ini begitu pesat. Banyak dari inovasi itu yang pantas untuk dirayakan.

Masalahnya muncul ketika kita menggunakan istilah payung “AI” yang sangat longgar dan luas ini untuk hal-hal seperti itu serta aplikasi yang lebih rumit, seperti metode statistik untuk prediksi risiko kriminal. Dalam konteks itu, jenis teknologi yang terlibat sangat berbeda. Ini adalah dua jenis aplikasi yang sangat berbeda, dan potensi keuntungan dan kerugiannya juga sangat berbeda. Hampir tidak ada hubungan sama sekali di antara keduanya, jadi menggunakan istilah yang sama untuk keduanya benar-benar membingungkan.

Orang-orang disesatkan dengan berpikir bahwa semua kemajuan yang mereka lihat dengan pembuatan gambar ini akan benar-benar diterjemahkan menjadi kemajuan terhadap tugas-tugas sosial seperti memprediksi risiko kriminal atau memprediksi anak mana yang akan putus sekolah. Tapi bukan itu masalahnya sama sekali. Pertama-tama, kita hanya bisa melakukan sedikit lebih baik daripada peluang acak dalam memprediksi siapa yang mungkin ditangkap karena kejahatan. Dan akurasi itu dicapai dengan pengklasifikasi yang sangat sederhana. Ini tidak menjadi lebih baik dari waktu ke waktu, dan tidak menjadi lebih baik saat kami mengumpulkan lebih banyak set data. Jadi semua pengamatan ini berbeda dengan penggunaan deep learning untuk pembuatan gambar, misalnya.

Bagaimana Anda membedakan berbagai jenis masalah pembelajaran mesin?

Ini bukan daftar lengkap, tetapi ada tiga kategori umum. Kategori pertama adalah persepsi, yang mencakup tugas-tugas seperti mendeskripsikan konten gambar. Kategori kedua adalah apa yang saya sebut "penghakiman otomatis", seperti ketika Facebook ingin menggunakan algoritme untuk menentukan ucapan mana yang terlalu beracun untuk tetap berada di platform. Dan yang ketiga memprediksi hasil sosial di masa depan di antara orang-orang - apakah seseorang akan ditangkap karena kejahatan, atau jika seorang anak akan putus sekolah.

Dalam ketiga kasus tersebut, akurasi yang dapat dicapai sangat berbeda, potensi bahaya AI yang tidak akurat sangat berbeda, dan implikasi etis yang mengikutinya sangat berbeda.

Misalnya, pengenalan wajah, dalam klasifikasi saya, adalah masalah persepsi. Banyak orang berbicara tentang pengenalan wajah yang tidak akurat, dan terkadang mereka benar. Tapi saya tidak berpikir itu karena ada batasan mendasar untuk keakuratan pengenalan wajah. Teknologi itu telah meningkat, dan itu akan menjadi lebih baik. Itulah mengapa kita harus memperhatikannya dari sudut pandang etika - ketika Anda menyerahkannya ke tangan polisi, yang mungkin tidak bertanggung jawab, atau negara yang tidak transparan tentang penggunaannya.

Pengantar

Apa yang membuat masalah prediksi sosial jauh lebih sulit daripada masalah persepsi?

Masalah persepsi memiliki beberapa karakteristik. Satu, tidak ada ambiguitas tentang apakah ada kucing dalam sebuah gambar. Jadi Anda memiliki kebenaran dasar. Kedua, pada dasarnya Anda memiliki data pelatihan yang tidak terbatas karena Anda dapat menggunakan semua gambar di web. Dan jika Anda adalah Google atau Facebook, Anda dapat menggunakan semua gambar yang diunggah orang ke aplikasi Anda. Jadi kedua faktor itu — kurangnya ambiguitas dan ketersediaan data — memungkinkan pengklasifikasi bekerja dengan sangat baik.

Hal itu berbeda dengan soal prediksi yang tidak memiliki kedua karakteristik tersebut. Ada perbedaan ketiga yang harus saya sebutkan, yang dalam arti tertentu adalah yang paling penting: Konsekuensi moral dari menerapkan model prediksi ini sangat berbeda dengan menggunakan alat terjemahan bahasa di ponsel Anda, atau alat pelabelan gambar.

Tapi itu bukan keseriusan yang sama dengan alat yang digunakan untuk menentukan apakah seseorang harus, katakanlah, ditahan praperadilan. Itu memiliki konsekuensi bagi kebebasan orang. Jadi ironisnya, area di mana AI bekerja paling buruk, belum benar-benar membaik dari waktu ke waktu, dan tidak mungkin membaik di masa mendatang adalah area yang memiliki semua konsekuensi yang sangat penting ini.

Sebagian besar pekerjaan Anda mengharuskan berbicara dengan para ahli di luar bidang Anda. Bagaimana rasanya berkolaborasi dengan orang lain seperti ini?

Kolaborasi interdisipliner telah menjadi beberapa kolaborasi yang paling menyenangkan. Saya pikir kolaborasi semacam itu akan mengalami saat-saat yang membuat frustrasi karena orang tidak berbicara bahasa yang sama.

Resep saya untuk itu adalah: budaya, lalu bahasa, lalu substansi. Jika Anda tidak memahami budaya mereka — seperti beasiswa apa yang mereka hargai — itu akan sangat sulit. Apa yang berharga bagi satu orang mungkin tampak tidak relevan bagi orang lain. Jadi aspek budaya harus dinavigasi terlebih dahulu. Kemudian Anda dapat mulai membangun bahasa dan kosa kata yang sama dan akhirnya sampai pada substansi kolaborasi.

Seberapa optimis Anda tentang apakah kita dapat mengadopsi teknologi baru dengan aman dan bijak?

Sebagian dari masalahnya adalah kesenjangan pengetahuan. Pengambil keputusan, lembaga pemerintah, perusahaan, dan orang lain yang membeli alat AI ini mungkin tidak mengenali batasan serius untuk akurasi prediksi.

Tapi pada akhirnya saya pikir itu masalah politik. Beberapa orang ingin memangkas biaya, jadi mereka menginginkan alat otomatis, yang menghilangkan pekerjaan. Jadi ada tekanan yang sangat kuat untuk mempercayai apa pun yang dikatakan vendor ini tentang alat prediksi mereka.

Itu adalah dua masalah yang berbeda. Orang-orang seperti saya mungkin dapat membantu mengatasi kesenjangan informasi. Tetapi mengatasi masalah politik membutuhkan aktivisme. Ini mengharuskan kita untuk mengambil keuntungan dari proses demokrasi. Senang melihat ada banyak orang yang melakukan itu. Dan dalam jangka panjang, saya pikir kita dapat melawan aplikasi AI yang berbahaya dan kasar. Saya tidak berpikir itu akan berubah dalam sekejap tetapi melalui proses aktivisme yang panjang, berlarut-larut, dan berlarut-larut yang telah berlangsung selama satu dekade atau lebih. Saya yakin itu akan berlanjut untuk waktu yang lama.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- Platoblockchain. Intelijen Metaverse Web3. Pengetahuan Diperkuat. Akses Di Sini.

- Sumber: https://www.quantamagazine.org/he-protects-privacy-and-ai-fairness-with-statistics-20230310/

- :adalah

- ][P

- $ 1 juta

- $NAIK

- 2017

- a

- kemampuan

- Sanggup

- Tentang Kami

- tentang itu

- ABSTRAK

- mengakses

- akuntabilitas

- ketepatan

- dicapai

- ACM

- Tindakan

- Aktivisme

- sebenarnya

- alamat

- menangani

- mengambil

- uang muka

- Keuntungan

- terhadap

- lembaga

- badan

- AI

- algoritma

- Semua

- sudah

- selalu

- menakjubkan

- Kemenduaan

- antara

- dan

- Anonim

- Lain

- siapapun

- aplikasi

- Aplikasi

- aplikasi

- Mendaftar

- ADALAH

- DAERAH

- daerah

- ditangkap

- buatan

- kecerdasan buatan

- AS

- aspek

- At

- atribut

- Otomatis

- tersedianya

- tersedia

- hadiah

- kembali

- latar belakang

- BE

- karena

- menjadi

- Daging Sapi

- mulai

- makhluk

- Percaya

- Manfaat

- Lebih baik

- antara

- luas

- Browsing

- Pembelian

- by

- panggilan

- bernama

- CAN

- tidak bisa

- menangkap

- Lowongan Kerja

- hati-hati

- kasus

- kasus

- KUCING

- kategori

- Kategori

- kenamaan

- tertentu

- kesempatan

- perubahan

- karakteristik

- Catur

- diklaim

- kejelasan

- klasifikasi

- Jelas

- Berkolaborasi

- kolaborasi

- Kolaborasi

- mengumpulkan

- kombinasi

- bagaimana

- Umum

- Perusahaan

- kompetisi

- sama sekali

- kompleks

- kompromi

- komputer

- konsep

- prihatin

- membingungkan

- kebingungan

- koneksi

- Konsekuensi

- Konten

- konteks

- terus

- kontras

- kue

- Biaya

- bisa

- sepasang

- Kelas

- Kejahatan

- Pidana

- kriptografi

- kultural

- budaya

- terbaru

- Memotong

- memangkas biaya

- bahaya

- data

- titik data

- kumpulan data

- set data

- dasawarsa

- pengambil keputusan

- mendalam

- belajar mendalam

- didefinisikan

- demokratis

- layak

- tertahan

- Menentukan

- dikembangkan

- mata uang

- MELAKUKAN

- perbedaan

- berbeda

- masalah yang berbeda

- menemukan

- membedakan

- Anjing

- melakukan

- Dont

- Menjatuhkan

- Awal

- efektif

- upaya

- menghilangkan

- nikmat

- terutama

- dasarnya

- menetapkan

- membangun

- etis

- Bahkan

- akhirnya

- persis

- ahli

- menjelaskan

- ekstrak

- Menghadapi

- pengenalan wajah

- faktor

- GAGAL

- Gagal

- adil

- keadilan

- beberapa

- bidang

- pertarungan

- Akhirnya

- Menemukan

- Pertama

- terfokus

- mengikuti

- Untuk

- bentuk

- resmi

- ditemukan

- Kebebasan

- dari

- membuat frustrasi

- mendasar

- masa depan

- celah

- generasi

- mendapatkan

- mendapatkan

- Memberikan

- memberikan

- Go

- akan

- baik

- Pemerintah

- Tanah

- Kelompok

- membimbing

- tangan

- Kejadian

- Sulit

- berbahaya

- merugikan

- Memiliki

- memiliki

- kepala

- mendengar

- Hati

- membantu

- membantu

- sejarah

- Seterpercayaapakah Olymp Trade? Kesimpulan

- HTTPS

- besar

- i

- ide

- identifier

- identitas

- gambar

- gambar

- Dampak

- implikasi

- pentingnya

- penting

- mustahil

- memperbaiki

- ditingkatkan

- meningkatkan

- in

- Di lain

- tidak akurat

- termasuk

- luar biasa

- informasi

- Innovation

- contoh

- saat

- instrumental

- Intelijen

- niat

- tertarik

- Internasional

- Internet

- Wawancara

- terlibat

- isu

- IT

- NYA

- Diri

- Jobs

- perjalanan

- Anak

- anak

- Jenis

- Tahu

- pengetahuan

- dikenal

- pelabelan

- Kekurangan

- bahasa

- BELAJAR

- pengetahuan

- Dipimpin

- adalah ide yang bagus

- cahaya

- 'like'

- batas

- Daftar

- Panjang

- lama

- lagi

- Lot

- mesin

- Mesin belajar

- Mesin

- MEMBUAT

- banyak

- Marketing

- matematika

- matematis

- makna

- Memenuhi

- metode

- Metrik

- mungkin

- juta

- model

- Waktu

- lebih

- paling

- termotivasi

- Motivasi

- nasional

- keamanan nasional

- Alam

- perlu

- Perlu

- Netflix

- New

- jumlah

- of

- menawarkan

- Minyak

- on

- ONE

- Buka

- Optimis

- Lainnya

- Lainnya

- jika tidak

- Hasil

- di luar

- secara keseluruhan

- pihak

- lalu

- Konsultan Ahli

- orang

- persepsi

- Melakukan

- mungkin

- orang

- Sendiri

- perspektif

- telepon

- potongan-potongan

- Platform

- plato

- Kecerdasan Data Plato

- Data Plato

- masuk akal

- poin

- Polisi

- kebijaksanaan

- kebijakan

- politik

- positif

- potensi

- praktek

- tepat

- memprediksi

- ramalan

- resep

- tekanan

- terutama

- pribadi

- Masalah

- masalah

- proses

- program

- Kemajuan

- Rasakan itu

- disediakan

- publik

- Dorong

- menekan

- menempatkan

- Puting

- Puzzle

- Majalah kuantitas

- Pertanyaan

- acak

- cepat

- peringkat

- Reaksi

- dunia nyata

- menyadari

- mewujudkan

- alasan

- diterima

- baru

- pengakuan

- mengenali

- Rekomendasi

- dirilis

- tinggal

- Dihapus

- wajib

- membutuhkan

- penelitian

- peneliti

- peneliti

- ISTIRAHAT

- mengungkapkan

- Risiko

- Run

- aman

- sama

- skema

- Sekolah

- Ilmu

- ilmuwan

- Kedua

- keamanan

- melihat

- rasa

- peka

- serius

- set

- set

- harus

- Sederhana

- tunggal

- Keraguan

- ketrampilan

- So

- Sosial

- Memecahkan

- beberapa

- Seseorang

- mutakhir

- berbicara

- Secara khusus

- pidato

- Disponsori

- awal

- mulai

- Laporan

- Negara

- statistik

- Masih

- kekuatan

- kuat

- Belajar

- Belajar

- zat

- sukses

- seperti itu

- sistem

- sistem

- Mengambil

- Berbicara

- pembicaraan

- tugas

- tim

- Teknis

- Teknologi

- Teknologi

- istilah

- bahwa

- Grafik

- Daerah

- Masa depan

- informasi

- Dunia

- mereka

- Mereka

- teoretis

- dengan demikian

- Ini

- hal

- Pikir

- Ketiga

- Pihak ketiga

- sepenuhnya

- tiga

- Melalui

- waktu

- untuk

- bersama

- terlalu

- alat

- alat

- tema

- terhadap

- jalur

- Pelatihan

- lintasan

- Transformasi

- menterjemahkan

- Terjemahan

- Transparansi

- jelas

- mengobati

- Berbalik

- jenis

- Akhirnya

- payung

- bawah

- memahami

- unik

- universitas

- tak terbatas

- upload

- us

- menggunakan

- Pengguna

- Pengguna

- Berharga

- nilai

- vendor

- 'view'

- Cara..

- cara

- jaringan

- webp

- situs web

- minggu

- Selamat datang

- BAIK

- Apa

- Apa itu

- apakah

- yang

- sementara

- SIAPA

- siapapun

- Wikipedia

- akan

- dengan

- Kerja

- bekerja

- bekerja

- dunia

- akan

- Salah

- tahun

- tahun

- Kamu

- Anda

- Youtube

- zephyrnet.dll