ChatGPT の発売と生成 AI の人気の高まりは、このテクノロジーを使用して、より会話的なエンタープライズ チャットボットなどの新しい製品やサービスを AWS 上で作成する方法に興味を持つ顧客の想像力を魅了しました。 この投稿では、チャット スタジオと呼ばれる Web UI を作成して、会話を開始し、で利用可能な基盤モデルと対話する方法を説明します。 Amazon SageMaker ジャンプスタート Llama 2、Stable Diffusion、その他のモデルが利用可能です。 アマゾンセージメーカー。 このソリューションをデプロイすると、ユーザーはすぐに使い始めて、Web インターフェイスを通じて会話型 AI の複数の基盤モデルの機能を体験できます。

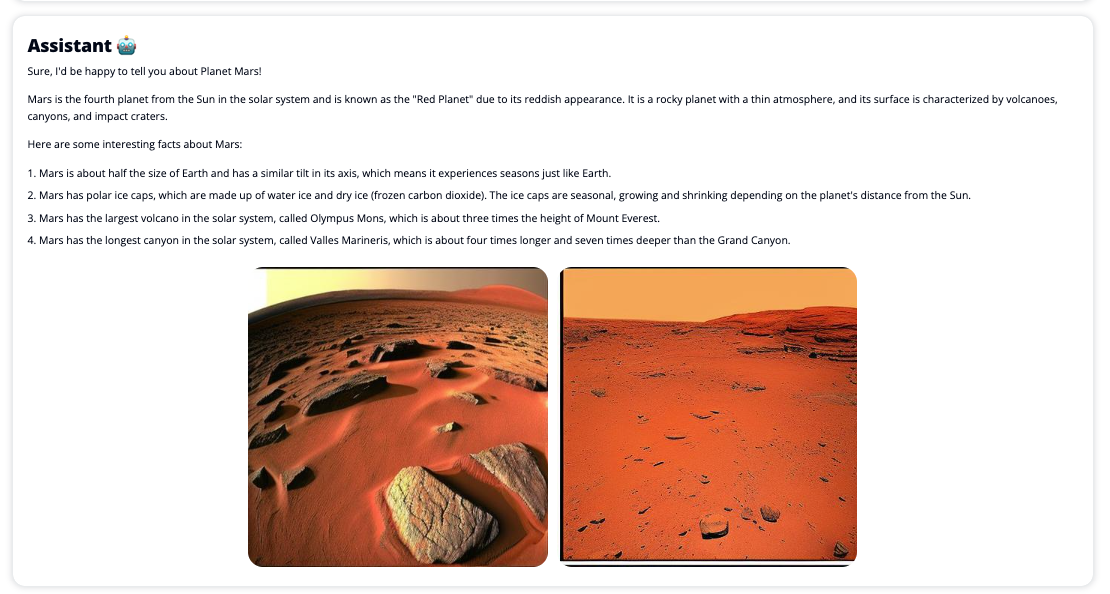

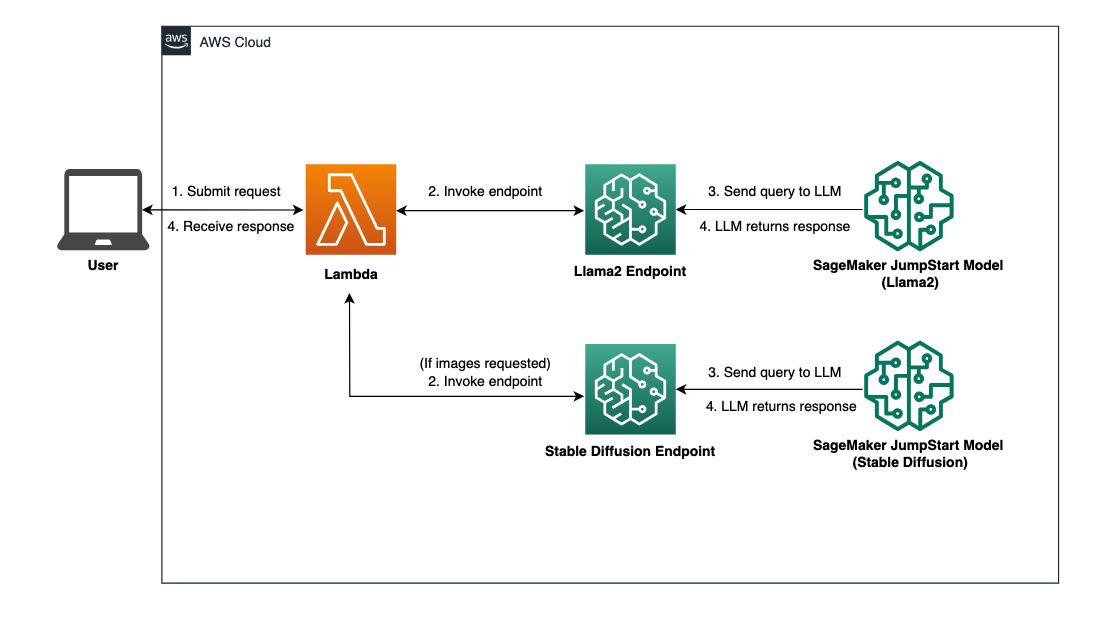

Chat Studio は、ユーザーがメディアの表示をリクエストした場合、オプションで安定拡散モデル エンドポイントを呼び出して、関連する画像とビデオのコラージュを返すこともできます。 この機能は、応答に付随する資産としてメディアを使用することで、ユーザー エクスペリエンスを向上させるのに役立ちます。 これは、目標を達成するために追加の統合によって Chat Studio を強化する方法の一例にすぎません。

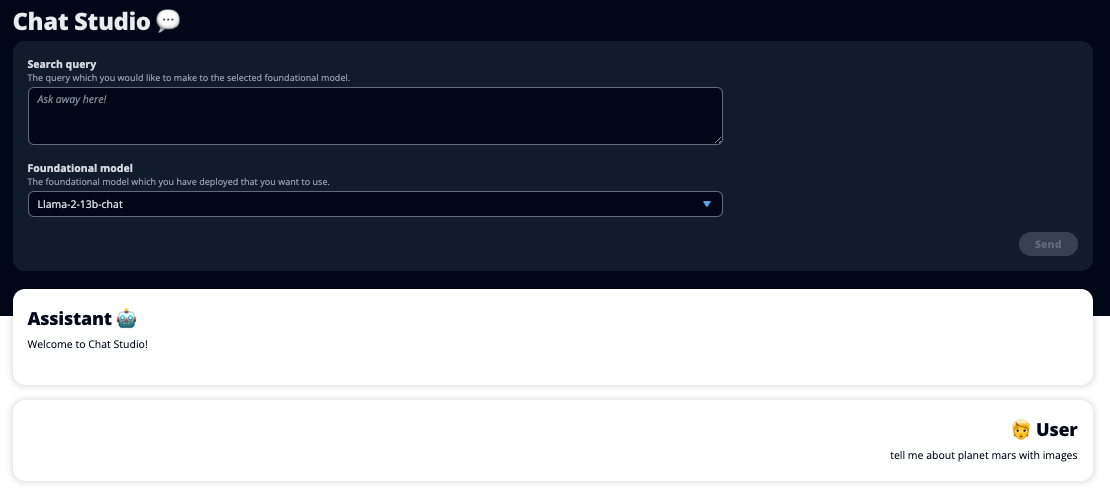

次のスクリーンショットは、ユーザーのクエリと応答がどのようなものかを示す例です。

大規模な言語モデル

ChatGPT などの生成 AI チャットボットは、大量のラベルのないテキストでトレーニングできる深層学習ニューラル ネットワークに基づく大規模言語モデル (LLM) を利用しています。 LLM を使用すると、実際の人間とのやり取りによく似た、より良い会話体験が可能になり、つながりの感覚が育まれ、ユーザーの満足度が向上します。

SageMaker 基盤モデル

2021 年、スタンフォード人間中心人工知能研究所は、一部の LLM を次のように呼びました。 基礎モデル。 基礎モデルは、大規模かつ広範な一般データのセットで事前トレーニングされており、デジタル アートの生成から多言語テキストの分類まで、幅広いユースケースでさらなる最適化のための基礎として機能することを目的としています。 新しいモデルをゼロからトレーニングするには時間がかかり、費用がかかる可能性があるため、これらの基礎モデルは顧客に人気があります。 SageMaker JumpStart は、サードパーティのオープンソースおよび独自のプロバイダーが維持する何百もの基盤モデルへのアクセスを提供します。

ソリューションの概要

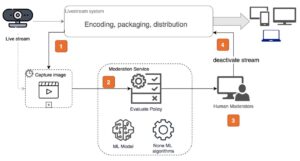

この投稿では、SageMaker を介して事前トレーニング済みおよびカスタム LLM をデプロイし、デプロイされたモデルとインターフェイスする Web UI を作成するためのローコード ワークフローについて説明します。 次の手順について説明します。

- SageMaker 基盤モデルをデプロイします。

- 配備します AWSラムダ および AWS IDおよびアクセス管理 (IAM) アクセス許可を使用する AWS CloudFormation.

- ユーザーインターフェイスを設定して実行します。

- 必要に応じて、他の SageMaker 基盤モデルを追加します。 このステップにより、Chat Studio の機能が拡張され、追加の基盤モデルと対話できるようになります。

- 必要に応じて、次を使用してアプリケーションをデプロイします。 AWS 増幅。 この手順では、Chat Studio を Web にデプロイします。

ソリューション アーキテクチャの概要については、次の図を参照してください。

前提条件

ソリューションをウォークスルーするには、次の前提条件が必要です。

- An AWSアカウント 十分な IAM ユーザー権限があること。

npmローカル環境にインストールされます。 インストール方法については、npm、 参照する Node.js と npm のダウンロードとインストール.- 対応する SageMaker エンドポイントのサービス クォータは 1。 Llama 2 13b Chat の場合は ml.g5.48xlarge インスタンスを使用し、Stable Diffusion 2.1 の場合は ml.p3.2xlarge インスタンスを使用します。

サービスクォータの増加をリクエストするには、 AWS サービスクォータコンソール、 案内する AWSサービス, セージメーカー、サービス クォータをエンドポイント使用量の ml.g1xlarge とエンドポイント使用量の ml.p5.48xlarge の値 3.2 に引き上げるよう要求します。

インスタンス タイプの可用性によっては、サービス クォータ リクエストが承認されるまでに数時間かかる場合があります。

SageMaker 基盤モデルをデプロイする

SageMaker は、開発者が ML モデルを迅速に構築し、簡単にトレーニングできるフルマネージドの機械学習 (ML) サービスです。 次の手順を実行して、Llama 2 13b Chat および Stable Diffusion 2.1 基盤モデルをデプロイします。 Amazon SageMakerスタジオ:

- SageMaker ドメインを作成します。 手順については、を参照してください。 クイックセットアップを使用して Amazon SageMaker ドメインにオンボードする.

ドメインはすべてのストレージをセットアップし、SageMaker にアクセスするユーザーを追加できるようにします。

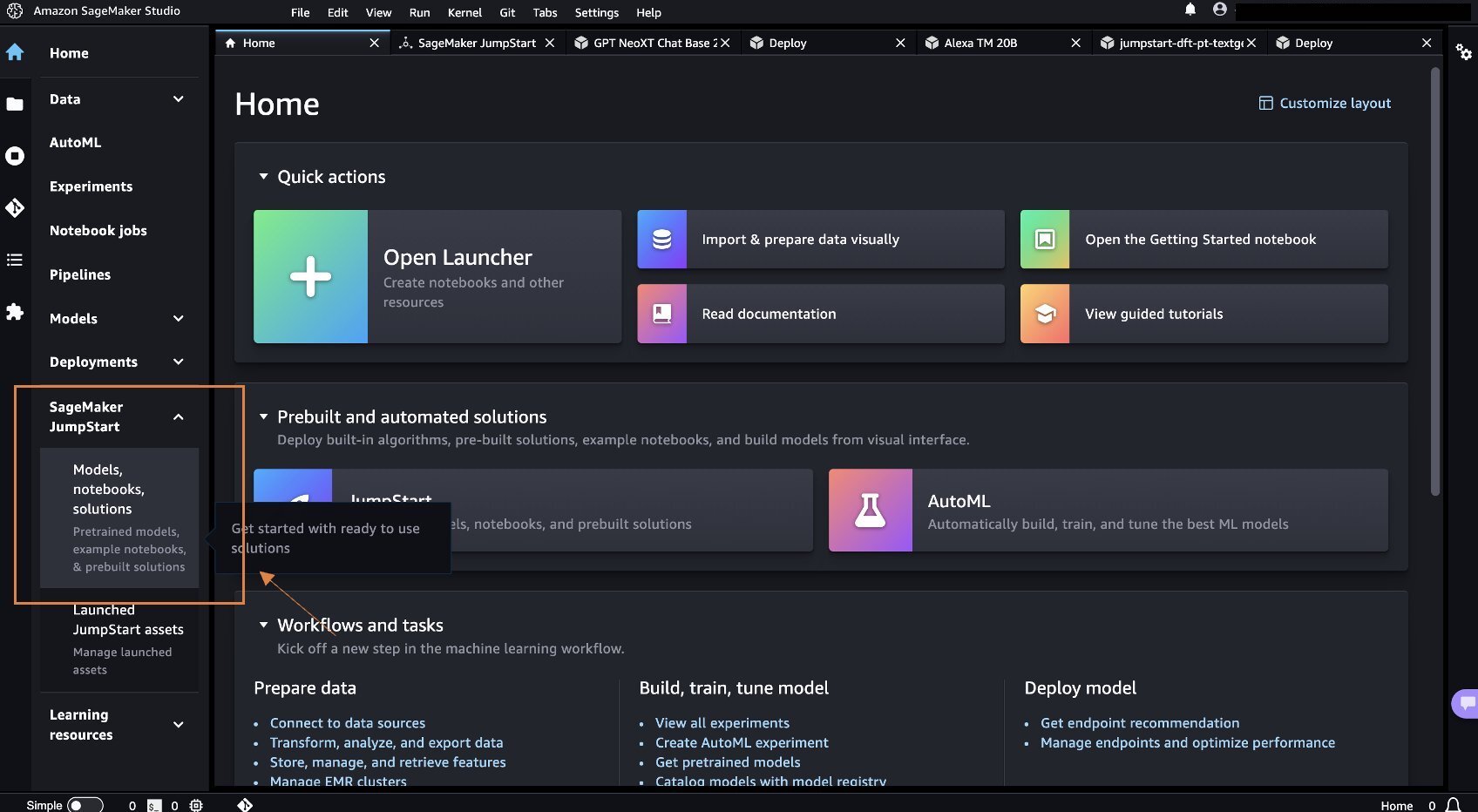

- SageMakerコンソールで、 Studio ナビゲーションペインで、を選択します オープンスタジオ.

- Studio を起動すると、 SageMaker ジャンプスタート ナビゲーション ペインで、 モデル、ノートブック、ソリューション.

- 検索バーで「Llama 2 13b Chat」を検索します。

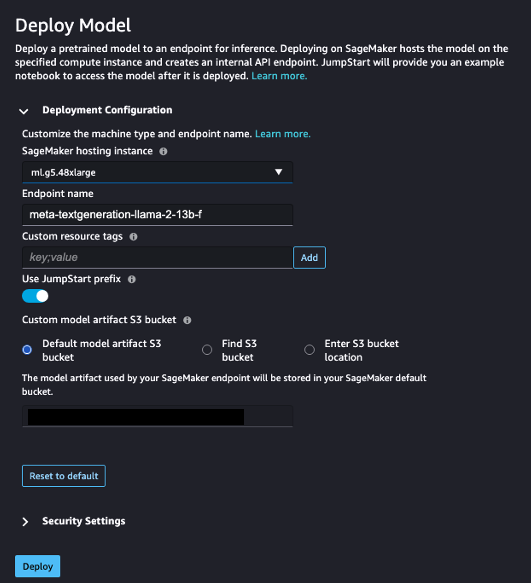

- 展開構成、用 SageMaker ホスティング インスタンス、選択する ml.g5.48xラージ とのために エンドポイント名、 入る

meta-textgeneration-llama-2-13b-f. - 選択する 展開します。

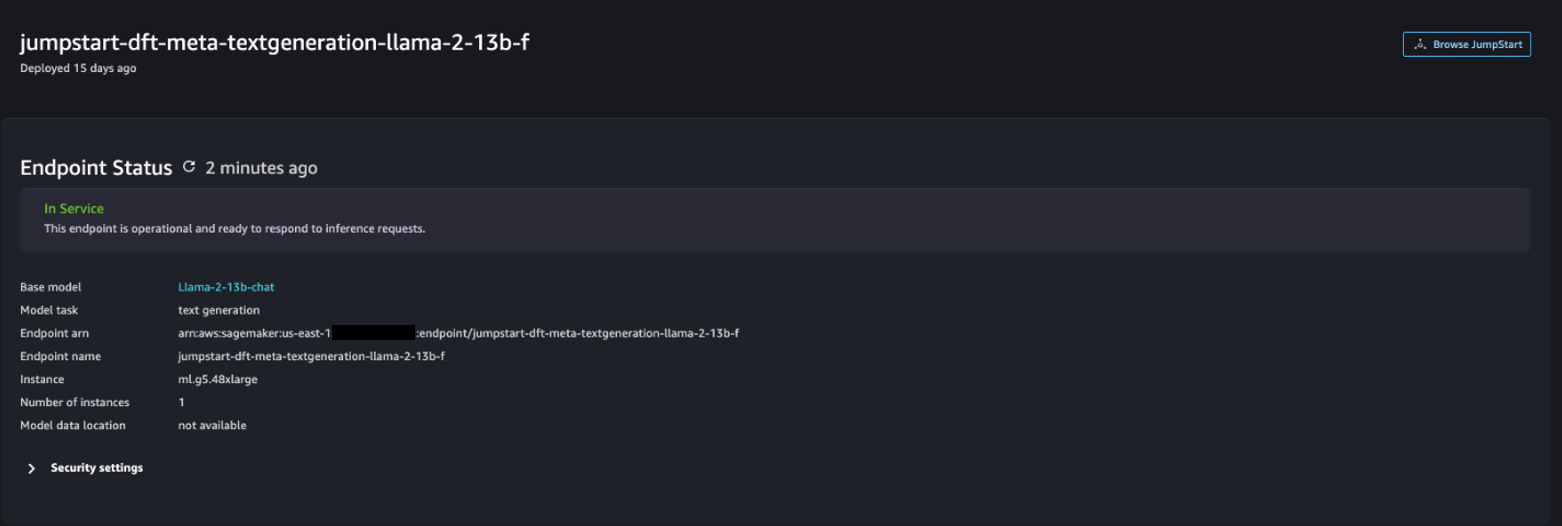

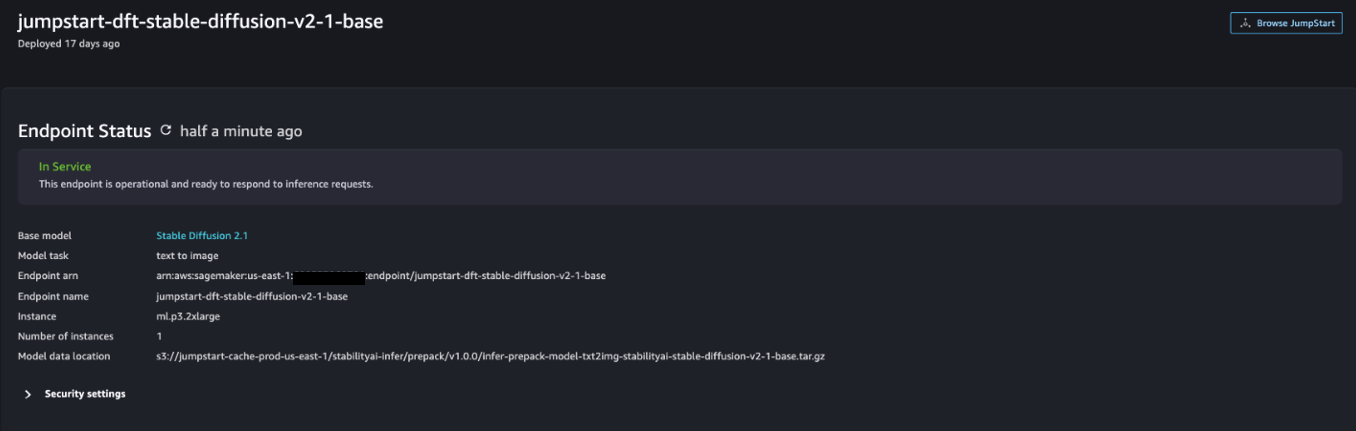

デプロイメントが成功すると、次のメッセージが表示されるはずです。 In Service 状態。

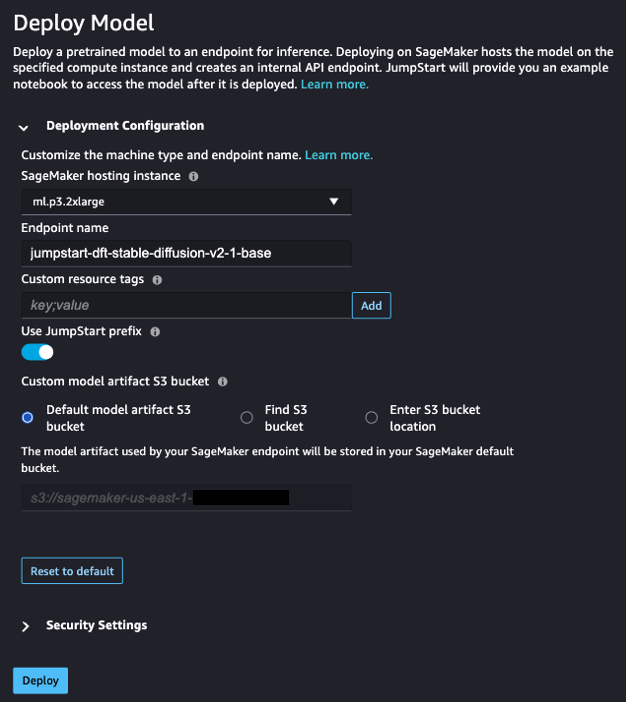

- ソフトウェア設定ページで、下図のように モデル、ノートブック、ソリューション ページで、Stable Diffusion 2.1 を検索します。

- 展開構成、用 SageMaker ホスティング インスタンス、選択する ml.p3.2xlarge とのために エンドポイント名、 入る

jumpstart-dft-stable-diffusion-v2-1-base. - 選択する 配備します.

デプロイメントが成功すると、次のメッセージが表示されるはずです。 In Service 状態。

AWS CloudFormation を使用して Lambda と IAM 権限をデプロイする

このセクションでは、ユーザーリクエストを処理し、デプロイした SageMaker エンドポイントを呼び出し、必要なすべての IAM 権限をデプロイする Lambda 関数をデプロイする CloudFormation スタックを起動する方法について説明します。 次の手順を実行します。

- に移動します GitHubリポジトリ CloudFormation テンプレートをダウンロードします (

lambda.cfn.yaml) をローカルマシンにコピーします。 - CloudFormation コンソールで、 スタックを作成 ドロップダウンメニューから選択 新しいリソースを使用(標準).

- ソフトウェア設定ページで、下図のように テンプレートを指定 テンプレートファイルをアップロードする および ファイルを選ぶ.

- 選択する

lambda.cfn.yamlダウンロードしたファイルを選択し、 Next. - ソフトウェア設定ページで、下図のように スタックの詳細を指定する ページで、スタック名と前提条件で取得した API キーを入力し、選択します Next.

- ソフトウェア設定ページで、下図のように スタックオプションを構成する ページ、選択 Next.

- 変更を確認して承認し、選択します 送信.

Web UIをセットアップする

このセクションでは、Web UI (次を使用して作成) を実行する手順について説明します。 Cloudscape デザイン システム) ローカルマシン上:

- IAM コンソールで、ユーザーに移動します。

functionUrl. - ソフトウェア設定ページで、下図のように セキュリティ資格情報 タブを選択 アクセスキーの作成.

- ソフトウェア設定ページで、下図のように 主要なベストプラクティスと代替案にアクセスする コマンドラインインタフェース(CLI) 選択して Next.

- ソフトウェア設定ページで、下図のように 説明タグを設定する ページ、選択 アクセスキーの作成.

- アクセスキーとシークレットアクセスキーをコピーします。

- 選択する クリックします.

- に移動します GitHubリポジトリ ダウンロードして

react-llm-chat-studioコード。 - 好みの IDE でフォルダーを起動し、ターミナルを開きます。

- MFAデバイスに移動する

src/configs/aws.json取得したアクセスキーとシークレットアクセスキーを入力します。 - ターミナルに次のコマンドを入力します。

- Open http://localhost:3000 ブラウザでモデルとの対話を開始してください。

Chat Studio を使用するには、ドロップダウン メニューで基本モデルを選択し、テキスト ボックスにクエリを入力します。 AI が生成した画像を応答とともに取得するには、クエリの最後に「画像あり」というフレーズを追加します。

他の SageMaker 基盤モデルを追加する

このソリューションの機能をさらに拡張して、追加の SageMaker 基盤モデルを含めることができます。 各モデルは SageMaker エンドポイントを呼び出すときに異なる入力および出力形式を想定しているため、モデルとインターフェースをとるために callSageMakerEndpoints Lambda 関数に変換コードを記述する必要があります。

このセクションでは、選択した追加モデルを実装するために必要な一般的な手順とコードの変更について説明します。 ステップ 6 ~ 8 では、Python 言語の基本的な知識が必要であることに注意してください。

- SageMaker Studio で、選択した SageMaker 基盤モデルをデプロイします。

- 選択する SageMaker ジャンプスタート および JumpStart アセットを起動する.

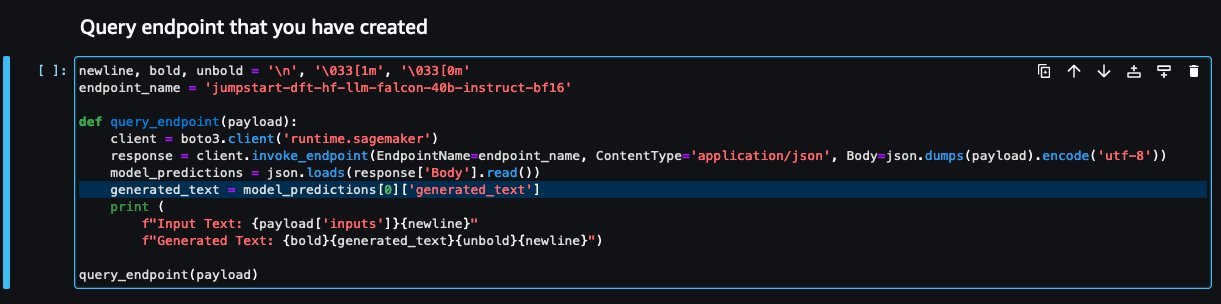

- 新しくデプロイされたモデルのエンドポイントを選択し、 ノートブックを開く.

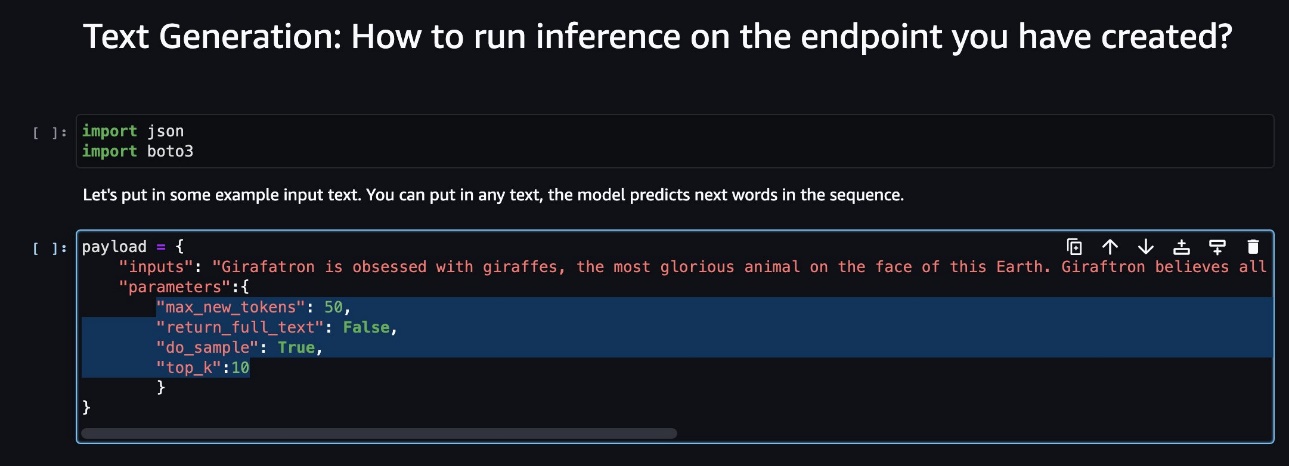

- ノートブック コンソールで、ペイロード パラメーターを見つけます。

これらは、新しいモデルが SageMaker エンドポイントを呼び出すときに予期するフィールドです。 次のスクリーンショットは例を示しています。

- Lambda コンソールで、次の場所に移動します。

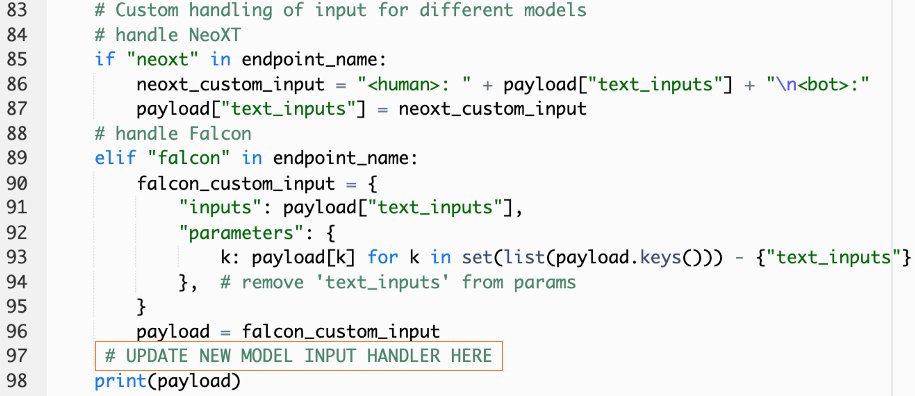

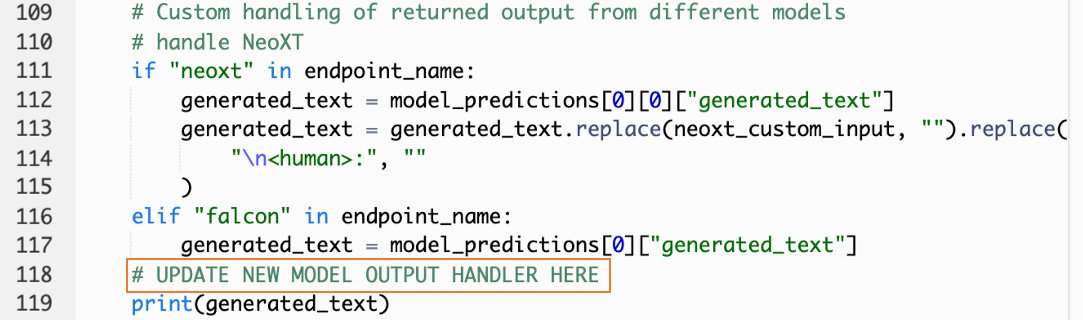

callSageMakerEndpoints. - 新しいモデルにカスタム入力ハンドラーを追加します。

次のスクリーンショットでは、Falcon 40B Instruct BF16 と GPT NeoXT Chat Base 20B FP16 の入力を変換しました。 指示に従ってカスタム パラメーター ロジックを挿入し、コピーしたペイロード パラメーターを参照して入力変換ロジックを追加できます。

- ノートブックのコンソールに戻り、

query_endpoint.

この関数は、モデルの出力を変換して最終的なテキスト応答を抽出する方法を示します。

- のコードを参照すると、

query_endpoint、新しいモデルのカスタム出力ハンドラーを追加します。

- 選択する 展開します。

- IDE を開き、

react-llm-chat-studioコードを入力して、次の場所に移動しますsrc/configs/models.json. - モデル名とモデル エンドポイントを追加し、ステップ 4 のペイロード パラメーターを入力します。

payload次の形式を使用します。 - ブラウザを更新して、新しいモデルとの対話を開始してください。

Amplify を使用してアプリケーションをデプロイする

Amplify は、アプリケーションを迅速かつ効率的にデプロイできる完全なソリューションです。 このセクションでは、Chat Studio を アマゾンCloudFrontの アプリケーションを他のユーザーと共有したい場合は、Amplify を使用して配布します。

- に移動します

react-llm-chat-studio先ほど作成した code フォルダー。 - ターミナルに次のコマンドを入力し、セットアップ手順に従います。

- 次のコマンドを使用して、新しい Amplify プロジェクトを初期化します。 プロジェクト名を入力し、デフォルトの構成を受け入れ、選択します AWS アクセスキー 認証方法の選択を求められた場合。

- 次のコマンドを使用して、Amplify プロジェクトをホストします。 選ぶ Amazon CloudFront と S3 プラグイン モードを選択するよう求められたら。

- 最後に、次のコマンドを使用してプロジェクトをビルドしてデプロイします。

- デプロイが成功したら、ブラウザーで指定された URL を開いて、モデルとの対話を開始します。

クリーンアップ

今後の請求を回避するには、次の手順を実行します。

- CloudFormation スタックを削除します。 手順については、を参照してください。 AWSCloudFormationコンソールでスタックを削除する.

- SageMaker JumpStart エンドポイントを削除します。 手順については、を参照してください。 エンドポイントとリソースの削除.

- SageMaker ドメインを削除します。 手順については、を参照してください。 AmazonSageMakerドメインを削除します.

まとめ

この投稿では、AWS にデプロイされた LLM とインターフェースするための Web UI を作成する方法を説明しました。

このソリューションを使用すると、LLM と対話し、ユーザーフレンドリーな方法で会話を行って、テストしたり、LLM に質問したり、必要に応じて画像やビデオのコラージュを取得したりできます。

このソリューションは、追加の基礎モデルを統合するなど、さまざまな方法で拡張できます。 Amazon Kendra との統合 エンタープライズ コンテンツなどを理解するための ML を利用したインテリジェントな検索を可能にします。

ぜひ実験してみてください AWS で利用可能なさまざまな事前トレーニング済み LLM、または SageMaker で独自の LLM を構築したり、独自の LLM を作成したりできます。 コメントで質問や発見をお知らせください。楽しんでください。

著者について

ジャレット・ヨー・シャンウェイ は、ASEAN 全体の公共部門をカバーする AWS プロフェッショナル サービスのアソシエイト クラウド アーキテクトであり、顧客の最新化とクラウドへの移行を支援する提唱者です。 彼は 8 つの AWS 認定を取得しており、第 XNUMX 回 AI 国際会議で勾配ブースティング マシン アンサンブルに関する研究論文も発表しました。 ジャレットは自由時間には AWS の生成 AI シーンに焦点を当て、貢献しています。

ジャレット・ヨー・シャンウェイ は、ASEAN 全体の公共部門をカバーする AWS プロフェッショナル サービスのアソシエイト クラウド アーキテクトであり、顧客の最新化とクラウドへの移行を支援する提唱者です。 彼は 8 つの AWS 認定を取得しており、第 XNUMX 回 AI 国際会議で勾配ブースティング マシン アンサンブルに関する研究論文も発表しました。 ジャレットは自由時間には AWS の生成 AI シーンに焦点を当て、貢献しています。

タミー・リム・リー・シン AWS のアソシエイト クラウド アーキテクトです。 彼女はテクノロジーを使用して、顧客がクラウド導入の過程で望ましい結果を実現できるよう支援しており、AI/ML に情熱を注いでいます。 仕事以外では、旅行、ハイキング、家族や友人と時間を過ごすことが大好きです。

タミー・リム・リー・シン AWS のアソシエイト クラウド アーキテクトです。 彼女はテクノロジーを使用して、顧客がクラウド導入の過程で望ましい結果を実現できるよう支援しており、AI/ML に情熱を注いでいます。 仕事以外では、旅行、ハイキング、家族や友人と時間を過ごすことが大好きです。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://aws.amazon.com/blogs/machine-learning/create-a-web-ui-to-interact-with-llms-using-amazon-sagemaker-jumpstart/

- :持っている

- :は

- $UP

- 1

- 10

- 120

- 160

- 2021

- 3000

- 320

- 7

- 8

- 8

- a

- できる

- 私たちについて

- 同意

- アクセス

- 認める

- 越えて

- 加えます

- NEW

- 養子縁組

- 支持者

- 後

- AI

- AI / ML

- すべて

- ことができます

- 沿って

- また

- Amazon

- アマゾンセージメーカー

- Amazon SageMaker ジャンプスタート

- Amazon Webサービス

- 増幅する

- an

- および

- API

- 申し込み

- 承認された

- 建築

- です

- 宝品

- 人工の

- 人工知能

- AS

- アセアン

- 頼む

- 資産

- 仲間

- At

- 達成

- 認証

- 賃貸条件の詳細・契約費用のお見積り等について

- 利用できます

- 避ける

- AWS

- AWS CloudFormation

- AWSプロフェッショナルサービス

- バー

- ベース

- ベース

- 基本

- BE

- なぜなら

- BEST

- ベストプラクティス

- より良いです

- 後押し

- ボックス

- 広い

- ブラウザ

- ビルド

- by

- コール

- コール

- 缶

- 取得することができます

- 機能

- 機能

- 捕捉した

- 例

- 認定

- 変更

- 課金

- チャットボット

- AI言語モデルを活用してコードのデバッグからデータの異常検出まで、

- 選択

- 選択する

- 分類

- 密接に

- クラウド

- クラウドの採用

- コード

- 注釈

- コンプリート

- 講演

- 接続

- 領事

- コンテンツ

- 貢献する

- 会話

- 会話

- 会話型AI

- 対応する

- カバー

- カバーする

- 作ります

- 作成した

- 作成

- 興味深い

- カスタム

- Customers

- データ

- 深いです

- 深い学習

- デフォルト

- 配信する

- によっては

- 展開します

- 展開

- 展開する

- 展開

- 配備する

- 説明

- 設計

- 希望

- 細部

- 開発者

- 異なります

- デジタル

- デジタルアート

- 表示される

- ディストリビューション

- ドメイン

- ダウンロード

- 前

- 緩和する

- 効率良く

- enable

- end

- エンドポイント

- 高めます

- 豊かにする

- 入力します

- Enterprise

- 環境

- さらに

- あらゆる

- 例

- 例

- 期待する

- 高価な

- 体験

- 実験

- 説明

- 伸ばす

- 拡張する

- エキス

- 家族

- 特徴

- 少数の

- フィールズ

- File

- ファイナル

- もう完成させ、ワークスペースに掲示しましたか?

- 調査結果

- 五

- 焦点を当てて

- フォロー中

- 形式でアーカイブしたプロジェクトを保存します.

- 助長

- Foundation

- 基礎的な

- 無料版

- 友達

- から

- 完全に

- function

- さらに

- 未来

- 一般的なデータ

- 生成

- 生々しい

- 生成AI

- 取得する

- 与える

- 目標

- 持ってる

- he

- 助けます

- 助け

- 彼の

- ホスティング

- HOURS

- 認定条件

- How To

- HTML

- HTTP

- HTTPS

- 人間

- 何百

- アイデア

- アイデンティティ

- if

- 画像

- 想像力

- 実装する

- 改善されました

- in

- include

- 増える

- 示された

- install

- インストール

- インストールする

- 機関

- 説明書

- 統合する

- 統合

- インテリジェンス

- インテリジェント-

- 対話

- 相互作用

- 相互作用

- インタフェース

- 世界全体

- に

- 招待

- ITS

- 旅

- JPG

- ただ

- 一つだけ

- キー

- 知っている

- 知識

- 言語

- 大

- 起動する

- 発射

- 学習

- リー

- う

- ような

- LINE

- ラマ

- LLM

- ローカル

- ロジック

- 見て

- のように見える

- で

- 機械

- 機械学習

- マネージド

- 方法

- 五月..

- 意味した

- メディア

- 大会

- メニュー

- 方法

- 移動します

- ML

- モード

- モデル

- 近代化します

- 他には?

- の試合に

- しなければなりません

- 名

- ナビゲート

- ナビゲーション

- 必要

- 必要

- ネットワーク

- ニューラル

- ニューラルネットワーク

- 新作

- 新製品

- 新しく

- Node.js

- 注意

- ノート

- 得

- of

- on

- ONE

- 開いた

- オープンソース

- オプション

- or

- その他

- 成果

- 出力

- 外側

- 概要

- 自分の

- ページ

- ペイン

- 紙素材

- パラメーター

- パラメータ

- 情熱的な

- パーミッション

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- プラグイン

- 人気

- 人気

- ポスト

- パワード

- プラクティス

- 優先

- 前提条件

- 特権

- ラボレーション

- 製品

- プロ

- プロジェクト

- 所有権

- 提供します

- 提供

- プロバイダ

- は、大阪で

- 公共

- 公表

- Python

- 質問

- クイック

- すぐに

- 上げる

- 範囲

- リアル

- 参照する

- 参照

- 関連した

- 要求

- リクエスト

- の提出が必要です

- 研究

- 似てる

- リソース

- 応答

- return

- 上昇

- ラン

- セージメーカー

- 満足

- シーン

- スクラッチ

- スクリーンショット

- を検索

- 秘密

- セクション

- セクター

- select

- センス

- 役立つ

- サービス

- サービス

- セッションに

- セット

- シェアする

- 彼女

- すべき

- 表示する

- 作品

- スニペット

- 溶液

- 一部

- ソース

- 支出

- 安定した

- スタック

- 標準

- スタンフォード

- start

- 開始

- Status:

- 手順

- ステップ

- ストレージ利用料

- 研究

- そのような

- 十分な

- 取る

- 取り

- テクノロジー

- template

- ターミナル

- test

- 클라우드 기반 AI/ML및 고성능 컴퓨팅을 통한 디지털 트윈의 기초 – Edward Hsu, Rescale CPO 많은 엔지니어링 중심 기업에게 클라우드는 R&D디지털 전환의 첫 단계일 뿐입니다. 클라우드 자원을 활용해 엔지니어링 팀의 제약을 해결하는 단계를 넘어, 시뮬레이션 운영을 통합하고 최적화하며, 궁극적으로는 모델 기반의 협업과 의사 결정을 지원하여 신제품을 결정할 때 데이터 기반 엔지니어링을 적용하고자 합니다. Rescale은 이러한 혁신을 돕기 위해 컴퓨팅 추천 엔진, 통합 데이터 패브릭, 메타데이터 관리 등을 개발하고 있습니다. 이번 자리를 빌려 비즈니스 경쟁력 제고를 위한 디지털 트윈 및 디지털 스레드 전략 개발 방법에 대한 인사이트를 나누고자 합니다.

- テキスト分類

- それ

- アプリ環境に合わせて

- その後

- ボーマン

- 彼ら

- サードパーティ

- この

- しかし?

- 介して

- 時間

- 〜へ

- top

- トレーニング

- 訓練された

- トレーニング

- 最適化の適用

- 変換

- 変換

- type

- ui

- 下

- 理解する

- URL

- us

- 使用法

- つかいます

- ユーザー

- 操作方法

- ユーザーインターフェース

- 「DeckleBenchは非常に使いやすく最適なソリューションを簡単に見つけることができるため、稼働率が向上しコストも削減した。当社の旧システムは良かったが改善は期待していなかった。

- users

- 使用されます

- 値

- さまざまな

- 動画

- 歩く

- walks

- 方法

- we

- ウェブ

- Webサービス

- この試験は

- いつ

- which

- 誰

- ワイド

- 広い範囲

- 意志

- 希望

- 仕事

- ワークフロー

- 書きます

- ヨ

- You

- あなたの

- ゼファーネット