金融サービス (FinServ) 業界には、ドメイン固有のデータ、データ セキュリティ、規制管理、業界のコンプライアンス標準に関連する独自の生成 AI 要件があります。 さらに、顧客は、最もパフォーマンスが高くコスト効率の高い機械学習 (ML) モデルを選択する選択肢と、ビジネス ユース ケースに合わせて必要なカスタマイズ (微調整) を実行する機能を求めています。 Amazon SageMaker ジャンプスタート は、必要なデータ セキュリティ制御を提供し、コンプライアンス標準要件を満たしているため、FinServ 顧客の生成 AI ユースケースに最適です。

この投稿では、単純な金融ドメインのユースケースを使用して、SageMaker JumpStart の大規模言語モデル (LLM) を使用した検索拡張生成 (RAG) ベースのアプローチを使用した質問応答タスクを示します。 RAG は、LLM と情報検索 (IR) システムを組み合わせることにより、テキスト生成の品質を向上させるためのフレームワークです。 LLM がテキストを生成し、IR システムが知識ベースから関連情報を取得します。 取得された情報は、LLM の入力を補強するために使用されます。これは、モデルが生成したテキストの精度と関連性を向上させるのに役立ちます。 RAG は、質問応答や要約など、さまざまなテキスト生成タスクに効果的であることがわかっています。 これは、テキスト生成モデルの品質と精度を向上させるための有望なアプローチです。

SageMaker JumpStart を使用する利点

SageMaker JumpStart を使用すると、ML 実践者は、コンテンツ作成、画像生成、コード生成、質問応答、コピーライティング、要約、分類、情報検索などのユースケースに合わせた最先端のモデルを幅広い選択肢から選択できます。 ML 実践者は基礎モデルを専用のモデルにデプロイできます。 アマゾンセージメーカー ネットワーク分離環境からインスタンスを抽出し、モデルのトレーニングとデプロイメントに SageMaker を使用してモデルをカスタマイズします。

SageMaker JumpStart は以下を提供するため、FinServ 顧客の生成 AI ユースケースに最適です。

- カスタマイズ機能 – SageMaker JumpStart は、基礎モデルのドメイン適応に関するステップバイステップのガイダンスのためのサンプル ノートブックと詳細な投稿を提供します。 これらのリソースに従って、基礎モデルの微調整、ドメイン適応、指示を行ったり、RAG ベースのアプリケーションを構築したりできます。

- データセキュリティ – 推論ペイロード データのセキュリティを確保することが最も重要です。 SageMaker JumpStart を使用すると、シングル テナンシーのエンドポイント プロビジョニングを使用して、ネットワークを分離してモデルをデプロイできます。 さらに、プライベート モデル ハブ機能を通じて、個別のセキュリティ要件に合わせて、選択したモデルへのアクセス制御を管理できます。

- 規制管理とコンプライアンス – HIPAA BAA、SOC123、PCI、HITRUST CSF などの標準への準拠は SageMaker の中核機能であり、金融セクターの厳格な規制状況との整合性を確保します。

- モデルの選択 – SageMaker JumpStart は、業界で認められた HELM ベンチマークで常にトップにランクされる最先端の ML モデルのセレクションを提供します。 これらには、Llama 2、Falcon 40B、AI21 J2 Ultra、AI21 Summarize、Hugging Face MiniLM、および BGE モデルが含まれますが、これらに限定されません。

この投稿では、Llama 2 基盤モデルと ハグフェイス GPTJ-6B-FP16 埋め込みモデル。どちらも SageMaker JumpStart で利用できます。 私たちも使っています ベクトルエンジン for Amazon OpenSearch サーバーレス (現在プレビュー中) 埋め込みを保存するベクター データ ストアとして。

大規模な言語モデルの制限

LLM は膨大な量の非構造化データについてトレーニングを受けており、一般的なテキスト生成に優れています。 このトレーニングを通じて、LLM は事実の知識を取得し、蓄積します。 ただし、既製の LLM には次のような制限があります。

- 彼らはオフラインでトレーニングしているため、最新の情報を知ることができません。

- 主に一般化されたデータに関するトレーニングでは、ドメイン固有のタスクにおける効率が低下します。 たとえば、金融会社は、Q&A ボットが最新の内部文書から回答を取得し、正確さとビジネス ルールへの準拠を確保することを好む場合があります。

- 埋め込まれた情報に依存すると、解釈可能性が損なわれます。

LLM で特定のデータを使用するには、次の XNUMX つの一般的な方法があります。

- モデル プロンプト内にデータを埋め込むと、出力生成中にこのコンテキストを利用できるようになります。 これは、ゼロショット (例なし)、少数ショット (限られた例)、または多ショット (豊富な例) のいずれかになります。 このような状況に応じたプロンプトは、モデルをより微妙な結果に向けて導きます。

- プロンプトと補完のペアを使用してモデルを微調整します。

- RAG は、外部データ (ノンパラメトリック) を取得し、このデータをプロンプトに統合して、コンテキストを強化します。

ただし、最初の方法はコンテキスト サイズに関するモデルの制約に対処するため、長いドキュメントの入力が困難になり、コストが増加する可能性があります。 微調整アプローチは強力ではありますが、特に進化し続ける外部データの場合、リソースを大量に消費するため、展開の遅れやコストの増加につながります。 RAG と LLM を組み合わせることで、前述の制限に対する解決策が提供されます。

検索拡張生成

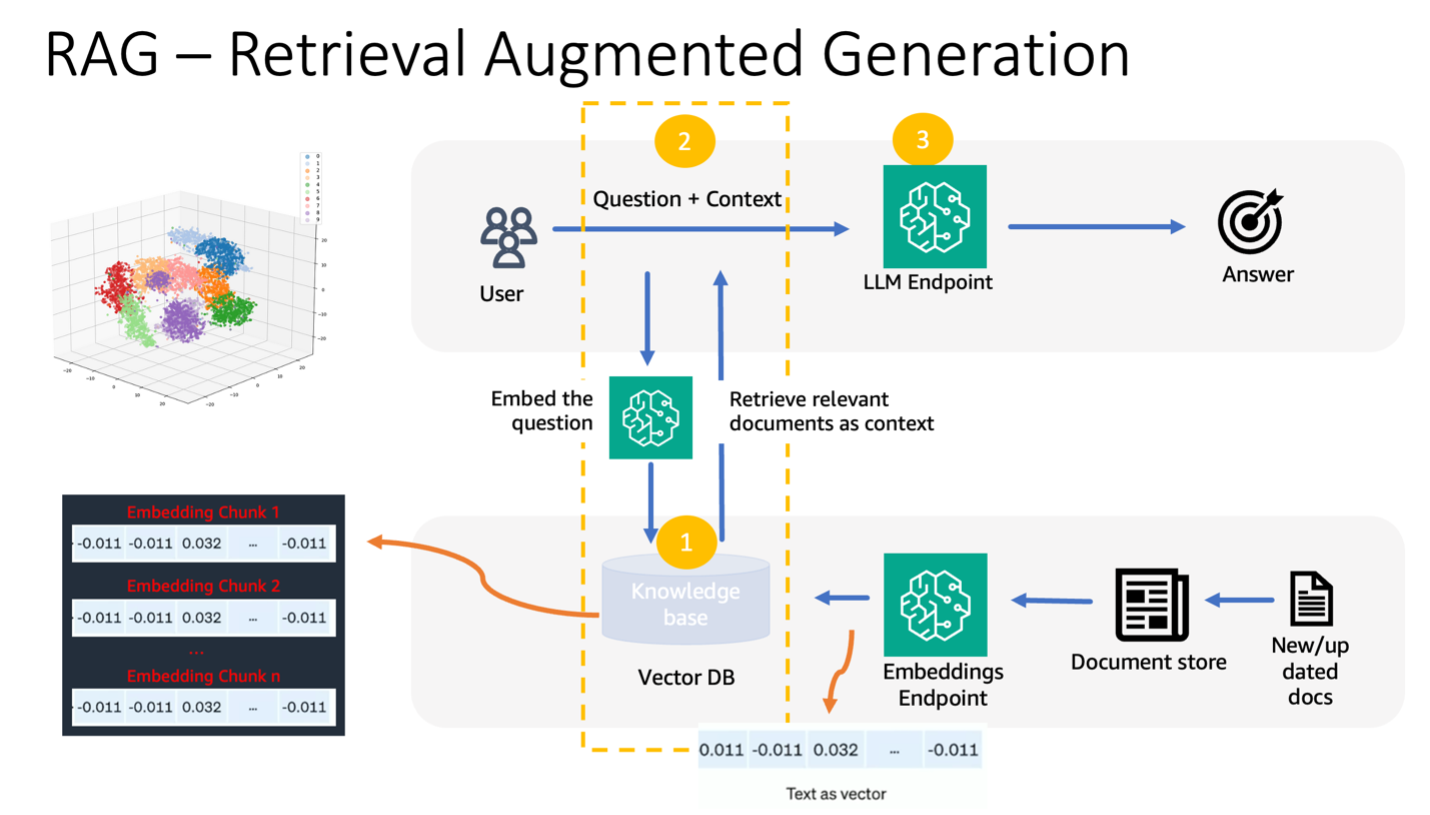

RAG は外部データ (ノンパラメトリック) を取得し、このデータを ML プロンプトに統合して、コンテキストを強化します。 ルイスら。 は 2020 年に RAG モデルを導入し、事前トレーニングされたシーケンス間モデル (パラメトリック メモリ) とニューラル リトリーバーを介してアクセスされる Wikipedia の高密度ベクトル インデックス (ノンパラメトリック メモリ) の融合として概念化しました。

RAG の動作方法は次のとおりです。

- データソース – RAG は、ドキュメント リポジトリ、データベース、API などのさまざまなデータ ソースから取得できます。

- データのフォーマット – ユーザーのクエリとドキュメントの両方が、関連性の比較に適した形式に変換されます。

- 埋め込み – この比較を容易にするために、クエリとドキュメント コレクション (またはナレッジ ライブラリ) は、言語モデルを使用して数値埋め込みに変換されます。 これらの埋め込みは、テキストの概念を数値的にカプセル化します。

- 関連性検索 – ユーザー クエリの埋め込みがドキュメント コレクションの埋め込みと比較され、埋め込み空間での類似性検索を通じて関連テキストが特定されます。

- コンテキストの強化 – 識別された関連テキストがユーザーの元のプロンプトに追加されるため、そのコンテキストが強化されます。

- LLM処理 – 強化されたコンテキストを使用して、プロンプトが LLM に供給され、関連する外部データが含まれるため、関連性のある正確な出力が生成されます。

- 非同期更新 – 参照ドキュメントを最新の状態に保つために、埋め込み表現とともに参照ドキュメントを非同期的に更新できます。 これにより、将来のモデル応答が最新の情報に基づいて作成され、精度が保証されます。

基本的に、RAG は LLM にリアルタイムの関連情報を注入する動的な方法を提供し、正確かつタイムリーな出力の生成を保証します。

次の図は、LLM で RAG を使用する概念的なフローを示しています。

ソリューションの概要

金融サービス アプリケーション用のコンテキストに応じた質問応答チャットボットを作成するには、次の手順が必要です。

- SageMaker JumpStart GPT-J-6B 埋め込みモデルを使用して、 Amazon シンプル ストレージ サービス (Amazon S3) アップロードディレクトリ。

- 次の手順を使用して、関連するドキュメントを特定します。

- 同じモデルを使用してユーザーのクエリの埋め込みを生成します。

- OpenSearch Serverless とベクトル エンジン機能を使用して、埋め込みスペース内で最も関連性の高い上位 K 個のドキュメント インデックスを検索します。

- 識別されたインデックスを使用して、対応するドキュメントを取得します。

- 取得したドキュメントをコンテキストとしてユーザーのプロンプトや質問と組み合わせます。 これを SageMaker LLM に転送して応答を生成します。

このプロセスを調整するために、人気のあるフレームワークである LangChain を採用しています。 LangChain は、LLM を利用したアプリケーションを強化するように特別に設計されており、さまざまな LLM にユニバーサル インターフェイスを提供します。 複数の LLM の統合を合理化し、呼び出し間のシームレスな状態の永続性を確保します。 さらに、カスタマイズ可能なプロンプト テンプレート、包括的なアプリケーション構築エージェント、検索と取得に特化したインデックスなどの機能により、開発者の効率が向上します。 より深く理解するには、を参照してください。 ラングチェーンのドキュメント.

前提条件

コンテキスト認識型チャットボットを構築するには、次の前提条件が必要です。

OpenSearch サーバーレス ベクトル エンジンのセットアップ方法については、以下を参照してください。 Amazon OpenSearch サーバーレス用のベクター エンジンの紹介、現在プレビュー中.

次のソリューションの包括的なチュートリアルについては、 GitHubレポ を参照してください Jupyterノートブック。

SageMaker JumpStart を使用して ML モデルをデプロイする

ML モデルをデプロイするには、次の手順を実行します。

- SageMaker JumpStart から Llama 2 LLM をデプロイします。

- GPT-J 埋め込みモデルをデプロイします。

データをチャンク化してドキュメント埋め込みオブジェクトを作成する

このセクションでは、データを小さなドキュメントに分割します。 チャンク化は、大きなテキストを小さなチャンクに分割する技術です。 これは、RAG モデルに対する検索クエリの関連性を最適化し、チャットボットの品質を向上させるため、重要なステップです。 チャンク サイズは、ドキュメントの種類や使用されるモデルなどの要因によって異なります。 これが段落のおおよそのサイズであるため、チャンク chunk_size=1600 が選択されています。 モデルが改良されると、コンテキスト ウィンドウのサイズが増加し、より大きなチャンク サイズが可能になります。

Job Status ページの下部にある Jupyter Notebook 完全なソリューションについては、GitHub リポジトリを参照してください。

- ラングチェーンを拡張する

SageMakerEndpointEmbeddingsクラスを使用して、(埋め込みモデルの採用の一部として) 前に作成した gpt-j-6b-fp16 SageMaker エンドポイントを使用するカスタム埋め込み関数を作成します。 - embeddings オブジェクトを作成し、ドキュメントの埋め込みの作成をバッチ処理します。

- これらの埋め込みは、LangChain を使用してベクトル エンジンに保存されます。

OpenSearchVectorSearch。 これらの埋め込みは次のセクションで保存します。 OpenSearch Serverless に埋め込まれたドキュメントを保存します。 これで、チャンク化されたドキュメントを反復処理し、埋め込みを作成し、これらの埋め込みをベクトル検索コレクション内に作成された OpenSearch サーバーレス ベクトル インデックスに保存する準備が整いました。 次のコードを参照してください。

書類上の質疑応答

ここまでは、大きなドキュメントを小さなドキュメントに分割し、ベクトル埋め込みを作成して、ベクトル エンジンに保存しました。 この文書データに関する質問に回答できるようになります。 データに対してインデックスを作成したため、セマンティック検索を実行できます。 このようにして、質問に答えるために必要な最も関連性の高い文書のみが、プロンプトを介して LLM に渡されます。 これにより、関連するドキュメントのみを LLM に渡すだけで時間と費用を節約できます。 ドキュメント チェーンの使用方法の詳細については、次を参照してください。 資料.

ドキュメントを使用して質問に答えるには、次の手順を実行します。

- LangChain で SageMaker LLM エンドポイントを使用するには、次を使用します。

langchain.llms.sagemaker_endpoint.SagemakerEndpoint、SageMaker LLM エンドポイントを抽象化します。 LangChain SageMaker 統合の次のコードに示すように、リクエストとレスポンスのペイロードの変換を実行します。 content_type に基づいて ContentHandler のコードを調整する必要がある場合があり、使用することを選択した LLM モデルの形式を受け入れることに注意してください。

これで、財務書類を操作する準備が整いました。

- ドキュメントに関する質問をするには、次のクエリとプロンプト テンプレートを使用します。

掃除

将来のコストの発生を避けるために、このノートブックで作成した SageMaker 推論エンドポイントを削除してください。 これを行うには、SageMaker Studio ノートブックで次のコマンドを実行します。

この例用に OpenSearch サーバーレス コレクションを作成し、不要になった場合は、OpenSearch サーバーレス コンソールから削除できます。

まとめ

この投稿では、ドメイン固有のコンテキストを LLM に提供するアプローチとして RAG を使用することについて説明しました。 SageMaker JumpStart を使用して、ベクトル データ ストアとしてベクトル エンジンを備えた Llama 2 と OpenSearch Serverless を使用する金融サービス組織向けに、RAG ベースのコンテキスト チャットボットを構築する方法を示しました。 この方法では、関連するコンテキストを動的に取得することで、Llama 2 を使用したテキスト生成を改良します。 カスタム データを持ち込み、SageMaker JumpStart でこの RAG ベースの戦略を革新できることを楽しみにしています。

著者について

スニル・パドマナバン AWSのスタートアップソリューションアーキテクトです。 元スタートアップの創設者兼CTOとして、彼は機械学習に情熱を注いでおり、スタートアップがビジネスの成果のためにAI / MLを活用し、ML/AIソリューションを大規模に設計および展開できるよう支援することに注力しています。

スニル・パドマナバン AWSのスタートアップソリューションアーキテクトです。 元スタートアップの創設者兼CTOとして、彼は機械学習に情熱を注いでおり、スタートアップがビジネスの成果のためにAI / MLを活用し、ML/AIソリューションを大規模に設計および展開できるよう支援することに注力しています。

スレマン・パテル アマゾン ウェブ サービス (AWS) のシニア ソリューション アーキテクトであり、特に機械学習と最新化に重点を置いています。 ビジネスとテクノロジーの両方における専門知識を活用して、Suleman は、顧客が現実のビジネス上の問題に取り組むソリューションの設計と構築を支援します。 仕事に没頭していないときは、Suleman さんはアウトドアを探索したり、ドライブ旅行に出かけたり、キッチンでおいしい料理を作ったりするのが大好きです。

スレマン・パテル アマゾン ウェブ サービス (AWS) のシニア ソリューション アーキテクトであり、特に機械学習と最新化に重点を置いています。 ビジネスとテクノロジーの両方における専門知識を活用して、Suleman は、顧客が現実のビジネス上の問題に取り組むソリューションの設計と構築を支援します。 仕事に没頭していないときは、Suleman さんはアウトドアを探索したり、ドライブ旅行に出かけたり、キッチンでおいしい料理を作ったりするのが大好きです。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://aws.amazon.com/blogs/machine-learning/build-a-contextual-chatbot-for-financial-services-using-amazon-sagemaker-jumpstart-llama-2-and-amazon-opensearch-serverless-with-vector-engine/

- :持っている

- :は

- :not

- $UP

- 1

- 100

- 13

- 2020

- 視聴者の38%が

- 30

- 7

- 8

- 9

- a

- 能力

- 私たちについて

- 抄録

- 豊富な

- 受け入れる

- アクセス

- アクセス

- 精度

- 取得する

- 適応

- 添加

- エージェント

- AI

- aiのユースケース

- AI / ML

- AL

- 整列

- アラインメント

- 許可

- ことができます

- 沿って

- また

- Amazon

- アマゾンセージメーカー

- Amazon SageMaker ジャンプスタート

- Amazon Webサービス

- Amazon Webサービス(AWS)

- 間で

- an

- および

- 回答

- 回答

- API

- 申し込み

- アプローチ

- 近似

- 建築

- です

- AS

- 頼む

- At

- 増強

- 増強された

- 利用できます

- 避ける

- AWS

- ベース

- ベース

- BE

- なぜなら

- き

- ベンチマーク

- の間に

- ボルスター

- ブースト

- ロボット

- 両言語で

- 持って来る

- 広い

- ビルド

- 建物

- ビジネス

- 焙煎が極度に未発達や過発達のコーヒーにて、クロロゲン酸の味わいへの影響は強くなり、金属を思わせる味わいと乾いたマウスフィールを感じさせます。

- by

- コール

- 缶

- 機能

- 場合

- 例

- チェーン

- チェーン

- チャットボット

- 選択肢

- 選択する

- class

- 分類

- コード

- コレクション

- コレクション

- 組み合わせた

- 結合

- 比べ

- 比較

- 比較

- コンプリート

- コンプライアンス

- 包括的な

- 計算

- コンセプト

- 概念の

- 一貫して

- 領事

- 制約

- コンテンツ

- コンテンツライティング

- コンテキスト

- 文脈上の

- コントロール

- controls

- 広告文案作成

- 基本

- 対応する

- コスト効率の良い

- コスト

- 作ります

- 作成した

- 創造

- CTO

- 電流プローブ

- 現在

- カスタム

- Customers

- カスタマイズ可能な

- カスタム化

- カスタマイズ

- データ

- データセキュリティ

- データベースを追加しました

- 専用の

- 定義する

- 遅延

- 実証します

- 依存

- 展開します

- 展開

- 配備

- 設計

- 設計

- 詳細な

- 細部

- Developer

- DICT

- 議論する

- do

- ドキュメント

- ドキュメント

- ドメイン

- ドロー

- 原因

- 間に

- ダイナミック

- 動的に

- E&T

- 各

- 前

- 利益

- 収益報告

- 効果的な

- 効能

- 効率

- ほかに

- 埋め込みます

- 埋め込まれた

- 埋め込み

- 採用

- end

- エンドポイント

- エンジン

- 強化

- 豊かな

- 濃縮

- 確保

- 確実に

- 確保する

- 環境

- 本質

- 本質的な

- 例

- 例

- Excel

- 興奮した

- 存在する

- 専門知識

- 探る

- 探る

- 伸ばす

- 外部

- 顔

- 容易にする

- 要因

- 遠く

- 特徴

- 特徴

- FRBは

- ファイナンシャル

- 金融部門

- 金融サービス

- 金融業務

- フィンサーブ

- 会社

- 名

- フィット

- フロート

- フロー

- フォーカス

- 焦点を当てて

- フォロー中

- 形式でアーカイブしたプロジェクトを保存します.

- 前者

- フォワード

- Foundation

- AIとMoku

- フレームワーク

- から

- function

- さらに

- 融合

- 未来

- 生成する

- 生成された

- 世代

- 生々しい

- 生成AI

- GitHubの

- だ

- ガイダンス

- 持ってる

- he

- 助けます

- 助け

- ことができます

- 彼の

- host

- 認定条件

- How To

- しかしながら

- HTTP

- HTTPS

- ハブ

- i

- 理想的には

- 特定され

- 識別

- if

- 画像

- 浸した

- import

- 改善します

- 向上させる

- 改善

- in

- 綿密な

- include

- 含めて

- 包含

- 増える

- 増加した

- の増加

- index

- インデックス

- 個人

- 産業を変えます

- 情報

- 革新します

- 入力

- 説明書

- 統合する

- 統合

- 対話

- インタフェース

- 内部

- に

- 導入

- 分離された

- 分離

- IT

- ITS

- JPG

- JSON

- 知識

- 風景

- 言語

- 大

- より大きい

- 最新の

- 主要な

- 学習

- 長さ

- 活用します

- 活用

- ルイス

- 図書館

- ような

- 制限

- 限定的

- リスト

- ラマ

- LLM

- ロギング

- より長いです

- 探して

- で

- 機械

- 機械学習

- 作成

- 管理します

- 多くの

- 五月..

- ミーツ

- メモリ

- 言及した

- 方法

- メソッド

- かもしれない

- ML

- モデル

- お金

- 他には?

- さらに

- 最も

- の試合に

- 必要

- 必要

- ネットワーク

- ニューラル

- 次の

- いいえ

- なし

- ノート

- 今

- オブジェクト

- of

- 提供すること

- オファー

- オンライン

- on

- ONE

- もの

- の

- 動作

- 最適化

- or

- 組織

- 組織

- オリジナル

- 私たちの

- 成果

- 屋外で

- 出力

- outputs

- が

- 足

- パラメータ

- 最高の

- 部

- 特に

- 渡された

- 通過

- 情熱的な

- 実行する

- 持続性

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- 人気

- おそらく

- ポスト

- 投稿

- 強力な

- パワード

- 正確な

- 主に

- 好む

- 前提条件

- 現在

- 流行している

- プレビュー

- 前に

- プライベート

- 問題

- プロセス

- 生産する

- 有望

- 提供します

- は、大阪で

- 準備

- 質問と回答

- 品質

- 質問

- 質問

- ランク

- 準備

- 現実の世界

- への

- 参照する

- 参照

- に対する

- レギュレータ

- 規制状況

- 関連する

- 関連性

- 関連した

- 依存

- 残る

- レンダリング

- レポート

- 要求

- 必要とする

- の提出が必要です

- 要件

- リソースを大量に消費する

- リソース

- 応答

- 回答

- 結果

- return

- 収益

- 厳しい

- ロード

- 職種

- ルール

- ランニング

- セージメーカー

- SageMaker の推論

- 同じ

- Save

- 規模

- シームレス

- を検索

- セクション

- セクター

- セキュリティ

- select

- 選択

- 選択

- 自己

- シニア

- サーバレス

- サービス

- サービス

- セッションに

- 示されました

- 示す

- 作品

- 簡単な拡張で

- サイズ

- サイズ

- より小さい

- So

- 溶液

- ソリューション

- ソース

- ソース

- 部品調達

- スペース

- 特別

- 専門の

- 特定の

- 特に

- 指定の

- 規格

- スタートアップ

- スタートアップ

- 都道府県

- 最先端の

- 手順

- ステップ

- ストレージ利用料

- 店舗

- 保存され

- 戦略

- 流線

- 研究

- そのような

- 適当

- まとめる

- タックル

- 取得

- タスク

- 技術

- テクノロジー

- template

- テンプレート

- 클라우드 기반 AI/ML및 고성능 컴퓨팅을 통한 디지털 트윈의 기초 – Edward Hsu, Rescale CPO 많은 엔지니어링 중심 기업에게 클라우드는 R&D디지털 전환의 첫 단계일 뿐입니다. 클라우드 자원을 활용해 엔지니어링 팀의 제약을 해결하는 단계를 넘어, 시뮬레이션 운영을 통합하고 최적화하며, 궁극적으로는 모델 기반의 협업과 의사 결정을 지원하여 신제품을 결정할 때 데이터 기반 엔지니어링을 적용하고자 합니다. Rescale은 이러한 혁신을 돕기 위해 컴퓨팅 추천 엔진, 통합 데이터 패브릭, 메타데이터 관리 등을 개발하고 있습니다. 이번 자리를 빌려 비즈니스 경쟁력 제고를 위한 디지털 트윈 및 디지털 스레드 전략 개발 방법에 대한 인사이트를 나누고자 합니다.

- テキスト

- それ

- アプリ環境に合わせて

- それら

- その後

- それによって

- ボーマン

- 彼ら

- この

- 三

- 介して

- 時間

- タイムリーな

- 〜へ

- 一緒に

- top

- 厳しい

- に向かって

- 訓練された

- トレーニング

- 変換

- 変換

- true

- 順番

- type

- 超

- 理解する

- ユニーク

- ユニバーサル

- 最新

- 更新しました

- つかいます

- 使用事例

- 中古

- ユーザー

- 使用されます

- 活用する

- 変化した

- 多様

- さまざまな

- 広大な

- 、

- ボリューム

- ウォークスルー

- 仕方..

- we

- ウェブ

- Webサービス

- この試験は

- いつ

- which

- while

- Wikipedia

- 意志

- ウィンドウを使用して入力ファイルを追加します。

- 以内

- 仕事

- 書き込み

- 年

- You

- あなたの

- ゼファーネット