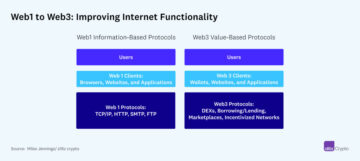

Met de verbuiging van grote taalmodellen (LLM's) zijn we getuige van een paradigmaverschuiving in softwareontwikkeling en de computerindustrie als geheel. AI is aan het gebeuren en een nieuwe stapel vormt zich voor onze ogen. Het is net als het internet helemaal opnieuw, dat nieuwe infrastructuurcomponenten in gebruik neemt die zijn gebouwd voor de nieuwe manier van doen.

Er is een groeiende erkenning dat LLM's eigenlijk zijn een nieuwe computervorm, In zekere zin. Ze kunnen "programma's" uitvoeren die zijn geschreven in natuurlijke taal (dwz prompts), willekeurige computertaken uitvoeren (bijvoorbeeld Python-code schrijven of zoeken op Google) en de resultaten terugsturen naar de gebruiker in een voor mensen leesbare vorm. Dit is een groot probleem, om twee redenen:

- Een nieuwe klasse toepassingen rond samenvatting en generatieve inhoud is nu mogelijk, wat resulteert in een verandering van het consumentengedrag rond softwareconsumptie.

- Een nieuwe klasse ontwikkelaars kan nu software schrijven. Computerprogrammering vereist nu alleen beheersing van het Engels (of een andere menselijke taal), geen training in een traditionele programmeertaal zoals Python of JavaScript.

Een van onze topprioriteiten bij Andreessen Horowitz is het identificeren van de bedrijven die de belangrijkste componenten van deze nieuwe AI-stack bouwen. We zijn verheugd om aan te kondigen dat we een Series B-ronde van $ 100 miljoen leiden pinecone, ter ondersteuning van hun visie om de geheugenlaag voor AI-toepassingen te worden.

Het probleem: LLM's hallucineren en zijn staatloos

Een enorme uitdaging met de huidige LLM's is hallucinatie. Ze geven zeer zelfverzekerde antwoorden die feitelijk en soms logisch onjuist zijn. Als u bijvoorbeeld een LLM vraagt naar de brutomarge van Apple voor het laatste kwartaal, kan dit resulteren in een zelfverzekerd antwoord van $ 63 miljard. Het model kan zijn antwoord zelfs staven door uit te leggen dat door $ 25 miljard aan goederenkosten af te trekken van $ 95 miljard aan inkomsten, je een brutomarge krijgt van $ 63 miljard. Natuurlijk is het verkeerd op verschillende dimensies:

- Ten eerste klopt het omzetcijfer niet, omdat de LLM geen realtime gegevens heeft. Het werkt met verouderde trainingsgegevens die maanden of waarschijnlijk jaren oud zijn.

- Ten tweede pikte het die inkomsten en kosten van goederen willekeurig op uit de jaarrekening van een ander fruitbedrijf.

- Ten derde is de berekening van de brutomarge wiskundig niet correct.

Stel je voor dat je dat antwoord geeft aan de CEO van een Fortuin 500 bedrijf.

Dit gebeurt allemaal omdat LLM's uiteindelijk voorspellingsmachines zijn die zijn getraind op enorme hoeveelheden internetgegevens van derden. Vaak zit de informatie die de gebruiker nodig heeft gewoon niet in de trainingsset. Het model geeft dus de meest waarschijnlijke en taalkundig goed geformatteerde antwoorden op basis van verouderde trainingsgegevens. We kunnen al een mogelijke oplossing voor het bovenstaande probleem beginnen te zien: contextueel relevante particuliere bedrijfsgegevens in realtime aan de LLM's leveren.

De algemene vorm van dit probleem is dat, vanuit een systeemperspectief, LLM's en de meeste andere AI-modellen stateloos zijn bij de inferentiestap. Elke keer dat u de GPT-4 API aanroept, hangt de uitvoer ervan af Slechts op de gegevens en parameters die u in de payload verzendt. Het model heeft geen ingebouwde manier om contextuele gegevens op te nemen of te onthouden wat u eerder hebt gevraagd. Verfijning van het model is mogelijk, maar het is duur en relatief inflexibel (dwz het model kan niet in realtime reageren op nieuwe gegevens). Aangezien de modellen de status of het geheugen niet zelf beheren, is het aan ontwikkelaars om het gat op te vullen.

De oplossing: vectordatabases zijn de opslaglaag voor LLM's

Dit is waar Pinecone binnenkomt.

Pinecone is een externe database waarin ontwikkelaars relevante contextuele gegevens voor LLM-apps kunnen opslaan. In plaats van grote documentverzamelingen heen en weer te sturen bij elke API-aanroep, kunnen ontwikkelaars ze opslaan in een Pinecone-database en vervolgens de weinige selecteren die het meest relevant zijn voor een bepaalde zoekopdracht - een benadering die in-context leren wordt genoemd. Het is een must-have voor enterprise use cases om echt tot bloei te komen.

In het bijzonder is Pinecone een vector database, wat betekent dat gegevens worden opgeslagen in de vorm van semantisch betekenisvolle inbedding. Hoewel een technische uitleg van inbeddingen buiten het bestek van dit bericht valt, is het belangrijkste om te begrijpen dat LLM's ook werken op vectorinbeddingen - dus door gegevens in Pinecone in dit formaat op te slaan, is een deel van het AI-werk effectief voorverwerkt en geoffload naar de database.

In tegenstelling tot bestaande databases, die zijn ontworpen voor atomaire transactionele of uitputtende analytische werklasten, is de (Pinecone) vectordatabase ontworpen voor uiteindelijk consistent benaderend zoeken naar buren, het juiste databaseparadigma voor hoger-dimensionale vectoren. Ze bieden ook ontwikkelaars-API's die kunnen worden geïntegreerd met andere belangrijke componenten van AI-toepassingen, zoals OpenAI, Cohere, LangChain, enz. Zo'n goed doordacht ontwerp maakt het leven van ontwikkelaars veel gemakkelijker. Eenvoudige AI-taken zoals semantisch zoeken, productaanbevelingen of feed-ranking kunnen ook rechtstreeks worden gemodelleerd als vectorzoekproblemen en worden uitgevoerd op de vectordatabase zonder een laatste modeldeductiestap. iets wat bestaande databases niet kunnen.

Pinecone is de opkomende standaard voor het beheer van staats- en contextuele bedrijfsgegevens in LLM-toepassingen. We denken dat het een belangrijke infrastructuurcomponent is, die de opslag- of 'geheugen'-laag levert aan een gloednieuwe AI-applicatiestack.

Ongelooflijke vooruitgang voor Pinecone tot nu toe

Pinecone is niet de enige vectordatabase, maar we geloven dat het met een aanzienlijke marge de toonaangevende vectordatabase is - nu klaar voor gebruik in de echte wereld. Pinecone heeft in slechts drie maanden tijd een achtvoudige groei gezien in betaalde klanten (ongeveer 8), inclusief toekomstgerichte technologiebedrijven zoals Shopify, Gong, Zapier en meer. Het wordt gebruikt in een groot aantal sectoren, waaronder bedrijfssoftware, consumentenapps, e-commerce, fintech, verzekeringen, media en AI/ML.

We schrijven dit succes niet alleen toe aan het diepgaande begrip van het team van de gebruiker, de markt en de technologie, maar ook - cruciaal - aan hun cloud-native productbenadering vanaf het begin. Een van de moeilijkste onderdelen van het bouwen van deze service is het bieden van een betrouwbare, zeer beschikbare cloud-backend die voldoet aan een breed scala aan prestatiedoelen en SLA's van klanten. Met meerdere iteraties van productarchitectuur en het beheer van veel grootschalige, betaalde klanten in productie, heeft dit team operationele uitmuntendheid getoond die wordt verwacht van een productiedatabase.

pinecone is opgericht door Edo Liberty, die al heel lang een hardnekkig pleitbezorger is voor het belang van vectordatabases bij machine learning, inclusief hoe ze elke onderneming in staat kunnen stellen use cases te bouwen bovenop LLM's. Als toegepast wiskundige bracht hij zijn carrière door met het bestuderen en implementeren van geavanceerde vectorzoekalgoritmen. Tegelijkertijd was hij een pragmaticus, bouwde hij ML-tools zoals Sagemaker bij AWS en vertaalde hij toegepast ML-onderzoek naar praktische producten die klanten kunnen gebruiken. Het is zeldzaam om zo'n combinatie van diep onderzoek en pragmatisch productdenken te zien.

Edo wordt vergezeld door Bob Wiederhold, een ervaren CEO en operator (voorheen van Couchbase), als partner aan de operationele kant als President en COO. Pinecone heeft ook een fantastisch team van leidinggevenden en ingenieurs met diepgaande expertise op het gebied van cloudsystemen van plaatsen als AWS, Google en Databricks. We zijn onder de indruk van de diepgaande technische expertise van het team, de focus op ontwikkelaarservaring en efficiënte GTM-uitvoering, en we hebben het voorrecht om met hen samen te werken om de geheugenlaag voor AI-toepassingen te bouwen.

* * *

De standpunten die hier naar voren worden gebracht, zijn die van het individuele personeel van AH Capital Management, LLC (“a16z”) dat wordt geciteerd en zijn niet de standpunten van a16z of haar gelieerde ondernemingen. Bepaalde informatie in dit document is verkregen uit externe bronnen, waaronder van portefeuillebedrijven van fondsen die worden beheerd door a16z. Hoewel ontleend aan bronnen die betrouwbaar worden geacht, heeft a16z dergelijke informatie niet onafhankelijk geverifieerd en doet het geen uitspraken over de blijvende nauwkeurigheid van de informatie of de geschiktheid ervan voor een bepaalde situatie. Bovendien kan deze inhoud advertenties van derden bevatten; a16z heeft dergelijke advertenties niet beoordeeld en keurt de daarin opgenomen advertentie-inhoud niet goed.

Deze inhoud is uitsluitend bedoeld voor informatieve doeleinden en mag niet worden beschouwd als juridisch, zakelijk, investerings- of belastingadvies. U dient hierover uw eigen adviseurs te raadplegen. Verwijzingen naar effecten of digitale activa zijn alleen voor illustratieve doeleinden en vormen geen beleggingsaanbeveling of aanbod om beleggingsadviesdiensten te verlenen. Bovendien is deze inhoud niet gericht op of bedoeld voor gebruik door beleggers of potentiële beleggers, en mag er in geen geval op worden vertrouwd bij het nemen van een beslissing om te beleggen in een fonds dat wordt beheerd door a16z. (Een aanbod om te beleggen in een a16z-fonds wordt alleen gedaan door middel van het onderhandse plaatsingsmemorandum, de inschrijvingsovereenkomst en andere relevante documentatie van een dergelijk fonds en moet in hun geheel worden gelezen.) Alle genoemde beleggingen of portefeuillebedrijven waarnaar wordt verwezen, of beschreven zijn niet representatief voor alle investeringen in voertuigen die door a16z worden beheerd, en er kan geen garantie worden gegeven dat de investeringen winstgevend zullen zijn of dat andere investeringen die in de toekomst worden gedaan vergelijkbare kenmerken of resultaten zullen hebben. Een lijst van investeringen die zijn gedaan door fondsen die worden beheerd door Andreessen Horowitz (met uitzondering van investeringen waarvoor de uitgevende instelling geen toestemming heeft gegeven aan a16z om openbaar te maken, evenals onaangekondigde investeringen in openbaar verhandelde digitale activa) is beschikbaar op https://a16z.com/investments /.

De grafieken en grafieken die hierin worden verstrekt, zijn uitsluitend bedoeld voor informatieve doeleinden en er mag niet op worden vertrouwd bij het nemen van een investeringsbeslissing. In het verleden behaalde resultaten zijn geen indicatie voor toekomstige resultaten. De inhoud spreekt alleen vanaf de aangegeven datum. Alle projecties, schattingen, voorspellingen, doelstellingen, vooruitzichten en/of meningen die in deze materialen worden uitgedrukt, kunnen zonder voorafgaande kennisgeving worden gewijzigd en kunnen verschillen of in strijd zijn met meningen van anderen. Zie https://a16z.com/disclosures voor aanvullende belangrijke informatie.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoAiStream. Web3 gegevensintelligentie. Kennis versterkt. Toegang hier.

- De toekomst slaan met Adryenn Ashley. Toegang hier.

- Bron: https://a16z.com/2023/04/27/investing-in-pinecone/

- : heeft

- :is

- :niet

- :waar

- $ 100 miljoen

- $UP

- 1

- 500

- a

- a16z

- in staat

- Over

- boven

- nauwkeurigheid

- over

- werkelijk

- toevoeging

- Extra

- Adoptie

- ADVERTISING

- advies

- adviserend

- adviesdiensten

- advocaat

- filialen

- weer

- Overeenkomst

- AI

- AI / ML

- algoritmen

- Alles

- al

- ook

- hoeveelheden

- an

- analytisch

- en

- Andreessen

- Andreessen Horowitz

- aankondigen

- Nog een

- beantwoorden

- antwoorden

- elke

- api

- APIs

- Apple

- Aanvraag

- toepassingen

- toegepast

- nadering

- ongeveer

- apps

- architectuur

- ZIJN

- rond

- AS

- Activa

- zekerheid

- At

- Beschikbaar

- AWS

- terug

- backend

- gebaseerde

- BE

- omdat

- worden

- geweest

- vaardigheden

- geloofd wie en wat je bent

- geloofde

- Verder

- Groot

- Miljard

- Bloeien

- bob

- merk

- Brand New

- bouw

- Gebouw

- bebouwd

- ingebouwd

- bedrijfsdeskundigen

- maar

- by

- Bellen

- Dit betekent dat we onszelf en onze geliefden praktisch vergiftigen.

- oproepen

- CAN

- hoofdstad

- Carrière

- gevallen

- ceo

- zeker

- uitdagen

- verandering

- kenmerken

- situatie

- klasse

- Cloud

- code

- collecties

- combinatie van

- komt

- Bedrijven

- afstand

- Bedrijf

- bestanddeel

- componenten

- computer

- computergebruik

- zeker

- consequent

- vormen

- consument

- consumptie

- content

- contextual

- tegendeel

- kirren

- Kern

- Kosten

- Bankstel

- Type cursus

- Actueel

- klant

- Klanten

- op het randje

- gegevens

- Database

- databanken

- Datum

- dag

- transactie

- beslissing

- deep

- afhankelijk

- beschreven

- Design

- ontworpen

- Ontwikkelaar

- ontwikkelaars

- Ontwikkeling

- verschillen

- digitaal

- Digitale activa

- Afmeting

- direct

- Openbaren

- do

- document

- documentatie

- doet

- Nee

- doen

- Dont

- e

- e-commerce

- elk

- gemakkelijker

- effectief

- doeltreffend

- opkomende

- in staat stellen

- einde

- onderschreven

- langdurig

- Engineering

- Ingenieurs

- Engels

- Enterprise

- bedrijfssoftware

- geheel

- schattingen

- etc

- Zelfs

- uiteindelijk

- Alle

- voorbeeld

- Uitmuntendheid

- Exclusief

- uitvoeren

- uitvoering

- leidinggevende

- bestaand

- verwacht

- duur

- ervaring

- ervaren

- expertise

- uitleggen

- uitleg

- uitgedrukt

- extern

- Ogen

- fantastisch

- voeden

- weinig

- vullen

- finale

- financieel

- FinTech

- Focus

- Voor

- prognoses

- formulier

- formaat

- vroeger

- voort

- toekomstgericht

- Opgericht

- oppompen van

- fonds

- fondsen

- Bovendien

- toekomst

- kloof

- Algemeen

- generatief

- krijgen

- Geven

- gegeven

- Vrijgevigheid

- goederen

- Kopen Google Reviews

- grafieken

- bruto

- Groeiend

- Happening

- gebeurt

- Hebben

- he

- hier

- zeer

- zijn

- Horowitz

- Hoe

- HTTPS

- reusachtig

- menselijk

- leesbare

- i

- identificeren

- uitvoering

- belang

- belangrijk

- onder de indruk

- in

- omvatten

- Inclusief

- nemen

- onafhankelijk

- aangegeven

- individueel

- industrieën

- -industrie

- informatie

- Informatieve

- Infrastructuur

- verzekering

- Integreren

- Internet

- in

- Investeren

- investeren

- investering

- beleggingsadvies

- Investeringen

- Investeerders

- Emittent

- IT

- iteraties

- HAAR

- JavaScript

- toegetreden

- voor slechts

- sleutel

- taal

- Groot

- Achternaam*

- lagen

- leidend

- leren

- Juridisch

- Vrijheid

- als

- Lijst

- Lives

- LLM

- machine

- machine learning

- Machines

- gemaakt

- maken

- MERKEN

- maken

- beheer

- beheerd

- management

- beheren

- veel

- Marge

- Markt

- materieel

- mathematisch

- Zaken

- Mei..

- zinvolle

- middel

- Media

- Meets

- Memorandum

- Geheugen

- vermeld

- miljoen

- ML

- model

- modellen

- maanden

- meer

- meest

- veel

- meervoudig

- Must-have

- Naturel

- behoeften

- New

- geen

- Merk op..

- nu

- aantal

- nummers

- verkregen

- of

- korting

- bieden

- het aanbieden van

- vaak

- Oud

- on

- EEN

- Slechts

- OpenAI

- besturen

- operationele

- Operations

- operator

- Meningen

- or

- Overige

- Overig

- onze

- uitgang

- over

- het te bezitten.

- betaald

- paradigma

- parameters

- deel

- bijzonder

- partner

- onderdelen

- verleden

- prestatie

- toestemming

- Personeel

- perspectief

- kiezen

- uitgekozen

- plaatsen

- Plato

- Plato gegevensintelligentie

- PlatoData

- dan

- portfolio

- mogelijk

- Post

- potentieel

- PRAKTISCH

- pragmatisch

- voorspelling

- president

- privaat

- bevoorrecht

- waarschijnlijk

- probleem

- problemen

- Product

- productie

- Producten

- winstgevend

- Programming

- Voortgang

- projecties

- aanstaande

- vooruitzichten

- zorgen voor

- mits

- het verstrekken van

- in het openbaar

- doeleinden

- Python

- Quarter

- reeks

- BIJZONDER

- liever

- Lees

- klaar

- vast

- echte wereld

- real-time

- realtime gegevens

- redenen

- erkenning

- Aanbeveling

- aanbevelingen

- referenties

- verwezen

- relatief

- relevante

- betrouwbaar

- niet vergeten

- vertegenwoordiger

- vereist

- onderzoek

- Reageren

- resultaat

- verkregen

- Resultaten

- terugkeer

- inkomsten

- beoordeeld

- ronde

- lopen

- sagemaker

- dezelfde

- omvang

- Ontdek

- zoeken

- Effecten

- zien

- gezien

- sturen

- verzending

- zin

- -Series

- Serie B

- service

- Diensten

- reeks

- verscheidene

- verschuiving

- moet

- getoond

- kant

- aanzienlijke

- gelijk

- eenvoudigweg

- sinds

- situatie

- So

- Software

- software development

- oplossing

- sommige

- iets

- bronnen

- spreekt

- besteed

- stack

- standaard

- begin

- Land

- verklaringen

- Stap voor

- mediaopslag

- shop

- opgeslagen

- bewaartemperatuur

- Bestuderen

- onderwerpen

- abonnement

- succes

- dergelijk

- ondersteuning

- Systems

- doelen

- taken

- belasting

- team

- tech

- tech bedrijven

- Technisch

- Technologie

- neem contact

- dat

- De

- De toekomst

- de informatie

- hun

- Ze

- harte

- Er.

- daarin

- Deze

- ze

- denken

- het denken

- van derden

- dit

- die

- drie

- blij

- niet de tijd of

- naar

- tools

- top

- verhandeld

- traditioneel

- getraind

- Trainingen

- transactionele

- echt

- twee

- voor

- begrijpen

- begrip

- op

- .

- gebruikt

- Gebruiker

- groot

- Voertuigen

- geverifieerd

- zeer

- .

- visie

- was

- Manier..

- we

- GOED

- Wat

- wanneer

- welke

- en

- WIE

- geheel

- breed

- Grote range

- wil

- Met

- binnen

- zonder

- getuigen

- Mijn werk

- werkzaam

- schrijven

- het schrijven van

- geschreven

- Verkeerd

- jaar

- You

- Your

- zephyrnet