Introduksjon

En gang i blant kan en person ta et abstrakt konsept som tilsynelatende er for vagt for formell studie og tilby en elegant formell definisjon. Claude Shannon gjorde det med informasjon, og Andrey Kolmogorov gjorde det med tilfeldig. De siste årene har forskere forsøkt å gjøre det samme for begrepet rettferdighet i maskinlæring. Dessverre har dette vært vanskeligere. Ikke bare er konseptet vanskeligere å definere, men det er også umulig for en enkelt definisjon å tilfredsstille alle ønskelige rettferdighetsverdier. Arvind Narayanan, en informatiker ved Princeton University, har vært medvirkende til å kontekstualisere forskjellige synspunkter og hjelpe dette nye feltet med å etablere seg.

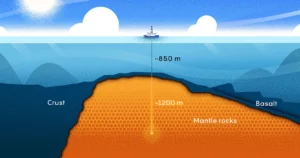

Karrieren hans har spennet over alle nivåer av abstraksjon, fra teori til politikk, men reisen som til slutt førte til hans nåværende arbeid begynte i 2006. Det året sponset Netflix en konkurranse som ville gi $1 million til den som forbedret nøyaktigheten til anbefalingssystemet sitt med 10 %. Netflix ga et angivelig anonymt datasett med brukere og deres vurderinger, med personlig identifiserbar informasjon fjernet. Men Narayanan viste at med en sofistikert statistisk teknikk trenger du bare noen få datapunkter for å avsløre identiteten til en "anonym" bruker i datasettet.

Siden den gang har Narayanan fokusert på andre områder hvor teori møter praksis. Gjennom Princeton Web Transparency and Accountability Project, avdekket teamet hans skjulte måter som nettsteder sporer brukere og trekker ut sensitive data. Teamet hans fant ut at en gruppe som National Security Agency kunne bruke nettsurfingsdata (spesifikt informasjonskapsler plassert av tredjeparter) ikke bare for å oppdage brukerens virkelige identitet, men også for å rekonstruere 62 % til 73 % av nettleserhistorikken deres. . De viste det — å riffe på berømt New Yorker tegnefilm – på internett vet nettsteder nå at du er en hund.

De siste årene har Narayanan henvendt seg spesielt til maskinlæring — en applikasjon av kunstig intelligens som gir maskiner muligheten til å lære av data. Mens han hilser fremskritt innen AI velkommen, påpeker han hvordan slike systemer kan mislykkes selv med gode intensjoner, og hvordan disse ellers nyttige teknologiene kan bli verktøy for å rettferdiggjøre diskriminering. I dette lyset danner de tilsynelatende usammenhengende prikkene som har definert Narayanans forskningsbane en slags konstellasjon.

Quanta snakket med Narayanan om hans arbeid med de-anonymisering, viktigheten av statistisk intuisjon og de mange fallgruvene til AI-systemer. Intervjuet er komprimert og redigert for klarhet.

Introduksjon

Har du alltid hatt lyst til å forske på matematikk og naturfag?

Jeg vokste opp veldig interessert i begge deler, men først og fremst i matte. Jeg var flink til å løse gåter og hadde til og med en viss suksess på den internasjonale matematiske olympiaden. Men jeg hadde en stor misforståelse om forskjellen mellom gåteløsing og forskning i matematikk.

Og så tidlig fokuserte jeg forskningen min på kryptografi, spesielt teoretisk kryptografi, fordi jeg fortsatt arbeidet under villfarelsen om at jeg var veldig god i matematikk. Og så har resten av karrieren min vært en reise for å innse at det faktisk ikke er min styrke i det hele tatt.

Det må ha fungert som en god bakgrunn for avanonymiseringsarbeidet ditt.

Du har rett. Det som tillot de-anonymiseringsforskningen er ferdigheten jeg kaller statistisk intuisjon. Det er faktisk ikke formell matematisk kunnskap. Det er å kunne ha en intuisjon i hodet som: "Hvis jeg tar dette komplekse datasettet og bruker denne transformasjonen på det, hva er et plausibelt utfall?"

Intuisjon kan ofte være feil, og det er greit. Men det er viktig å ha intuisjon fordi den kan lede deg mot veier som kan være fruktbare.

Introduksjon

Hvordan hjalp statistisk intuisjon med arbeidet ditt med Netflix-dataene?

Jeg hadde prøvd å utarbeide et anonymiseringsskjema for høydimensjonale data. Det mislyktes fullstendig, men i prosessen med å mislykkes hadde jeg utviklet intuisjonen om at høydimensjonale data ikke kan anonymiseres effektivt. Selvfølgelig hevdet Netflix, med konkurrentene deres, å ha gjort akkurat det.

Jeg hadde min naturlige skepsis til selskapers markedsføringsuttalelser, så jeg var motivert til å bevise at de tok feil. Rådgiveren min, Vitaly Shmatikov, og jeg jobbet med det i noen intense uker. Da vi skjønte at arbeidet virkelig hadde en innvirkning, begynte jeg å gjøre mer.

Hva var den samlede virkningen? Hørte du tilbake fra Netflix og andre selskaper hvis data viste seg å ikke være fullt så anonyme?

Vel, en positiv effekt er at det ansporet vitenskapen til forskjellig personvern. Men med tanke på hvordan bedriftene reagerte, har det vært litt forskjellige reaksjoner. I mange tilfeller gjør selskaper som ellers ville ha gitt ut datasett til offentligheten, det nå ikke lenger - de våpner personvernet som en måte å bekjempe åpenhetsarbeid.

Facebook er kjent for å gjøre dette. Når forskere går til Facebook og sier: «Vi trenger tilgang til noen av disse dataene for å studere hvordan informasjon forplanter seg på plattformen», kan Facebook nå si: «Nei, det kan vi ikke gi deg. Det vil kompromittere personvernet til brukerne våre.»

Du skrev en gang en papir argumenterer for at begrepet "personlig identifiserbar informasjon" kan være misvisende. Hvordan det?

Jeg tror det er forvirring blant beslutningstakere som oppstår fra to forskjellige måter begrepet brukes på. Den ene er informasjon om deg som er svært sensitiv, som personnummeret ditt. En annen betydning er informasjon som kan indekseres inn i enkelte datasett og dermed brukes til å finne mer informasjon om deg.

Disse to har forskjellige betydninger. Jeg har ingen beef med konseptet PII i første forstand. Visse opplysninger om personer er svært sensitive, og vi bør behandle dem mer forsiktig. Men selv om e-postadressen din ikke nødvendigvis er veldig sensitiv for folk flest, er den fortsatt en unik identifikator som kan brukes til å finne deg i andre datasett. Så lenge kombinasjonen av attributter om en person er tilgjengelig for alle andre i verden, er det alt du trenger for avanonymisering.

Introduksjon

Hvordan kom du til slutt på å studere rettferdighet?

Jeg underviste i et rettferdighets- og maskinlæringskurs i 2017. Det ga meg et godt inntrykk av de åpne problemene i feltet. Og sammen med det holdt jeg et foredrag kalt "21 Definisjoner av rettferdighet og deres politikk." Jeg forklarte at spredningen av tekniske definisjoner ikke var på grunn av tekniske årsaker, men fordi det er genuine moralske spørsmål i hjertet av alt dette. Det er ingen måte du kan ha ett enkelt statistisk kriterium som fanger opp alle normative ønsker - alle tingene du ønsker. Foredraget ble godt mottatt, så de to sammen overbeviste meg om at jeg burde begynne å sette meg inn i dette emnet.

Du også holdt et foredrag på å oppdage AI slangeolje, som også ble godt mottatt. Hvordan forholder det seg til rettferdighet i maskinlæring?

Så motivasjonen for dette var at det tydeligvis skjer mye genuin teknisk innovasjon i AI, som tekst-til-bilde-programmet DALL E 2 eller sjakkprogrammet alphazero. Det er virkelig utrolig at denne fremgangen har vært så rask. Mye av den innovasjonen fortjener å bli feiret.

Problemet kommer når vi bruker dette veldig løse og brede paraplybegrepet "AI" for slike ting, så vel som mer krevende applikasjoner, for eksempel statistiske metoder for prediksjon av kriminell risiko. I den sammenheng er typen teknologi som er involvert svært forskjellig. Dette er to svært forskjellige typer applikasjoner, og de potensielle fordelene og skadene er også svært forskjellige. Det er nesten ingen forbindelse i det hele tatt mellom dem, så å bruke samme begrep for begge er grundig forvirrende.

Folk blir villedet til å tro at all denne fremgangen de ser med bildegenerering faktisk vil føre til fremgang mot sosiale oppgaver som å forutsi kriminell risiko eller forutsi hvilke barn som kommer til å slutte på skolen. Men det er ikke tilfelle i det hele tatt. Først av alt, vi kan bare gjøre litt bedre enn tilfeldige sjanser til å forutsi hvem som kan bli arrestert for en forbrytelse. Og den nøyaktigheten oppnås med veldig enkle klassifiserere. Det blir ikke bedre over tid, og det blir ikke bedre etter hvert som vi samler inn flere datasett. Så alle disse observasjonene står i kontrast til bruken av dyp læring for bildegenerering, for eksempel.

Hvordan vil du skille mellom ulike typer maskinlæringsproblemer?

Dette er ikke en uttømmende liste, men det er tre vanlige kategorier. Den første kategorien er persepsjon, som inkluderer oppgaver som å beskrive innholdet i et bilde. Den andre kategorien er det jeg kaller «automatisering av dømmekraft», for eksempel når Facebook ønsker å bruke algoritmer for å finne ut hvilken tale som er for giftig til å forbli på plattformen. Og den tredje er å forutsi fremtidige sosiale utfall blant folk - om noen ville bli arrestert for en forbrytelse, eller om et barn kommer til å droppe ut av skolen.

I alle tre tilfellene er nøyaktighetene som kan oppnås svært forskjellige, de potensielle farene ved unøyaktig AI er svært forskjellige, og de etiske implikasjonene som følger er svært forskjellige.

For eksempel er ansiktsgjenkjenning, i min klassifisering, et persepsjonsproblem. Mange snakker om at ansiktsgjenkjenning er unøyaktig, og noen ganger har de rett. Men jeg tror ikke det er fordi det er grunnleggende grenser for nøyaktigheten av ansiktsgjenkjenning. Den teknologien har blitt bedre, og den kommer til å bli bedre. Det er nettopp derfor vi bør være bekymret for det fra et etisk perspektiv - når du legger det i hendene på politiet, som kan være uansvarlige, eller stater som ikke er transparente om bruken.

Introduksjon

Hva gjør sosiale prediksjonsproblemer så mye vanskeligere enn persepsjonsproblemer?

Persepsjonsproblemer har et par kjennetegn. En, det er ingen tvetydighet om hvorvidt det er en katt i et bilde. Så du har grunnsannheten. For det andre har du i hovedsak ubegrenset treningsdata fordi du kan bruke alle bildene på nettet. Og hvis du er Google eller Facebook, kan du bruke alle bildene som folk har lastet opp til appen din. Så disse to faktorene - mangelen på tvetydighet og datatilgjengelighet - gjør at klassifiserere kan prestere veldig bra.

Det er forskjellig fra prediksjonsproblemer, som ikke har disse to egenskapene. Det er en tredje forskjell jeg bør nevne, som på en eller annen måte er den viktigste: De moralske konsekvensene av å sette disse prediksjonsmodellene i bruk er veldig forskjellige fra å bruke et språkoversettelsesverktøy på telefonen eller et bildemerkingsverktøy.

Men det er ikke det samme alvoret som verktøyet som ble brukt for å avgjøre om noen for eksempel skal varetektsfengsles før rettssaken. Det har konsekvenser for folks frihet. Så ironien er at området der AI fungerer dårligst, egentlig ikke har blitt bedre over tid, og det er usannsynlig at det vil bli bedre i fremtiden, er området som har alle disse utrolig viktige konsekvensene.

Mye av arbeidet ditt har krevd å snakke med eksperter utenfor ditt felt. Hvordan er det å samarbeide med andre som dette?

Tverrfaglige samarbeid har vært noen av de hyggeligste samarbeidene. Jeg tror et slikt samarbeid vil ha sine frustrerende øyeblikk fordi folk ikke snakker samme språk.

Min oppskrift på det er: kultur, så språk, så substans. Hvis du ikke forstår kulturen deres - for eksempel hva slags stipend de verdsetter - kommer det til å bli veldig vanskelig. Hva som er verdifullt for en person kan virke irrelevant for en annen. Så de kulturelle aspektene må navigeres først. Da kan man begynne å etablere et felles språk og ordforråd og til slutt komme til substansen i samarbeidet.

Hvor optimistisk er du om vi trygt og klokt kan ta i bruk ny teknologi?

En del av problemet er et kunnskapshull. Beslutningstakere, offentlige etater, selskaper og andre personer som kjøper disse AI-verktøyene vil kanskje ikke gjenkjenne de alvorlige grensene for prediktiv nøyaktighet.

Men til syvende og sist tror jeg det er et politisk problem. Noen ønsker å kutte kostnader, så de vil ha et automatisert verktøy som eliminerer arbeidsplasser. Så det er et veldig sterkt press for å tro hva enn disse leverandørene sier om deres prediktive verktøy.

Det er to forskjellige problemer. Folk som meg kan kanskje bidra til å løse informasjonsgapet. Men å ta tak i det politiske problemet krever aktivisme. Det krever at vi drar nytte av den demokratiske prosessen. Det er godt å se at det er mange som gjør det. Og i det lange løp tror jeg vi kan presse tilbake mot de skadelige og misbrukende bruken av AI. Jeg tror ikke det kommer til å endre seg på et øyeblikk, men gjennom en lang, utstrakt, langvarig prosess med aktivisme som allerede har pågått i et tiår eller mer. Jeg er sikker på at det vil fortsette i lang tid.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- Platoblokkkjede. Web3 Metaverse Intelligence. Kunnskap forsterket. Tilgang her.

- kilde: https://www.quantamagazine.org/he-protects-privacy-and-ai-fairness-with-statistics-20230310/

- :er

- ][s

- $ 1 millioner

- $OPP

- 2017

- a

- evne

- I stand

- Om oss

- om det

- ABSTRACT

- adgang

- ansvarlighet

- nøyaktighet

- oppnådd

- ACM

- Handling

- Aktivisme

- faktisk

- adresse

- adressering

- adoptere

- fremskritt

- Fordel

- mot

- byråer

- byrå

- AI

- algoritmer

- Alle

- allerede

- alltid

- utrolig

- tvetydighet

- blant

- og

- Anonym

- En annen

- noen

- app

- Søknad

- søknader

- Påfør

- ER

- AREA

- områder

- arrestert

- kunstig

- kunstig intelligens

- AS

- aspekter

- At

- attributter

- Automatisert

- tilgjengelighet

- tilgjengelig

- award

- tilbake

- bakgrunn

- BE

- fordi

- bli

- Storfekjøtt

- begynte

- være

- tro

- Fordeler

- Bedre

- mellom

- bred

- Surfer

- Kjøpe

- by

- ring

- som heter

- CAN

- kan ikke

- fanger

- Karriere

- nøye

- saken

- saker

- CAT

- kategorier

- Kategori

- feiret

- viss

- sjanse

- endring

- egenskaper

- Sjakk

- hevdet

- klarhet

- klassifisering

- klart

- samarbeide

- samarbeid

- samarbeid

- samle

- kombinasjon

- Kom

- Felles

- Selskaper

- konkurranse

- helt

- komplekse

- kompromiss

- datamaskin

- konsept

- bekymret

- forvirrende

- forvirring

- tilkobling

- Konsekvenser

- innhold

- kontekst

- fortsette

- kontrast

- cookies

- Kostnader

- kunne

- Par

- Kurs

- Crime

- Criminal

- kryptografi

- kulturell

- Kultur

- Gjeldende

- Kutt

- kutte kostnader

- farene

- dato

- datapunkter

- datasett

- datasett

- tiår

- beslutningstakere

- dyp

- dyp læring

- definert

- demokratisk

- fortjener

- arrestert

- Bestem

- utviklet

- tenke

- gJORDE

- forskjell

- forskjellig

- forskjellige problemer

- oppdage

- skille

- Hund

- gjør

- ikke

- Drop

- Tidlig

- effektivt

- innsats

- eliminerer

- emalje

- hyggelig

- spesielt

- hovedsak

- etablere

- etablere

- etisk

- Selv

- etter hvert

- nøyaktig

- eksperter

- forklarte

- trekke ut

- Face

- ansiktsgjenkjenning

- faktorer

- FAIL

- Mislyktes

- rettferdig

- rettferdighet

- Noen få

- felt

- slåss

- Endelig

- Finn

- Først

- fokuserte

- følge

- Til

- skjema

- formell

- funnet

- Frihet

- fra

- frustrerende

- fundamental

- framtid

- mellomrom

- generasjonen

- få

- få

- Gi

- gir

- Go

- skal

- god

- Regjeringen

- Ground

- Gruppe

- veilede

- hender

- Skjer

- Hard

- skadelig

- skader

- Ha

- å ha

- hode

- høre

- Hjerte

- hjelpe

- hjelpe

- historie

- Hvordan

- HTTPS

- stort

- i

- Tanken

- identifikator

- Identitet

- bilde

- bilder

- Påvirkning

- implikasjoner

- betydning

- viktig

- umulig

- forbedre

- forbedret

- bedre

- in

- I andre

- unøyaktig

- inkluderer

- utrolig

- informasjon

- Innovasjon

- f.eks

- instant

- instrumental

- Intelligens

- intensjoner

- interessert

- internasjonalt

- Internet

- Intervju

- involvert

- utstedelse

- IT

- DET ER

- selv

- Jobb

- reise

- Kid

- kids

- Type

- Vet

- kunnskap

- kjent

- merking

- maling

- Språk

- LÆRE

- læring

- Led

- nivåer

- lett

- i likhet med

- grenser

- Liste

- Lang

- lang tid

- lenger

- Lot

- maskin

- maskinlæring

- maskiner

- GJØR AT

- mange

- Marketing

- math

- matematiske

- betyr

- møter

- metoder

- Metrics

- kunne

- millioner

- modeller

- Moments

- mer

- mest

- motivert

- Motivasjon

- nasjonal

- nasjonal sikkerhet

- Naturlig

- nødvendigvis

- Trenger

- Netflix

- Ny

- Antall

- of

- tilby

- Olje

- on

- ONE

- åpen

- Optimistisk

- Annen

- andre

- ellers

- Utfallet

- utenfor

- samlet

- parter

- Past

- Ansatte

- folks

- persepsjon

- Utfør

- kanskje

- person

- personlig

- perspektiv

- telefon

- stykker

- plattform

- plato

- Platon Data Intelligence

- PlatonData

- plausibel

- poeng

- Politiet

- politikk

- beslutningstakere

- politisk

- positiv

- potensiell

- praksis

- nettopp

- forutsi

- prediksjon

- resept

- press

- primært

- privatliv

- Problem

- problemer

- prosess

- program

- Progress

- Bevis

- forutsatt

- offentlig

- Skyv

- skyv tilbake

- sette

- Sette

- Puslespill

- Quantamagazin

- spørsmål

- tilfeldig

- rask

- rangeringer

- reaksjoner

- virkelige verden

- realisert

- realisere

- grunner

- mottatt

- nylig

- anerkjennelse

- gjenkjenne

- Anbefaling

- utgitt

- forbli

- fjernet

- påkrevd

- Krever

- forskning

- forsker

- forskere

- REST

- avsløre

- Risiko

- Kjør

- trygt

- samme

- ordningen

- Skole

- Vitenskap

- Forsker

- Sekund

- sikkerhet

- se

- forstand

- sensitive

- alvorlig

- sett

- sett

- bør

- Enkelt

- enkelt

- Skepsis

- ferdighet

- So

- selskap

- løse

- noen

- Noen

- sofistikert

- snakke

- spesielt

- tale

- Sponset

- Begynn

- startet

- uttalelser

- Stater

- statistisk

- Still

- styrke

- sterk

- Studer

- Studerer

- substans

- suksess

- slik

- system

- Systemer

- Ta

- Snakk

- snakker

- oppgaver

- lag

- Teknisk

- Technologies

- Teknologi

- vilkår

- Det

- De

- Området

- Fremtiden

- informasjonen

- verden

- deres

- Dem

- teoretiske

- derved

- Disse

- ting

- tenker

- Tredje

- tredjeparter

- grundig

- tre

- Gjennom

- tid

- til

- sammen

- også

- verktøy

- verktøy

- Tema

- mot

- spor

- Kurs

- bane

- Transformation

- oversette

- Oversettelse

- Åpenhet

- gjennomsiktig

- behandle

- snudde

- typer

- Til syvende og sist

- paraply

- etter

- forstå

- unik

- universitet

- ubegrenset

- lastet opp

- us

- bruke

- Bruker

- Brukere

- Verdifull

- verdi

- leverandører

- visninger

- Vei..

- måter

- web

- webp

- nettsteder

- uker

- Ønsker velkommen

- VI VIL

- Hva

- Hva er

- om

- hvilken

- mens

- HVEM

- hvem som helst

- Wikipedia

- vil

- med

- Arbeid

- arbeidet

- virker

- verden

- ville

- Feil

- år

- år

- Du

- Din

- youtube

- zephyrnet