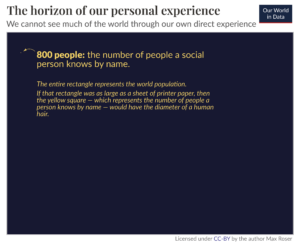

Odkąd ChatGPT eksplodował na scenie technologicznej w listopadzie ubiegłego roku, pomaga ludziom pisać wszelkiego rodzaju materiały, generować kod i znajdować informacje. To i inne duże modele językowe (LLM) ułatwiły zadania, od odbierania połączeń z obsługą klienta po przyjmowanie zamówień na fast food. Biorąc pod uwagę, jak przydatne były LLM dla ludzi w krótkim czasie, w jaki istniały, w jaki sposób ChatGPT dla robotów może wpłynąć na ich zdolność uczenia się i robienia nowych rzeczy? Naukowcy z Google DeepMind postanowili się tego dowiedzieć i opublikowali swoje odkrycia w blogu i papier wydany w zeszłym tygodniu.

Nazywają swój system RT-2. To skrót od Robotics Transformer 2 i jest następcą transformator robotyki 1, którą firma wypuściła pod koniec ubiegłego roku. RT-1 był oparty na małym programie językowym i wizyjnym i został specjalnie wyszkolony do wykonywania wielu zadań. Oprogramowanie było używane w Alphabet X Codzienne roboty, umożliwiając im wykonanie ponad 700 różnych zadań z 97-procentową skutecznością. Ale kiedy poproszono je o wykonanie nowych zadań, do których nie były przeszkolone, roboty korzystające z RT-1 odnosiły sukcesy tylko w 32 procentach przypadków.

RT-2 prawie podwaja ten wskaźnik, z powodzeniem wykonując nowe zadania przez 62 procent czasu, o który został poproszony. Naukowcy nazywają RT-2 modelem wizja-język-działanie (VLA). Wykorzystuje tekst i obrazy, które widzi online, aby nauczyć się nowych umiejętności. To nie jest takie proste, jak się wydaje; wymaga, aby oprogramowanie najpierw „zrozumiało” koncepcję, a następnie zastosowało to zrozumienie do polecenia lub zestawu instrukcji, a następnie wykonało działania, które spełniają te instrukcje.

Jednym z przykładów, które podają autorzy artykułu, jest wyrzucanie śmieci. W poprzednich modelach oprogramowanie robota musiało zostać najpierw przeszkolone w rozpoznawaniu śmieci. Na przykład, jeśli na stole znajduje się obrany banan, a obok niego skórka, botowi zostanie pokazane, że skórka to śmieci, podczas gdy banan nie. Następnie nauczono go, jak podnieść skórkę, przenieść ją do kosza na śmieci i tam zdeponować.

RT-2 działa jednak trochę inaczej. Ponieważ model trenował na mnóstwie informacji i danych z Internetu, ma ogólne pojęcie o tym, czym są śmieci, i chociaż nie jest przeszkolony w wyrzucaniu śmieci, może złożyć kroki, aby wykonać to zadanie.

LLM, których naukowcy używali do trenowania RT-2, to PaLI-X (model wizji i języka z 55 miliardami parametrów) oraz PaLM-E (co Google nazywa ucieleśnionym multimodalnym modelem językowym, opracowanym specjalnie dla robotów, z 12 miliardami parametrów). „Parametr” odnosi się do atrybutu definiowanego przez model uczenia maszynowego na podstawie jego danych szkoleniowych. W przypadku LLM modelują relacje między słowami w zdaniu i ważą prawdopodobieństwo, że przed danym słowem lub po nim pojawi się inne słowo.

Dzięki znajdowaniu relacji i wzorców między słowami w gigantycznym zbiorze danych modele uczą się na podstawie własnych wniosków. W końcu mogą dowiedzieć się, w jaki sposób różne koncepcje odnoszą się do siebie i rozpoznać kontekst. W przypadku RT-2 przekłada tę wiedzę na uogólnione instrukcje dotyczące działań robotów.

Działania te są reprezentowane przez robota jako tokeny, które są zwykle używane do reprezentowania tekstu w języku naturalnym w postaci fragmentów słów. W tym przypadku tokeny są częścią akcji, a oprogramowanie łączy ze sobą wiele tokenów w celu wykonania akcji. Ta struktura umożliwia również oprogramowaniu przeprowadzanie wnioskowania opartego na łańcuchu myśli, co oznacza, że może odpowiadać na pytania lub podpowiedzi, które wymagają pewnego stopnia rozumowania.

Przykłady podane przez zespół obejmują wybieranie przedmiotu, który ma służyć jako młotek, gdy nie ma dostępnego młotka (robot wybiera kamień) i wybieranie najlepszego napoju dla zmęczonej osoby (robot wybiera napój energetyczny).

„RT-2 wykazuje ulepszone możliwości uogólniania oraz zrozumienie semantyczne i wizualne poza danymi robotów, na które był narażony” – napisali naukowcy w Google blogu. „Obejmuje to interpretację nowych poleceń i reagowanie na polecenia użytkownika poprzez przeprowadzanie podstawowego rozumowania, takiego jak rozumowanie dotyczące kategorii obiektów lub opisów wysokiego poziomu”.

Marzenie roboty ogólnego przeznaczenia które mogą pomóc ludziom we wszystkim, co się pojawi — czy to w domu, w środowisku komercyjnym, czy w środowisku przemysłowym — nie będzie osiągalne, dopóki roboty nie będą mogły uczyć się w ruchu. To, co wydaje nam się najbardziej podstawowym instynktem, jest dla robotów złożoną kombinacją rozumienia kontekstu, zdolności do rozumowania i podejmowania działań w celu rozwiązania problemów, których się nie spodziewano. Zaprogramowanie ich, aby odpowiednio reagowały na różne nieplanowane scenariusze, jest niemożliwe, dlatego muszą umieć uogólniać i uczyć się na podstawie doświadczenia, tak jak ludzie.

RT-2 to krok w tym kierunku. Naukowcy przyznają jednak, że chociaż RT-2 może uogólniać koncepcje semantyczne i wizualne, nie jest jeszcze w stanie samodzielnie uczyć się nowych działań. Zamiast tego stosuje działania, które już zna, w nowych scenariuszach. Być może RT-3 lub 4 będą w stanie przenieść te umiejętności na wyższy poziom. W międzyczasie, jak podsumowuje zespół blogu, „Chociaż wciąż pozostaje wiele do zrobienia, aby umożliwić pomocnym robotom w środowiskach skoncentrowanych na człowieku, RT-2 pokazuje nam ekscytującą przyszłość robotyki na wyciągnięcie ręki”.

Kredytowych Image: Google DeepMind

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Motoryzacja / pojazdy elektryczne, Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Przesunięcia bloków. Modernizacja własności offsetu środowiskowego. Dostęp tutaj.

- Źródło: https://singularityhub.com/2023/08/02/deepminds-chatgpt-like-brain-for-robots-lets-them-learn-from-the-internet/

- :ma

- :Jest

- :nie

- $W GÓRĘ

- 12

- 32

- 700

- a

- zdolność

- Zdolny

- O nas

- uznać

- Działania

- działania

- Wszystkie kategorie

- Alfabet

- już

- również

- ilość

- an

- i

- Inne

- Przewiduje

- Aplikuj

- odpowiednio

- SĄ

- na około

- AS

- At

- Autorzy

- dostępny

- z dala

- Banan

- na podstawie

- podstawowy

- BE

- być

- jest

- BEST

- pomiędzy

- Poza

- Miliard

- Bot

- Mózg

- ale

- by

- wezwanie

- Połączenia

- CAN

- możliwości

- nieść

- walizka

- kategorie

- ChatGPT

- Wybierając

- kod

- połączenie

- jak

- handlowy

- sukcesy firma

- kompletny

- kompleks

- pojęcie

- Koncepcje

- kontekst

- kredyt

- klient

- Obsługa klienta

- dane

- postanowiła

- DeepMind

- Definiuje

- Stopień

- kaucja

- rozwinięty

- różne

- kierunek

- do

- zrobić

- Debel

- marzenie

- Drink

- każdy

- umożliwiać

- Umożliwia

- umożliwiając

- zakończenia

- energia

- środowiska

- ostatecznie

- przykład

- ekscytujący

- doświadczenie

- narażony

- ułatwione

- FAST

- Postać

- Znajdź

- znalezieniu

- Ustalenia

- i terminów, a

- następnie

- jedzenie

- W razie zamówieenia projektu

- Nasz formularz

- od

- przyszłość

- Ogólne

- Generować

- gigant

- Dać

- dany

- daje

- Go

- chwycić

- młotek

- Have

- pomoc

- pomocny

- pomoc

- na wysokim szczeblu

- Strona główna

- W jaki sposób

- How To

- HTML

- HTTPS

- Ludzie

- zidentyfikować

- if

- zdjęcia

- Rezultat

- niemożliwy

- ulepszony

- in

- zawierać

- obejmuje

- przemysłowy

- Informacja

- instrukcje

- Internet

- najnowszych

- IT

- JEGO

- jpg

- właśnie

- wiedza

- język

- duży

- Nazwisko

- Ostatni rok

- UCZYĆ SIĘ

- nauka

- pozwala

- poziom

- lubić

- Prawdopodobnie

- mało

- masa

- maszyna

- uczenie maszynowe

- wiele

- materiał

- Maksymalna szerokość

- Może..

- znaczenie

- w międzyczasie

- może

- model

- modele

- większość

- ruch

- wielokrotność

- Naturalny

- Potrzebować

- Nowości

- Następny

- Nie

- listopad

- przedmiot

- of

- on

- Online

- tylko

- na

- or

- Zlecenia

- Inne

- na zewnątrz

- koniec

- własny

- Papier

- parametry

- strony

- wzory

- Ludzie

- procent

- wykonać

- wykonywania

- może

- osoba

- wybierać

- kawałek

- plato

- Analiza danych Platona

- PlatoDane

- muzyka pop

- poprzedni

- problemy

- Program

- Programowanie

- opublikowany

- pytania

- Kurs

- raczej

- React

- powód

- odnosi

- Relacje

- wydany

- reprezentować

- reprezentowane

- wymagać

- Wymaga

- Badacze

- Odpowiadać

- odpowiadanie

- robot

- robotyka

- roboty

- skała

- s

- scenariusze

- scena

- wydaje

- widzi

- wyrok

- usługa

- zestaw

- ustawienie

- Short

- pokazane

- Targi

- Prosty

- ponieważ

- umiejętności

- mały

- So

- Tworzenie

- ROZWIĄZANIA

- kilka

- swoiście

- Ewolucja krok po kroku

- Cel

- Nadal

- Struktura

- sukces

- udany

- Z powodzeniem

- taki

- system

- stół

- Brać

- biorąc

- Zadanie

- zadania

- nauczony

- zespół

- tech

- że

- Połączenia

- ich

- Im

- następnie

- Tam.

- Te

- one

- rzeczy

- to

- tych

- chociaż?

- Przez

- czas

- zmęczony

- do

- razem

- Żetony

- Pociąg

- przeszkolony

- Trening

- transformator

- ogromny

- zrozumienie

- aż do

- us

- posługiwać się

- używany

- Użytkownik

- zastosowania

- za pomocą

- zazwyczaj

- różnorodność

- wizja

- była

- tydzień

- ważyć

- były

- Co

- cokolwiek

- jeśli chodzi o komunikację i motywację

- który

- Podczas

- będzie

- w

- w ciągu

- słowo

- słowa

- Praca

- działa

- by

- napisać

- napisał

- X

- rok

- jeszcze

- zefirnet