Naukowcy zajmujący się klimatem w USA opracowali systematyczne podejście do przekwalifikowania algorytmów sztucznej inteligencji do radzenia sobie w różnych sytuacjach. Zespół odkrył, że wbrew obiegowym opiniom, ponowne uczenie algorytmu na wcześniejszych poziomach często daje lepsze wyniki niż ponowne uczenie późniejszych.

Głębokie uczenie się to wysoce zaawansowany, czasem kontrowersyjny rodzaj uczenia maszynowego, w którym algorytmy komputerowe same uczą się ważnych cech systemu i uczą się klasyfikować jego naturę i przewidywać jego zachowanie, często z dokładnością przekraczającą możliwości człowieka. Być może najbardziej znanym pokazem głębokiego uczenia się w działaniu było zwycięstwo programu Google AlphaGo nad mistrzem gry w go Lee Sedolem w 2017 roku. Głębokie uczenie się ma jednak bardziej praktyczne zastosowania: może przewidywać fałdowanie białek, przeszukiwać biopsje tkanek pod kątem wczesnych oznak raka i przewidywać wzorce pogodowe.

Ponieważ jednak algorytmy głębokiego uczenia się nie są programowane przez zewnętrznego operatora, nie można ich po prostu przeprogramować. Zamiast tego, jeśli system się zmieni, algorytm musi zostać przeszkolony przy użyciu danych z nowego systemu. Jest to ważne w klimatologii, jeśli algorytmy głębokiego uczenia, które trenowały z wykorzystaniem dzisiejszych warunków klimatycznych, mają generować przydatne prognozy dotyczące warunków pogodowych w świecie dotkniętym zmianami klimatycznymi. Ten znany ludziom proces adaptacji wcześniejszych doświadczeń do nieznanych sytuacji jest znany informatykom jako uczenie się transferowe.

Głęboka tajemnica

Klimatolog Pedrama Hassanzadeha z Rice University w Teksasie wyjaśnia, że algorytmy głębokiego uczenia przetwarzają informacje w sekwencji warstw. „Informacje trafiają do warstwy, która wyodrębnia niektóre informacje, a następnie wysyła te informacje do innej warstwy, która wyodrębnia więcej informacji”. Ten proces ostatecznie generuje dane wyjściowe, ale jak wyjaśnia Hassanzadeh: „Nikt nie wie dokładnie, jakie jest zadanie każdej warstwy, ponieważ nie projektujemy żadnej z nich – wszystkich się uczymy”. Transfer learning wykorzystuje niewielką ilość dostępnych danych z nowego zestawu danych do przeszkolenia jednego (lub kilku) z tych poziomów, a Hassanzadeh mówi, że „ważne jest, który poziom wybierzesz”.

Mówi, że konwencjonalna mądrość mówi, że specyfika problemu jest opracowywana w najgłębszych warstwach sieci (w tych warstwach, które są najbliżej wyjścia). Dlatego, aby przeprowadzić nauczanie transferowe, najlepiej jest je przekwalifikować. „To, co zrobiono w przeszłości, to powiedzmy, że Google trenuje tysiącwarstwową sieć w Google Images, a następnie ktoś przynosi niewielką liczbę promieni rentgenowskich, więc ponownie szkolą warstwy 998 i 999” — wyjaśnia Hassanzadeh. Teraz on i jego koledzy zamiast tego przyjęli systematyczne podejście.

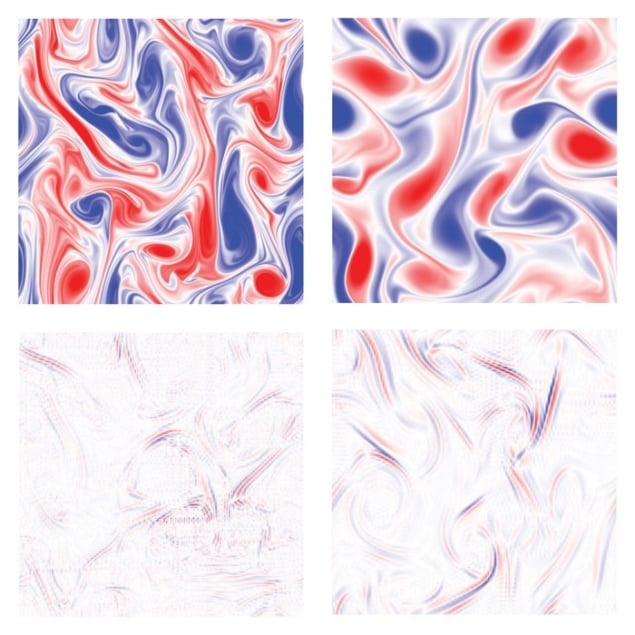

Naukowcy przeprowadzili symulacje zachowania płynów w wysokiej rozdzielczości w trzech różnych zestawach warunków. Wykorzystali te dane do wytrenowania trzech 10-warstwowych algorytmów głębokiego uczenia się w celu przewidywania zachowania płynów przy każdym z tych określonych parametrów. Zmienili niektóre parametry, takie jak liczba Reynoldsa (stosunek sił bezwładności do sił lepkości) lub wirowość płynu w każdym przypadku i przeprowadzili kolejny zestaw symulacji o wysokiej rozdzielczości, aby przewidzieć zachowanie nowych płynów. W każdym z trzech przypadków trenowali te same algorytmy na nowych danych. Na koniec przeprowadzili uczenie się starych algorytmów na niewielkim podzbiorze nowych danych, przyglądając się efektom ponownego uczenia każdego poziomu i porównując wydajność przeszkolonego starego algorytmu z algorytmem, który został wyszkolony od podstaw na nowych danych.

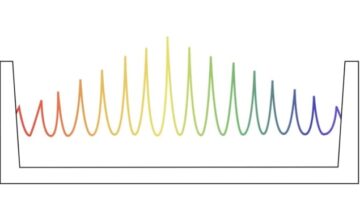

Przekwalifikowanie płytkich warstw

Wyniki były zaskakujące. „W tym artykule stwierdziliśmy, że najpłytsze warstwy były najlepsze do przekwalifikowania” – mówi Hassanzadeh. Dostęp do przewidywanego sygnału wytwarzanego przez ponowne uczenie każdej warstwy z kolei dał im wgląd w wpływ każdej warstwy na ten końcowy sygnał. Dlatego po prostu wykorzystali analizę widmową każdego sygnału, aby zobaczyć, jak każda warstwa modyfikuje każdą obecną częstotliwość. Niektóre poziomy kontrolowały niskie częstotliwości i przydatne było ponowne ich przeszkolenie, ponieważ przechwytywały płynnie zmieniające się, makroskopowe cechy algorytmu. Tymczasem inne poziomy przewidywały szczegóły, a przekwalifikowanie ich samych było prawie bezużyteczne. Naukowcy opracowali protokół określania najważniejszych poziomów w danym przypadku. „Nie chcieliśmy mówić, że w tym dokumencie mamy praktyczną zasadę” — mówi Hassanzadeh. „Teraz znaleźliśmy systemy, w których na przykład środkowe warstwy są najlepsze [do przekwalifikowania]”.

Sztuczna inteligencja upraszcza obliczenia właściwości elektronicznych

Zespół opisuje pracę w artykule opublikowanym w Nexus PNAS.

„Myślę, że to naprawdę interesujący artykuł” — mówi astrofizyk i ekspert w dziedzinie uczenia maszynowego Shirley Ho Flatiron Institute w Nowym Jorku. Dodaje: „Z drugiej strony w wielu innych dyscyplinach naukowych używamy analizy spektralnej już od dłuższego czasu, więc myślę, że pytanie brzmi, czy zastosowanie jej do wielu warstw jest znaczącym wkładem. Mam wrażenie, że prawdopodobnie jest to jedna z tych rzeczy, które są w umysłach ludzi, ale nikt tego nie napisał. To może być jeden z tych świetnych artykułów, w których po wypowiedzeniu staje się to oczywiste dla wszystkich”.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- Platoblockchain. Web3 Inteligencja Metaverse. Wzmocniona wiedza. Dostęp tutaj.

- Źródło: https://physicsworld.com/a/new-approach-retrains-deep-neural-networks-to-deal-with-changes-in-complex-systems/

- 2017

- a

- O nas

- dostęp

- Osiąga

- Działania

- Dodaje

- zaawansowany

- algorytm

- Algorytmy

- Wszystkie kategorie

- sam

- ilość

- analiza

- i

- Inne

- aplikacje

- Stosowanie

- podejście

- sztuczny

- sztuczna inteligencja

- dostępny

- bo

- BEST

- Ulepsz Swój

- Dolny

- Przynosi

- Obliczenia

- Rak

- nie może

- możliwości

- walizka

- Etui

- mistrz

- zmiana

- Zmiany

- Miasto

- Klimat

- Zmiana klimatu

- koledzy

- porównanie

- kompleks

- komputer

- Warunki

- przeciwnie

- wkład

- kontrolowania

- kontrowersyjny

- Konwencjonalny

- dane

- zbiór danych

- sprawa

- głęboko

- głęboka nauka

- najgłębszy

- Wnętrze

- detale

- określaniu

- rozwinięty

- dyktuje

- Różnice

- różne

- nie

- podczas

- każdy

- Wcześniej

- Wcześnie

- efekt

- bądź

- Elektroniczny

- ostatecznie

- dokładnie

- przykład

- doświadczenie

- ekspert

- Objaśnia

- zewnętrzny

- Wyciągi

- znajomy

- sławny

- Korzyści

- kilka

- Postać

- finał

- W końcu

- Siły

- znaleziono

- Częstotliwość

- od

- otrzymać

- dany

- Go

- Goes

- Google'a

- wspaniały

- Zarządzanie

- ręka

- mający

- wysoka rozdzielczość

- wysoko

- W jaki sposób

- Jednak

- HTTPS

- Ludzie

- obraz

- zdjęcia

- ważny

- in

- Informacja

- zamiast

- Instytut

- Inteligencja

- ciekawy

- problem

- IT

- Praca

- znany

- warstwa

- nioski

- UCZYĆ SIĘ

- dowiedziałem

- nauka

- Lee

- poziom

- poziomy

- Lista

- długo

- długi czas

- poszukuje

- maszyna

- uczenie maszynowe

- robić

- wiele

- Maksymalna szerokość

- W międzyczasie

- Środkowy

- umysły

- model

- jeszcze

- większość

- wielokrotność

- Natura

- sieć

- sieci

- sieci neuronowe

- Nowości

- I Love New York

- nowy jork

- numer

- oczywista

- Stary

- ONE

- koncepcja

- operator

- Inne

- Papier

- Papiery

- parametry

- Przeszłość

- wzory

- Ludzie na

- wykonać

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- może

- plato

- Analiza danych Platona

- PlatoDane

- gracz

- Praktyczny

- przewidzieć

- Przewiduje

- Przewidywania

- teraźniejszość

- Wcześniejszy

- prawdopodobnie

- Problem

- wygląda tak

- Wytworzony

- Program

- zaprogramowany

- Białko

- protokół

- pod warunkiem,

- opublikowany

- pytanie

- stosunek

- rozpoznać

- Badacze

- Efekt

- Ryż

- Zasada

- taki sam

- mówią

- Skala

- naukowy

- Naukowiec

- Naukowcy

- Ekran

- Sekwencja

- zestaw

- Zestawy

- płytki

- pokazane

- Signal

- znaczący

- znaki

- po prostu

- sytuacje

- mały

- płynnie

- So

- kilka

- specyficzny

- Widmowy

- znaczny

- taki

- zaskakujący

- system

- systemy

- zespół

- texas

- Połączenia

- sami

- w związku z tym

- rzeczy

- trzy

- miniatur

- czas

- do

- dzisiaj

- Top

- Pociąg

- przeszkolony

- Trening

- pociągi

- przenieść

- prawdziwy

- SKRĘCAĆ

- dla

- nieznany

- uniwersytet

- us

- Pogoda

- Co

- czy

- który

- mądrość

- Praca

- pracował

- świat

- napisany

- You

- zefirnet