Os algoritmos de inteligência artificial são projetados para aprender aos trancos e barrancos. Em vez de atualizar continuamente sua base de conhecimento com novas informações ao longo do tempo, como os humanos fazem, os algoritmos podem aprender apenas durante a fase de treinamento. Depois disso, seu conhecimento permanece congelado; eles realizam a tarefa para a qual foram treinados sem serem capazes de continuar aprendendo enquanto o fazem. Para aprender até mesmo uma coisa nova, os algoritmos devem ser treinados novamente do zero. É como se toda vez que você conhecesse uma nova pessoa, a única maneira de aprender o nome dela fosse reiniciar seu cérebro.

O treinamento do zero pode levar a um comportamento conhecido como esquecimento catastrófico, em que uma máquina incorpora novos conhecimentos ao custo de esquecer quase tudo o que já aprendeu. Essa situação surge devido à maneira como os algoritmos de IA mais poderosos de hoje, chamados redes neurais, aprendem coisas novas.

Esses algoritmos são baseados livremente em nossos cérebros, onde o aprendizado envolve alterar a força das conexões entre os neurônios. Mas esse processo fica complicado. As conexões neurais também representam o conhecimento passado, portanto, alterá-las demais causará esquecimento.

As redes neurais biológicas desenvolveram estratégias ao longo de centenas de milhões de anos para garantir que informações importantes permaneçam estáveis. Mas as redes neurais artificiais de hoje lutam para encontrar um bom equilíbrio entre o conhecimento novo e o antigo. Suas conexões são sobrescritas com muita facilidade quando a rede vê novos dados, o que pode resultar em uma falha repentina e grave no reconhecimento de informações anteriores.

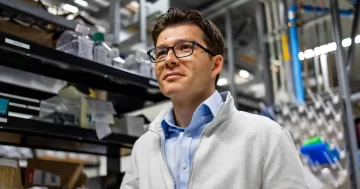

Para ajudar a combater isso, Cristóvão Kanan, um cientista da computação de 41 anos da Universidade de Rochester, ajudou a estabelecer um novo campo de pesquisa em IA conhecido como aprendizado contínuo. Seu objetivo é que a IA continue aprendendo coisas novas a partir de fluxos contínuos de dados e faça isso sem esquecer tudo o que veio antes.

Kanan tem brincado com inteligência de máquina quase toda a sua vida. Quando criança na zona rural de Oklahoma, que só queria se divertir com as máquinas, ele ensinou bots a jogar os primeiros jogos de computador para vários jogadores. Isso o fez se perguntar sobre a possibilidade de inteligência geral artificial – uma máquina com a capacidade de pensar como um humano em todos os sentidos. Isso o fez se interessar por como as mentes funcionam, e ele se formou em filosofia e ciência da computação na Oklahoma State University antes de seus estudos de pós-graduação o levarem para a Universidade da Califórnia, em San Diego.

Agora Kanan encontra inspiração não apenas nos videogames, mas também em assistir sua filha de quase 2 anos aprender sobre o mundo, com cada nova experiência de aprendizado baseada na última. Por causa do trabalho dele e de outros, o esquecimento catastrófico não é mais tão catastrófico.

Quanta conversou com Kanan sobre memórias de máquina, quebrando as regras de treinamento de redes neurais e se a IA alcançará o aprendizado em nível humano. A entrevista foi condensada e editada para maior clareza.

Como sua formação em filosofia impacta a maneira como você pensa sobre seu trabalho?

Tem me servido muito bem como acadêmico. A filosofia ensina a você: “Como você faz argumentos racionais” e “Como você analisa os argumentos dos outros?” Isso é muito do que você faz na ciência. Ainda tenho redações da época sobre as falhas do teste de Turing e coisas assim. E então essas coisas eu ainda penso muito.

Meu laboratório foi inspirado por fazer a pergunta: Bem, se não podemos fazer X, como poderemos fazer Y? Aprendemos com o tempo, mas as redes neurais, em geral, não. Você os treina uma vez. É uma entidade fixa depois disso. E isso é uma coisa fundamental que você precisa resolver se quiser fazer inteligência artificial geral um dia. Se ele não pode aprender sem mexer em seu cérebro e reiniciar do zero, você realmente não vai chegar lá, certo? Essa é uma capacidade pré-requisito para mim.

Como os pesquisadores lidaram com o esquecimento catastrófico até agora?

O método mais bem-sucedido, chamado replay, armazena experiências passadas e as reproduz durante o treinamento com novos exemplos, para que não sejam perdidas. É inspirado na consolidação da memória em nosso cérebro, onde durante o sono as codificações de alto nível das atividades do dia são “repetidas” à medida que os neurônios se reativam.

Em outras palavras, para os algoritmos, o novo aprendizado não pode erradicar completamente o aprendizado passado, pois estamos misturando experiências passadas armazenadas.

Existem três estilos para fazer isso. O estilo mais comum é o “replay verídico”, onde os pesquisadores armazenam um subconjunto das entradas brutas – por exemplo, as imagens originais para uma tarefa de reconhecimento de objetos – e depois misturam essas imagens armazenadas do passado com novas imagens a serem aprendidas. A segunda abordagem reproduz representações compactadas das imagens. Um terceiro método muito menos comum é o “replay generativo”. Aqui, uma rede neural artificial realmente gera uma versão sintética de uma experiência passada e depois mistura esse exemplo sintético com novos exemplos. Meu laboratório se concentrou nos dois últimos métodos.

Infelizmente, porém, o replay não é uma solução muito satisfatória.

Por que não?

Para aprender algo novo, a rede neural precisa armazenar pelo menos algumas informações sobre cada conceito que aprendeu no passado. E de uma perspectiva neurocientífica, a hipótese é que você e eu temos uma repetição de uma experiência relativamente recente – não algo que aconteceu em nossa infância – para evitar o esquecimento dessa experiência recente. Considerando que da maneira como fazemos isso em redes neurais profundas, isso não é verdade. Ele não precisa necessariamente armazenar tudo o que viu, mas precisa armazenar algo sobre cada tarefa que aprendeu no passado para usar o replay. E não está claro o que ele deve armazenar. Então, replay como é feito hoje ainda parece que não está até lá.

Se pudéssemos resolver completamente o esquecimento catastrófico, isso significaria que a IA poderia aprender coisas novas continuamente ao longo do tempo?

Não exatamente. Acho que as grandes, grandes, grandes questões em aberto no campo da aprendizagem contínua não estão no esquecimento catastrófico. O que realmente me interessa é: como o aprendizado passado torna o aprendizado futuro mais eficiente? E como aprender algo no futuro corrige os aprendizados do passado? Essas são coisas que poucas pessoas estão medindo, e acho que fazer isso é uma parte crítica para impulsionar o campo porque, na verdade, não se trata apenas de esquecer as coisas. É sobre se tornar um aluno melhor.

É aí que eu acho que o campo está perdendo a floresta para as árvores. Grande parte da comunidade está configurando o problema de maneiras que não combinam com questões biológicas interessantes ou aplicações de engenharia interessantes. Não podemos deixar todo mundo fazer o mesmo problema de brinquedo para sempre. Você tem que dizer: Qual é a nossa tarefa de desafio? Como podemos empurrar as coisas para a frente?

Então, por que você acha que a maioria das pessoas está se concentrando nesses problemas simples?

Só posso especular. A maior parte do trabalho é feito por alunos que estão seguindo trabalhos anteriores. Eles estão copiando a configuração do que outros fizeram e mostrando alguns pequenos ganhos de desempenho com as mesmas medidas. Criar novos algoritmos tem mais probabilidade de levar a uma publicação, mesmo que esses algoritmos não estejam realmente nos permitindo fazer progressos significativos no aprendizado contínuo. O que me surpreende é que o mesmo tipo de trabalho é produzido por grandes empresas que não têm os mesmos incentivos, exceto o trabalho conduzido por estagiários.

Além disso, este trabalho não é trivial. Precisamos estabelecer o experimento correto e a configuração algorítmica para medir se o aprendizado passado ajuda no aprendizado futuro. O grande problema é que não temos bons conjuntos de dados para estudar o aprendizado contínuo no momento. Quero dizer, estamos basicamente pegando conjuntos de dados existentes que são usados no aprendizado de máquina tradicional e os redirecionando.

Essencialmente, no dogma do aprendizado de máquina (ou pelo menos sempre que começo a ensinar aprendizado de máquina), temos um conjunto de treinamento, temos um conjunto de teste – treinamos no conjunto de treinamento, testamos no conjunto de teste. O aprendizado contínuo quebra essas regras. Seu conjunto de treinamento torna-se então algo que evolui à medida que o aluno aprende. Mas ainda estamos limitados aos conjuntos de dados existentes. Precisamos trabalhar isso. Precisamos de um ambiente de aprendizado contínuo realmente bom, no qual possamos realmente nos esforçar.

Como seria o ambiente ideal de aprendizagem contínua?

É mais fácil dizer o que não é do que o que é. Eu estava em um painel em que identificamos isso como um problema crítico, mas não é um em que acho que alguém tenha a resposta imediatamente.

Posso dizer-lhe as propriedades que pode ter. Então, por enquanto, vamos supor que os algoritmos de IA não sejam agentes incorporados em simulações. Então, no mínimo, idealmente, estamos aprendendo com vídeos, ou algo assim, como fluxos de vídeo multimodais, e esperamos fazer mais do que apenas classificação [de imagens estáticas].

Há muitas perguntas em aberto sobre isso. Eu estava em um workshop de aprendizado contínuo há alguns anos e algumas pessoas como eu diziam: “Temos que parar de usar um conjunto de dados chamado MNIST, é muito simples”. E então alguém disse: “OK, bem, vamos fazer um aprendizado incremental do [videogame baseado em estratégia] StarCraft”. E estou fazendo isso também agora por várias razões, mas acho que isso também não chega. A vida é uma coisa muito mais rica do que aprender a jogar StarCraft.

Como seu laboratório tentou projetar algoritmos que possam continuar aprendendo ao longo do tempo?

Com meu ex-aluno Tyler Hayes, eu foi pioneiro em uma tarefa de aprendizado contínuo para o raciocínio analógico. Achamos que seria uma boa área para estudar a ideia de transferência de aprendizagem, onde você adquire habilidades e agora precisa usar habilidades mais complexas para resolver problemas mais complexos. Especificamente, medimos a transferência para trás – quão bem aprender algo no passado o ajuda no futuro e vice-versa. E encontramos boas evidências de transferência, muito mais significativas do que para uma tarefa simples como reconhecimento de objetos.

Seu laboratório também se concentra no treinamento de algoritmos para aprender continuamente com um exemplo por vez ou com conjuntos muito pequenos de exemplos. Como isso ajuda?

Muitas configurações de aprendizado contínuo ainda usam lotes muito grandes de exemplos. Então eles vão essencialmente dizer ao algoritmo: “Aqui estão 100,000 coisas; aprendê-los. Aqui estão as próximas 100,000 coisas; aprendê-los”. Isso realmente não combina com o que eu diria ser a aplicação do mundo real, que é: “Aqui está uma coisa nova; aprenda. Aqui está outra coisa nova; aprenda."

Se queremos que a IA aprenda mais como nós, devemos também tentar replicar como os humanos aprendem coisas diferentes em diferentes idades, sempre refinando nosso conhecimento?

Acho que é um caminho muito frutífero para progredir neste campo. As pessoas me dizem que estou obcecada com o desenvolvimento agora que tenho um filho, mas posso ver que minha filha é capaz de aprender de uma só vez, onde ela me vê fazer algo uma vez e pode copiá-lo imediatamente. E os algoritmos de aprendizado de máquina não podem fazer nada assim hoje.

Realmente abriu meus olhos. Deve haver muito mais coisas acontecendo em nossas cabeças do que em nossas redes neurais modernas. É por isso que acho que o campo precisa ir em direção a essa ideia de aprendizado ao longo do tempo, onde os algoritmos se tornam melhores aprendizes ao se basearem em experiências passadas.

Você acha que a IA realmente aprenderá da mesma maneira que os humanos?

Eu acho que eles vão. Definitivamente. É muito mais promissor hoje porque há tantas pessoas trabalhando no campo. Mas ainda precisamos de mais criatividade. Grande parte da cultura na comunidade de aprendizado de máquina é uma abordagem de seguir o líder.

Penso em nós apenas como máquinas bioquímicas e, eventualmente, descobriremos como fazer nossos algoritmos para as arquiteturas corretas que acho que terão mais recursos do que têm hoje. Não há nenhum argumento convincente para mim que diga que é impossível.