Um sistema de inteligência artificial (IA) recém-criado baseado em aprendizado de reforço profundo (DRL) pode reagir a invasores em um ambiente simulado e bloquear 95% dos ataques cibernéticos antes que eles aumentem.

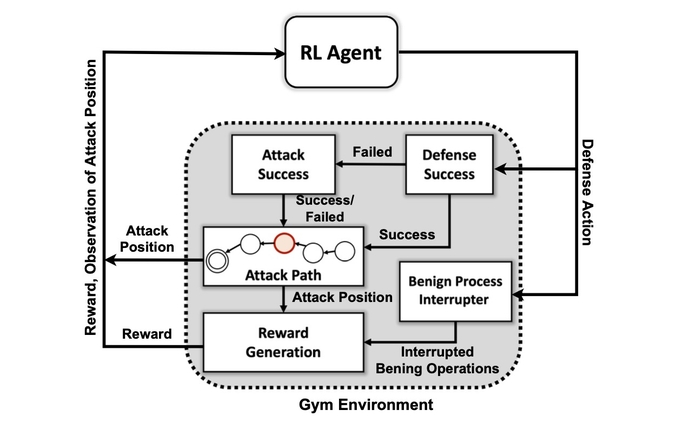

Isso é de acordo com os pesquisadores do Pacific Northwest National Laboratory do Departamento de Energia, que construíram uma simulação abstrata do conflito digital entre invasores e defensores em uma rede e treinaram quatro redes neurais DRL diferentes para maximizar as recompensas com base na prevenção de comprometimentos e na minimização da interrupção da rede.

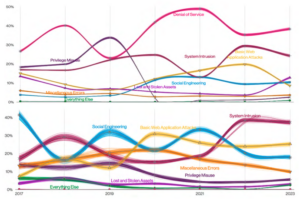

Os atacantes simulados usaram uma série de táticas baseadas na MITER ATT & CK classificação do framework para passar da fase inicial de acesso e reconhecimento para outras fases de ataque até atingirem seu objetivo: a fase de impacto e exfiltração.

O treinamento bem-sucedido do sistema de IA no ambiente de ataque simplificado demonstra que respostas defensivas a ataques em tempo real podem ser tratadas por um modelo de IA, diz Samrat Chatterjee, cientista de dados que apresentou o trabalho da equipe na reunião anual da Associação para o Avanço da Inteligência Artificial em Washington, DC em 14 de fevereiro.

“Você não quer mudar para arquiteturas mais complexas se não puder mostrar a promessa dessas técnicas”, diz ele. “Queríamos primeiro demonstrar que podemos realmente treinar um DRL com sucesso e mostrar alguns bons resultados de teste antes de seguir em frente.”

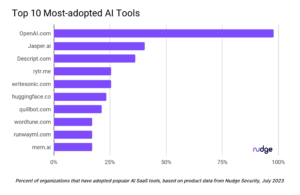

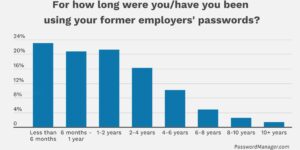

A aplicação de técnicas de aprendizado de máquina e inteligência artificial em diferentes campos da segurança cibernética tornou-se uma tendência importante na última década, desde a integração inicial do aprendizado de máquina em gateways de segurança de e-mail no inicio dos anos 2010 aos esforços mais recentes para use o ChatGPT para analisar o código ou realizar análises forenses. Agora, a maioria dos produtos de segurança tem – ou afirmam ter – alguns recursos alimentados por algoritmos de aprendizado de máquina treinados em grandes conjuntos de dados.

No entanto, criar um sistema de IA capaz de defesa proativa continua sendo uma aspiração, e não prática. Embora uma variedade de obstáculos permaneça para os pesquisadores, a pesquisa do PNNL mostra que um defensor da IA pode ser possível no futuro.

“Avaliar vários algoritmos DRL treinados em diversas configurações adversárias é um passo importante em direção a soluções práticas de defesa cibernética autônoma”, a equipe de pesquisa do PNNL afirmou em seu papel. “Nossos experimentos sugerem que os algoritmos DRL sem modelo podem ser efetivamente treinados em perfis de ataque de vários estágios com diferentes níveis de habilidade e persistência, gerando resultados de defesa favoráveis em configurações contestadas”.

Como o sistema usa o MITRE ATT&CK

O primeiro objetivo da equipe de pesquisa era criar um ambiente de simulação personalizado com base em um kit de ferramentas de código aberto conhecido como Academia de IA aberta. Usando esse ambiente, os pesquisadores criaram entidades atacantes de diferentes níveis de habilidade e persistência com a capacidade de usar um subconjunto de 7 táticas e 15 técnicas da estrutura MITRE ATT&CK.

Os objetivos dos agentes atacantes são percorrer as sete etapas da cadeia de ataque, do acesso inicial à execução, da persistência ao comando e controle e da coleta ao impacto.

Para o atacante, adaptar suas táticas ao estado do ambiente e às ações atuais do defensor pode ser complexo, diz Chatterjee do PNNL.

“O adversário tem que navegar desde um estado de reconhecimento inicial até algum estado de exfiltração ou impacto”, diz ele. “Não estamos tentando criar uma espécie de modelo para parar um adversário antes que ele entre no ambiente – assumimos que o sistema já está comprometido.”

Os pesquisadores usaram quatro abordagens para redes neurais baseadas no aprendizado por reforço. O aprendizado por reforço (RL) é uma abordagem de aprendizado de máquina que emula o sistema de recompensa do cérebro humano. Uma rede neural aprende fortalecendo ou enfraquecendo certos parâmetros de neurônios individuais para recompensar soluções melhores, conforme medido por uma pontuação que indica o desempenho do sistema.

O aprendizado por reforço essencialmente permite que o computador crie uma abordagem boa, mas não perfeita, para o problema em questão, diz Mahantesh Halappanavar, pesquisador do PNNL e autor do artigo.

“Sem usar qualquer aprendizado por reforço, ainda poderíamos fazê-lo, mas seria um problema realmente grande que não teria tempo suficiente para realmente criar um bom mecanismo”, diz ele. “Nossa pesquisa … nos dá esse mecanismo em que o aprendizado por reforço profundo é uma espécie de imitação de parte do próprio comportamento humano, até certo ponto, e pode explorar esse vasto espaço com muita eficiência”.

Não está pronto para o horário nobre

Os experimentos descobriram que um método específico de aprendizado por reforço, conhecido como Deep Q Network, criou uma solução forte para o problema defensivo, pegando 97% dos atacantes no conjunto de dados de teste. No entanto, a pesquisa é apenas o começo. Os profissionais de segurança não devem procurar um companheiro de IA para ajudá-los na resposta a incidentes e na análise forense tão cedo.

Entre os muitos problemas que ainda precisam ser resolvidos está o aprendizado por reforço e as redes neurais profundas para explicar os fatores que influenciaram suas decisões, uma área de pesquisa chamada aprendizado por reforço explicável (XRL).

Além disso, a robustez dos algoritmos de IA e encontrar formas eficientes de treinar as redes neurais são problemas que precisam ser resolvidos, diz Chatterjee do PNNL.

“Criar um produto – essa não foi a principal motivação para esta pesquisa”, diz ele. “Isso foi mais sobre experimentação científica e descoberta algorítmica.”

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- Platoblockchain. Inteligência Metaverso Web3. Conhecimento Ampliado. Acesse aqui.

- Fonte: https://www.darkreading.com/emerging-tech/researchers-create-ai-cyber-defender-that-reacts-to-attackers

- 7

- 95%

- a

- habilidade

- Sobre

- RESUMO

- Acesso

- Segundo

- ações

- Adição

- avanço

- adversarial

- agentes

- AI

- Alimentado por AI

- algorítmico

- algoritmos

- Todos os Produtos

- permite

- já

- análise

- analisar

- e

- anual

- Aplicação

- abordagem

- se aproxima

- ÁREA

- artificial

- inteligência artificial

- Inteligência artificial (AI)

- Associação

- ataque

- Ataques

- autor

- Autônomo

- baseado

- tornam-se

- antes

- Melhor

- entre

- Grande

- Bloquear

- Cérebro

- construído

- chamado

- não podes

- capaz

- certo

- cadeia

- ChatGPT

- reivindicar

- classificação

- coleção

- como

- integrações

- Comprometido

- computador

- Conduzir

- conflito

- continua

- ao controle

- poderia

- crio

- criado

- Criar

- Atual

- personalizadas

- cibernético

- ataques cibernéticos

- Cíber segurança

- dados,

- cientista de dados

- conjunto de dados

- conjuntos de dados

- dc

- década

- decisão

- decisões

- profundo

- Defensores

- Defesa

- defensiva

- demonstrar

- demonstra

- Departamento

- diferente

- digital

- descoberta

- Rompimento

- diferente

- Cedo

- efetivamente

- eficiente

- eficientemente

- esforços

- segurança de email

- energia

- suficiente

- entidades

- Meio Ambiente

- essencialmente

- avaliação

- Mesmo

- execução

- exfiltração

- Explicação

- explorar

- fatores

- Funcionalidades

- poucos

- Campos

- descoberta

- Primeiro nome

- fluxo

- Forense

- forense

- para a frente

- encontrado

- Quadro

- da

- futuro

- ter

- obtendo

- dá

- meta

- Objetivos

- Bom estado, com sinais de uso

- mão

- ajudar

- HOT

- Como funciona o dobrador de carta de canal

- HTTPS

- humano

- Obstáculos

- Impacto

- importante

- in

- incidente

- resposta a incidentes

- Individual

- influenciado

- do estado inicial,

- integração

- Inteligência

- IT

- se

- Tipo

- conhecido

- laboratório

- grande

- aprendizagem

- níveis

- olhar

- máquina

- aprendizado de máquina

- a Principal

- muitos

- max-width

- Maximizar

- mecanismo

- reunião

- método

- minimizando

- modelo

- mais

- Motivação

- mover

- em movimento

- múltiplo

- Nacional

- Navegar

- você merece...

- rede

- redes

- rede neural

- redes neurais

- Neurônios

- aberto

- open source

- Outros

- Pacífico

- Papel

- parâmetros

- passado

- perfeita

- executa

- persistência

- fase

- platão

- Inteligência de Dados Platão

- PlatãoData

- possível

- alimentado

- Prática

- apresentado

- impedindo

- Prime

- Proactive

- Problema

- problemas

- Produtos

- Perfis

- promessa

- RE

- alcançado

- Reagir

- Reage

- pronto

- reais

- em tempo real

- recentemente

- permanecem

- pesquisa

- investigador

- pesquisadores

- resposta

- Recompensa

- Recompensas

- robustez

- diz

- científico

- Cientista

- segurança

- Série

- conjunto

- Configurações

- Sete

- rede de apoio social

- mostrar

- Shows

- simplificada

- simulação

- habilidade

- solução

- Soluções

- alguns

- fonte

- Espaço

- específico

- começo

- Estado

- Passo

- Passos

- Ainda

- Dê um basta

- fortalecimento

- mais forte,

- bem sucedido

- entraram com sucesso

- .

- tática

- Profissionais

- técnicas

- ensaio

- A

- O Estado

- deles

- Através da

- tempo

- para

- kit de ferramentas

- para

- Trem

- treinado

- Training

- Trend

- para

- us

- usar

- variedade

- Grande

- querido

- Washington

- maneiras

- enquanto

- QUEM

- precisarão

- dentro

- sem

- Atividades:

- seria

- produzindo

- Vocês

- zefirnet