Modelele mari de limbaj (LLM) recente au permis progrese uriașe în înțelegerea limbajului natural. Cu toate acestea, aceștia sunt predispuși să genereze explicații încrezătoare, dar fără sens, ceea ce reprezintă un obstacol semnificativ în stabilirea încrederii utilizatorilor. În această postare, arătăm cum să încorporăm feedback uman cu privire la lanțurile de raționament incorecte pentru raționamentul multi-hop pentru a îmbunătăți performanța acestor sarcini. În loc să colectăm lanțurile de raționament de la zero întrebând oameni, în schimb, învățăm din feedback-ul uman bogat asupra lanțurilor de raționament generate de model folosind abilitățile de incitare ale LLM-urilor. Colectăm două astfel de seturi de date de feedback uman sub formă de (corecție, explicație, tip de eroare) pentru seturi de date StrategyQA și Sports Understanding și evaluăm mai mulți algoritmi obișnuiți pentru a învăța din astfel de feedback. Metodele noastre propuse funcționează în mod competitiv la stimularea lanțului de gândire folosind baza Flan-T5, iar a noastră este mai bună în a aprecia corectitudinea propriului răspuns.

Prezentare generală a soluțiilor

Odată cu apariția modelelor mari de limbaj, domeniul a înregistrat progrese extraordinare în ceea ce privește diferitele standarde de procesare a limbajului natural (NLP). Printre acestea, progresul a fost izbitor în ceea ce privește sarcinile relativ mai simple, cum ar fi contextul scurt sau răspunsul la întrebări concrete, în comparație cu sarcinile mai dificile care necesită raționament, cum ar fi răspunsul la întrebări cu mai multe hop. Performanța anumitor sarcini folosind LLM-uri poate fi similară cu ghicitul aleatoriu la scari mai mici, dar se îmbunătățește semnificativ la scari mai mari. În ciuda acestui fapt, abilitățile de stimulare ale LLM-urilor au potențialul de a oferi unele fapte relevante necesare pentru a răspunde la întrebare.

Cu toate acestea, este posibil ca acele modele să nu genereze în mod fiabil lanțuri de raționament sau explicații corecte. Acele explicații încrezătoare, dar fără sens, sunt și mai răspândite atunci când LLM-urile sunt antrenate folosind Reinforcement Learning from Human Feedback (RLHF), unde poate apărea hackingul de recompense.

Motivați de acest lucru, încercăm să abordăm următoarea întrebare de cercetare: putem îmbunătăți raționamentul LLM-urilor învățând din feedbackul uman asupra lanțurilor de raționament generate de model? Următoarea figură oferă o privire de ansamblu asupra abordării noastre: mai întâi solicităm modelului să genereze lanțuri de raționament pentru întrebări cu mai multe hop, apoi colectăm feedback uman divers asupra acestor lanțuri pentru diagnosticare și propunem algoritmi de antrenament pentru a învăța din datele colectate.

Colectăm feedback uman divers cu privire la două seturi de date de raționament multi-hop, StrategyQA și Sports Understanding de la BigBench. Pentru fiecare întrebare și lanț de raționament generat de model, colectăm lanțul de raționament corect, tipul de eroare din lanțul de raționament generat de model și o descriere (în limbaj natural) a motivului pentru care acea eroare este prezentată în lanțul de raționament furnizat. Setul de date final conține feedback pentru 1,565 de mostre de la StrategyQA și 796 de exemple pentru Sports Understanding.

Propunem mai mulți algoritmi de antrenament pentru a învăța din feedback-ul colectat. În primul rând, propunem o variantă de auto-consecvență în stimularea lanțului de gândire, luând în considerare o variantă ponderată a acesteia care poate fi învățată din feedback. În al doilea rând, propunem rafinarea iterativă, în care rafinăm iterativ lanțul de raționament generat de model până când este corect. Demonstrăm empiric pe cele două seturi de date că reglarea fină a unui LLM, și anume Flan-T5 folosind algoritmii propuși, funcționează în mod comparabil cu linia de bază de învățare în context. Mai important, arătăm că modelul reglat fin este mai bine să judece dacă propriul răspuns este corect în comparație cu modelul de bază Flan-T5.

De colectare a datelor

În această secțiune, descriem detaliile feedback-ului pe care l-am colectat și protocolul de adnotare urmat în timpul colectării datelor. Am colectat feedback pentru generațiile de modele pe baza a două seturi de date bazate pe raționament: StrategyQA și Sports Understanding de la BigBench. Am folosit GPT-J pentru a genera răspunsul pentru StrategyQA și Flan-T5 pentru a genera răspunsul pentru setul de date Sports Understanding. În fiecare caz, modelul a fost solicitat cu k exemple în context care conțineau întrebare, răspuns și explicație, urmate de întrebarea test.

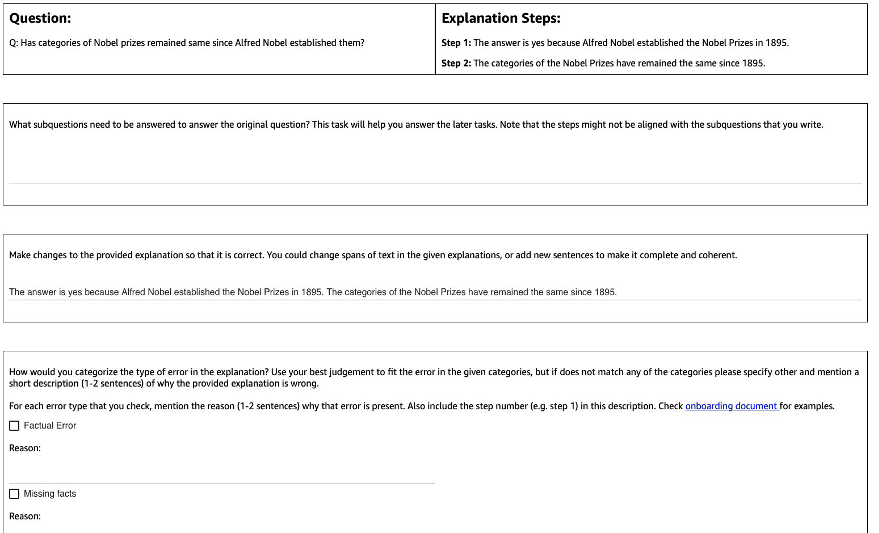

Figura următoare arată interfața pe care am folosit-o. Adnotatorilor li se oferă întrebarea, răspunsul generat de model și explicația împărțită în pași.

Pentru fiecare întrebare, am colectat următorul feedback:

- Subîntrebări – Adnotatorii descompun întrebarea inițială în subîntrebări mai simple necesare pentru a răspunde la întrebarea inițială. Această sarcină a fost adăugată după un pilot în care am constatat că adăugarea acestei sarcini ajută la pregătirea adnotatorilor și la îmbunătățirea calității restului sarcinilor.

- Corecție – Adnotatorii sunt furnizați cu o casetă de text în formă liberă pre-completă cu răspunsul și explicația generat de model și li se cere să o editeze pentru a obține răspunsul și explicația corecte.

- Tipul de eroare – Printre cele mai frecvente tipuri de erori pe care le-am găsit în generațiile de model (Eroare faptică, Fapte lipsă, Fapte irelevante și Incoerență logică), adnotatorii au fost rugați să aleagă unul sau mai multe dintre tipurile de eroare care se aplică răspunsului și explicației date.

- Descrierea erorii – Adnotatorii au fost instruiți nu numai să clasifice erorile, ci și să ofere o justificare cuprinzătoare pentru clasificarea lor, inclusiv să precizeze pasul exact în care s-a produs greșeala și modul în care aceasta se aplică răspunsului și explicației oferite.

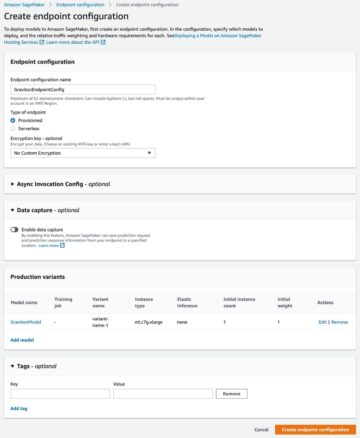

Noi am folosit Amazon SageMaker Ground Truth Plus în colectarea noastră de date. Colectarea datelor a avut loc în mai multe runde. Am efectuat mai întâi două proiecte pilot de 30 de exemple, respectiv 200 de exemple, după care echipa de adnotări a primit feedback detaliat cu privire la adnotare. Apoi am efectuat colectarea datelor pe două loturi pentru StrategyQA și peste un lot pentru Înțelegerea sportului, oferind feedback periodic – un total de 10 adnotatori au lucrat la sarcină pe o perioadă de aproape 1 lună.

Am adunat feedback cu privire la un total de 1,565 de exemple pentru StrategyQA și 796 de exemple pentru Sports Understanding. Următorul tabel ilustrează procentul de exemple care au fost fără erori în generarea modelului și proporția de exemple care au conținut un anumit tip de eroare. Este de remarcat faptul că unele exemple pot avea mai multe tipuri de eroare.

| Tipul de eroare | StrategyQA | Înțelegerea sportivă |

| Nici unul | 17.6% | 31.28% |

| Eroare de fapt | 27.6% | 38.1% |

| Fapte lipsă | 50.4% | 46.1% |

| Fapte irelevante | 14.6% | 3.9% |

| Incoerență logică | 11.2% | 5.2% |

Algoritmi de învățare

Pentru fiecare întrebare q, și răspunsul și explicația generate de model m, am colectat următorul feedback: răspuns corect și explicație c, tip de eroare prezentă în m (notat cu t), și descrierea erorii d, așa cum este descris în secțiunea anterioară.

Am folosit următoarele metode:

- Învățare multitask – O bază simplă pentru a învăța din feedback-ul divers disponibil este să tratezi fiecare dintre ele ca pe o sarcină separată. Mai concret, reglam Flan-T5 (text la text) cu obiectivul maximaliza p(c|q) + p(t|q, m) + p(d|q, m). Pentru fiecare termen din obiectiv, folosim o instrucțiune separată adecvată pentru sarcină (de exemplu, „Prevedeți eroarea în răspunsul dat”). De asemenea, convertim variabila categorială t într-o propoziție în limbaj natural. În timpul inferenței, folosim instrucțiunea pentru termen p(c|q) („Prevestește răspunsul corect pentru întrebarea dată”) pentru a genera răspunsul la întrebarea test.

- Consecvența de sine ponderată – Motivați de succesul consecvenței de sine în stimularea în lanț de gândire, propunem o variantă ponderată a acesteia. În loc să tratăm fiecare explicație eșantionată din model ca fiind corectă și să luăm în considerare votul agregat, mai întâi luăm în considerare dacă explicația este corectă și apoi cumulăm în consecință. Mai întâi ajustăm Flan-T5 cu același obiectiv ca și în învățarea multitask. În timpul inferenței, dată o întrebare de test q, eșantionăm mai multe răspunsuri posibile cu instrucțiunea pentru p(c|q)): a1, a2, .., an. Pentru fiecare răspuns eșantionat ai, folosim instrucțiunea pentru termen p(t|q, m) („Prevedeți eroarea în răspunsul dat”) pentru a identifica dacă conține eroare ti = argmax p(t|q, a_i). Fiecare răspuns ai i se atribuie o pondere de 1 dacă este corectă, în caz contrar i se atribuie o pondere mai mică decât 1 (hiperparametru reglabil). Răspunsul final se obține luând în considerare un vot ponderat peste toate răspunsurile a1 la an.

- Rafinament iterativ – În metodele propuse anterior, modelul generează direct răspunsul corect c conditionat de intrebare q. Aici ne propunem să rafinăm răspunsul generat de model m pentru a obține răspunsul corect la o întrebare dată. Mai precis, mai întâi reglam fin Flan-T5 (text la text cu obiectivul). maximizați p(t; c|q, m), În cazul în care ; denotă concatenarea (tipul de eroare t urmată de răspunsul corect c). O modalitate de a vedea acest obiectiv este ca modelul să fie mai întâi antrenat pentru a identifica eroarea în generația dată m, apoi pentru a elimina acea eroare pentru a obține răspunsul corect c. În timpul inferenței, putem folosi modelul în mod iterativ până când generează răspunsul corect, având în vedere o întrebare de test q, obținem mai întâi generația inițială a modelului m (folosind Flan-T5 pre-antrenat). Apoi generăm iterativ tipul de eroare ti și potențial răspuns corect ci până la ti = nicio eroare (în practică, setăm un număr maxim de iterații unui hiperparametru), caz în care răspunsul corect final va fi CI-1 (obtinut de la p(ti ; ci | q, ci-1)).

REZULTATE

Pentru ambele seturi de date, comparăm toți algoritmii de învățare propuși cu linia de bază de învățare în context. Toate modelele sunt evaluate pe setul de dezvoltare StrategyQA și Sports Understanding. Următorul tabel arată rezultatele.

| Metodă | StrategyQA | Înțelegerea sportivă |

| Flan-T5 4-shot Chain-of-Thought Învățare în context | 67.39 ± 2.6% | 58.5% |

| Învățare multitask | 66.22 ± 0.7% | 54.3 ± 2.1% |

| Consecvența de sine ponderată | 61.13 ± 1.5% | 51.3 ± 1.9% |

| Rafinament iterativ | 61.85 ± 3.3% | 57.0 ± 2.5% |

După cum s-a observat, unele metode funcționează comparabil cu linia de bază de învățare în context (multitask pentru StrategyQA și rafinament iterativ pentru Sports Understanding), ceea ce demonstrează potențialul de a colecta feedback continuu de la oameni cu privire la rezultatele modelului și de a le folosi pentru a îmbunătăți modelele lingvistice. Acest lucru este diferit de lucrările recente, cum ar fi RLHF, unde feedback-ul este limitat la categoric și de obicei binar.

După cum se arată în tabelul următor, investigăm modul în care modelele adaptate cu feedback uman asupra greșelilor de raționament pot ajuta la îmbunătățirea calibrării sau conștientizarea explicațiilor greșite cu încredere. Acest lucru este evaluat solicitând modelului să prezică dacă generarea acestuia conține erori.

| Metodă | Corectarea erorii | StrategyQA |

| Flan-T5 4-shot Chain-of-Thought Învățare în context | Nu | 30.17% |

| Model ajustat multitask | Da | 73.98% |

Mai detaliat, solicităm modelului de limbaj cu propriul lanț de răspuns și raționament generat (pentru care am colectat feedback), apoi îl solicităm din nou pentru a prezice eroarea din generație. Folosim instrucțiunile adecvate pentru sarcină („Identificați eroarea în răspuns”). Modelul este punctat corect dacă prezice „nicio eroare” sau „corect” în generație dacă adnotatorii au etichetat exemplul ca neavând nicio eroare sau dacă prezice oricare dintre tipurile de eroare din generație (împreună cu „incorect” sau „ greșit”) când adnotatorii l-au etichetat ca având o eroare. Rețineți că nu evaluăm capacitatea modelului de a identifica corect tipul de eroare, ci mai degrabă dacă este prezentă o eroare. Evaluarea se face pe un set de 173 de exemple suplimentare din setul de dezvoltare StrategyQA care au fost colectate, care nu sunt văzute în timpul reglajului fin. Patru exemple dintre acestea sunt rezervate pentru solicitarea modelului de limbă (primul rând din tabelul precedent).

Rețineți că nu arătăm rezultatul liniei de bază 0-shot deoarece modelul nu poate genera răspunsuri utile. Observăm că utilizarea feedback-ului uman pentru corectarea erorilor pe lanțurile de raționament poate îmbunătăți predicția modelului dacă face erori sau nu, ceea ce poate îmbunătăți conștientizarea sau calibrarea explicațiilor greșite.

Concluzie

În această postare, am arătat cum să gestionăm seturi de date de feedback uman cu corecții detaliate ale erorilor, care este o modalitate alternativă de a îmbunătăți abilitățile de raționament ale LLM-urilor. Rezultatele experimentale coroborează faptul că feedbackul uman cu privire la erorile de raționament poate îmbunătăți performanța și calibrarea la întrebările provocatoare multi-hop.

Dacă sunteți în căutarea feedback-ului uman pentru a vă îmbunătăți modelele lingvistice mari, vizitați Etichetarea datelor Amazon SageMaker și consola Ground Truth Plus.

Despre Autori

Erran Li este managerul științei aplicate la humain-in-the-loop services, AWS AI, Amazon. Interesele sale de cercetare sunt învățarea profundă 3D și învățarea viziunii și reprezentării limbajului. Anterior, a fost om de știință senior la Alexa AI, șeful de învățare automată la Scale AI și om de știință șef la Pony.ai. Înainte de asta, a fost cu echipa de percepție de la Uber ATG și cu echipa platformei de învățare automată de la Uber, lucrând la învățarea automată pentru conducere autonomă, sisteme de învățare automată și inițiative strategice ale inteligenței artificiale. Și-a început cariera la Bell Labs și a fost profesor adjunct la Universitatea Columbia. A predat împreună tutoriale la ICML'17 și ICCV'19 și a co-organizat mai multe ateliere la NeurIPS, ICML, CVPR, ICCV despre învățarea automată pentru conducere autonomă, viziune 3D și robotică, sisteme de învățare automată și învățare automată adversară. Are un doctorat în informatică la Universitatea Cornell. El este ACM Fellow și IEEE Fellow.

Erran Li este managerul științei aplicate la humain-in-the-loop services, AWS AI, Amazon. Interesele sale de cercetare sunt învățarea profundă 3D și învățarea viziunii și reprezentării limbajului. Anterior, a fost om de știință senior la Alexa AI, șeful de învățare automată la Scale AI și om de știință șef la Pony.ai. Înainte de asta, a fost cu echipa de percepție de la Uber ATG și cu echipa platformei de învățare automată de la Uber, lucrând la învățarea automată pentru conducere autonomă, sisteme de învățare automată și inițiative strategice ale inteligenței artificiale. Și-a început cariera la Bell Labs și a fost profesor adjunct la Universitatea Columbia. A predat împreună tutoriale la ICML'17 și ICCV'19 și a co-organizat mai multe ateliere la NeurIPS, ICML, CVPR, ICCV despre învățarea automată pentru conducere autonomă, viziune 3D și robotică, sisteme de învățare automată și învățare automată adversară. Are un doctorat în informatică la Universitatea Cornell. El este ACM Fellow și IEEE Fellow.

Nitish Joshi a fost stagiar în științe aplicate la AWS AI, Amazon. Este doctorand în informatică la Institutul Courant de Științe Matematice al Universității din New York, consiliat de prof. He He. Lucrează la Machine Learning și Natural Language Processing și a fost afiliat grupului de cercetare Machine Learning for Language (ML2). El a fost în mare parte interesat de înțelegerea robustă a limbajului: atât în construirea de modele care sunt robuste la schimbările de distribuție (de exemplu, prin creșterea datelor umane în buclă), cât și în proiectarea unor modalități mai bune de evaluare/măsurare a robusteței modelelor. El a fost, de asemenea, curios despre evoluțiile recente în învățarea în context și înțelegerea modului în care funcționează.

Nitish Joshi a fost stagiar în științe aplicate la AWS AI, Amazon. Este doctorand în informatică la Institutul Courant de Științe Matematice al Universității din New York, consiliat de prof. He He. Lucrează la Machine Learning și Natural Language Processing și a fost afiliat grupului de cercetare Machine Learning for Language (ML2). El a fost în mare parte interesat de înțelegerea robustă a limbajului: atât în construirea de modele care sunt robuste la schimbările de distribuție (de exemplu, prin creșterea datelor umane în buclă), cât și în proiectarea unor modalități mai bune de evaluare/măsurare a robusteței modelelor. El a fost, de asemenea, curios despre evoluțiile recente în învățarea în context și înțelegerea modului în care funcționează.

Kumar Chellapilla este director general și director la Amazon Web Services și conduce dezvoltarea serviciilor ML/AI, cum ar fi sistemele human-in-loop, AI DevOps, Geospatial ML și dezvoltarea ADAS/Autonomous Vehicle. Înainte de AWS, Kumar a fost director de inginerie la Uber ATG și Lyft Level 5 și a condus echipe folosind învățarea automată pentru a dezvolta capabilități de auto-conducere, cum ar fi percepția și maparea. De asemenea, a lucrat la aplicarea tehnicilor de învățare automată pentru a îmbunătăți căutarea, recomandările și produsele de publicitate la LinkedIn, Twitter, Bing și Microsoft Research.

Kumar Chellapilla este director general și director la Amazon Web Services și conduce dezvoltarea serviciilor ML/AI, cum ar fi sistemele human-in-loop, AI DevOps, Geospatial ML și dezvoltarea ADAS/Autonomous Vehicle. Înainte de AWS, Kumar a fost director de inginerie la Uber ATG și Lyft Level 5 și a condus echipe folosind învățarea automată pentru a dezvolta capabilități de auto-conducere, cum ar fi percepția și maparea. De asemenea, a lucrat la aplicarea tehnicilor de învățare automată pentru a îmbunătăți căutarea, recomandările și produsele de publicitate la LinkedIn, Twitter, Bing și Microsoft Research.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoAiStream. Web3 Data Intelligence. Cunoștințe amplificate. Accesați Aici.

- Mintând viitorul cu Adryenn Ashley. Accesați Aici.

- Sursa: https://aws.amazon.com/blogs/machine-learning/improve-multi-hop-reasoning-in-llms-by-learning-from-rich-human-feedback/

- :are

- :este

- :nu

- :Unde

- 1

- 10

- 100

- 13

- 200

- 22

- 30

- 39

- 3d

- 7

- a

- abilități

- capacitate

- Despre Noi

- în consecință

- ACM

- adăugat

- adăugare

- Suplimentar

- adresa

- contradictorialității

- Promovare

- Afiliat

- După

- din nou

- AI

- Alexa

- algoritmi

- TOATE

- de-a lungul

- de asemenea

- alternativă

- Amazon

- Amazon SageMaker

- Amazon Web Services

- printre

- an

- și

- răspunde

- răspunsuri

- Orice

- aplicat

- Aplică

- Aplicarea

- abordare

- adecvat

- SUNT

- AS

- alocate

- At

- autonom

- disponibil

- gradului de conştientizare

- AWS

- de bază

- bazat

- De bază

- BE

- deoarece

- fost

- înainte

- Clopot

- valori de referință

- Mai bine

- Bing

- atât

- Cutie

- in linii mari

- Clădire

- modele de clădire

- dar

- by

- CAN

- capacități

- Carieră

- caz

- sigur

- lanţ

- lanţuri

- provocare

- şef

- Clasifica

- Închide

- colecta

- Colectare

- colectare

- COLUMBIA

- Comun

- comparabil

- comparaţie

- comparație

- cuprinzător

- calculator

- Informatică

- efectuat

- încrezător

- cu încredere

- Lua în considerare

- luand in considerare

- Consoleze

- conține

- context

- converti

- Cornell

- Corectarea

- coroborează

- curios

- de date

- seturi de date

- adânc

- învățare profundă

- demonstra

- demonstrează

- descrie

- descris

- descriere

- proiect

- În ciuda

- detaliu

- detaliat

- detalii

- dev

- dezvolta

- Dezvoltare

- evoluții

- diferit

- direct

- Director

- distribuire

- diferit

- do

- făcut

- Dont

- conducere

- în timpul

- e

- fiecare

- activat

- Inginerie

- eroare

- Erori

- stabilirea

- evalua

- evaluat

- evaluare

- Chiar

- exemplu

- exemple

- explicație

- feedback-ul

- membru

- camp

- Figura

- final

- First

- a urmat

- următor

- Pentru

- formă

- găsit

- patru

- din

- culegere

- General

- genera

- generată

- generează

- generator

- generaţie

- generații

- ML geospațial

- Da

- dat

- Oferirea

- Teren

- grup

- hacking

- Avea

- având în

- he

- cap

- ajutor

- ajută

- aici

- lui

- Cum

- Cum Pentru a

- Totuși

- HTTPS

- uman

- Oamenii

- identifica

- IEEE

- if

- ilustrează

- îmbunătăţi

- in

- Inclusiv

- incorpora

- inițială

- inițiative

- in schimb

- Institut

- interesat

- interese

- interfaţă

- în

- investiga

- IT

- iterații

- ESTE

- jpg

- Labs

- limbă

- mare

- mai mare

- Conduce

- AFLAȚI

- învățat

- învăţare

- Led

- Nivel

- Limitat

- LLM

- logic

- cautati

- Lyft

- maşină

- masina de învățare

- FACE

- manager

- cartografiere

- matematic

- maxim

- Mai..

- Metode

- Microsoft

- dispărut

- greşeală

- greşeli

- ML

- ml2

- model

- Modele

- Lună

- mai mult

- cele mai multe

- motivat

- multiplu

- și anume

- Natural

- Procesarea limbajului natural

- Nou

- New York

- nlp

- Nu.

- număr

- obiectiv

- observa

- obstacol

- obține

- obținut

- a avut loc

- of

- on

- ONE

- în curs de desfășurare

- afară

- atac

- or

- original

- in caz contrar

- al nostru

- afară

- peste

- Prezentare generală

- propriu

- procent

- percepţie

- Efectua

- performanță

- efectuează

- perioadă

- periodic

- alege

- pilot

- Loc

- platformă

- Plato

- Informații despre date Platon

- PlatoData

- la care se adauga

- ridică

- posibil

- Post

- potenţial

- practică

- prezice

- prezicere

- prezice

- Pregăti

- prezenta

- prezentat

- prevalent

- precedent

- în prealabil

- anterior

- prelucrare

- Produse

- Profesor

- Progres

- proporție

- propune

- propus

- protocol

- furniza

- prevăzut

- furnizează

- calitate

- întrebare

- Întrebări

- aleator

- mai degraba

- recent

- Recomandări

- rafina

- relativ

- scoate

- reprezentare

- necesita

- necesar

- cercetare

- rezervat

- respectiv

- REST

- rezultat

- REZULTATE

- Răsplăti

- Bogat

- robotica

- robust

- robusteţe

- runde

- RÂND

- sagemaker

- acelaşi

- Scară

- scara ai

- cântare

- Ştiinţă

- ȘTIINȚE

- Om de stiinta

- Caută

- Al doilea

- Secțiune

- văzut

- SELF

- auto-conducere

- senior

- propoziție

- distinct

- Servicii

- set

- câteva

- Ture

- Pantaloni scurți

- Arăta

- indicat

- Emisiuni

- semnificativ

- semnificativ

- asemănător

- simplu

- mic

- mai mici

- unele

- specific

- specific

- împărţi

- Sportul

- început

- Pas

- paşi

- Strategic

- student

- succes

- astfel de

- sisteme

- tabel

- Sarcină

- sarcini

- echipă

- echipe

- tehnici de

- test

- decât

- acea

- lor

- Lor

- apoi

- Acestea

- ei

- acest

- aceste

- Prin

- la

- Total

- dresat

- Pregătire

- trata

- tratare

- extraordinar

- Încredere

- Adevăr

- tutoriale

- stare de nervozitate

- Două

- tip

- Tipuri

- Uber

- înţelegere

- universitate

- utilizare

- utilizat

- utilizatorii

- folosind

- obișnuit

- Variantă

- diverse

- vehicul

- Vizualizare

- viziune

- Vizita

- Vot

- a fost

- Cale..

- modalități de

- we

- web

- servicii web

- greutate

- au fost

- cand

- dacă

- care

- de ce

- voi

- cu

- Apartamente

- a lucrat

- de lucru

- fabrică

- Ateliere

- valoare

- Greșit

- York

- Ta

- zephyrnet