Vorbește cu aproape oricine - cu oricine uman, adică - și conversația ta va întâlni ce Malihe Alikhani numește „frecări sănătoase”, momente în care scopul tău în conversație se lovește de cel al partenerului tău, momente care necesită clarificare, produc confuzie sau duc la dezacord.

Nu este așa cu modelele mari de limbaj.

Alikhani, profesor asistent la Colegiul Khoury de Științe Calculatoare de la Universitatea Northeastern, spune că modelele mari de limbaj precum ChatGPT au o problemă serioasă cu certitudine.

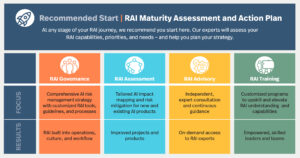

Noul proiect al lui Alikhani, numit Friction for Accountability in Conversational Transactions (FACT), este o colaborare între Northeastern University, University of Illinois Urbana-Champaign și University of Southern California.

Finanțat printr-un grant pentru Explorarea Inteligenței Artificiale prin Agenția de Proiecte de Cercetare Avansată a Apărării, proiectul FACT își propune să dezvolte instrumente de inteligență artificială mai transparente și mai echitabile.

„Unul dintre lucrurile care fac din comunicarea umană un instrument fructuos”, spune Alikhani, „este faptul că ne reprezentăm incertitudinea în vorbirea noastră, în tonul nostru. O punem în expresia feței noastre.”

Fricțiunile sănătoase care apar din incertitudinea în comunicarea de la om la om ajută la menținerea unei diversități de opinii și puncte de vedere, continuă ea.

Dar modelele de limbaj mari (sau LLM) nu sunt interesate să-și exprime incertitudinea, rezultând ceea ce Alikhani numește „comportamente adulatorice”. Modelele mari de limbaj „dor să maximizeze satisfacția” utilizatorului lor, spune ea, și „nu introduc niciodată fricțiuni în conversație, indiferent dacă [modelul este] încrezător” în declarațiile sale sau nu.

Probleme suplimentare apar cu modelele mari de limbaj prin tendința lor de a halucina. LLM-urile „inventează fapte. Sunt foarte buni în a convinge oamenii de fapte inventate.”

În ciuda acestor probleme, Alikhani mai spune că oamenii sunt predispuși să se bazeze prea mult pe „faptele” generate de aceste modele de inteligență artificială, care „poate inventa fapte care să te facă fericit”.

O parte din ceea ce contribuie la dependența excesivă a utilizatorilor de LLM sunt „comportamentele umane”, spune ea. „Asta ne va manipula cogniția.”

De asemenea, modelele mari de limbaj par să-și producă răspunsurile instantaneu, un alt factor care îi face pe utilizatori să-și asume corectitudinea. „Este greu pentru noi, oamenii de știință AI, să le spunem oamenilor: „Da, este coerent. Da, este rapid. Da, se adaptează la stilul tău. Dar halucinează”, spune Alikhani.

În cadrul noului lor grant, Alikhani și echipa ei vor proiecta instrumente care demonstrează nivelurile de certitudine pe care un LLM îl deține cu privire la o declarație pe care o face și vor introduce fricțiuni sănătoase în conversațiile om-AI.

„Cum putem prezice și verbaliza încrederea sistemului?” întreabă Alikhani. Dacă un model de inteligență artificială are „doar 2% încredere, ar trebui să exteriorizeze asta”.

„Unul dintre principalele obiective ale cercetării este de a modela incertitudinea, de a externaliza incertitudinea” și de a-i învăța pe LLM cum să înfățișeze această incertitudine într-o conversație uman-AI. Acest lucru ar putea apărea în interfața unui utilizator ca un scor percentil al certitudinii modelului sau modelul ar putea reflecta incertitudinea în răspunsurile sale într-un mod mai asemănător uman.

De exemplu, Alikhani își imaginează o situație în care un pacient ar putea adresa unui model lingvistic mare o întrebare despre sănătatea sa. Actuala generație de LLM va încerca să ofere un răspuns, chiar dacă acel răspuns s-ar putea dovedi periculos. Alikhani speră să construiască modele care să spună: „Nu știu. Ar trebui să-ți suni asistenta.”

„Robusitatea este cheia responsabilităţii în AI”, spune Alikhani. În prezent, este obișnuit ca un LLM să răspundă cu un răspuns la o interogare în momentul solicitării și un răspuns complet diferit câteva minute mai târziu.

Când vine vorba de proiectarea AI care este atât sigură, cât și responsabilă, sistemele AI anterioare care ar putea ajuta la sarcini simple „nu aveau acces la o grămadă de alte seturi de date”, spune Alikhani, „și nu puteau spune lucruri care ar putea fi periculoase. , pentru că nu era în datele lor.”

Exact ceea ce includ – sau exclud acele seturi de date – este cheia pentru depășirea prejudecăților pe care LLM-urile le manifestă față de „gen, dar și prejudecăți mai subtile, cum ar fi grupurile interne și externe și diferite prejudecăți cognitive care se reflectă în modelele [limbi mari]”.

Acum, Alikhani speră să proiecteze modele care să servească oamenii cu „affordanțe și preferințe diferite”, spune ea.

„Nu vrem să continuăm să construim sisteme pentru populația pentru care avem date, dar ne gândim la cine lăsăm în urmă și cum putem opri acest decalaj imens de inegalitate în loc să o agravăm?” ea intreaba. „Scopul laboratorului meu este să merg în această direcție.”

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- Sursa: https://www.mtlc.co/large-language-models-can-lie-to-you-this-professor-wants-you-to-know-when-they-do/

- :este

- :nu

- :Unde

- $UP

- 2%

- a

- Despre Noi

- acces

- responsabilitate

- responsabil

- avansat

- împotriva

- agenție

- AI

- Sisteme AI

- isi propune

- aproape

- de asemenea

- an

- și

- O alta

- răspunde

- Orice

- oricine

- apărea

- SUNT

- apărea

- artificial

- inteligență artificială

- AS

- cere

- solicitând

- Asistent

- asuma

- At

- BE

- deoarece

- comportamente

- în spatele

- între

- distorsiunilor

- atât

- construi

- Clădire

- Buchet

- dar

- by

- California

- apel

- denumit

- apeluri

- CAN

- certitudine

- Chat GPT

- cunoaștere

- cognitive

- COERENT

- colaborare

- Colegiu

- vine

- Comun

- Comunicare

- complet

- calculator

- încredere

- încrezător

- confuzie

- continuă

- contribuie

- Conversație

- de conversaţie

- conversații

- Consiliu

- Curent

- Periculos

- de date

- seturi de date

- Apărare

- demonstra

- Amenajări

- proiect

- dezvolta

- diferit

- direcţie

- Afişa

- Diversitate

- do

- Dont

- întâlni

- echitabil

- Chiar

- explorare

- exprimând

- expresie

- facial

- fapt

- factor

- fapte

- FAST

- puțini

- Pentru

- frecare

- din

- roditor

- decalaj

- generată

- generaţie

- scop

- Goluri

- bine

- acordarea

- fericit

- Greu

- Avea

- Sănătate

- sănătos

- ajutor

- ei

- deține

- speranțe

- Cum

- Cum Pentru a

- HTTPS

- mare

- uman

- Oamenii

- if

- Illinois

- închipuie

- in

- include

- inegalitate

- instanță

- instantaneu

- in schimb

- Inteligență

- interesat

- interfaţă

- în

- introduce

- probleme de

- IT

- ESTE

- doar

- A pastra

- Cheie

- Cunoaște

- de laborator

- limbă

- mare

- mai tarziu

- conduce

- Conducere

- lăsând

- nivelurile de

- minciună

- ca

- LLM

- făcut

- Principal

- menține

- face

- FACE

- Efectuarea

- Masa

- Maximaliza

- ar putea

- minute

- model

- Modele

- moment

- Momente

- mai mult

- muta

- my

- Nou

- Universitatea Northeastern

- of

- on

- ONE

- Avize

- or

- Altele

- al nostru

- afară

- peste

- depășirea

- pacient

- oameni

- Plato

- Informații despre date Platon

- PlatoData

- populație

- prezice

- preferinţele

- precedent

- Problemă

- probleme

- produce

- Profesor

- proiect

- furniza

- pune

- întrebare

- întrebare

- reflecta

- reflectat

- bazându-se

- reprezenta

- necesita

- cercetare

- Răspunde

- răspunsuri

- rezultând

- sigur

- Spune

- spune

- ȘTIINȚE

- oamenii de stiinta

- scor

- părea

- serios

- serviciu

- ea

- să

- simplu

- situație

- So

- Sudic

- discurs

- Declarație

- Declarații

- Stop

- stil

- astfel de

- sistem

- sisteme

- sarcini

- echipă

- tech

- spune

- tendinţă

- acea

- lor

- Acestea

- ei

- lucruri

- crede

- acest

- aceste

- Prin

- timp

- la

- TONE

- instrument

- Unelte

- spre

- față de

- Tranzacții

- transparent

- încerca

- de reglaj

- ÎNTORCĂ

- Incertitudine

- universitate

- us

- Utilizator

- utilizatorii

- Impotriva

- foarte

- puncte de vedere

- vrea

- vrea

- a fost

- Cale..

- we

- Ce

- cand

- dacă

- care

- OMS

- voi

- cu

- în

- mai rău

- da

- Tu

- Ta

- zephyrnet