Astăzi, suntem încântați să anunțăm că Mixtral-8x7B Modelul de limbaj mare (LLM), dezvoltat de Mistral AI, este disponibil pentru clienți prin intermediul Amazon SageMaker JumpStart pentru a implementa cu un singur clic pentru a rula inferența. Mixtral-8x7B LLM este un amestec rar pre-antrenat de model expert, bazat pe o coloană vertebrală de 7 miliarde de parametri, cu opt experți pe strat de feed-forward. Puteți încerca acest model cu SageMaker JumpStart, un hub de învățare automată (ML) care oferă acces la algoritmi și modele, astfel încât să puteți începe rapid cu ML. În această postare, vom explica cum să descoperim și să implementăm modelul Mixtral-8x7B.

Ce este Mixtral-8x7B

Mixtral-8x7B este un model de bază dezvoltat de Mistral AI, care acceptă texte în engleză, franceză, germană, italiană și spaniolă, cu abilități de generare de cod. Acceptă o varietate de cazuri de utilizare, cum ar fi rezumarea textului, clasificarea, completarea textului și completarea codului. Se comportă bine în modul chat. Pentru a demonstra personalizarea simplă a modelului, Mistral AI a lansat, de asemenea, un model Mixtral-8x7B-instruct pentru cazurile de utilizare a chat-ului, reglat fin folosind o varietate de seturi de date de conversație disponibile public. Modelele Mixtral au o lungime mare de context de până la 32,000 de jetoane.

Mixtral-8x7B oferă îmbunătățiri semnificative de performanță față de modelele anterioare de ultimă generație. Amestecul său rar de arhitectură de experți îi permite să obțină rezultate de performanță mai bune pe 9 din 12 benchmark-uri de procesare a limbajului natural (NLP) testate de Mistral AI. Mixtral se potrivește sau depășește performanța modelelor de până la 10 ori dimensiunea sa. Utilizând doar o fracțiune de parametri pe token, atinge viteze de inferență mai rapide și costuri de calcul mai mici în comparație cu modelele dense de dimensiuni echivalente - de exemplu, cu 46.7 miliarde de parametri în total, dar numai 12.9 miliarde utilizați per token. Această combinație de înaltă performanță, suport multilingv și eficiență de calcul face Mixtral-8x7B o alegere atrăgătoare pentru aplicațiile NLP.

Modelul este disponibil sub licența Apache 2.0 permisivă, pentru utilizare fără restricții.

Ce este SageMaker JumpStart

Cu SageMaker JumpStart, practicienii ML pot alege dintr-o listă tot mai mare de modele de fond de ten cu cele mai bune performanțe. Practicienii ML pot implementa modele de fundație pentru dedicate Amazon SageMaker instanțe într-un mediu izolat în rețea și personalizați modelele utilizând SageMaker pentru instruirea și implementarea modelelor.

Acum puteți descoperi și implementa Mixtral-8x7B cu câteva clicuri Amazon SageMaker Studio sau programatic prin intermediul SDK-ului SageMaker Python, permițându-vă să obțineți performanța modelului și controalele MLOps cu funcții SageMaker, cum ar fi Pipelines Amazon SageMaker, Debugger Amazon SageMaker, sau jurnalele containerului. Modelul este implementat într-un mediu securizat AWS și sub controalele dvs. VPC, contribuind la asigurarea securității datelor.

Descoperă modele

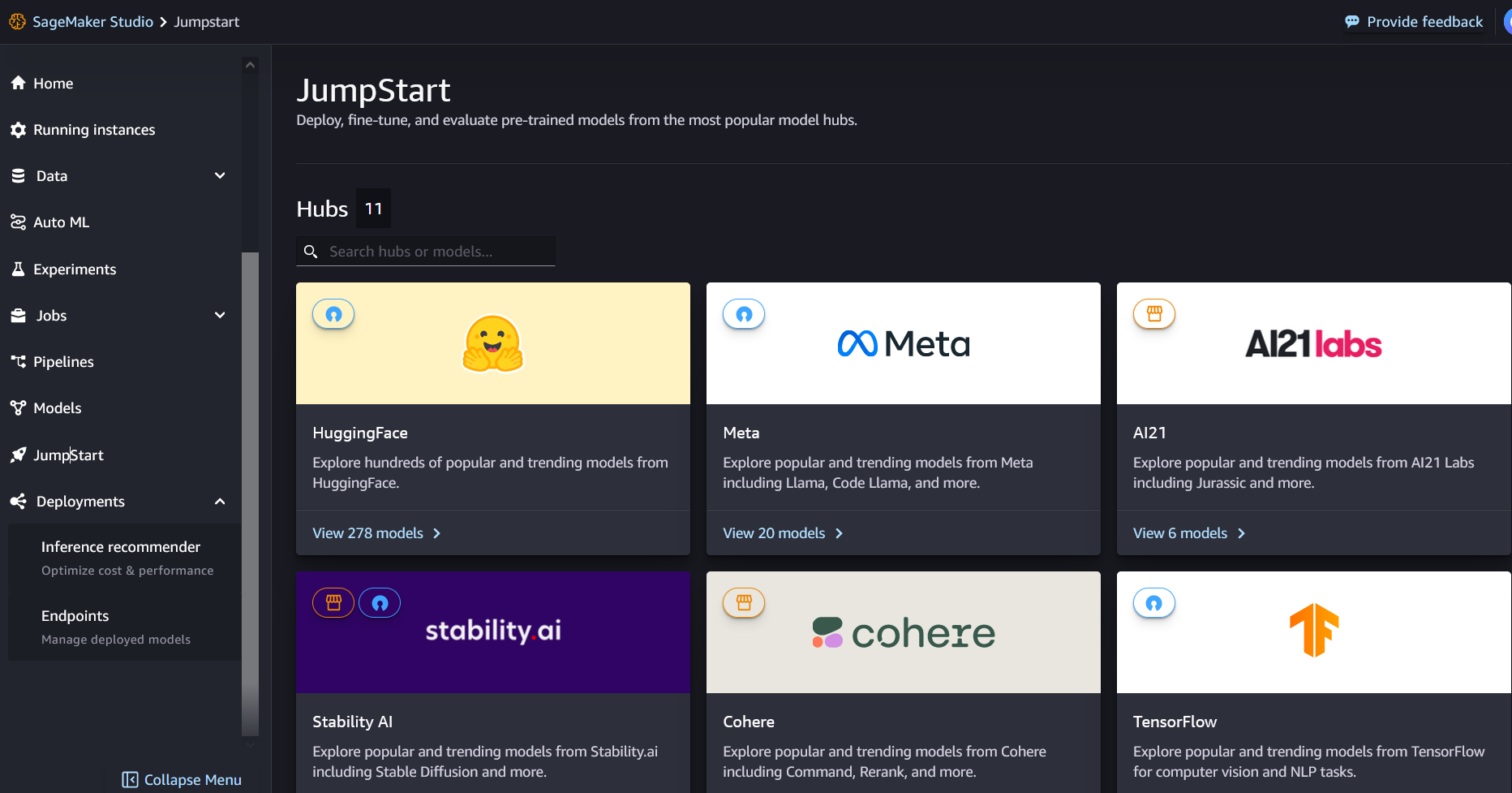

Puteți accesa modelele de fundație Mixtral-8x7B prin SageMaker JumpStart în SageMaker Studio UI și SageMaker Python SDK. În această secțiune, vom analiza cum să descoperiți modelele în SageMaker Studio.

SageMaker Studio este un mediu de dezvoltare integrat (IDE) care oferă o interfață vizuală unică bazată pe web, unde puteți accesa instrumente special create pentru a efectua toți pașii de dezvoltare ML, de la pregătirea datelor până la construirea, antrenamentul și implementarea modelelor dvs. ML. Pentru mai multe detalii despre cum să începeți și să configurați SageMaker Studio, consultați Amazon SageMaker Studio.

În SageMaker Studio, puteți accesa SageMaker JumpStart alegând pornire în panoul de navigare.

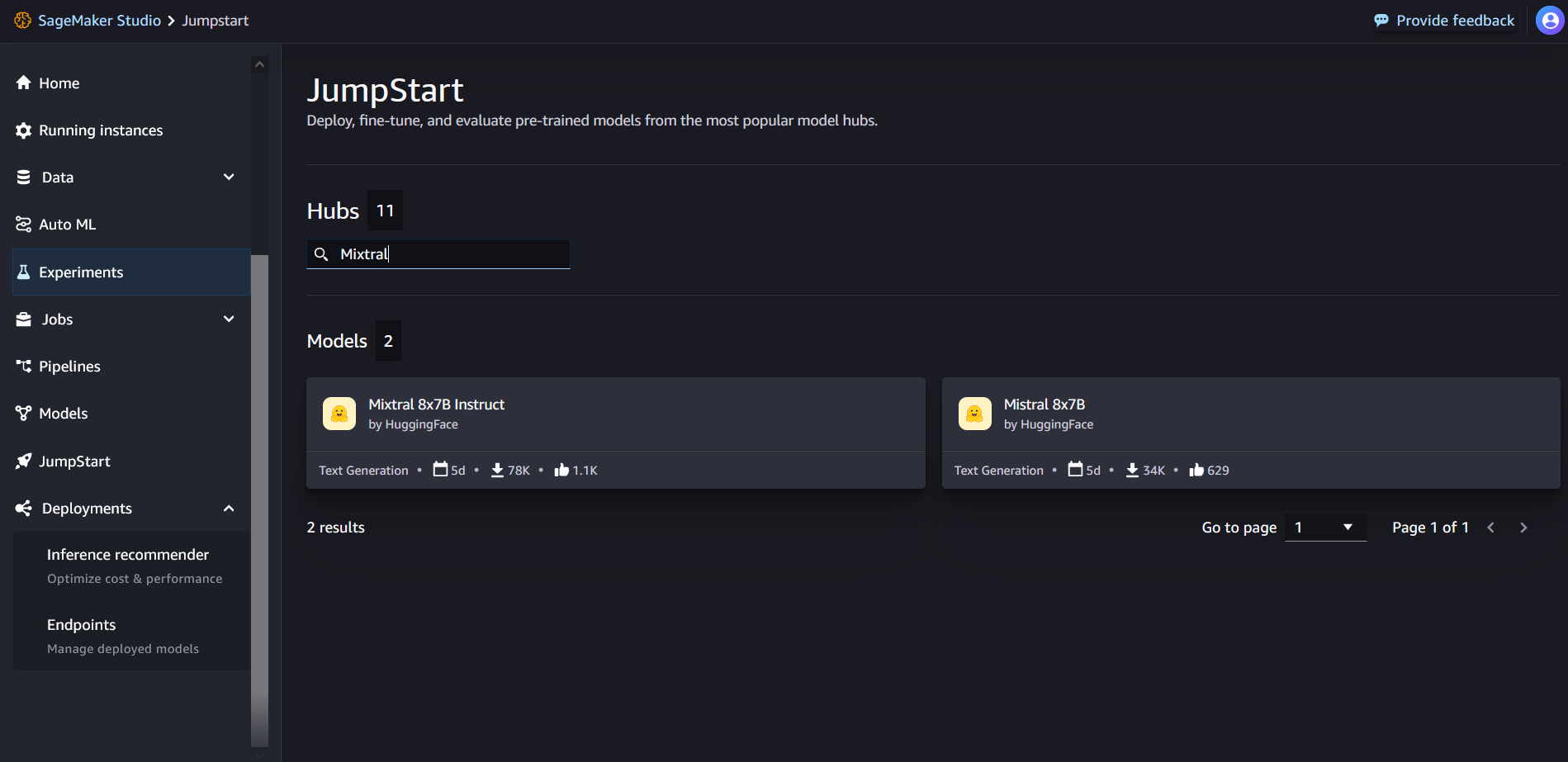

Din pagina de destinație SageMaker JumpStart, puteți căuta „Mixtral” în caseta de căutare. Veți vedea rezultatele căutării care arată Mixtral 8x7B și Mixtral 8x7B Instruct.

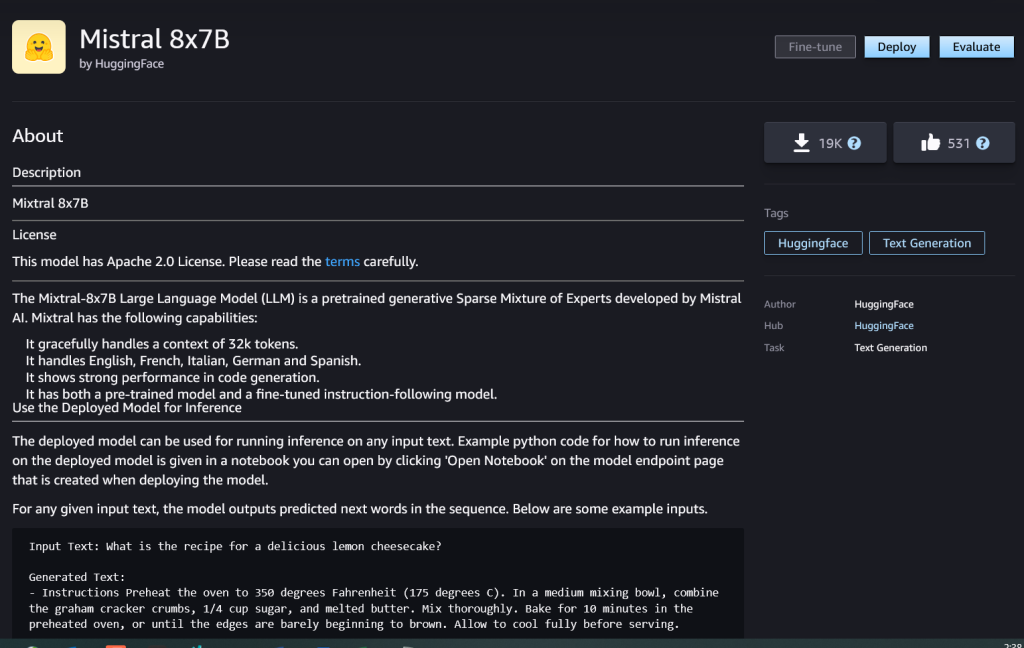

Puteți alege cardul model pentru a vedea detalii despre model, cum ar fi licența, datele utilizate pentru antrenament și modul de utilizare. Veți găsi, de asemenea, Lansa butonul, pe care îl puteți folosi pentru a implementa modelul și a crea un punct final.

Implementați un model

Implementarea începe atunci când alegeți Lansa. După finalizarea implementării, a fost creat un punct final. Puteți testa punctul final prin transmiterea unui eșantion de sarcină utilă a cererii de inferență sau selectând opțiunea de testare folosind SDK-ul. Când selectați opțiunea de utilizare a SDK-ului, veți vedea exemplu de cod pe care îl puteți utiliza în editorul de notebook-uri preferat din SageMaker Studio.

Pentru a implementa folosind SDK-ul, începem prin a selecta modelul Mixtral-8x7B, specificat de model_id with value huggingface-llm-mixtral-8x7b. Puteți implementa oricare dintre modelele selectate pe SageMaker cu următorul cod. În mod similar, puteți implementa instrucțiunile Mixtral-8x7B folosind propriul ID de model:

Aceasta implementează modelul pe SageMaker cu configurații implicite, inclusiv tipul de instanță implicit și configurațiile VPC implicite. Puteți modifica aceste configurații specificând valori care nu sunt implicite în JumpStartModel.

După ce este implementat, puteți rula inferențe împotriva punctului final implementat prin predictorul SageMaker:

Exemple de solicitări

Puteți interacționa cu un model Mixtral-8x7B ca orice model standard de generare de text, în care modelul procesează o secvență de intrare și scoate cuvintele următoare prezise din secvență. În această secțiune, oferim exemple de solicitări.

Generarea codului

Folosind exemplul precedent, putem folosi solicitări de generare de cod precum următoarele:

Obțineți următoarea ieșire:

Prompt de analiză a sentimentelor

Puteți efectua o analiză a sentimentelor folosind un prompt ca următorul cu Mixtral 8x7B:

Obțineți următoarea ieșire:

Solicitări de răspuns la întrebări

Puteți utiliza un prompt de răspuns la întrebări precum următorul cu Mixtral-8x7B:

Obțineți următoarea ieșire:

Mixtral-8x7B Instruct

Versiunea ajustată pentru instrucțiuni a Mixtral-8x7B acceptă instrucțiuni formatate în care rolurile de conversație trebuie să înceapă cu un prompt al utilizatorului și să alterneze între instrucțiunile utilizatorului și asistent (răspuns model). Formatul de instrucțiuni trebuie respectat cu strictețe, altfel modelul va genera rezultate suboptime. Șablonul utilizat pentru a construi un prompt pentru modelul Instruct este definit după cum urmează:

Rețineți că <s> și </s> sunt jetoane speciale pentru începutul șirului (BOS) și sfârșitul șirului (EOS), în timp ce [INST] și [/INST] sunt șiruri obișnuite.

Următorul cod arată cum puteți formata promptul în format de instrucțiune:

Recuperarea cunoștințelor

Puteți utiliza următorul cod pentru o solicitare de recuperare a cunoștințelor:

Obțineți următoarea ieșire:

Codificare

Modelele Mixtral pot demonstra punctele forte evaluate pentru sarcinile de codificare, așa cum se arată în următorul cod:

Matematică și raționament

Modelele mixtrale raportează, de asemenea, puncte forte în acuratețea matematicii:

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- Sursa: https://aws.amazon.com/blogs/machine-learning/mixtral-8x7b-is-now-available-in-amazon-sagemaker-jumpstart/

- :are

- :este

- :nu

- :Unde

- $UP

- 000

- 1

- 10

- 100

- 11

- 12

- 120

- 13

- 130

- 14

- 15%

- 16

- 17

- 1M

- 200

- 25

- 26%

- 30

- 32

- 50

- 600

- 7

- 72

- 8

- 9

- a

- abilități

- Despre Noi

- mai sus

- accelerarea

- acceptă

- acces

- Conturi

- precizie

- Obține

- Realizeaza

- peste

- activ

- adăugat

- adăugare

- După

- împotriva

- AI

- AI / ML

- algoritmi

- TOATE

- de asemenea

- Amazon

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- sumă

- an

- analiză

- și

- și infrastructură

- anunța

- răspunde

- Orice

- Apache

- interesant

- aplicatii

- aplicat

- Aplicarea

- arhitectură

- SUNT

- argument

- articol

- AS

- Asistent

- At

- disponibil

- AWS

- înapoi

- Șira spinării

- bazat

- pocni

- acumulator

- Bayesian

- BE

- deoarece

- fost

- înainte

- Început

- consideră că

- Clopot

- comparativ

- valori de referință

- Mai bine

- între

- Proiect de lege

- facturare

- Miliard

- au cumpărat

- Cutie

- Pauză

- aduce

- construi

- Clădire

- construit-in

- afaceri

- dar

- by

- calcula

- apel

- denumit

- apeluri

- CAN

- card

- caz

- cazuri

- Schimbare

- Chat

- alegere

- Alege

- alegere

- Chris

- clasificare

- clic

- cod

- Codificare

- combinaţie

- comparație

- compilat

- completare

- de calcul

- Calcula

- calculator

- Computer Vision

- conferințe

- mereu

- Recipient

- conţinut

- context

- continuă

- continuu

- controale

- Conversație

- A costat

- Cheltuieli

- ar putea

- crea

- a creat

- crucial

- Ceaşcă

- Curent

- clienţii care

- personalizare

- personaliza

- de date

- securitatea datelor

- seturi de date

- zi

- Zi

- dedicat

- Mod implicit

- definit

- democratizarea

- demonstra

- implementa

- dislocate

- Implementarea

- desfășurarea

- implementează

- deriva

- detalii

- dezvolta

- dezvoltat

- Dezvoltator

- Dezvoltare

- DICT

- FĂCUT

- descoperi

- do

- face

- de dolari

- domenii

- făcut

- jos

- Picătură

- Duce

- duke universitate

- fiecare

- Economic

- editor

- eficiență

- Ouă

- altfel

- permite

- permite

- permițând

- capăt

- Punct final

- Inginerie

- Engleză

- asigura

- Mediu inconjurator

- EOS

- egal

- Echivalent

- etic

- exemplu

- depășește

- excitat

- F? r?

- expert

- experți

- Explica

- explicație

- extensie

- familie

- mai repede

- DESCRIERE

- puțini

- Fişiere

- Filtre

- Găsi

- First

- următor

- urmează

- Pentru

- format

- Fundație

- fracțiune

- Franceză

- din

- funcţie

- viitor

- scop general

- genera

- generată

- generaţie

- generativ

- AI generativă

- Germană

- obține

- Go

- bine

- am

- În creştere

- ură

- Avea

- he

- ajutor

- ajutor

- ajută

- ei

- aici

- Înalt

- Hills

- lui

- Cum

- Cum Pentru a

- HTML

- HTTPS

- Butuc

- i

- ICE

- îngheţată

- ID

- if

- Illinois

- boală

- import

- important

- îmbunătăţi

- îmbunătățiri

- in

- include

- Inclusiv

- Incorporated

- Infrastructură

- intrare

- intrări

- instanță

- instrucțiuni

- integra

- integrate

- interacţiona

- interese

- interfaţă

- Inventat

- izolat

- IT

- Italiană

- ESTE

- în sine

- jpg

- copii

- cunoştinţe

- Kyle

- Labs

- aterizare

- limbă

- mare

- Nume

- strat

- Conduce

- învăţare

- Lungime

- lăsa

- Licență

- ca

- îi place

- Limitele

- LINK

- Listă

- Ascultare

- mic

- LLM

- logică

- cautati

- LOWER

- maşină

- masina de învățare

- făcut

- FACE

- Efectuarea

- manager

- multe

- meciuri

- matematica

- matematică

- me

- mediu

- amestec

- ML

- MLOps

- mod

- model

- Modele

- modificată

- Lună

- mai mult

- motocicletă

- mult

- înmulțit

- Muzică

- trebuie sa

- my

- Natural

- Procesarea limbajului natural

- Navigare

- negativ

- reţea

- Neutru

- Nou

- următor

- nlp

- Nici unul

- nota

- caiet

- acum

- număr

- of

- Ulei

- on

- dată

- ONE

- afară

- de operare

- sistem de operare

- Opțiune

- or

- Altele

- in caz contrar

- afară

- producție

- iesiri

- exterior

- peste

- propriu

- pagină

- plătit

- pâine

- lucrări

- parametru

- parametrii

- Care trece

- pasiune

- pasionat

- căi

- pentru

- Efectua

- performanță

- PhD

- telefon

- Plato

- Informații despre date Platon

- PlatoData

- Punct

- portabil

- pozitiv

- Post

- precedent

- a prezis

- Predictor

- preferat

- pregătirea

- precedent

- Principal

- procedural

- proces

- procese

- prelucrare

- Produs

- Program

- Programare

- solicitări

- prosperitate

- furniza

- furnizori

- furnizează

- public

- publicat

- Piton

- Trimestru

- întrebare

- repede

- RE

- Citind

- reţetă

- recursive

- reduce

- trimite

- regulat

- eliberat

- raportează

- solicita

- cercetare

- cercetător

- Resurse

- apreciat

- răspuns

- responsabil

- restricții

- rezultat

- REZULTATE

- reveni

- Returnează

- călărie

- Risc

- Rol

- rolurile

- Cameră

- Alerga

- funcţionare

- s

- SA

- sagemaker

- sare

- scalabil

- Scară

- Ştiinţă

- Om de stiinta

- sdk

- Caută

- Secțiune

- sigur

- securitate

- vedea

- selecta

- selectate

- selectarea

- selecţie

- senior

- sentiment

- distinct

- Secvenţă

- serie

- Servicii

- set

- a arătat

- indicat

- Emisiuni

- semnificativ

- asemănător

- simplu

- întrucât

- singur

- Mărimea

- So

- Social

- Societate

- Software

- soluţie

- Spaniolă

- special

- specialist

- specificată

- viteze

- Cheltuire

- standard

- Începe

- început

- începe

- de ultimă oră

- statistic

- Pas

- paşi

- Încă

- oprit

- stoca

- simplu

- Strategic

- curent

- puncte forte

- Şir

- structurat

- studio

- astfel de

- a sustine

- De sprijin

- Sprijină

- sistem

- ia

- sarcini

- gust

- echipă

- Tehnologia

- șablon

- test

- testat

- Testarea

- a) Sport and Nutrition Awareness Day in Manasia Around XNUMX people from the rural commune Manasia have participated in a sports and healthy nutrition oriented activity in one of the community’s sports ready yards. This activity was meant to gather, mainly, middle-aged people from a Romanian rural community and teach them about the benefits that sports have on both their mental and physical health and on how sporting activities can be used to bring people from a community closer together. Three trainers were made available for this event, so that the participants would get the best possible experience physically and so that they could have the best access possible to correct information and good sports/nutrition practices. b) Sports Awareness Day in Poiana Țapului A group of young participants have taken part in sporting activities meant to teach them about sporting conduct, fairplay, and safe physical activities. The day culminated with a football match.

- acea

- Viitorul

- apoi

- Acestea

- ei

- acest

- Prin

- timp

- Seria de timp

- ori

- la

- împreună

- semn

- indicativele

- de asemenea

- Unelte

- Total

- Tren

- Pregătire

- adevărat

- încerca

- tweet

- tip

- ui

- în

- universitate

- unix

- deschide

- până la

- utilizare

- carcasa de utilizare

- utilizat

- Utilizator

- utilizări

- folosind

- Utilizand

- Vale

- valoare

- Valori

- varietate

- versiune

- Video

- Vizualizare

- viziune

- Vizita

- vizual

- umbla

- a fost

- Apă

- we

- web

- servicii web

- bazat pe web

- BINE

- Ce

- Ce este

- cand

- întrucât

- care

- alb

- OMS

- voi

- cu

- în

- fără

- cuvinte

- Apartamente

- ar

- scrie

- scris

- Tu

- Ta

- zephyrnet

Rachna Chadha este arhitect principal de soluții AI/ML în conturi strategice la AWS. Rachna este o optimistă care crede că utilizarea etică și responsabilă a inteligenței artificiale poate îmbunătăți societatea în viitor și poate aduce prosperitate economică și socială. În timpul liber, Rachnei îi place să petreacă timpul cu familia ei, să facă drumeții și să asculte muzică.

Rachna Chadha este arhitect principal de soluții AI/ML în conturi strategice la AWS. Rachna este o optimistă care crede că utilizarea etică și responsabilă a inteligenței artificiale poate îmbunătăți societatea în viitor și poate aduce prosperitate economică și socială. În timpul liber, Rachnei îi place să petreacă timpul cu familia ei, să facă drumeții și să asculte muzică. Dr. Kyle Ulrich este un om de știință aplicat cu

Dr. Kyle Ulrich este un om de știință aplicat cu  Christopher Whitten este un dezvoltator de software în echipa JumpStart. El ajută la selectarea modelelor la scară și la integrarea modelelor cu alte servicii SageMaker. Chris este pasionat de accelerarea omniprezentei AI într-o varietate de domenii de afaceri.

Christopher Whitten este un dezvoltator de software în echipa JumpStart. El ajută la selectarea modelelor la scară și la integrarea modelelor cu alte servicii SageMaker. Chris este pasionat de accelerarea omniprezentei AI într-o varietate de domenii de afaceri. Dr. Fabio Nonato de Paula este Senior Manager, Specialist GenAI SA, ajutând furnizorii de modele și clienții să scaleze AI generativă în AWS. Fabio are o pasiune pentru democratizarea accesului la tehnologia AI generativă. În afara serviciului, îl puteți găsi pe Fabio mergând cu motocicleta pe dealurile din Valea Sonoma sau citind ComiXology.

Dr. Fabio Nonato de Paula este Senior Manager, Specialist GenAI SA, ajutând furnizorii de modele și clienții să scaleze AI generativă în AWS. Fabio are o pasiune pentru democratizarea accesului la tehnologia AI generativă. În afara serviciului, îl puteți găsi pe Fabio mergând cu motocicleta pe dealurile din Valea Sonoma sau citind ComiXology. Dr. Ashish Khetan este un om de știință senior aplicat cu algoritmi încorporați Amazon SageMaker și ajută la dezvoltarea algoritmilor de învățare automată. Și-a luat doctoratul la Universitatea din Illinois Urbana-Champaign. Este un cercetător activ în învățarea automată și inferența statistică și a publicat multe lucrări în conferințele NeurIPS, ICML, ICLR, JMLR, ACL și EMNLP.

Dr. Ashish Khetan este un om de știință senior aplicat cu algoritmi încorporați Amazon SageMaker și ajută la dezvoltarea algoritmilor de învățare automată. Și-a luat doctoratul la Universitatea din Illinois Urbana-Champaign. Este un cercetător activ în învățarea automată și inferența statistică și a publicat multe lucrări în conferințele NeurIPS, ICML, ICLR, JMLR, ACL și EMNLP. Karl Albertsen conduce produse, inginerie și știință pentru Amazon SageMaker Algorithms și JumpStart, centrul de învățare automată al SageMaker. Este pasionat de aplicarea învățării automate pentru a debloca valoarea afacerii.

Karl Albertsen conduce produse, inginerie și știință pentru Amazon SageMaker Algorithms și JumpStart, centrul de învățare automată al SageMaker. Este pasionat de aplicarea învățării automate pentru a debloca valoarea afacerii.