Pe măsură ce organizațiile implementează modele în producție, ele caută în mod constant modalități de a optimiza performanța modelelor lor de bază (FM) care rulează pe cele mai recente acceleratoare, cum ar fi Inferentia AWS și GPU, astfel încât să își poată reduce costurile și să reducă latența de răspuns pentru a oferi cea mai bună experiență utilizatorilor finali. Cu toate acestea, unele FM nu utilizează pe deplin acceleratoarele disponibile cu instanțele în care sunt implementate, ceea ce duce la o utilizare ineficientă a resurselor hardware. Unele organizații implementează mai multe FM în aceeași instanță pentru a utiliza mai bine toate acceleratoarele disponibile, dar acest lucru necesită o orchestrare complexă a infrastructurii, care necesită timp și dificil de gestionat. Atunci când mai multe FM-uri partajează aceeași instanță, fiecare FM are propriile nevoi de scalare și modele de utilizare, ceea ce face dificil de prezis când trebuie să adăugați sau să eliminați instanțe. De exemplu, un model poate fi utilizat pentru a alimenta o aplicație de utilizator în care utilizarea poate crește în anumite ore, în timp ce un alt model poate avea un model de utilizare mai consistent. Pe lângă optimizarea costurilor, clienții doresc să ofere cea mai bună experiență utilizatorului final prin reducerea latenței. Pentru a face acest lucru, deseori implementează mai multe copii ale unui FM la solicitările de câmp de la utilizatori în paralel. Deoarece ieșirile FM pot varia de la o singură propoziție la mai multe paragrafe, timpul necesar pentru finalizarea cererii de inferență variază semnificativ, ceea ce duce la vârfuri imprevizibile ale latenței dacă cererile sunt direcționate aleatoriu între instanțe. Amazon SageMaker acum acceptă noi capabilități de inferență care vă ajută să reduceți costurile de implementare și latența.

Acum puteți crea puncte finale bazate pe componente de inferență și puteți implementa modele de învățare automată (ML) într-un punct final SageMaker. O componentă de inferență (IC) extrage modelul dvs. ML și vă permite să atribui procesoare, GPU sau AWS Neuron acceleratoare și politici de scalare pe model. Componentele de inferență oferă următoarele beneficii:

- SageMaker va plasa și va împacheta în mod optim modelele în instanțe ML pentru a maximiza utilizarea, ceea ce duce la economii de costuri.

- SageMaker va scala fiecare model în sus și în jos în funcție de configurația dvs. pentru a îndeplini cerințele aplicației dvs. de ML.

- SageMaker se va scala pentru a adăuga și elimina instanțe în mod dinamic pentru a se asigura că capacitatea este disponibilă, menținând în același timp calculul inactiv la minimum.

- Puteți reduce la zero copii ale unui model pentru a elibera resurse pentru alte modele. De asemenea, puteți specifica să păstrați modelele importante mereu încărcate și gata să deservească traficul.

Cu aceste capabilități, puteți reduce costurile de implementare a modelului cu 50% în medie. Economiile de costuri vor varia în funcție de volumul de muncă și de tiparele de trafic. Să luăm un exemplu simplu pentru a ilustra modul în care împachetarea mai multor modele pe un singur punct final poate maximiza utilizarea și poate economisi costuri. Să presupunem că aveți o aplicație de chat care îi ajută pe turiști să înțeleagă obiceiurile locale și cele mai bune practici construite folosind două variante de Llama 2: una ajustată pentru vizitatorii europeni și cealaltă ajustată pentru vizitatorii americani. Ne așteptăm la trafic pentru modelul european între 00:01–11:59 UTC și pentru modelul american între 12:00–23:59 UTC. În loc să implementați aceste modele pe propriile instanțe dedicate în care vor sta inactiv jumătate din timp, acum le puteți implementa pe un singur punct final pentru a economisi costuri. Puteți reduce modelul american la zero atunci când nu este necesar pentru a elibera capacitatea pentru modelul european și invers. Acest lucru vă permite să utilizați hardware-ul în mod eficient și să evitați risipa. Acesta este un exemplu simplu folosind două modele, dar puteți extinde cu ușurință această idee pentru a împacheta sute de modele într-un singur punct final care se extinde automat în funcție de volumul de lucru.

În această postare, vă arătăm noile capabilități ale punctelor finale SageMaker bazate pe IC. De asemenea, vă ghidăm prin implementarea mai multor modele folosind componente de inferență și API-uri. În cele din urmă, detaliem câteva dintre noile capabilități de observabilitate și cum să configurați politicile de scalare automată pentru modelele dvs. și să gestionați scalarea instanțelor pentru punctele finale. De asemenea, puteți implementa modele prin noua noastră experiență de utilizator simplificată și interactivă. De asemenea, susținem capabilități avansate de rutare pentru a optimiza latența și performanța sarcinilor de lucru de inferență.

Blocuri de construcție

Să aruncăm o privire mai profundă și să înțelegem cum funcționează aceste noi capabilități. Mai jos este o terminologie nouă pentru găzduirea SageMaker:

- Componenta de inferență – Un obiect de găzduire SageMaker pe care îl puteți utiliza pentru a implementa un model la un punct final. Puteți crea o componentă de inferență furnizând următoarele:

- Modelul SageMaker sau specificația unei imagini și artefacte model compatibile cu SageMaker.

- Cerințele de resurse de calcul, care specifică nevoile fiecărei copii a modelului dvs., inclusiv nucleele CPU, memoria gazdă și numărul de acceleratoare.

- Copie model – O copie de rulare a unei componente de inferență care este capabilă să servească cereri.

- Scalare automată a instanțelor gestionate – O capacitate de găzduire SageMaker pentru a crește sau reduce numărul de instanțe de calcul utilizate pentru un punct final. Scalarea instanțelor reacționează la scalarea componentelor de inferență.

Pentru a crea o nouă componentă de inferență, puteți specifica o imagine de container și un artefact de model sau puteți utiliza modele SageMaker pe care este posibil să le fi creat deja. De asemenea, trebuie să specificați cerințele de resurse de calcul, cum ar fi numărul de nuclee ale procesorului gazdă, memoria gazdă sau numărul de acceleratoare pe care modelul dvs. trebuie să ruleze.

Când implementați o componentă de inferență, puteți specifica MinCopies pentru a vă asigura că modelul este deja încărcat în cantitatea de care aveți nevoie, gata de a servi cererile.

Aveți, de asemenea, opțiunea de a vă seta politicile astfel încât copiile componentelor de inferență să se scaleze la zero. De exemplu, dacă nu aveți încărcare care rulează pe un IC, copia modelului va fi descărcată. Acest lucru poate elibera resurse care pot fi înlocuite cu sarcini de lucru active pentru a optimiza utilizarea și eficiența punctului final.

Pe măsură ce cererile de inferență cresc sau scad, numărul de copii ale IC-urilor dvs. poate, de asemenea, să crească sau să scadă în funcție de politicile dvs. de scalare automată. SageMaker se va ocupa de plasare pentru a optimiza ambalarea modelelor dvs. pentru disponibilitate și cost.

În plus, dacă activați scalarea automată a instanțelor gestionate, SageMaker va scala instanțele de calcul în funcție de numărul de componente de inferență care trebuie încărcate la un moment dat pentru a servi traficul. SageMaker va extinde instanțele și va împacheta instanțele și componentele de inferență pentru a optimiza costurile, păstrând în același timp performanța modelului. Deși vă recomandăm utilizarea scalarii instanțelor gestionate, aveți și opțiunea de a gestiona singur scalarea, dacă alegeți, prin scalarea automată a aplicației.

SageMaker va reechilibra componentele de inferență și va reduce instanțele dacă nu mai sunt necesare componentelor de inferență și va economisi costurile.

Prezentarea API-urilor

SageMaker a introdus o nouă entitate numită InferenceComponent. Acest lucru decuplează detaliile găzduirii modelului ML de punctul final în sine. The InferenceComponent vă permite să specificați proprietățile cheie pentru găzduirea modelului, cum ar fi modelul SageMaker pe care doriți să îl utilizați sau detaliile containerului și artefactele modelului. De asemenea, specificați numărul de copii ale componentelor în sine de implementat și numărul de acceleratoare (acceleratoare GPU, Inf sau Trn) sau CPU (vCPU) necesare. Acest lucru oferă mai multă flexibilitate pentru a utiliza un singur punct final pentru orice număr de modele pe care intenționați să le implementați în viitor.

Să ne uităm la apelurile API Boto3 pentru a crea un punct final cu o componentă de inferență. Rețineți că există câțiva parametri pe care îi vom aborda mai târziu în această postare.

Următorul este exemplu de cod pentru CreateEndpointConfig:

Următorul este exemplu de cod pentru CreateEndpoint:

Următorul este exemplu de cod pentru CreateInferenceComponent:

Această decuplare a InferenceComponent la un punct final oferă flexibilitate. Puteți găzdui mai multe modele pe aceeași infrastructură, adăugându-le sau eliminându-le pe măsură ce cerințele dumneavoastră se modifică. Fiecare model poate fi actualizat independent după cum este necesar. În plus, puteți scala modele în funcție de nevoile dvs. de afaceri. InferenceComponent de asemenea, vă permite să controlați capacitatea pe model. Cu alte cuvinte, puteți determina câte copii ale fiecărui model să găzduiți. Această scalare previzibilă vă ajută să îndepliniți cerințele specifice de latență pentru fiecare model. Per total, InferenceComponent vă oferă mult mai mult control asupra modelelor dvs. găzduite.

În tabelul următor, arătăm o comparație alăturată a abordării la nivel înalt pentru crearea și invocarea unui punct final fără InferenceComponent si cu InferenceComponent. Rețineți că CreateModel() este acum opțional pentru punctele finale bazate pe IC.

| Pas | Puncte finale bazate pe model | Inferența punctelor finale bazate pe componente |

| 1 | Creați un model(…) | CreateEndpointConfig(…) |

| 2 | CreateEndpointConfig(…) | Creați un punct final(…) |

| 3 | Creați un punct final(…) | CreateInferenceComponent(…) |

| 4 | InvokeEndpoint(…) | InvokeEndpoint(InferneceComponentName=’valoare’…) |

Introducerea InferenceComponent vă permite să scalați la nivel de model. Vedea Aprofundați în scalarea automată a instanțelor și IC pentru mai multe detalii despre cum InferenceComponent funcționează cu scalare automată.

Când invocați punctul final SageMaker, acum puteți specifica noul parametru InferenceComponentName pentru a lovi doritul InferenceComponentName. SageMaker se va ocupa de rutarea cererii către instanța care găzduiește solicitarea InferenceComponentName. Consultați următorul cod:

În mod implicit, SageMaker utilizează direcționarea aleatorie a cererilor către instanțele care susțin punctul final. Dacă doriți să activați rutarea cererilor cele mai puțin restante, puteți seta strategia de rutare în configurația punctului final. RoutingConfig:

Solicitările cele mai puțin restante direcționează rute către instanțe specifice care au mai multă capacitate de procesare a cererilor. Acest lucru va asigura o echilibrare a sarcinii și o utilizare mai uniformă a resurselor.

În plus față de CreateInferenceComponent, următoarele API-uri sunt acum disponibile:

DescribeInferenceComponentDeleteInferenceComponentUpdateInferenceComponentListInferenceComponents

Jurnalele și valorile InferenceComponent

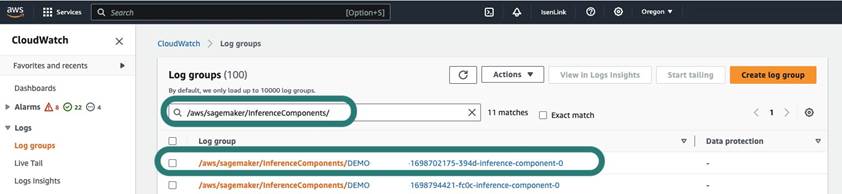

InferenceComponent bustenii sunt situati in /aws/sagemaker/InferenceComponents/<InferenceComponentName>. Toate jurnalele trimise către stderr și stdout din container sunt trimise la aceste loguri Amazon CloudWatch.

Odată cu introducerea punctelor finale bazate pe IC, acum aveți posibilitatea de a vizualiza valori suplimentare ale instanțelor, valori ale componentelor de inferență și valori ale invocarii.

Pentru instanțe SageMaker, acum puteți urmări GPUReservation și CPUReservation pentru a vedea resursele rezervate pentru un punct final pe baza componentelor de inferență pe care le-ați implementat. Aceste valori vă pot ajuta să dimensionați punctele finale și politicile de scalare automată. De asemenea, puteți vizualiza valorile agregate asociate cu toate modelele implementate la un punct final.

SageMaker expune, de asemenea, metrici la nivel de componentă de inferență, care poate afișa o vedere mai granulară a utilizării resurselor pentru componentele de inferență pe care le-ați implementat. Acest lucru vă permite să obțineți o vedere a cât de multă utilizare a resurselor agregate, cum ar fi GPUUtilizationNormalized și GPUMemoryUtilizationNormalized pentru fiecare componentă de inferență pe care ați implementat-o și care poate avea zero sau mai multe copii.

În cele din urmă, SageMaker oferă valori de invocare, care acum urmăresc invocările pentru componentele de inferență în mod agregat (Invocations) sau per copie instanțiată (InvocationsPerCopy)

Pentru o listă cuprinzătoare de valori, consultați SageMaker Endpoint Invocation Metrics.

Scalare automată la nivel de model

Pentru a implementa comportamentul de scalare automată pe care l-am descris, atunci când creați configurația punctului final SageMaker și componenta de inferență, definiți numărul inițial de instanțe și, respectiv, numărul inițial de copiere a modelului. După ce creați punctul final și IC-urile corespunzătoare, pentru a aplica scalarea automată la nivel de IC, trebuie să înregistrați mai întâi ținta de scalare și apoi să asociați politica de scalare la IC.

Când implementăm politica de scalare, folosim SageMakerInferenceComponentInvocationsPerCopy, care este o nouă măsurătoare introdusă de SageMaker. Captează numărul mediu de invocări per copie de model pe minut.

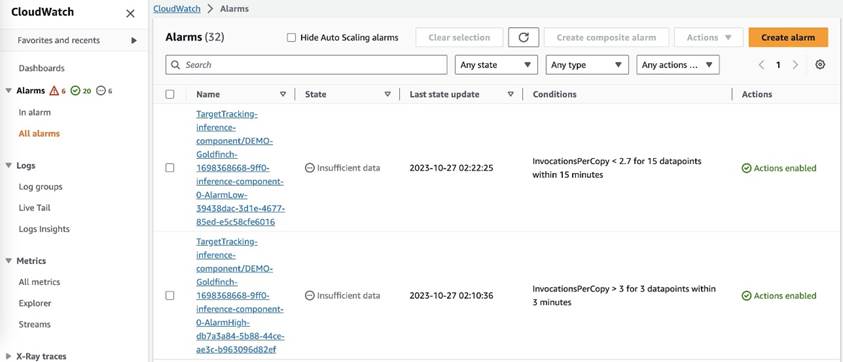

După ce setați politica de scalare, SageMaker creează două alarme CloudWatch pentru fiecare țintă de autoscaling: una pentru a declanșa scale-out dacă este în alarmă timp de 3 minute (trei puncte de date de 1 minut) și una pentru a declanșa scale-in dacă este în alarmă timp de 15 minute (15 puncte de date de 1 minut), așa cum se arată în următoarea captură de ecran. Timpul de declanșare a acțiunii de scalare este de obicei cu 1-2 minute mai lung decât acele minute, deoarece punctul final necesită timp pentru a publica valorile în CloudWatch și, de asemenea, este nevoie de timp pentru AutoScaling a reactiona. Perioada de răcire este perioada de timp, în secunde, după finalizarea unei activități de scalare sau extindere înainte ca o altă activitate de extindere poate începe. Dacă timpul de răcire a scalei-out este mai scurt decât timpul de actualizare a punctului final, atunci nu are efect, deoarece nu este posibil să actualizați un punct final SageMaker atunci când este în Actualizarea stare.

Rețineți că, atunci când configurați scalarea automată la nivel de IC, trebuie să vă asigurați că MaxInstanceCount parametrul este egal sau mai mic decât numărul maxim de circuite integrate pe care acest punct final le poate gestiona. De exemplu, dacă punctul final este configurat doar pentru a avea o singură instanță în configurația punctului final și această instanță poate găzdui doar maximum patru copii ale modelului, atunci MaxInstanceCount ar trebui să fie egal cu sau mai mic decât 4. Cu toate acestea, puteți utiliza și capacitatea de scalare automată gestionată oferită de SageMaker pentru a scala automat numărul de instanțe pe baza numărului de copiere a modelului necesar pentru a satisface nevoia de mai multe resurse de calcul. Următorul fragment de cod demonstrează cum să configurați scalarea instanței gestionate în timpul creării configurației punctului final. În acest fel, atunci când scalarea automată la nivel de IC necesită un număr mai mare de instanțe pentru a găzdui copiile modelului, SageMaker va scala automat numărul de instanță pentru a permite scalarea la nivel de IC să aibă succes.

Puteți aplica mai multe politici de scalare automată față de același punct final, ceea ce înseamnă că veți putea aplica politica tradițională de scalare automată la punctele finale create cu CI și să scalați în sus și în jos pe baza celorlalte valori ale punctelor finale. Pentru mai multe informații, consultați Optimizați-vă implementările de învățare automată cu scalarea automată pe Amazon SageMaker. Cu toate acestea, deși acest lucru este posibil, vă recomandăm totuși să utilizați scalarea instanțelor gestionate în loc de gestionarea personală a scalării.

Concluzie

În această postare, am introdus o nouă caracteristică în inferența SageMaker care vă va ajuta să maximizați utilizarea instanțelor de calcul, să scalați la sute de modele și să optimizați costurile, oferind în același timp performanțe previzibile. În plus, am oferit o prezentare a API-urilor și v-am arătat cum să configurați și să implementați componente de inferență pentru sarcinile dvs. de lucru.

Sustinem si noi capabilități avansate de rutare pentru a optimiza latența și performanța sarcinilor de lucru de inferență. SageMaker vă poate ajuta să vă optimizați sarcinile de lucru de inferență pentru costuri și performanță și vă poate oferi granularitate la nivel de model pentru management. Am creat un set de caiete care vă va arăta cum să implementați trei modele diferite, folosind containere diferite și aplicând politici de scalare automată în GitHub. Vă încurajăm să începeți cu notebook-ul 1 și să puneți mâna mai departe cu noile capabilități de găzduire SageMaker astăzi!

Despre autori

James Park este arhitect de soluții la Amazon Web Services. El lucrează cu Amazon.com pentru a proiecta, construi și implementa soluții tehnologice pe AWS și are un interes deosebit pentru AI și învățarea automată. În timpul liber, îi place să caute noi culturi, experiențe noi și să fie la curent cu cele mai recente tendințe tehnologice. Îl poți găsi pe LinkedIn.

James Park este arhitect de soluții la Amazon Web Services. El lucrează cu Amazon.com pentru a proiecta, construi și implementa soluții tehnologice pe AWS și are un interes deosebit pentru AI și învățarea automată. În timpul liber, îi place să caute noi culturi, experiențe noi și să fie la curent cu cele mai recente tendințe tehnologice. Îl poți găsi pe LinkedIn.

Melanie Li, PhD, este TAM Senior AI/ML Specialist la AWS cu sediul în Sydney, Australia. Ea ajută clienții întreprinderilor să construiască soluții folosind instrumente AI/ML de ultimă generație pe AWS și oferă îndrumări privind arhitectura și implementarea soluțiilor ML cu cele mai bune practici. În timpul liber, îi place să exploreze natura și să petreacă timp cu familia și prietenii.

Melanie Li, PhD, este TAM Senior AI/ML Specialist la AWS cu sediul în Sydney, Australia. Ea ajută clienții întreprinderilor să construiască soluții folosind instrumente AI/ML de ultimă generație pe AWS și oferă îndrumări privind arhitectura și implementarea soluțiilor ML cu cele mai bune practici. În timpul liber, îi place să exploreze natura și să petreacă timp cu familia și prietenii.

Marc Karp este arhitect ML cu echipa Amazon SageMaker Service. El se concentrează pe a ajuta clienții să proiecteze, să implementeze și să gestioneze sarcinile de lucru ML la scară. În timpul liber, îi place să călătorească și să exploreze locuri noi.

Marc Karp este arhitect ML cu echipa Amazon SageMaker Service. El se concentrează pe a ajuta clienții să proiecteze, să implementeze și să gestioneze sarcinile de lucru ML la scară. În timpul liber, îi place să călătorească și să exploreze locuri noi.

Alan Tan este Senior Product Manager la SageMaker, conducând eforturile pentru inferența modelelor mari. Este pasionat de aplicarea învățării automate în domeniul analizei. În afara serviciului, se bucură de aer liber.

Alan Tan este Senior Product Manager la SageMaker, conducând eforturile pentru inferența modelelor mari. Este pasionat de aplicarea învățării automate în domeniul analizei. În afara serviciului, se bucură de aer liber.

Raghu Ramesha este arhitect senior de soluții ML cu echipa Amazon SageMaker Service. El se concentrează pe a ajuta clienții să construiască, să implementeze și să migreze sarcinile de lucru de producție ML către SageMaker la scară. El este specializat în domeniile învățarea automată, AI și viziunea pe computer și deține o diplomă de master în Informatică de la UT Dallas. În timpul liber, îi place să călătorească și să fotografieze.

Raghu Ramesha este arhitect senior de soluții ML cu echipa Amazon SageMaker Service. El se concentrează pe a ajuta clienții să construiască, să implementeze și să migreze sarcinile de lucru de producție ML către SageMaker la scară. El este specializat în domeniile învățarea automată, AI și viziunea pe computer și deține o diplomă de master în Informatică de la UT Dallas. În timpul liber, îi place să călătorească și să fotografieze.

Rupinder Grewal este un arhitect specializat în soluții Sr Ai/ML cu AWS. În prezent, se concentrează pe servirea modelelor și a MLOps-ului pe SageMaker. Înainte de acest rol, a lucrat ca inginer de învățare automată, construind și găzduind modele. În afara serviciului, îi place să joace tenis și să meargă cu bicicleta pe traseele montane.

Rupinder Grewal este un arhitect specializat în soluții Sr Ai/ML cu AWS. În prezent, se concentrează pe servirea modelelor și a MLOps-ului pe SageMaker. Înainte de acest rol, a lucrat ca inginer de învățare automată, construind și găzduind modele. În afara serviciului, îi place să joace tenis și să meargă cu bicicleta pe traseele montane.

Dhawal Patel este arhitect principal de învățare automată la AWS. El a lucrat cu organizații, de la întreprinderi mari până la startup-uri mijlocii, pe probleme legate de calculul distribuit și inteligența artificială. El se concentrează pe învățarea profundă, inclusiv pe domeniile NLP și Computer Vision. El îi ajută pe clienți să obțină inferențe de model de înaltă performanță pe SageMaker.

Dhawal Patel este arhitect principal de învățare automată la AWS. El a lucrat cu organizații, de la întreprinderi mari până la startup-uri mijlocii, pe probleme legate de calculul distribuit și inteligența artificială. El se concentrează pe învățarea profundă, inclusiv pe domeniile NLP și Computer Vision. El îi ajută pe clienți să obțină inferențe de model de înaltă performanță pe SageMaker.

Saurabh Trikande este Senior Product Manager pentru Amazon SageMaker Inference. Este pasionat de lucrul cu clienții și este motivat de obiectivul democratizării învățării automate. El se concentrează pe provocările de bază legate de implementarea de aplicații ML complexe, modele ML multi-locatari, optimizări ale costurilor și de a face implementarea modelelor de învățare profundă mai accesibilă. În timpul liber, lui Saurabh îi place să facă drumeții, să învețe despre tehnologii inovatoare, să urmeze TechCrunch și să petreacă timpul cu familia sa.

Saurabh Trikande este Senior Product Manager pentru Amazon SageMaker Inference. Este pasionat de lucrul cu clienții și este motivat de obiectivul democratizării învățării automate. El se concentrează pe provocările de bază legate de implementarea de aplicații ML complexe, modele ML multi-locatari, optimizări ale costurilor și de a face implementarea modelelor de învățare profundă mai accesibilă. În timpul liber, lui Saurabh îi place să facă drumeții, să învețe despre tehnologii inovatoare, să urmeze TechCrunch și să petreacă timpul cu familia sa.

Lakshmi Ramakrishnan este inginer principal la echipa platformei Amazon SageMaker Machine Learning (ML) din AWS, oferind conducere tehnică pentru produs. El a lucrat în mai multe roluri de inginerie în Amazon de peste 9 ani. Are o diplomă de licență în Inginerie în Tehnologia Informației de la Institutul Național de Tehnologie, Karnataka, India și o diplomă de Master în Științe Informatice de la Universitatea din Minnesota Twin Cities.

Lakshmi Ramakrishnan este inginer principal la echipa platformei Amazon SageMaker Machine Learning (ML) din AWS, oferind conducere tehnică pentru produs. El a lucrat în mai multe roluri de inginerie în Amazon de peste 9 ani. Are o diplomă de licență în Inginerie în Tehnologia Informației de la Institutul Național de Tehnologie, Karnataka, India și o diplomă de Master în Științe Informatice de la Universitatea din Minnesota Twin Cities.

David Nigenda este inginer senior de dezvoltare software în echipa Amazon SageMaker, care lucrează în prezent la îmbunătățirea fluxurilor de lucru de învățare automată de producție, precum și la lansarea de noi funcții de inferență. În timpul liber, încearcă să țină pasul cu copiii săi.

David Nigenda este inginer senior de dezvoltare software în echipa Amazon SageMaker, care lucrează în prezent la îmbunătățirea fluxurilor de lucru de învățare automată de producție, precum și la lansarea de noi funcții de inferență. În timpul liber, încearcă să țină pasul cu copiii săi.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- Sursa: https://aws.amazon.com/blogs/machine-learning/reduce-model-deployment-costs-by-50-on-average-using-sagemakers-latest-features/

- :are

- :este

- :nu

- :Unde

- $UP

- 1

- 10

- 100

- 114

- 12

- 13

- 15%

- 150

- 16

- 22

- 360

- 362

- 500

- 7

- 9

- a

- capacitate

- Capabil

- Despre Noi

- rezumate

- acceleratoare

- accesibil

- Conform

- Obține

- Acțiune

- activ

- activitate

- adăuga

- adăugare

- plus

- Suplimentar

- În plus,

- adresa

- avansat

- După

- împotriva

- agregat

- AI

- AI / ML

- Alan

- alarmă

- TOATE

- permite

- permite

- deja

- de asemenea

- Cu toate ca

- mereu

- Amazon

- Amazon SageMaker

- Amazon Web Services

- Amazon.com

- american

- sumă

- an

- Google Analytics

- și

- O alta

- Orice

- api

- API-uri

- aplicație

- aplicatii

- Aplică

- Aplicarea

- abordare

- SUNT

- ZONĂ

- artificial

- inteligență artificială

- AS

- Avocat Colaborator

- asociate

- At

- Australia

- Auto

- în mod automat

- disponibilitate

- disponibil

- in medie

- evita

- AWS

- sprijin

- bazat

- BE

- deoarece

- înainte

- comportament

- Beneficiile

- CEL MAI BUN

- Cele mai bune practici

- Mai bine

- între

- construi

- Clădire

- construit

- afaceri

- dar

- by

- denumit

- apeluri

- CAN

- capacități

- capacitate

- capabil

- Capacitate

- capturi

- sigur

- provocări

- provocare

- Schimbare

- Alege

- Oraşe

- cod

- COM

- comparație

- Completă

- finalizeaza

- complex

- component

- componente

- cuprinzător

- Calcula

- calculator

- Informatică

- Computer Vision

- tehnica de calcul

- Configuraţie

- configurat

- consistent

- mereu

- mistuitor

- Recipient

- Containere

- Control

- Nucleu

- Corespunzător

- A costat

- economii

- Cheltuieli

- ar putea

- crea

- a creat

- creează

- Crearea

- creaţie

- În prezent

- clienţii care

- vamă

- Dallas

- de date

- puncte de date

- Data

- scădea

- dedicat

- adânc

- învățare profundă

- Mai adânc

- Mod implicit

- defini

- Grad

- se îngropa

- democratizarea

- demonstrează

- În funcție

- implementa

- dislocate

- Implementarea

- desfășurarea

- implementări

- descris

- Amenajări

- dorit

- detaliu

- detalii

- Determina

- Dezvoltare

- diferit

- dificil

- distribuite

- calcul distribuit

- do

- domenii

- Dont

- jos

- în timpul

- dinamic

- fiecare

- cu ușurință

- efect

- eficiență

- eficient

- Eforturile

- permite

- activat

- permite

- încuraja

- Punct final

- inginer

- Inginerie

- asigura

- Afacere

- Companii

- entitate

- egal

- european

- exemplu

- aștepta

- experienţă

- Experiențe

- explora

- Explorarea

- extinde

- familie

- Caracteristică

- DESCRIERE

- camp

- Găsi

- First

- Flexibilitate

- se concentrează

- următor

- Pentru

- Fundație

- patru

- Gratuit

- Prietenii lui

- din

- complet

- În plus

- viitor

- obține

- gif

- GitHub

- Da

- dat

- oferă

- scop

- GPU

- unități de procesare grafică

- granular

- îndrumare

- Jumătate

- manipula

- mâini

- Piese metalice

- Avea

- he

- ajutor

- ajutor

- ajută

- ei

- Înalt

- la nivel înalt

- -l

- lui

- Lovit

- deține

- gazdă

- găzduit

- găzduire

- ORE

- Cum

- Cum Pentru a

- Totuși

- http

- HTTPS

- sute

- idee

- Idle

- if

- ilustra

- imagine

- punerea în aplicare a

- Punere în aplicare a

- important

- îmbunătățirea

- in

- În altele

- Inclusiv

- Crește

- independent

- India

- ineficace

- informații

- tehnologia informației

- Infrastructură

- inițială

- inovatoare

- tehnologii inovatoare

- instanță

- in schimb

- Institut

- Inteligență

- interactiv

- interes

- în

- introdus

- Introducere

- IT

- ESTE

- în sine

- jpg

- A pastra

- păstrare

- Cheie

- copii

- mare

- Întreprinderi mari

- în cele din urmă

- Latență

- mai tarziu

- Ultimele

- lansare

- Conducere

- conducere

- învăţare

- cel mai puțin

- Nivel

- ca

- Listă

- Lamă

- încărca

- local

- situat

- mai lung

- Uite

- cautati

- iubeste

- maşină

- masina de învățare

- face

- Efectuarea

- administra

- gestionate

- administrare

- manager

- de conducere

- multe

- maestru

- studii de masterat

- Maximaliza

- maxim

- Mai..

- mijloace

- Întâlni

- Memorie

- metric

- Metrici

- migra

- minim

- minut

- minute

- ML

- MLOps

- model

- Modele

- mai mult

- motivat

- Munte

- mult

- multiplu

- național

- Natură

- Nevoie

- necesar

- nevoilor

- Nou

- nlp

- Nu.

- nota

- caiet

- acum

- număr

- obiect

- of

- oferi

- de multe ori

- on

- ONE

- afară

- pe

- Optimizați

- optimizarea

- Opțiune

- or

- orchestrație

- organizații

- Altele

- al nostru

- afară

- în aer liber

- iesiri

- exterior

- remarcabil

- peste

- global

- propriu

- Ambalaj

- Paralel

- parametru

- parametrii

- special

- pasionat

- Model

- modele

- pentru

- performanță

- perioadă

- PhD

- fotografie

- Loc

- plasare

- Locuri

- plan

- platformă

- Plato

- Informații despre date Platon

- PlatoData

- joc

- puncte

- Politicile

- Politica

- posibil

- Post

- putere

- practicile

- prezice

- predictibil

- păstrarea

- Principal

- anterior

- probleme

- proces

- Produs

- manager de produs

- producere

- proprietăţi

- furniza

- prevăzut

- furnizează

- furnizarea

- publica

- cantitate

- aleator

- gamă

- variind

- Reacţiona

- reacţionează

- gata

- reechilibreze

- recomanda

- reduce

- reducerea

- trimite

- Inregistreaza-te

- legate de

- scoate

- eliminarea

- înlocuiește

- solicita

- cereri de

- necesita

- necesar

- Cerinţe

- Necesită

- rezervat

- resursă

- Resurse

- respectiv

- răspuns

- Rol

- rolurile

- rute

- rutare

- Alerga

- funcţionare

- Runtime

- sagemaker

- SageMaker Inference

- acelaşi

- Economisiți

- Economie

- Spune

- Scară

- cântare

- scalare

- Ştiinţă

- secunde

- vedea

- caută

- senior

- trimis

- propoziție

- servi

- serviciu

- Servicii

- servire

- set

- instalare

- câteva

- Distribuie

- ea

- să

- Arăta

- a arătat

- indicat

- semnificativ

- simplu

- simplificată

- singur

- sta

- Mărimea

- mai mici

- fragment

- So

- Software

- de dezvoltare de software

- soluţii

- unele

- specialist

- specializată

- specific

- specificație

- petrece

- Cheltuire

- cui

- piroane

- Începe

- Startup-urile

- de ultimă oră

- Stare

- ședere

- Încă

- Strategie

- de succes

- astfel de

- furnizarea

- a sustine

- Sprijină

- sigur

- sydney

- tabel

- Lua

- ia

- Ţintă

- echipă

- TechCrunch

- Tehnic

- Tehnologii

- Tehnologia

- tenis

- terminologie

- decât

- acea

- Zona

- Viitorul

- lor

- Lor

- apoi

- Acolo.

- Acestea

- ei

- acest

- aceste

- trei

- Prin

- timp

- la

- Unelte

- urmări

- tradiţional

- trafic

- Traveling

- Tendinţe

- declanşa

- geamăn

- Două

- înţelege

- universitate

- imprevizibil

- Actualizează

- actualizat

- Folosire

- utilizare

- utilizat

- Utilizator

- Experiența de utilizare

- utilizatorii

- utilizări

- folosind

- obișnuit

- UTC

- folosi

- viciu

- Vizualizare

- viziune

- vizitatori

- umbla

- walkthrough

- vrea

- Deșeuri

- Cale..

- modalități de

- we

- web

- servicii web

- BINE

- cand

- întrucât

- care

- în timp ce

- voi

- cu

- fără

- cuvinte

- Apartamente

- a lucrat

- fluxuri de lucru

- de lucru

- fabrică

- ani

- Tu

- Ta

- te

- zephyrnet

- zero