Introducere

În învățarea automată, compromisul bias-varianță este un concept fundamental care afectează performanța oricărui model predictiv. Se referă la echilibrul delicat dintre eroarea de părtinire și eroarea de varianță a unui model, deoarece este imposibil să le minimizezi simultan pe ambele. Găsirea echilibrului corect este crucială pentru obținerea performanței optime a modelului.

În acest scurt articol, vom defini părtinirea și varianța, vom explica modul în care acestea afectează un model de învățare automată și vom oferi câteva sfaturi practice despre cum să le gestionăm în practică.

Înțelegerea părtinirii și a variației

Înainte de a aborda relația dintre părtinire și varianță, să definim ce reprezintă acești termeni în învățarea automată.

Eroarea de părtinire se referă la diferența dintre predicția unui model și valorile corecte pe care încearcă să le prezică (adevărul de bază). Cu alte cuvinte, părtinirea este eroarea pe care o comite un model din cauza ipotezelor sale incorecte cu privire la distribuția datelor subiacente. Modelele de părtinire ridicată sunt adesea prea simpliste, nereușind să surprindă complexitatea datelor, ceea ce duce la o adaptare insuficientă.

Eroarea de varianță, pe de altă parte, se referă la sensibilitatea modelului la mici fluctuații ale datelor de antrenament. Modelele cu variație mare sunt excesiv de complexe și tind să se potrivească mai degrabă cu zgomotul din date decât cu modelul de bază, ceea ce duce la supraadaptare. Acest lucru duce la o performanță slabă pentru date noi, nevăzute.

Prejudecățile ridicate pot duce la o adaptare insuficientă, în cazul în care modelul este prea simplu pentru a captura complexitatea datelor. Face ipoteze puternice despre date și nu reușește să surprindă relația adevărată dintre variabilele de intrare și de ieșire. Pe de altă parte, varianța mare poate duce la supraadaptare, în cazul în care modelul este prea complex și învață mai degrabă zgomotul din date decât relația de bază dintre variabilele de intrare și de ieșire. Astfel, modelele de supraadaptare tind să se potrivească prea mult cu datele de antrenament și nu se vor generaliza bine la datele noi, în timp ce modelele de subadaptare nici măcar nu sunt capabile să se potrivească cu precizie la datele de antrenament.

După cum sa menționat mai devreme, părtinirea și varianța sunt legate, iar un model bun echilibrează eroarea de părtinire și eroarea de varianță. Compensația bias-varianță este procesul de găsire a echilibrului optim între aceste două surse de eroare. Un model cu părtinire scăzută și varianță scăzută va funcționa probabil bine atât la antrenament, cât și la datele noi, minimizând eroarea totală.

Schimbul de părtinire-varianță

Obținerea unui echilibru între complexitatea modelului și capacitatea acestuia de a generaliza la date necunoscute este nucleul compromisului de variație de părtinire. În general, un model mai complex va avea o părtinire mai mică, dar o varianță mai mare, în timp ce un model mai simplu va avea o părtinire mai mare, dar o varianță mai mică.

Deoarece este imposibil să minimizezi simultan părtinirea și varianța, găsirea echilibrului optim între ele este crucială în construirea unui model robust de învățare automată. De exemplu, pe măsură ce creștem complexitatea unui model, creștem și varianța. Acest lucru se datorează faptului că un model mai complex este mai probabil să se potrivească cu zgomotul din datele de antrenament, ceea ce va duce la supraadaptare.

Pe de altă parte, dacă păstrăm modelul prea simplu, vom crește părtinirea. Acest lucru se datorează faptului că un model mai simplu nu va putea surprinde relațiile de bază în date, ceea ce va duce la subadaptare.

Scopul este de a antrena un model care este suficient de complex pentru a capta relațiile de bază din datele de antrenament, dar nu atât de complex încât să se potrivească cu zgomotul din datele de antrenament.

Schimbul de părtinire-varianță în practică

Pentru a diagnostica performanța modelului, de obicei calculăm și comparăm erorile de tren și de validare. Un instrument util pentru vizualizarea acestui lucru este un grafic al curbelor de învățare, care afișează performanța modelului atât pe tren, cât și pe datele de validare pe tot parcursul procesului de antrenament. Examinând aceste curbe, putem determina dacă un model este supraadaptat (varianță mare), subadaptare (bias mare) sau bine adaptat (echilibru optim între părtinire și varianță).

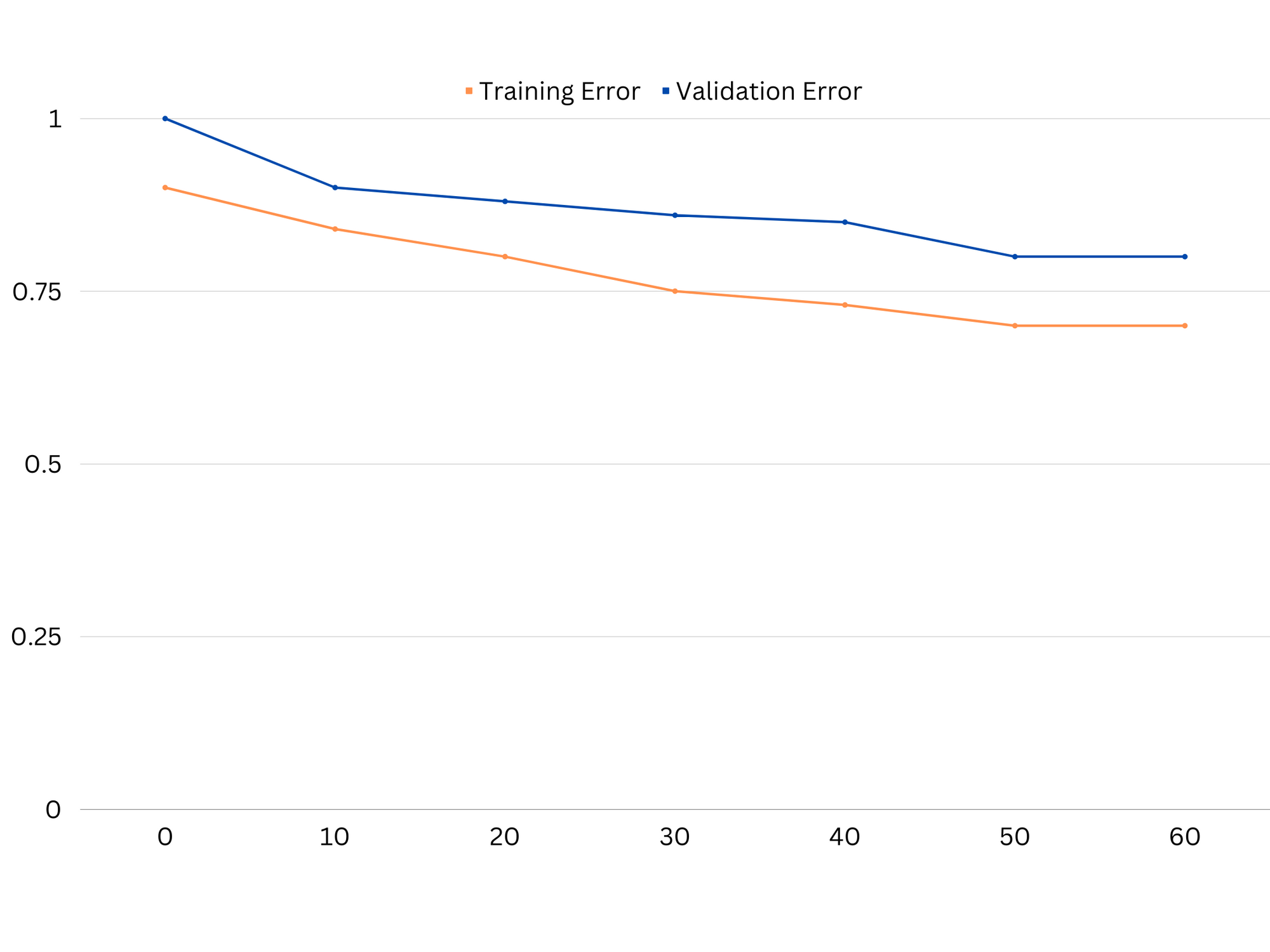

Exemplu de curbe de învățare ale unui model de underfitting. Atât eroarea de tren, cât și eroarea de validare sunt mari.

În practică, performanța scăzută atât a datelor de instruire, cât și a datelor de validare sugerează că modelul este prea simplu, ceea ce duce la o adaptare insuficientă. Pe de altă parte, dacă modelul funcționează foarte bine pe datele de antrenament, dar slab pe datele de testare, complexitatea modelului este probabil prea mare, ducând la supraadaptare. Pentru a aborda subadaptarea, putem încerca să creștem complexitatea modelului adăugând mai multe caracteristici, schimbând algoritmul de învățare sau alegând diferiți hiperparametri. În cazul supraajustării, ar trebui să luăm în considerare regularizarea modelului sau utilizarea unor tehnici precum validarea încrucișată pentru a-și îmbunătăți capacitățile de generalizare.

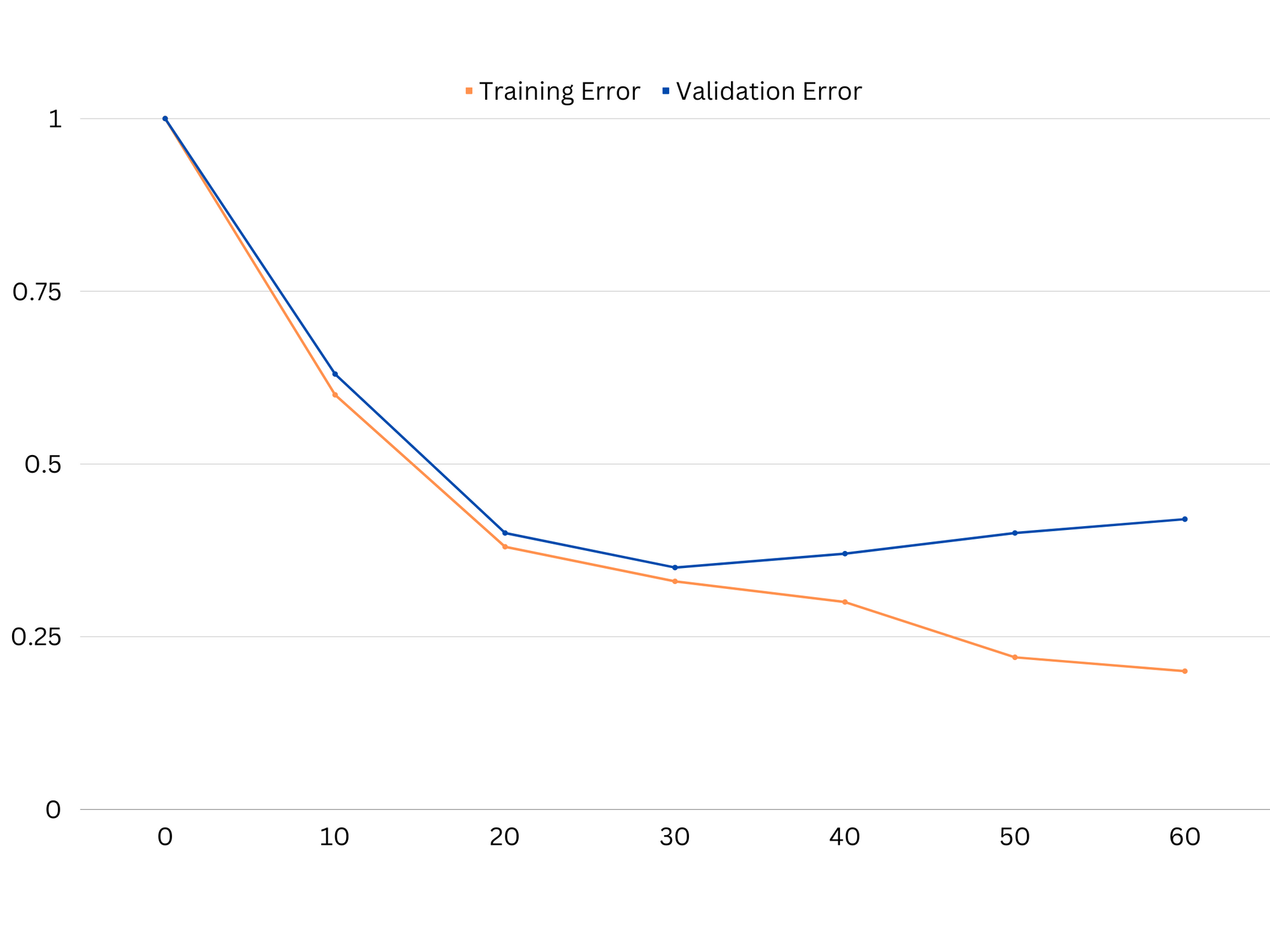

Exemplu de curbe de învățare ale unui model de supraadaptare. Eroarea trenului scade în timp ce eroarea de validare începe să crească. Modelul nu poate generaliza.

Regularizarea este o tehnică care poate fi utilizată pentru a reduce eroarea de varianță în modelele de învățare automată, ajutând la abordarea compromisului de prejudecată-varianță. Există o serie de tehnici de regularizare diferite, fiecare cu propriile avantaje și dezavantaje. Unele tehnici de regularizare populare includ regresia crestei, regresia lasso și regularizarea rețelei elastice. Toate aceste tehnici ajută la prevenirea supraajustării prin adăugarea unui termen de penalizare la funcția obiectivă a modelului, care descurajează valorile extreme ale parametrilor și încurajează modele mai simple.

Regresia crestei, cunoscută și sub denumirea de regularizare L2, adaugă un termen de penalizare proporțional cu pătratul parametrilor modelului. Această tehnică tinde să aibă ca rezultat modele cu valori mai mici ale parametrilor, ceea ce poate duce la o variație redusă și o generalizare îmbunătățită. Cu toate acestea, nu efectuează selecția caracteristicilor, așa că toate caracteristicile rămân în model.

Consultați ghidul nostru practic și practic pentru a învăța Git, cu cele mai bune practici, standarde acceptate de industrie și fisa de cheat incluse. Opriți căutarea pe Google a comenzilor Git și de fapt învăţa aceasta!

Regresia lazo, sau regularizarea L1, adaugă un termen de penalizare proporțional cu valoarea absolută a parametrilor modelului. Această tehnică poate duce la modele cu valori rare ale parametrilor, efectuând în mod eficient selecția caracteristicilor prin setarea unor parametri la zero. Acest lucru poate duce la modele mai simple, care sunt mai ușor de interpretat.

Regularizare plasă elastică este o combinație între regularizarea L1 și L2, permițând un echilibru între regresia crestei și lazo. Prin controlul raportului dintre cei doi termeni de penalizare, plasa elastică poate obține beneficiile ambelor tehnici, cum ar fi generalizarea îmbunătățită și selecția caracteristicilor.

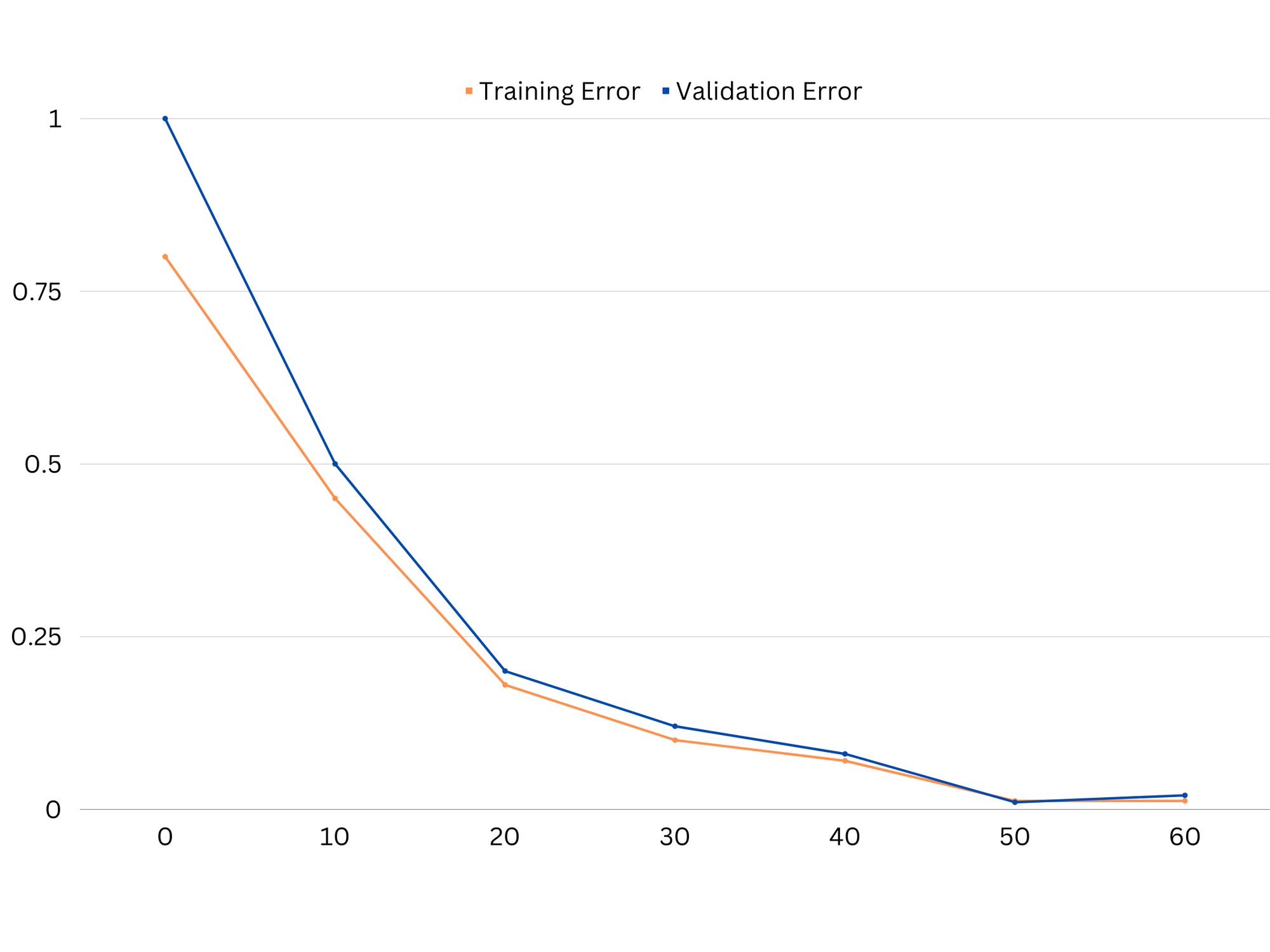

Exemplu de curbe de învățare ale modelului de potrivire bună.

Concluzii

Compensația părtinire-varianță este un concept crucial în învățarea automată care determină eficacitatea și bunătatea unui model. În timp ce prejudecățile ridicate duce la subadaptare, iar variația mare duce la supraadaptare, găsirea echilibrului optim între cele două este necesară pentru a construi modele robuste care se generalizează bine la datele noi.

Cu ajutorul curbelor de învățare, este posibilă identificarea problemelor de supraadaptare sau subadaptare, iar prin reglarea complexității modelului sau implementarea tehnicilor de regularizare, este posibilă îmbunătățirea performanței atât asupra datelor de antrenament, cât și a datelor de validare, precum și a datelor de testare.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoAiStream. Web3 Data Intelligence. Cunoștințe amplificate. Accesați Aici.

- Mintând viitorul cu Adryenn Ashley. Accesați Aici.

- Cumpărați și vindeți acțiuni în companii PRE-IPO cu PREIPO®. Accesați Aici.

- Sursa: https://stackabuse.com/the-bias-variance-trade-off-in-machine-learning/

- :este

- :nu

- :Unde

- 1

- 12

- 20

- 8

- a

- capacitate

- Capabil

- Despre Noi

- Absolut

- precis

- Obține

- realizarea

- de fapt

- adăugare

- adresa

- Adaugă

- Avantajele

- sfat

- afecta

- care afectează

- Algoritmul

- TOATE

- Permiterea

- de asemenea

- an

- și

- Orice

- SUNT

- articol

- AS

- Sold

- soldurile

- BE

- deoarece

- Beneficiile

- între

- părtinire

- frontieră

- atât

- Clădire

- dar

- by

- calcula

- CAN

- capacități

- captura

- caz

- schimbarea

- alegere

- îndeaproape

- combinaţie

- comparaţie

- complex

- complexitate

- concept

- Lua în considerare

- controlul

- Nucleu

- corecta

- crucial

- de date

- afacere

- scade

- Determina

- determină

- diferenţă

- diferit

- afișează

- distribuire

- face

- două

- fiecare

- Mai devreme

- mai ușor

- în mod eficient

- eficacitate

- încurajează

- suficient de

- eroare

- Erori

- Chiar

- examinator

- exemplu

- Explica

- extremă

- în lipsa

- eșuează

- Caracteristică

- DESCRIERE

- descoperire

- potrivi

- montaj

- fluctuațiile

- Concentra

- Pentru

- funcţie

- fundamental

- General

- merge

- scop

- bine

- Teren

- ghida

- mână

- hands-on

- Avea

- ajutor

- ajutor

- Înalt

- superior

- planare

- Cum

- Cum Pentru a

- Totuși

- HTTPS

- identifica

- if

- Punere în aplicare a

- imposibil

- îmbunătăţi

- îmbunătățit

- in

- În altele

- include

- inclus

- Crește

- crescând

- intrare

- în

- Introducere

- IT

- ESTE

- A pastra

- cunoscut

- L1

- l2

- conduce

- conducere

- Conduce

- învăţare

- lăsa

- LG

- ca

- Probabil

- ll

- Jos

- LOWER

- maşină

- masina de învățare

- FACE

- menționat

- minimizând

- model

- Modele

- mai mult

- necesar

- net

- Nou

- Zgomot

- număr

- obiectiv

- of

- de multe ori

- on

- optimă

- or

- Altele

- al nostru

- afară

- producție

- propriu

- parametru

- parametrii

- Model

- Efectua

- performanță

- efectuarea

- efectuează

- Plato

- Informații despre date Platon

- PlatoData

- sărac

- Popular

- posibil

- Practic

- practică

- prezice

- prezicere

- împiedica

- probleme

- proces

- furniza

- mai degraba

- raport

- reduce

- Redus

- se referă

- legate de

- relaţie

- Relaţii

- rămâne

- reprezenta

- rezultat

- rezultând

- REZULTATE

- dreapta

- Inel

- robust

- s

- selecţie

- Sensibilitate

- instalare

- Umbră

- coală

- Pantaloni scurți

- să

- simplu

- simultan

- mic

- mai mici

- So

- unele

- Surse

- pătrat

- Stackabuse

- standarde

- Stop

- puternic

- astfel de

- sugerează

- tehnici de

- durată

- termeni

- test

- decât

- acea

- lor

- Lor

- Acolo.

- Acestea

- ei

- acest

- de-a lungul

- la

- de asemenea

- instrument

- Total

- Tren

- Pregătire

- tranziţie

- adevărat

- Adevăr

- încerca

- Două

- tipic

- incapabil

- care stau la baza

- necunoscut

- utilizat

- folosind

- validare

- valoare

- Valori

- foarte

- we

- BINE

- Ce

- dacă

- care

- în timp ce

- voi

- cu

- cuvinte

- zephyrnet

- zero