Modelele de limbaj generativ s-au dovedit remarcabil de abil în rezolvarea sarcinilor logice și analitice de procesare a limbajului natural (NLP). În plus, utilizarea de inginerie promptă le pot îmbunătăți în mod semnificativ performanța. De exemplu, lanțul-gândirii (CoT) este cunoscut că îmbunătățește capacitatea unui model pentru probleme complexe în mai multe etape. Pentru a spori în plus acuratețea sarcinilor care implică raționament, a auto-consecvență s-a sugerat o abordare stimulatoare, care înlocuiește lacomul cu decodarea stocastică în timpul generării limbajului.

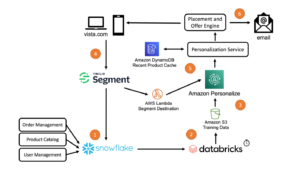

Amazon Bedrock este un serviciu complet gestionat care oferă o gamă de modele de fundație de înaltă performanță de la companii de IA și Amazon prin intermediul unui singur API, împreună cu un set larg de capabilități pentru a construi AI generativă aplicații cu securitate, confidențialitate și IA responsabilă. Cu inferență în lot API, puteți utiliza Amazon Bedrock pentru a efectua inferențe cu modele de fundație în loturi și pentru a obține răspunsuri mai eficient. Această postare arată cum să implementați promptarea de auto-consecvență prin inferență în lot pe Amazon Bedrock pentru a îmbunătăți performanța modelului în sarcinile aritmetice și de raționament cu alegeri multiple.

Prezentare generală a soluției

Îndemnul de auto-consecvență a modelelor de limbaj se bazează pe generarea de răspunsuri multiple care sunt agregate într-un răspuns final. Spre deosebire de abordările cu o singură generație, cum ar fi CoT, procedura de eșantionare și marginalizare cu auto-consecvență creează o serie de completări de model care conduc la o soluție mai consistentă. Generarea de răspunsuri diferite pentru un prompt dat este posibilă datorită utilizării unei strategii de decodare stocastice, mai degrabă decât lacome.

Următoarea figură arată modul în care auto-coerența diferă de CoT lacom prin faptul că generează un set divers de căi de raționament și le agregează pentru a produce răspunsul final.

Strategii de decodare pentru generarea de text

Textul generat de modelele de limbaj numai cu decodor se desfășoară cuvânt cu cuvânt, simbolul următor fiind prezis pe baza contextului precedent. Pentru un prompt dat, modelul calculează o distribuție de probabilitate care indică probabilitatea ca fiecare jeton să apară în continuare în secvență. Decodificarea implică traducerea acestor distribuții de probabilitate în text real. Generarea textului este mediată de un set de parametrii de inferență care sunt adesea hiperparametri ai metodei de decodare în sine. Un exemplu este temperatură, care modulează distribuția de probabilitate a următorului simbol și influențează caracterul aleatoriu al rezultatului modelului.

Decodare lacomă este o strategie de decodare deterministă care la fiecare pas selectează jetonul cu cea mai mare probabilitate. Deși simplă și eficientă, abordarea riscă să cadă în tipare repetitive, deoarece nu ține cont de spațiul mai larg de probabilitate. Setarea parametrului de temperatură la 0 la momentul deducerii echivalează în esență cu implementarea decodării lacome.

Prelevarea de probe introduce stocasticitatea în procesul de decodificare prin selectarea aleatorie a fiecărui simbol ulterior pe baza distribuției probabilității prezise. Această aleatorie are ca rezultat o variabilitate mai mare a producției. Decodificarea stocastică se dovedește mai abil în captarea diversității potențialelor rezultate și adesea oferă răspunsuri mai imaginative. Valorile mai mari ale temperaturii introduc mai multe fluctuații și cresc creativitatea răspunsului modelului.

Tehnici de stimulare: CoT și auto-consistență

Capacitatea de raționament a modelelor de limbaj poate fi sporită prin inginerie promptă. În special, s-a demonstrat că CoT a provoca raționament în sarcini complexe NLP. O modalitate de a implementa a zero-shot CoT se face printr-o creștere rapidă cu instrucțiunea de a „gândi pas cu pas”. Un altul este de a expune modelul la exemple de pași intermediari de raționament în îndemnul de câteva lovituri Modă. Ambele scenarii folosesc de obicei decodare lacomă. CoT duce la câștiguri semnificative de performanță în comparație cu instrucțiunile simple privind sarcinile aritmetice, de bun simț și de raționament simbolic.

Îndemnul de auto-consecvență se bazează pe presupunerea că introducerea diversității în procesul de raționament poate fi benefică pentru a ajuta modelele să convergă către răspunsul corect. Tehnica folosește decodarea stocastică pentru a atinge acest obiectiv în trei pași:

- Îndemnați modelul de limbaj cu exemple CoT pentru a provoca raționament.

- Înlocuiți decodarea lacomă cu o strategie de eșantionare pentru a genera un set divers de căi de raționament.

- Agregați rezultatele pentru a găsi cel mai consistent răspuns din setul de răspunsuri.

S-a dovedit că auto-consecvența depășește solicitarea CoT pe criteriile de referință populare de aritmetică și raționament de bun simț. O limitare a abordării este costul său de calcul mai mare.

Această postare arată cum îndemnul de auto-consecvență îmbunătățește performanța modelelor de limbaj generativ în două sarcini de raționament NLP: rezolvarea problemelor aritmetice și răspunsul la întrebări specifice domeniului cu alegeri multiple. Demonstrăm abordarea folosind inferența în lot pe Amazon Bedrock:

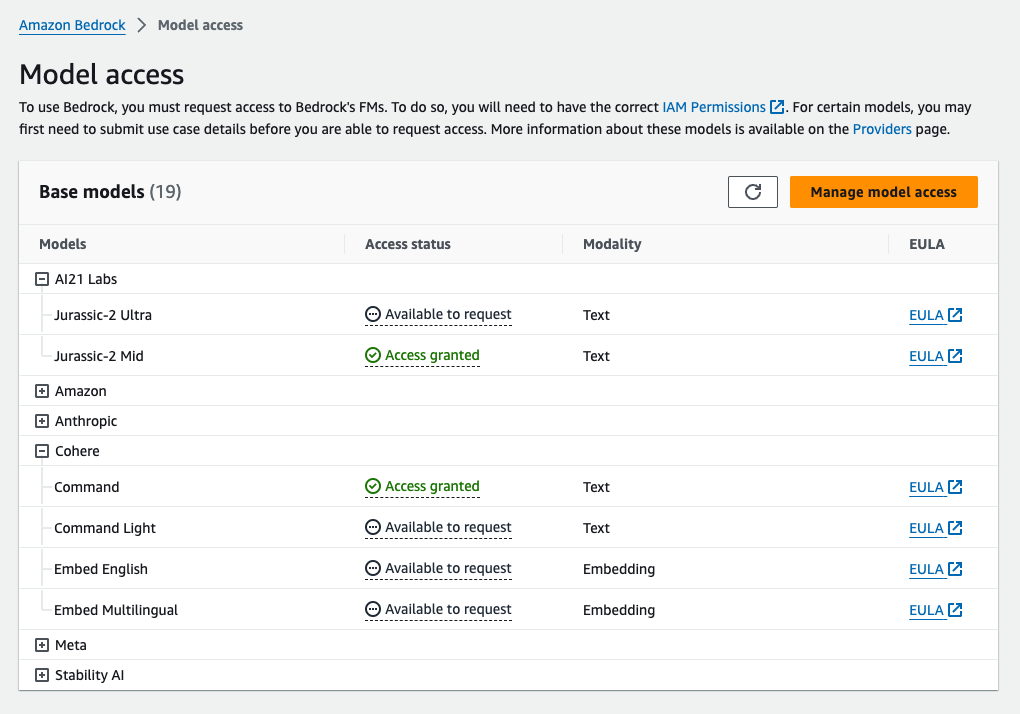

- Accesăm Amazon Bedrock Python SDK în JupyterLab pe un Amazon SageMaker instanță de notebook.

- Pentru raționamentul aritmetic, solicităm Cohere Command pe setul de date GSM8K al problemelor de matematică din școala generală.

- Pentru raționament cu variante multiple, solicităm AI21 Labs Jurassic-2 Mid pe un mic eșantion de întrebări de la examenul AWS Certified Solutions Architect – Associate.

Cerințe preliminare

Această explicație presupune următoarele cerințe preliminare:

Costul estimat pentru a rula codul afișat în această postare este de 100 USD, presupunând că rulați o solicitare de auto-consecvență cu 30 de căi de raționament folosind o singură valoare pentru eșantionarea bazată pe temperatură.

Set de date pentru a examina capabilitățile de raționament aritmetic

GSM8K este un set de date de probleme de matematică a școlii generale asamblate de oameni, care prezintă o mare diversitate lingvistică. Fiecare problemă necesită 2-8 pași pentru a fi rezolvată și necesită efectuarea unei secvențe de calcule elementare cu operații aritmetice de bază. Aceste date sunt utilizate în mod obișnuit pentru a evalua capabilitățile de raționament aritmetic în mai mulți pași ale modelelor de limbaj generativ. The Set tren GSM8K cuprinde 7,473 de înregistrări. Următorul este un exemplu:

{"question": "Natalia sold clips to 48 of her friends in April, and then she sold half as many clips in May. How many clips did Natalia sell altogether in April and May?", "answer": "Natalia sold 48/2 = <<48/2=24>>24 clips in May.nNatalia sold 48+24 = <<48+24=72>>72 clips altogether in April and May.n#### 72"}

Configurați pentru a rula inferențe în loturi cu Amazon Bedrock

Inferența în lot vă permite să rulați mai multe apeluri de inferență către Amazon Bedrock în mod asincron și să îmbunătățiți performanța inferenței modelului pe seturi de date mari. Serviciul este în previzualizare la momentul scrierii acestui articol și este disponibil numai prin API. A se referi la Executați inferența în lot pentru a accesa API-urile de inferență în loturi prin SDK-uri personalizate.

După ce ați descărcat și dezarhivat fișierul Python SDK într-o instanță de blocnotes SageMaker, o puteți instala rulând următorul cod într-o celulă de blocnotes Jupyter:

Formatați și încărcați datele de intrare în Amazon S3

Datele de intrare pentru inferența lotului trebuie pregătite în format JSONL cu recordId și modelInput chei. Acesta din urmă ar trebui să se potrivească cu câmpul corpului modelului care urmează să fie invocat pe Amazon Bedrock. În special, unii parametrii de inferență acceptați pentru Cohere Command sunt temperature pentru aleatoriu, max_tokens pentru lungimea de ieșire și num_generations pentru a genera răspunsuri multiple, toate acestea fiind transmise împreună cu prompt as modelInput:

Vedea Parametri de inferență pentru modelele de fundație pentru mai multe detalii, inclusiv alți furnizori de modele.

Experimentele noastre privind raționamentul aritmetic sunt efectuate în setarea cu câteva lovituri, fără a personaliza sau ajusta Cohere Command. Folosim același set de opt exemplare cu câteva fotografii din lanțul de gândire (Tabelul 20) și autoconsecvența (Tabelul 17) hârtii. Solicitările sunt create prin concatenarea exemplarelor cu fiecare întrebare din setul de tren GSM8K.

Noi am stabilit max_tokens la 512 și num_generations la 5, maximul permis de Cohere Command. Pentru decodare lacomă, am stabilit temperature la 0 și pentru auto-coerență, derulăm trei experimente la temperaturi de 0.5, 0.7 și 1. Fiecare setare produce date de intrare diferite în funcție de valorile respective de temperatură. Datele sunt formatate ca JSONL și stocate în Amazon S3.

Creați și rulați joburi de inferență în lot în Amazon Bedrock

Crearea sarcinilor de inferență în loturi necesită un client Amazon Bedrock. Specificăm căile de intrare și ieșire S3 și dăm fiecărui job de invocare un nume unic:

Locuri de munca sunt a creat prin transmiterea rolului IAM, ID-ului modelului, numele jobului și configurația de intrare/ieșire ca parametri către API-ul Amazon Bedrock:

listarea, Monitorizarea, și oprire joburile de inferență în loturi sunt acceptate de apelurile API respective ale acestora. La creare, locurile de muncă apar mai întâi ca Submitted, apoi ca InProgress, și în cele din urmă ca Stopped, Failed, Sau Completed.

Dacă lucrările sunt finalizate cu succes, conținutul generat poate fi preluat de pe Amazon S3 folosind locația sa unică de ieșire.

[Out]: 'Natalia sold 48 * 1/2 = 24 clips less in May. This means she sold 48 + 24 = 72 clips in April and May. The answer is 72.'

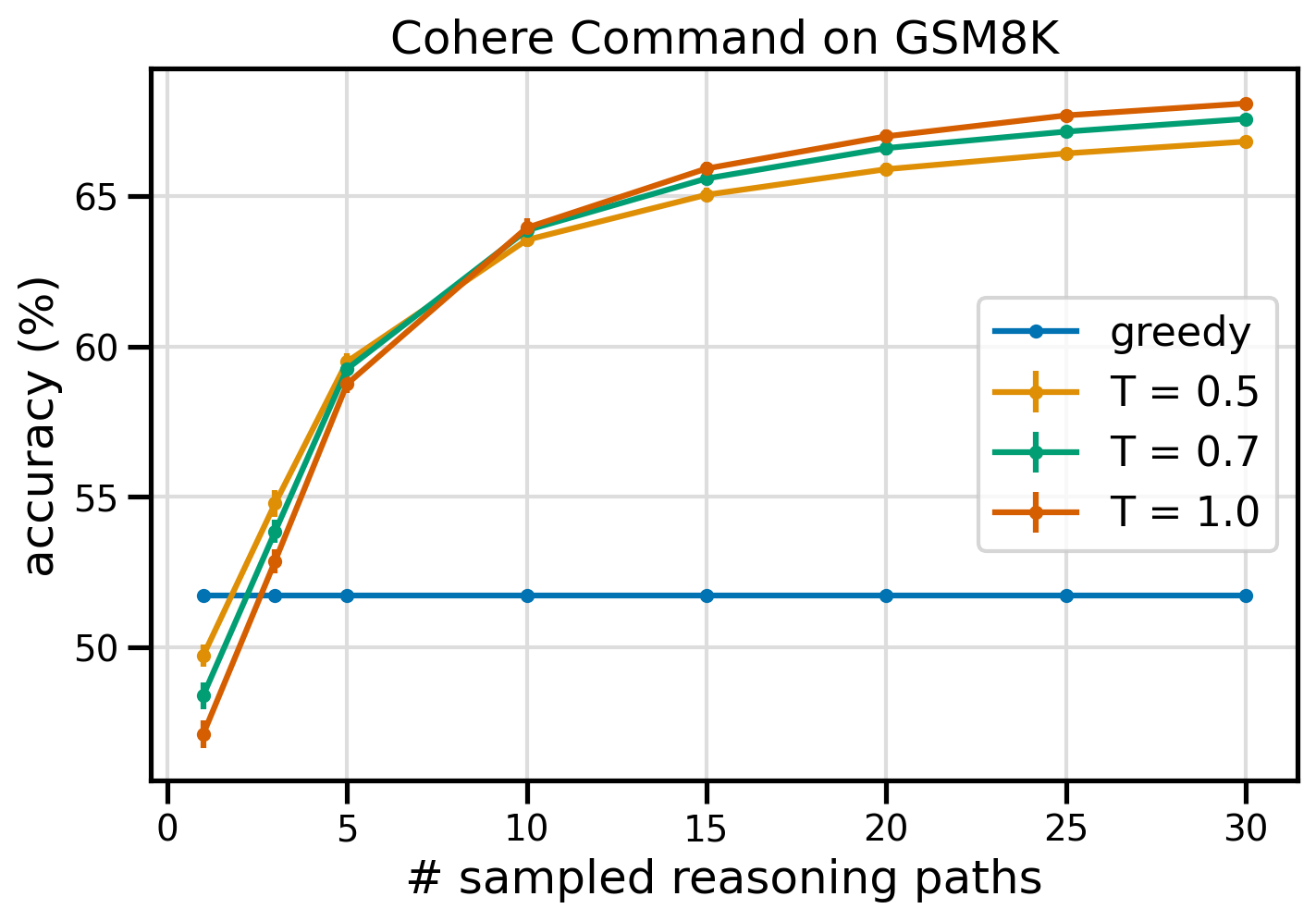

Auto-consecvența îmbunătățește acuratețea modelului în sarcinile aritmetice

Indemnul de auto-consecvență a Cohere Command depășește o linie de bază CoT lacomă în ceea ce privește acuratețea setului de date GSM8K. Pentru auto-consecvență, eșantionăm 30 de căi de raționament independente la trei temperaturi diferite, cu topP și topK setat la lor valori implicite. Soluțiile finale sunt agregate prin alegerea celei mai consistente apariții prin votul majoritar. În caz de egalitate, alegem aleatoriu unul dintre răspunsurile majoritare. Calculăm precizia și valorile abaterii standard în medie peste 100 de rulări.

Următoarea figură arată acuratețea setului de date GSM8K de la Cohere Command solicitat cu CoT lacom (albastru) și auto-consecvență la valorile temperaturii 0.5 (galben), 0.7 (verde) și 1.0 (portocaliu) în funcție de numărul de eșantionate. căi de raționament.

Figura precedentă arată că auto-coerența îmbunătățește acuratețea aritmetică față de CoT lacom atunci când numărul de căi eșantionate este de până la trei. Performanța crește în mod consecvent cu alte căi de raționament, confirmând importanța introducerii diversității în generarea gândirii. Cohere Command rezolvă setul de întrebări GSM8K cu o precizie de 51.7% atunci când este solicitat cu CoT vs. 68% cu 30 de căi de raționament auto-consecvente la T=1.0. Toate cele trei valori de temperatură analizate dau rezultate similare, temperaturile mai scăzute fiind comparativ mai performante pe căi mai puțin eșantionate.

Considerații practice privind eficiența și costul

Auto-consecvența este limitată de timpul de răspuns crescut și de costurile suportate atunci când se generează mai multe ieșiri per prompt. Ca o ilustrare practică, inferența în loturi pentru generarea lacomă cu Cohere Command pe 7,473 de înregistrări GSM8K s-a terminat în mai puțin de 20 de minute. Lucrarea a luat 5.5 milioane de jetoane ca intrare și a generat 630,000 de jetoane de ieșire. La curent Prețurile de inferență Amazon Bedrock, costul total suportat a fost de aproximativ 9.50 USD.

Pentru auto-consecvență cu Cohere Command, folosim parametrul de inferență num_generations pentru a crea mai multe completări pentru fiecare prompt. În momentul scrierii acestui articol, Amazon Bedrock permite maximum cinci generații și trei concurente Submitted locuri de muncă de inferență în loturi. Locurile de muncă continuă la InProgress starea secvenţială, prin urmare eşantionarea a mai mult de cinci căi necesită invocări multiple.

Următoarea figură arată timpii de execuție pentru Cohere Command pe setul de date GSM8K. Timpul total de rulare este afișat pe axa x și timpul de rulare pe calea de raționament eșantionată pe axa y. Generarea greedy rulează în cel mai scurt timp, dar implică un cost de timp mai mare pe cale eșantionată.

Generarea greedy se finalizează în mai puțin de 20 de minute pentru setul complet GSM8K și eșantionează o cale de raționament unică. Auto-consecvența cu cinci mostre necesită aproximativ 50% mai mult pentru finalizare și costă aproximativ 14.50 USD, dar produce cinci căi (peste 500%) în acel timp. Durata totală de rulare și costurile cresc treptat cu fiecare cinci căi eșantionate suplimentare. O analiză cost-beneficiu sugerează că 1-2 joburi de inferență în loturi cu 5-10 căi eșantionate este setarea recomandată pentru implementarea practică a auto-coerenței. Acest lucru realizează o performanță îmbunătățită a modelului, ținând în același timp costurile și latența la distanță.

Auto-consecvența îmbunătățește performanța modelului dincolo de raționamentul aritmetic

O întrebare crucială pentru a dovedi adecvarea solicitării de auto-consecvență este dacă metoda reușește în alte sarcini NLP și modele de limbaj. Ca o extensie a unui caz de utilizare legat de Amazon, efectuăm o analiză de dimensiuni mici pe exemple de întrebări din AWS Solutions Architect Associate Certification. Acesta este un examen cu variante multiple despre tehnologia și serviciile AWS, care necesită cunoștințe de domeniu și capacitatea de a raționa și de a decide între mai multe opțiuni.

Pregătim un set de date din SAA-C01 și SAA-C03 exemple de întrebări de examen. Din cele 20 de întrebări disponibile, le folosim pe primele 4 ca exemplare cu câteva fotografii și solicităm modelului să răspundă la celelalte 16. De data aceasta, rulăm inferența cu modelul AI21 Labs Jurassic-2 Mid și generăm maximum 10 căi de raționament la temperatura 0.7. Rezultatele arată că auto-consecvența îmbunătățește performanța: deși CoT lacom produce 11 răspunsuri corecte, auto-consecvența reușește cu încă 2.

Următorul tabel arată rezultatele de precizie pentru 5 și 10 căi eșantionate, în medie pe 100 de rulări.

| . | Decodare lacomă | T = 0.7 |

| # căi eșantionate: 5 | 68.6 | 74.1 0.7 ± |

| # căi eșantionate: 10 | 68.6 | 78.9 ± 0.3 |

În tabelul următor, prezentăm două întrebări de examen la care CoT lacom răspunde incorect în timp ce autoconsistența reușește, evidențiind în fiecare caz urmele de raționament corecte (verzi) sau incorecte (roșii) care au determinat modelul să producă răspunsuri corecte sau incorecte. Deși nu toate căile eșantionate generate de auto-consistență sunt corecte, majoritatea converge către răspunsul adevărat pe măsură ce numărul de căi eșantionate crește. Observăm că 5-10 căi sunt de obicei suficiente pentru a îmbunătăți rezultatele lacome, cu randamente descrescătoare în ceea ce privește eficiența peste aceste valori.

| Întrebare |

O aplicație web permite clienților să încarce comenzi într-un bucket S3. Evenimentele Amazon S3 rezultate declanșează o funcție Lambda care inserează un mesaj într-o coadă SQS. O singură instanță EC2 citește mesajele din coadă, le procesează și le stochează într-un tabel DynamoDB partiționat de un ID de comandă unic. Luna viitoare, traficul este de așteptat să crească cu un factor de 10, iar un arhitect de soluții revizuiește arhitectura pentru posibile probleme de scalare. Care componentă este cel mai probabil să aibă nevoie de re-arhitectură pentru a putea scala pentru a se adapta noului trafic? A. Funcția Lambda |

O aplicație care rulează pe AWS utilizează o implementare Amazon Aurora Multi-AZ DB pentru baza de date. Când a evaluat valorile de performanță, un arhitect de soluții a descoperit că citirile bazei de date cauzează I/O mari și adaugă latență la cererile de scriere în baza de date. Ce ar trebui să facă arhitectul de soluții pentru a separa cererile de citire de cererile de scriere? A. Activați memorarea în cache read-through în baza de date Aurora. |

| Răspuns corect | C – O singură instanță EC2 nu se va scala și este un singur punct de eșec în arhitectură. O soluție mult mai bună ar fi ca instanțe EC2 dintr-un grup Auto Scaling din 2 zone de disponibilitate să citească mesajele din coadă. Celelalte răspunsuri sunt toate servicii gestionate care pot fi configurate la scalare sau se vor scala automat. | C – Replicile Aurora oferă o modalitate de a descărca traficul de citire. Replicale Aurora partajează aceeași stocare de bază ca baza de date principală, astfel încât timpul de întârziere este în general foarte mic. Replicale Aurora au propriile puncte finale, așa că aplicația va trebui configurată pentru a direcționa traficul de citire către noile puncte finale. |

| Decodare lacomă | Scalarea directă a instanței EC2 poate să nu fie posibilă, deoarece este posibil să nu fie posibilă redimensionarea instanței. Scalarea funcției Lambda poate să nu fie suficientă, deoarece funcțiile Lambda au o limită de alocare de memorie de 6 GB. Scalarea cozii SQS poate să nu fie suficientă, deoarece SQS are o limită de 10,000 de mesaje. Tabelele DynamoDB pot fi scalate prin furnizarea de mai multe unități de capacitate. Raspunsul corect este D. | Modificarea aplicației pentru a citi din instanța de așteptare Multi-AZ (opțiunea B) este cea mai bună abordare. Instanța de așteptare este replicată asincron de la instanța principală, astfel încât operațiunile de citire nu vor interfera cu operațiunile de scriere. Activarea memorării în cache read-through (opțiunea A) sau crearea unei replici Aurora (opțiunea C) nu va rezolva problema conflictului I/O. Crearea unei a doua baze de date Aurora și conectarea acesteia ca o replică citită (opțiunea D) nu va rezolva nici problema conflictului I/O. Raspunsul corect este B. |

| Calea eșantionată #1 | Scalarea instanței EC2 la de 10 ori dimensiunea sa actuală poate să nu fie fezabilă, fie din punct de vedere al costurilor, fie din punct de vedere al performanței. Ar necesita o instanță mai mare, care poate fi costisitoare. O abordare mai rentabilă ar putea fi folosirea unui roi de instanțe mai mici (de exemplu, Auto Scaling Group) pentru a împărți sarcina. În acest caz, instanța EC2 ar trebui probabil să fie rearhitectată. Raspunsul corect este C. | Modificarea aplicației pentru a utiliza punctele finale adecvate nu este o soluție practică, deoarece ar necesita modificări ale codului aplicației. Răspunsul corect este C: Creați o replică Aurora și modificați aplicația pentru a utiliza punctele finale adecvate. |

| Calea eșantionată #2 | Scalarea unei singure instanțe EC2 este mai dificilă și mai problematică decât scalarea celorlalte componente ale serviciului. Amazon SQS, Lambda și DynamoDB se pot scala automat pentru a face față sarcinii crescute. Raspunsul corect este C. |

(C) Creați o replică Aurora și modificați aplicația pentru a utiliza punctele finale adecvate. Prin configurarea unei replici Aurora, puteți separa traficul de citire de cel de scriere. Replicile Aurora folosesc adrese URL de puncte finale diferite, permițându-vă să direcționați traficul de citire către replică în loc de baza de date primară. Replica poate procesa solicitările de citire în paralel cu cererile de scriere către baza de date primară, reducând I/O și latența. |

A curăța

Executarea inferenței pe lot în Amazon Bedrock este supusă unor taxe conform prețurilor Amazon Bedrock. Când finalizați procedura, ștergeți instanța de blocnotes SageMaker și eliminați toate datele din compartimentele S3 pentru a evita costurile viitoare.

Considerații

Deși soluția demonstrată arată o performanță îmbunătățită a modelelor lingvistice atunci când este solicitată cu auto-consecvență, este important de reținut că procedura nu este pregătită pentru producție. Înainte de a vă implementa în producție, ar trebui să adaptați această dovadă a conceptului la propria implementare, ținând cont de următoarele cerințe:

- Restricție de acces la API-uri și baze de date pentru a preveni utilizarea neautorizată.

- Respectarea celor mai bune practici de securitate AWS privind accesul la rol IAM și grupurile de securitate.

- Validarea și igienizarea intrărilor utilizatorului pentru a preveni atacurile prompte de injecție.

- Monitorizarea și înregistrarea proceselor declanșate pentru a permite testarea și auditarea.

Concluzie

Această postare arată că îndemnul de auto-consecvență îmbunătățește performanța modelelor de limbaj generativ în sarcini complexe NLP care necesită abilități aritmetice și logice cu alegeri multiple. Auto-consecvența folosește decodarea stocastică bazată pe temperatură pentru a genera diverse căi de raționament. Acest lucru crește capacitatea modelului de a genera gânduri diverse și utile pentru a ajunge la răspunsuri corecte.

Cu inferența pe lot Amazon Bedrock, modelul de limbaj Cohere Command este solicitat să genereze răspunsuri auto-consistente la un set de probleme aritmetice. Precizia se îmbunătățește de la 51.7% cu decodare lacomă la 68% cu eșantionare auto-consecvență a 30 de căi de raționament la T=1.0. Eșantionarea a cinci căi îmbunătățește deja acuratețea cu 7.5 puncte procentuale. Abordarea este transferabilă către alte modele lingvistice și sarcini de raționament, așa cum demonstrează rezultatele modelului AI21 Labs Jurassic-2 Mid la un examen de certificare AWS. Într-un set de întrebări de dimensiuni mici, auto-consecvența cu cinci căi eșantionate crește precizia cu 5 puncte procentuale față de CoT lacom.

Vă încurajăm să implementați solicitări de auto-consecvență pentru performanță îmbunătățită în propriile aplicații cu modele de limbaj generativ. Află mai multe despre Cohere Command și AI21 Labs Jurassic modele disponibile pe Amazon Bedrock. Pentru mai multe informații despre inferența în lot, consultați Executați inferența în lot.

Mulţumiri

Autorul mulțumește recenzenților tehnici Amin Tajgardoon și Patrick McSweeney pentru feedback util.

Despre autor

Lucía Santamaría este om de știință senior aplicat la Universitatea ML din Amazon, unde se concentrează pe creșterea nivelului de competență ML în cadrul companiei prin educație practică. Lucía are un doctorat în astrofizică și este pasionată de democratizarea accesului la cunoștințele și instrumentele tehnologice.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- Sursa: https://aws.amazon.com/blogs/machine-learning/enhance-performance-of-generative-language-models-with-self-consistency-prompting-on-amazon-bedrock/

- :are

- :este

- :nu

- :Unde

- $UP

- 000

- 1

- 10

- 100

- 11

- 12

- 13

- 14

- 15%

- 150

- 16

- 19

- 20

- 24

- 25

- 30

- 33

- 50

- 51

- 7

- 72

- 8

- a

- capacitate

- Capabil

- Despre Noi

- acces

- găzdui

- Conform

- precizie

- Obține

- Realizeaza

- peste

- curent

- adapta

- adăugare

- În plus,

- adept

- împotriva

- agregate

- agregate

- AI

- TOATE

- alocare

- permis

- Permiterea

- permite

- de-a lungul

- deja

- Cu toate ca

- întru totul

- Amazon

- Amazon Web Services

- printre

- an

- analiză

- Analitic

- și

- O alta

- răspunde

- telefonic

- răspunsuri

- api

- API-uri

- apărea

- aplicație

- aplicatii

- aplicat

- abordare

- abordari

- adecvat

- Aprilie

- arhitectură

- SUNT

- în jurul

- AS

- Avocat Colaborator

- presupune

- presupunere

- At

- Atacuri

- audit

- augmented

- Auroră

- autor

- Auto

- în mod automat

- disponibilitate

- disponibil

- evita

- AWS

- Axă

- bazat

- De bază

- de bază

- bază

- Golf

- BE

- deoarece

- fost

- înainte

- fiind

- Benchmark

- valori de referință

- benefică

- CEL MAI BUN

- Cele mai bune practici

- Mai bine

- între

- Dincolo de

- Albastru

- corp

- a stimula

- atât

- larg

- mai larg

- construi

- dar

- by

- cache

- calcule

- apeluri

- CAN

- capacități

- Capacitate

- capturarea

- caz

- provocând

- celulă

- Certificare

- Certificate

- Modificări

- taxe

- alegere

- Alege

- alegere

- client

- clipuri

- Grup

- cod

- în mod obișnuit

- Companii

- companie

- comparativ

- comparație

- Completă

- finalizeaza

- complex

- component

- componente

- cuprinde

- de calcul

- Calcula

- concept

- concurent

- Configuraţie

- configurat

- configurarea

- Considerații

- consistent

- consecvent

- conţinut

- context

- contrast

- converg

- corecta

- A costat

- cost-eficiente

- Cheltuieli

- crea

- a creat

- creează

- Crearea

- creaţie

- creativitate

- crucial

- Curent

- personalizat

- clienţii care

- de date

- Baza de date

- baze de date

- seturi de date

- decide

- Decodare

- democratizarea

- demonstra

- demonstrat

- implementa

- desfășurarea

- detalii

- deviere

- FĂCUT

- diferenţele

- diferit

- dificil

- diminuarea

- direcționa

- direct

- a descoperit

- distribuire

- distribuții

- diferit

- Diversitate

- do

- domeniu

- descărcat

- două

- în timpul

- e

- fiecare

- Educaţie

- eficiență

- eficient

- eficient

- opt

- oricare

- permite

- permițând

- încuraja

- Punct final

- Inginerie

- spori

- sporită

- Îmbunătăţeşte

- suficient de

- echivaleaza

- În esență,

- estimativ

- evaluarea

- evenimente

- Fiecare

- examen

- exemplu

- de aşteptat

- scump

- experimente

- extensie

- suplimentar

- factor

- Eșec

- Cădere

- Modă

- realizabil

- Dispunând

- feedback-ul

- camp

- Figura

- Fișier

- final

- În cele din urmă

- Găsi

- First

- cinci

- fluctuațiile

- concentrat

- următor

- Pentru

- format

- Fundație

- Prietenii lui

- din

- Complet

- complet

- funcţie

- funcții

- mai mult

- În plus

- viitor

- câștig

- în general

- genera

- generată

- generează

- generator

- generaţie

- generații

- generativ

- obține

- GitHub

- Da

- dat

- scop

- calitate

- mai mare

- Lacom

- Verde

- grup

- Grupului

- Jumătate

- hands-on

- Avea

- cap

- ajutor

- util

- ei

- Înalt

- performanta inalta

- superior

- cea mai mare

- subliniind

- Cum

- Cum Pentru a

- HTML

- HTTPS

- ID

- punerea în aplicare a

- implementarea

- Punere în aplicare a

- importanță

- important

- îmbunătăţi

- îmbunătățit

- îmbunătăţeşte

- in

- Inclusiv

- incorect

- în mod incorect

- Crește

- a crescut

- Creșteri

- suportate

- independent

- indicând

- informații

- intrare

- inserții

- instala

- instanță

- in schimb

- interfera

- în

- introduce

- Prezintă

- introducerea

- invocat

- implica

- implică

- problema

- IT

- ESTE

- în sine

- Loc de munca

- Locuri de munca

- JSON

- păstrare

- Cheie

- chei

- cunoştinţe

- cunoscut

- Labs

- limbă

- mare

- mai mare

- Latență

- conduce

- conducere

- Conduce

- AFLAȚI

- Led

- Lungime

- mai puțin

- Nivel

- ca

- probabilitate

- Probabil

- LIMITĂ

- limitare

- Limitat

- linii

- LINK

- legarea

- încărca

- locaţie

- logare

- logic

- mai lung

- Jos

- LOWER

- Principal

- Majoritate

- administra

- gestionate

- multe

- Meci

- matematica

- maxim

- Mai..

- mijloace

- Memorie

- mesaj

- mesaje

- metodă

- Metrici

- La mijlocul

- ar putea

- milion

- minte

- minute

- ML

- model

- Modele

- modifica

- Lună

- mai mult

- cele mai multe

- mult

- multiplu

- nume

- Natural

- Procesarea limbajului natural

- Nevoie

- nevoilor

- Nou

- următor

- nlp

- în special

- nota

- caiet

- număr

- observa

- apariţie

- of

- promoții

- de multe ori

- on

- ONE

- afară

- Operațiuni

- Opțiune

- Opţiuni

- or

- Portocaliu

- comandă

- comenzilor

- Altele

- afară

- outperform

- surclasează

- producție

- iesiri

- peste

- propriu

- ofertele

- lucrări

- Paralel

- parametru

- parametrii

- special

- partiționat

- Trecut

- Care trece

- pasionat

- trecut

- cale

- căi

- patrick

- modele

- pentru

- la sută

- Efectua

- performanță

- efectuată

- efectuarea

- perspectivă

- PhD

- Plato

- Informații despre date Platon

- PlatoData

- Punct

- puncte

- Popular

- posibil

- Post

- potenţial

- Practic

- practicile

- precedent

- a prezis

- Pregăti

- pregătit

- premise

- prezenta

- împiedica

- Anunţ

- de stabilire a prețurilor

- primar

- intimitate

- sondă

- Problemă

- de rezolvare a problemelor

- problematic

- probleme

- procedură

- continua

- proces

- procese

- prelucrare

- produce

- produce

- producere

- solicitări

- dovadă

- dovada de concept

- Dovedi

- dovedit

- dovedește

- furniza

- furnizori

- Piton

- întrebare

- Întrebări

- ridicare

- dezordine

- gamă

- mai degraba

- Citeste

- motiv

- recomandat

- înregistrări

- Roșu

- reducerea

- trimite

- cu privire la

- se bazează

- rămas

- scoate

- repetitiv

- răspunde

- replicat

- cereri de

- necesita

- Cerinţe

- Necesită

- respectiv

- răspuns

- răspunsuri

- responsabil

- restricţie

- rezultând

- REZULTATE

- Returnează

- revizuirea

- Riscurile

- Rol

- RÂND

- Alerga

- funcţionare

- ruleaza

- Runtime

- sagemaker

- acelaşi

- probă

- Scară

- scalate

- scalare

- scenarii

- Şcoală

- Om de stiinta

- sdk

- sdks

- Al doilea

- securitate

- selectarea

- vinde

- distinct

- Secvenţă

- serviciu

- Servicii

- sesiune

- set

- instalare

- câteva

- Distribuie

- ea

- cel mai scurt

- să

- Arăta

- indicat

- Emisiuni

- semnificativ

- asemănător

- simplu

- singur

- Mărimea

- aptitudini

- mic

- mai mici

- So

- vândut

- soluţie

- soluţii

- REZOLVAREA

- rezolvă

- Rezolvarea

- unele

- Spaţiu

- standard

- Stare

- Pas

- paşi

- depozitare

- stoca

- stocate

- magazine

- simplu

- strategii

- Strategie

- subiect

- ulterior

- Reușit

- sugerează

- potrivire

- Suportat

- au realizat studii

- roi

- simbolic

- tabel

- ia

- sarcini

- tech

- Tehnic

- tehnică

- tehnici de

- Tehnologia

- termeni

- Testarea

- a) Sport and Nutrition Awareness Day in Manasia Around XNUMX people from the rural commune Manasia have participated in a sports and healthy nutrition oriented activity in one of the community’s sports ready yards. This activity was meant to gather, mainly, middle-aged people from a Romanian rural community and teach them about the benefits that sports have on both their mental and physical health and on how sporting activities can be used to bring people from a community closer together. Three trainers were made available for this event, so that the participants would get the best possible experience physically and so that they could have the best access possible to correct information and good sports/nutrition practices. b) Sports Awareness Day in Poiana Țapului A group of young participants have taken part in sporting activities meant to teach them about sporting conduct, fairplay, and safe physical activities. The day culminated with a football match.

- decât

- mulțumesc

- acea

- lor

- Lor

- apoi

- prin urmare

- Acestea

- acest

- aceste

- gândit

- trei

- Prin

- TIE

- timp

- ori

- la

- împreună

- semn

- indicativele

- a luat

- Unelte

- Total

- trafic

- Tren

- transferabil

- declanşa

- a declanșat

- adevărat

- Două

- tipic

- neautorizat

- care stau la baza

- unic

- de unităţi

- universitate

- Actualizează

- Folosire

- utilizare

- carcasa de utilizare

- utilizat

- util

- Utilizator

- utilizări

- folosind

- valoare

- Valori

- diverse

- foarte

- de

- Vot

- vs

- walkthrough

- a fost

- Cale..

- we

- web

- aplicatie web

- servicii web

- cand

- dacă

- care

- în timp ce

- WHL

- voi

- cu

- fără

- Cuvânt

- ar

- scrie

- scris

- X

- Randament

- randamentele

- Tu

- Ta

- zephyrnet

- Zip

- zone