Într-o lume din ce în ce mai centrată pe date, întreprinderile trebuie să se concentreze atât pe adunarea de informații fizice valoroase, cât și pe generarea informațiilor de care au nevoie, dar care nu le pot captura cu ușurință. Accesul la date, reglementarea și conformitatea sunt o sursă tot mai mare de fricțiuni pentru inovarea în analiză și inteligență artificială (AI).

Pentru sectoarele foarte reglementate, cum ar fi serviciile financiare, asistența medicală, științele vieții, automobile, robotică și producție, problema este și mai mare. Cauzează bariere în calea proiectării sistemului, a partajării datelor (interne și externe), a monetizării, a analizei și a învățării automate (ML).

Datele sintetice sunt un instrument care abordează multe provocări legate de date, în special AI și probleme de analiză, cum ar fi protecția vieții private, conformitatea cu reglementările, accesibilitatea, deficitul de date și părtinirea. Aceasta include, de asemenea, partajarea datelor și timpul până la date (și, prin urmare, timpul până la piață).

Datele sintetice sunt generate algoritmic. Oglindește proprietățile și modelele statistice din datele sursă. Dar, important, nu conține puncte de date sensibile, private sau personale.

Puneți întrebări despre datele sintetice și obțineți aceleași răspunsuri pe care le-ați obține din datele reale.

În nostru post anterior, am demonstrat cum să folosim rețele adverse precum Generative Adversarial Networks (GANS) pentru a genera seturi de date tabulare pentru a îmbunătăți formarea modelului de fraudă de credit.

Pentru ca părțile interesate de afaceri să adopte date sintetice pentru proiectele lor de ML și de analiză, este imperativ să se asigure nu numai că datele sintetice generate se vor potrivi cu scopul și aplicațiile așteptate din aval, ci și pentru ca aceștia să fie capabili să măsoare și să demonstreze calitatea datele generate.

Odată cu creșterea obligațiilor legale și etice în păstrarea confidențialității, unul dintre punctele forte ale datelor sintetice este capacitatea de a elimina informațiile sensibile și originale în timpul sintezei lor. Prin urmare, pe lângă calitate, avem nevoie de metrici care să evalueze riscul de scurgeri de informații private, dacă există, și să evaluăm că procesul de generare nu „memorează” sau copiază niciuna dintre datele originale.

Pentru a realiza toate acestea, putem mapa calitatea datelor sintetice în dimensiuni, care ajută utilizatorii, părțile interesate și pe noi să înțelegem mai bine datele generate.

Cele trei dimensiuni ale evaluării sintetice a calității datelor

Datele sintetice generate sunt măsurate în raport cu trei dimensiuni cheie:

- Fidelitate

- Utilitate

- Privacy

Acestea sunt câteva dintre întrebările despre orice date sintetice generate la care ar trebui să se răspundă printr-un raport de calitate a datelor sintetice:

- Cât de similare sunt aceste date sintetice în comparație cu setul de antrenament original?

- Cât de utile sunt aceste date sintetice pentru aplicațiile noastre din aval?

- S-au scurs informații din datele de antrenament originale în datele sintetice?

- Au fost sintetizate din neatenție de către modelul nostru orice date considerate sensibile în lumea reală (din alte seturi de date care nu sunt utilizate pentru antrenamentul modelului?

Valorile care traduc fiecare dintre aceste dimensiuni pentru utilizatorii finali sunt oarecum flexibile. La urma urmei, datele care trebuie generate pot varia în ceea ce privește distribuțiile, dimensiunea și comportamentul. De asemenea, ar trebui să fie ușor de înțeles și interpretat.

În cele din urmă, valorile trebuie să fie complet bazate pe date și să nu necesite cunoștințe anterioare sau informații specifice domeniului. Cu toate acestea, dacă utilizatorul dorește să aplice reguli și constrângeri specifice aplicabile unui anumit domeniu de afaceri, atunci ar trebui să le poată defini în timpul procesului de sinteză pentru a se asigura că este îndeplinită fidelitatea specifică domeniului.

Ne uităm la fiecare dintre aceste valori mai detaliat în secțiunile următoare.

Metrici pentru a înțelege fidelitatea

În orice proiect de știință a datelor, trebuie să înțelegem dacă o anumită populație eșantion este relevantă pentru problema pe care o rezolvăm. În mod similar, pentru procesul de evaluare a relevanței datelor sintetice generate, trebuie să o evaluăm din punct de vedere al fidelitate comparativ cu originalul.

Reprezentările vizuale ale acestor valori le fac mai ușor de înțeles. Am putea ilustra dacă s-au respectat cardinalitatea și raportul categoriilor, s-au păstrat corelațiile dintre diferitele variabile etc.

Vizualizarea datelor nu numai că ajută la evaluarea calității datelor sintetice, ci se încadrează și ca unul dintre pașii inițiali din ciclul de viață al științei datelor pentru o mai bună înțelegere a datelor.

Să ne aprofundăm câteva valori de fidelitate mai detaliat.

Comparații statistice exploratorii

În cadrul comparațiilor statistice exploratorii, caracteristicile seturilor de date originale și sintetice sunt explorate folosind măsuri statistice cheie, cum ar fi media, mediana, abaterea standard, valori distincte, valori lipsă, minime, maxime, intervale de quartile pentru caracteristicile continue și numărul de înregistrări pe categorie, valori lipsă pe categorie și cele mai multe caractere care apar pentru atributele categoriale.

Această comparație ar trebui efectuată între setul de date original și datele sintetice. Această evaluare ar dezvălui dacă seturile de date comparate sunt similare din punct de vedere statistic. Dacă nu sunt, atunci vom înțelege ce caracteristici și măsuri sunt diferite. Ar trebui să luați în considerare reantrenarea și regenerarea datelor sintetice cu diferiți parametri dacă se observă o diferență semnificativă.

Acest test acționează ca o examinare inițială pentru a vă asigura că datele sintetice au o fidelitate rezonabilă față de setul de date original și, prin urmare, pot fi supuse unor teste mai riguroase.

Scorul de similaritate histogramă

Scorul de similaritate histogramă măsoară distribuțiile marginale ale fiecărei caracteristici ale setului de date sintetice și originale.

Scorul de similaritate este delimitat între zero și unu, cu un scor de unu indicând faptul că distribuțiile de date sintetice se suprapun perfect cu distribuțiile datelor originale.

Un scor apropiat de unu ar oferi utilizatorilor încrederea că setul de date holdout și setul de date sintetice sunt similare statistic.

Scorul de informații reciproce

Scorul de informare reciprocă măsoară dependența reciprocă a două caracteristici, numerice sau categorice, indicând cât de multă informație poate fi obținută de la o caracteristică prin observarea alteia.

Informațiile reciproce pot măsura relațiile neliniare, oferind o înțelegere mai cuprinzătoare a calității datelor sintetice, deoarece ne permite să înțelegem gradul de conservare a relațiilor variabilei.

Un scor de unu indică faptul că dependența reciprocă dintre caracteristici a fost surprinsă perfect în datele sintetice.

Scorul de corelare

Scorul de corelație măsoară cât de bine au fost capturate corelațiile din setul de date original în datele sintetice.

Corelațiile dintre două sau mai multe coloane sunt extrem de importante pentru aplicațiile ML, care ajută la descoperirea relațiilor dintre caracteristici și variabila țintă și ajută la crearea unui model bine antrenat.

Scorul de corelație este delimitat între zero și unu, cu un scor de unu indicând că corelațiile au fost perfect potrivite.

Spre deosebire de datele tabulare structurate, pe care le întâlnim în mod obișnuit în problemele de date, unele tipuri de date structurate au un comportament special în care observațiile anterioare au probabilitatea de a influența următoarea observație. Acestea sunt cunoscute ca serii temporale sau date secvențiale – de exemplu, un set de date cu măsurători orare ale temperaturii camerei.

Acest comportament înseamnă că există o cerință de a defini anumite valori care pot măsura în mod specific calitatea acestor seturi de date în serie de timp.

Scorul de autocorelare și autocorelație parțială

Deși similară cu corelația, autocorelația arată relația dintre o serie de timp la valoarea sa actuală, așa cum se raportează la valorile sale anterioare. Eliminarea efectelor decalajelor de timp anterioare produce o autocorelare parțială. Prin urmare, scorul de autocorelare măsoară cât de bine au capturat datele sintetice autocorelațiile semnificative, sau corelațiile parțiale, din setul de date original.

Metrici pentru a înțelege utilitatea

Acum s-ar putea să ne fi dat seama statistic că datele sintetice sunt similare cu setul de date original. În plus, trebuie să evaluăm, de asemenea, cât de bine se descurcă setul de date sintetizat în problemele comune ale științei datelor atunci când sunt antrenați pe mai mulți algoritmi ML.

Folosind următoarele utilitate de măsurare, ne propunem să construim încrederea că putem obține efectiv performanță pe aplicațiile din aval în ceea ce privește modul în care au funcționat datele originale.

Scorul de pronostic

Măsurarea performanței datelor sintetice în comparație cu datele reale originale se poate face prin modele ML. Scorul modelului din aval surprinde calitatea datelor sintetice prin compararea performanței modelelor ML antrenate atât pe seturile de date sintetice, cât și pe cele originale și validate pe datele de testare reținute din setul de date original. Aceasta oferă o Scorul Train Synthetic Test Real (TSTR). și Train Real Test Real (TRTR) scor respectiv.

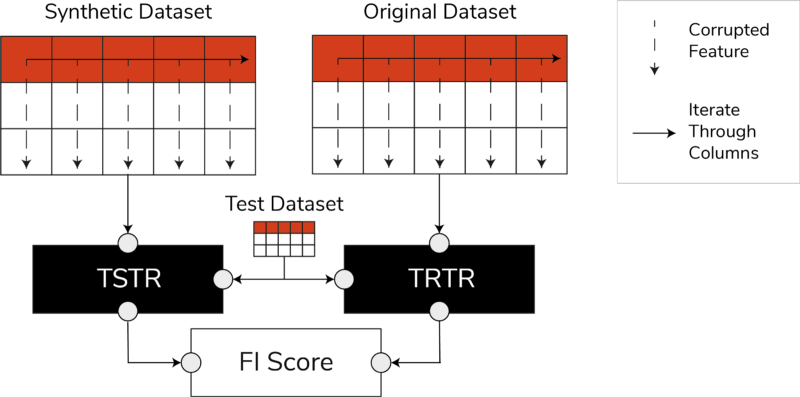

Scorurile TSTR, TRTR și Scorul de importanță a caracteristicilor (Imagine după autor)

Scorul încorporează o gamă largă de algoritmi ML cei mai de încredere pentru sarcini de regresie sau clasificare. Utilizarea mai multor clasificatori și regresori vă asigură că scorul este mai generalizabil în majoritatea algoritmilor, astfel încât datele sintetice pot fi considerate utile în viitor.

În cele din urmă, dacă scorul TSTR și scorul TRTR sunt comparabile, acest lucru indică faptul că datele sintetice au calitatea de a fi utilizate pentru a antrena modele ML eficiente pentru aplicații din lumea reală.

Scorul de importanță a caracteristicilor

Extrem de legat de scorul de predicție, scorul de importanță a caracteristicilor (FI) îl extinde prin adăugarea de interpretabilitate scorurilor TSTR și TRTR.

Scorul F1 compară modificările și stabilitatea ordinii de importanță a caracteristicii obținute cu scorul de predicție. Un set sintetic de date este considerat a fi de mare utilitate dacă are aceeași ordine de importanță a caracteristicilor ca și datele originale originale.

QScore

Pentru a ne asigura că un model antrenat pe datele noastre nou generate va produce aceleași răspunsuri la aceleași întrebări ca un model antrenat folosind datele originale, folosim Qscore. Acest lucru măsoară performanța în aval a datelor sintetice prin rularea multor interogări aleatorii bazate pe agregare atât pe seturile de date sintetice, cât și pe cele originale (și care nu sunt disponibile).

Ideea aici este că ambele interogări ar trebui să returneze rezultate similare.

Un QScore ridicat se asigură că aplicațiile din aval care utilizează operațiuni de interogare și agregare pot oferi o valoare aproape egală cu cea a setului de date original.

Valori pentru a înțelege confidențialitatea

cu intimitate reglementările deja în vigoare, este o obligație etică și o cerință legală pentru a vă asigura că informațiile sensibile sunt protejate.

Înainte ca aceste date sintetice să poată fi partajate în mod liber și utilizate pentru aplicații din aval, trebuie să luăm în considerare valorile de confidențialitate care pot ajuta părțile interesate să înțeleagă unde se află datele sintetice generate în comparație cu datele originale în ceea ce privește amploarea informațiilor scurse. Mai mult, trebuie să luăm decizii critice cu privire la modul în care datele sintetice pot fi partajate și utilizate.

Scorul exact de potrivire

O evaluare directă și intuitivă a confidențialității este de a căuta copii ale datelor reale printre înregistrările sintetice. Scorul exact al meciului numără numărul de înregistrări reale care pot fi găsite în setul sintetic.

Scorul ar trebui să fie zero, afirmând că nicio informație reală nu este prezentă așa cum este în datele sintetice. Această măsurătoare acționează ca un mecanism de screening înainte de a evalua alte valori de confidențialitate.

Scorul de confidențialitate al vecinilor

În plus, scorul de confidențialitate al vecinilor măsoară raportul dintre înregistrările sintetice care ar putea fi prea apropiate ca similaritate cu cele reale. Aceasta înseamnă că, deși nu sunt copii directe, ele sunt puncte potențiale de scurgere a confidențialității și o sursă de informații utile pentru atacurile de inferență.

Scorul este calculat prin efectuarea unei căutări de dimensiuni înalte a vecinilor cei mai apropiați pe datele sintetice suprapuse cu datele originale.

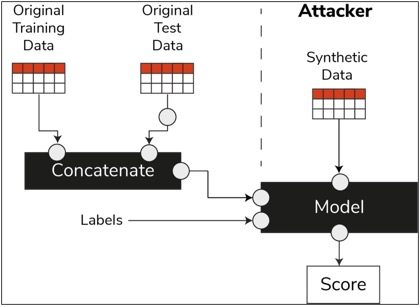

Scorul de inferență de membru

În ciclul de viață al științei datelor, odată ce un model a fost antrenat, acesta nu mai are nevoie de acces la eșantioanele de antrenament și poate face predicții asupra datelor nevăzute. În mod similar, în cazul nostru, odată ce modelul sintetizatorului este antrenat, pot fi generate mostre de date sintetice fără a fi nevoie de datele originale.

Printr-un tip de atac numit „atac de inferență de membru”, atacatorii pot încerca să dezvăluie datele care au fost folosite pentru a crea datele sintetice, fără a avea acces la datele originale. Acest lucru duce la un compromis de confidențialitate.

Scorul de inferență de membru măsoară probabilitatea ca un atac de inferență de membru să aibă succes.

Un scor scăzut sugerează fezabilitatea deducerii că o anumită înregistrare a fost membru al setului de date de antrenament care a condus la crearea datelor sintetice. Cu alte cuvinte, atacurile pot deduce detalii ale unei înregistrări individuale, compromițând astfel confidențialitatea.

Un scor mare de inferență de membru indică faptul că un atacator este puțin probabil să determine dacă o anumită înregistrare a făcut parte din setul de date inițial utilizat pentru a crea datele sintetice. Acest lucru înseamnă, de asemenea, că informațiile despre individ nu au fost compromise prin datele sintetice.

Conceptul de reținere

O bună practică importantă pe care trebuie să o urmăm este să ne asigurăm că datele sintetice sunt suficient de generale și nu se potrivesc peste datele originale pe care au fost instruite. În fluxul tipic de știință a datelor, în timp ce construim modele ML, cum ar fi un clasificator Random Forest, lăsăm deoparte datele de testare, antrenăm modelele folosind datele de antrenament și evaluăm valorile pe date de testare nevăzute.

În mod similar, pentru datele sintetice, păstrăm deoparte un eșantion de date originale – denumit în general un set de date reținute sau date de testare nevăzute reținute – și evaluăm datele sintetice generate în raport cu setul de date reținute.

Se așteaptă ca setul de date holdout să fie o reprezentare a datelor inițiale, dar care nu este văzut când au fost generate datele sintetice. Prin urmare, este vital să aveți scoruri similare pentru toate valorile atunci când comparăm originalul cu seturile de date holdout și sintetice.

Când se obțin scoruri similare, putem stabili că punctele de date sintetice nu sunt rezultatul memorării punctelor de date originale, păstrând în același timp aceeași fidelitate și utilitate.

Gânduri finale

Lumea începe să înțeleagă importanța strategică a datelor sintetice. În calitate de oameni de știință și generatori de date, este de datoria noastră să construim încredere în datele sintetice pe care le generăm și să ne asigurăm că acestea au un scop.

Datele sintetice evoluează într-un element obligatoriu în setul de instrumente pentru dezvoltarea științei datelor. MIT Technology Review are notat datele sintetice ca una dintre tehnologiile inovatoare ale anului 2022. Nu ne putem imagina construirea unor modele AI cu valoare excelentă fără date sintetice, susține Gartner.

În conformitate cu McKinsey, datele sintetice minimizează costurile și barierele pe care altfel le-ați avea atunci când dezvoltați algoritmi sau obțineți acces la date.

Generarea datelor sintetice se referă la cunoașterea aplicațiilor din aval și la înțelegerea compromisurilor dintre diferitele dimensiuni pentru calitatea datelor sintetice.

Rezumat

În calitate de utilizator al datelor sintetice, este esențial să definiți contextul cazului de utilizare pentru care fiecare eșantion de sintetic va fi utilizat în viitor. La fel ca în cazul datelor reale, calitatea datelor sintetice depinde de cazul de utilizare prevăzut, precum și de parametrii aleși pentru sintetizare.

De exemplu, păstrarea valorii aberante în datele sintetice ca și în datele originale este utilă pentru un caz de utilizare pentru detectarea fraudei. Cu toate acestea, nu este util într-un caz de utilizare a asistenței medicale cu probleme de confidențialitate, deoarece valorile aberante ar putea fi în general scurgeri de informații.

Mai mult, există un compromis între fidelitate, utilitate și confidențialitate. Datele nu pot fi optimizate pentru toate trei simultan. Aceste metrici le permit părților interesate să prioritizeze ceea ce este esențial pentru fiecare caz de utilizare și să gestioneze așteptările din datele sintetice generate.

În cele din urmă, când vedem valorile fiecărei metrici și când acestea îndeplinesc așteptările, părțile interesate pot avea încredere în soluțiile pe care le construiesc folosind datele sintetice.

Cazurile de utilizare pentru datele sintetice structurate acoperă o gamă largă de aplicații, de la date de testare pentru dezvoltarea de software până la crearea de brațe de control sintetice în studiile clinice.

Adresați-vă pentru a explora aceste oportunități sau creați un PoC pentru a demonstra valoarea.

Faris Haddad este responsabilul Data & Insights în echipa AABG Strategic Pursuits. El ajută companiile să devină cu succes bazate pe date.

Faris Haddad este responsabilul Data & Insights în echipa AABG Strategic Pursuits. El ajută companiile să devină cu succes bazate pe date.

- Avansat (300)

- AI

- ai art

- ai art generator

- ai robot

- Învățare automată Amazon

- inteligență artificială

- certificare de inteligență artificială

- inteligența artificială în domeniul bancar

- robot cu inteligență artificială

- roboți cu inteligență artificială

- software de inteligență artificială

- Învățare automată AWS

- blockchain

- conferință blockchain ai

- coingenius

- inteligența artificială conversațională

- criptoconferință ai

- dall-e

- învățare profundă

- google ai

- masina de învățare

- Plato

- platoul ai

- Informații despre date Platon

- Jocul lui Platon

- PlatoData

- platogaming

- scara ai

- sintaxă

- Instrucțiuni tehnice

- zephyrnet