Det här inlägget tar dig igenom de vanligaste utmaningarna som kunder möter när de söker i interna dokument, och ger dig konkret vägledning om hur AWS-tjänster kan användas för att skapa en generativ AI-konversationsbot som gör intern information mer användbar.

Ostrukturerad data står för 80 % av all data finns inom organisationer, bestående av arkiv med manualer, PDF-filer, vanliga frågor, e-postmeddelanden och andra dokument som växer dagligen. Företag i dag förlitar sig på ständigt växande förråd av intern information, och problem uppstår när mängden ostrukturerad data blir ohanterlig. Ofta finner användare att de läser och kontrollerar många olika interna källor för att hitta de svar de behöver.

Interna fråge- och svarsforum kan hjälpa användare att få mycket specifika svar men kräver också längre väntetider. När det gäller företagsspecifika interna vanliga frågor, leder långa väntetider till lägre medarbetarproduktivitet. Fråge- och svarsforum är svåra att skala eftersom de förlitar sig på manuellt skrivna svar. Med generativ AI sker för närvarande ett paradigmskifte i hur användare söker och hittar information. Nästa logiska steg är att använda generativ AI för att kondensera stora dokument till mindre bitstorleksinformation för enklare användarkonsumtion. Istället för att spendera lång tid på att läsa text eller vänta på svar kan användare generera sammanfattningar i realtid baserat på flera befintliga arkiv med intern information.

Lösningsöversikt

Lösningen gör det möjligt för kunder att hämta kurerade svar på frågor som ställs om interna dokument genom att använda en transformatormodell för att generera svar på frågor om data som den inte har tränats på, en teknik som kallas noll-shot prompting. Genom att använda den här lösningen kan kunder få följande fördelar:

- Hitta korrekta svar på frågor baserat på befintliga källor till interna dokument

- Minska den tid användare spenderar på att söka efter svar genom att använda stora språkmodeller (LLM) för att ge nästan omedelbara svar på komplexa frågor med hjälp av dokument med den mest uppdaterade informationen

- Sök tidigare besvarade frågor genom en centraliserad instrumentpanel

- Minska stressen som orsakas av att lägga tid på att manuellt läsa information för att leta efter svar

Retrieval Augmented Generation (RAG)

Retrieval Augmented Generation (RAG) minskar några av bristerna i LLM-baserade frågor genom att hitta svaren från din kunskapsbas och använda LLM för att sammanfatta dokumenten till koncisa svar. Snälla Läs detta inlägg att lära sig att implementera RAG-metoden med Amazon Kendra. Följande risker och begränsningar är förknippade med LLM-baserade frågor som en RAG-metod med Amazon Kendra adresserar:

- Hallucinationer och spårbarhet – LLMS tränas på stora datamängder och genererar svar på sannolikheter. Detta kan leda till felaktiga svar, som kallas hallucinationer.

- Flera datasilos – För att referera till data från flera källor i ditt svar måste man ställa in ett kopplingsekosystem för att aggregera data. Att komma åt flera arkiv är manuellt och tidskrävande.

- Säkerhet – Säkerhet och integritet är kritiska överväganden när man använder konversationsrobotar som drivs av RAG och LLM. Trots att man använder Amazon Comprehend för att filtrera bort personlig information som kan tillhandahållas genom användarförfrågningar, finns det fortfarande en möjlighet att oavsiktligt komma fram till personlig eller känslig information, beroende på den intagna informationen. Detta innebär att kontroll av åtkomst till chatboten är avgörande för att förhindra oavsiktlig åtkomst till känslig information.

- Datarelevans – LLMS tränas på data upp till ett visst datum, vilket innebär att informationen ofta inte är aktuell. Kostnaden för utbildningsmodeller på nyare data är hög. För att säkerställa korrekta och aktuella svar har organisationer ansvaret för att regelbundet uppdatera och berika innehållet i de indexerade dokumenten.

- Kostnad – Kostnaden förknippad med att implementera den här lösningen bör övervägas för företag. Företag måste noggrant utvärdera sin budget och prestandakrav när de implementerar denna lösning. Att köra LLM kan kräva betydande beräkningsresurser, vilket kan öka driftskostnaderna. Dessa kostnader kan bli en begränsning för applikationer som behöver arbeta i stor skala. Men en av fördelarna med AWS Cloud är flexibiliteten att bara betala för det du använder. AWS erbjuder en enkel, konsekvent, pay-as-you-go-prismodell, så att du bara debiteras för de resurser du förbrukar.

Användning av Amazon SageMaker JumpStart

För transformatorbaserade språkmodeller kan organisationer dra nytta av att använda Amazon SageMaker JumpStart, som erbjuder en samling förbyggda maskininlärningsmodeller. Amazon SageMaker JumpStart erbjuder ett brett utbud av grundmodeller för textgenerering och frågesvar (Q&A) som enkelt kan distribueras och användas. Denna lösning integrerar en FLAN T5-XL Amazon SageMaker JumpStart-modell, men det finns olika aspekter att tänka på när att välja en grundmodell.

Integrera säkerhet i vårt arbetsflöde

Följer bästa praxis i säkerhetspelaren i Välbyggt ramverk, Amazon Cognito används för autentisering. Amazon Cognito User Pools kan integreras med tredjepartsidentitetsleverantörer som stöder flera ramverk som används för åtkomstkontroll, inklusive Open Authorization (OAuth), OpenID Connect (OIDC) eller Security Assertion Markup Language (SAML). Genom att identifiera användare och deras handlingar kan lösningen upprätthålla spårbarheten. Lösningen använder också Amazon Förstå identifiering av personligt identifierbar information (PII). funktion för att automatiskt identifiera och redigera PII. Redigerad PII inkluderar adresser, personnummer, e-postadresser och annan känslig information. Denna design säkerställer att all PII som användaren tillhandahåller genom inmatningsfrågan redigeras. PII lagras inte, används av Amazon Kendra eller matas till LLM.

Lösningsgenomgång

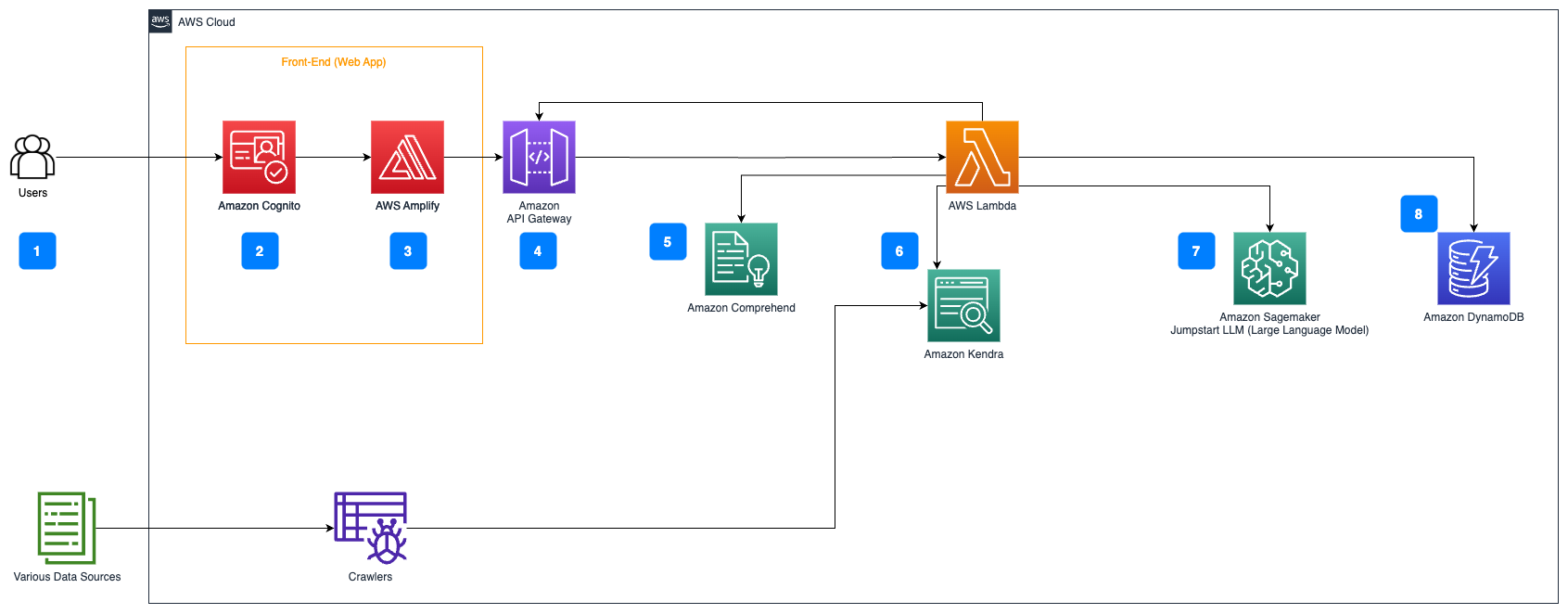

Följande steg beskriver arbetsflödet för Frågesvar över dokumentflödet:

- Användare skickar en fråga via ett webbgränssnitt.

- Amazon Cognito används för autentisering, vilket säkerställer säker åtkomst till webbapplikationen.

- Webbapplikationens gränssnitt finns på AWS förstärka.

- Amazon API Gateway är värd för ett REST API med olika slutpunkter för att hantera användarförfrågningar som är autentiserade med Amazon Cognito.

- PII-redigering med Amazon Comprehend:

- Bearbetning av användarfrågor: När en användare skickar in en fråga eller indata skickas den först genom Amazon Comprehend. Tjänsten analyserar texten och identifierar eventuella PII-enheter som finns i frågan.

- PII-extraktion: Amazon Comprehend extraherar de upptäckta PII-enheterna från användarfrågan.

- Relevant informationssökning med Amazon Kendra:

- Amazon Kendra används för att hantera ett index över dokument som innehåller informationen som används för att generera svar på användarens frågor.

- Smakämnen LangChain QA-hämtning modulen används för att bygga en konversationskedja som har relevant information om användarens frågor.

- Integration med Amazon SageMaker JumpStart:

- AWS Lambda-funktionen använder LangChain-biblioteket och ansluter till Amazon SageMaker JumpStart-slutpunkten med en kontextfylld fråga. Amazon SageMaker JumpStart-slutpunkten fungerar som gränssnittet för LLM som används för slutledning.

- Lagra svar och returnera det till användaren:

- Svaret från LLM lagras i Amazon DynamoDB tillsammans med användarens fråga, tidsstämpeln, en unik identifierare och andra godtyckliga identifierare för objektet såsom frågekategori. Genom att lagra frågan och svaret som diskreta objekt kan AWS Lambda-funktionen enkelt återskapa en användares konversationshistorik baserat på den tidpunkt då frågorna ställdes.

- Slutligen skickas svaret tillbaka till användaren via en HTTPs-förfrågan genom integreringssvaret för Amazon API Gateway REST API.

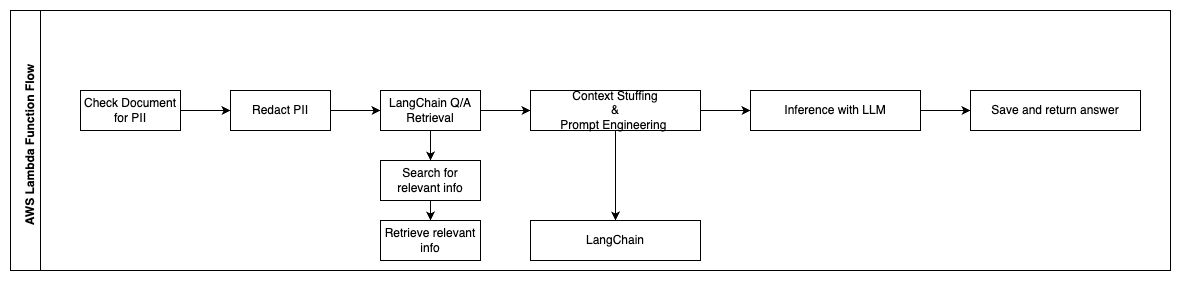

Följande steg beskriver AWS Lambda-funktioner och deras flöde genom processen:

- Kontrollera och redigera eventuell PII/känslig information

- LangChain QA Retrieval Chain

- Sök och hämta relevant information

- Context Stuffing & Prompt Engineering

- Slutsats med LLM

- Returnera svar och spara det

Användningsfall

Det finns många affärsanvändningsfall där kunder kan använda detta arbetsflöde. Följande avsnitt förklarar hur arbetsflödet kan användas i olika branscher och vertikaler.

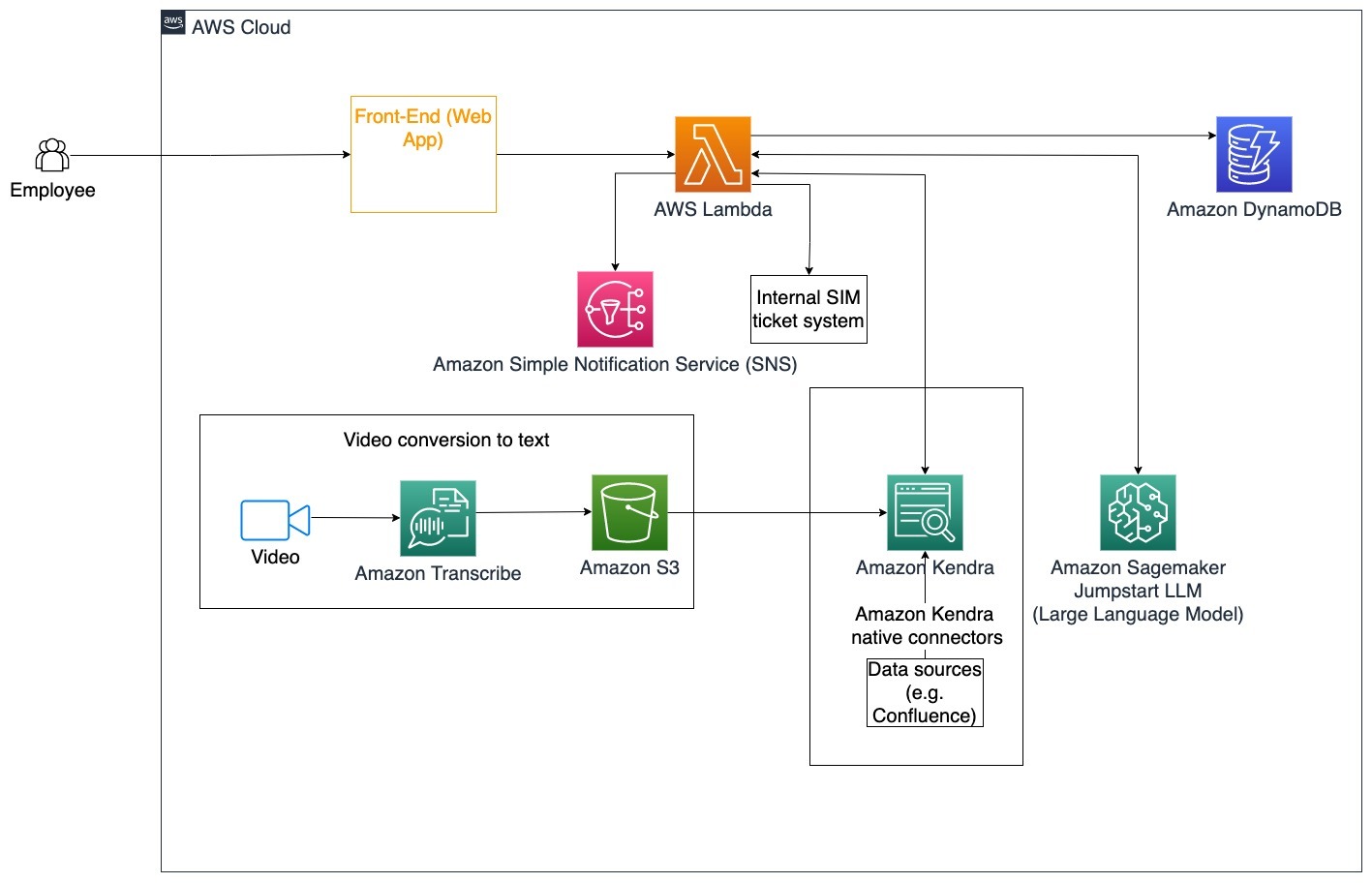

Personalhjälp

Väl utformad företagsutbildning kan förbättra medarbetarnas tillfredsställelse och minska tiden som krävs för att anställa nya medarbetare. När organisationer växer och komplexiteten ökar, har anställda svårt att förstå de många källorna till interna dokument. Interna dokument i detta sammanhang inkluderar företagets riktlinjer, policyer och standardiserade operativa procedurer. För det här scenariot har en anställd en fråga om hur han ska gå vidare och redigera en intern ärendebiljett. Den anställde kan komma åt och använda den generativa artificiella intelligensen (AI) konversationsboten för att fråga och utföra nästa steg för en specifik biljett.

Specifikt användningsfall: Automatisera problemlösning för anställda baserat på företagets riktlinjer.

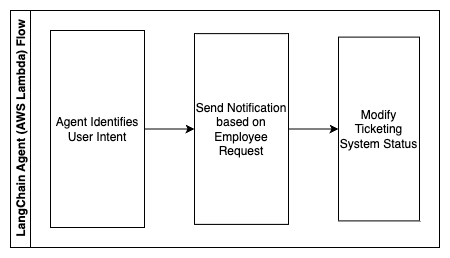

Följande steg beskriver AWS Lambda-funktioner och deras flöde genom processen:

- LangChain agent för att identifiera avsikten

- Skicka meddelande baserat på anställds begäran

- Ändra biljettstatus

I det här arkitekturdiagrammet kan företagsutbildningsvideor intas genom Amazon Transcribe för att samla en logg över dessa videoskript. Dessutom kan företagsutbildningsinnehåll lagrat i olika källor (t.ex. Confluence, Microsoft SharePoint, Google Drive, Jira, etc.) användas för att skapa index genom Amazon Kendra-anslutningar. Läs den här artikeln för att lära dig mer om samlingen av infödda kontakter du kan använda i Amazon Kendra som en källpunkt. Amazon Kendra-sökroboten kan sedan använda både företagsutbildningsvideoskript och dokumentation som lagras i dessa andra källor för att hjälpa konversationsboten att svara på frågor som är specifika för företagets riktlinjer för företagsutbildning. LangChain-agenten verifierar behörigheter, ändrar biljettstatus och meddelar rätt personer med Amazon Simple Notification Service (Amazon SNS).

Kundsupportteam

Att snabbt lösa kundfrågor förbättrar kundupplevelsen och uppmuntrar varumärkeslojalitet. En lojal kundbas hjälper till att driva försäljning, vilket bidrar till resultatet och ökar kundernas engagemang. Kundsupportteam lägger ner mycket energi på att referera till många interna dokument och programvara för kundrelationshantering för att svara på kundernas frågor om produkter och tjänster. Interna dokument i detta sammanhang kan inkludera generiska kundsupportsamtalsskript, spelböcker, riktlinjer för eskalering och affärsinformation. Den generativa AI-konversationsboten hjälper till med kostnadsoptimering eftersom den hanterar frågor på uppdrag av kundsupportteamet.

Specifikt användningsfall: Hantera en begäran om oljebyte baserat på servicehistorik och köpt kundserviceplan.

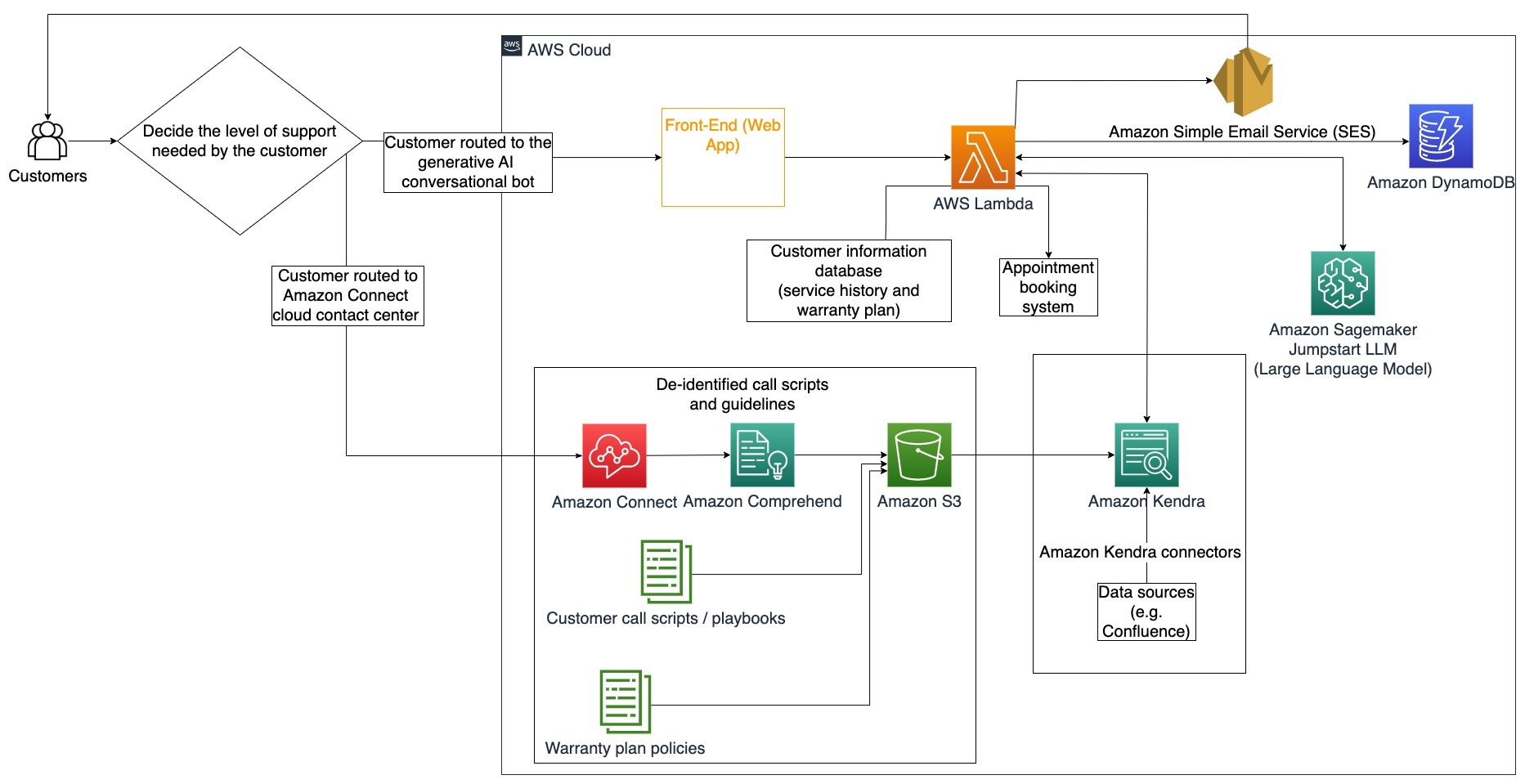

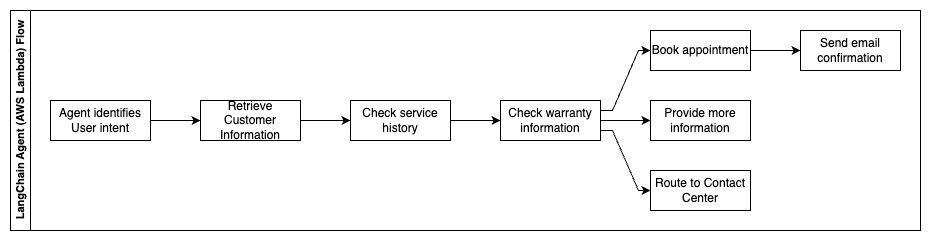

I detta arkitekturdiagram dirigeras kunden till antingen den generativa AI-konversationsboten eller Amazon Connect kontaktcenter. Detta beslut kan baseras på nivån av support som behövs eller tillgängligheten av kundsupportagenter. LangChain-agenten identifierar kundens avsikt och verifierar identiteten. LangChain-agenten kontrollerar också servicehistoriken och den köpta supportplanen.

Följande steg beskriver AWS Lambda-funktioner och deras flöde genom processen:

- LangChain-agenten identifierar avsikten

- Hämta kundinformation

- Kontrollera kundtjänsthistorik och garantiinformation

- Boka tid, ge mer information eller väg till kontaktcenter

- Skicka e-postbekräftelse

Amazon Connect används för att samla in röst- och chattloggarna, och Amazon Comprehend används för att ta bort personligt identifierbar information (PII) från dessa loggar. Amazon Kendra-sökroboten kan sedan använda de redigerade röst- och chattloggarna, skript för kundsamtal och policyer för kundtjänstsupportplan för att skapa indexet. När ett beslut är fattat bestämmer den generativa AI-konversationsboten om den ska boka ett möte, ge mer information eller dirigera kunden till kontaktcentret för ytterligare hjälp. För kostnadsoptimering kan LangChain-agenten också generera svar med färre tokens och en billigare stor språkmodell för lägre prioriterade kundfrågor.

Financial Services

Finansiella tjänsteföretag förlitar sig på snabb användning av information för att förbli konkurrenskraftiga och följa finansiella regler. Med hjälp av en generativ AI-konversationsbot kan finansanalytiker och rådgivare interagera med textinformation på ett konversationssätt och minska tiden och ansträngningen det tar att fatta bättre informerade beslut. Utöver investeringar och marknadsundersökningar kan en generativ AI-konversationsbot också utöka mänskliga förmågor genom att hantera uppgifter som traditionellt skulle kräva mer mänsklig ansträngning och tid. Till exempel kan en finansiell institution som specialiserat sig på personliga lån öka takten med vilken lån behandlas samtidigt som det ger bättre insyn till kunderna.

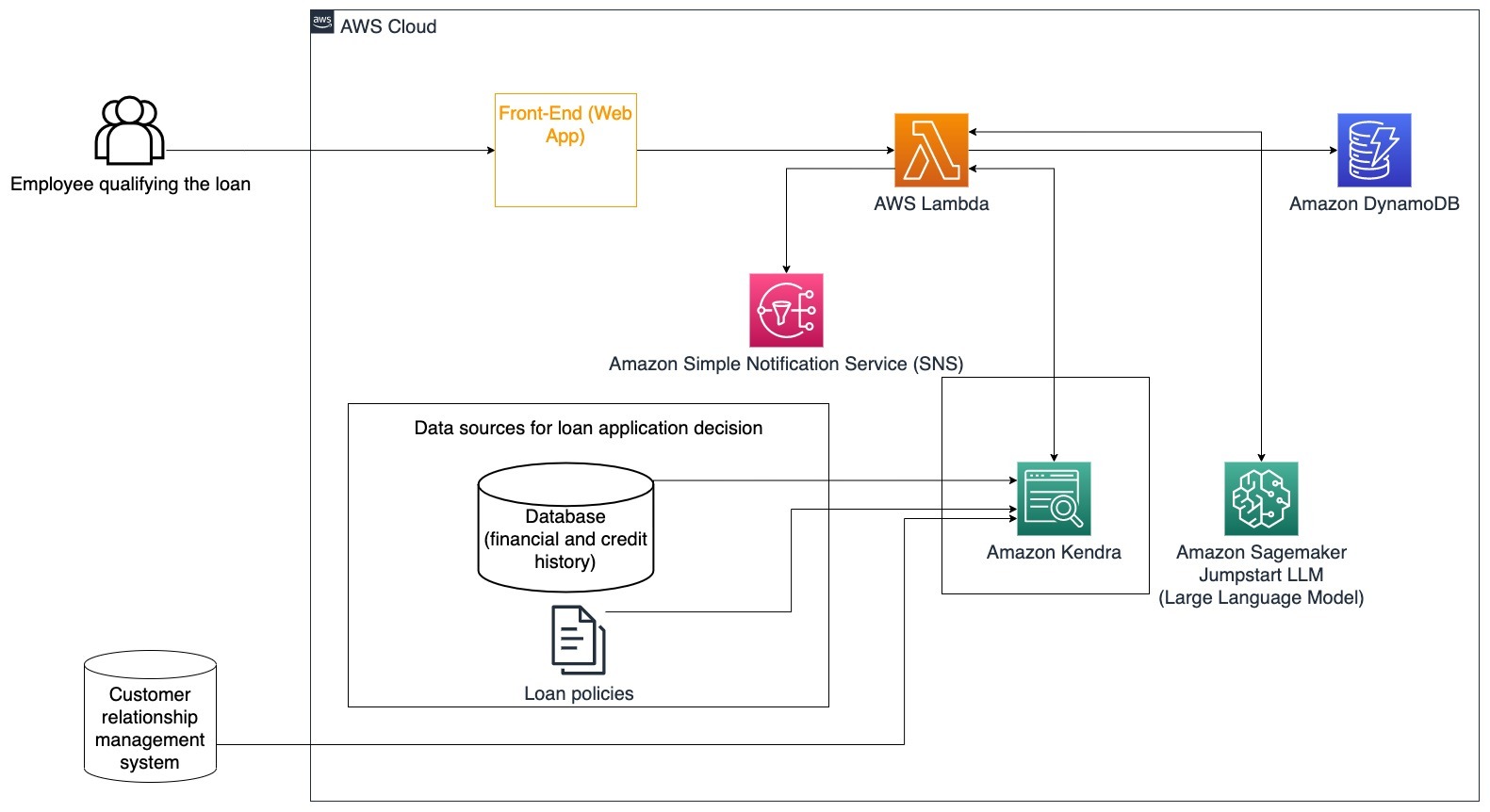

Specifikt användningsfall: Använd kundekonomisk historik och tidigare låneansökningar för att besluta och förklara lånebeslut.

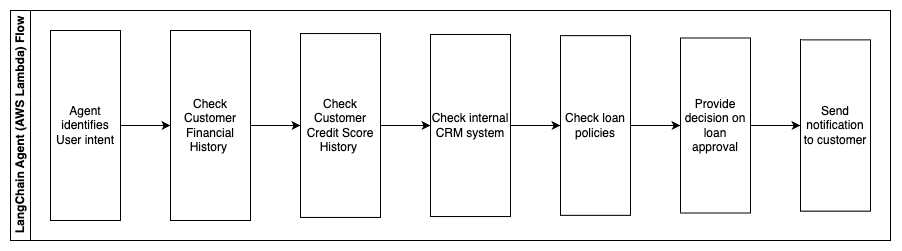

Följande steg beskriver AWS Lambda-funktioner och deras flöde genom processen:

- LangChain agent för att identifiera avsikten

- Kontrollera kundens ekonomiska och kredithistorik

- Kontrollera interna kundrelationshanteringssystem

- Kontrollera standardlånepolicyer och föreslå beslut för anställd som kvalificerar lånet

- Skicka meddelande till kund

Denna arkitektur inkluderar kundekonomisk data lagrad i en databas och data lagrad i ett CRM-verktyg (Customer Relationship Management). Dessa datapunkter används för att informera ett beslut baserat på företagets interna lånepolicyer. Kunden kan ställa förtydligande frågor för att förstå vilka lån de kvalificerar sig för och villkoren för de lån de kan acceptera. Om den generativa AI-konversationsboten inte kan godkänna en låneansökan kan användaren fortfarande ställa frågor om att förbättra kreditvärden eller alternativa finansieringsalternativ.

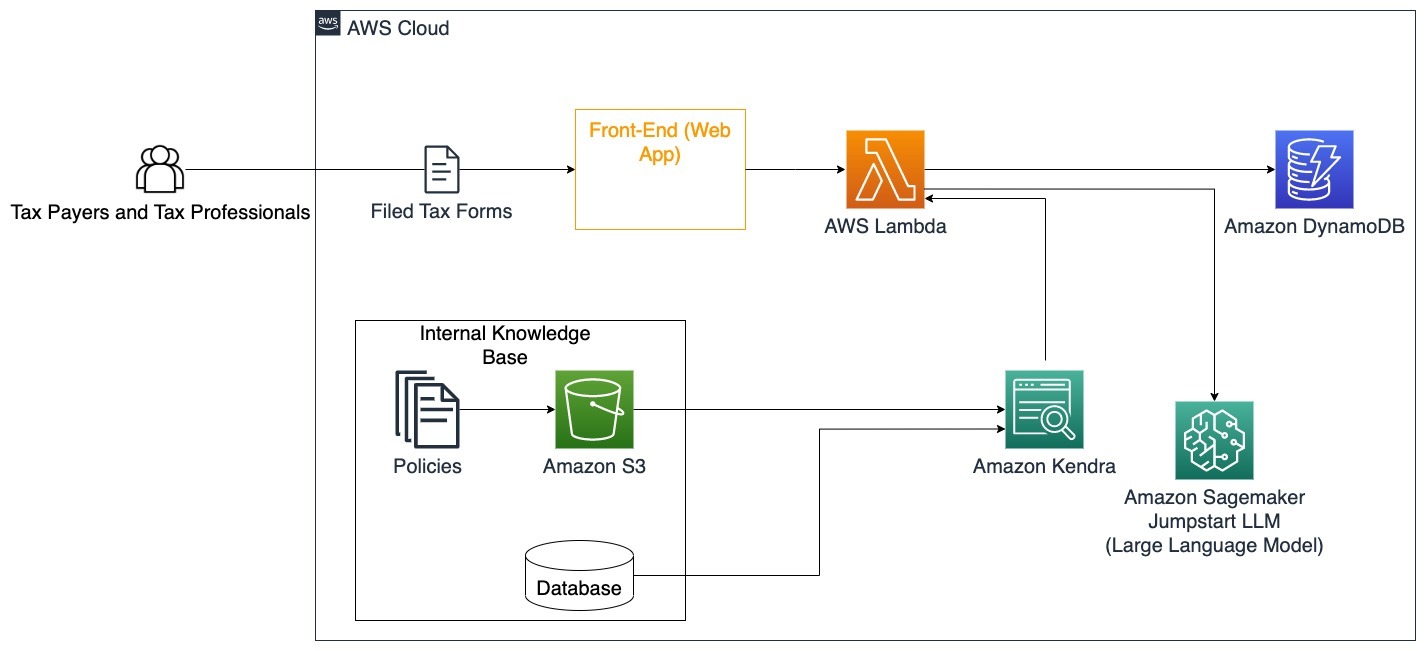

Regeringen

Generativa AI-konversationsrobotar kan till stor del gynna statliga institutioner genom att påskynda kommunikation, effektivitet och beslutsprocesser. Generativa AI-konversationsrobotar kan också ge omedelbar tillgång till interna kunskapsbaser för att hjälpa statliga anställda att snabbt hämta information, policyer och procedurer (dvs. behörighetskriterier, ansökningsprocesser och medborgarnas tjänster och support). En lösning är ett interaktivt system som gör att skattebetalare och skatteproffs enkelt kan hitta skatterelaterade detaljer och förmåner. Det kan användas för att förstå användarfrågor, sammanfatta skattedokument och ge tydliga svar genom interaktiva konversationer.

Användare kan ställa frågor som:

- Hur fungerar arvsskatten och vilka är skattegränserna?

- Kan du förklara begreppet inkomstskatt?

- Vilka är skattekonsekvenserna vid försäljning av en andra fastighet?

Dessutom kan användare ha bekvämligheten att skicka in skatteformulär till ett system, vilket kan hjälpa till att verifiera riktigheten av den information som tillhandahålls.

Den här arkitekturen illustrerar hur användare kan ladda upp ifyllda skatteformulär till lösningen och använda dem för interaktiv verifiering och vägledning om hur man korrekt fyller i nödvändig information.

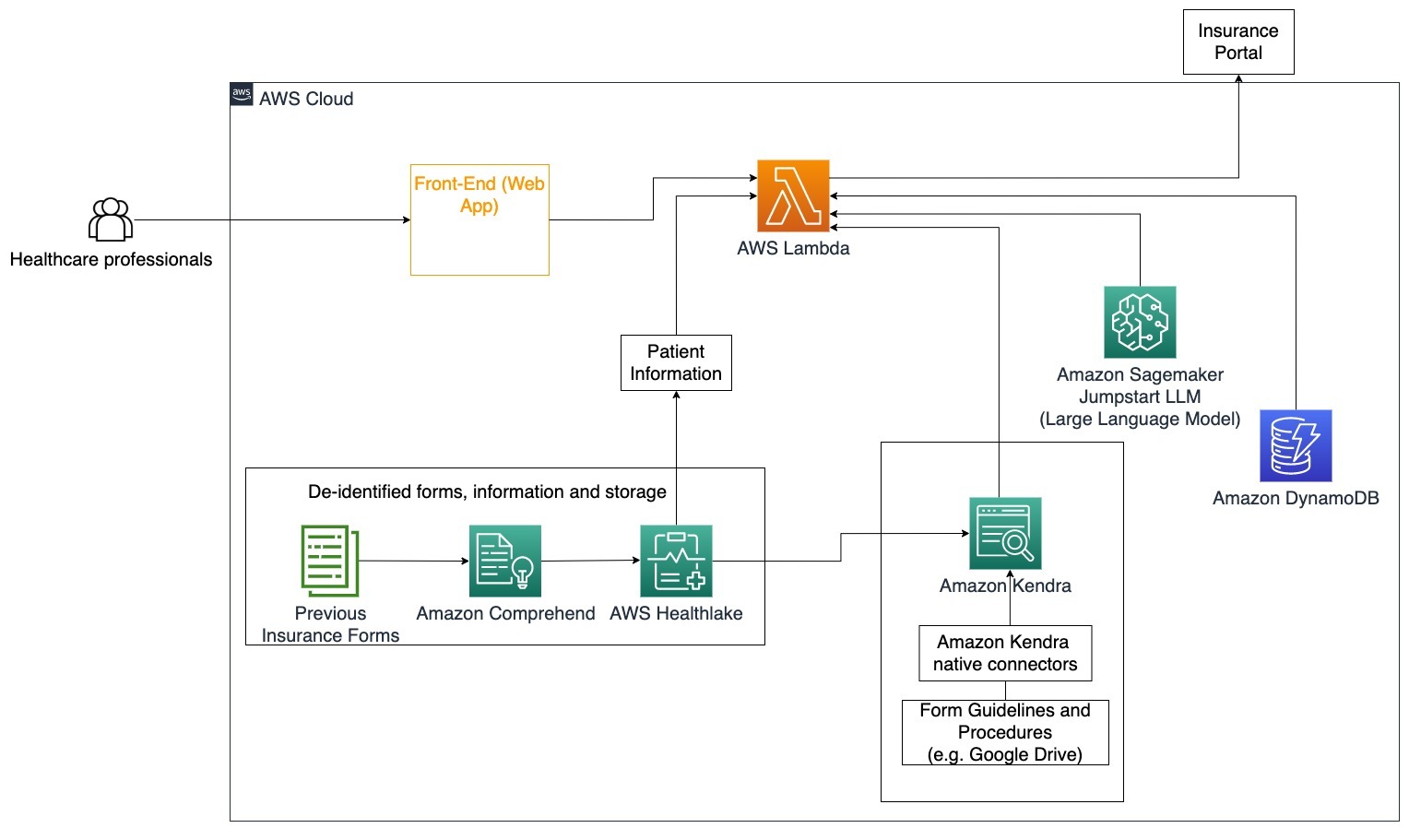

Sjukvård

Hälso- och sjukvårdsföretag har möjlighet att automatisera användningen av stora mängder intern patientinformation, samtidigt som de tar itu med vanliga frågor angående användningsfall såsom behandlingsalternativ, försäkringsanspråk, kliniska prövningar och läkemedelsforskning. Att använda en generativ AI-konversationsbot möjliggör snabb och korrekt generering av svar om hälsoinformation från den tillhandahållna kunskapsbasen. Till exempel lägger en del vårdpersonal mycket tid på att fylla i formulär för att lämna in försäkringsanspråk.

I liknande miljöer behöver administratörer och forskare för kliniska prövningar hitta information om behandlingsalternativ. En generativ AI-konversationsbot kan använda de förbyggda kontakterna i Amazon Kendra för att hämta den mest relevanta informationen från de miljontals dokument som publiceras genom pågående forskning utförd av läkemedelsföretag och universitet.

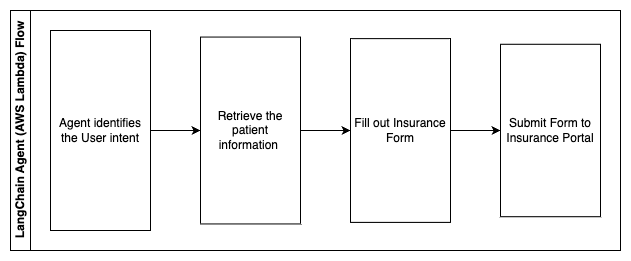

Specifikt användningsfall: Minska antalet fel och den tid som behövs för att fylla i och skicka försäkringsformulär.

I det här arkitekturdiagrammet kan en vårdpersonal använda den generativa AI-konversationsboten för att ta reda på vilka formulär som måste fyllas i för försäkringen. LangChain-agenten kan sedan hämta rätt formulär och lägga till nödvändig information för en patient samt ge svar för beskrivande delar av formulären baserat på försäkringar och tidigare formulär. Vårdpersonalen kan redigera svaren från LLM innan han godkänner och får formuläret levererat till försäkringsportalen.

Följande steg beskriver AWS Lambda-funktioner och deras flöde genom processen:

- LangChain agent för att identifiera avsikten

- Hämta den patientinformation som behövs

- Fyll i försäkringsblanketten utifrån patientinformationen och blankettriktlinjen

- Skicka in blanketten till försäkringsportalen efter användarens godkännande

AWS HealthLake används för att säkert lagra hälsodata inklusive tidigare försäkringsformulär och patientinformation, och Amazon Comprehend används för att ta bort personligt identifierbar information (PII) från de tidigare försäkringsformulären. Amazon Kendra-sökroboten kan sedan använda uppsättningen försäkringsformulär och riktlinjer för att skapa indexet. När formuläret/formulären har fyllts i av den generativa AI:n kan formuläret/formulären som granskats av läkaren skickas till försäkringsportalen.

Kostnadsberäkning

Kostnaden för att implementera baslösningen som ett proof-of-concept visas i följande tabell. Eftersom baslösningen anses vara ett proof-of-concept, användes Amazon Kendra Developer Edition som ett lågkostnadsalternativ eftersom arbetsbelastningen inte skulle vara i produktion. Vårt antagande för Amazon Kendra Developer Edition var 730 aktiva timmar för månaden.

För Amazon SageMaker gjorde vi ett antagande om att kunden skulle använda ml.g4dn.2xlarge-instansen för realtidsinferens, med en enda slutpunkt per instans. Du kan hitta mer information om Amazon SageMaker-priser och tillgängliga inferensinstanstyper här..

| Service | Resurser förbrukade | Kostnadsuppskattning per månad i USD |

| AWS förstärka | 150 byggminuter 1 GB data serverad 500,000 förfrågningar |

15.71 |

| Amazon API Gateway | 1M REST API-anrop | 3.5 |

| AWS Lambda | 1 miljon förfrågningar 5 sekunders varaktighet per begäran 2 GB minne tilldelat |

160.23 |

| Amazon DynamoDB | 1 miljon läsningar 1 miljon skriver 100 GB lagring |

26.38 |

| Amazon Sagemaker | Realtidsinferens med ml.g4dn.2xlarge | 676.8 |

| Amazon Kendra | Developer Edition med 730 timmar/månad 10,000 XNUMX dokument skannade 5,000 XNUMX frågor/dag |

821.25 |

| . | . | Total kostnad: 1703.87 |

* Amazon Cognito har en gratis nivå på 50,000 50 månatliga aktiva användare som använder Cognito User Pools eller 2.0 månatliga aktiva användare som använder SAML XNUMX-identitetsleverantörer

Clean Up

För att spara kostnader, ta bort alla resurser du distribuerade som en del av handledningen. Du kan ta bort alla SageMaker-slutpunkter som du kan ha skapat via SageMaker-konsolen. Kom ihåg, att ta bort ett Amazon Kendra-index tar inte bort originaldokumenten från din lagring.

Slutsats

I det här inlägget visade vi dig hur du förenklar åtkomsten till intern information genom att sammanfatta från flera arkiv i realtid. Efter den senaste utvecklingen av kommersiellt tillgängliga LLM:er har möjligheterna med generativ AI blivit mer uppenbara. I det här inlägget visade vi upp sätt att använda AWS-tjänster för att skapa en serverlös chatbot som använder generativ AI för att svara på frågor. Detta tillvägagångssätt innehåller ett autentiseringslager och Amazon Comprehends PII-detektering för att filtrera bort all känslig information som tillhandahålls i användarens fråga. Oavsett om det är individer inom vården som förstår nyanserna i att lämna in försäkringsanspråk eller HR som förstår specifika företagsomfattande regleringar, finns det flera branscher och vertikaler som kan dra nytta av detta tillvägagångssätt. En Amazon SageMaker JumpStart-grundmodell är motorn bakom chatboten, medan en kontextstoppningsmetod som använder RAG-tekniken används för att säkerställa att svaren mer exakt refererar till interna dokument.

För att lära dig mer om att arbeta med generativ AI på AWS, se Tillkännager nya verktyg för att bygga med generativ AI på AWS. För mer djupgående vägledning om att använda RAG-tekniken med AWS-tjänster, se Bygg snabbt generativa AI-applikationer med hög precision på företagsdata med hjälp av Amazon Kendra, LangChain och stora språkmodeller. Eftersom tillvägagångssättet i den här bloggen är LLM-agnostisk, kan vilken LLM som helst användas för slutledning. I vårt nästa inlägg kommer vi att skissera sätt att implementera denna lösning med Amazon Bedrock och Amazon Titan LLM.

Om författarna

Abhishek Maligehalli Shivalingaiah är senior AI Services Solution Architect på AWS. Han brinner för att bygga applikationer med hjälp av Generative AI, Amazon Kendra och NLP. Han har cirka 10 års erfarenhet av att bygga data- och AI-lösningar för att skapa värde för kunder och företag. Han har till och med byggt en (personlig) chatbot för skojs skull för att svara på frågor om hans karriär och yrkesresa. Utanför jobbet tycker han om att göra porträtt av familj och vänner, och älskar att skapa konstverk.

Abhishek Maligehalli Shivalingaiah är senior AI Services Solution Architect på AWS. Han brinner för att bygga applikationer med hjälp av Generative AI, Amazon Kendra och NLP. Han har cirka 10 års erfarenhet av att bygga data- och AI-lösningar för att skapa värde för kunder och företag. Han har till och med byggt en (personlig) chatbot för skojs skull för att svara på frågor om hans karriär och yrkesresa. Utanför jobbet tycker han om att göra porträtt av familj och vänner, och älskar att skapa konstverk.

Medha Aiyah är en Associate Solutions Architect på AWS, baserad i Austin, Texas. Hon tog nyligen examen från University of Texas i Dallas i december 2022 med sin magisterexamen i datavetenskap med specialisering på intelligenta system med fokus på AI/ML. Hon är intresserad av att lära sig mer om AI/ML och att använda AWS-tjänster för att upptäcka lösningar som kunder kan dra nytta av.

Medha Aiyah är en Associate Solutions Architect på AWS, baserad i Austin, Texas. Hon tog nyligen examen från University of Texas i Dallas i december 2022 med sin magisterexamen i datavetenskap med specialisering på intelligenta system med fokus på AI/ML. Hon är intresserad av att lära sig mer om AI/ML och att använda AWS-tjänster för att upptäcka lösningar som kunder kan dra nytta av.

Hugo Tse är en Associate Solutions Architect på AWS baserad i Seattle, Washington. Han har en magisterexamen i informationsteknologi från Arizona State University och en kandidatexamen i ekonomi från University of Chicago. Han är medlem i Information Systems Audit and Control Association (ISACA) och International Information System Security Certification Consortium (ISC)2. Han tycker om att hjälpa kunder att dra nytta av tekniken.

Hugo Tse är en Associate Solutions Architect på AWS baserad i Seattle, Washington. Han har en magisterexamen i informationsteknologi från Arizona State University och en kandidatexamen i ekonomi från University of Chicago. Han är medlem i Information Systems Audit and Control Association (ISACA) och International Information System Security Certification Consortium (ISC)2. Han tycker om att hjälpa kunder att dra nytta av tekniken.

Ayman Ishimwe är en Associate Solutions Architect på AWS baserad i Seattle, Washington. Han har en magisterexamen i mjukvaruteknik och IT från Oakland University. Han har tidigare erfarenhet av mjukvaruutveckling, speciellt av att bygga mikrotjänster för distribuerade webbapplikationer. Han brinner för att hjälpa kunder att bygga robusta och skalbara lösningar på AWS molntjänster enligt bästa praxis.

Ayman Ishimwe är en Associate Solutions Architect på AWS baserad i Seattle, Washington. Han har en magisterexamen i mjukvaruteknik och IT från Oakland University. Han har tidigare erfarenhet av mjukvaruutveckling, speciellt av att bygga mikrotjänster för distribuerade webbapplikationer. Han brinner för att hjälpa kunder att bygga robusta och skalbara lösningar på AWS molntjänster enligt bästa praxis.

Shervin Suresh är en Associate Solutions Architect på AWS baserad i Austin, Texas. Han har tagit examen med en magisterexamen i mjukvaruteknik med en koncentration i molnberäkning och virtualisering och en kandidatexamen i datateknik från San Jose State University. Han brinner för att utnyttja teknik för att förbättra livet för människor från alla bakgrunder.

Shervin Suresh är en Associate Solutions Architect på AWS baserad i Austin, Texas. Han har tagit examen med en magisterexamen i mjukvaruteknik med en koncentration i molnberäkning och virtualisering och en kandidatexamen i datateknik från San Jose State University. Han brinner för att utnyttja teknik för att förbättra livet för människor från alla bakgrunder.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Fordon / elbilar, Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- ChartPrime. Höj ditt handelsspel med ChartPrime. Tillgång här.

- BlockOffsets. Modernisera miljökompensation ägande. Tillgång här.

- Källa: https://aws.amazon.com/blogs/machine-learning/simplify-access-to-internal-information-using-retrieval-augmented-generation-and-langchain-agents/

- : har

- :är

- :inte

- :var

- $UPP

- 000

- 10

- 100

- 125

- 2022

- 50

- 7

- a

- Able

- Om Oss

- Acceptera

- tillgång

- åtkomst

- konton

- exakt

- exakt

- åtgärder

- aktiv

- lägga till

- Dessutom

- adresser

- adresse

- administratörer

- Anta

- rådgivare

- Efter

- Recensioner

- medel

- aggregat

- AI

- AI-tjänster

- AI / ML

- Alla

- tillåter

- längs

- också

- alternativ

- amason

- Amazon API Gateway

- Amazon Cognito

- Amazon Comprehend

- Amazon Kendra

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- mängd

- mängder

- an

- analytiker

- analyser

- och

- svara

- svar

- vilken som helst

- api

- skenbar

- Ansökan

- tillämpningar

- tidsbeställning

- tillvägagångssätt

- godkänna

- arkitektur

- ÄR

- stiga upp

- arizona

- runt

- Artikeln

- konstgjord

- artificiell intelligens

- Konstgjord intelligens (AI)

- konstverk

- AS

- be

- aspekter

- bedöma

- bistå

- Bistånd

- Associate

- associerad

- Förening

- Antagandet

- At

- revision

- augmented

- austin

- authenticated

- Autentisering

- tillstånd

- automatisera

- automatiskt

- tillgänglighet

- tillgänglig

- AWS

- AWS Lambda

- tillbaka

- bakgrunder

- bas

- baserat

- BE

- Bear

- därför att

- blir

- blir

- varit

- innan

- vägnar

- bakom

- fördel

- Fördelarna

- BÄST

- bästa praxis

- Bättre

- Blogg

- boken

- Bot

- båda

- botar

- Botten

- varumärke

- budget

- SLUTRESULTAT

- Byggnad

- byggt

- företag

- företag

- men

- by

- Ring

- KAN

- kapacitet

- Karriär

- försiktigt

- Vid

- fall

- Kategori

- orsakas

- Centrum

- centraliserad

- vissa

- certifiering

- kedja

- utmaningar

- byta

- laddad

- chatbot

- kontroll

- Kontroller

- chicago

- hävdar

- klar

- Klinisk

- kliniska tester

- cloud

- cloud computing

- molntjänster

- samla

- samling

- kommersiellt

- Gemensam

- Kommunikation

- Företag

- företag

- Företagets

- konkurrenskraftig

- Avslutade

- fullborda

- komplex

- Komplexiteten

- följa

- förstå

- dator

- Datorteknik

- Datavetenskap

- databehandling

- koncentration

- begrepp

- koncis

- genomfördes

- konfluens

- Kontakta

- ansluter

- övervägande

- överväganden

- anses

- konsekvent

- Bestående

- Konsol

- konsortium

- konsumera

- konsumtion

- kontakta

- kontaktcenter

- innehåller

- innehåll

- sammanhang

- kontinuerligt

- bidrar

- kontroll

- styrning

- bekvämlighet

- Konversation

- konversera

- konversationer

- Företag

- korrekt

- Pris

- Kostar

- sökrobot

- skapa

- Skapa värde

- skapas

- Skapa

- kredit

- kriterier

- kritisk

- CRM

- avgörande

- kurerad

- Aktuella

- För närvarande

- kund

- Kundförlovning

- kundupplevelse

- Kundservice

- Helpdesk

- Kunder

- dagligen

- Dallas

- datum

- datapunkter

- datauppsättningar

- Databas

- Datum

- December

- beslutar

- Beslutet

- Beslutsfattande

- beslut

- Examen

- levereras

- beroende

- utplacerade

- utplacera

- beskriva

- Designa

- Trots

- detaljer

- detekterad

- Detektering

- Utvecklare

- Utveckling

- utvecklingen

- olika

- svårt

- Upptäck

- distribueras

- dokumentation

- dokument

- gör

- inte

- driv

- varaktighet

- e

- lättare

- lätt

- Ekonomi

- ekosystemet

- edition

- effektivitet

- ansträngning

- antingen

- berättigande

- e

- Anställd

- anställda

- möjliggör

- uppmuntrar

- Slutpunkt

- energi

- ingrepp

- Motor

- Teknik

- berikande

- säkerställa

- säkerställer

- säkerställa

- Företag

- företag

- enheter

- fel

- eskalering

- uppskatta

- etc

- Även

- exempel

- exekvera

- befintliga

- dyra

- erfarenhet

- Förklara

- Förklarar

- extraktion

- extrakt

- Ansikte

- familj

- Leverans

- Fed

- färre

- Figur

- Fil

- fylla

- fyllda

- fyllning

- filtrera

- finansiella

- finansiella data

- ekonomisk historia

- finansiell institution

- finansiering

- hitta

- finna

- Förnamn

- Flexibilitet

- flöda

- fokusering

- efter

- För

- formen

- former

- forum

- hittade

- fundament

- ramar

- Fri

- vänner

- från

- kul

- fungera

- funktioner

- ytterligare

- Få

- nätbryggan

- generera

- generering

- generativ

- Generativ AI

- skaffa sig

- ges

- ger

- Ge

- Regeringen

- kraftigt

- Väx

- Odling

- Växer

- vägleda

- riktlinjer

- hantera

- Handtag

- Arbetsmiljö

- Har

- har

- he

- Hälsa

- hälsoinformation

- hälso-och sjukvård

- hjälpa

- hjälpa

- hjälper

- här

- Hög

- höggradigt

- hans

- historia

- innehar

- värd

- värdar

- ÖPPETTIDER

- Hur ser din drömresa ut

- How To

- Men

- hr

- html

- HTTPS

- humant

- i

- identifierare

- identifierare

- identifierar

- identifiera

- identifiera

- Identitet

- if

- illustrerar

- genomföra

- genomföra

- implikationer

- förbättra

- förbättrar

- förbättra

- in

- djupgående

- felaktig

- innefattar

- innefattar

- Inklusive

- Inkomst

- inkomstskatt

- Öka

- Ökar

- index

- indexeras

- index

- individer

- industrier

- underrätta

- informationen

- Informationssystem

- informationsteknologi

- informeras

- arv

- ingång

- exempel

- omedelbar

- istället

- Institution

- institutioner

- försäkring

- integrerade

- integrerar

- integrering

- Intelligens

- Intelligent

- uppsåt

- interagera

- interaktiva

- intresserad

- Gränssnitt

- inre

- Internationell

- in

- investering

- fråga

- IT

- artikel

- resa

- jpg

- Ha kvar

- kunskap

- känd

- språk

- Large

- lager

- leda

- LÄRA SIG

- inlärning

- mindre

- Nivå

- hävstångs

- Bibliotek

- begränsning

- begränsningar

- linje

- Bor

- LLM

- lån

- Lån

- log

- logisk

- Lång

- länge sedan

- längre

- se

- Lot

- älskar

- låg kostnad

- lägre

- lojala

- Lojalitet

- Maskinen

- maskininlärning

- gjord

- bibehålla

- göra

- GÖR

- Framställning

- hantera

- ledning

- sätt

- manuell

- manuellt

- många

- marknad

- marknadsundersökning

- master

- Maj..

- betyder

- medicinsk

- medlem

- Minne

- microservices

- Microsoft

- miljon

- miljoner

- emot

- ML

- modell

- modeller

- Modulerna

- Månad

- månad

- mer

- mest

- multipel

- nativ

- nödvändigt för

- Behöver

- behövs

- behov

- Nya

- Nästa

- nlp

- anmälan

- nummer

- Oakland

- oauth

- of

- Erbjudanden

- Ofta

- Olja

- on

- Onboarding

- gång

- ONE

- pågående

- endast

- öppet

- driva

- drift

- operativa

- Möjlighet

- optimering

- Alternativet

- Tillbehör

- or

- beställa

- organisationer

- ursprungliga

- Övriga

- vår

- ut

- översikt

- utanför

- över

- paradigmet

- del

- reservdelar till din klassiker

- Godkänd

- brinner

- Patienten

- Betala

- Personer

- för

- prestanda

- behörigheter

- personlig

- personlig information

- Personligen

- Läkemedelsindustrin

- Pelare

- Planen

- plato

- Platon Data Intelligence

- PlatonData

- snälla du

- Punkt

- poäng

- Strategier

- Pools

- Portal

- porträtt

- Möjligheterna

- Möjligheten

- Inlägg

- drivs

- praxis

- presentera

- förhindra

- föregående

- tidigare

- prissättning

- prissättningsmodell

- Innan

- prioritet

- privatpolicy

- problem

- förfaranden

- Fortsätt

- process

- Bearbetad

- processer

- bearbetning

- Produktion

- produktivitet

- Produkter

- professionell

- yrkesmän/kvinnor

- egenskapen

- ge

- förutsatt

- leverantörer

- tillhandahålla

- publicerade

- köpt

- Frågor och svar

- kvalificera

- kvalificerande

- sökfrågor

- fråga

- frågor

- Snabbt

- snabbt

- område

- Betygsätta

- Läsa

- Läsning

- realtid

- senaste

- nyligen

- minska

- minskar

- hänvisa

- erat

- om

- regelbundet

- föreskrifter

- relation

- relevans

- relevanta

- förlita

- resterna

- ihåg

- ta bort

- begära

- förfrågningar

- kräver

- Obligatorisk

- Krav

- forskning

- forskare

- Upplösning

- lösa

- Resurser

- respons

- svar

- ansvaret

- REST

- resultera

- tillbaka

- Granskad

- höger

- risker

- robusta

- Rutt

- rinnande

- s

- sagemaker

- försäljning

- San

- San Jose

- tillfredsställande

- Save

- skalbar

- Skala

- scenario

- Vetenskap

- göra

- skript

- Sök

- söka

- Seattle

- Andra

- sekunder

- §

- säkra

- säkert

- säkerhet

- Försäljningen

- sända

- senior

- känslig

- skickas

- Server

- serverar

- service

- Tjänster

- in

- uppsättningar

- inställningar

- flera

- hon

- skifta

- brister

- skall

- utställningsmonter

- visade

- visas

- silor

- liknande

- Enkelt

- förenkla

- eftersom

- enda

- sized

- mindre

- So

- Social hållbarhet

- Mjukvara

- mjukvaruutveckling

- mjukvaruutveckling

- lösning

- Lösningar

- några

- Källa

- Källor

- specialiserat

- specifik

- specifikt

- spendera

- Spendera

- standard

- Ange

- status

- bo

- Steg

- Steg

- Fortfarande

- förvaring

- lagra

- lagras

- misslyckande

- påkänning

- fyllning

- väsentlig

- sådana

- föreslå

- sammanfatta

- stödja

- system

- System

- bord

- tar

- uppgifter

- skatt

- grupp

- lag

- Teknologi

- villkor

- texas

- text

- text-

- den där

- Smakämnen

- den information

- deras

- sig själva

- sedan

- Där.

- Dessa

- de

- tredje part

- detta

- Genom

- biljett

- biljettförsäljning

- djur

- tid

- tidskrävande

- tid

- gånger

- tidsstämpel

- titan

- till

- i dag

- tokens

- verktyg

- verktyg

- Spårbarhet

- traditionellt

- tränad

- Utbildning

- transformator

- Öppenhet

- behandling

- rättegång

- försök

- handledning

- typer

- oförmögen

- förstå

- förståelse

- unika

- Universitet

- universitet

- University of Chicago

- TIDSENLIG

- uppdaterad

- uppdatering

- användning

- användningsfall

- Begagnade

- Användare

- användare

- användningar

- med hjälp av

- utnyttja

- utnyttjas

- Använda

- värde

- olika

- Verifiering

- verifiera

- vertikaler

- via

- Video

- Video

- Röst

- vänta

- väntar

- var

- washington

- sätt

- we

- webb

- webbapplikation

- webbapplikationer

- webbservice

- VÄL

- były

- Vad

- när

- om

- som

- medan

- VEM

- bred

- Brett utbud

- med

- inom

- Arbete

- arbetsflöde

- arbetssätt

- skulle

- skriven

- år

- Om er

- Din

- zephyrnet