Bias i AI-system har visat sig vara en stor stötesten i ansträngningarna att bredare integrera tekniken i vårt samhälle. Ett nytt initiativ som kommer att belöna forskare för att hitta eventuella fördomar i AI-system kan hjälpa till att lösa problemet.

Ansträngningen bygger på buggpengarna som programvaruföretag betalar till cybersäkerhetsexperter som varnar dem of eventuella säkerhetsbrister i deras produkter. Idén är inte ny; "bias bounties" var först föreslog av AJag forskar och entreprenör JB Rubinovitz redan 2018, och olika organisationer har redan drivit sådana utmaningar.

Men den nya ansträngningen syftar till att skapa ett pågående forum för partiska bounty-tävlingar som är oberoende av någon särskild organisation. De så kallade "Bias Buccaneers" består av volontärer från en rad företag, inklusive Twitter, och planerar att hålla regelbundna tävlingar, eller "myterier", och tidigare denna månad lanserade den första sådana utmaningen.

"Bug bounties är en standardpraxis inom cybersäkerhet som ännu inte har fått fotfäste i den algoritmiska bias-gemenskapen, säger organisationen.nizers säger på deras hemsida. "Medan de första engångshändelserna visade entusiasm för belöningar, är Bias Buccaneers den första ideella organisationen avsedd att skapa pågående myterier, samarbeta med teknikföretag och bana väg för transparenta och reproducerbara utvärderingar av AI-system."

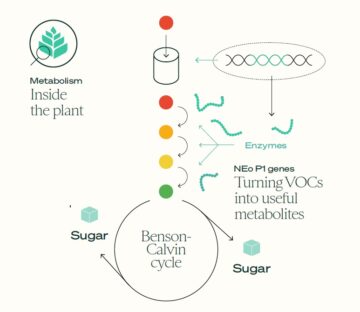

Den här första tävlingen syftar till att ta itu med bias i bilddetekteringsalgoritmer, men snarare än att få människor att rikta in sig på specifika AI-system, tävlingen kommer XNUMX kapuppmana forskare att bygga verktyg som kan upptäcka partiska datamängder. Tanken är att skapa en maskininlärningsmodell som exakt kan märka varje bild i en datauppsättning med dess hudton, upplevda kön och åldersgrupp. Tävlingen avslutas den 30 november och har ett förstapris på $6,000 4,000, andrapris på $2,000 XNUMX och tredjepris på $XNUMX XNUMX.

Utmaningen grundar sig på det faktum att ofta källan till algoritmisk bias inte så mycket är själva algoritmen, utan arten av data den tränas på. Automatiserade verktyg som snabbt kan bedöma hur balanserad en samling of bilder är i relation till attribut som ofta är källor till diskriminering kan hjälpa AI-forskare att undvika tydligt partiska datakällor.

Men arrangörerna säger att detta bara är det första steget i ett försök att bygga upp en verktygslåda för att bedöma bias i datamängder, algoritmer och applikationer, och i slutändan skapa standarder för hur man kan avläsal med algoritmisk fördom, rättvisa och förklarabarhet.

Det är inte den enda ansträngningen. En av ledarna för det nya initiativ är Twitters Rumman Chowdhury, som hjälpte till att organisera den första AI-bias bounty-tävlingen förra året, inriktad på en algoritm som plattformen använde för att beskära bilder som användare klagade gynnade vithyade och manliga ansikten framför svarta och kvinnliga.

Tävlingen gav hackare tillgång till företagets modell och utmanade dem att hitta brister i den. Deltagare hittat ett stort antal problem, inklusiveföredrar stereotypt vackra ansikten, en motvilja mot personer med vitt hår (en markör för ålder), och en preferens för memes med engelska snarare än arabiska.

Stanford University har också nyligen avslutat en tävling som utmanade team att komma med verktyg utformade för att hjälpa människor att granska kommersiellt distribuerade eller öppen källkod AI-system för diskriminering. Och nuvarande och kommande EU-lagar kan göra det obligatoriskt för företag att regelbundet granska sina data och algoritmer.

Men tar AI-buggbelöningar och algoritmisk granskning mainstream och att göra dem effektiva är lättare sagt än gjort. Oundvikligen kommer företag som bygger sina verksamheter på sina algoritmer att motstå alla försök att misskreditera dem.

Bygger på lärdomar från revisionssystem inom andra områden, såsom ekonomi och miljö- och hälsobestämmelser, forskare nyligen beskrivs några av de avgörande ingredienserna för effektiv ansvarsskyldighet. En av de mest viktiga kriterier de identifierade var ett meningsfullt engagemang från oberoende tredje parter.

Forskarna påpekade att nuvarande frivilliga AI-revisioner ofta innebär intressekonflikter, som att målorganisationen betalar för revisionen, hjälper till att rama in revisionens omfattning eller har möjlighet att granska resultaten innan de publiceras. Denna oro återspeglades i en färsk rapport från Algoritmisk rättvisaliga, which noterade överdimensionend målorganisationers roll i nuvarande program för cybersäkerhetsfel.

Att hitta ett sätt att finansiera och stödja verkligt oberoende AI-revisorer och buggjägare kommer att vara en betydande utmaning, särskilt eftersom de kommer att ställas mot några av de mest välresursstarka företagen i världen. Men lyckligtvis verkar det finnas en växande känsla inom branschen att det kommer att vara avgörande att ta itu med detta problem för att upprätthålla användarnas förtroende för deras tjänster.

Image Credit: Jakob Rosen / Unsplash