Eye-tracking – möjligheten att snabbt och exakt mäta i vilken riktning en användare tittar inuti ett VR-headset – talas ofta om inom ramen för foveated rendering, och hur det kan minska prestandakraven för XR-headset. Och medan foveated rendering är ett spännande användningsfall för eye-tracking i AR- och VR-headset, kan eyetracking-stativ tillföra mycket mer till bordet.

Uppdaterad – 2 maj 2023

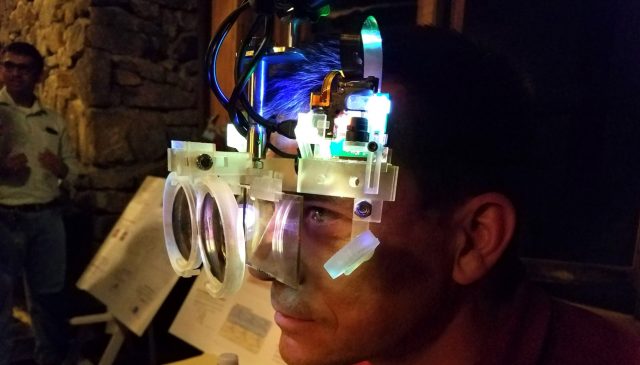

Eye-tracking har pratats om med avseende på XR som en avlägsen teknologi i många år, men hårdvaran blir äntligen allt mer tillgänglig för utvecklare och kunder. PSVR 2 och Quest Pro är de mest synliga exemplen på headset med inbyggd eyetracking, tillsammans med sådana som Varjo Aero, Vive Pro Eye och mer.

Med detta momentum kunde vi på bara några år se eyetracking bli en standarddel av XR-headset för konsumenter. När det händer finns det ett brett utbud av funktioner som tekniken kan möjliggöra för att drastiskt förbättra upplevelsen.

Foveated Rendering

Låt oss först börja med den som många redan känner till. Foveated rendering syftar till att minska den beräkningskraft som krävs för att visa krävande AR- och VR-scener. Namnet kommer från "fovea" - en liten grop i mitten av den mänskliga näthinnan som är tätt packad med fotoreceptorer. Det är fovea som ger oss högupplöst syn i mitten av vårt synfält; Samtidigt är vårt perifera seende faktiskt mycket dåligt på att fånga upp detaljer och färg, och är bättre inställda för att se rörelser och kontrast än att se detaljer. Du kan tänka på det som en kamera som har en stor sensor med bara några megapixlar, och en annan mindre sensor i mitten med massor av megapixlar.

Området i din syn där du kan se i hög detalj är faktiskt mycket mindre än de flesta tror – bara några grader tvärs över mitten av din syn. Skillnaden i upplösningsförmåga mellan fovea och resten av näthinnan är så drastisk att utan din fovea skulle du inte kunna urskilja texten på den här sidan. Du kan enkelt se detta själv: om du håller ögonen fokuserade på detta ord och försök att läsa bara två meningar nedan, kommer du att upptäcka att det är nästan omöjligt att förstå vad orden säger, även om du kan se något liknar ord. Anledningen till att människor överskattar den foveala regionen av sin syn verkar vara för att hjärnan gör många omedvetna tolkningar och förutsägelser för att bygga en modell av hur vi tror att världen är.

Foveated rendering syftar till att utnyttja denna egenhet i vår vision genom att återge den virtuella scenen i hög upplösning endast i den region som fovean ser, och sedan drastiskt minska komplexiteten i scenen i vår perifera vision där detaljen inte kan lösas ändå. . Genom att göra det kan vi fokusera det mesta av processorkraften där den bidrar mest till detaljer, samtidigt som vi sparar bearbetningsresurser någon annanstans. Det kanske inte låter som en stor affär, men när skärmupplösningen för XR-headset och synfält ökar, växer kraften som behövs för att rendera komplexa scener snabbt.

Eye-tracking spelar förstås in eftersom vi behöver veta var centrum för användarens blick hela tiden befinner sig snabbt och med hög precision för att få fram foveated rendering. Även om det är svårt att klara av detta utan att användaren märker det, är det möjligt och har demonstrerats ganska effektivt på nya headset som Quest Pro och PSVR 2.

Automatisk användaridentifiering och -justering

![]()

Förutom att detektera rörelse kan eye-tracking också användas som en biometrisk identifierare. Det gör eye-tracking till en utmärkt kandidat för flera användarprofiler över ett enda headset – när jag sätter på mig headsetet kan systemet omedelbart identifiera mig som en unik användare och kalla fram min anpassade miljö, innehållsbibliotek, spelframsteg och inställningar. När en vän tar på sig headsetet kan systemet laddas deras inställningar och sparad data.

Eye-tracking kan också användas för att exakt mäta IPD (avståndet mellan ens ögon). Att känna till din IPD är viktigt i XR eftersom det krävs för att flytta linserna och bildskärmarna till den optimala positionen för både komfort och visuell kvalitet. Tyvärr många människor förståeligt nog inte vet vad deras IPD från toppen av huvudet.

Med eye-tracking skulle det vara enkelt att omedelbart mäta varje användares IPD och sedan låta headsetets programvara hjälpa användaren att justera headsetets IPD för att matcha, eller varna användare att deras IPD ligger utanför det intervall som stöds av headsetet.

I mer avancerade headset kan denna process vara osynlig och automatisk – IPD kan mätas osynligt, och headsetet kan ha en motoriserad IPD-justering som automatiskt flyttar linserna till rätt position utan att användaren behöver vara medveten om något av det, som t.ex. på Varjo Aero, till exempel.

Varifokala skärmar

De optiska systemen som används i dagens VR-headset fungerar ganska bra men de är faktiskt ganska enkla och stöder inte en viktig funktion av mänskligt syn: dynamiskt fokus. Detta beror på att displayen i XR-headset alltid är på samma avstånd från våra ögon, även när det stereoskopiska djupet antyder något annat. Detta leder till en fråga som kallas vergens-boendekonflikt. Om du vill lära dig lite mer på djupet, kolla in vår primer nedan:

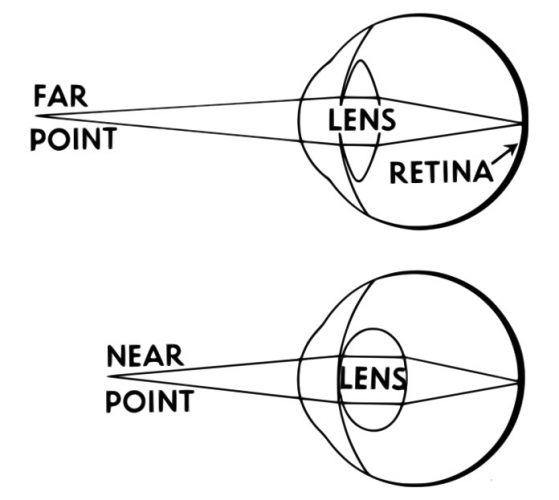

Boende

I den verkliga världen, för att fokusera på ett nära föremål, böjs ögonlinsen för att få ljuset från föremålet att träffa rätt plats på din näthinna, vilket ger dig en skarp bild av föremålet. För ett objekt som är längre bort rör sig ljuset i olika vinklar in i ditt öga och linsen måste återigen böjas för att säkerställa att ljuset fokuseras på din näthinna. Det är därför, om du blundar ett öga och fokuserar på fingret några centimeter från ditt ansikte, är världen bakom ditt finger suddig. Omvänt, om du fokuserar på världen bakom fingret, blir ditt finger suddigt. Detta kallas boende.

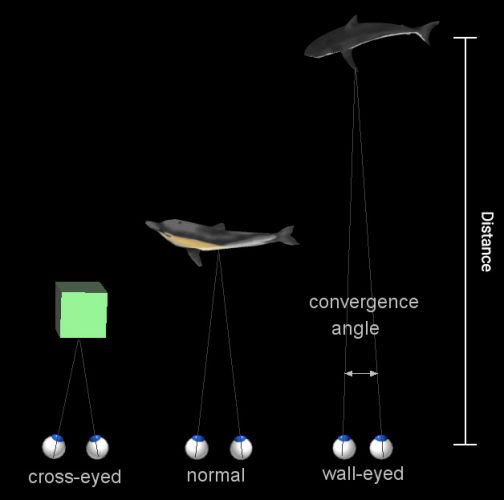

Vergens

Sedan finns det vergens, vilket är när vart och ett av dina ögon roterar inåt för att "konvergera" de separata vyerna från varje öga till en överlappande bild. För mycket avlägsna föremål är dina ögon nästan parallella, eftersom avståndet mellan dem är så litet i jämförelse med föremålets avstånd (vilket innebär att varje öga ser en nästan identisk del av föremålet). För mycket nära föremål måste dina ögon rotera inåt för att få varje ögons perspektiv i linje. Du kan också se detta med vårt lillfingertrick enligt ovan: denna gång, med båda ögonen, håll fingret några centimeter från ansiktet och titta på det. Lägg märke till att du ser dubbla bilder av objekt långt bakom fingret. När du sedan fokuserar på de där föremålen bakom fingret, ser du nu en dubbelfingerbild.

Konflikten

Med tillräckligt exakta instrument kan du använda antingen vergens eller anpassning för att veta hur långt bort ett föremål är som en person tittar på. Men grejen är att både boende och vergens händer i ditt öga tillsammans, automatiskt. Och de inträffar inte bara samtidigt – det finns en direkt korrelation mellan vergens och ackommodation, så att det för varje given mätning av vergens finns en direkt motsvarande nivå av ackommodation (och vice versa). Sedan du var en liten bebis har din hjärna och dina ögon bildat muskelminne för att få dessa två saker att hända tillsammans, utan att tänka, vilken som helsttid du tittar på något.

Men när det kommer till de flesta av dagens AR- och VR-headset, är vergens och boende inte synkroniserade på grund av inneboende begränsningar i den optiska designen.

I ett grundläggande AR- eller VR-headset finns det en skärm (som är, låt oss säga, 3 tum från ditt öga) som visar den virtuella scenen, och en lins som fokuserar ljuset från skärmen på ditt öga (precis som linsen i ditt öga skulle normalt fokusera ljuset från världen på din näthinna). Men eftersom displayen är ett statiskt avstånd från ditt öga, och linsens form är statisk, kommer ljuset från alla objekt som visas på den displayen kommer från samma avstånd. Så även om det finns ett virtuellt berg fem mil bort och en kaffekopp på ett bord fem tum bort, kommer ljuset från båda föremålen in i ögat i samma vinkel (vilket innebär att ditt boende – linsens böjning i ögat – aldrig förändras ).

Det kommer i konflikt med vergensen i sådana headset som – eftersom vi kan visa olika bilder för varje öga –is variabel. Att kunna justera föreställningen oberoende för varje öga, så att våra ögon behöver konvergera mot objekt på olika djup, är i grunden det som ger dagens AR- och VR-headset stereoskopi.

Men den mest realistiska (och utan tvekan, mest bekväma) skärm vi kunde skapa skulle eliminera problemet med gränsöverskridande boende och låta de två fungera i synka, precis som vi är vana vid i den verkliga världen.

Varifokala skärmar – de som dynamiskt kan ändra sitt brännvidd – föreslås som en lösning på detta problem. Det finns ett antal tillvägagångssätt för varifokala skärmar, varav den kanske enklaste är ett optiskt system där skärmen fysiskt flyttas fram och tillbaka från linsen för att ändra bränndjupet i farten.

Att uppnå en sådan aktiverad varifokal display kräver eye-tracking eftersom systemet behöver veta exakt var i scenen användaren tittar. Genom att spåra en väg in i den virtuella scenen från var och en av användarens ögon, kan systemet hitta punkten där dessa vägar korsar varandra, vilket etablerar det korrekta fokalplanet som användaren tittar på. Denna information skickas sedan till displayen för att justera därefter och ställa in brännviddet för att matcha det virtuella avståndet från användarens öga till objektet.

En välimplementerad varifokal skärm kan inte bara eliminera konflikten mellan vergens-boende, utan också tillåta användare att fokusera på virtuella objekt mycket närmare dem än i befintliga headset.

Och långt innan vi sätter in varifokala skärmar i XR-headset, kan eye-tracking användas för simulerat skärpedjup, vilket skulle kunna approximera suddigheten av objekt utanför fokusplanet för användarens ögon.

För närvarande finns det inget större headset på marknaden med varifokala funktioner, men det finns en växande mängd forskning och utveckling försöker ta reda på hur man gör kapaciteten kompakt, pålitlig och prisvärd.

Foveated Displayer

Medan foveated rendering syftar till att bättre fördela renderingskraften mellan den del av vår vision där vi kan se skarpt och vår perifera vision med låga detaljer, kan något liknande uppnås för det faktiska pixelantalet.

Snarare än att bara ändra detaljerna i renderingen på vissa delar av skärmen jämfört med andra, är foveerade skärmar de som fysiskt flyttas (eller i vissa fall "styrs") för att hålla sig framför användarens blick oavsett var de tittar.

Foveated skärmar öppnar dörren för att uppnå mycket högre upplösning i AR- och VR-headset utan att tvinga fram problemet genom att försöka få ihop pixlar med högre upplösning över hela vårt synfält. Att göra det är inte bara kostsamt, utan stöter också på utmanande kraft- och storleksbegränsningar när antalet pixlar närmar sig näthinneupplösning. Istället skulle foveated skärmar flytta en mindre, pixeltät skärm till varthelst användaren tittar baserat på eyetracking-data. Detta tillvägagångssätt kan till och med leda till högre synfält än vad som annars skulle kunna uppnås med en enda platt skärm.

Varjo är ett företag som arbetar med ett foveat displaysystem. De använder en typisk skärm som täcker ett brett synfält (men är inte särskilt pixeltät) och lägger sedan en mikroskärm som är mycket mer pixeltät ovanpå den. Kombinationen av de två innebär att användaren får både ett brett synfält för sin perifera syn och ett område med mycket hög upplösning för sin foveala syn.

Visserligen är den här skärmbilden fortfarande statisk (den högupplösta området förblir i mitten av skärmen) snarare än dynamisk, men företaget har övervägde ett antal metoder för att flytta skärmen för att säkerställa att området med hög upplösning alltid är i centrum för din blick.

Fortsättning på sida 2: Bättre sociala avatarer »

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoAiStream. Web3 Data Intelligence. Kunskap förstärkt. Tillgång här.

- Minting the Future med Adryenn Ashley. Tillgång här.

- Källa: https://www.roadtovr.com/why-eye-tracking-is-a-game-changer-for-vr-headsets-virtual-reality/

- : har

- :är

- :inte

- :var

- $UPP

- 23

- 500

- 7

- 70

- a

- förmåga

- Able

- Om oss

- ovan

- i enlighet med detta

- uppnås

- uppnå

- tvärs

- faktiskt

- Dessutom

- Justering

- avancerat

- prisvärd

- igen

- mot

- Syftet

- Justerat

- uppriktning

- Alla

- tillåter

- tillåter

- längs

- redan

- också

- alltid

- an

- och

- Annan

- vilken som helst

- tillvägagångssätt

- tillvägagångssätt

- AR

- ÄR

- OMRÅDE

- AS

- bistå

- At

- automatiskt

- tillgänglig

- bort

- Bebis

- tillbaka

- baserat

- grundläggande

- BE

- därför att

- blir

- blir

- passande

- varit

- innan

- bakom

- Där vi får lov att vara utan att konstant prestera,

- tro

- nedan

- Bättre

- mellan

- Bortom

- biometriska

- Bit

- kropp

- båda

- Hjärna

- föra

- SLUTRESULTAT

- inbyggd

- men

- by

- Ring

- kallas

- rum

- KAN

- kandidat

- kapacitet

- fall

- Centrum

- vissa

- utmanande

- byta

- Växlare

- Förändringar

- byte

- ta

- Stäng

- Kaffe

- färg

- kombination

- kommer

- bekvämlighet

- bekväm

- kommande

- företag

- jämförelse

- komplex

- Komplexiteten

- beräkningskraft

- konflikt

- begränsningar

- Konsumenten

- innehåll

- sammanhang

- Däremot

- konvergerar

- korrekt

- Korrelation

- Motsvarande

- kunde

- Kurs

- Täcker

- skapa

- Cup

- Kunder

- kundanpassad

- Klipp

- datum

- behandla

- krävande

- demonstreras

- djup

- Djup

- Designa

- detalj

- Detektering

- utvecklare

- Skillnaden

- olika

- svårt

- rikta

- riktning

- direkt

- Visa

- displayer

- avstånd

- distribuera

- gör

- gör

- inte

- Dörr

- dubbla

- ner

- drastiskt

- grund

- dynamisk

- dynamiskt

- varje

- lätt

- lätt

- effektivt

- antingen

- eliminera

- annorstädes

- möjliggöra

- tillräckligt

- säkerställa

- Går in

- Hela

- Miljö

- väsentligen

- upprättandet

- Även

- exempel

- exempel

- spännande

- befintliga

- erfarenhet

- Exploit

- ögat

- Ögon

- Ansikte

- bekant

- långt

- Funktioner

- få

- fält

- Figur

- Slutligen

- hitta

- finger

- Förnamn

- platta

- Fokus

- fokuserade

- fokuserar

- För

- bildad

- vidare

- eftertraktad rendering

- vän

- från

- främre

- fungera

- ytterligare

- lek

- spel-växlare

- ges

- ger

- Ge

- Går

- stor

- Växer

- hända

- händer

- hårdvara

- Har

- huvud

- headset

- headset

- Hög

- högre

- Träffa

- hålla

- Hur ser din drömresa ut

- How To

- HTTPS

- stor

- humant

- i

- identiska

- identifierare

- identifiera

- if

- bild

- bilder

- bild

- genomföras

- med Esport

- omöjligt

- förbättra

- in

- Ökar

- alltmer

- oberoende av

- informationen

- inneboende

- Omedelbart

- istället

- instrument

- tolkning

- in

- fråga

- IT

- jpg

- bara

- Ha kvar

- Vet

- Large

- större

- leda

- Leads

- LÄRA SIG

- linser

- mindre

- Låt

- Nivå

- Bibliotek

- ljus

- tycka om

- gillar

- begränsningar

- liten

- läsa in

- se

- du letar

- UTSEENDE

- Lot

- större

- göra

- GÖR

- många

- många människor

- marknad

- Match

- Materia

- max-bredd

- Maj..

- betyder

- betyder

- Samtidigt

- mäta

- Minne

- metoder

- Mitten

- modell

- Momentum

- mer

- mest

- rörelse

- Berg

- flytta

- rörelse

- förflyttar

- rörliga

- mycket

- multipel

- måste

- namn

- Nära

- nästan

- Behöver

- behövs

- behöver

- behov

- netto

- Nej

- normalt

- Lägga märke till..

- nu

- antal

- objektet

- objekt

- of

- sänkt

- Ofta

- on

- ONE

- endast

- öppet

- optimala

- or

- beställa

- Övrigt

- annat

- vår

- ut

- utanför

- packad

- sida

- Parallell

- del

- reservdelar till din klassiker

- bana

- pearson

- Personer

- prestanda

- kanske

- personen

- perspektiv

- Fysiskt

- GROP

- pixel

- plato

- Platon Data Intelligence

- PlatonData

- Spela

- Punkt

- dålig

- del

- placera

- möjlig

- kraft

- exakt

- exakt

- Precision

- förutsägelse

- preferenser

- pretty

- Pro

- Problem

- process

- bearbetning

- Process kraft

- Profiler

- Framsteg

- rätt

- föreslagen

- Prototypen

- PSVR

- PSVR 2

- sätta

- Puts

- sätta

- kvalitet

- quest

- quest pro

- snabbt

- område

- snarare

- Läsa

- verklig

- verkliga världen

- realistisk

- Anledningen

- senaste

- minska

- Hälsningar

- region

- pålitlig

- rendering

- Obligatorisk

- Krav

- Kräver

- forskning

- liknar

- Upplösning

- löst

- lösa

- Resurser

- REST

- Retina

- väg

- Vägen till VR

- Samma

- sparande

- säga

- scen

- scener

- se

- se

- verkar

- ser

- separat

- inställning

- inställningar

- Forma

- Dela

- skarp

- show

- visas

- Visar

- liknande

- Enkelt

- eftersom

- enda

- Storlek

- Small

- mindre

- So

- Social hållbarhet

- Mjukvara

- lösning

- några

- något

- ljud

- Spot

- spotting

- standard

- står

- starta

- bo

- Fortfarande

- sådana

- Föreslår

- stödja

- Som stöds

- system

- System

- bord

- tech

- Teknologi

- än

- den där

- Smakämnen

- världen

- deras

- Dem

- sedan

- Dessa

- de

- sak

- saker

- tror

- Tänkande

- detta

- de

- fastän?

- tid

- gånger

- till

- dagens

- tillsammans

- alltför

- topp

- spåra

- Traveling

- två

- typisk

- Förstående

- tyvärr

- unika

- us

- användning

- Begagnade

- Användare

- användare

- med hjälp av

- varjo

- version

- mycket

- utsikt

- visningar

- Virtuell

- synlig

- syn

- liv

- vr

- VR headset

- VR-headset

- vs

- vill

- we

- VÄL

- były

- Vad

- när

- som

- medan

- varför

- bred

- Brett utbud

- med

- inom

- utan

- ord

- ord

- Arbete

- arbetssätt

- världen

- skulle

- XR

- XR-headset

- år

- Om er

- Din

- själv

- zephyrnet