Datavetare hävdar att de har kommit på ett sätt att omintetgöra maskininlärningssystems försök att digitalt manipulera bilder och skapa deepfakes.

Nuförtiden kan du inte bara skapa bilder från grunden med hjälp av AI-modeller – ge dem bara en skriftlig beskrivning, så kommer de att ta fram motsvarande bilder – du kan också manipulera befintliga bilder med samma teknik. Du kan ge dessa tränade system en bild och beskriva hur du vill att det ska ändras, eller använda ett grafiskt användargränssnitt för att styra dem, och de går.

Det skapar potentialen för en skrämmande framtid där sociala medier översvämmas av automatiserad massdesinformation, eller människor utpressas över snaps vridna av maskiner. Om ingen kan skilja förfalskningarna från den äkta varan kan de vara lika skadliga.

Ett sätt att förhindra det är att vattenmärka eller digitalt signera bilder och annat innehåll så att manipulationer kan upptäckas. En annan väg – föreslagen av hjärnorna på MIT – är att konstruera snaps så att AI-modeller inte kan ändra dem alls i första hand.

"Tänk på möjligheten av bedräglig spridning av falska katastrofhändelser, som en explosion vid ett betydande landmärke," sade Hadi Salman, en doktorand vid universitetets avdelning för elektroteknik och datavetenskap som arbetade med detta projekt.

"Detta bedrägeri kan manipulera marknadstrender och allmänhetens sentiment, men riskerna är inte begränsade till den offentliga sfären. Personliga bilder kan olämpligt ändras och användas för utpressning, vilket resulterar i betydande ekonomiska konsekvenser när de utförs i stor skala.”

Salman kan mycket väl ha rätt. Deepfakes har redan använts för att sprida desinformation, eller lura och trakassera nätanvändare, och AI-tillverkade bilder har blivit allt mer realistiska. När tekniken förbättras i framtiden kommer människor att kunna skapa videor med realistiskt falskt ljud också, varnade han.

Det var därför Salman och hans kollegor bestämde sig för att utveckla programvara för maskininlärning, dubbad PhotoGuard, för att förhindra missbrukare från att missbruka dessa verktyg för att manipulera innehåll.

Bilder bearbetas i princip av ML-modeller som arrayer av nummer. PhotoGuard justerar dessa arrayer för att hindra andra maskininlärningsmodeller från att korrekt uppfatta ingångsbilden – så att bilden i slutändan inte kan manipuleras. Pixlarna lämnas orörda för människor, så den skyddade bilden ser likadan ut för det mänskliga ögat – men inte för en dator.

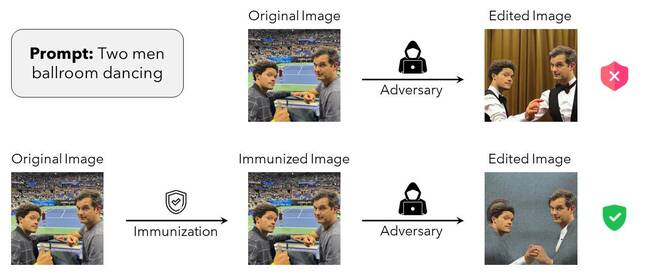

I exemplet som visas nedan visar ett foto USA:s TV-lustiga Trevor Noah och Michael Kosta vid US Open. Det ursprungliga – oskyddade – fotot kan manipuleras av en textdriven spridningsmodell för att få dem att synas i en helt annan miljö: i en balsal som dansar tillsammans. Men med PhotoGuard-ändringarna tillämpade, kastas diffusionsmodellen bort av de osynliga störningarna och kan inte helt förändra bilden.

Bild från MIT PhotoGuard-tidningen som beskriver hur denna immunisering av data från manipulation i princip fungerar – Klicka för att förstora

"I den här attacken stör vi ingångsbilden så att den slutliga bilden som genereras av den [stora diffusionsmodellen] är en specifik målbild (t.ex. slumpmässigt brus eller grå bild)", skrev akademikerna i sin icke-peer-reviewed papper som beskriver PhotoGuard, släppt på ArXiv.

Strängt taget kallas det tillvägagångssättet som en diffusionsattack av MIT-teamet. Dess mål är att förvirra den bildmanipulerande AI:n och få den att effektivt ignorera vilken textuppmaning den än har fått.

Det finns en andra, enklare teknik som kallas en kodarattack, som försöker få den manipulerande AI:n att uppfatta ett foto som något annat – till exempel en grå fyrkant – som omintetgör dess automatiska redigering. Resultatet är mer eller mindre detsamma, oavsett hur: försök att använda AI för att manipulera bilderna går av stapeln.

"När vi tillämpar kodarattacken är vårt mål att kartlägga representationen av originalbilden till representationen av en målbild (grå bild)," skrev teamet i sin tidning. "Vår (mer komplexa) diffusionsattack, å andra sidan, syftar till att bryta diffusionsprocessen genom att manipulera hela processen för att generera en bild som liknar en given målbild (grå bild)."

De utförde sina experiment mot Stability AI:s Stable Diffusion Model v1.5, och noterade att även om PhotoGuard kan skydda bilder från att digitalt förändras av AI, är det svårt att tillämpa praktiskt. Dels kräver diffusionsattacken avsevärd GPU-kapacitet – så om du inte har den typen av kisel till hands har du ingen tur.

Egentligen borde ansvaret ligga på de organisationer som utvecklar dessa AI-verktyg snarare än individer som försöker skydda sina bilder, hävdar forskarna.

"Ett samarbetssätt som involverar modellutvecklare, sociala medieplattformar och beslutsfattare utgör ett robust försvar mot otillåten bildmanipulation. Att arbeta med denna brådskande fråga är av yttersta vikt idag”, hävdade Salman.

"Och även om jag är glad att kunna bidra till den här lösningen, krävs mycket arbete för att göra detta skydd praktiskt. Företag som utvecklar dessa modeller måste investera i att utveckla robusta immuniseringar mot de möjliga hoten från dessa AI-verktyg. När vi går in i denna nya era av generativa modeller, låt oss sträva efter potential och skydd i lika mått.”

PhotoGuard är inte en perfekt lösning. Om en bild är tillgänglig för vem som helst att ladda ner utan att något skydd tillämpas på den, kan en skurk ta tag i den oskyddade versionen av fotot, redigera den med AI och distribuera den. Dessutom kan beskärning, rotation eller tillämpning av vissa filter bryta PhotoGuards störningar.

MIT-organen sa att de arbetar för att försöka göra sin programvara med öppen källkod (MIT-licensierad, natch) mer robust mot sådana ändringar.

Registret har bett Salman om ytterligare kommentarer. ®

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Fordon / elbilar, Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- BlockOffsets. Modernisera miljökompensation ägande. Tillgång här.

- Källa: https://go.theregister.com/feed/www.theregister.com/2023/08/01/photoguard_deepfake_ai/

- : har

- :är

- :inte

- $UPP

- 7

- a

- Able

- akademiker

- mot

- AI

- AI-modeller

- Syftet

- Alla

- redan

- också

- förändringar

- förändrad

- Även

- am

- an

- och

- Annan

- vilken som helst

- någon

- visas

- tillämpas

- Ansök

- Tillämpa

- tillvägagångssätt

- ÄR

- argued

- AS

- At

- attackera

- Försök

- audio

- Automatiserad

- tillgänglig

- I grund och botten

- BE

- blir

- varit

- Där vi får lov att vara utan att konstant prestera,

- nedan

- Blackmail

- Ha sönder

- men

- by

- kallas

- KAN

- kan inte

- Kapacitet

- genom

- katastrofal

- patentkrav

- klick

- CO

- samarbete

- kollegor

- komma

- kommentar

- Företag

- fullständigt

- komplex

- dator

- Datavetenskap

- aktuella

- Tänk

- betydande

- innehåll

- bidra

- Motsvarande

- kunde

- skapa

- skapar

- skada

- Dans

- datum

- Dagar

- beslutade

- deepfakes

- Försvar

- Avdelning

- beskriva

- beskrivning

- utveckla

- utvecklare

- utveckla

- olika

- svårt

- Diffusion

- digitalt

- rikta

- desinformation

- distribuera

- donation

- ladda ner

- dubbade

- effektivt

- antingen

- annars

- ingenjör

- Teknik

- lika

- Era

- händelser

- exempel

- exekveras

- befintliga

- experiment

- Explosionen

- ögat

- fejka

- falsk

- långt

- Figur

- filter

- slutlig

- finansiella

- Förnamn

- översvämmade

- För

- bedräglig

- från

- fullständigt

- ytterligare

- framtida

- generera

- genereras

- generativ

- Ge

- ges

- Go

- Målet

- GPU

- ta

- uppgradera

- grå

- sidan

- Har

- he

- hans

- Hur ser din drömresa ut

- Men

- HTTPS

- humant

- i

- if

- bild

- bilder

- implikationer

- vikt

- in

- alltmer

- individer

- ingång

- in

- Invest

- involverar

- isn

- fråga

- IT

- DESS

- jpg

- bara

- Snäll

- landmärke

- Large

- inlärning

- vänster

- mindre

- Låt

- Licensierade

- lie

- tycka om

- Begränsad

- ll

- UTSEENDE

- tur

- Maskinen

- maskininlärning

- Maskiner

- göra

- manipuleras

- manipulerings

- Manipulation

- karta

- marknad

- Marknadstrender

- Massa

- Maj..

- åtgärder

- Media

- Michael

- desinformation

- MIT

- ML

- modell

- modeller

- modifieringar

- mer

- mycket

- Behöver

- behövs

- Nya

- Noah

- Brus

- noterade

- nummer

- of

- sänkt

- Erbjudanden

- on

- ONE

- endast

- öppet

- öppen källkod

- or

- beställa

- organisationer

- ursprungliga

- Övriga

- vår

- ut

- över

- Papper

- Yttersta

- bana

- Personer

- perfekt

- personlig

- bild

- Bild

- Plats

- Plattformar

- plato

- Platon Data Intelligence

- PlatonData

- beslutsfattare

- Möjligheten

- möjlig

- potentiell

- Praktisk

- praktiskt taget

- presenterar

- trycka

- förhindra

- process

- Bearbetad

- projektet

- föreslagen

- skydda

- skyddad

- skydd

- allmän

- rails

- slumpmässig

- snarare

- RE

- verklig

- realistisk

- avses

- frigörs

- representation

- Kräver

- forskare

- Liknar

- ansvaret

- resultera

- resulterande

- höger

- risker

- robusta

- s

- Nämnda

- Samma

- Skala

- Vetenskap

- vetenskapsmän

- repa

- Andra

- känsla

- inställning

- skall

- visas

- Visar

- signera

- signifikant

- Kisel

- enklare

- So

- Social hållbarhet

- sociala medier

- sociala medierna

- Mjukvara

- lösning

- några

- något

- Källa

- tala

- specifik

- spridning

- kvadrat

- Stabilitet

- stabil

- strävar

- student

- sådana

- System

- Målet

- grupp

- Teknologi

- tala

- än

- den där

- Smakämnen

- Framtiden

- deras

- Dem

- Dessa

- de

- sak

- detta

- hot

- omintetgöra

- till

- i dag

- tillsammans

- alltför

- verktyg

- mot

- tränad

- Trender

- Trevor

- prova

- tv

- Ytterst

- universitet

- us

- användning

- Begagnade

- med hjälp av

- v1

- Ve

- version

- Video

- vill

- var

- vattenmärke

- Sätt..

- we

- VÄL

- oberoende

- när

- som

- medan

- VEM

- Hela

- varför

- kommer

- med

- utan

- Arbete

- arbetade

- arbetssätt

- fungerar

- skriven

- skrev

- Om er

- zephyrnet