การเติบโตของ AI กำเนิดนั้นมีขอบเขตของการคำนวณ มีคุณสมบัติเฉพาะที่การเพิ่มการประมวลผลโดยตรงส่งผลให้ผลิตภัณฑ์ดีขึ้น โดยปกติแล้ว การลงทุนด้าน R&D จะเชื่อมโยงโดยตรงกับคุณค่าของผลิตภัณฑ์มากกว่า และความสัมพันธ์ดังกล่าวจะเป็นแบบเส้นตรงอย่างชัดเจน แต่ในปัจจุบันปัญญาประดิษฐ์ไม่เป็นเช่นนั้น ด้วยเหตุนี้ ปัจจัยหลักที่ขับเคลื่อนอุตสาหกรรมในปัจจุบันจึงเป็นเพียงต้นทุนของการฝึกอบรมและการอนุมานเท่านั้น

แม้ว่าเราจะไม่ทราบตัวเลขที่แท้จริง แต่เราได้ยินจากแหล่งข่าวที่มีชื่อเสียงว่าอุปทานของการประมวลผลมีจำกัดมาก อุปสงค์มีมากกว่า 10 เท่า (!) ดังนั้นเราจึงคิดว่ามันยุติธรรมที่จะพูดว่า ในตอนนี้ การเข้าถึงทรัพยากรการประมวลผลด้วยต้นทุนรวมที่ต่ำที่สุด กลายเป็นปัจจัยกำหนดความสำเร็จของบริษัท AI.

ในความเป็นจริง เราได้เห็นหลายบริษัทใช้จ่ายมากกว่า 80% ของทุนทั้งหมดของพวกเขาในทรัพยากรการประมวลผล!

ในโพสต์นี้ เราพยายามแจกแจงปัจจัยด้านต้นทุนสำหรับบริษัท AI แน่นอนว่าจำนวนสัมบูรณ์จะเปลี่ยนแปลงไปตามกาลเวลา แต่เราไม่เห็นความโล่งใจในทันทีที่บริษัท AI ถูกผูกมัดด้วยการเข้าถึงทรัพยากรการประมวลผล หวังว่านี่จะเป็นกรอบที่เป็นประโยชน์สำหรับการคิดผ่านภูมิทัศน์

เหตุใดแบบจำลอง AI จึงมีราคาแพงในการคำนวณ

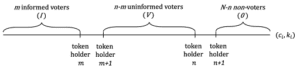

มีโมเดล AI เชิงกำเนิดที่หลากหลาย และการอนุมานและค่าใช้จ่ายในการฝึกอบรมขึ้นอยู่กับขนาดและประเภทของโมเดล โชคดีที่โมเดลที่ได้รับความนิยมสูงสุดในปัจจุบันส่วนใหญ่เป็นสถาปัตยกรรมแบบ Transformer ซึ่งรวมถึงโมเดลภาษาขนาดใหญ่ (LLM) ยอดนิยม เช่น GPT-3, GPT-J หรือ BERT ในขณะที่จำนวนการดำเนินการที่แน่นอนสำหรับการอนุมานและการเรียนรู้ของหม้อแปลงเป็นแบบเฉพาะ (ดู กระดาษนี้) มีกฎง่ายๆ ที่ค่อนข้างแม่นยำซึ่งขึ้นอยู่กับจำนวนของพารามิเตอร์ (เช่น น้ำหนักของโครงข่ายประสาทเทียม) ของโมเดลและจำนวนของโทเค็นอินพุตและเอาต์พุตเท่านั้น

โทเค็นเป็นลำดับสั้น ๆ ของอักขระสองสามตัว สอดคล้องกับคำหรือบางส่วนของคำ วิธีที่ดีที่สุดในการรับโทเค็นโดยสัญชาตญาณคือลองใช้โทเค็นกับโทเค็นออนไลน์ที่เผยแพร่ต่อสาธารณะ (เช่น OpenAI). สำหรับ GPT-3 ความยาวเฉลี่ยของโทเค็น เป็น 4 ตัว.

กฎง่ายๆ สำหรับทรานส์ฟอร์มเมอร์คือการส่งต่อ (เช่น การอนุมาน) สำหรับโมเดลที่มี p พารามิเตอร์สำหรับอินพุตและเอาต์พุตตามลำดับความยาว n สัญญาณ แต่ละ, ใช้เวลาประมาณ 2 * น * หน้า การดำเนินการจุดลอยตัว (ฟล็อปส์)¹. การฝึกรุ่นเดียวกันใช้เวลาประมาณ 6 * หน้า FLOPS ต่อโทเค็น (เช่น การย้อนกลับเพิ่มเติมต้องใช้การดำเนินการเพิ่มเติมสี่ครั้ง²). คุณสามารถประมาณต้นทุนการฝึกอบรมทั้งหมดได้โดยคูณด้วยจำนวนโทเค็นในข้อมูลการฝึกอบรม

ข้อกำหนดหน่วยความจำสำหรับหม้อแปลงยังขึ้นอยู่กับขนาดของรุ่นด้วย สำหรับการอนุมาน เราต้องการ p พารามิเตอร์แบบจำลองเพื่อให้พอดีกับหน่วยความจำ สำหรับการเรียนรู้ (เช่น การเผยแพร่ย้อนกลับ) เราจำเป็นต้องเก็บค่ากลางเพิ่มเติมต่อพารามิเตอร์ระหว่างการส่งไปข้างหน้าและย้อนกลับ สมมติว่าเราใช้เลขทศนิยมแบบ 32 บิต ซึ่งก็คือเพิ่มอีก 8 ไบต์ต่อพารามิเตอร์ สำหรับการฝึกโมเดลที่มีพารามิเตอร์ 175 พันล้านพารามิเตอร์ เราจำเป็นต้องเก็บข้อมูลมากกว่าหนึ่งเทราไบต์ไว้ในหน่วยความจำ ซึ่งมากกว่า GPU ใดๆ ที่มีอยู่ในปัจจุบัน และทำให้เราต้องแบ่งโมเดลออกเป็นการ์ดต่างๆ ความต้องการหน่วยความจำสำหรับการอนุมานและการฝึกอบรมสามารถปรับให้เหมาะสมได้โดยใช้ค่าทศนิยมของความยาวที่สั้นกว่า โดย 16 บิตจะกลายเป็นแบบทั่วไปและ 8 บิตที่คาดว่าจะเกิดขึ้นในอนาคตอันใกล้

ตารางด้านบนมีขนาดและค่าใช้จ่ายในการคำนวณสำหรับรุ่นยอดนิยมหลายรุ่น GPT-3 มีพารามิเตอร์ประมาณ 175 พันล้านพารามิเตอร์ ซึ่งสำหรับอินพุตและเอาต์พุตของโทเค็น 1,024 รายการ ส่งผลให้ต้นทุนการคำนวณของการดำเนินการทศนิยมประมาณ 350 ล้านล้านรายการ (เช่น Teraflops หรือ TFLOPS) การฝึกโมเดลเช่น GPT-3 ใช้การดำเนินการทศนิยมประมาณ 3.14*10^23 โมเดลอื่นๆ เช่น LLaMA ของ Meta มี ยิ่งสูงขึ้นไป ข้อกำหนดการคำนวณ การฝึกอบรมแบบจำลองดังกล่าวเป็นหนึ่งในภารกิจที่ต้องใช้การคำนวณมากยิ่งกว่าที่มนุษย์ได้ดำเนินการมาจนถึงตอนนี้

สรุป: โครงสร้างพื้นฐาน AI มีราคาแพงเนื่องจากปัญหาอัลกอริทึมพื้นฐานนั้นยากต่อการคำนวณอย่างมาก ความซับซ้อนของอัลกอริทึมของการจัดเรียงตารางฐานข้อมูลที่มีหนึ่งล้านรายการนั้นไม่มีนัยสำคัญเมื่อเทียบกับความซับซ้อนของการสร้างคำเดียวด้วย GPT-3 ซึ่งหมายความว่าคุณต้องการเลือกรุ่นที่เล็กที่สุดที่ตอบโจทย์กรณีการใช้งานของคุณ

ข่าวดีก็คือสำหรับ Transformers เราสามารถประเมินได้อย่างง่ายดายว่าโมเดลในขนาดใดขนาดหนึ่งจะใช้การประมวลผลและหน่วยความจำเท่าใด ดังนั้น การเลือกฮาร์ดแวร์ที่เหมาะสมจึงกลายเป็นข้อพิจารณาถัดไป

อาร์กิวเมนต์เวลาและต้นทุนสำหรับ GPU

ความซับซ้อนในการคำนวณแปลตามเวลาอย่างไร โดยทั่วไป แกนประมวลผลสามารถดำเนินการได้ 1-2 คำสั่งต่อรอบ และอัตราสัญญาณนาฬิกาของโปรเซสเซอร์คงที่ประมาณ 3 GHz ในช่วง 15 ปีที่ผ่านมาเนื่องจากการสิ้นสุดของ เดนนาร์ดสเกลลิ่ง. การดำเนินการอนุมาน GPT-3 เพียงครั้งเดียวโดยไม่ใช้ประโยชน์จากสถาปัตยกรรมแบบขนานใดๆ จะใช้เวลา 350 TFLOPS/(3 GHz*1 FLOP) หรือ 116,000 วินาที หรือ 32 ชั่วโมง สิ่งนี้ไม่สามารถทำได้จริง เราต้องการชิปพิเศษที่ช่วยเร่งงานนี้แทน

ในทางปฏิบัติ ปัจจุบัน AI ทุกรุ่นทำงานบนการ์ดที่ใช้แกนเฉพาะจำนวนมาก ตัวอย่างเช่น NVIDIA A100 GPU มี 512 “แกนเทนเซอร์” ที่สามารถทำการคูณเมทริกซ์ 4×4 (ซึ่งเทียบเท่ากับการคูณและการบวก 64 ครั้ง หรือ 128 FLOPS) ในรอบเดียว การ์ดเร่งความเร็ว AI มักถูกเรียกว่า GPU (หน่วยประมวลผลกราฟิก) เนื่องจากเดิมทีสถาปัตยกรรมได้รับการพัฒนาสำหรับเกมเดสก์ท็อป ในอนาคต เราคาดว่า AI จะกลายเป็นกลุ่มผลิตภัณฑ์ที่แตกต่างออกไปมากขึ้นเรื่อยๆ

A100 มีประสิทธิภาพเล็กน้อย 312 TFLOPS ซึ่งในทางทฤษฎีจะลดการอนุมานของ GPT-3 ให้เหลือประมาณ 1 วินาที อย่างไรก็ตาม นี่เป็นการคำนวณที่ง่ายเกินไปด้วยเหตุผลหลายประการ ประการแรก สำหรับกรณีการใช้งานส่วนใหญ่ ปัญหาคอขวดไม่ใช่พลังการประมวลผลของ GPU แต่เป็นความสามารถในการรับข้อมูลจากหน่วยความจำกราฟิกพิเศษไปยังแกนเทนเซอร์ ประการที่สอง น้ำหนัก 175 พันล้านก้อนจะใช้พื้นที่ถึง 700GB และจะไม่พอดีกับหน่วยความจำกราฟิกของ GPU ใดๆ จำเป็นต้องใช้เทคนิคต่างๆ เช่น การแบ่งพาร์ติชันและการสตรีมน้ำหนัก และประการที่สาม มีการเพิ่มประสิทธิภาพจำนวนหนึ่ง (เช่น การใช้การแสดงทศนิยมที่สั้นกว่า เช่น FP16, FP8 หรือเมทริกซ์แบบกระจาย) ที่ใช้เพื่อเร่งการคำนวณ แต่โดยรวมแล้ว คณิตศาสตร์ข้างต้นทำให้เราเข้าใจถึงต้นทุนการคำนวณโดยรวมของ LLM ในปัจจุบัน

การฝึกอบรมโมเดลหม้อแปลงใช้เวลาประมาณสามเท่าต่อโทเค็นในการอนุมาน อย่างไรก็ตาม เนื่องจากชุดข้อมูลการฝึกมีขนาดใหญ่กว่าการอนุมานประมาณ 300 ล้านเท่า การฝึกจึงใช้เวลานานขึ้นถึง 1 พันล้านเท่าตัว สำหรับ GPU ตัวเดียว การฝึกอบรมอาจใช้เวลาหลายทศวรรษ ในทางปฏิบัติ วิธีนี้ทำได้บนคลัสเตอร์การประมวลผลขนาดใหญ่ในศูนย์ข้อมูลเฉพาะหรือในระบบคลาวด์ การฝึกอบรมยังทำให้ขนานกันได้ยากกว่าการอนุมาน เนื่องจากต้องมีการเปลี่ยนน้ำหนักที่อัปเดตระหว่างโหนดต่างๆ หน่วยความจำและแบนด์วิธระหว่าง GPU มักจะกลายเป็นปัจจัยที่สำคัญกว่ามาก เนื่องจากการเชื่อมต่อระหว่างกันความเร็วสูงและแฟบริคเฉพาะนั้นเป็นเรื่องปกติ สำหรับการฝึกอบรมโมเดลที่มีขนาดใหญ่มาก การสร้างการตั้งค่าเครือข่ายที่เหมาะสมอาจเป็นความท้าทายหลัก เมื่อมองไปในอนาคต ตัวเร่งความเร็ว AI จะมีความสามารถด้านเครือข่ายบนการ์ดหรือแม้แต่บนชิป

ความซับซ้อนในการคำนวณนี้แปลงเป็นต้นทุนได้อย่างไร การอนุมาน GPT-3 ซึ่งตามที่เราเห็นข้างต้น ใช้เวลาประมาณ 1 วินาทีบน A100 จะมีต้นทุนการประมวลผลดิบระหว่าง 0.0002 ถึง 0.0014 ดอลลาร์สำหรับ 1,000 โทเค็น (ซึ่งเปรียบเทียบกับราคาของ OpenAI ที่ 0.002 ดอลลาร์/1000 โทเค็น) ผู้ใช้ที่สร้างคำขอการอนุมาน 100 รายการต่อวันจะมีค่าใช้จ่ายตามลำดับเป็นดอลลาร์ต่อปี นี่เป็นราคาที่ต่ำมากและทำให้กรณีการใช้งานส่วนใหญ่ของ AI แบบข้อความโดยมนุษย์มีศักยภาพทางการเงิน

การฝึกอบรม ในทางกลับกัน GPT-3 มีราคาแพงกว่ามาก อีกครั้ง การคำนวณเฉพาะต้นทุนการประมวลผลสำหรับ 3.14*10^23 FLOPS ตามอัตราข้างต้น ทำให้เรามีค่าประมาณ 560,000 ดอลลาร์สำหรับการ์ด A100 สำหรับ การฝึกวิ่งเดี่ยว. ในทางปฏิบัติสำหรับการฝึกอบรมเราจะไม่ได้รับประสิทธิภาพเกือบ 100% ใน GPU แต่เราสามารถใช้การปรับให้เหมาะสมเพื่อลดเวลาการฝึกอบรม ค่าประมาณอื่นๆ ของค่าฝึกอบรม GPT-3 มีตั้งแต่ $500,000 ไปยัง 4.6 $ ล้าน ขึ้นอยู่กับสมมติฐานของฮาร์ดแวร์ โปรดทราบว่านี่เป็นต้นทุนของการดำเนินการครั้งเดียว ไม่ใช่ต้นทุนโดยรวม อาจต้องมีการเรียกใช้หลายครั้งและผู้ให้บริการคลาวด์ต้องการข้อผูกมัดระยะยาว (เพิ่มเติมเกี่ยวกับสิ่งนี้ด้านล่าง) การฝึกอบรมโมเดลระดับแนวหน้ายังคงมีราคาแพง แต่ก็อยู่ไม่ไกลเกินเอื้อมสำหรับสตาร์ทอัพที่มีเงินทุนเพียงพอ

โดยสรุป วันนี้ AI เชิงกำเนิดต้องการการลงทุนจำนวนมากในโครงสร้างพื้นฐาน AI ไม่มีเหตุผลที่จะเชื่อว่าสิ่งนี้จะเปลี่ยนแปลงในอนาคตอันใกล้ การฝึกอบรมแบบจำลองเช่น GPT-3 เป็นหนึ่งในงานที่ต้องใช้การคำนวณมากที่สุดเท่าที่มนุษย์เคยดำเนินการมา และในขณะที่ GPU เร็วขึ้น และเราหาวิธีเพิ่มประสิทธิภาพการฝึกอบรม การขยายตัวอย่างรวดเร็วของ AI จะลบล้างผลกระทบทั้งสองนี้

ข้อควรพิจารณาสำหรับโครงสร้างพื้นฐาน AI

ณ จุดนี้ เราได้พยายามให้สัญชาตญาณแก่คุณเกี่ยวกับสเกลที่จำเป็นในการฝึกอบรมและการอนุมานของโมเดล AI และพารามิเตอร์พื้นฐานที่ขับเคลื่อนโมเดลเหล่านี้ ด้วยบริบทนั้น ตอนนี้เราต้องการให้คำแนะนำเชิงปฏิบัติเกี่ยวกับวิธีตัดสินใจว่าจะใช้โครงสร้างพื้นฐาน AI ใด

โครงสร้างพื้นฐานภายนอกกับภายในองค์กร

ลองมาดูกัน: GPU นั้นยอดเยี่ยม วิศวกรและผู้ก่อตั้งที่มีแนวคิดด้านวิศวกรรมหลายคนมีอคติต่อการจัดหาฮาร์ดแวร์ AI ของตนเอง ไม่เพียงเพราะมันให้การควบคุมแบบละเอียดสำหรับการฝึกโมเดล แต่เพราะมีเรื่องสนุกเกี่ยวกับการควบคุมพลังการประมวลผลจำนวนมาก (จัดแสดงนิทรรศการ).

แต่ความจริงก็คือ สตาร์ทอัพจำนวนมาก โดยเฉพาะบริษัทแอพ ไม่จำเป็นต้องสร้างโครงสร้างพื้นฐาน AI ของตนเอง ในวันที่ 1 แทน บริการโมเดลที่โฮสต์เช่น OpenAI หรือ Hugging Face (สำหรับภาษา) และ Replicate (สำหรับการสร้างรูปภาพ) ช่วยให้ผู้ก่อตั้งสามารถค้นหาผลิตภัณฑ์ที่เหมาะสมกับตลาดได้อย่างรวดเร็วโดยไม่จำเป็นต้องจัดการโครงสร้างพื้นฐานหรือโมเดลพื้นฐาน

บริการเหล่านี้ดีมากจนหลายบริษัทไม่เลิกใช้ นักพัฒนาสามารถควบคุมประสิทธิภาพของโมเดลได้อย่างมีนัยสำคัญผ่านวิศวกรรมที่รวดเร็วและนามธรรมการปรับแต่งขั้นสูง (เช่น การปรับแต่งอย่างละเอียดผ่านการเรียก API) ราคาสำหรับบริการเหล่านี้อิงตามปริมาณการใช้ ดังนั้นจึงมักจะถูกกว่าการใช้โครงสร้างพื้นฐานแยกต่างหาก เราเคยเห็นบริษัทแอปสร้าง ARR มากกว่า 50 ล้านดอลลาร์ และมีมูลค่ามากกว่า 1 พันล้านดอลลาร์ ซึ่งให้บริการโมเดลโฮสต์ภายใต้ประทุน

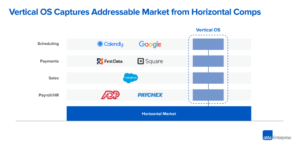

ในทางกลับกัน สตาร์ทอัพบางรายโดยเฉพาะ ผู้ที่ฝึกโมเดลพื้นฐานใหม่หรือสร้างแอปพลิเคชัน AI ที่ผสานรวมในแนวตั้ง ไม่สามารถหลีกเลี่ยงการเรียกใช้โมเดลของตนเองโดยตรงได้ บน GPU อาจเป็นเพราะโมเดลเป็นผลิตภัณฑ์ที่มีประสิทธิภาพ และทีมกำลังค้นหา "โมเดลที่เหมาะกับตลาด" หรือเพราะต้องมีการควบคุมแบบละเอียดในการฝึกอบรมและ/หรือการอนุมานเพื่อให้ได้ความสามารถบางอย่างหรือลดต้นทุนส่วนเพิ่มในระดับมาก ไม่ว่าจะด้วยวิธีใด การจัดการโครงสร้างพื้นฐานจะกลายเป็นแหล่งที่มาของความได้เปรียบในการแข่งขัน

ระบบคลาวด์เทียบกับศูนย์ข้อมูลสร้างขึ้น

ในกรณีส่วนใหญ่ ระบบคลาวด์คือสถานที่ที่เหมาะสมสำหรับโครงสร้างพื้นฐานด้าน AI ของคุณ ค่าใช้จ่ายล่วงหน้าที่น้อยลง ความสามารถในการขยายขนาดขึ้นและลง ความพร้อมใช้งานในระดับภูมิภาค และสิ่งที่ทำให้ไขว้เขวน้อยลงจากการสร้างศูนย์ข้อมูลของคุณเองเป็นสิ่งที่น่าสนใจสำหรับสตาร์ทอัพส่วนใหญ่และบริษัทขนาดใหญ่

แต่มีข้อยกเว้นบางประการสำหรับกฎนี้:

- หากคุณกำลังดำเนินการในระดับที่ใหญ่มาก การเรียกใช้ศูนย์ข้อมูลของคุณเองอาจคุ้มค่ากว่า ราคาที่แน่นอนจะแตกต่างกันไปตามที่ตั้งทางภูมิศาสตร์และการตั้งค่า แต่โดยทั่วไปแล้วจะต้องใช้โครงสร้างพื้นฐานมากกว่า 50 ล้านเหรียญต่อปี

- คุณต้องมีฮาร์ดแวร์เฉพาะที่คุณไม่สามารถหาได้จากผู้ให้บริการระบบคลาวด์ ตัวอย่างเช่น ประเภทของ GPU ที่ไม่สามารถใช้ได้อย่างกว้างขวาง เช่นเดียวกับข้อกำหนดหน่วยความจำ พื้นที่เก็บข้อมูล หรือเครือข่ายที่ผิดปกติ

- คุณไม่สามารถหาคลาวด์ที่ยอมรับได้สำหรับการพิจารณาทางภูมิรัฐศาสตร์

หากคุณต้องการสร้างศูนย์ข้อมูลของคุณเอง มีการวิเคราะห์ราคา/ประสิทธิภาพที่ครอบคลุมของ GPU สำหรับการตั้งค่าของคุณเอง (เช่น บทวิเคราะห์ของทิม เด็ตต์เมอร์). นอกจากราคาและประสิทธิภาพของตัวการ์ดแล้ว การเลือกฮาร์ดแวร์ยังขึ้นอยู่กับพลังงาน พื้นที่ และการระบายความร้อนด้วย ตัวอย่างเช่น การ์ด RTX 3080 Ti สองการ์ดรวมกันมีความสามารถในการประมวลผลดิบใกล้เคียงกับ A100 แต่การใช้พลังงานตามลำดับคือ 700W เทียบกับ 300W ความแตกต่างของพลังงาน 3,500 kWh ที่อัตราตลาด 0.10 ดอลลาร์/กิโลวัตต์ชั่วโมงตลอดอายุการใช้งาน 3080 ปีทำให้ต้นทุนของ RTX2 Ti สูงขึ้นเกือบ 1,000 เท่า (ประมาณ XNUMX ดอลลาร์)

ทั้งหมดนี้เราคาดว่าสตาร์ทอัพส่วนใหญ่จะใช้คลาวด์คอมพิวติ้ง

เปรียบเทียบผู้ให้บริการคลาวด์

Amazon Web Services (AWS), Microsoft Azure และ Google Cloud Platform (GCP) ต่างก็นำเสนออินสแตนซ์ GPU แต่ดูเหมือนว่าผู้ให้บริการรายใหม่จะมุ่งเน้นไปที่ปริมาณงาน AI โดยเฉพาะ ต่อไปนี้เป็นกรอบการทำงานที่เราเห็นว่าผู้ก่อตั้งจำนวนมากใช้เพื่อเลือกผู้ให้บริการระบบคลาวด์:

ราคา: ตารางด้านล่างแสดงราคาสำหรับคลาวด์พิเศษหลักและขนาดเล็กจำนวนหนึ่ง ณ วันที่ 7 เมษายน 2023 ข้อมูลนี้เป็นเพียงตัวบ่งชี้ เนื่องจากอินสแตนซ์แตกต่างกันมากในแง่ของแบนด์วิดท์เครือข่าย ต้นทุนข้อมูลขาออก ค่าใช้จ่ายเพิ่มเติมจาก CPU และเครือข่าย ส่วนลดและปัจจัยอื่นๆ

ความสามารถในการคำนวณบนฮาร์ดแวร์เฉพาะเป็นสินค้า อย่างไร้เดียงสา เราคาดหวังราคาที่ค่อนข้างสม่ำเสมอ แต่ก็ไม่เป็นเช่นนั้น และแม้ว่าจะมีความแตกต่างของคุณสมบัติที่สำคัญระหว่างคลาวด์ แต่ก็ไม่เพียงพอที่จะอธิบายว่าราคาสำหรับ NVIDIA A100 ตามความต้องการนั้นแตกต่างกันเกือบ 4 เท่าของผู้ให้บริการแต่ละราย

ที่ระดับบนสุดของสเกลราคา คลาวด์สาธารณะขนาดใหญ่จะคิดค่าบริการระดับพรีเมียมตามชื่อเสียงของแบรนด์ ความน่าเชื่อถือที่ได้รับการพิสูจน์แล้ว และความจำเป็นในการจัดการปริมาณงานที่หลากหลาย ผู้ให้บริการ AI เฉพาะทางรายเล็กเสนอราคาที่ต่ำกว่า ไม่ว่าจะด้วยการใช้งานศูนย์ข้อมูลที่สร้างขึ้นตามวัตถุประสงค์ (เช่น Coreweave) หรือการเก็งกำไรบนคลาวด์อื่นๆ (เช่น Lambda Labs)

ในทางปฏิบัติแล้ว ผู้ซื้อรายใหญ่ส่วนใหญ่จะต่อรองราคาโดยตรงกับผู้ให้บริการระบบคลาวด์ โดยมักจะให้ข้อผูกมัดกับข้อกำหนดการใช้จ่ายขั้นต่ำและข้อผูกมัดด้านเวลาขั้นต่ำ (เราเห็นว่า 1-3 ปี) ความแตกต่างของราคาระหว่างเมฆลดลงเล็กน้อยหลังจากการเจรจา แต่เราเห็นว่าอันดับในตารางด้านบนค่อนข้างคงที่ นอกจากนี้ สิ่งสำคัญที่ควรทราบคือบริษัทขนาดเล็กสามารถรับราคาที่สูงมากจากระบบคลาวด์พิเศษโดยไม่ต้องมีภาระผูกพันในการใช้จ่ายจำนวนมาก

สถานะ: GPU ที่ทรงพลังที่สุด (เช่น Nvidia A100) ขาดตลาดอย่างต่อเนื่องในช่วง 12 เดือนที่ผ่านมา

เป็นเรื่องสมเหตุสมผลที่จะคิดว่าผู้ให้บริการระบบคลาวด์สามอันดับแรกมีความพร้อมใช้งานที่ดีที่สุด เนื่องจากกำลังซื้อขนาดใหญ่และแหล่งทรัพยากรที่มีอยู่มากมาย แต่ที่น่าประหลาดใจคือสตาร์ทอัพจำนวนมากไม่พบว่าเป็นจริง คลาวด์ขนาดใหญ่มีฮาร์ดแวร์จำนวนมาก แต่ก็มีความต้องการของลูกค้ารายใหญ่เพื่อตอบสนองความต้องการ เช่น Azure เป็นโฮสต์หลักสำหรับ ChatGPT และกำลังเพิ่ม/เช่าความจุอย่างต่อเนื่องเพื่อตอบสนองความต้องการ ในขณะเดียวกัน Nvidia มุ่งมั่นที่จะทำให้ฮาร์ดแวร์พร้อมใช้งานในวงกว้างทั่วทั้งอุตสาหกรรม รวมถึงการจัดสรรสำหรับผู้ให้บริการพิเศษรายใหม่ (พวกเขาทำเช่นนี้ทั้งเพื่อความยุติธรรมและเพื่อลดการพึ่งพาลูกค้ารายใหญ่เพียงไม่กี่รายที่แข่งขันกับพวกเขาด้วย)

เป็นผลให้สตาร์ทอัพจำนวนมากค้นหาชิปที่มีจำหน่ายมากขึ้น รวมถึง Nvidia H100s ที่ล้ำสมัยในผู้ให้บริการระบบคลาวด์รายเล็ก หากคุณยินดีทำงานกับบริษัทโครงสร้างพื้นฐานที่ใหม่กว่า คุณอาจสามารถลดเวลารอสำหรับฮาร์ดแวร์และอาจช่วยประหยัดเงินในกระบวนการได้

โมเดลการนำส่งคอมพิวเตอร์: คลาวด์ขนาดใหญ่ในปัจจุบันมีเฉพาะอินสแตนซ์ที่มี GPU เฉพาะเท่านั้น สาเหตุที่ GPU เวอร์ชวลไลเซชันยังคงเป็นปัญหาที่ยังไม่ได้รับการแก้ไข คลาวด์ AI เฉพาะทางนำเสนอโมเดลอื่นๆ เช่น คอนเทนเนอร์หรืองานแบทช์ ที่สามารถจัดการงานแต่ละงานโดยไม่ทำให้ต้นทุนเริ่มต้นและค่ารื้อของอินสแตนซ์เพิ่มขึ้น หากคุณพอใจกับโมเดลนี้ ก็สามารถลดต้นทุนได้อย่างมาก

การเชื่อมต่อเครือข่าย: สำหรับการฝึกอบรมโดยเฉพาะ แบนด์วิธของเครือข่ายเป็นปัจจัยสำคัญในการเลือกผู้ให้บริการ คลัสเตอร์ที่มีแฟบริคเฉพาะระหว่างโหนด เช่น NVLink จำเป็นสำหรับการฝึกโมเดลขนาดใหญ่บางรุ่น สำหรับการสร้างภาพ ค่าธรรมเนียมการรับส่งข้อมูลขาออกสามารถเป็นตัวขับเคลื่อนต้นทุนที่สำคัญได้เช่นกัน

สนับสนุนลูกค้า: ผู้ให้บริการระบบคลาวด์ขนาดใหญ่ให้บริการลูกค้ากลุ่มใหญ่ใน SKU ของผลิตภัณฑ์หลายพันรายการ อาจเป็นเรื่องยากที่จะรับความสนใจจากฝ่ายสนับสนุนลูกค้าหรือแก้ไขปัญหา เว้นแต่คุณจะเป็นลูกค้ารายใหญ่ ในทางกลับกัน คลาวด์ AI เฉพาะจำนวนมากให้การสนับสนุนที่รวดเร็วและตอบสนองได้แม้สำหรับลูกค้าขนาดเล็ก ส่วนหนึ่งเป็นเพราะพวกเขาทำงานในสเกลที่เล็กกว่า แต่ยังเป็นเพราะปริมาณงานของพวกเขามีความเหมือนกันมากกว่า ดังนั้นพวกเขาจึงได้รับแรงจูงใจมากขึ้นในการมุ่งเน้นไปที่ฟีเจอร์และข้อบกพร่องเฉพาะของ AI

การเปรียบเทียบ GPU

อย่างอื่นเท่าเทียมกัน GPU ระดับบนจะทำงานได้ดีที่สุดกับปริมาณงานเกือบทั้งหมด อย่างไรก็ตาม ดังที่คุณเห็นในตารางด้านล่าง ฮาร์ดแวร์ที่ดีที่สุดก็มีราคาแพงกว่ามากเช่นกัน การเลือกประเภทของ GPU ที่เหมาะสมสำหรับแอปพลิเคชันเฉพาะของคุณสามารถลดต้นทุนได้อย่างมาก และอาจสร้างความแตกต่างระหว่างรูปแบบธุรกิจที่ทำงานได้และไม่ทำงาน

การตัดสินใจว่าจะลดรายการลงมากน้อยเพียงใด นั่นคือ การพิจารณาตัวเลือก GPU ที่คุ้มค่าที่สุดสำหรับแอปพลิเคชันของคุณ ส่วนใหญ่เป็นการตัดสินใจทางเทคนิคที่อยู่นอกเหนือขอบเขตของบทความนี้ แต่เราจะแบ่งปันเกณฑ์การคัดเลือกบางส่วนที่เราเห็นว่าสำคัญที่สุดด้านล่าง:

การฝึกอบรมกับการอนุมาน: ดังที่เราเห็นในส่วนแรกข้างต้น การฝึกโมเดล Transformer กำหนดให้เราต้องจัดเก็บข้อมูล 8 ไบต์สำหรับการฝึก นอกเหนือจากน้ำหนักของโมเดล ซึ่งหมายความว่า GPU สำหรับผู้บริโภคระดับไฮเอนด์ทั่วไปที่มีหน่วยความจำ 12GB แทบจะไม่สามารถใช้ในการฝึกโมเดลที่มีพารามิเตอร์ 4 พันล้านพารามิเตอร์ได้ ในทางปฏิบัติ การฝึกโมเดลขนาดใหญ่จะทำในคลัสเตอร์ของเครื่องที่มี GPU จำนวนมากต่อเซิร์ฟเวอร์ VRAM จำนวนมาก และการเชื่อมต่อแบนด์วิธสูงระหว่างเซิร์ฟเวอร์ (เช่น คลัสเตอร์ที่สร้างขึ้นโดยใช้ GPU ของศูนย์ข้อมูลระดับบนสุด)

โดยเฉพาะอย่างยิ่ง หลายๆ รุ่นจะคุ้มค่าที่สุดกับ NVIDIA H100 แต่ ณ วันนี้ มันหายากและมักจะต้องใช้ความมุ่งมั่นระยะยาวมากกว่าหนึ่งปี NVIDIA A100 ดำเนินการฝึกอบรมโมเดลส่วนใหญ่ในปัจจุบัน หาได้ง่ายกว่า แต่สำหรับคลัสเตอร์ขนาดใหญ่ อาจต้องใช้ข้อผูกมัดระยะยาวด้วย

ข้อกำหนดหน่วยความจำ: LLM ขนาดใหญ่มีจำนวนพารามิเตอร์สูงเกินกว่าจะใส่ลงในการ์ดใดๆ ได้ พวกเขาจำเป็นต้องแบ่งออกเป็นการ์ดหลาย ๆ ใบและต้องมีการตั้งค่าคล้ายกับการฝึกอบรม กล่าวอีกนัยหนึ่ง คุณอาจต้องใช้ H100 หรือ A100 ด้วยซ้ำสำหรับการอนุมาน LLM แต่รุ่นที่เล็กกว่า (เช่น Stable Diffusion) ต้องการ VRAM น้อยกว่ามาก ในขณะที่ A100 ยังคงได้รับความนิยม เราได้เห็นสตาร์ทอัพใช้ A10, A40, A4000, A5000 และ A6000 หรือแม้แต่การ์ด RTX

การสนับสนุนฮาร์ดแวร์: ในขณะที่ปริมาณงานส่วนใหญ่ในบริษัทต่างๆ ที่เราพูดคุยด้วยทำงานบน NVIDIA แต่มีเพียงไม่กี่รายที่เริ่มทดลองกับผู้จำหน่ายรายอื่น ที่พบมากที่สุดคือ Google TPU แต่ Gaudi 2 ของ Intel ดูเหมือนจะได้รับแรงฉุดเช่นกัน ความท้าทายของผู้จำหน่ายเหล่านี้คือประสิทธิภาพของโมเดลของคุณมักขึ้นอยู่กับความพร้อมใช้งานของการปรับแต่งซอฟต์แวร์สำหรับชิปเหล่านี้ คุณอาจต้องทำ PoC เพื่อให้เข้าใจประสิทธิภาพ

ข้อกำหนดด้านเวลาแฝง: โดยทั่วไป ปริมาณงานที่ไวต่อเวลาแฝงน้อยกว่า (เช่น การประมวลผลข้อมูลเป็นชุดหรือแอปพลิเคชันที่ไม่ต้องการการตอบสนองของ UI แบบโต้ตอบ) สามารถใช้ GPU ที่มีประสิทธิภาพน้อยกว่าได้ สิ่งนี้สามารถลดต้นทุนการประมวลผลได้มากถึง 3-4 เท่า (เช่น การเปรียบเทียบ A100 กับ A10 บน AWS) ในทางกลับกัน แอปที่ผู้ใช้เห็นมักจะต้องการการ์ดระดับบนสุดเพื่อมอบประสบการณ์ผู้ใช้แบบเรียลไทม์ที่น่าดึงดูดใจ การปรับโมเดลให้เหมาะสมมักจำเป็นเพื่อให้ต้นทุนอยู่ในระดับที่จัดการได้

ความแหลมคม: บริษัท Generative AI มักจะเห็นความต้องการพุ่งสูงขึ้นอย่างมากเนื่องจากเทคโนโลยีนี้ใหม่และน่าตื่นเต้นมาก ไม่ใช่เรื่องแปลกที่จะเห็นปริมาณคำขอเพิ่มขึ้น 10 เท่าในหนึ่งวัน โดยอิงจากการเปิดตัวผลิตภัณฑ์ใหม่ หรือเพิ่มขึ้น 50% ต่อสัปดาห์อย่างสม่ำเสมอ การจัดการที่เพิ่มขึ้นอย่างรวดเร็วเหล่านี้มักจะง่ายกว่าสำหรับ GPU ระดับล่าง เนื่องจากมีแนวโน้มว่าโหนดประมวลผลจะพร้อมใช้งานมากขึ้นตามความต้องการ บ่อยครั้งก็สมเหตุสมผลเช่นกัน ที่จะให้บริการทราฟฟิกประเภทนี้ด้วยทรัพยากรที่มีต้นทุนต่ำกว่า โดยแลกกับประสิทธิภาพ หากมาจากผู้ใช้ที่มีส่วนร่วมน้อยหรือเก็บตัวน้อยกว่า

การปรับให้เหมาะสมและการจัดตารางเวลาโมเดล

การเพิ่มประสิทธิภาพซอฟต์แวร์สามารถส่งผลกระทบอย่างมากต่อเวลาทำงานของโมเดล — และการเพิ่มขึ้น 10 เท่าไม่ใช่เรื่องแปลก อย่างไรก็ตาม คุณจะต้องพิจารณาว่าวิธีใดจะมีประสิทธิภาพมากที่สุดกับรุ่นและระบบเฉพาะของคุณ

เทคนิคบางอย่างใช้ได้กับโมเดลที่หลากหลายพอสมควร การใช้การแสดงทศนิยมที่สั้นกว่า (เช่น FP16 หรือ FP8 เทียบกับ FP32 ดั้งเดิม) หรือการวัดปริมาณ (INT8, INT4, INT2) ทำให้ได้ความเร็วที่มักจะเป็นเชิงเส้นพร้อมกับการลดลงของบิต บางครั้งสิ่งนี้จำเป็นต้องปรับเปลี่ยนโมเดล แต่มีเทคโนโลยีจำนวนมากขึ้นเรื่อยๆ ที่ทำให้การทำงานเป็นแบบอัตโนมัติด้วยความแม่นยำแบบผสมหรือแบบสั้นลง การตัดนิวรอลเน็ตเวิร์กจะลดจำนวนของน้ำหนักโดยละเว้นน้ำหนักที่มีค่าต่ำ เมื่อรวมกับการคูณเมทริกซ์แบบกระจายที่มีประสิทธิภาพ สิ่งนี้สามารถบรรลุความเร็วที่เพิ่มขึ้นอย่างมากใน GPU สมัยใหม่ เทคนิคการเพิ่มประสิทธิภาพอีกชุดหนึ่งจะจัดการกับปัญหาคอขวดของแบนด์วิธหน่วยความจำ (เช่น โดยการสตรีมน้ำหนักโมเดล)

การเพิ่มประสิทธิภาพอื่น ๆ นั้นมีความเฉพาะเจาะจงอย่างมาก ตัวอย่างเช่น Stable Diffusion มีความก้าวหน้าอย่างมากในด้านจำนวน VRAM ที่จำเป็นสำหรับการอนุมาน การเพิ่มประสิทธิภาพอีกประเภทหนึ่งคือเฉพาะฮาร์ดแวร์ TensorML ของ NVIDIA มีการเพิ่มประสิทธิภาพจำนวนหนึ่ง แต่จะใช้งานได้กับฮาร์ดแวร์ NVIDIA เท่านั้น สุดท้าย แต่ไม่ท้ายสุด การจัดตารางเวลาของงาน AI สามารถสร้างปัญหาคอขวดหรือการปรับปรุงประสิทธิภาพได้อย่างมาก การจัดสรรโมเดลให้กับ GPU เพื่อลดการสลับน้ำหนัก การเลือก GPU ที่ดีที่สุดสำหรับงานหนึ่งๆ หากมีให้ใช้งานหลายตัว และลดเวลาหยุดทำงานให้เหลือน้อยที่สุดโดยการแบทช์ปริมาณงานล่วงหน้าเป็นเทคนิคทั่วไป

ในท้ายที่สุด การปรับโมเดลให้เหมาะสมยังคงเป็นศิลปะสีดำเล็กน้อย และสตาร์ทอัพส่วนใหญ่ที่เราพูดคุยเพื่อทำงานร่วมกับบุคคลที่สามเพื่อช่วยเหลือด้านซอฟต์แวร์เหล่านี้บางส่วน บ่อยครั้ง ผู้ให้บริการเหล่านี้ไม่ใช่ผู้ให้บริการ MLops แบบดั้งเดิม แต่เป็นบริษัทที่เชี่ยวชาญด้านการเพิ่มประสิทธิภาพสำหรับโมเดลเชิงกำเนิดเฉพาะ (เช่น OctoML หรือ SegMind)

ต้นทุนโครงสร้างพื้นฐาน AI จะพัฒนาไปอย่างไร?

ในช่วงไม่กี่ปีที่ผ่านมา เราได้เห็นการเติบโตอย่างก้าวกระโดดของทั้งคู่ พารามิเตอร์ของโมเดล และ พลังการประมวลผลของ GPU. ยังไม่ชัดเจนว่าแนวโน้มนี้จะดำเนินต่อไปหรือไม่

ปัจจุบัน เป็นที่ยอมรับกันอย่างกว้างขวางว่ามีความสัมพันธ์ระหว่างจำนวนพารามิเตอร์ที่เหมาะสมที่สุดกับขนาดของชุดข้อมูลการฝึกอบรม (ดู Deepmind's สัตว์ชนิดหนึ่ง ทำงานเพิ่มเติมเกี่ยวกับเรื่องนี้) LLM ที่ดีที่สุดในปัจจุบันได้รับการฝึกอบรมเกี่ยวกับ การรวบรวมข้อมูลทั่วไป (การรวบรวมหน้าเว็บ 4.5 พันล้านหน้า หรือประมาณ 10% ของหน้าเว็บทั้งหมดที่มีอยู่) คลังข้อมูลการฝึกอบรมยังรวมถึงวิกิพีเดียและชุดหนังสือ แม้ว่าทั้งสองเล่มจะเล็กกว่ามาก (จำนวนหนังสือทั้งหมดที่มีอยู่คาดว่าจะเท่ากับ ประมาณ 100 ล้านเท่านั้น). มีการเสนอแนวคิดอื่นๆ เช่น การถอดความเนื้อหาวิดีโอหรือเสียง แต่ไม่มีแนวคิดใดที่ใกล้เคียงขนาด ยังไม่ชัดเจนว่าเราจะได้ชุดข้อมูลการฝึกอบรมที่ไม่ใช่การสังเคราะห์ซึ่งมีขนาดใหญ่กว่าที่ใช้ไปแล้วถึง 10 เท่า

ประสิทธิภาพของ GPU จะยังคงเพิ่มขึ้น แต่ในอัตราที่ช้าลงด้วย กฎของมัวร์ยังคงเหมือนเดิม อนุญาตให้มีทรานซิสเตอร์และคอร์มากขึ้น แต่พลังงานและ I/O กลายเป็นปัจจัยจำกัด นอกจากนี้ ยังมีการเลือกผลไม้แขวนต่ำจำนวนมากสำหรับการเพิ่มประสิทธิภาพ

อย่างไรก็ตาม ทั้งหมดนี้ไม่ได้หมายความว่าเราจะไม่คาดหวังว่าความต้องการความสามารถในการประมวลผลจะเพิ่มขึ้น แม้ว่าโมเดลและการฝึกอบรมจะเติบโตช้าลง แต่การเติบโตของอุตสาหกรรม AI และจำนวนนักพัฒนา AI ที่เพิ่มขึ้นจะกระตุ้นให้เกิดความต้องการ GPU ที่มากขึ้นและเร็วขึ้น ความจุส่วนใหญ่ของ GPU ใช้สำหรับการทดสอบโดยนักพัฒนาในระหว่างขั้นตอนการพัฒนาโมเดล และความต้องการนี้จะขยายเป็นเส้นตรงตามจำนวนพนักงาน ไม่มีสัญญาณว่าการขาดแคลน GPU ที่เรามีในปัจจุบันจะลดลงในอนาคตอันใกล้นี้

ต้นทุนโครงสร้างพื้นฐาน AI ที่สูงอย่างต่อเนื่องนี้จะสร้างคูเมืองที่ทำให้ผู้เข้ามาใหม่ไม่สามารถไล่ตามผู้ครอบครองตลาดที่มีเงินทุนเพียงพอได้หรือไม่ เรายังไม่รู้คำตอบสำหรับคำถามนี้ ค่าใช้จ่ายในการฝึกอบรมของ LLM อาจดูเหมือนคูเมืองในปัจจุบัน แต่โมเดลโอเพ่นซอร์สเช่น Alpaca หรือ Stable Diffusion แสดงให้เห็นว่าตลาดเหล่านี้ยังอยู่ในช่วงเริ่มต้นและอาจเปลี่ยนแปลงอย่างรวดเร็ว เมื่อเวลาผ่านไป โครงสร้างต้นทุนของชุดซอฟต์แวร์ AI ที่เกิดใหม่ (ดูโพสต์ก่อนหน้าของเรา) อาจเริ่มดูเหมือนอุตสาหกรรมซอฟต์แวร์แบบดั้งเดิมมากขึ้น

ในท้ายที่สุด นี่เป็นสิ่งที่ดี: ประวัติศาสตร์ได้แสดงให้เห็นว่าสิ่งนี้นำไปสู่ระบบนิเวศที่มีชีวิตชีวาด้วยนวัตกรรมที่รวดเร็วและโอกาสมากมายสำหรับผู้ก่อตั้งผู้ประกอบการ

ขอบคุณ Moin Nadeem และ Shangda Xu สำหรับการป้อนข้อมูลและคำแนะนำในระหว่างขั้นตอนการเขียน

¹ สัญชาตญาณในที่นี้คือสำหรับพารามิเตอร์ใดๆ (เช่น น้ำหนัก) ในโครงข่ายประสาทเทียม การดำเนินการอนุมาน (เช่น การส่งผ่านไปข้างหน้า) จำเป็นต้องดำเนินการสองจุดลอยตัวต่อพารามิเตอร์ ขั้นแรก ให้คูณค่าของโหนดอินพุตของโครงข่ายประสาทเทียมด้วยพารามิเตอร์ ประการที่สอง เพิ่มผลลัพธ์ของการรวมไปยังโหนดเอาต์พุตของโครงข่ายประสาทเทียม พารามิเตอร์ในตัวเข้ารหัสจะใช้หนึ่งครั้งต่อโทเค็นอินพุต และพารามิเตอร์ในตัวถอดรหัสจะใช้หนึ่งครั้งต่อโทเค็นเอาต์พุต หากเราถือว่าแบบจำลองมี p พารามิเตอร์และอินพุตและเอาต์พุตต่างก็มีความยาว n สัญญาณ, การดำเนินการจุดลอยตัวทั้งหมดคือ น * พี. มีการดำเนินการอื่นๆ อีกมากมาย (เช่น การทำให้เป็นมาตรฐาน การเข้ารหัส/ถอดรหัสการฝัง) ที่เกิดขึ้นในแบบจำลอง แต่เวลาที่ใช้ในการดำเนินการนั้นน้อยเมื่อเปรียบเทียบกัน

² การเรียนรู้ขั้นแรกต้องมีการส่งต่อผ่านหม้อแปลงตามที่อธิบายไว้ข้างต้น ตามด้วยการผ่านย้อนกลับซึ่งต้องมีการดำเนินการเพิ่มเติมสี่รายการต่อพารามิเตอร์เพื่อคำนวณการไล่ระดับสีและปรับน้ำหนัก โปรดทราบว่าการคำนวณการไล่ระดับสีจำเป็นต้องรักษาค่าโหนดที่คำนวณได้จากการส่งไปข้างหน้า สำหรับ GPT-3 โมเดลภาษาคือผู้เรียนไม่กี่ช็อต หารือเกี่ยวกับค่าใช้จ่ายในการฝึกอบรม

* * * * * * * * * * * *

ความคิดเห็นที่แสดงในที่นี้เป็นความคิดเห็นของบุคลากร AH Capital Management, LLC (“a16z”) ที่ยกมาและไม่ใช่ความคิดเห็นของ a16z หรือบริษัทในเครือ ข้อมูลบางอย่างในที่นี้ได้รับมาจากแหล่งบุคคลที่สาม รวมถึงจากบริษัทพอร์ตโฟลิโอของกองทุนที่จัดการโดย a16z ในขณะที่นำมาจากแหล่งที่เชื่อว่าเชื่อถือได้ a16z ไม่ได้ตรวจสอบข้อมูลดังกล่าวอย่างอิสระและไม่รับรองความถูกต้องของข้อมูลหรือความเหมาะสมสำหรับสถานการณ์ที่กำหนด นอกจากนี้ เนื้อหานี้อาจรวมถึงโฆษณาของบุคคลที่สาม a16z ไม่ได้ตรวจทานโฆษณาดังกล่าวและไม่ได้รับรองเนื้อหาโฆษณาใด ๆ ที่อยู่ในนั้น

เนื้อหานี้จัดทำขึ้นเพื่อวัตถุประสงค์ในการให้ข้อมูลเท่านั้น และไม่ควรใช้เป็นคำแนะนำทางกฎหมาย ธุรกิจ การลงทุน หรือภาษี คุณควรปรึกษาที่ปรึกษาของคุณเองในเรื่องเหล่านั้น การอ้างอิงถึงหลักทรัพย์หรือสินทรัพย์ดิจิทัลใดๆ มีวัตถุประสงค์เพื่อเป็นตัวอย่างเท่านั้น และไม่ถือเป็นการแนะนำการลงทุนหรือข้อเสนอเพื่อให้บริการที่ปรึกษาการลงทุน นอกจากนี้ เนื้อหานี้ไม่ได้มุ่งไปที่หรือมีไว้สำหรับการใช้งานโดยนักลงทุนหรือนักลงทุนที่คาดหวัง และไม่อาจเชื่อถือได้ไม่ว่าในกรณีใดๆ เมื่อตัดสินใจลงทุนในกองทุนใดๆ ที่จัดการโดย a16z (การเสนอให้ลงทุนในกองทุน a16z จะกระทำโดยบันทึกเฉพาะบุคคล ข้อตกลงจองซื้อ และเอกสารที่เกี่ยวข้องอื่นๆ ของกองทุนดังกล่าว และควรอ่านให้ครบถ้วน) การลงทุนหรือบริษัทพอร์ตการลงทุนใดๆ ที่กล่าวถึง อ้างถึง หรือ ที่อธิบายไว้ไม่ได้เป็นตัวแทนของการลงทุนทั้งหมดในยานพาหนะที่จัดการโดย a16z และไม่สามารถรับประกันได้ว่าการลงทุนนั้นจะให้ผลกำไรหรือการลงทุนอื่น ๆ ในอนาคตจะมีลักษณะหรือผลลัพธ์ที่คล้ายคลึงกัน รายการการลงทุนที่ทำโดยกองทุนที่จัดการโดย Andreessen Horowitz (ไม่รวมการลงทุนที่ผู้ออกไม่อนุญาตให้ a16z เปิดเผยต่อสาธารณะและการลงทุนที่ไม่ได้ประกาศในสินทรัพย์ดิจิทัลที่ซื้อขายในตลาดหลักทรัพย์) มีอยู่ที่ https://a16z.com/investments /.

แผนภูมิและกราฟที่ให้ไว้ภายในมีวัตถุประสงค์เพื่อให้ข้อมูลเท่านั้น และไม่ควรใช้ในการตัดสินใจลงทุนใดๆ ผลการดำเนินงานในอดีตไม่ได้บ่งบอกถึงผลลัพธ์ในอนาคต เนื้อหาพูดตามวันที่ระบุเท่านั้น การคาดการณ์ การประมาณการ การคาดการณ์ เป้าหมาย โอกาส และ/หรือความคิดเห็นใดๆ ที่แสดงในเอกสารเหล่านี้อาจเปลี่ยนแปลงได้โดยไม่ต้องแจ้งให้ทราบและอาจแตกต่างหรือขัดแย้งกับความคิดเห็นที่แสดงโดยผู้อื่น โปรดดู https://a16z.com/disclosures สำหรับข้อมูลสำคัญเพิ่มเติม

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- เพลโตไอสตรีม. ข้อมูลอัจฉริยะ Web3 ขยายความรู้ เข้าถึงได้ที่นี่.

- การสร้างอนาคตโดย Adryenn Ashley เข้าถึงได้ที่นี่.

- ที่มา: https://a16z.com/2023/04/27/navigating-the-high-cost-of-ai-compute/

- :มี

- :เป็น

- :ไม่

- $ 1 พันล้าน

- $ ขึ้น

- 000

- 1

- 100

- 116

- 2023

- 500

- 7

- 8

- a

- a16z

- ความสามารถ

- สามารถ

- เกี่ยวกับเรา

- ข้างบน

- แน่นอน

- เร่งความเร็ว

- คันเร่ง

- เร่ง

- ยอมรับได้

- ได้รับการยอมรับ

- เข้า

- ความถูกต้อง

- ถูกต้อง

- บรรลุ

- ข้าม

- เพิ่ม

- นอกจากนี้

- เพิ่มเติม

- นอกจากนี้

- เพิ่มเติม

- ที่อยู่

- เพิ่ม

- ความก้าวหน้า

- ความก้าวหน้า

- ความได้เปรียบ

- การโฆษณา

- คำแนะนำ

- ที่ปรึกษา

- บริการให้คำปรึกษา

- มีผลต่อ

- บริษัท ในเครือ

- หลังจาก

- อีกครั้ง

- ก้าวร้าว

- ข้อตกลง

- AI

- อัลกอริทึม

- ทั้งหมด

- การจัดสรร

- การอนุญาต

- แล้ว

- ด้วย

- แม้ว่า

- ในหมู่

- จำนวน

- จำนวน

- an

- การวิเคราะห์

- และ

- อันเดรสเซ่น

- Andreessen Horowitz

- อื่น

- คำตอบ

- ที่คาดว่าจะ

- ใด

- API

- app

- ปรากฏ

- ปรากฏ

- การใช้งาน

- การใช้งาน

- ประมาณ

- ปพลิเคชัน

- เมษายน

- สถาปัตยกรรม

- เป็น

- อาร์กิวเมนต์

- รอบ

- ศิลปะ

- บทความ

- เทียม

- ปัญญาประดิษฐ์

- AS

- ด้าน

- สินทรัพย์

- ความมั่นใจ

- At

- ความสนใจ

- เสียง

- โดยอัตโนมัติ

- ความพร้อมใช้งาน

- ใช้ได้

- เฉลี่ย

- หลีกเลี่ยง

- AWS

- สีฟ้า

- แบนด์วิดธ์

- ตาม

- BE

- เพราะ

- กลายเป็น

- จะกลายเป็น

- สมควร

- รับ

- กำลัง

- เชื่อ

- เชื่อว่า

- ด้านล่าง

- ที่ดีที่สุด

- ดีกว่า

- ระหว่าง

- เกิน

- อคติ

- ใหญ่

- พันล้าน

- บิต

- Black

- ร้านหนังสือเกาหลี

- ความเจริญ

- ทั้งสอง

- ขอบเขต

- ยี่ห้อ

- ทำลาย

- นำมาซึ่ง

- กว้าง

- แต้

- เป็นโรคจิต

- สร้าง

- การก่อสร้าง

- สร้าง

- ธุรกิจ

- รูปแบบธุรกิจ

- แต่

- ผู้ซื้อ

- by

- คำนวณ

- คำนวณ

- การคํานวณ

- โทร

- CAN

- สามารถรับ

- ไม่ได้

- ความสามารถในการ

- ความจุ

- เมืองหลวง

- บัตร

- การ์ด

- กรณี

- กรณี

- จับ

- ศูนย์

- ศูนย์

- บาง

- ท้าทาย

- เปลี่ยนแปลง

- ลักษณะ

- อักขระ

- รับผิดชอบ

- ChatGPT

- ราคาถูก

- ชิป

- ชิป

- ทางเลือก

- Choose

- สถานการณ์

- ชั้น

- ชัดเจน

- นาฬิกา

- ปิดหน้านี้

- เมฆ

- คอมพิวเตอร์เมฆ

- แพลตฟอร์มคลาวด์

- ชุด

- อย่างไร

- มา

- สบาย

- ความมุ่งมั่น

- มุ่งมั่น

- การกระทำ

- สินค้า

- ร่วมกัน

- บริษัท

- บริษัท

- เมื่อเทียบกับ

- เปรียบเทียบ

- การเปรียบเทียบ

- จับใจ

- แข่งขัน

- การแข่งขัน

- ความซับซ้อน

- ครอบคลุม

- การคำนวณ

- คำนวณ

- การคำนวณ

- พลังคอมพิวเตอร์

- การเชื่อมต่อ

- การพิจารณา

- การพิจารณา

- ไม่หยุดหย่อน

- เป็น

- บริโภค

- ผู้บริโภค

- การบริโภค

- ภาชนะบรรจุ

- เนื้อหา

- สิ่งแวดล้อม

- ต่อ

- อย่างต่อเนื่อง

- ตรงกันข้าม

- ควบคุม

- เย็น

- แกน

- ราคา

- ค่าใช้จ่ายที่มีประสิทธิภาพ

- ค่าใช้จ่าย

- ได้

- คอร์ส

- สร้าง

- การสร้าง

- เกณฑ์

- ขณะนี้

- ลูกค้า

- Customer Support

- ลูกค้า

- ตัดขอบ

- วงจร

- ข้อมูล

- ศูนย์ข้อมูล

- ศูนย์ข้อมูล

- การประมวลผล

- ชุดข้อมูล

- ฐานข้อมูล

- วันที่

- วัน

- ทศวรรษที่ผ่านมา

- ตัดสินใจ

- การตัดสินใจ

- ทุ่มเท

- Deepmind

- ส่งมอบ

- การจัดส่ง

- ความต้องการ

- การพึ่งพาอาศัยกัน

- ขึ้นอยู่กับ

- ทั้งนี้ขึ้นอยู่กับ

- ขึ้นอยู่กับ

- อธิบาย

- เดสก์ท็อป

- กำหนด

- การกำหนด

- พัฒนา

- นักพัฒนา

- พัฒนาการ

- แตกต่าง

- ความแตกต่าง

- ความแตกต่าง

- การจัดจำหน่าย

- ดิจิตอล

- สินทรัพย์ดิจิทัล

- โดยตรง

- เปิดเผย

- ส่วนลด

- แตกต่าง

- do

- เอกสาร

- ทำ

- การทำ

- ดอลลาร์

- ทำ

- Dont

- ลง

- หยุดทำงาน

- อย่างมาก

- ขับรถ

- คนขับรถ

- การขับขี่

- สอง

- ในระหว่าง

- e

- ก่อน

- ง่ายดาย

- อย่างง่ายดาย

- ระบบนิเวศ

- มีประสิทธิภาพ

- มีประสิทธิภาพ

- ผลกระทบ

- อย่างมีประสิทธิภาพ

- ที่มีประสิทธิภาพ

- ทั้ง

- การฝัง

- กากกะรุน

- ปลาย

- รับรอง

- ที่ยืนยง

- หมั้น

- น่าสนใจ

- ชั้นเยี่ยม

- วิศวกร

- ทั้งหมด

- ขาเข้า

- ผู้ประกอบการ

- เท่ากัน

- โดยเฉพาะอย่างยิ่ง

- เป็นหลัก

- ประมาณการ

- ประมาณ

- ประมาณการ

- แม้

- เคย

- คาย

- ตัวอย่าง

- เกินกว่า

- น่าตื่นเต้น

- ไม่รวม

- ดำเนินการ

- การดำเนินงาน

- มีอยู่

- การขยายตัว

- คาดหวัง

- แพง

- ประสบการณ์

- อธิบาย

- ที่ชี้แจง

- การเจริญเติบโต

- แสดง

- อย่างยิ่ง

- ผ้า

- ใบหน้า

- ปัจจัย

- ธรรม

- อย่างเป็นธรรม

- ครอบครัว

- FAST

- เร็วขึ้น

- ลักษณะ

- คุณสมบัติ

- ค่าธรรมเนียม

- สองสาม

- ให้เงิน

- หา

- ปลาย

- ชื่อจริง

- พอดี

- การแก้ไข

- พลิก

- ที่ลอย

- โฟกัส

- ตาม

- สำหรับ

- การคาดการณ์

- โชคดี

- ข้างหน้า

- พบ

- รากฐาน

- ผู้ก่อตั้ง

- สี่

- เศษ

- กรอบ

- ราคาเริ่มต้นที่

- เชื้อเพลิง

- สนุก

- กองทุน

- เงิน

- นอกจากนี้

- อนาคต

- กําไร

- การเล่นเกม

- General

- การสร้าง

- รุ่น

- กำเนิด

- กำเนิด AI

- ในทางภูมิศาสตร์

- ภูมิศาสตร์การเมือง

- ได้รับ

- ได้รับ

- ให้

- กำหนด

- จะช่วยให้

- Go

- ดี

- Google Cloud

- Google Cloud Platform

- GPU

- GPUs

- สำเร็จการศึกษา

- กราฟิก

- กราฟ

- ขึ้น

- การเจริญเติบโต

- คำแนะนำ

- มือ

- จัดการ

- การจัดการ

- เกิดขึ้น

- ยาก

- ฮาร์ดแวร์

- การควบคุม

- มี

- จำนวนพนง

- ได้ยิน

- ช่วย

- เป็นประโยชน์

- โปรดคลิกที่นี่เพื่ออ่านรายละเอียดเพิ่มเติม

- จุดสูง

- High-End

- อย่างสูง

- ประวัติ

- กระโปรงหน้ารถ

- หวังว่า

- ฮอ

- เจ้าภาพ

- เป็นเจ้าภาพ

- ชั่วโมง

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- ทำอย่างไร

- อย่างไรก็ตาม

- HTML

- HTTPS

- ใหญ่

- อย่างมหาศาล

- มนุษย์

- i

- ความคิด

- if

- ภาพ

- ทันที

- สำคัญ

- เป็นไปไม่ได้

- การปรับปรุง

- in

- ในอื่น ๆ

- แรงจูงใจ

- ประกอบด้วย

- รวมถึง

- รวมทั้ง

- เพิ่ม

- เพิ่มขึ้น

- ขึ้น

- อิสระ

- แสดงว่า

- เป็นรายบุคคล

- อุตสาหกรรม

- ข้อมูล

- เกี่ยวกับข้อมูล

- โครงสร้างพื้นฐาน

- นักวิเคราะห์ส่วนบุคคลที่หาโอกาสให้เป็นไปได้มากที่สุด

- อินพุต

- ตัวอย่าง

- แทน

- คำแนะนำการใช้

- แบบบูรณาการ

- Intelligence

- การโต้ตอบ

- เข้าไป

- ลงทุน

- การลงทุน

- ที่ปรึกษาการลงทุน

- เงินลงทุน

- นักลงทุน

- บริษัท ผู้ออกหลักทรัพย์

- IT

- ITS

- ตัวเอง

- งาน

- เพียงแค่

- เก็บ

- ชนิด

- ทราบ

- ห้องปฏิบัติการ

- ภูมิประเทศ

- ภาษา

- ใหญ่

- ส่วนใหญ่

- ที่มีขนาดใหญ่

- ชื่อสกุล

- ความแอบแฝง

- กฏหมาย

- นำไปสู่

- การเรียนรู้

- กฎหมาย

- ความยาว

- ชีวิต

- กดไลก์

- น่าจะ

- รายการ

- ดูรายละเอียด

- LLM

- ที่ตั้ง

- ตรรกะ

- นาน

- ระยะยาว

- อีกต่อไป

- ดู

- ดูเหมือน

- ที่ต้องการหา

- Lot

- ต่ำ

- ลด

- ต่ำที่สุด

- เครื่อง

- ทำ

- สำคัญ

- ส่วนใหญ่

- ทำ

- ทำให้

- การทำ

- จัดการ

- การจัดการ

- การจัดการ

- การจัดการ

- มนุษยชาติ

- หลาย

- ตลาด

- ตลาด

- มาก

- วัสดุ

- คณิตศาสตร์

- มดลูก

- เรื่อง

- ความกว้างสูงสุด

- อาจ..

- มีความหมาย

- วิธี

- ในขณะเดียวกัน

- พบ

- บันทึก

- หน่วยความจำ

- กล่าวถึง

- วิธีการ

- ไมโครซอฟท์

- Microsoft Azure

- ล้าน

- การลด

- ขั้นต่ำ

- ผสม

- ม.ป.ป

- แบบ

- โมเดล

- ทันสมัย

- เงิน

- เดือน

- ข้อมูลเพิ่มเติม

- มากที่สุด

- เป็นที่นิยม

- มาก

- หลาย

- คูณ

- การนำทาง

- ใกล้

- เกือบทั้งหมด

- จำเป็น

- จำเป็นต้อง

- จำเป็น

- ความต้องการ

- เครือข่าย

- เครือข่าย

- เครือข่าย

- เครือข่ายประสาท

- เครือข่ายประสาทเทียม

- ใหม่

- ผลิตภัณฑ์ใหม่

- ข่าว

- ถัดไป

- ไม่

- ปม

- โหนด

- สังเกต..

- ตอนนี้

- จำนวน

- ตัวเลข

- Nvidia

- ได้รับ

- ที่ได้รับ

- of

- เสนอ

- การเสนอ

- มักจะ

- on

- ตามความต้องการ

- ครั้งเดียว

- ONE

- ออนไลน์

- เพียง

- เปิด

- โอเพนซอร์ส

- OpenAI

- การดำเนินงาน

- การดำเนินการ

- การดำเนินการ

- ความคิดเห็น

- โอกาส

- ดีที่สุด

- การเพิ่มประสิทธิภาพ

- เพิ่มประสิทธิภาพ

- การปรับให้เหมาะสม

- การเพิ่มประสิทธิภาพ

- or

- ใบสั่ง

- เป็นต้นฉบับ

- แต่เดิม

- อื่นๆ

- ผลิตภัณฑ์อื่นๆ

- ของเรา

- ออก

- เอาท์พุต

- ล้ำหน้า

- เกิน

- ทั้งหมด

- ของตนเอง

- Parallel

- พารามิเตอร์

- พารามิเตอร์

- ในสิ่งที่สนใจ

- คู่กรณี

- ส่วน

- ส่ง

- อดีต

- รูปแบบไฟล์ PDF

- ดำเนินการ

- การปฏิบัติ

- การอนุญาต

- บุคลากร

- ระยะ

- เลือก

- เลือก

- สถานที่

- เวที

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- กรุณา

- PoC

- จุด

- สระ

- ยอดนิยม

- ผลงาน

- อาจ

- โพสต์

- อำนาจ

- ที่มีประสิทธิภาพ

- ประยุกต์

- การปฏิบัติ

- ความแม่นยำ

- Premium

- ก่อน

- ราคา

- ราคา

- การตั้งราคา

- ประถม

- ส่วนตัว

- อาจ

- ปัญหา

- ปัญหาที่เกิดขึ้น

- กระบวนการ

- การประมวลผล

- หน่วยประมวลผล

- ผลิตภัณฑ์

- มีกำไร

- ประมาณการ

- คุณสมบัติ

- ที่คาดหวัง

- กลุ่มเป้าหมาย

- ที่พิสูจน์แล้ว

- ให้

- ให้

- ผู้จัดหา

- ผู้ให้บริการ

- สาธารณะ

- สาธารณชน

- การจัดซื้อ

- วัตถุประสงค์

- คำถาม

- อย่างรวดเร็ว

- วิจัยและพัฒนา

- ยก

- พิสัย

- อันดับ

- รวดเร็ว

- อย่างรวดเร็ว

- คะแนน

- ราคา

- ดิบ

- มาถึง

- อ่าน

- เรียลไทม์

- ความจริง

- เหตุผล

- เหตุผล

- แนะนำ

- ลด

- ลด

- การอ้างอิง

- เรียกว่า

- ของแคว้น

- ความสัมพันธ์

- สัมพัทธ์

- ปล่อย

- ตรงประเด็น

- ความเชื่อถือได้

- น่าเชื่อถือ

- การสงเคราะห์

- ยังคง

- ซากศพ

- ตัวแทน

- มีชื่อเสียง

- ชื่อเสียง

- ขอ

- การร้องขอ

- ต้องการ

- จำเป็นต้องใช้

- ความต้องการ

- ความต้องการ

- ต้อง

- แหล่งข้อมูล

- ว่า

- การตอบสนอง

- ผล

- ผลสอบ

- สุดท้าย

- RTX

- RTX 3080

- RTX 3080 Ti

- กฎ

- วิ่ง

- วิ่ง

- กล่าวว่า

- เดียวกัน

- ลด

- ขนาด

- ตาชั่ง

- การกำหนด

- ขอบเขต

- ค้นหา

- ค้นหา

- ที่สอง

- วินาที

- Section

- หลักทรัพย์

- เห็น

- เห็น

- การเลือก

- ความรู้สึก

- มีความละเอียดอ่อน

- แยก

- ลำดับ

- ให้บริการ

- เซิร์ฟเวอร์

- บริการ

- บริการ

- ชุด

- การติดตั้ง

- หลาย

- Share

- สั้น

- ความขาดแคลน

- น่า

- แสดง

- แสดงให้เห็นว่า

- ด้าน

- ลงชื่อ

- คล้ายคลึงกัน

- ง่ายดาย

- ตั้งแต่

- เดียว

- สถานการณ์

- ขนาด

- ขนาด

- ช้า

- เล็ก

- มีขนาดเล็กกว่า

- So

- จนถึงตอนนี้

- ซอฟต์แวร์

- แก้ปัญหา

- บาง

- บางสิ่งบางอย่าง

- ค่อนข้าง

- แหล่ง

- แหล่งที่มา

- ช่องว่าง

- การพูด

- พูด

- มีความเชี่ยวชาญ

- เฉพาะ

- พิเศษ

- โดยเฉพาะ

- เฉพาะ

- ใช้จ่าย

- การใช้จ่าย

- แหลม

- แยก

- มั่นคง

- กอง

- เริ่มต้น

- Start-up

- ข้อความที่เริ่ม

- startups

- ยังคง

- การเก็บรักษา

- จัดเก็บ

- ที่พริ้ว

- โครงสร้าง

- หรือ

- การสมัครสมาชิก

- เป็นกอบเป็นกำ

- ความสำเร็จ

- อย่างเช่น

- เหมาะสม

- สรุป

- จัดหาอุปกรณ์

- สนับสนุน

- ระบบ

- ตาราง

- เอา

- ใช้เวลา

- คุย

- เป้าหมาย

- งาน

- งาน

- ภาษี

- ทีม

- วิชาการ

- เทคนิค

- เทคโนโลยี

- เทคโนโลยี

- เงื่อนไขการใช้บริการ

- การทดสอบ

- กว่า

- ที่

- พื้นที่

- ก้าวสู่อนาคต

- ข้อมูล

- ภูมิทัศน์

- ของพวกเขา

- พวกเขา

- ที่นั่น

- ในนั้น

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- พวกเขา

- สิ่ง

- คิด

- คิด

- ที่สาม

- บุคคลที่สาม

- ของบุคคลที่สาม

- นี้

- เหล่านั้น

- พัน

- สาม

- ตลอด

- ผูก

- เวลา

- ครั้ง

- ไปยัง

- ในวันนี้

- วันนี้

- ร่วมกัน

- โทเค็น

- tokenization

- ราชสกุล

- เกินไป

- ด้านบน

- รวม

- ไปทาง

- แรงฉุด

- ซื้อขาย

- แบบดั้งเดิม

- การจราจร

- รถไฟ

- ผ่านการฝึกอบรม

- การฝึกอบรม

- หม้อแปลง

- แปลความ

- เทรนด์

- พยายาม

- ล้านล้าน

- จริง

- สอง

- ชนิด

- ชนิด

- ตามแบบฉบับ

- เป็นปกติ

- ui

- ผิดปกติ

- ภายใต้

- พื้นฐาน

- เข้าใจ

- เป็นเอกลักษณ์

- หน่วย

- ให้กับคุณ

- เมื่อ

- us

- ใช้

- ใช้กรณี

- มือสอง

- ผู้ใช้งาน

- ประสบการณ์ของผู้ใช้

- ผู้ใช้

- การใช้

- มักจะ

- มีคุณค่า

- ความคุ้มค่า

- มูลค่า

- ความคุ้มค่า

- ความหลากหลาย

- กว้างใหญ่

- ยานพาหนะ

- ผู้ขาย

- การตรวจสอบแล้ว

- ดิ่ง

- มาก

- ทำงานได้

- สั่นสะเทือน

- วีดีโอ

- ยอดวิว

- ไดรฟ์

- vs

- รอ

- ต้องการ

- คือ

- ทาง..

- วิธี

- we

- เว็บ

- บริการเว็บ

- สัปดาห์

- น้ำหนัก

- ดี

- อะไร

- เมื่อ

- ที่

- ในขณะที่

- WHO

- กว้าง

- ช่วงกว้าง

- อย่างกว้างขวาง

- วิกิพีเดีย

- จะ

- เต็มใจ

- กับ

- ภายใน

- ไม่มี

- คำ

- คำ

- งาน

- การทำงาน

- จะ

- การเขียน

- ปี

- ปี

- ยัง

- คุณ

- ของคุณ

- ลมทะเล